手写机器学习正向传播和反向传播

https://www.cnblogs.com/charlotte77/p/5629865.html

我保存到了 pdf 中《一文弄懂神经网络中的反向传播法——BackPropagation.pdf》

参考链接

1 | #coding:utf-8 |

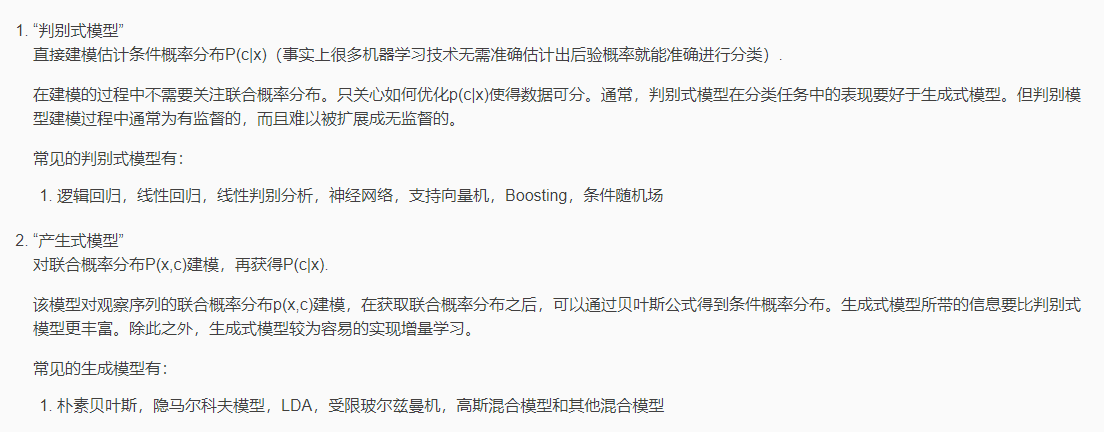

机器学习分类

根据训练数据是否有标签,可以分为:

监督学习:所有训练数据均具有标签(典型的问题有回归:模型输出的是一个具体数值;分类:模型的输出是某一类别) 在监督学习中,常用的模型种类可以分为:线性模型 和 非线性模型。其中,非线性模型应用更加广泛,表达能力也更强,包括深度学习,支持向量机(SVM),决策树,K-NN算法等。

半监督学习:训练数据中,部分具有标签,另一部分没有标签(但是没有标签的数据,对于模型的学习也是有用处的)。 迁移学习:使用与当前任务无关的数据(可能有标签,可能没有标签)来促进当前模型的学习。 无监督学习:训练数据都没有标签。 无监督学习存在的原因是,现实世界中,为训练数据进行标注成本较高,当训练数据都没有标签时,如果我们想要为数据进行分类,只能根据数据的特征进行划分,比如聚类算法。

强化学习:训练数据没有标签,智能体从环境交互中进行学习,来更新自身的策略,根据最终环境的反馈(获得的奖励)来调整自身行为。

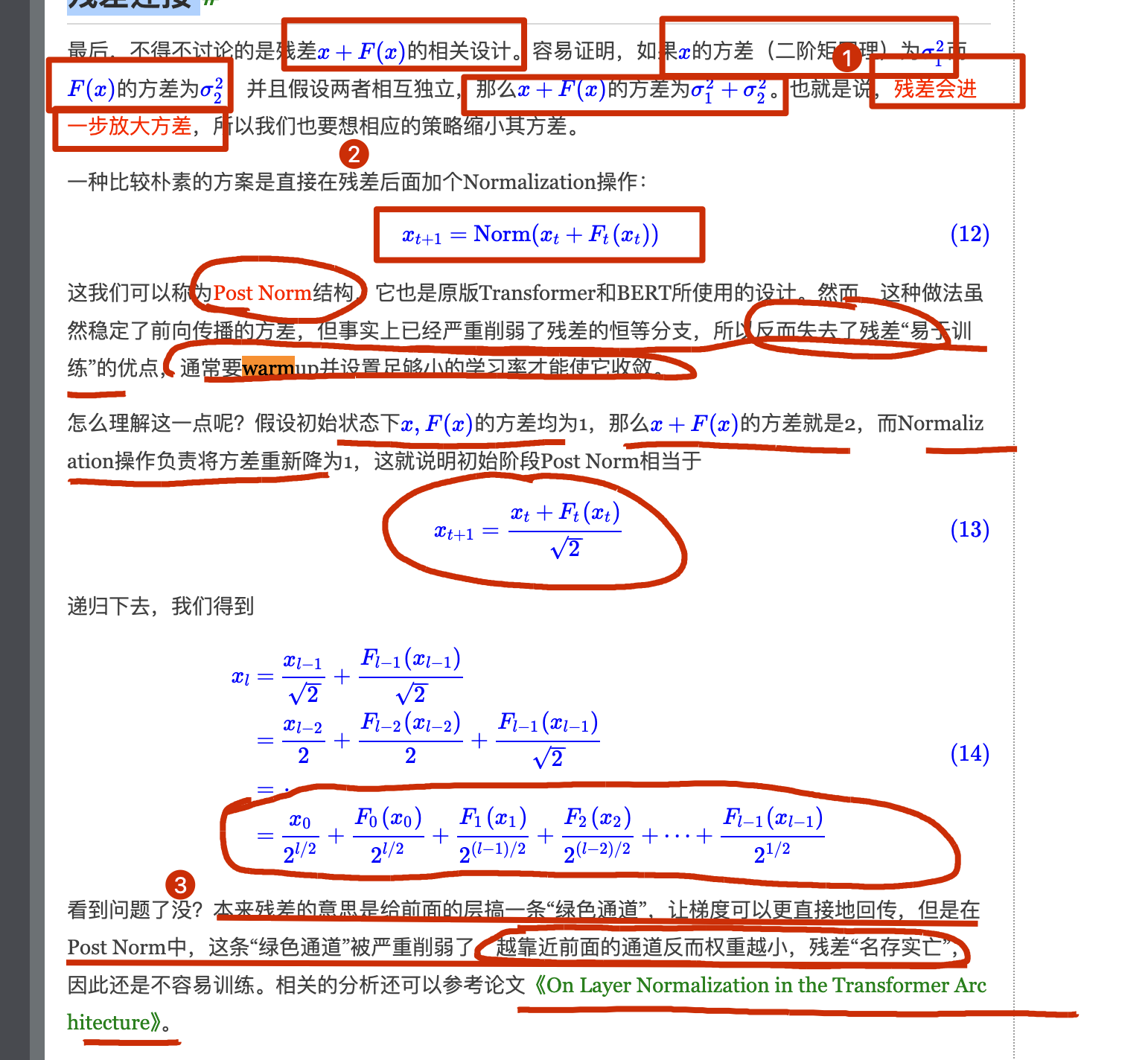

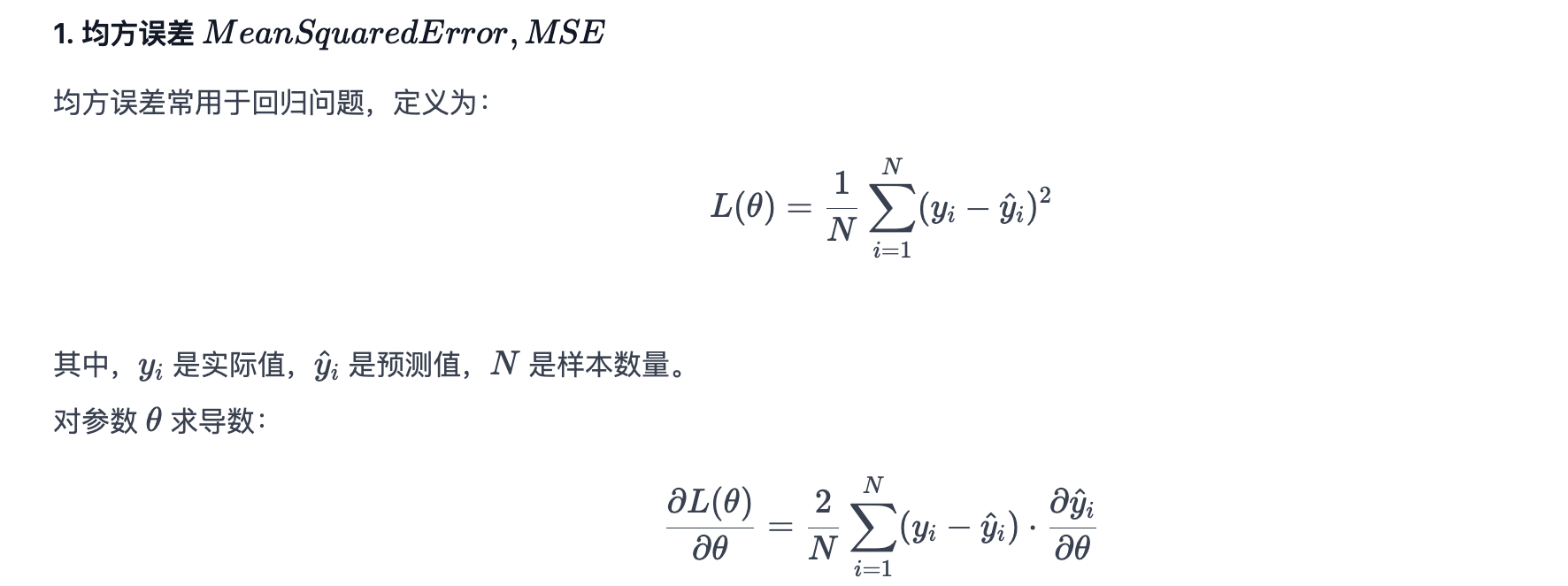

回归问题

机器学习笔记的第二篇博客,来介绍机器学习中最基础的回归任务,上一篇博客中有提到回归任务和分类任务的差别在于,回归任务中模型的输出是一个具体的数值, 而分类任务中模型的输出是某一类别。其实,许多问题我们都可以视为回归问题:例如:根据股票市场的历史数据预测明天的股票走势;自动驾驶中根据传感器获取的信息输出方向盘的转动角度;推荐系统中,输入用户和商品的特征,模型输出一个[0,1]之间的数值,表示购买的可能性。

回归模型的建立

机器学习模型建立的三个步骤:

- 我们准备许多备选的函数 f ,构成一个集合,也就是机器学习中的模型(Model)。

- 使用训练数据来衡量这些备选函数的好坏程度。

- 根据训练数据选出拟合最好的函数,作为最终的拟合函数。

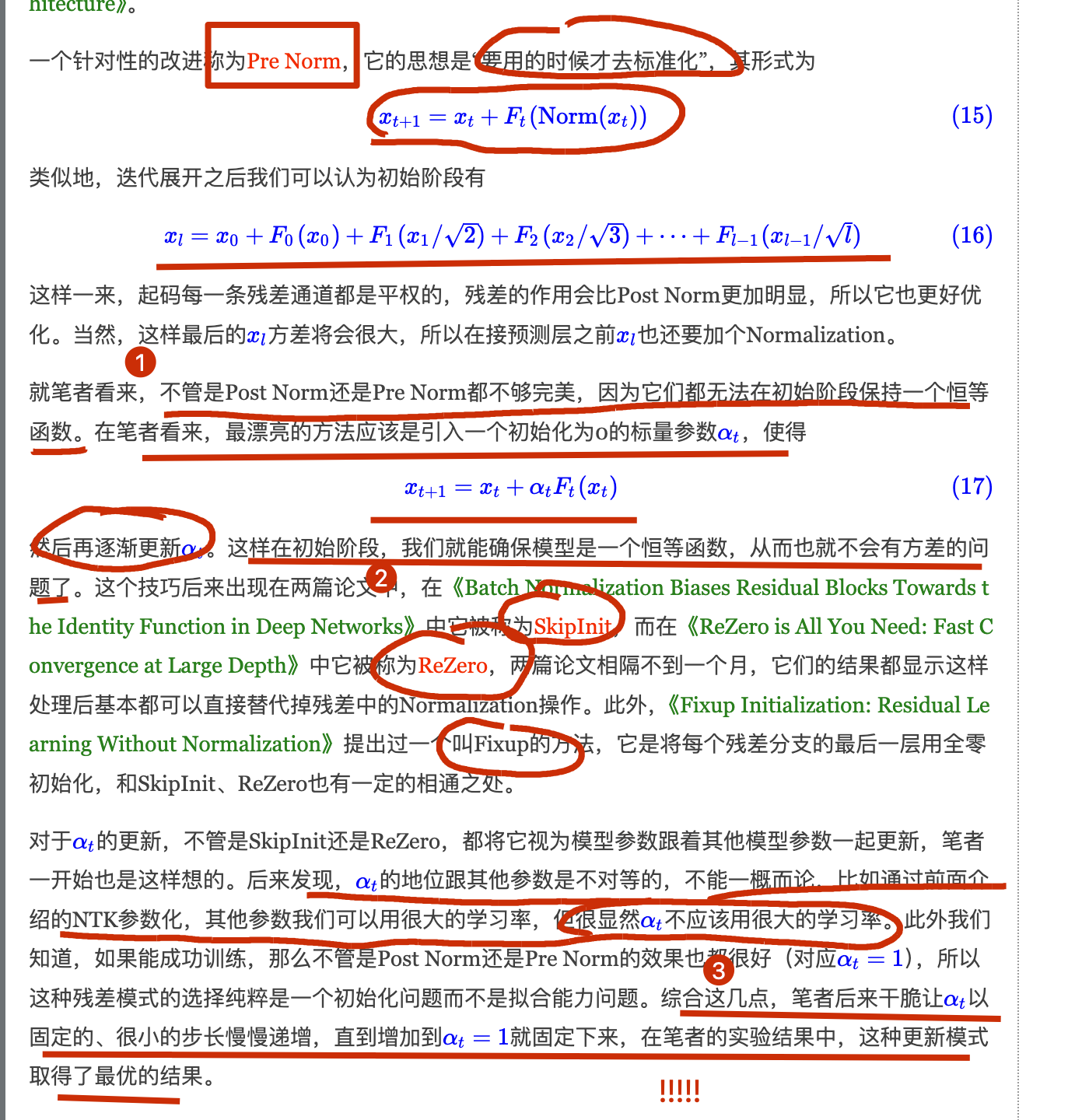

第一步:确定用于回归任务的模型

这里选择一元线性函数 y = wx + b即线性模型,一元表示我们使用的特征是一个(宝可梦的原CP值);这样我们就构造了一个函数集合,由于参数w和b的取值是无穷的,所以函数集合中函数的个数是无穷个,接下来在函数集合中选择最好的函数的过程实际上就是为函数确定参数值的过程。

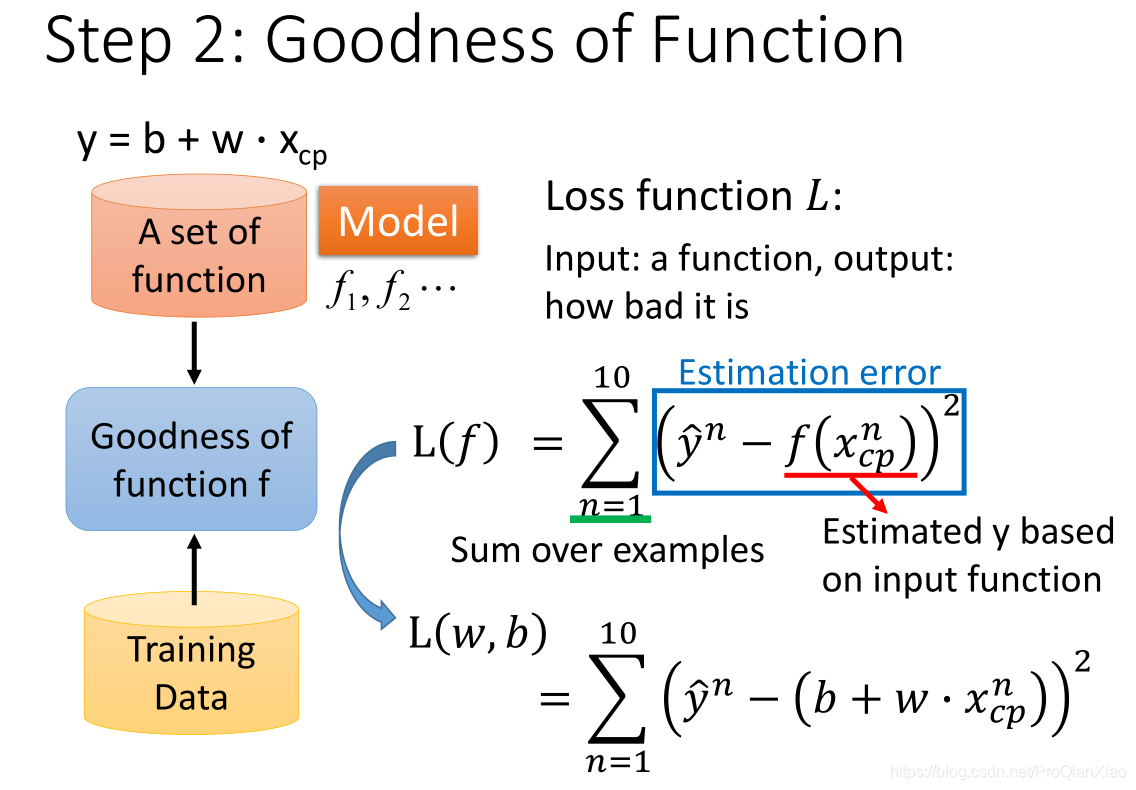

第二步:使用训练数据来衡量这些备选函数的好坏程度(确定参数)

接下来我们需要根据训练数据来从备选函数中选择一个效果最好的函数(即确定函数参数部分),这里需要使用损失函数,损失函数的输入是 “用来进行回归任务的函数” 和 “真实标签” ,输出是 进行回归任务的函数的好坏程度(Loss的值越小,认为该函数的效果越好)。如上图所示,我们使用 平方差之和 作为损失函数。

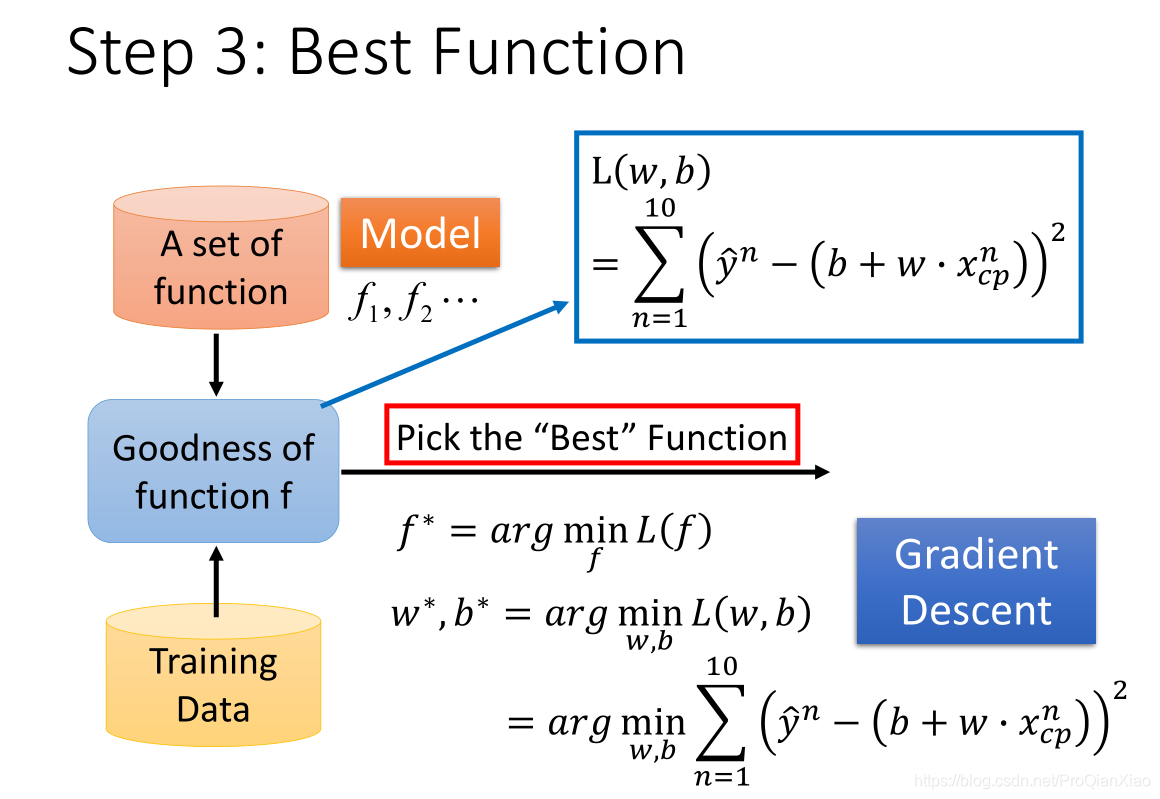

第三步:根据训练数据选出拟合最好的函数,作为最终的拟合函数

第三步,我们在训练数据上根据损失函数来评估拟合函数的好坏,找到使得损失函数最小的一组参数,作为我们最终的拟合函数。其中,寻找参数时,使用的方法为 梯度下降法 。

梯度下降

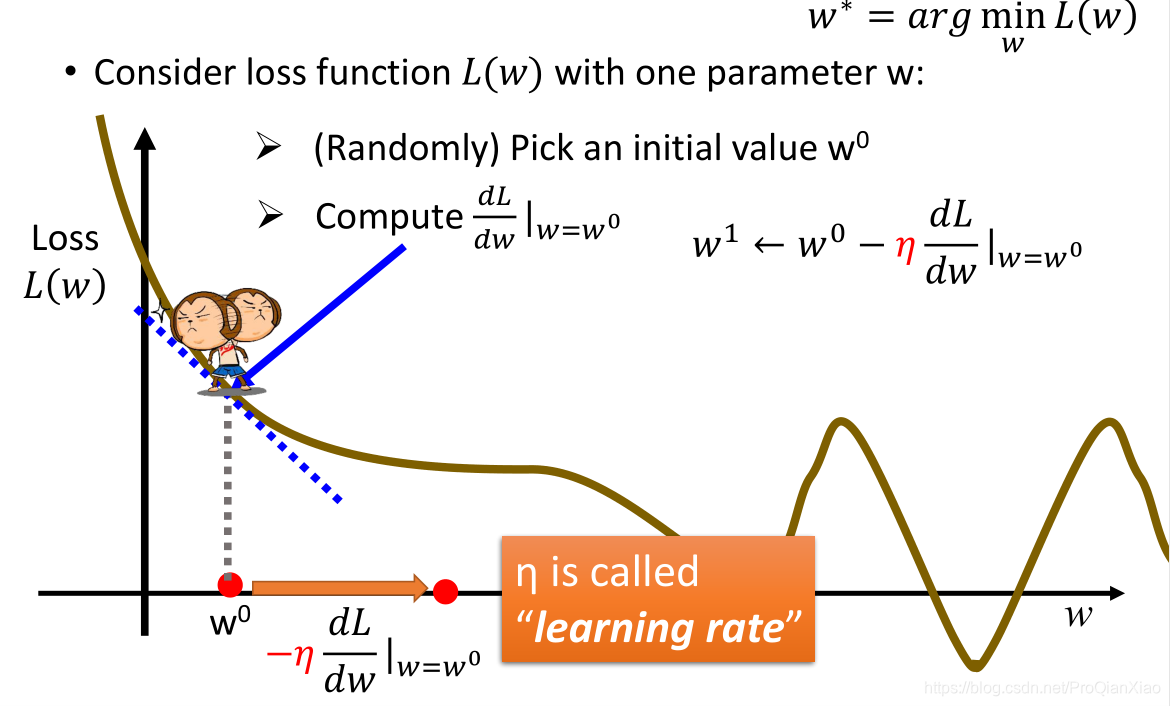

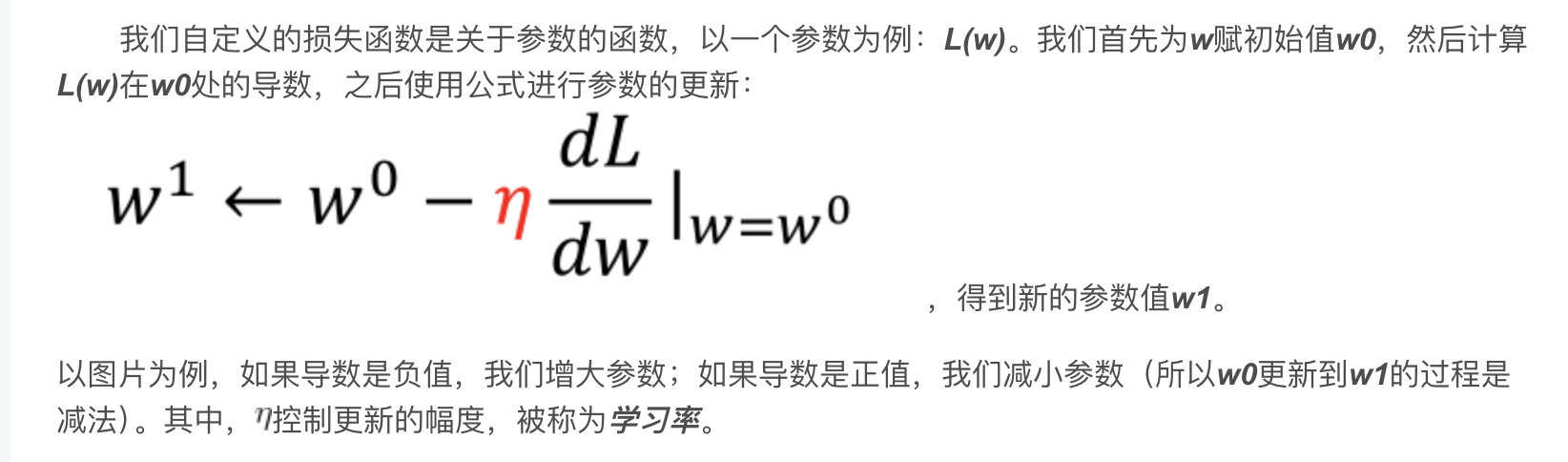

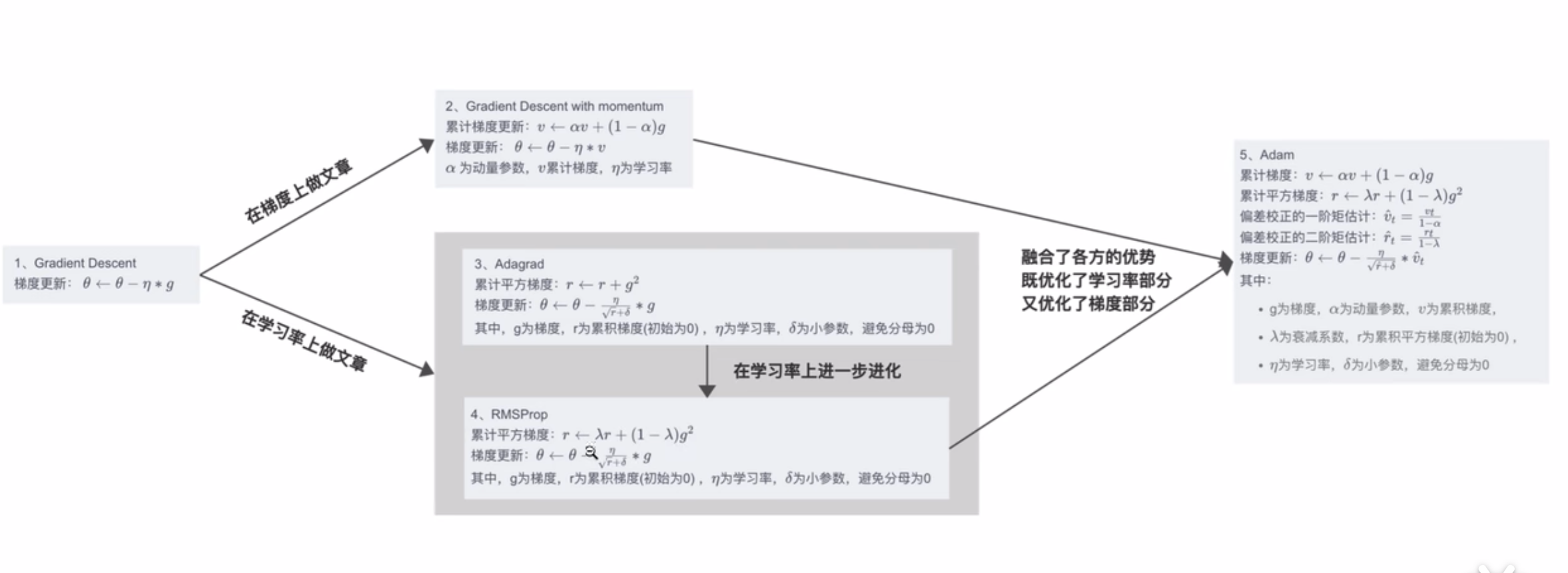

梯度下降算法是机器学习领域最广为人知、用途最广的优化算法,用来确定模型的参数(包括随机梯度下降SGD,Momentum,Adam等)。梯度下降算法的一个简单介绍如下:

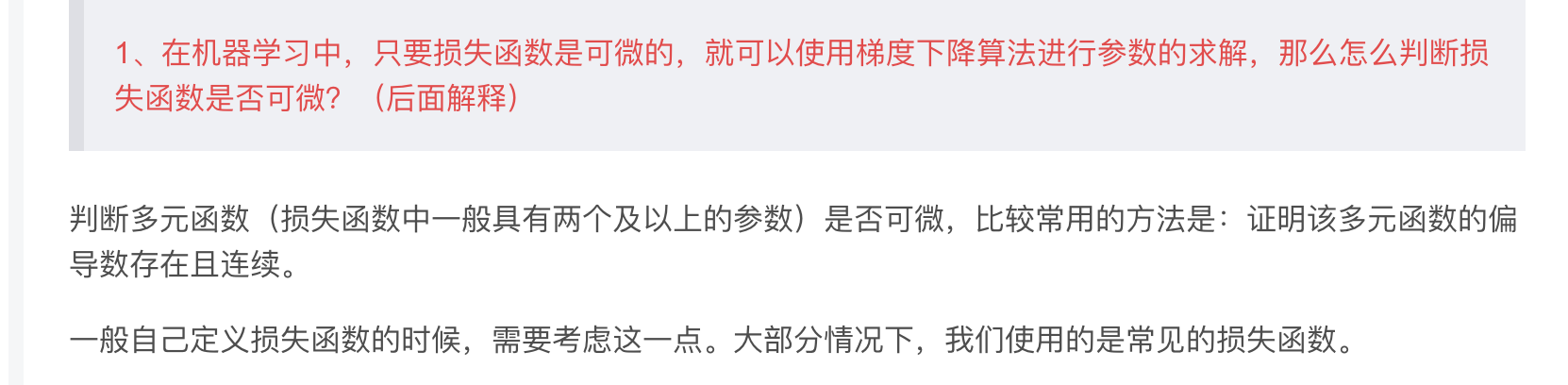

1、在机器学习中,只要损失函数是可微分(可求导)的,就可以使用梯度下降算法进行参数的求解,那么怎么判断损失函数是否可微?(后面解释)

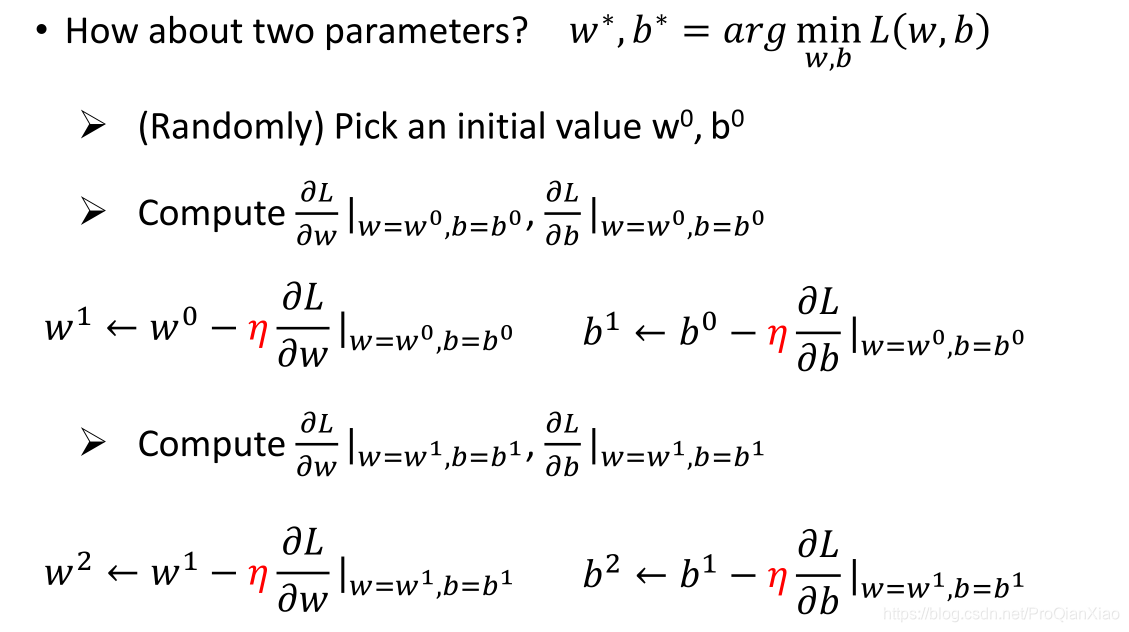

上面图片展示的是,模型当中只有一个参数(所以直接对该参数求导就可以),如果模型中存在两个及以上的参数,那么就需要分别对每个参数计算偏导数,然后根据参数更新公式进行每个参数的更新,如下图所示:

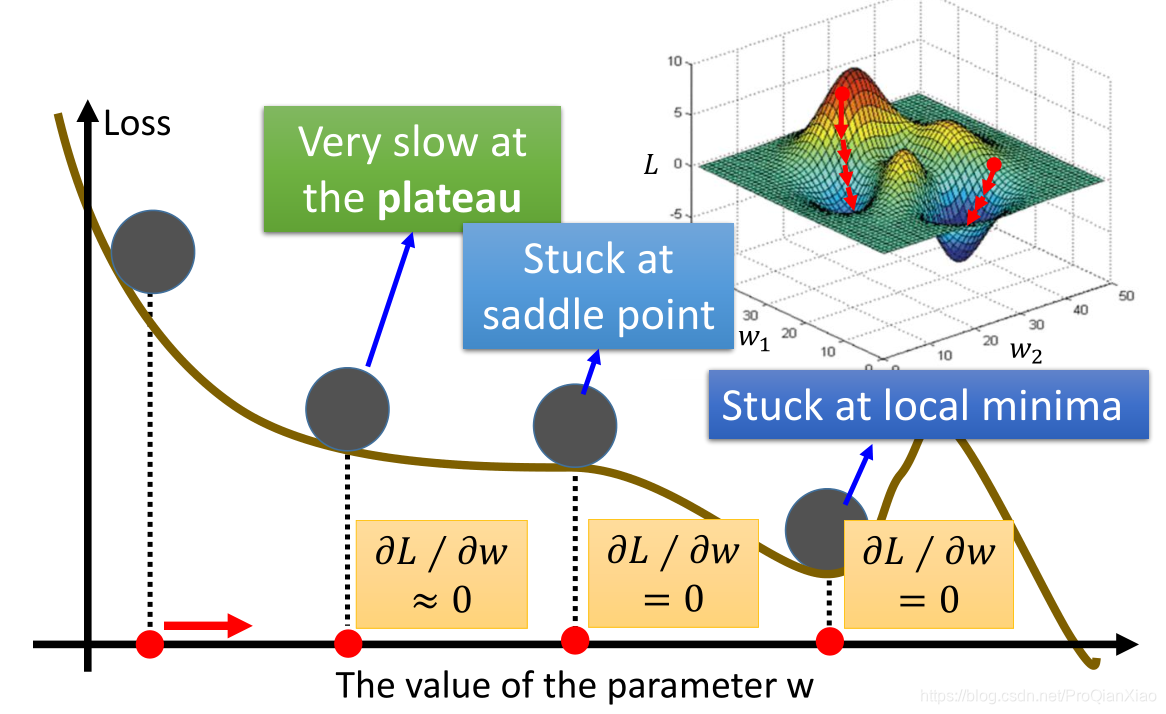

梯度下降算法的原理已经清楚,其实就是沿着损失函数降低的方向更新模型的参数,但是如果损失函数很复杂,比如下面图片所示,

我们很可能在更新参数的过程中,走到导数为0的点(第四个红点位置),这时因为不知道更新的方向,就陷入了局部最优点(其实真正的全局最优点还在右边)。

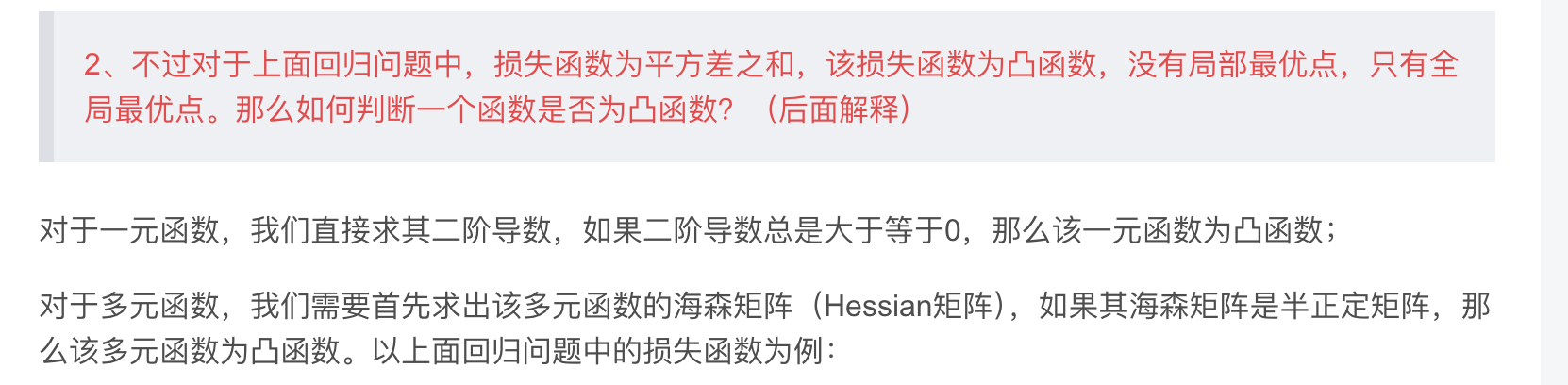

2、不过对于上面回归问题中,损失函数为平方差之和,该损失函数为凸函数,没有局部最优点,只有全局最优点。那么如何判断一个函数是否为凸函数?(后面解释)

预测结果分析

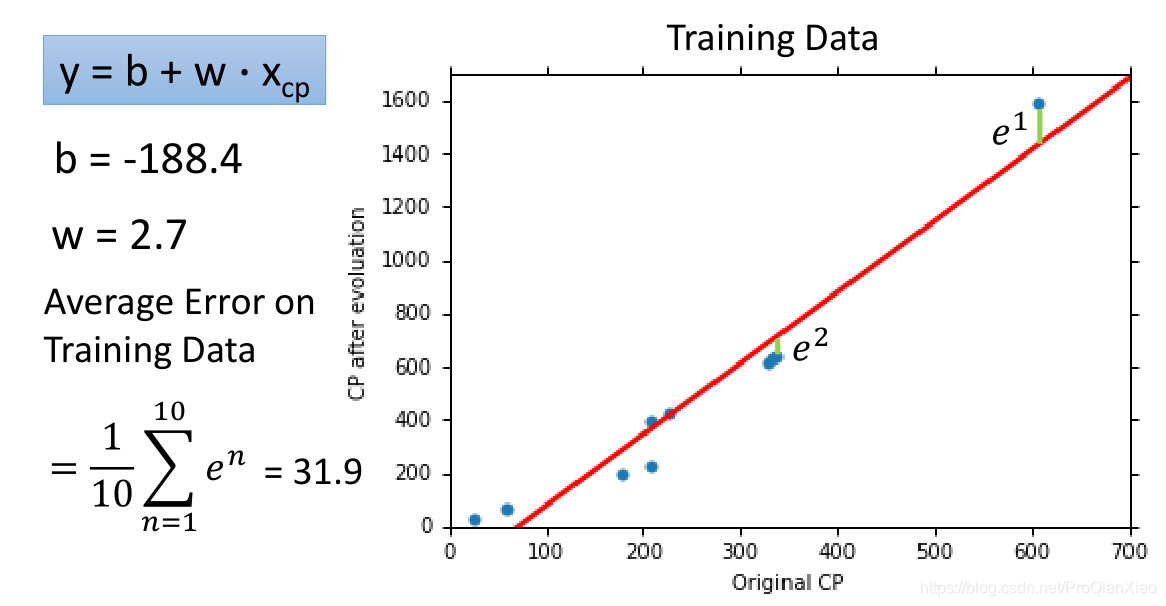

我们上面的线性模型,经过梯度下降算法,寻得一组最优参数,其结果表现如下:

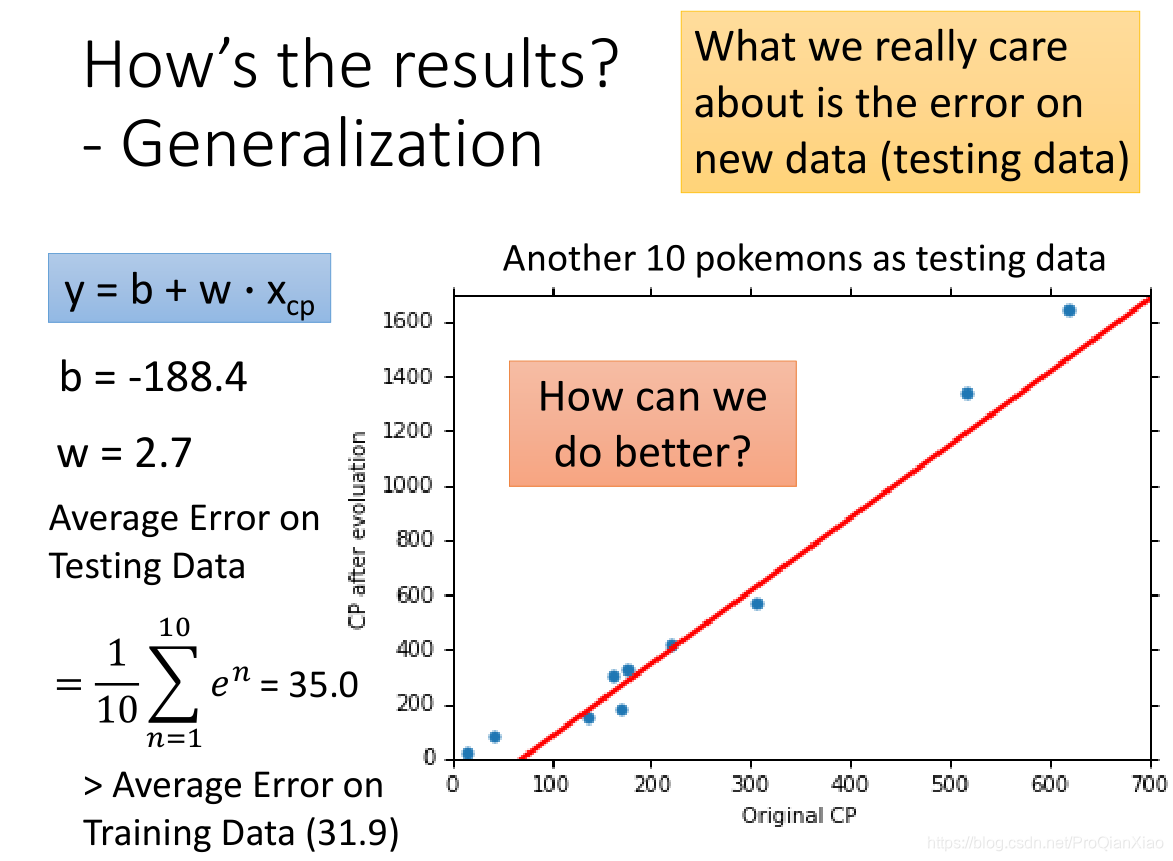

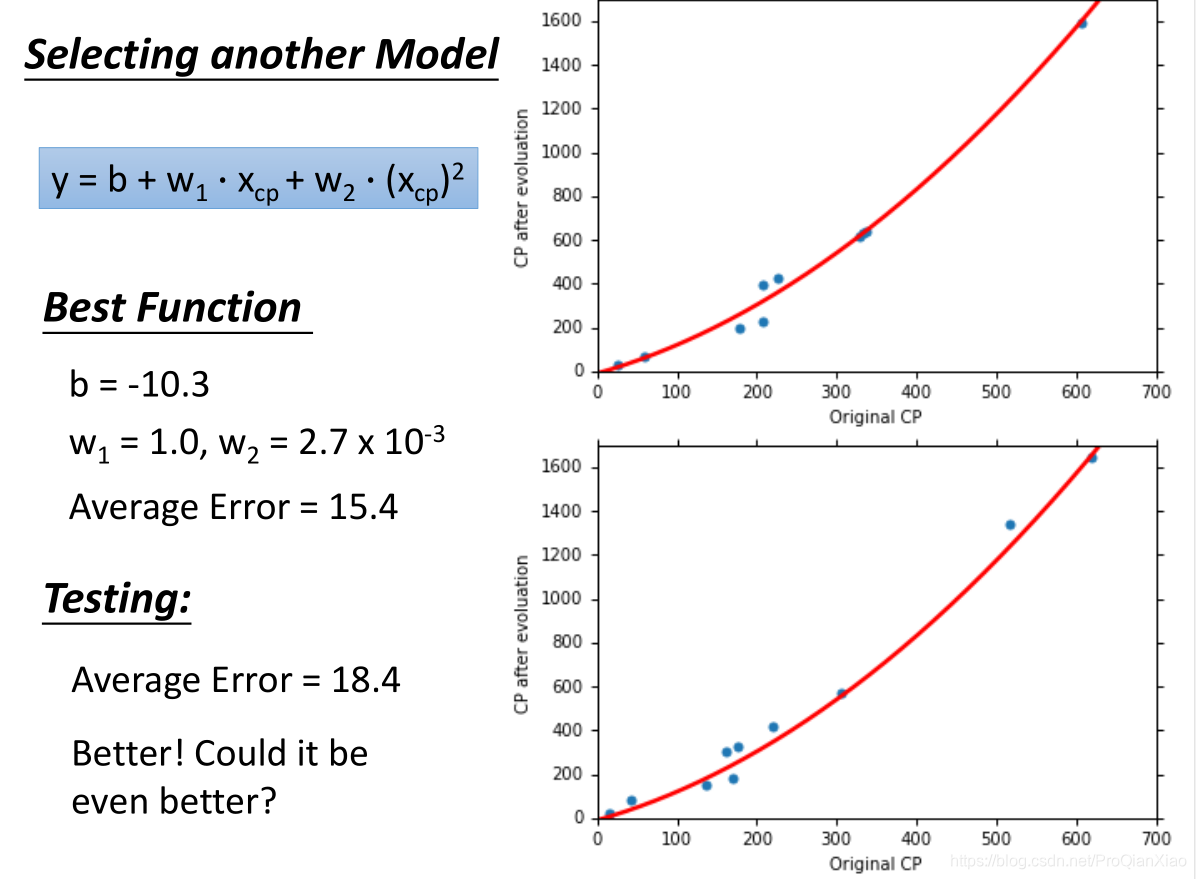

训练数据上面的损失函数值为31.9,测试数据上面损失函数值为35。在实际问题中,我们更加关注的是模型在测试集上面的性能表现,也就是模型的

泛化能力

,线性模型在测试集上面的误差较大,所以如果我们重新设计预测模型,使用更加复杂的模型,会不会得到更好的效果?

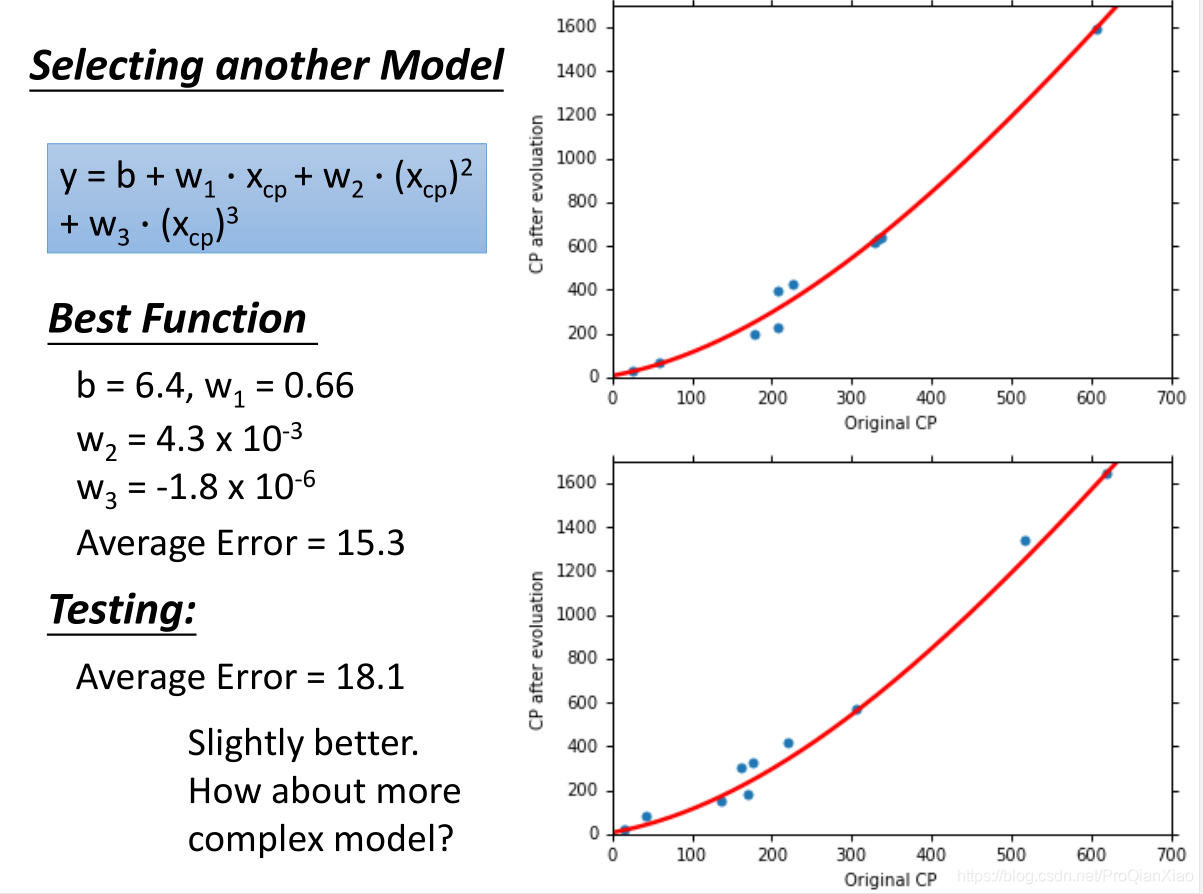

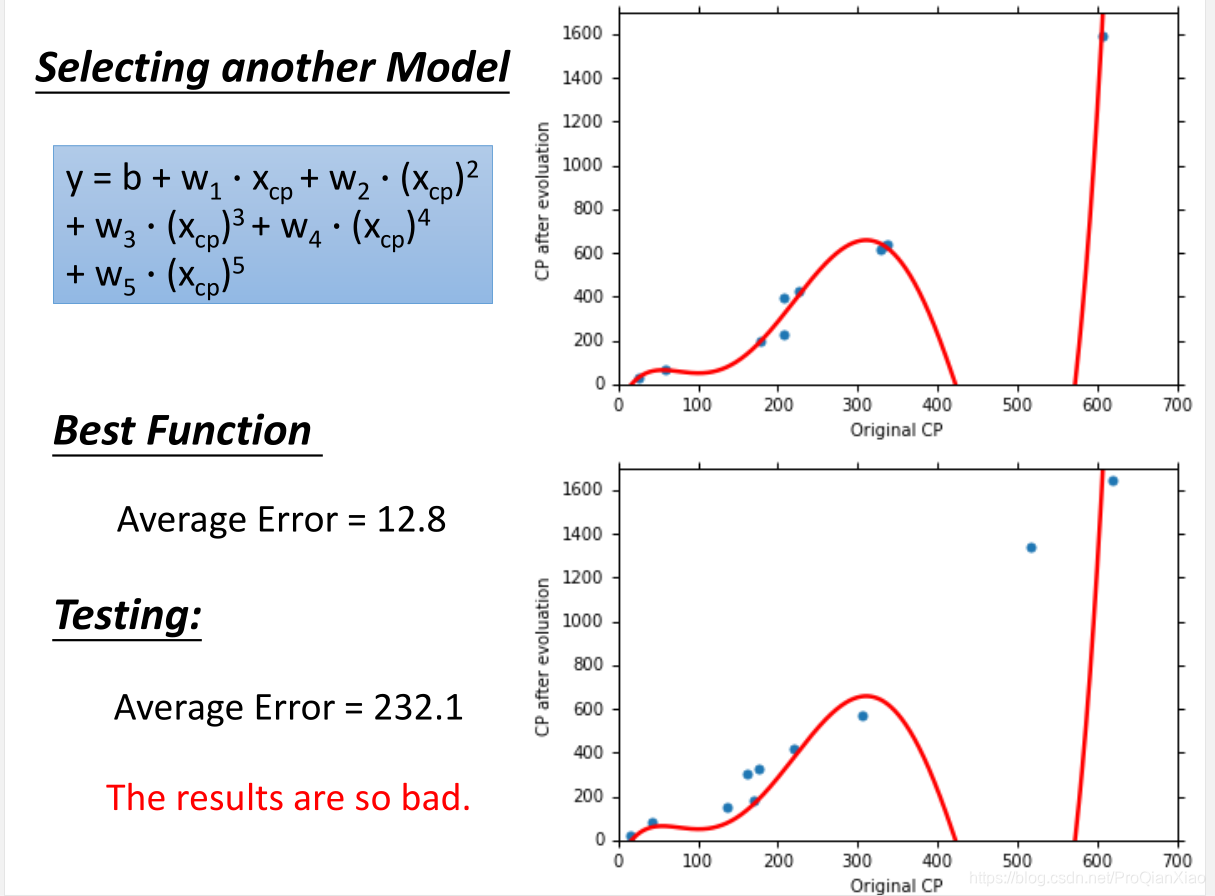

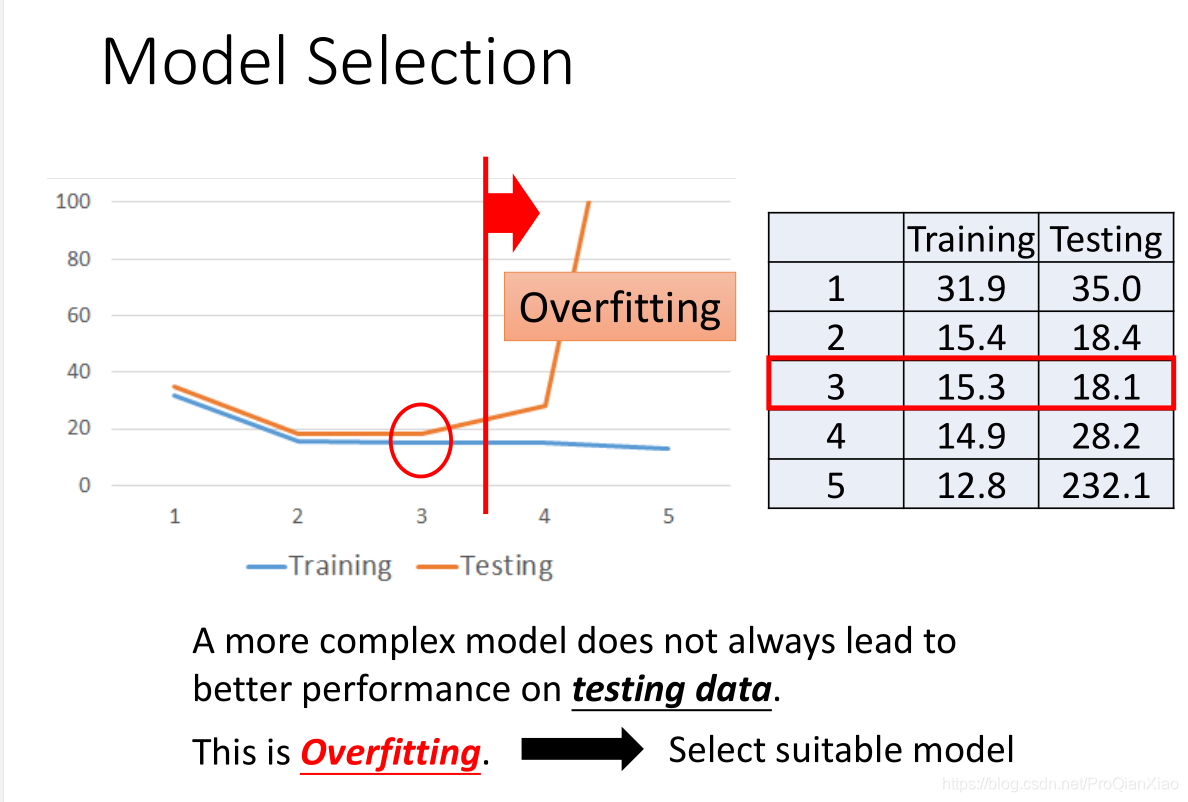

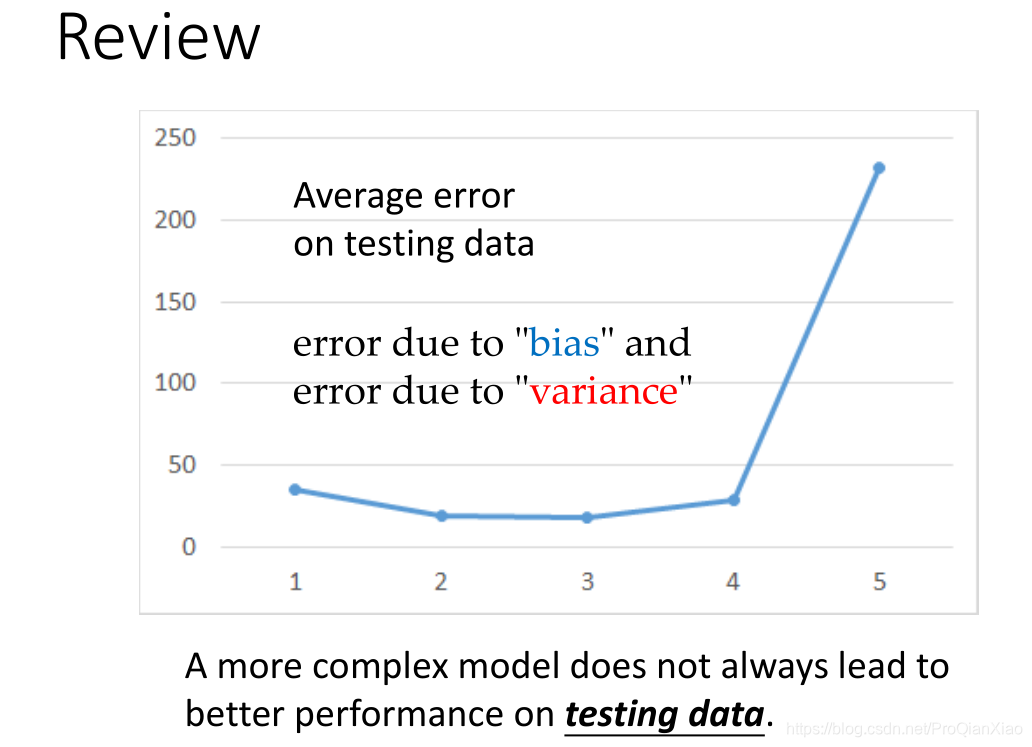

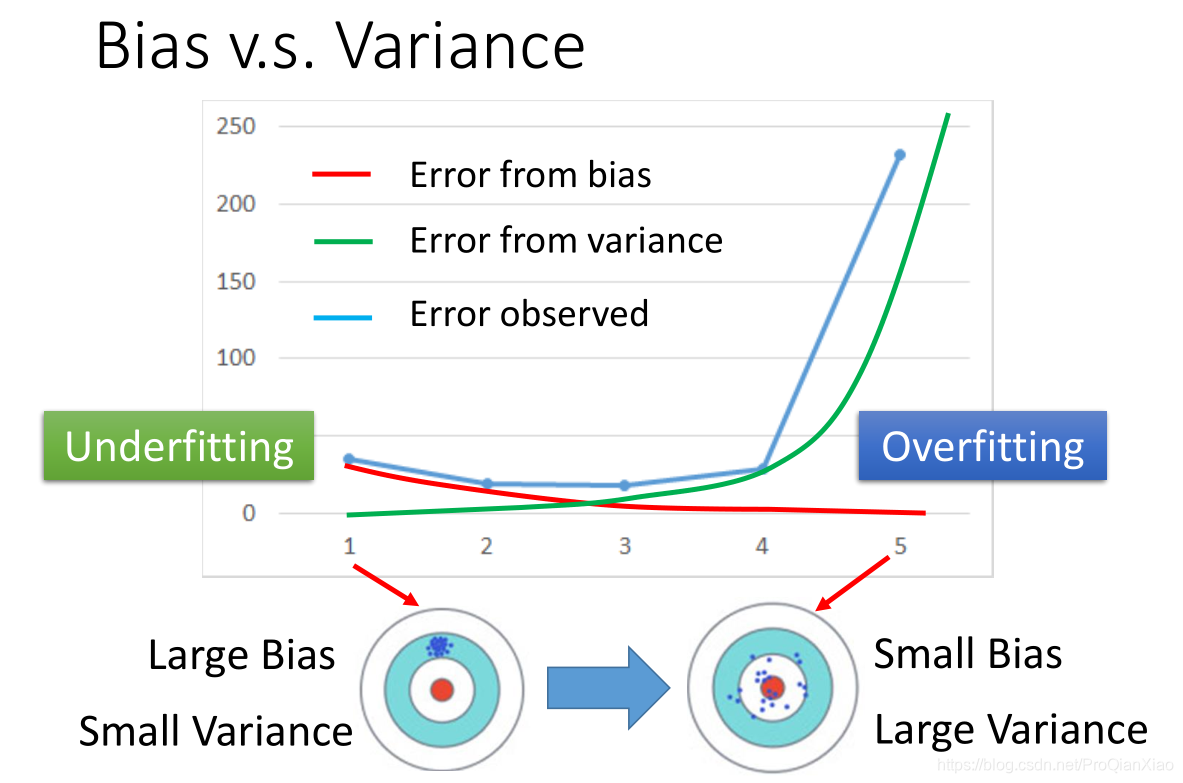

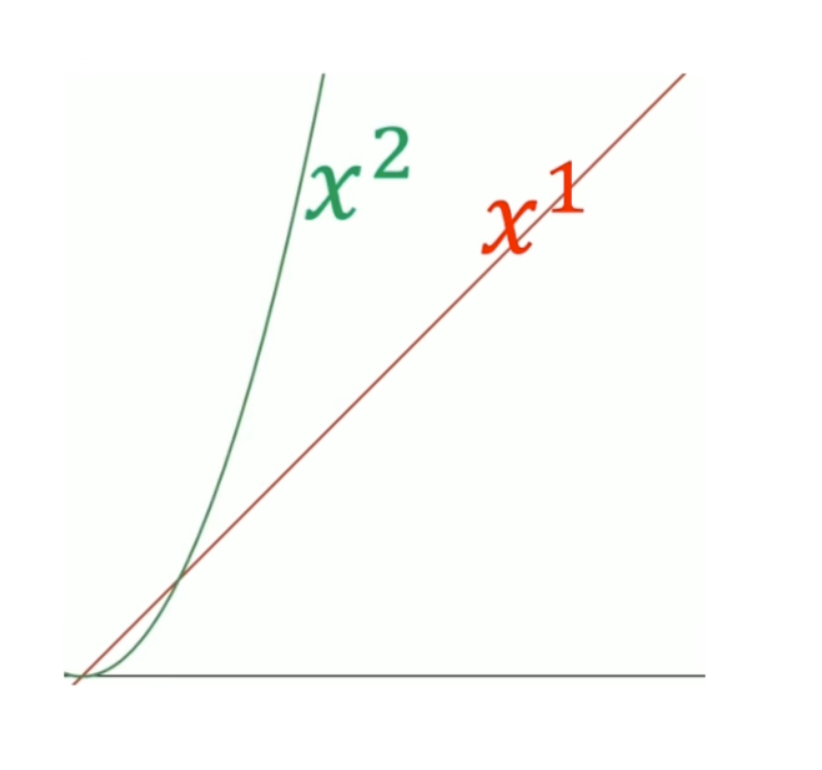

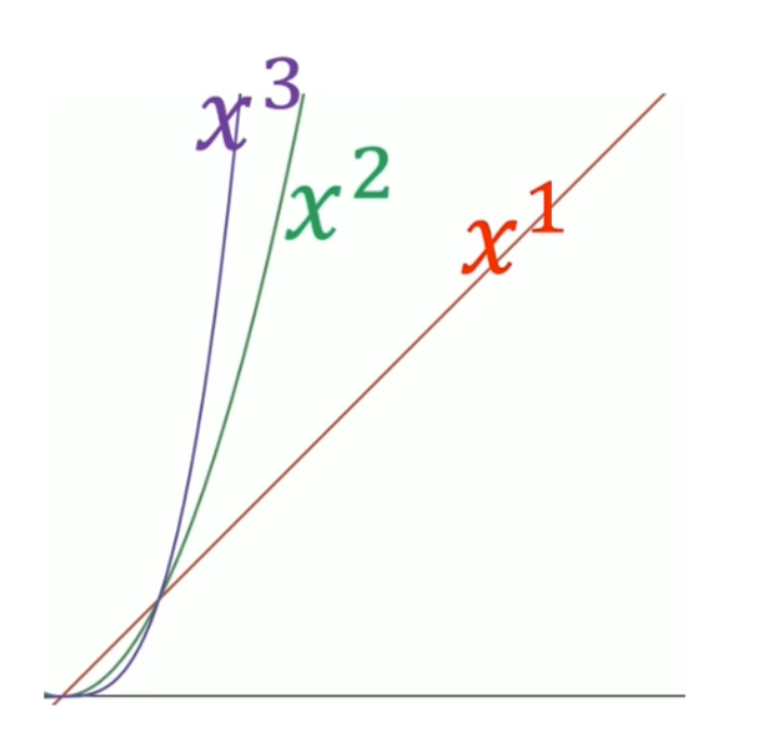

随着使用更加复杂的二次模型,三次模型,无论是在训练集还是测试集上面,效果都有提升。可是当继续增加模型的复杂度,使用四次模型的时候,虽然在训练集上面的loss更小,但是测试集上面的效果却变糟了。使用五次模型的时候,这一趋势更加明显:

虽然复杂的模型对于训练数据的拟合程度会更好,但是很容易出现过拟合的现象(过于严格的去拟合训练数据,当面对新数据的时候没有办法做出准确的预测,即无法泛化到其他数据)。

虽然复杂的模型对于训练数据的拟合程度会更好,但是很容易出现过拟合的现象(过于严格的去拟合训练数据,当面对新数据的时候没有办法做出准确的预测,即无法泛化到其他数据)。

在机器学习模型训练过程中,我们要尽量避免过拟合的现象,一方面要选择合适的模型,模型不是越复杂越好,可以通过交叉验证来选择合适的模型;另一方面,可以通过一些技术手段来帮助我们避免过拟合,比如正则化,early

stopping等等。

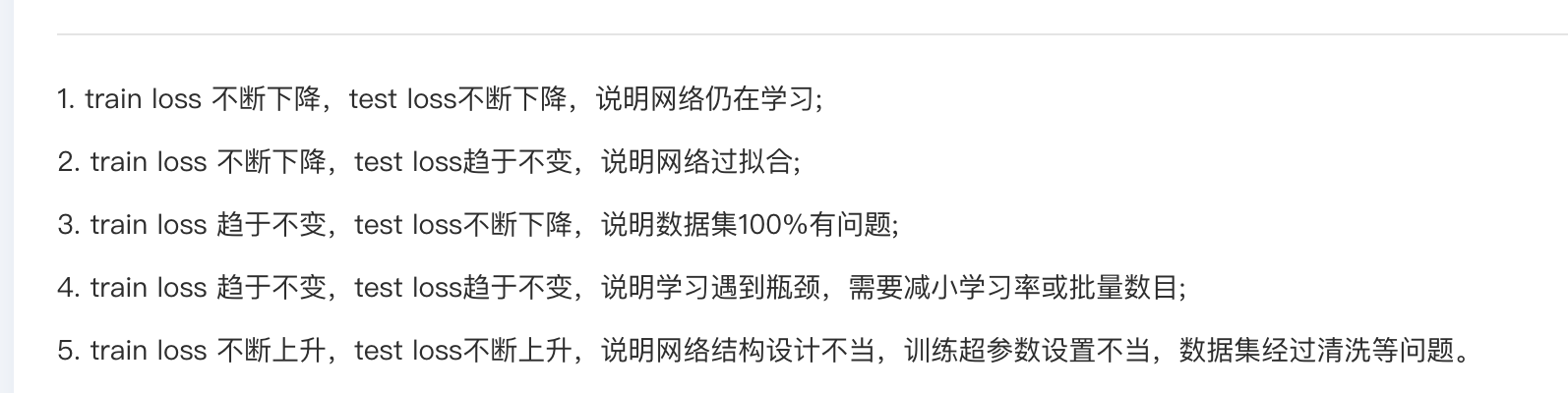

在机器学习模型训练过程中,我们要尽量避免过拟合的现象,一方面要选择合适的模型,模型不是越复杂越好,可以通过交叉验证来选择合适的模型;另一方面,可以通过一些技术手段来帮助我们避免过拟合,比如正则化,early

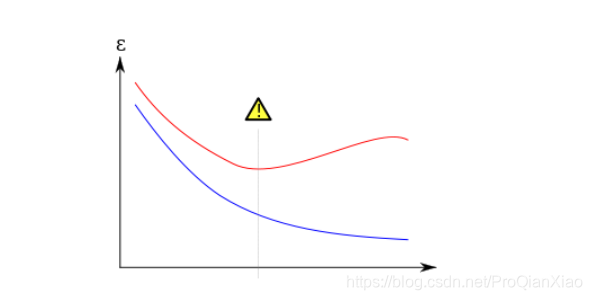

stopping等等。  如上图所示,蓝色线代表训练集上的损失函数,红色线代表验证集的损失函数,当训练进行到中间垂直的线段时,模型应该是最优的;如果继续训练,就会造成过拟合现象。

如上图所示,蓝色线代表训练集上的损失函数,红色线代表验证集的损失函数,当训练进行到中间垂直的线段时,模型应该是最优的;如果继续训练,就会造成过拟合现象。

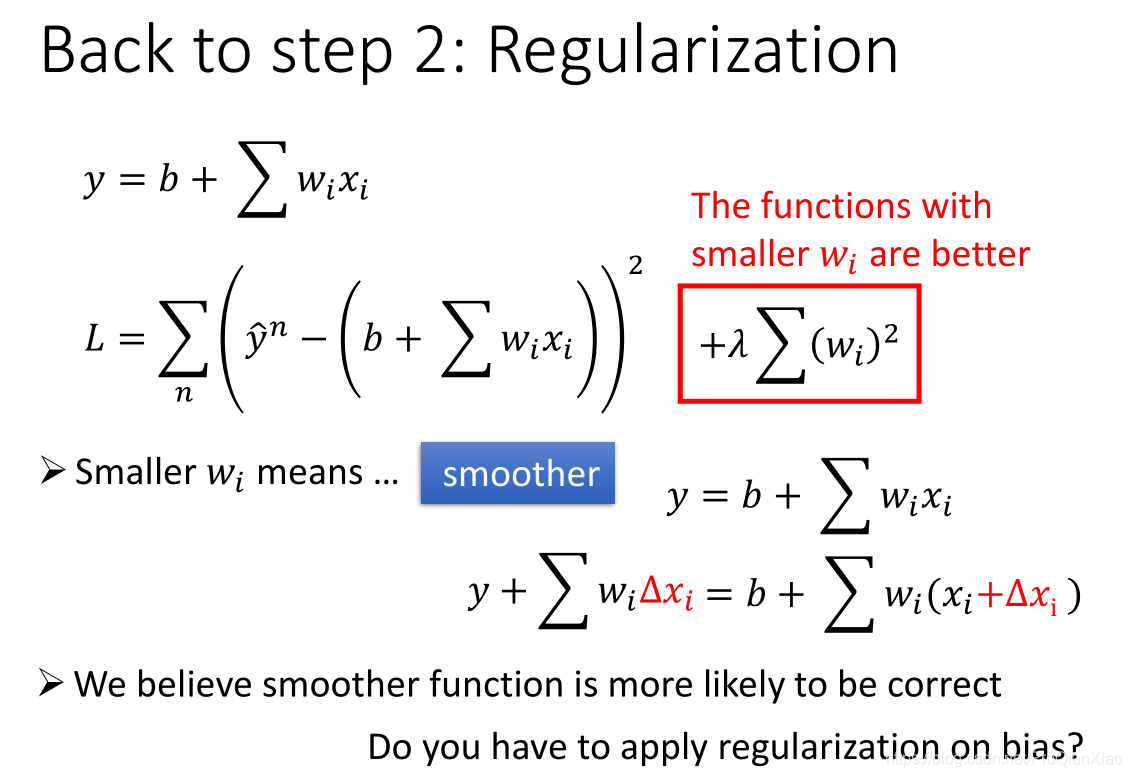

正则化

简单来说,正则化是一种为了减小测试误差的行为(有时候会增加训练误差)。我们在构造机器学习模型时,最终目的是让模型在面对新数据的时候,可以有很好的表现。当使用比较复杂的模型比如神经网络,去拟合数据时,很容易出现过拟合现象(训练集表现很好,测试集表现较差),这会导致模型的泛化能力下降,这时候,就需要使用正则化,降低模型的复杂度。

具体而言,正则化就是在损失函数后面增加一项惩罚项(对某些参数进行限制),使得我们的模型更加平滑。以上图为例,我们在损失函数后面增加一项关于参数w的正则项,限制参数w不要过大,这样模型会有更好的泛化能力。因为,这样对于测试数据中存在的噪声,会不那么敏感,即噪声对于预测的结果影响会降低。

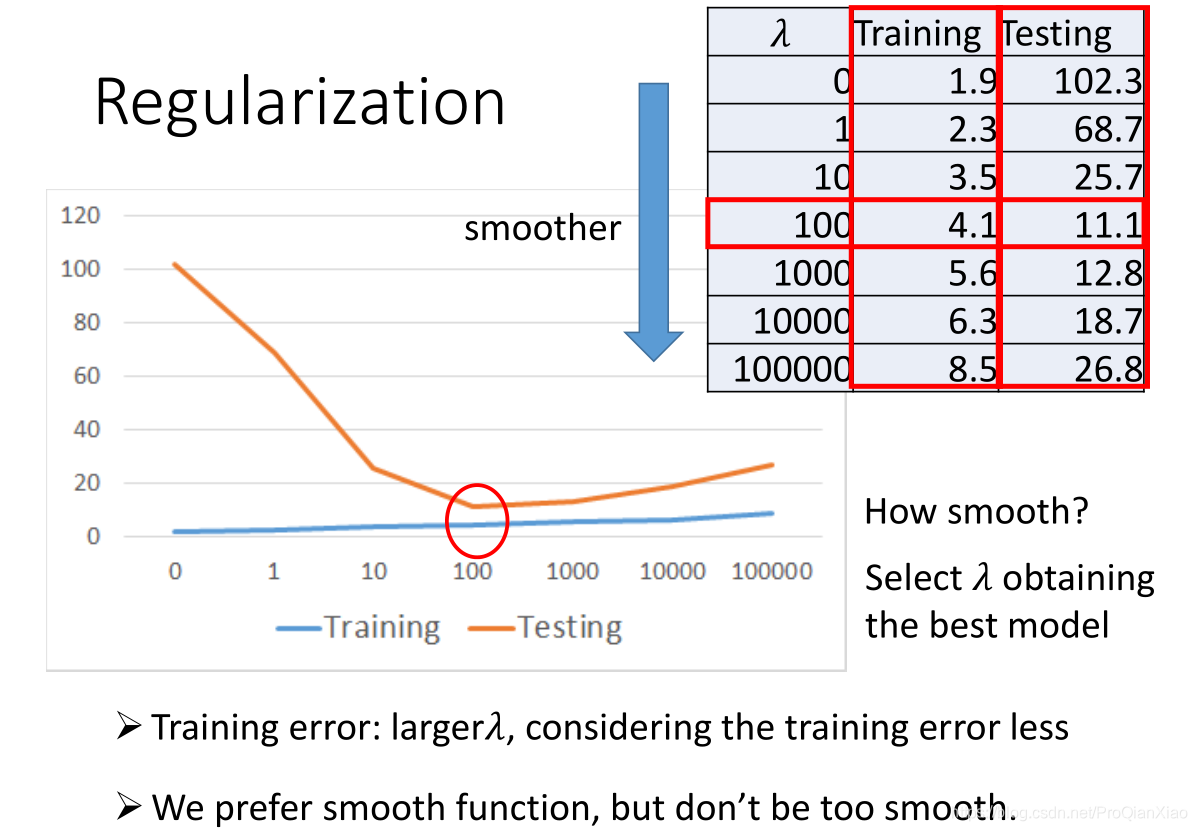

加入正则化技术之后,训练集和测试集上面的误差如下:

和我们的预期分析是一致的,加入正则化之后,参数

越大,表示我们越关注模型的平滑程度(也就是模型的泛化能力),相对于训练误差考虑较少,所以训练集上面的loss增大,测试集上面的loss降低。但是,参数

不是越大越好,我们希望得到一个比较平滑的函数,但是不能过于平滑(会丧失其预测能力)。

机器学习中的正则化概念

在机器学习中,正则化(Regularization)是一种用于防止过拟合(Overfitting)的技术。

过拟合是指模型在训练数据上表现得非常好,但在新的、未见过的数据上表现不佳。这通常是因为模型过于复杂,学习到了训练数据中的噪声和特定的细节,而不是一般性的模式。

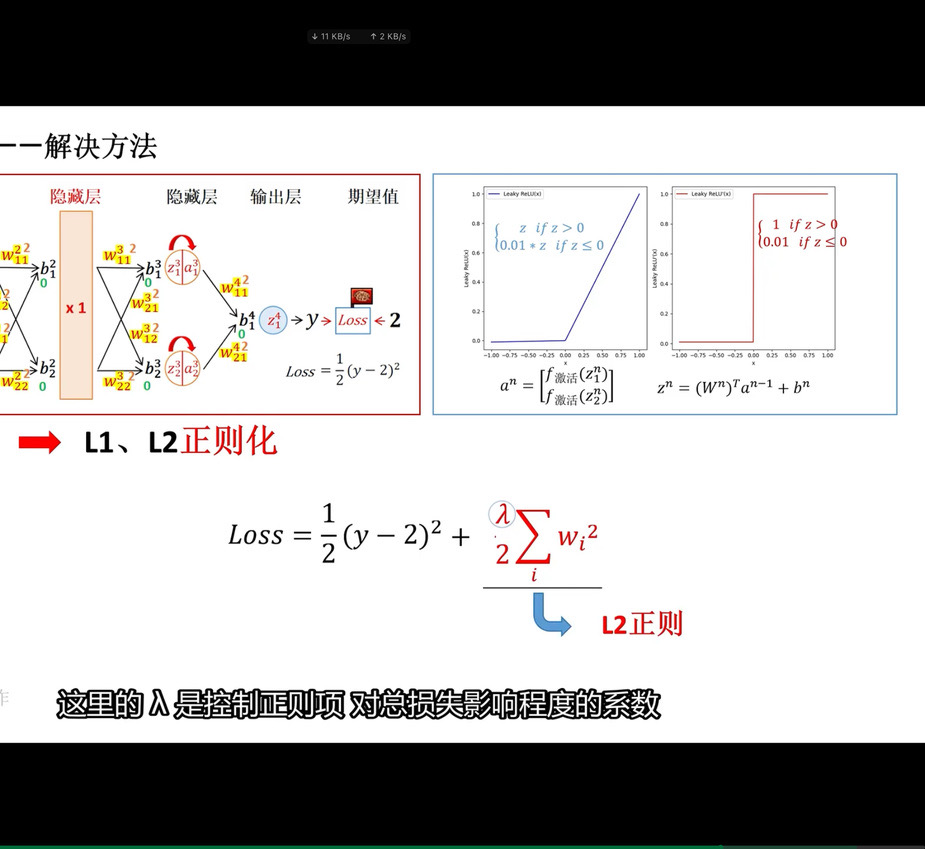

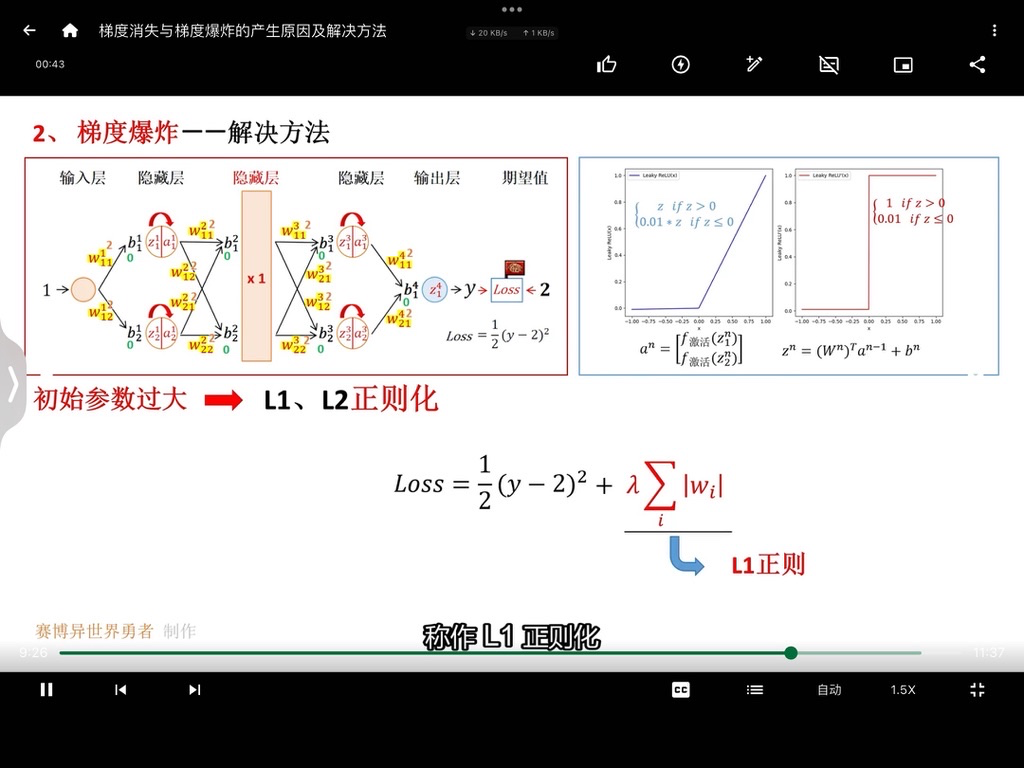

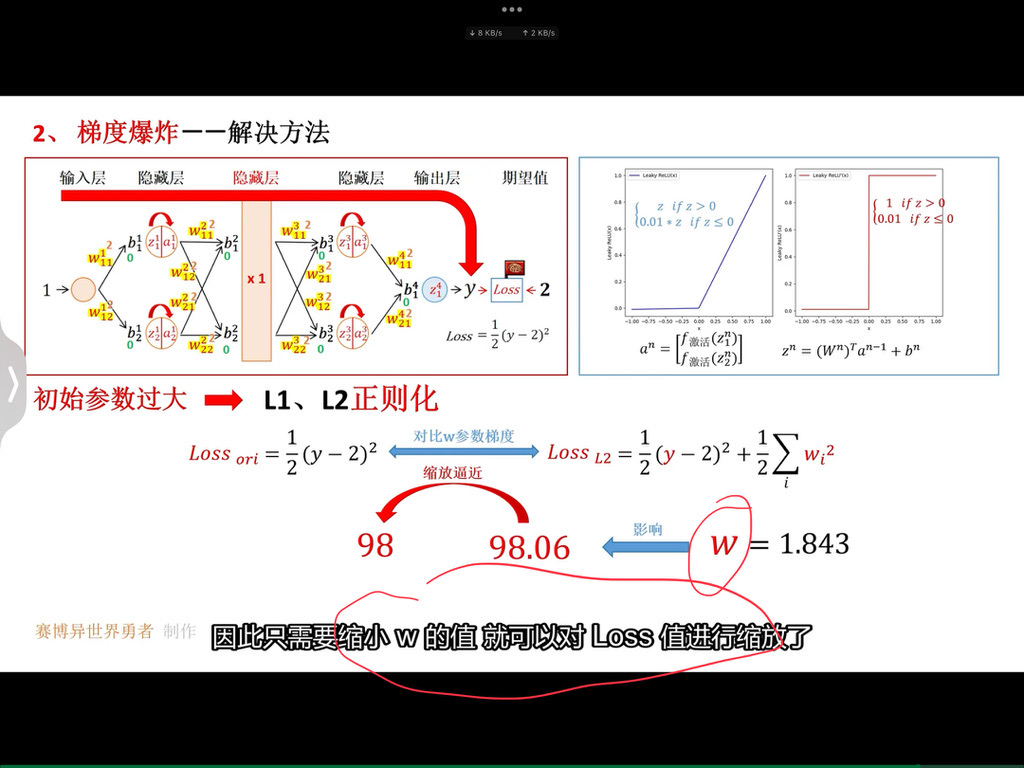

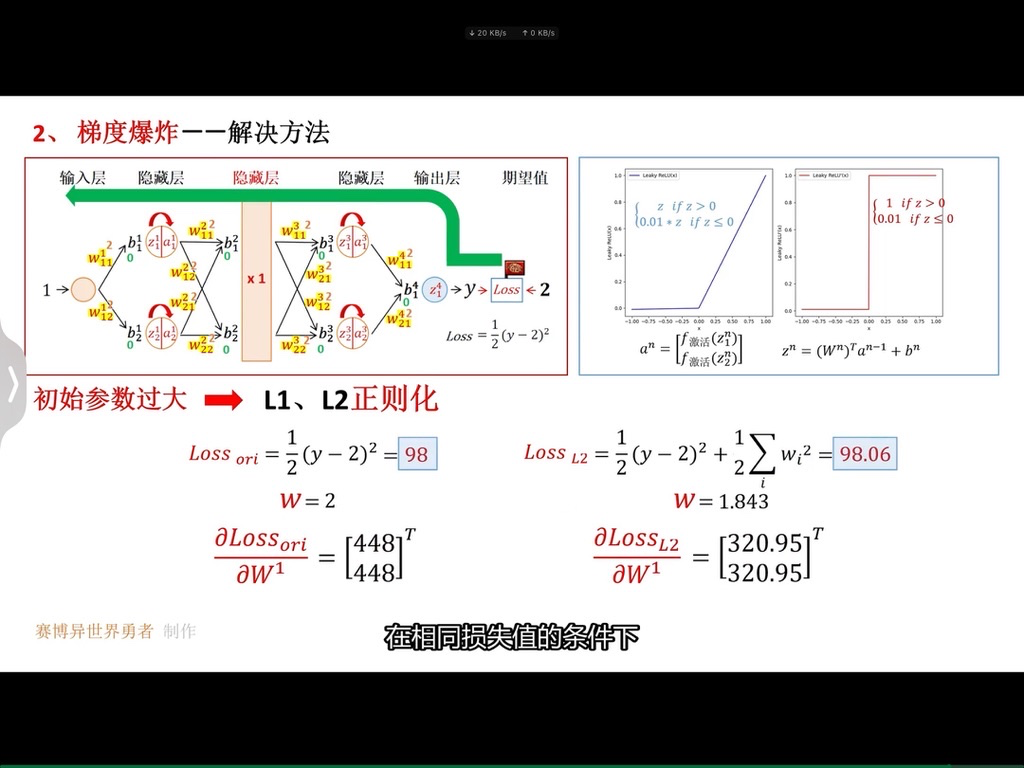

正则化通过在损失函数中添加一个惩罚项来限制模型的复杂度。常见的正则化方法有 L1 正则化和 L2 正则化。

L1 正则化:也称为 Lasso 正则化,它在损失函数中添加的惩罚项是模型参数的绝对值之和。L1 正则化具有特征选择的效果,因为它可能会将一些不重要的特征对应的参数压缩至零。

例如,在线性回归中,假设模型的预测函数为

y = w1 * x1 + w2 * x2 +... + wn * xn + b ,L1 正则化项就是

λ * |w1| + λ * |w2| +... + λ * |wn| ,其中 λ

是正则化参数,控制正则化的强度。

L2 正则化:也称为 Ridge 正则化,它在损失函数中添加的惩罚项是模型参数的平方和。L2 正则化会使模型的参数值趋向于较小的值,但不太会将参数压缩至零。

同样在线性回归中,L2 正则化项就是

λ * (w1^2 + w2^2 +... + wn^2) 。

正则化的作用:

- 控制模型复杂度:通过限制模型的参数大小,防止模型过于复杂。

- 提高模型泛化能力:使模型能够更好地应对新的数据,减少过拟合的风险。

举例说明: 假设我们正在训练一个神经网络来识别图像中的猫和狗。如果没有正则化,模型可能会过度学习训练数据中的细微特征,比如图片中的背景颜色或微小的噪声,导致在新的图像上识别准确率下降。

当我们应用 L2 正则化时,模型的参数会受到一定的约束,不会变得过大。这可能会导致模型在训练数据上的准确率稍微降低,但在测试数据上的表现会更好,因为它学习到了更通用的特征,而不是过度依赖于特定的训练样本。

总之,正则化是机器学习中非常重要的技术,有助于提高模型的性能和稳定性。

遗留问题

1、在机器学习中,只要损失函数是可微的,就可以使用梯度下降算法进行参数的求解,那么怎么判断损失函数是否可微?(后面解释)

2、不过对于上面回归问题中,损失函数为平方差之和,该损失函数为凸函数,没有局部最优点,只有全局最优点。那么如何判断一个函数是否为凸函数?(后面解释)

判断一个矩阵是不是半正定矩阵,方法之一是判断该矩阵的所有主子式是不是非负;对于上面的海森矩阵,其所有主子式为:

半正定矩阵

半正定矩阵是矩阵理论中的一个重要概念。

一个实对称矩阵 A

被称为半正定矩阵,如果对于任意的非零实向量 x ,都有

x^T Ax ≥ 0 。

性质 :

- 半正定矩阵的所有特征值都是非负的。

- 半正定矩阵的主子式都非负。

- 半正定矩阵与另一个半正定矩阵的和仍是半正定矩阵。

在实际的机器学习和优化问题中,Hessian 矩阵具有重要的地位。

计算方面: 计算 Hessian 矩阵可能是计算密集型的,特别是对于具有大量参数的模型。在深度学习中,直接计算完整的 Hessian 矩阵通常是不现实的。然而,可以使用近似方法或针对特定结构的模型进行简化计算。例如,对于一些具有简单结构的神经网络,可能通过一些技巧来估计 Hessian 矩阵的部分元素。

应用方面:

- 优化算法:如牛顿法及其变体,利用 Hessian

矩阵来确定搜索方向和步长。相比于梯度下降法只依赖一阶导数(梯度),牛顿法考虑了二阶导数信息,能够在一些情况下更快地收敛到最优解。

- 举例来说,在求解一个二次函数的最小值时,牛顿法通过一次迭代就可以直接到达最小值点,因为它准确地利用了 Hessian 矩阵的信息。

- 模型分析:帮助理解模型的性质和行为。通过分析 Hessian

矩阵的特征值和特征向量,可以了解模型在不同方向上的敏感度和曲率,从而洞察模型的稳定性和鲁棒性。

- 例如,在图像分类任务中,如果 Hessian 矩阵的某些特征值很大,说明模型在对应的特征方向上变化剧烈,可能对输入的微小变化非常敏感。

- 正则化:可以用于设计一些基于二阶信息的正则化方法,以防止过拟合。

- 比如,通过对 Hessian 矩阵进行某种变换或约束,使得模型的复杂度得到控制。

总之,尽管在实际中直接处理 Hessian 矩阵存在困难,但通过巧妙的近似和应用,它仍然为解决机器学习和优化问题提供了有价值的见解和工具。

梯度下降算法

梯度下降算法是机器学习领域最广为人知、用途最广的优化算法,用来确定模型的参数(包括随机梯度下降SGD,Momentum,Adam等)。首先回顾一下梯度下降的计算过程:

梯度下降中常用技巧(Tips)

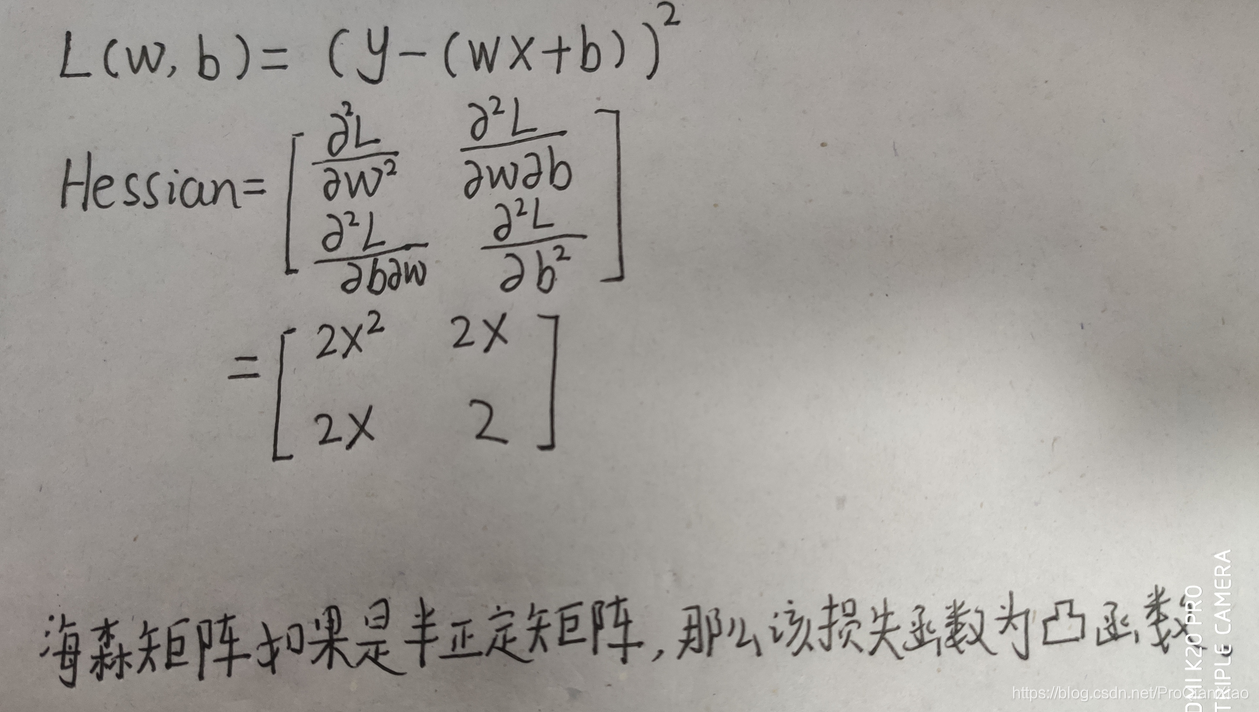

一、调整学习率

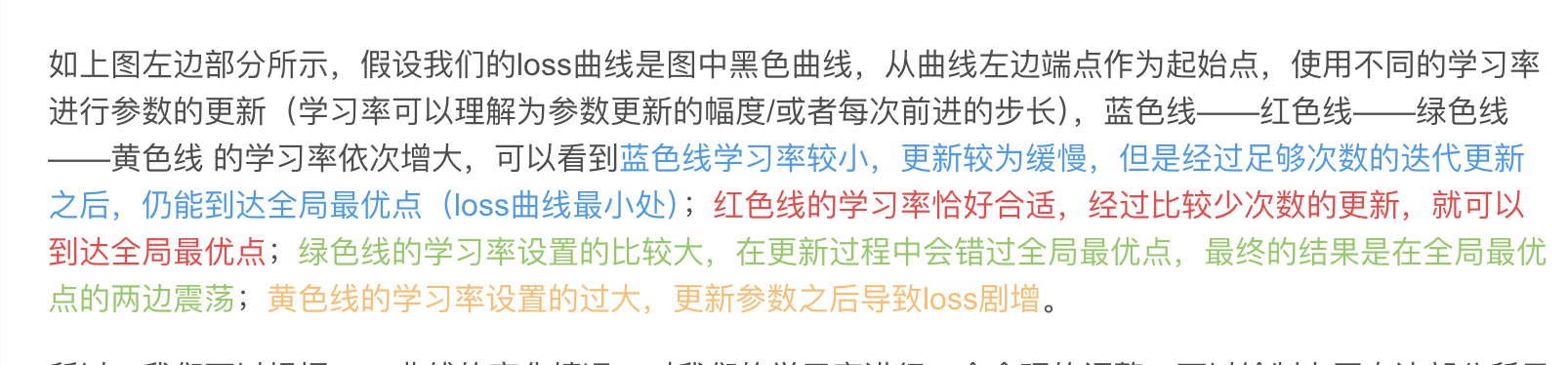

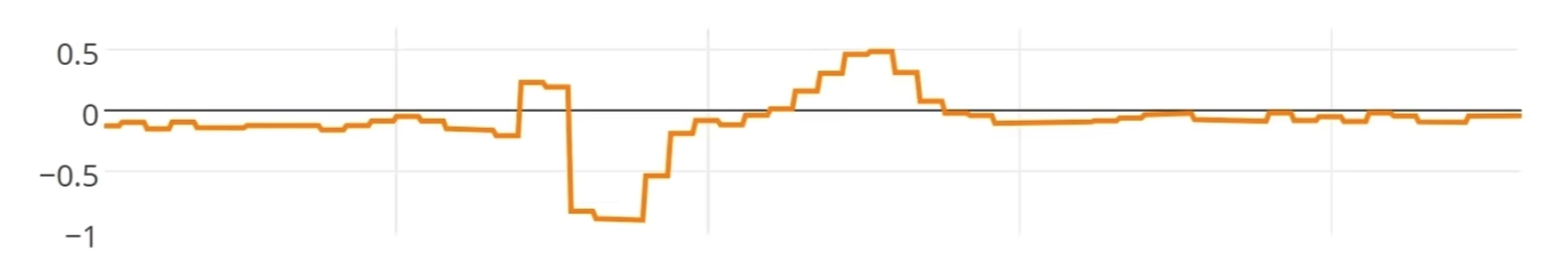

所以,我们可以根据Loss曲线的变化情况,对我们的学习率进行一个合理的调整。可以绘制上图右边部分所示的曲线图,横轴代表参数更新次数,纵轴代表Loss值,学习率的大小分为四种情况:

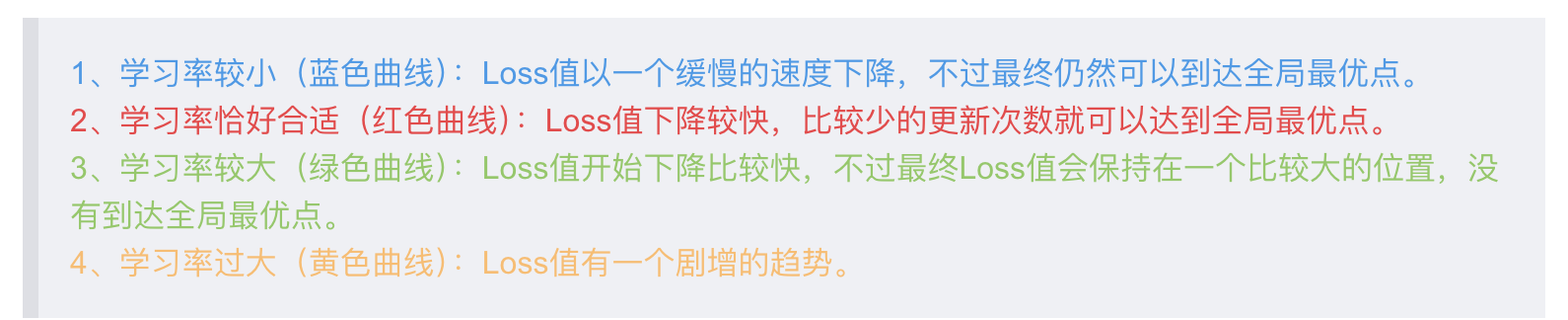

在学习率的设置过程中,常见的做法是,进行 学习率的衰减 。

在模型训练初期,距离全局最优点较远,可以设置一个相对大一些的学习率,随着训练的进行,距离全局最优点的距离越来越小,此时应该减小学习率;所以让学习率随着时间或者更新的次数进行衰减。

除了学习率的衰减之外,另外一个做法是:为不同的参数设置不同的学习率。也就是接下来要介绍的一种优化算法AdaGrad。

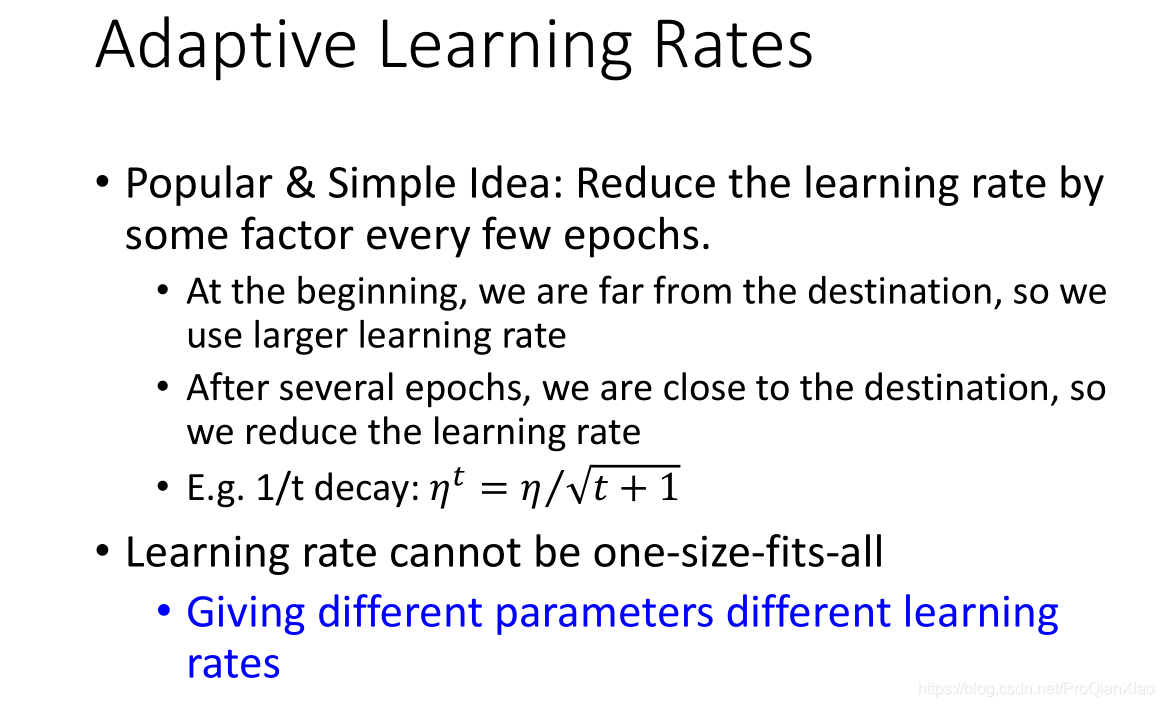

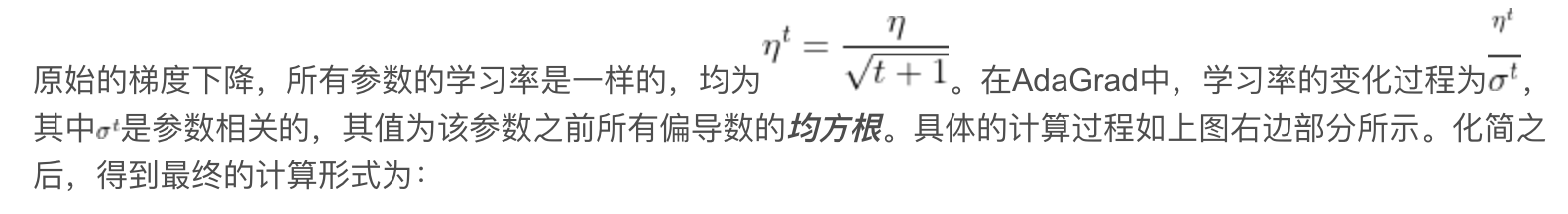

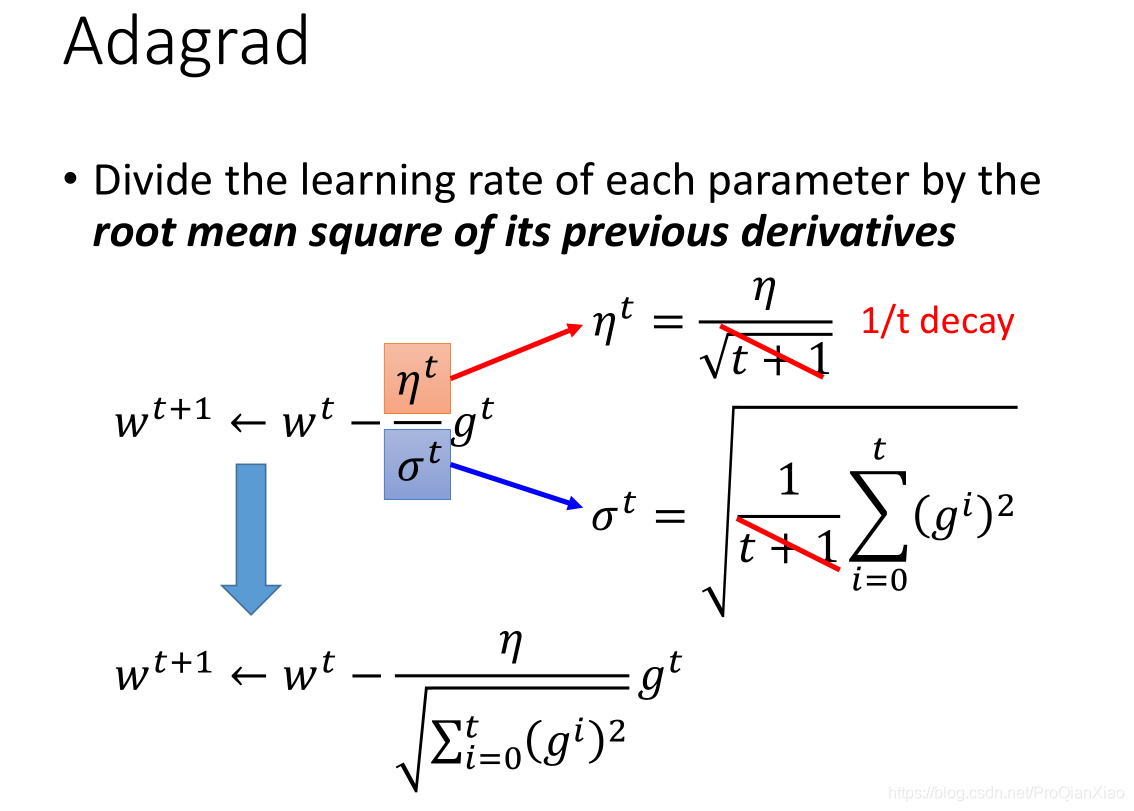

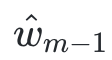

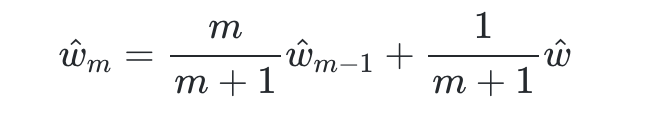

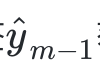

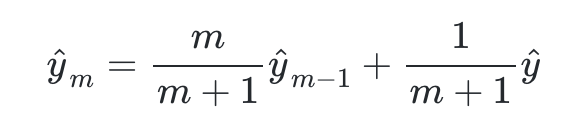

AdaGrad优化器

AdaGrad(Adaptive Gradient Algorithm)是一种自适应学习率的方法,用于优化机器学习模型,特别是在处理稀疏数据和高维数据时表现出色。AdaGrad的主要特点是它为每个参数维护一个单独的学习率,并根据之前的梯度信息调整这些学习率。

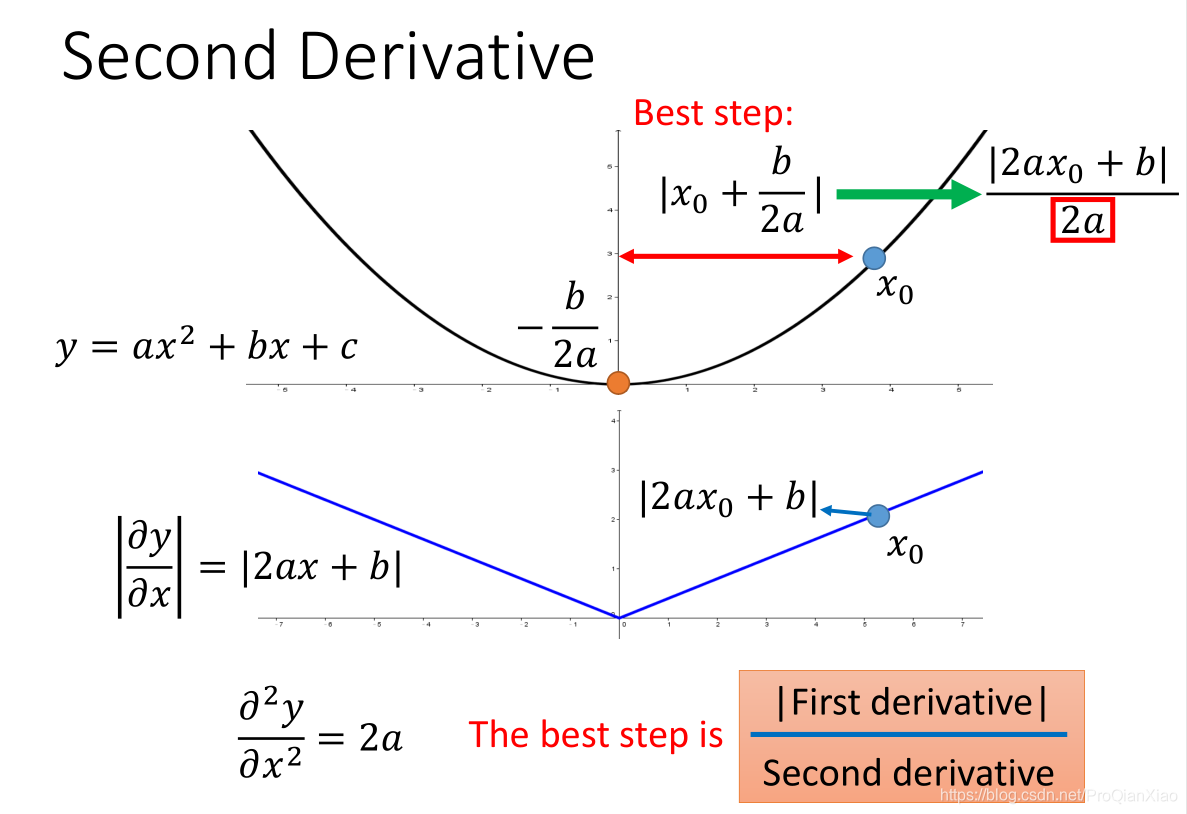

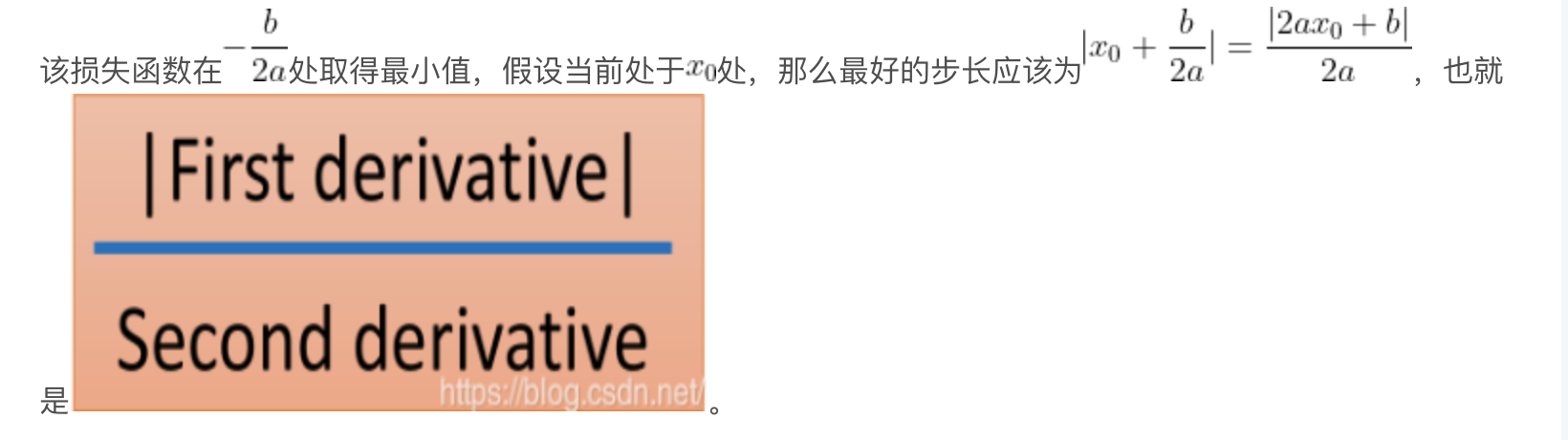

AdaGrad根据自变量在每个维度的梯度值的大小来调整各个维度上的学习率,从而避免统一的学习率难以适应所有维度的问题,即为每个参数设置不同的学习率。具体来说,对于每个参数 θi,AdaGrad计算其所有历史梯度的平方和,并用这个和来缩放当前的梯度,从而得到更新步长。

这里需要注意的一点为:

而在AdaGrad中,正是这一思想的体现,不过为了减少计算量,增加运算速度,AdaGrad中使用过去一阶偏导数的均方根作为分母项(二阶偏导数)的近似。

而在AdaGrad中,正是这一思想的体现,不过为了减少计算量,增加运算速度,AdaGrad中使用过去一阶偏导数的均方根作为分母项(二阶偏导数)的近似。

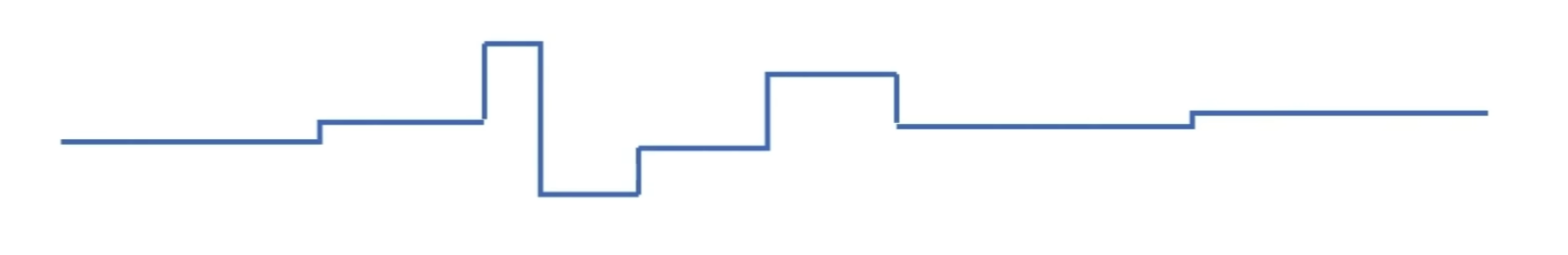

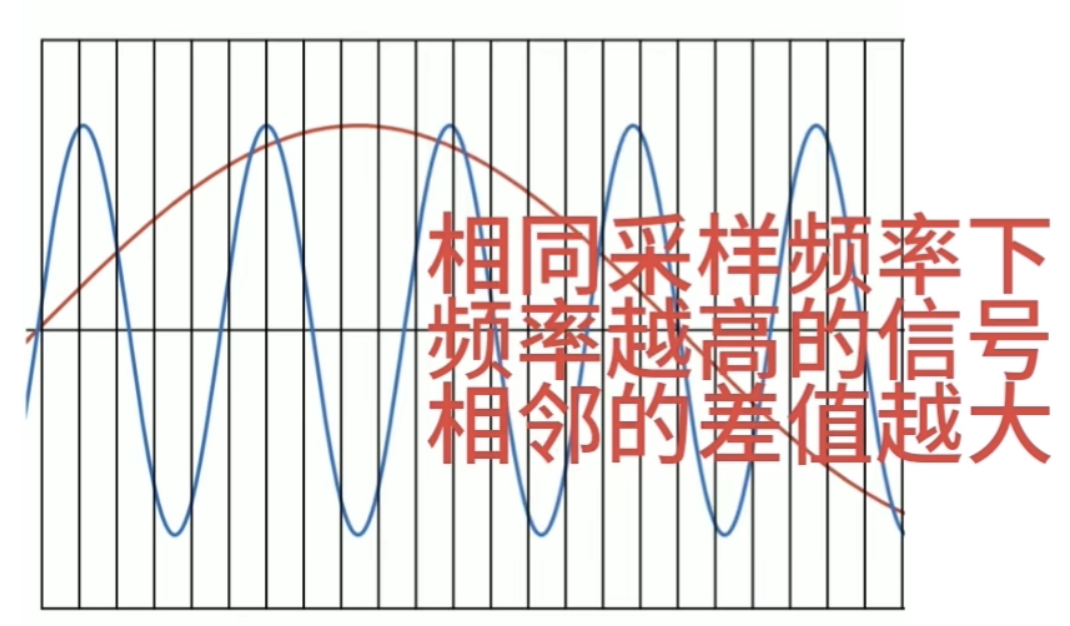

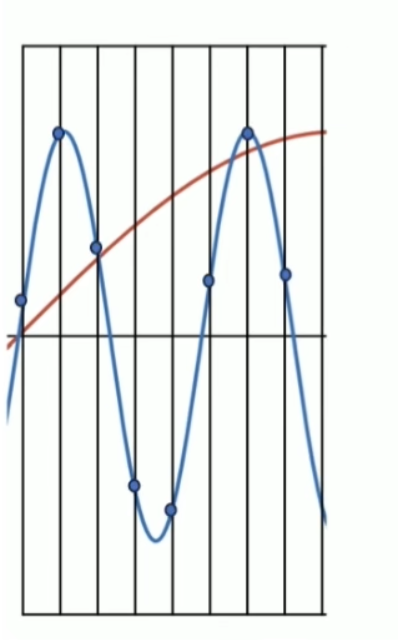

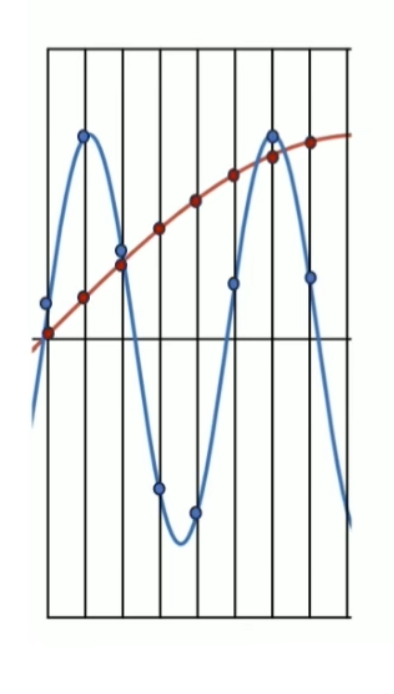

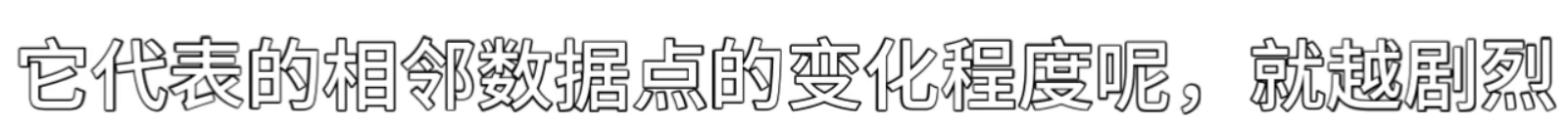

过去一阶偏导数的均方根可以在一定程度上反应二阶偏导的大小情况。如上图所示,二阶偏导小的函数,其采样的一阶偏导的值也相对较小。

过去一阶偏导数的均方根可以在一定程度上反应二阶偏导的大小情况。如上图所示,二阶偏导小的函数,其采样的一阶偏导的值也相对较小。

优势

- 自适应学习率 :不同参数有不同的学习率,能够更好地处理稀疏数据,使得更新幅度较大的参数的学习率更小,而更新幅度较小的参数的学习率更大。

- 简化调参 :由于学习率是自适应的,通常不需要频繁调整学习率超参数。

局限性

- 学习率过小 :随着时间的推移,累积梯度平方和不断增大,导致学习率逐渐缩小,可能会导致算法在后期学习变得非常缓慢。

- 不适用于所有问题 :虽然AdaGrad在处理稀疏数据上有优势,但对于某些问题,其性能可能不如其他优化算法,如RMSprop或Adam。

典型应用

AdaGrad常用于处理自然语言处理中的词嵌入、推荐系统中的用户行为数据等高维、稀疏数据场景。

总结来说,AdaGrad通过自适应地调整每个参数的学习率,在处理稀疏数据和高维数据时提供了显著的优势,但其逐渐减小的学习率可能在某些情况下限制其性能。

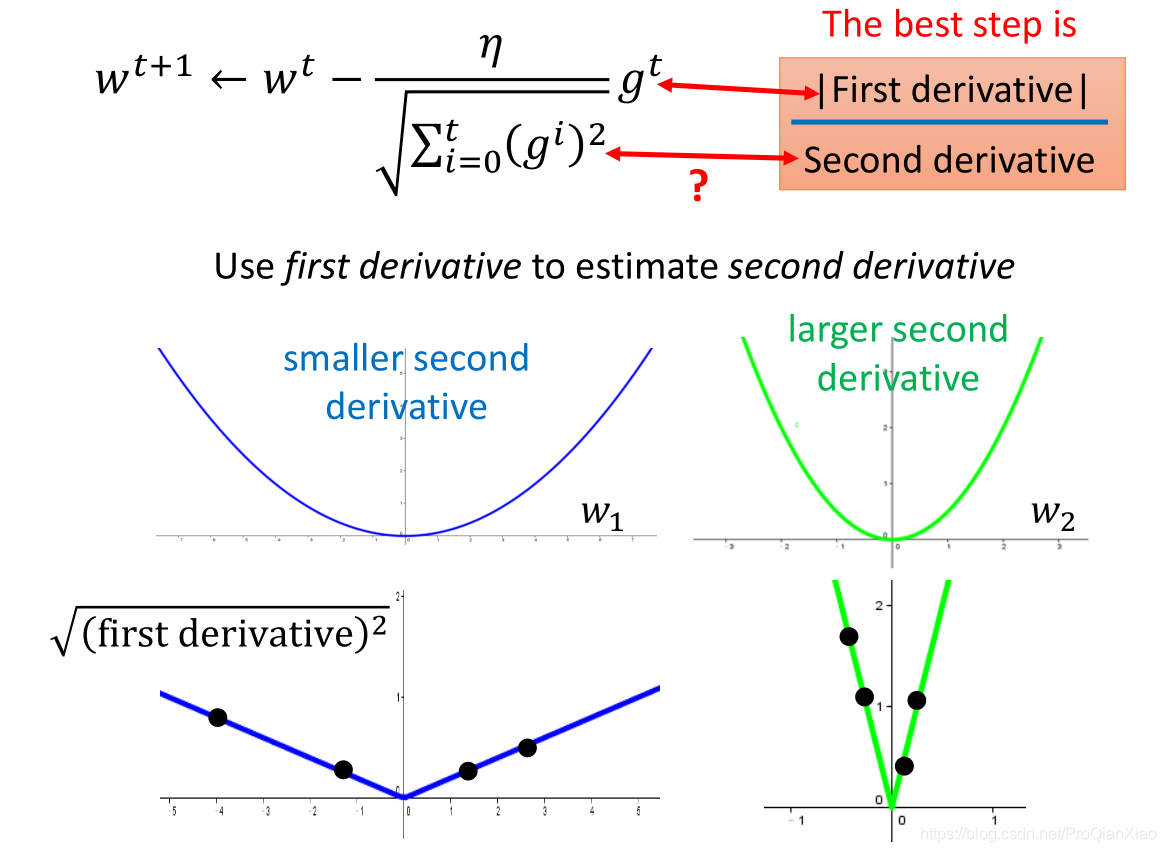

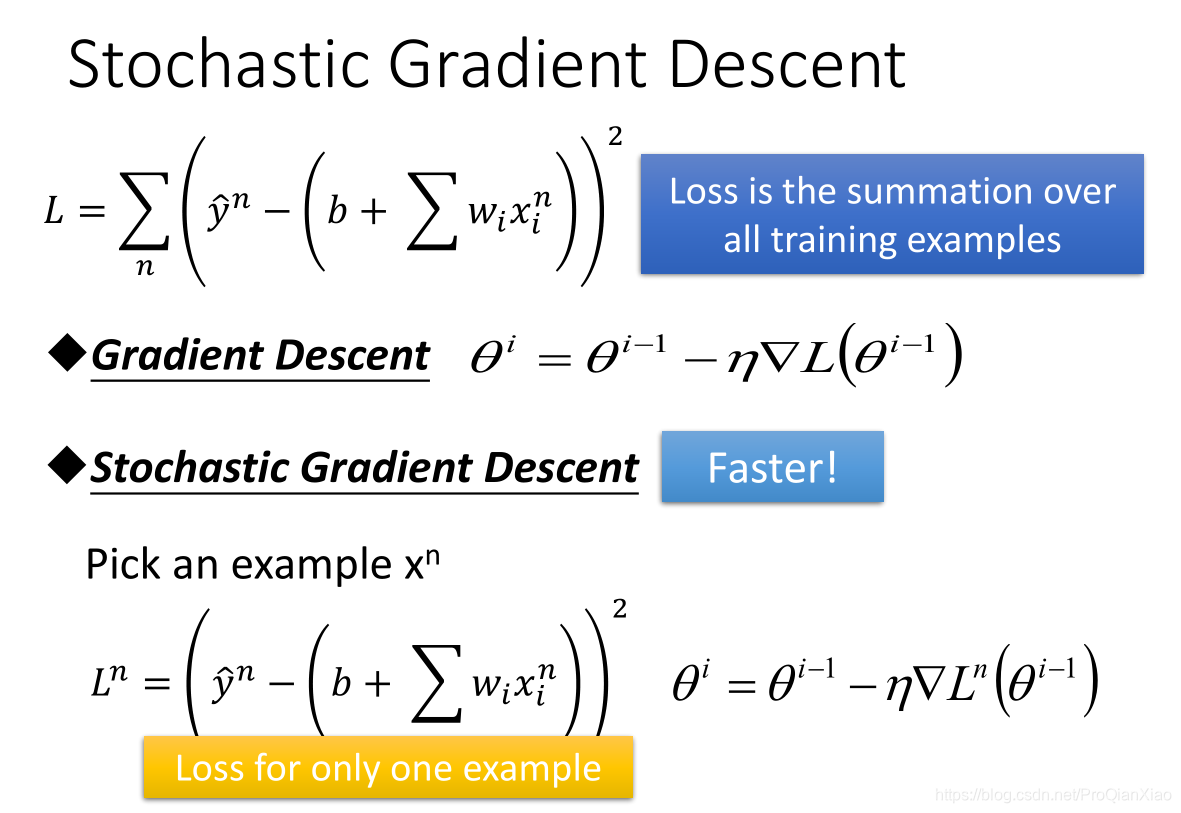

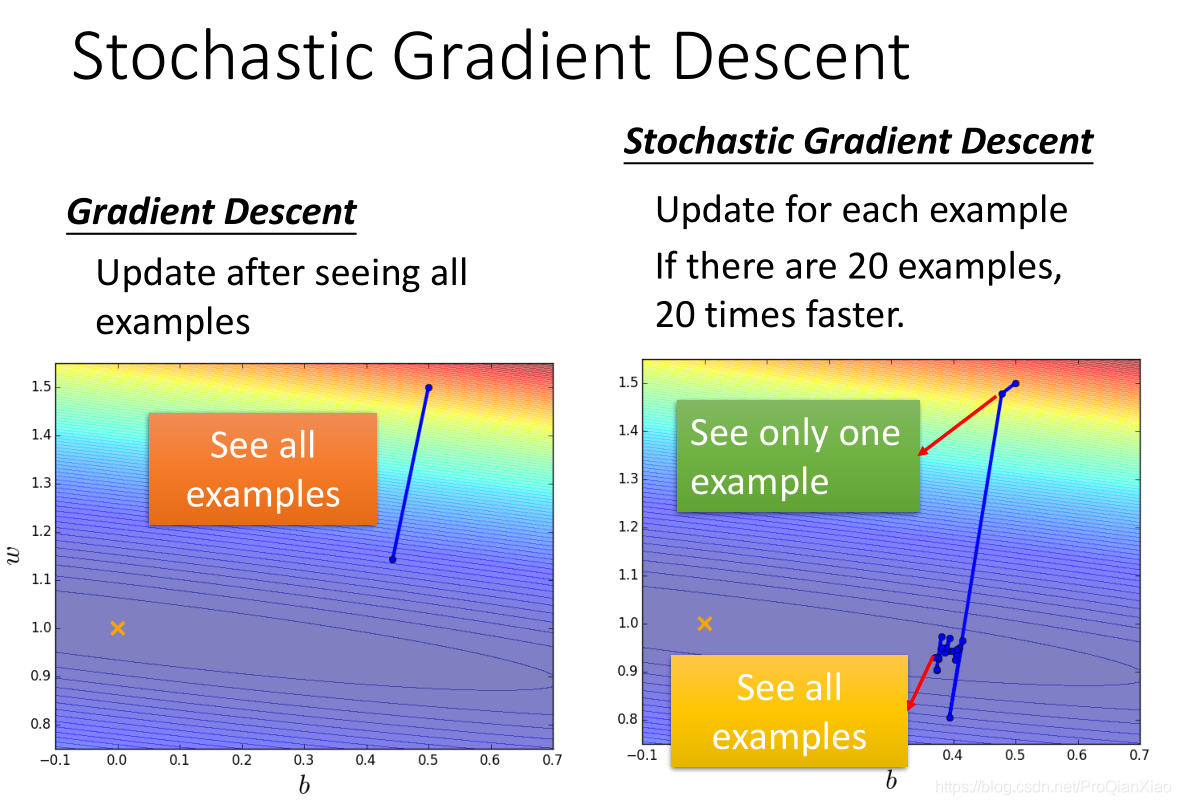

二、随机梯度下降(SGD)

随机梯度下降(SGD, Stochastic Gradient Descent)是一种用于优化机器学习模型参数的算法,特别适用于大规模数据集的训练。SGD与传统的批量梯度下降(Batch Gradient Descent)不同,它在每次迭代中仅使用一个样本或一个小批量的样本(mini-batch)来计算梯度和更新参数。这种方法具有较快的更新速度和更好的内存效率,特别是在处理大数据集时。

之前梯度下降算法中,Loss函数是对所有训练样本的Loss之和,而在随机梯度下降中,每次只采样一个样本,根据这一个样本进行一次梯度下降,所以随机梯度下降算法更新参数的过程更快。

之前梯度下降算法中,Loss函数是对所有训练样本的Loss之和,而在随机梯度下降中,每次只采样一个样本,根据这一个样本进行一次梯度下降,所以随机梯度下降算法更新参数的过程更快。

随机梯度下降(SGD, Stochastic Gradient Descent)是一种用于优化机器学习模型参数的算法,特别适用于大规模数据集的训练。SGD与传统的批量梯度下降(Batch Gradient Descent)不同,它在每次迭代中仅使用一个样本或一个小批量的样本(mini-batch)来计算梯度和更新参数。这种方法具有较快的更新速度和更好的内存效率,特别是在处理大数据集时。

优势

- 快速收敛:由于每次迭代只使用一个样本或小批量样本,更新频繁,收敛速度快。

- 内存效率:每次只需要加载一个样本或小批量样本,内存占用低,适合处理大规模数据集。

- 逃离局部最优:由于引入了随机性,SGD有助于跳出局部最优解,更容易找到全局最优解。

局限性

- 收敛波动:由于每次更新基于单个样本或小批量样本,导致参数更新不稳定,损失函数可能会剧烈波动。

- 调参困难:学习率的选择对SGD的性能影响很大,通常需要进行超参数调优。

改进方法

为了解决SGD的一些局限性,提出了多种改进算法,如:

- Mini-batch SGD:在每次迭代中使用一个小批量样本,而不是单个样本,平衡了收敛速度和稳定性。

- 动量(Momentum):在参数更新时引入动量项,利用之前梯度的指数加权平均来加速收敛。

- RMSprop:自适应调整学习率,缓解学习率逐渐减小的问题。

- Adam:结合了动量和RMSprop的优点,自适应地调整学习率。

应用场景

SGD广泛应用于深度学习和机器学习的各种模型训练中,包括神经网络、线性回归、逻辑回归等。它特别适用于大规模数据集和在线学习场景。

总结来说,SGD通过随机选择样本来进行参数更新,提供了快速且内存高效的优化方法,但其波动性和学习率调优是需要注意的问题。改进的变种算法如Mini-batch SGD、动量、RMSprop和Adam在实践中被广泛采用,以提高SGD的性能和稳定性。

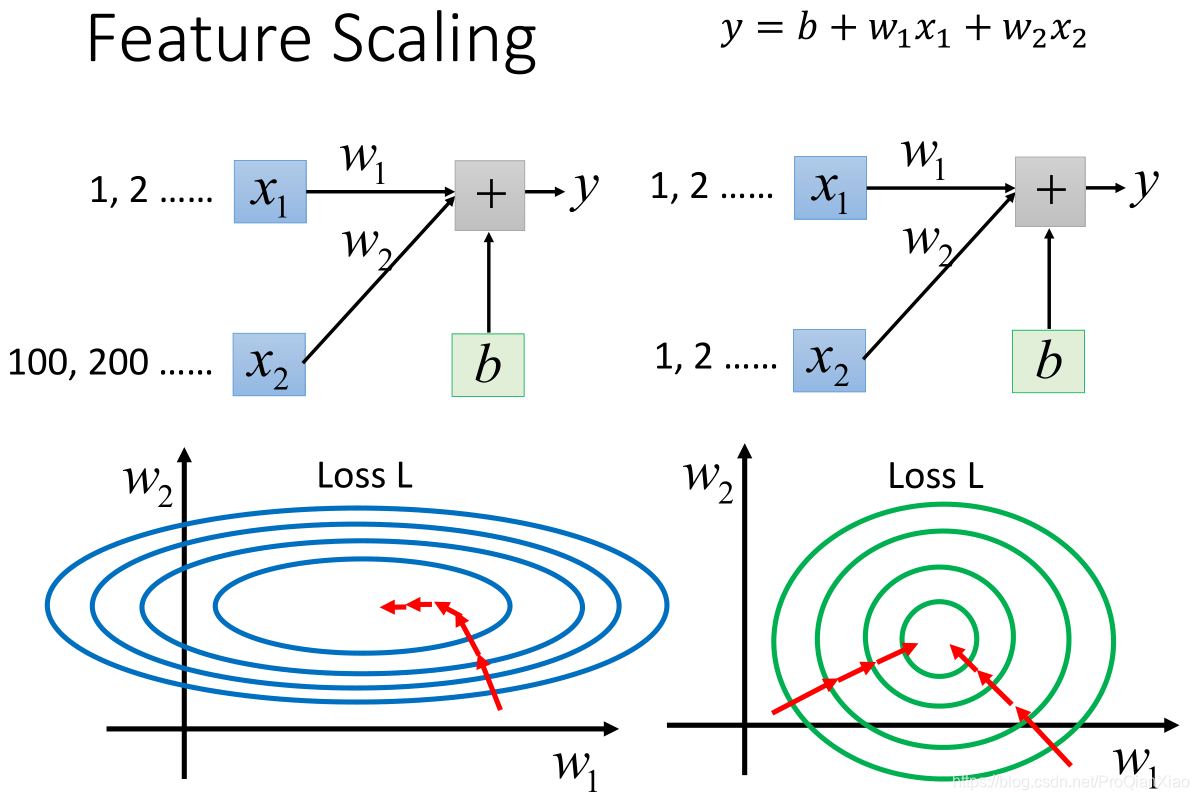

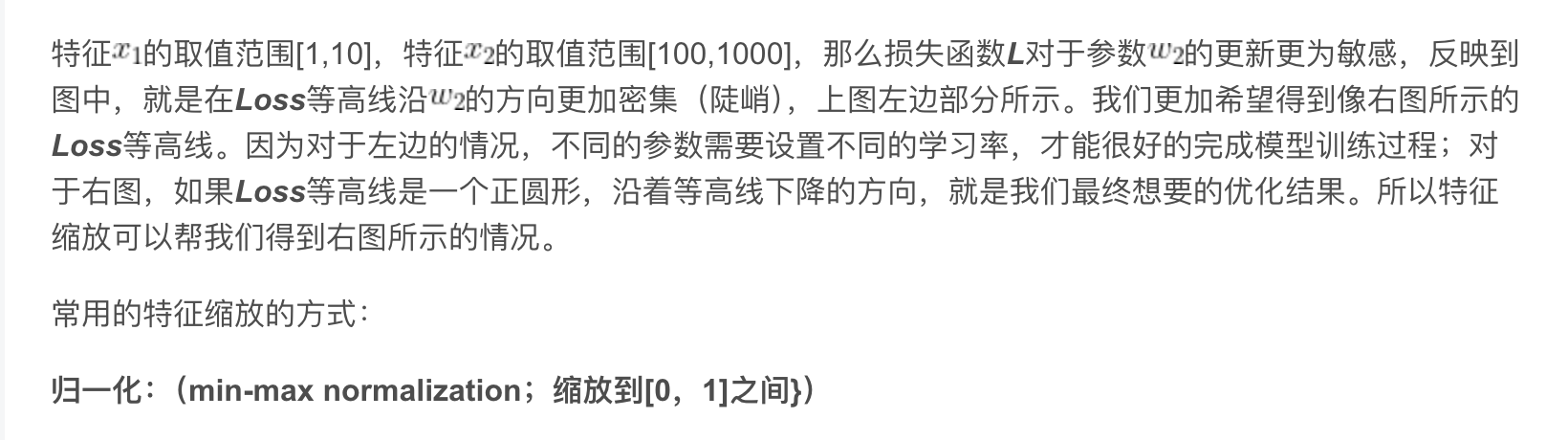

三、特征缩放(Feature Scaling)

特征缩放是用来标准化数据特征的范围,减少特征中特异值的影响。

例如:

k-means聚类

K-means 是我们最常用的基于欧式距离的聚类算法,其认为两个目标的距离越近,相似度越大。

K-means 有一个著名的解释:牧师—村民模型:

有四个牧师去郊区布道,一开始牧师们随意选了几个布道点,并且把这几个布道点的情况公告给了郊区所有的村民,于是每个村民到离自己家最近的布道点去听课。 听课之后,大家觉得距离太远了,于是每个牧师统计了一下自己的课上所有的村民的地址,搬到了所有地址的中心地带,并且在海报上更新了自己的布道点的位置。 牧师每一次移动不可能离所有人都更近,有的人发现A牧师移动以后自己还不如去B牧师处听课更近,于是每个村民又去了离自己最近的布道点…… 就这样,牧师每个礼拜更新自己的位置,村民根据自己的情况选择布道点,最终稳定了下来。

我们可以看到该牧师的目的是为了让每个村民到其最近中心点的距离和最小。

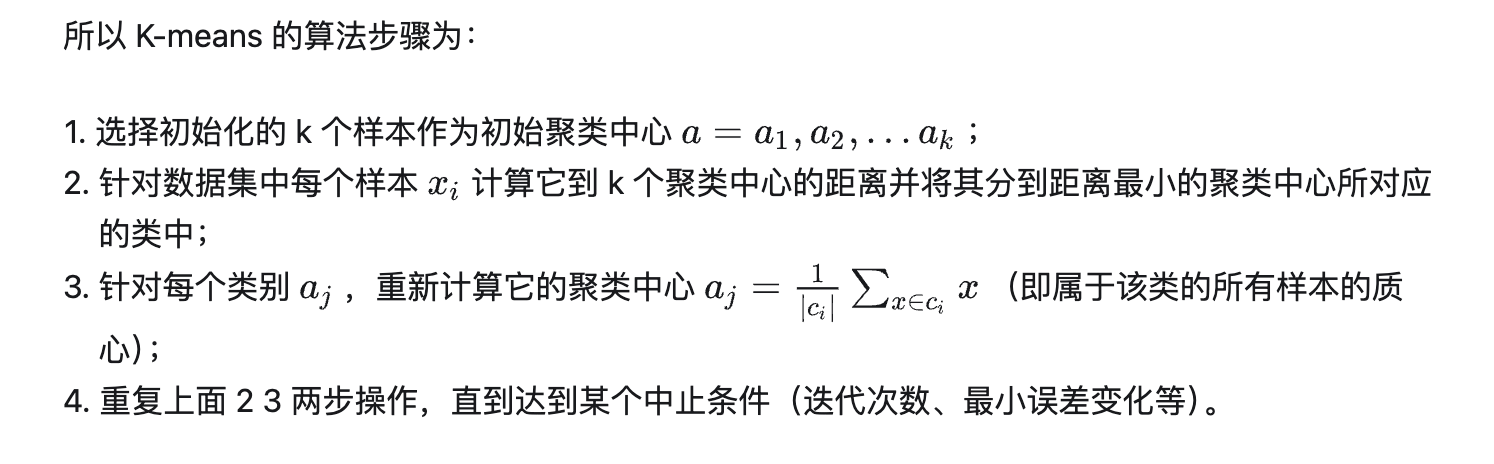

1.2 算法步骤

1.3 复杂度

我们先看下伪代码:

1 | 获取数据 n 个 m 维的数据 |

2. 优缺点

2.1 优点

- 容易理解,聚类效果不错,虽然是局部最优, 但往往局部最优就够了;

- 处理大数据集的时候,该算法可以保证较好的伸缩性;

- 当簇近似高斯分布的时候,效果非常不错;

- 算法复杂度低。

2.2 缺点

- K 值需要人为设定,不同 K 值得到的结果不一样;

- 对初始的簇中心敏感,不同选取方式会得到不同结果;

- 对异常值敏感;

- 样本只能归为一类,不适合多分类任务;

- 不适合太离散的分类、样本类别不平衡的分类、非凸形状的分类。

3. 算法调优与改进

针对 K-means 算法的缺点,我们可以有很多种调优方式:如数据预处理(去除异常点),合理选择 K 值,高维映射等。以下将简单介绍:

3.1 数据预处理

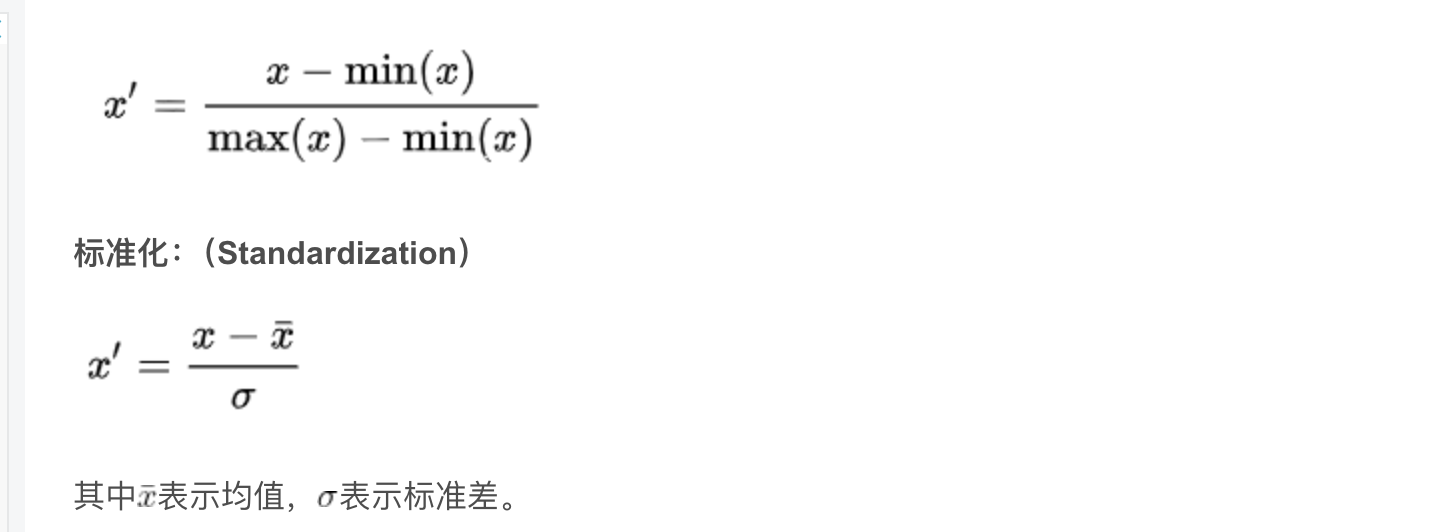

K-means 的本质是基于欧式距离的数据划分算法,均值和方差大的维度将对数据的聚类产生决定性影响。所以未做归一化处理和统一单位的数据是无法直接参与运算和比较的。常见的数据预处理方式有:数据归一化,数据标准化。

此外,离群点或者噪声数据会对均值产生较大的影响,导致中心偏移,因此我们还需要对数据进行异常点检测。

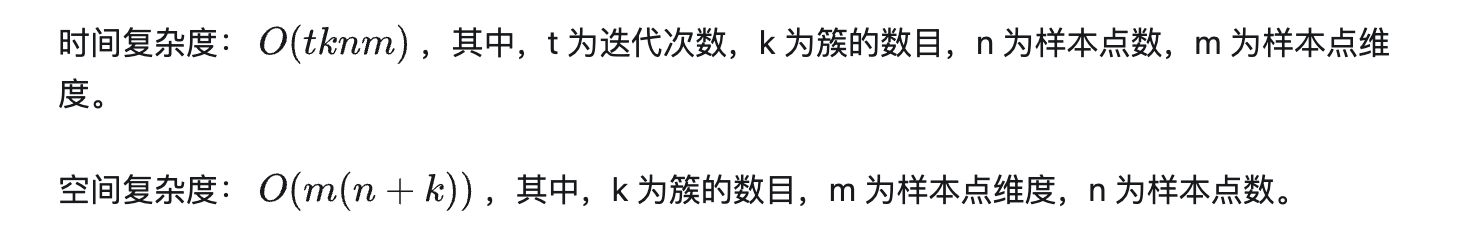

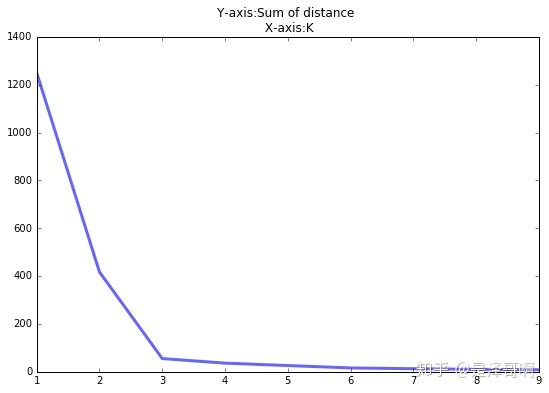

3.2 合理选择 K 值

K 值的选取对 K-means 影响很大,这也是 K-means 最大的缺点,常见的选取 K 值的方法有:手肘法、Gap statistic 方法。

手肘法:

当 K < 3 时,曲线急速下降;当 K > 3 时,曲线趋于平稳,通过手肘法我们认为拐点 3 为 K 的最佳值。

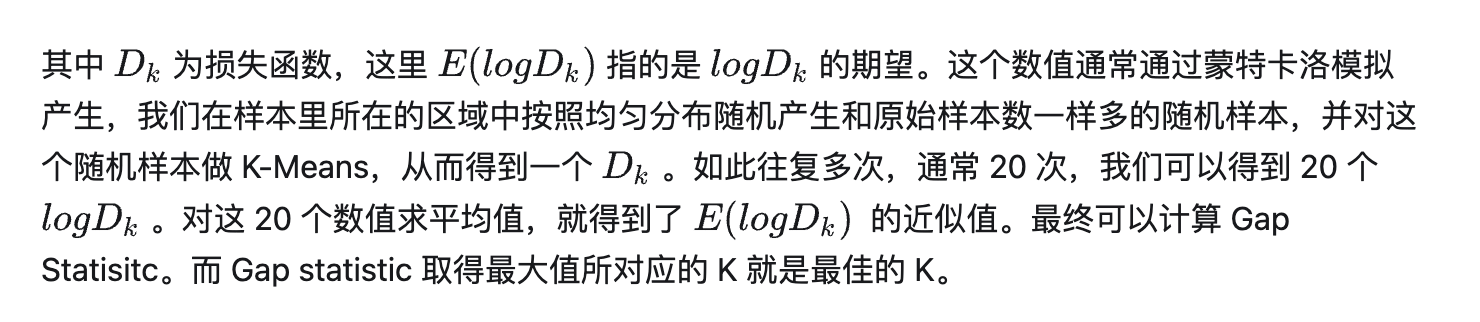

手肘法的缺点在于需要人工看不够自动化,所以我们又有了 Gap statistic 方法,这个方法出自斯坦福大学的几个学者的论文:Estimating the number of clusters in a data set via the gap statistic

由图可见,当 K=3 时,Gap(K) 取值最大,所以最佳的簇数是 K=3。

Github 上一个项目叫 gap_statistic ,可以更方便的获取建议的类簇个数。

3.3 采用核函数

基于欧式距离的 K-means 假设了了各个数据簇的数据具有一样的的先验概率并呈现球形分布,但这种分布在实际生活中并不常见。面对非凸的数据分布形状时我们可以引入核函数来优化,这时算法又称为核 K-means 算法,是核聚类方法的一种。核聚类方法的主要思想是通过一个非线性映射,将输入空间中的数据点映射到高位的特征空间中,并在新的特征空间中进行聚类。非线性映射增加了数据点线性可分的概率,从而在经典的聚类算法失效的情况下,通过引入核函数可以达到更为准确的聚类结果。

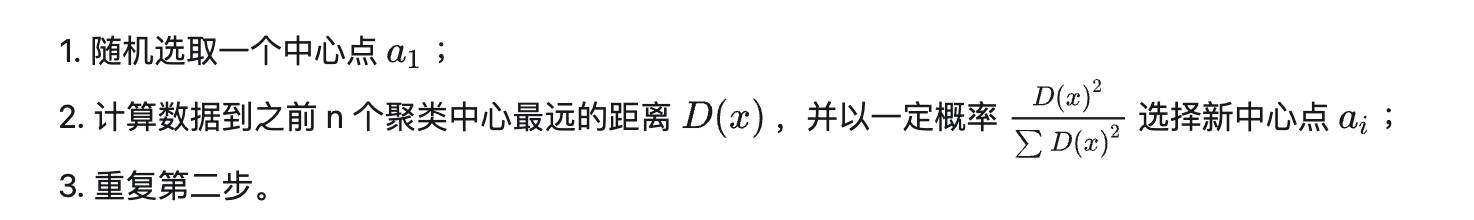

3.4 K-means++

我们知道初始值的选取对结果的影响很大,对初始值选择的改进是很重要的一部分。在所有的改进算法中,K-means++ 最有名。

K-means++ 算法步骤如下所示:

简单的来说,就是 K-means++ 就是选择离已选中心点最远的点。这也比较符合常理,聚类中心当然是互相离得越远越好。

3.5 ISODATA

ISODATA 的全称是迭代自组织数据分析法。它解决了 K 的值需要预先人为的确定这一缺点。而当遇到高维度、海量的数据集时,人们往往很难准确地估计出 K 的大小。ISODATA 就是针对这个问题进行了改进,它的思想也很直观:当属于某个类别的样本数过少时把这个类别去除,当属于某个类别的样本数过多、分散程度较大时把这个类别分为两个子类别。

4. 收敛证明

我们先来看一下 K-means 算法的步骤:先随机选择初始节点,然后计算每个样本所属类别,然后通过类别再跟新初始化节点。这个过程有没有想到之前介绍的 EM 算法 。

我们需要知道的是 K-means 聚类的迭代算法实际上是 EM 算法。EM

算法解决的是在概率模型中含有无法观测的隐含变量情况下的参数估计问题。在

K-means 中的隐变量是每个类别所属类别。K-means 算法迭代步骤中的

每次确认中心点以后重新进行标记 对应 EM 算法中的 E 步

求当前参数条件下的 Expectation 。而

根据标记重新求中心点 对应 EM 算法中的 M 步

求似然函数最大化时(损失函数最小时)对应的参数 。

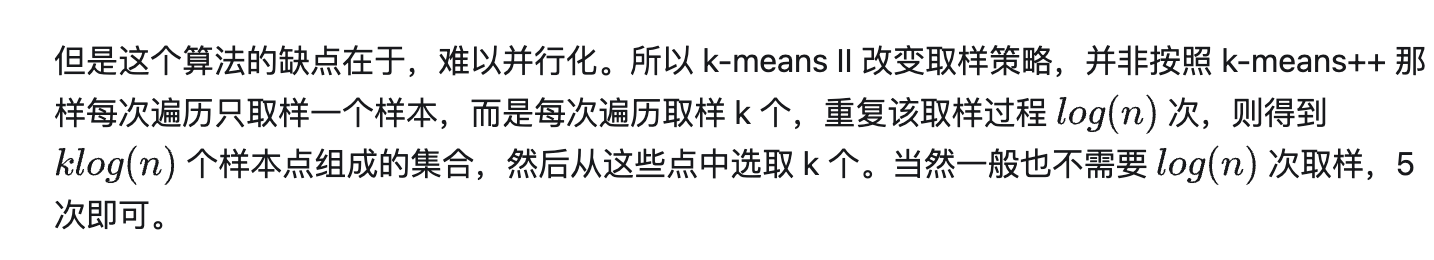

首先我们看一下损失函数的形式:

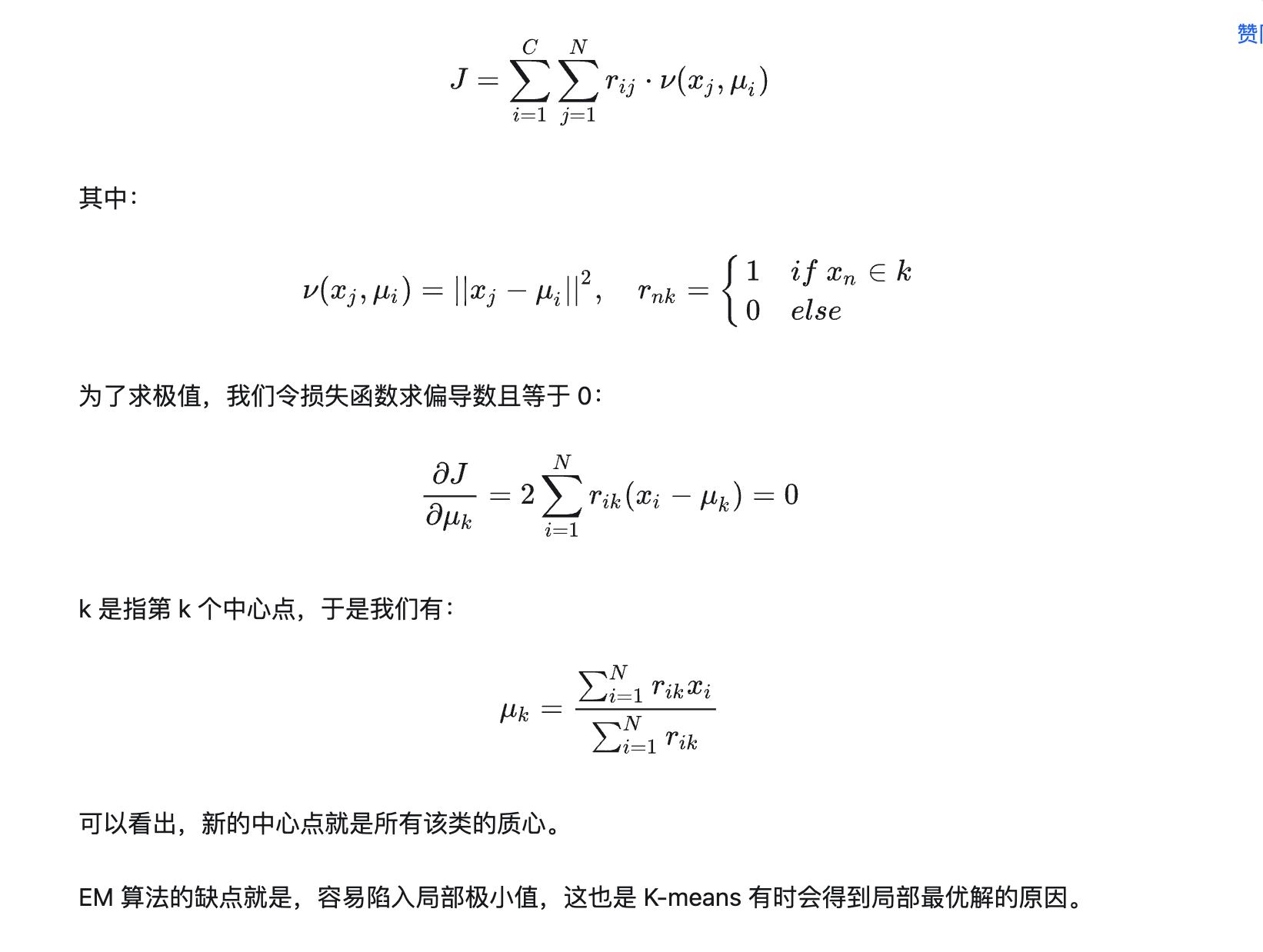

调参

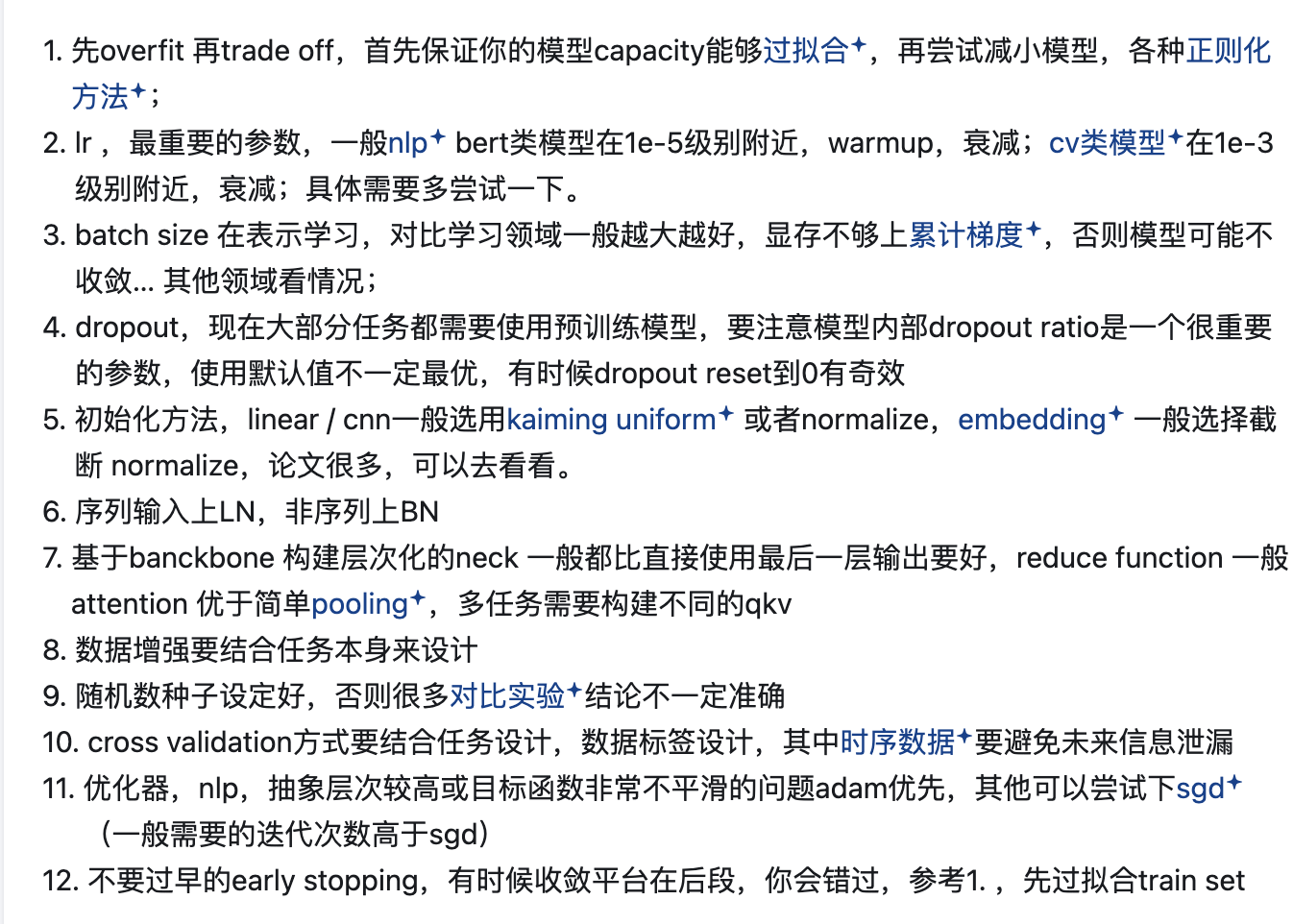

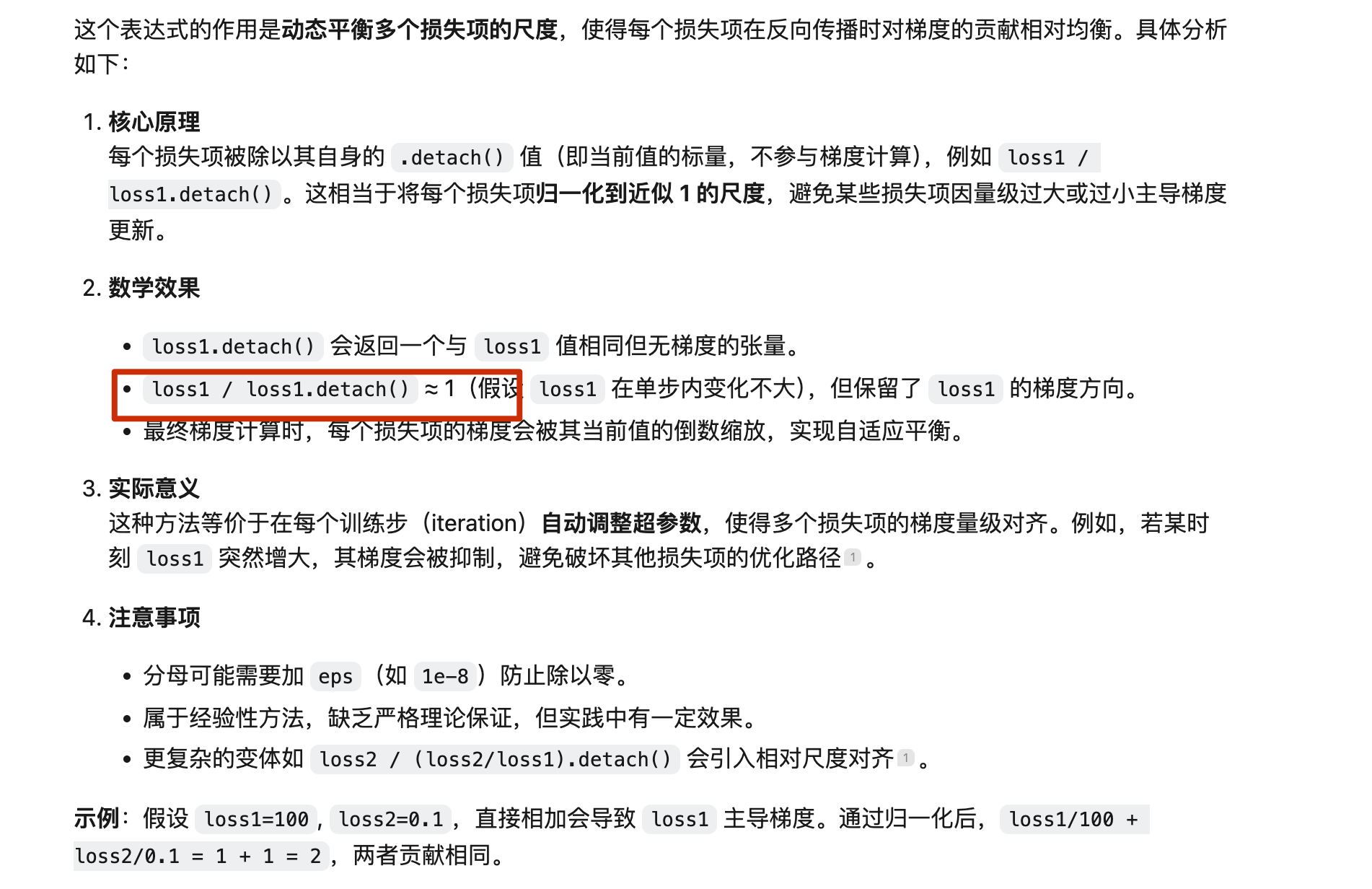

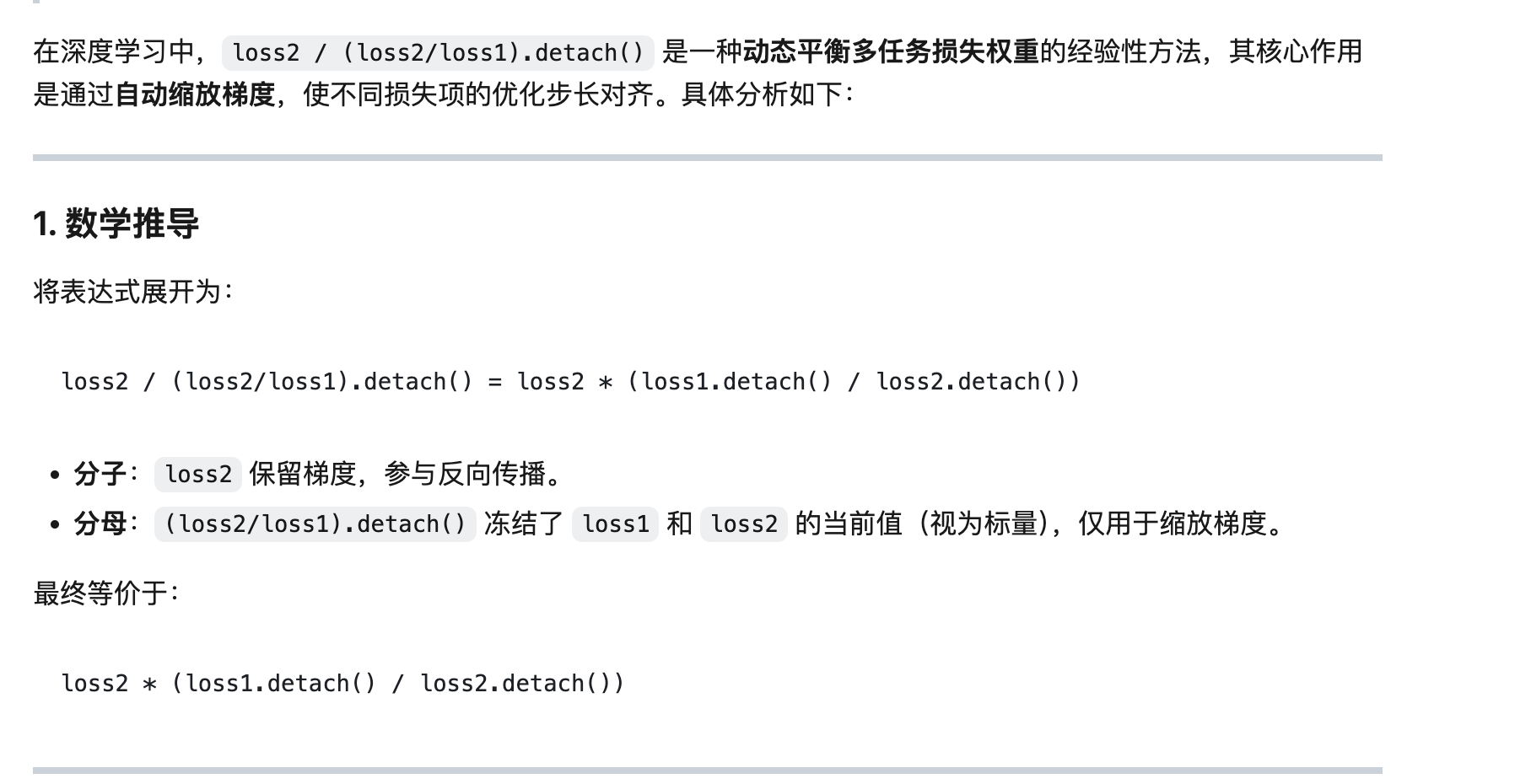

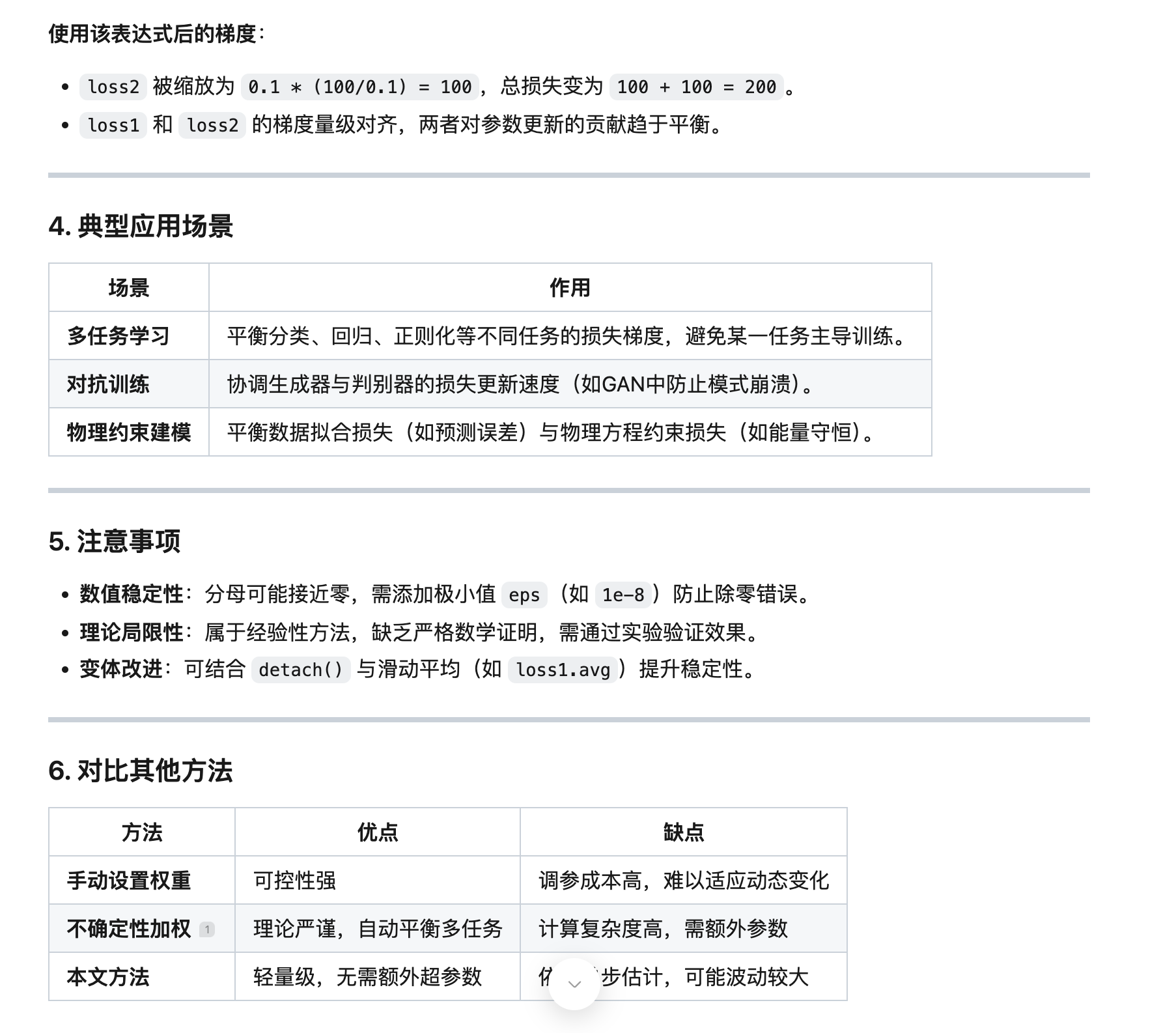

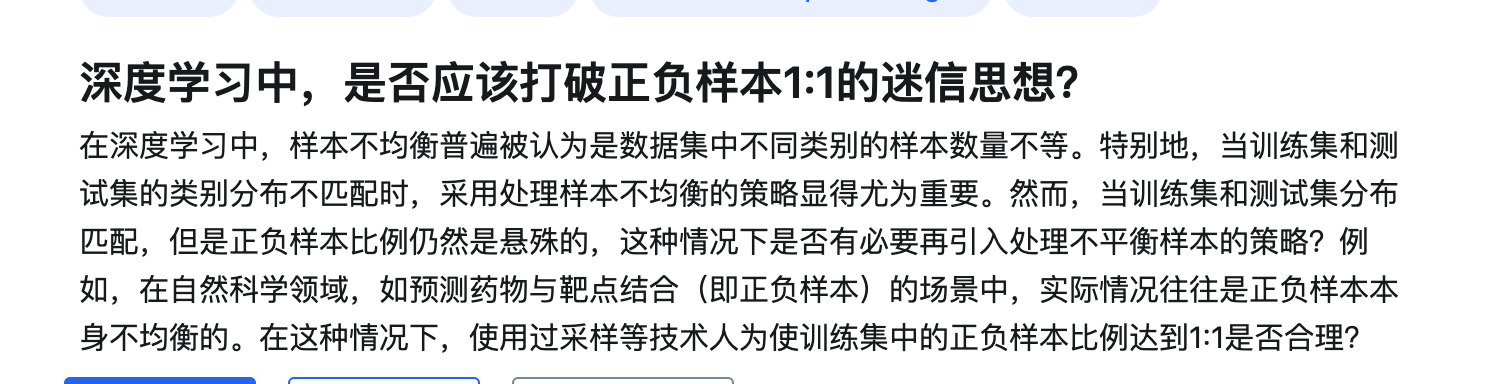

多任务 loss 协调

基于经验自己配置,或者基于现有的论文

一般按照两个原则

1.各个loss的数量级保持一致

2.各个loss单独作用的时候梯度的模长的数量级保持一致

这两个原则二选一即可

1 | # 原始表达式(存在除零风险) |

完整代码示例(PyTorch)

1 | import torch |

总结神经网络训练不收敛或训练失败的原因

数据平衡问题

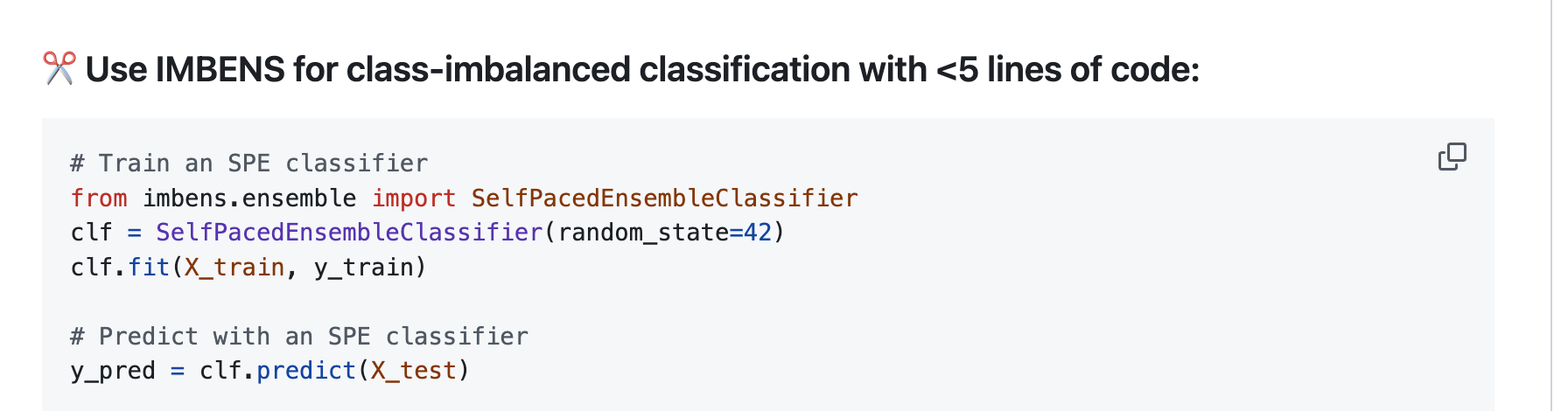

https://www.zhihu.com/question/654186093/answer/3483543427

https://zhuanlan.zhihu.com/p/86891438

https://link.zhihu.com/?target=https%3A//github.com/ZhiningLiu1998/imbalanced-ensemble

https://github.com/ZhiningLiu1998/imbalanced-ensemble

注意这句话

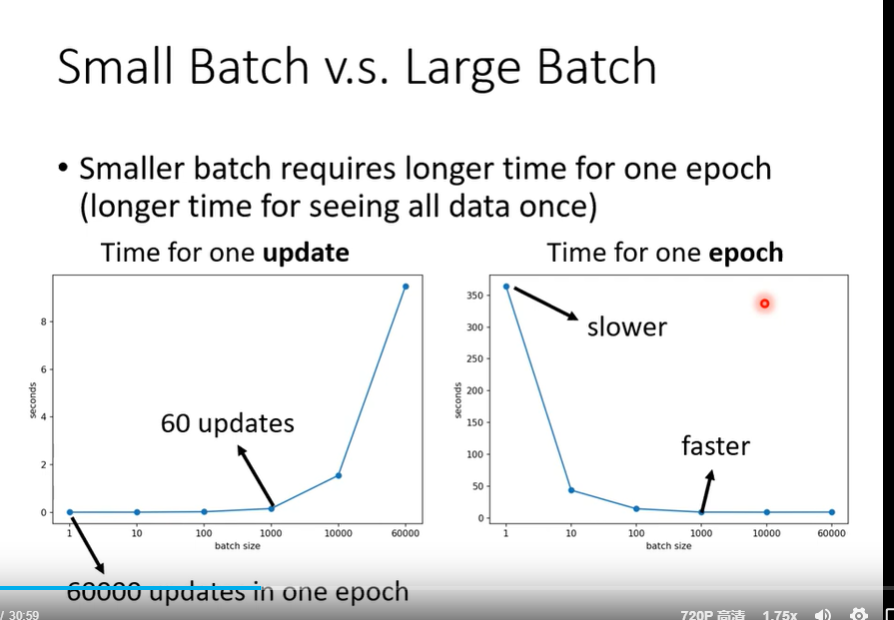

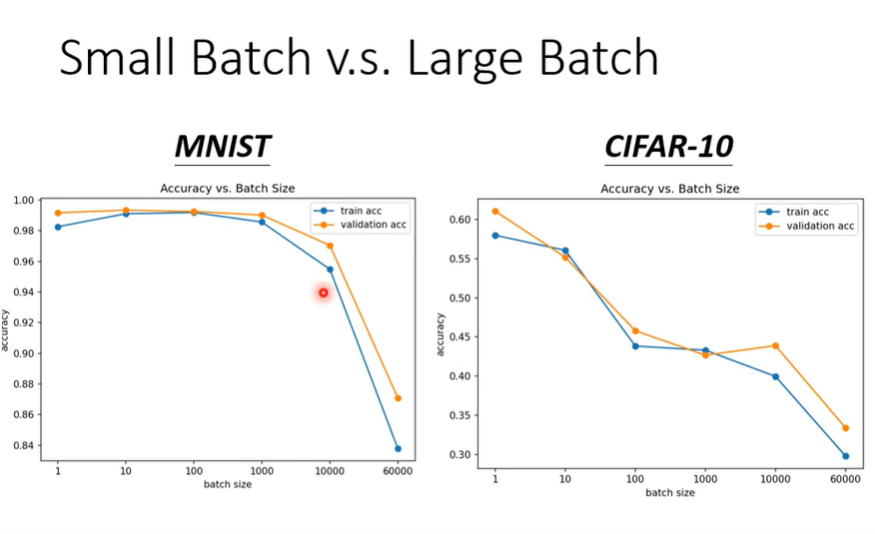

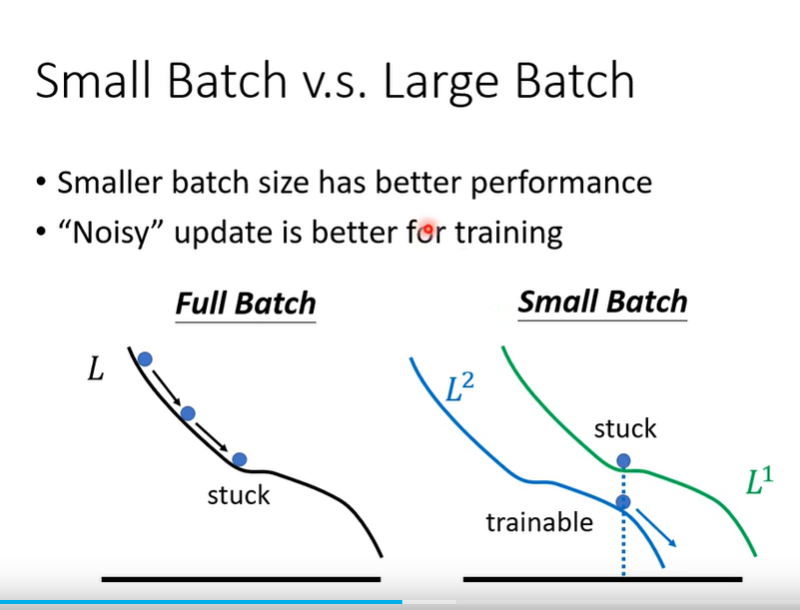

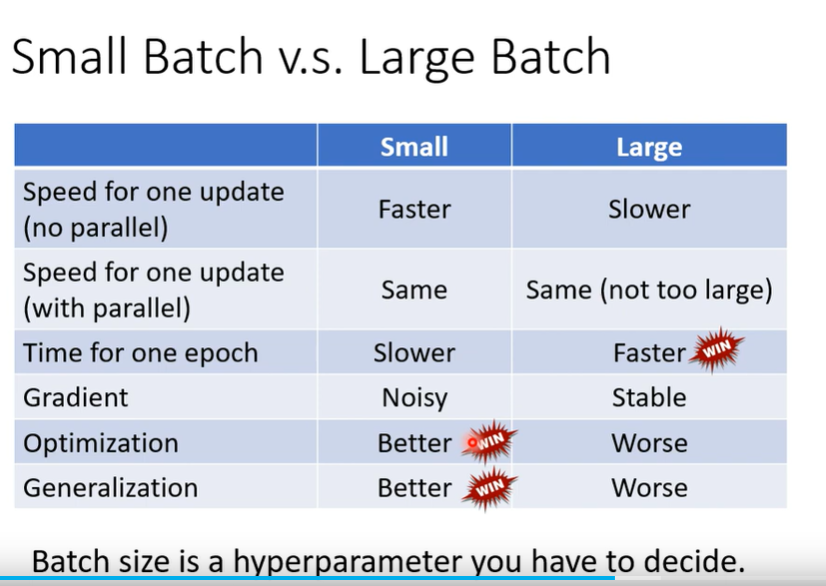

batch_size

batch_size越大训练时间越少,

但是太大的batch_SIZE会导致准确率降低,这个是optimization的问题

梯度上升和梯度下降的区别是什么?

!!!!!!! 简单来说就是正常的机器学习算法是需要计算loss函数的梯度,往梯度下降的方向走,需要loss函数的最小值

**但是梯度上升时,这个函数不是loss函数,而是一个真正的func函数,需要找这个func函数的最大值**梯度上升和梯度下降是两种相反的优化方法,主要区别如下:

目标方向:

梯度下降的目标是找到函数的最小值,因此沿着函数梯度的负方向更新参数。

梯度上升的目标是找到函数的最大值,所以沿着函数梯度的正方向更新参数。

更新参数的方式:

假设函数 f 关于参数 w 的梯度为

∇f(w) ,学习率为 α 。

在梯度下降中,参数的更新公式为:w = w - α * ∇f(w) 。

在梯度上升中,参数的更新公式为:w = w + α * ∇f(w) 。

应用场景:

梯度下降常用于损失函数的最小化,比如在机器学习中,通过最小化预测值与真实值之间的差异来优化模型的参数。

梯度上升则常用于需要最大化某个目标函数的情况,比如强化学习中最大化奖励,或者在某些特定的优化问题中找到使某个函数达到最大值的参数配置。

示例:

假设有一个简单的二次函数 f(w) = w^2 ,其梯度为

∇f(w) = 2w 。

如果使用梯度下降,学习率为 0.1 ,初始参数

w = 2 ,则第一次更新为

w = 2 - 0.1 * 2 * 2 = 1.6 。

如果使用梯度上升,同样学习率为 0.1 ,初始参数

w = 2 ,则第一次更新为

w = 2 + 0.1 * 2 * 2 = 2.4 。

总的来说,梯度上升和梯度下降的核心区别在于更新参数的方向,一个朝着梯度正方向,一个朝着梯度负方向,以分别实现最大化和最小化的目标。

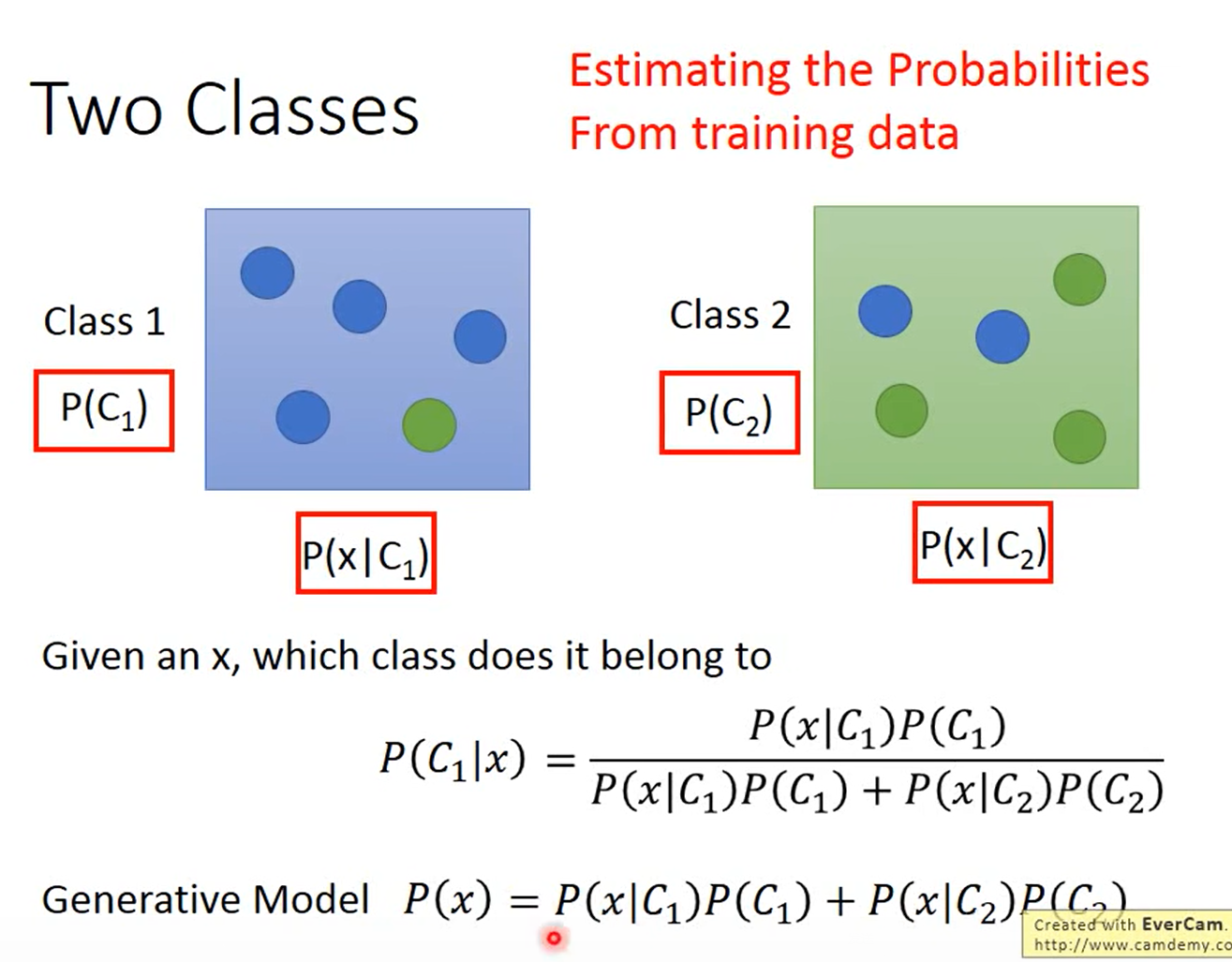

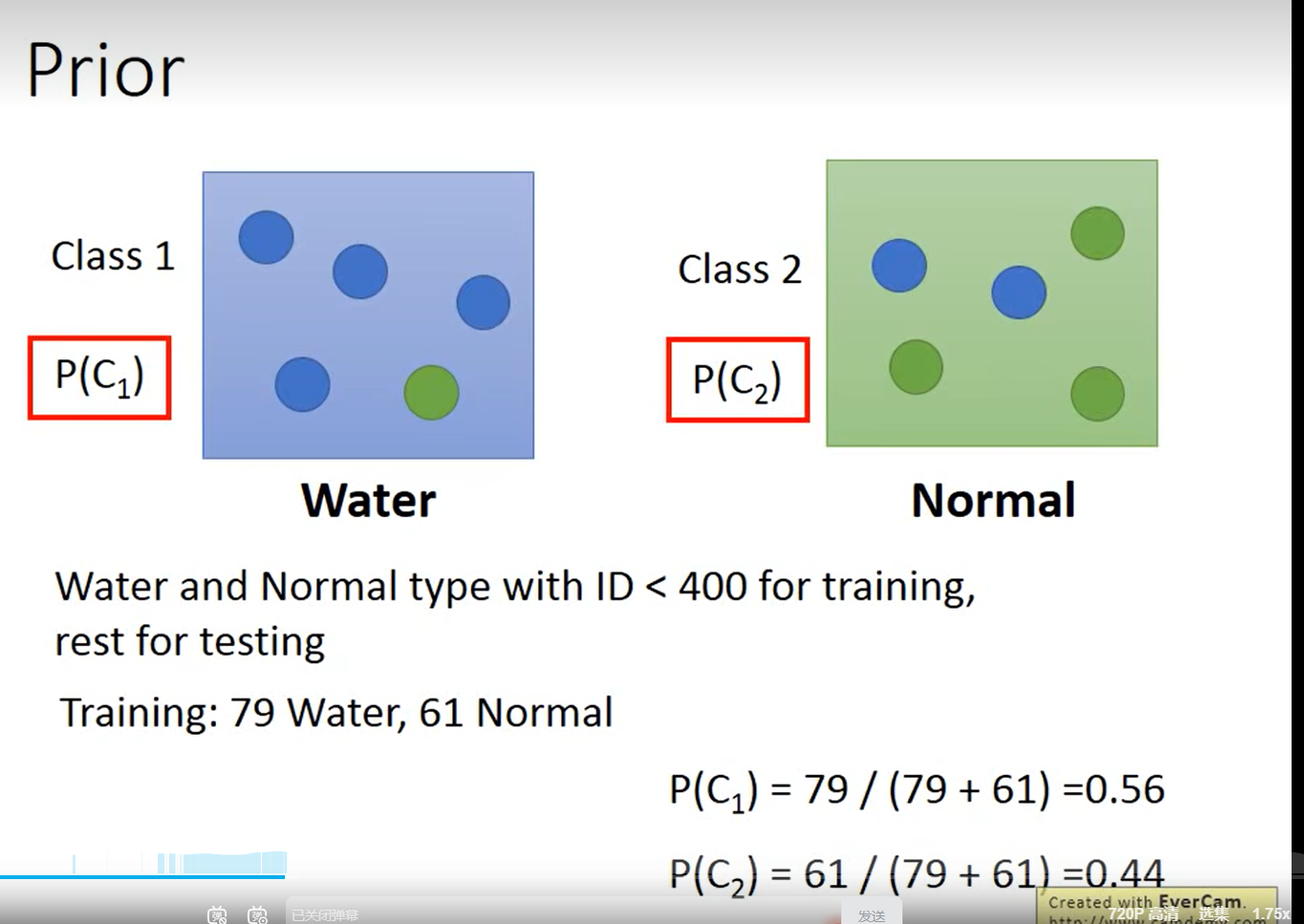

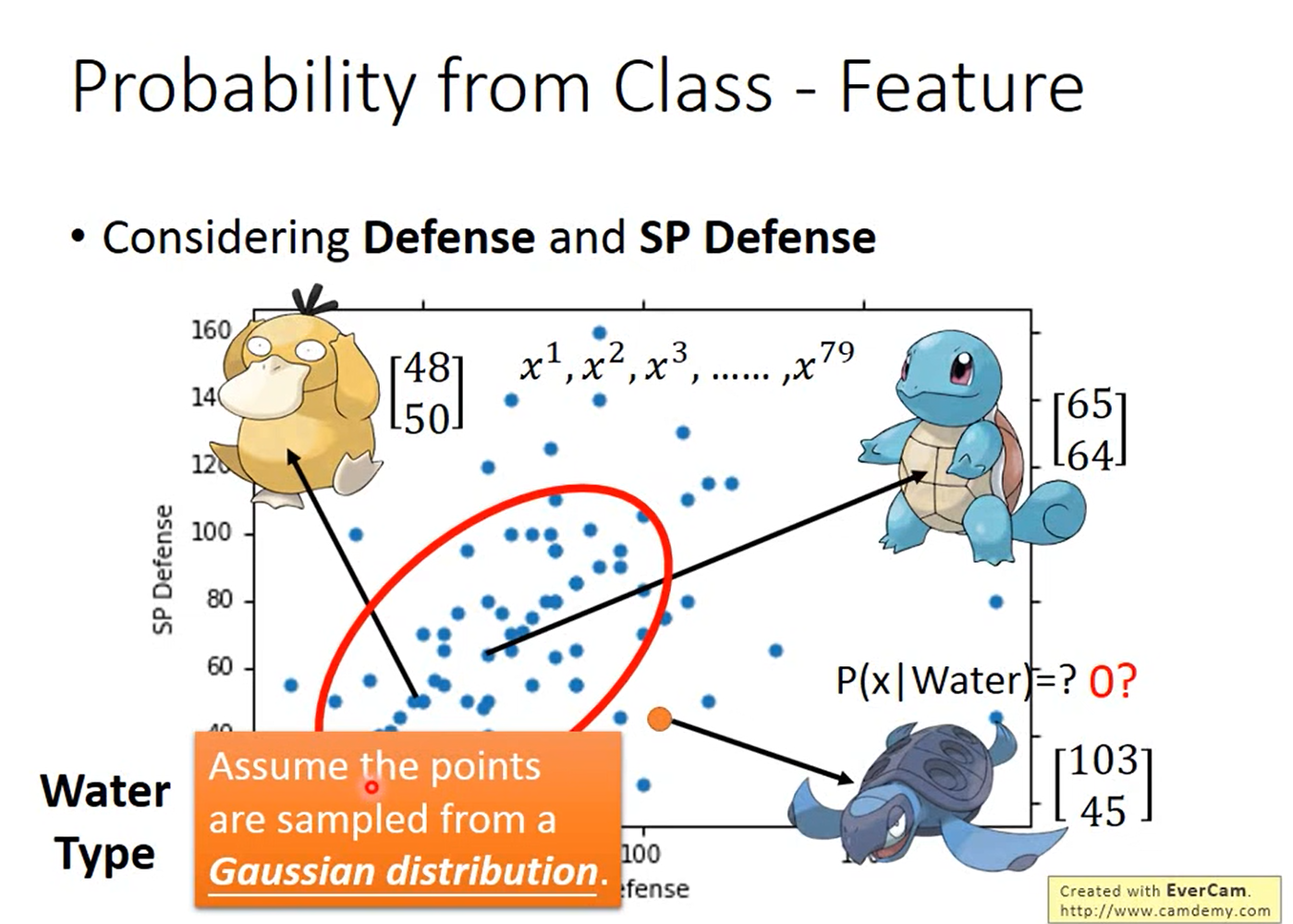

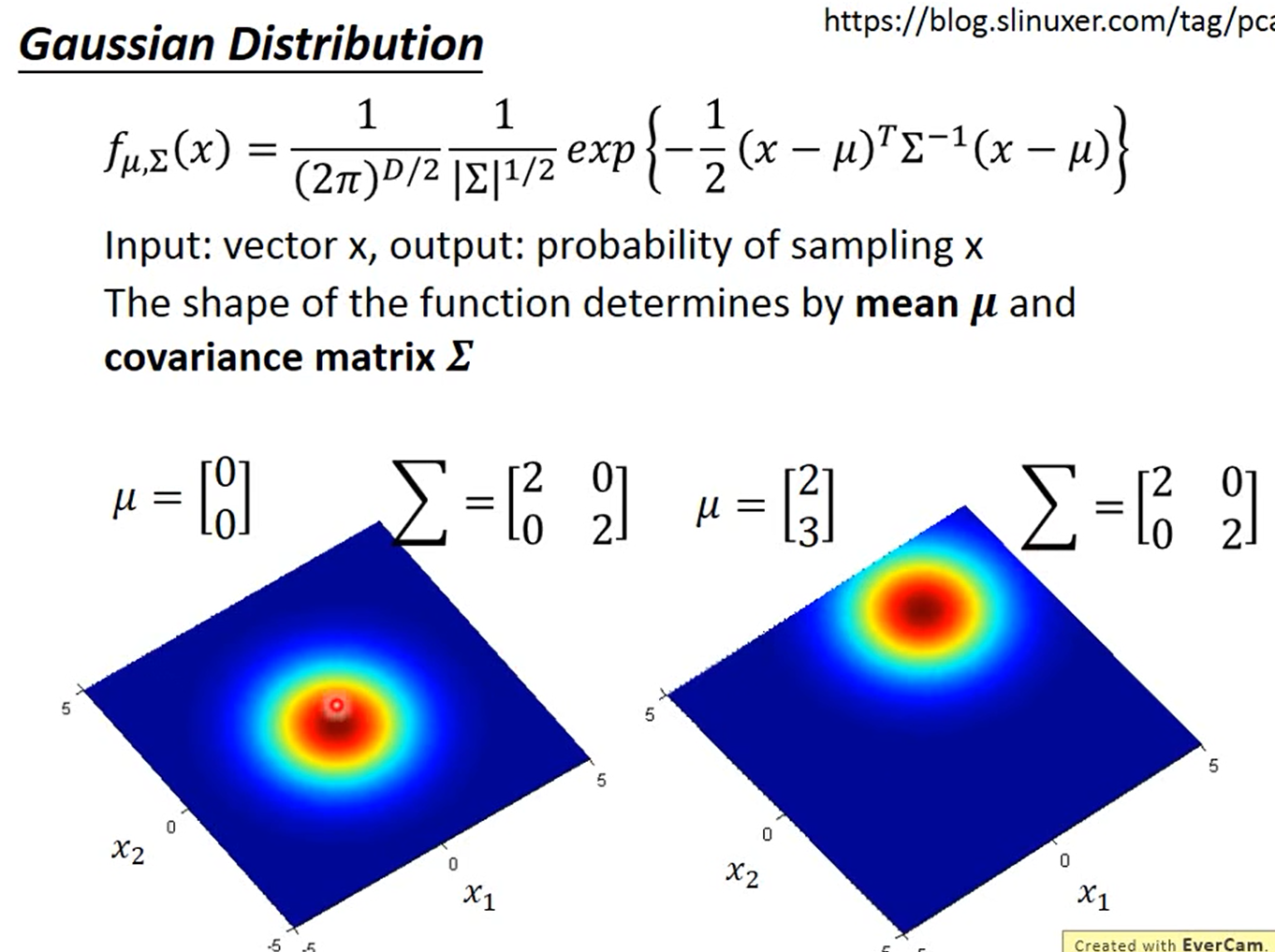

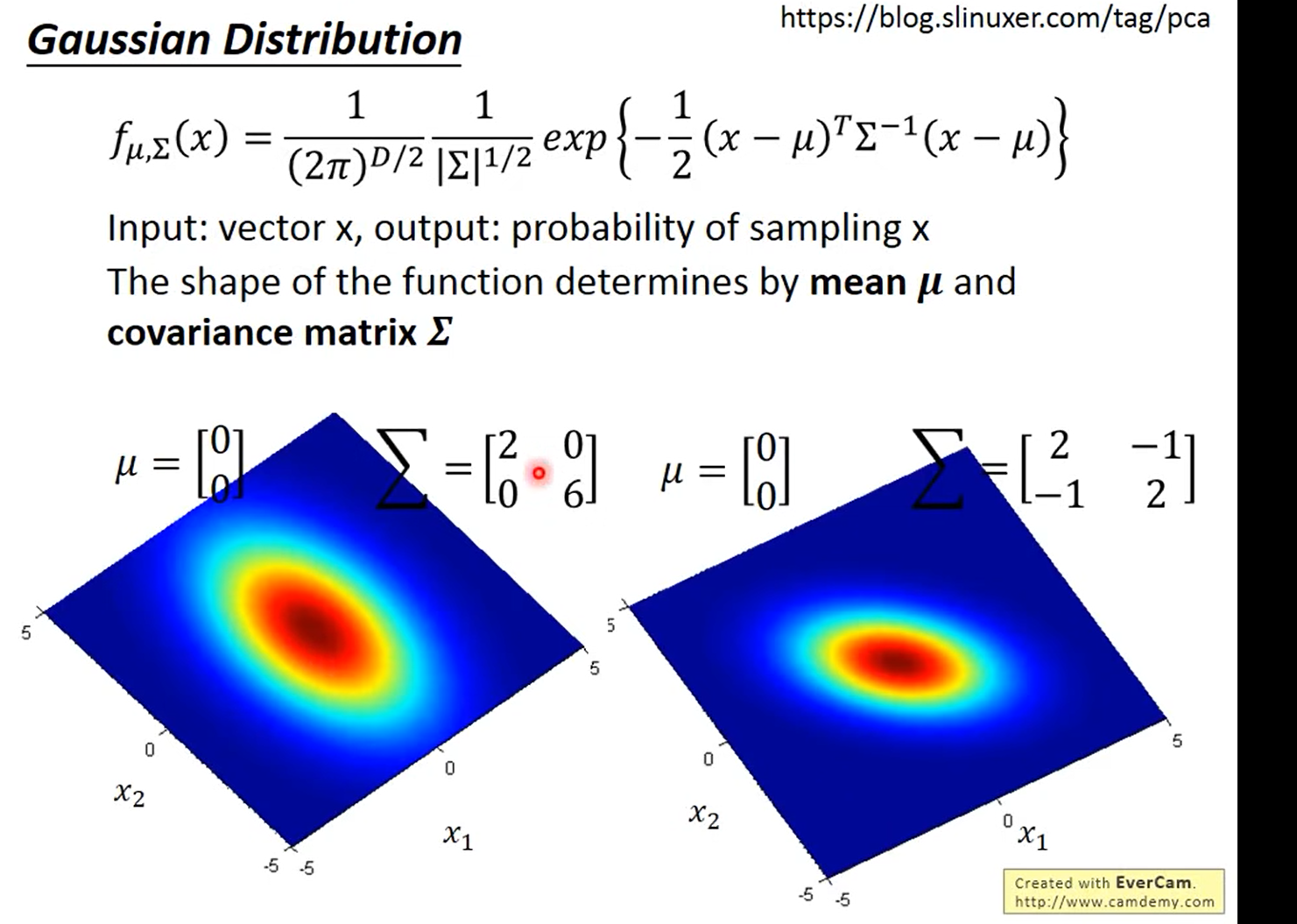

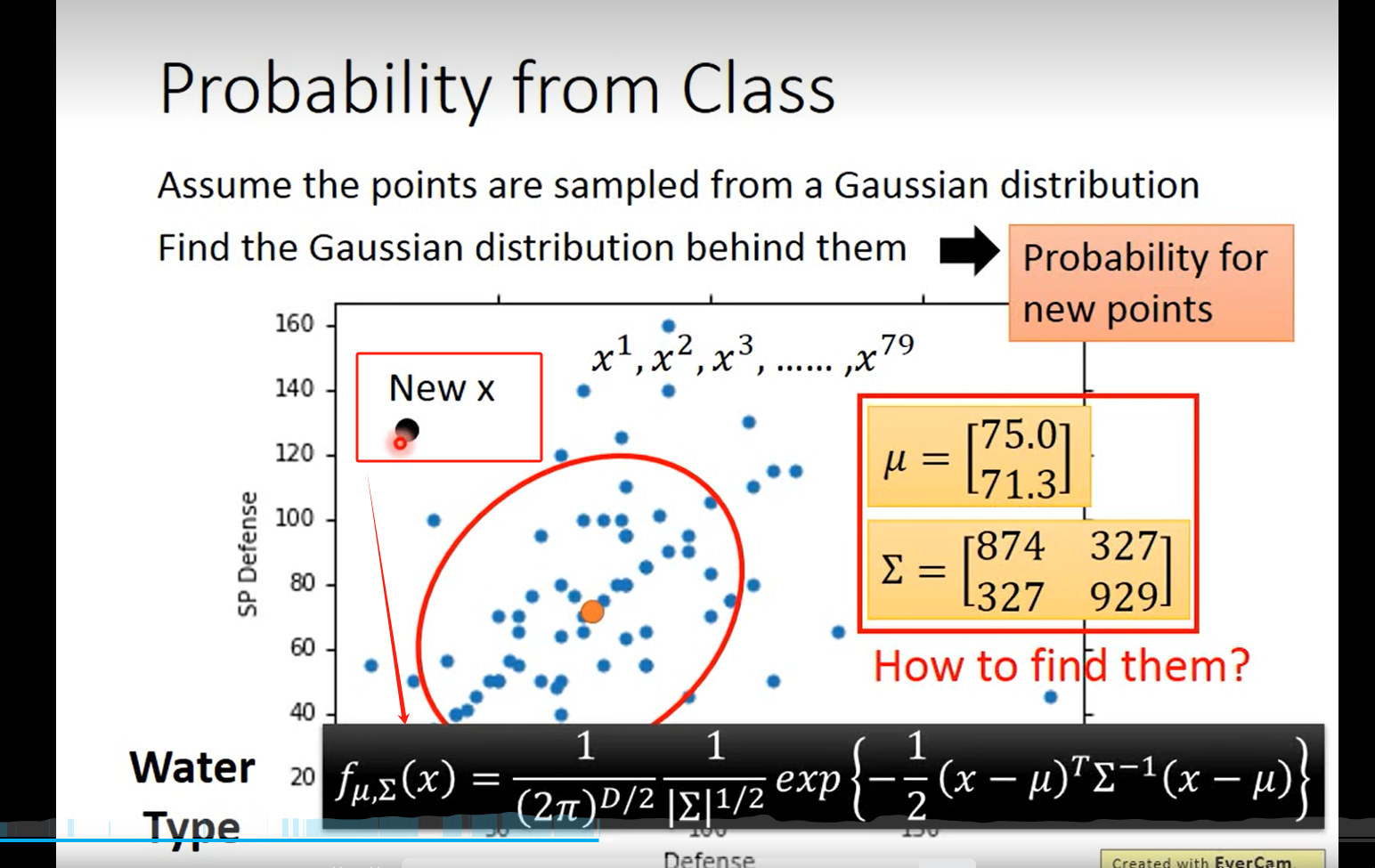

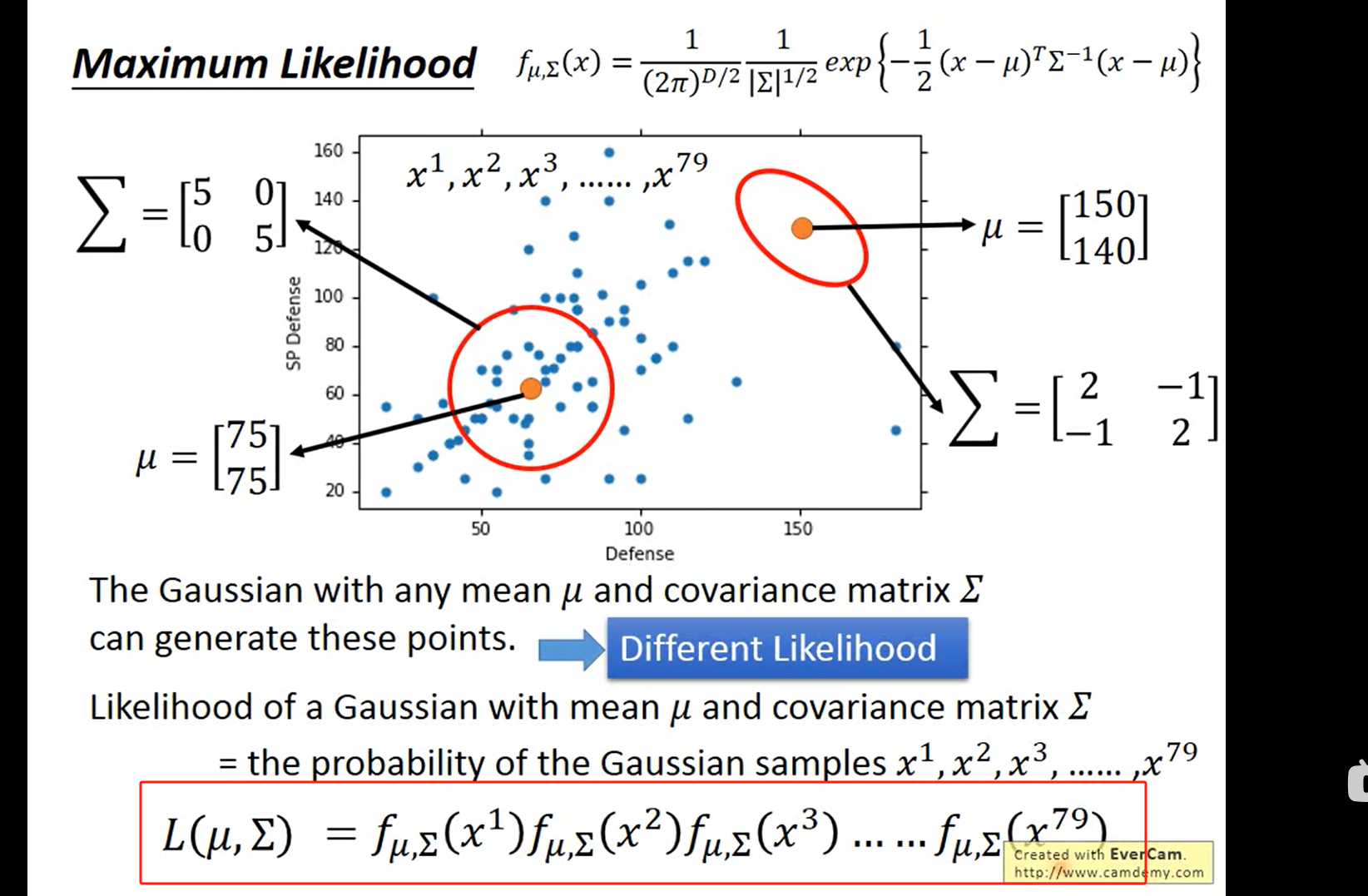

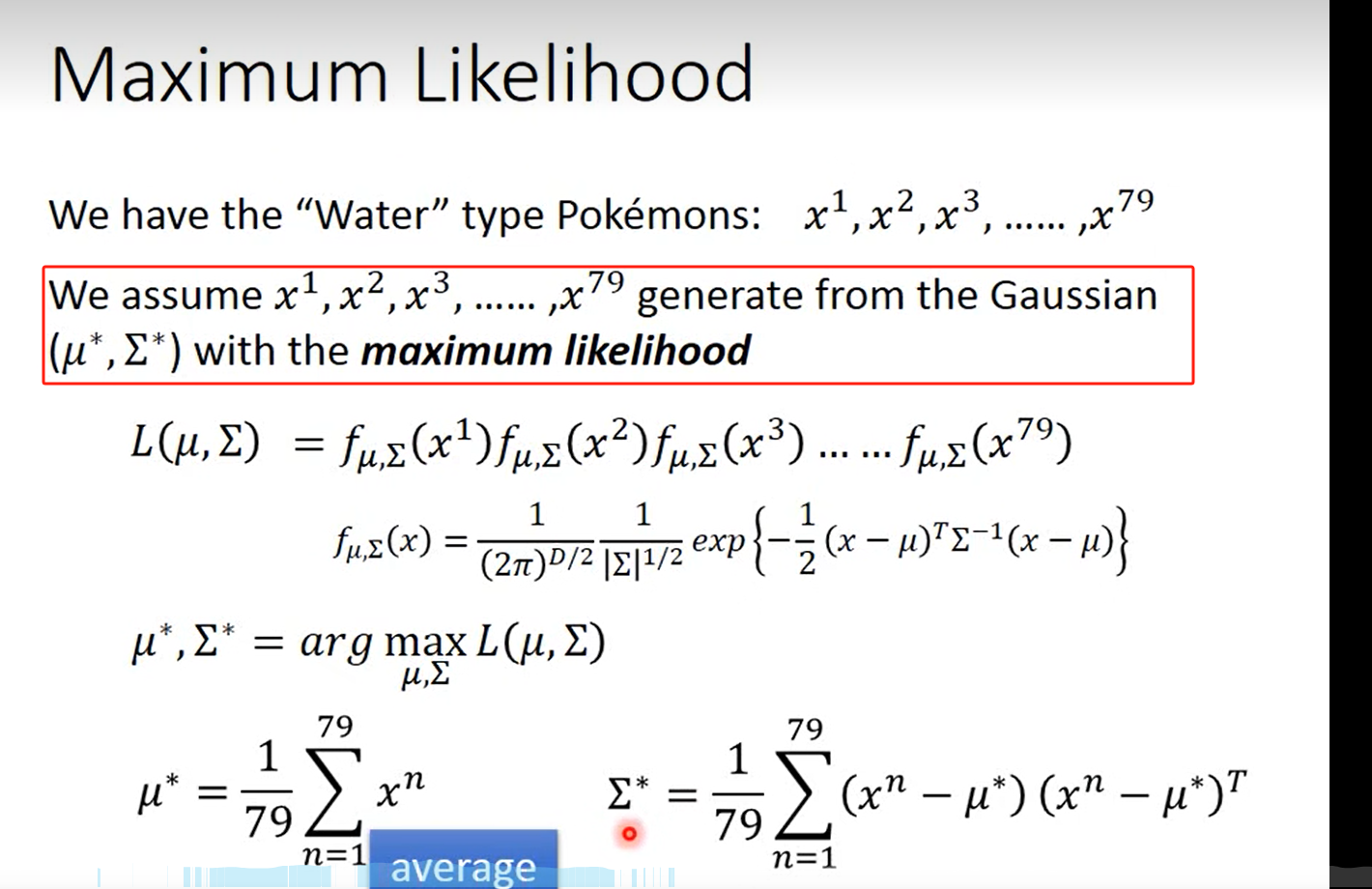

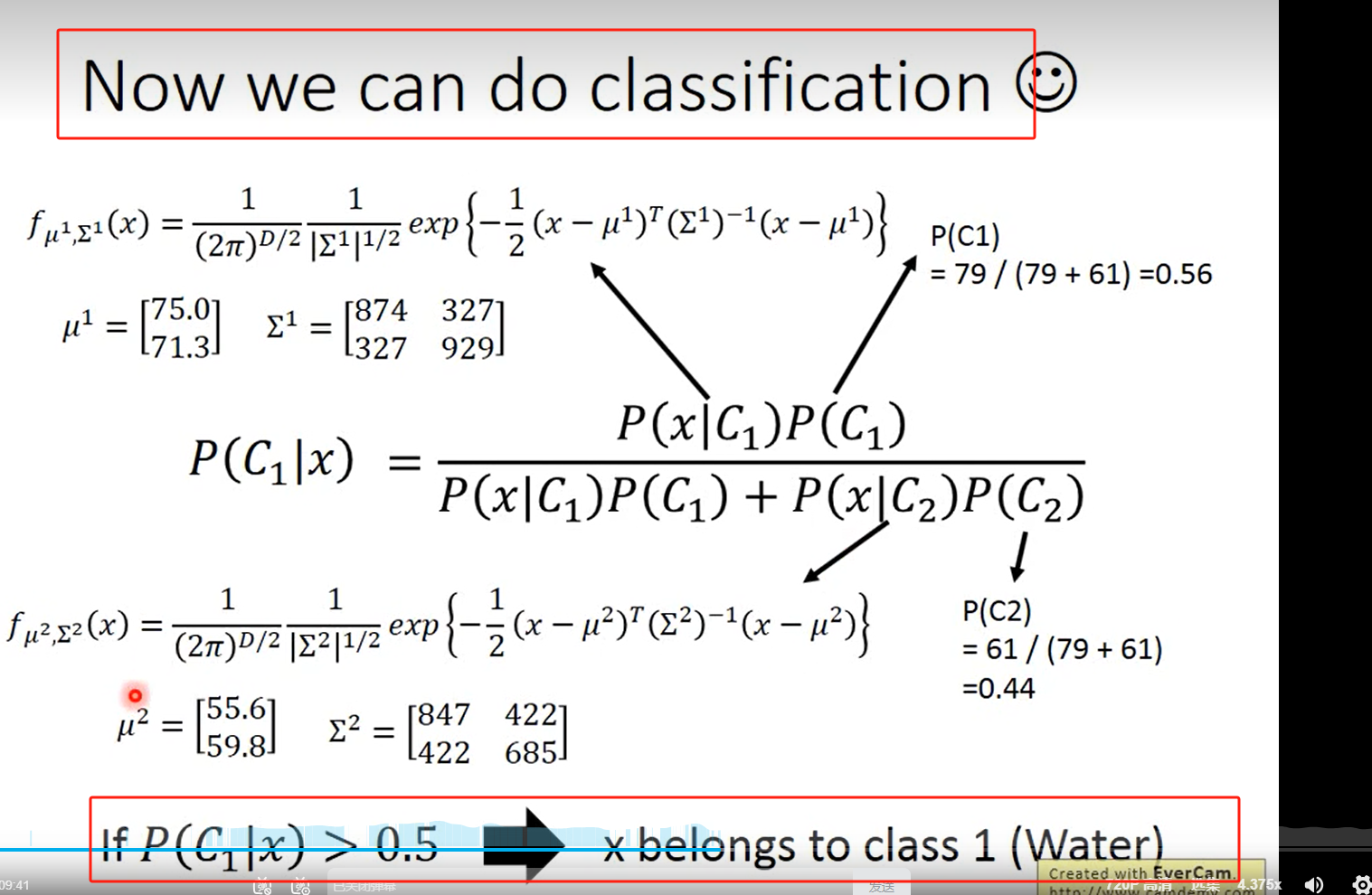

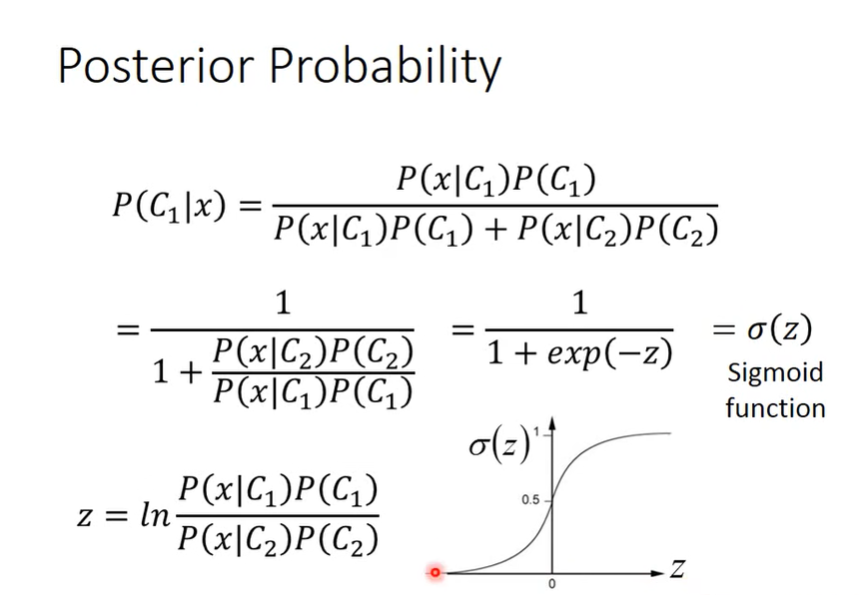

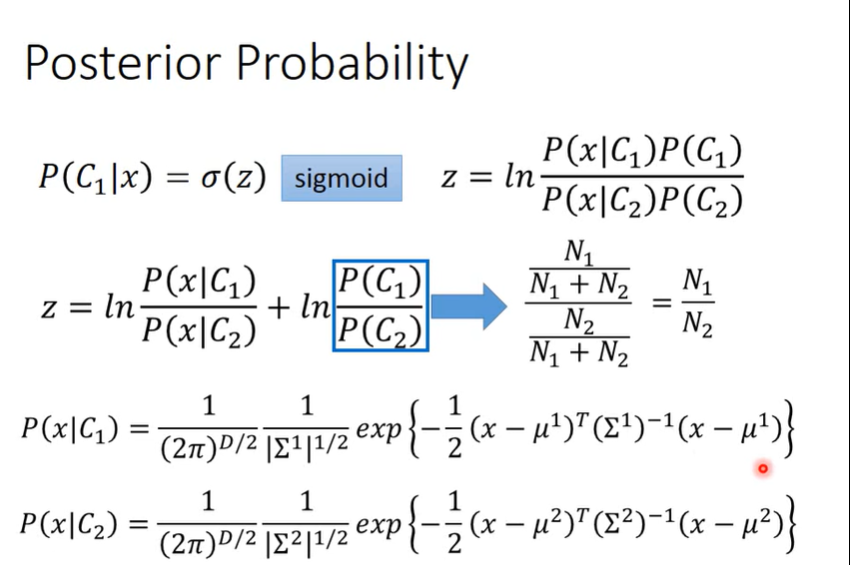

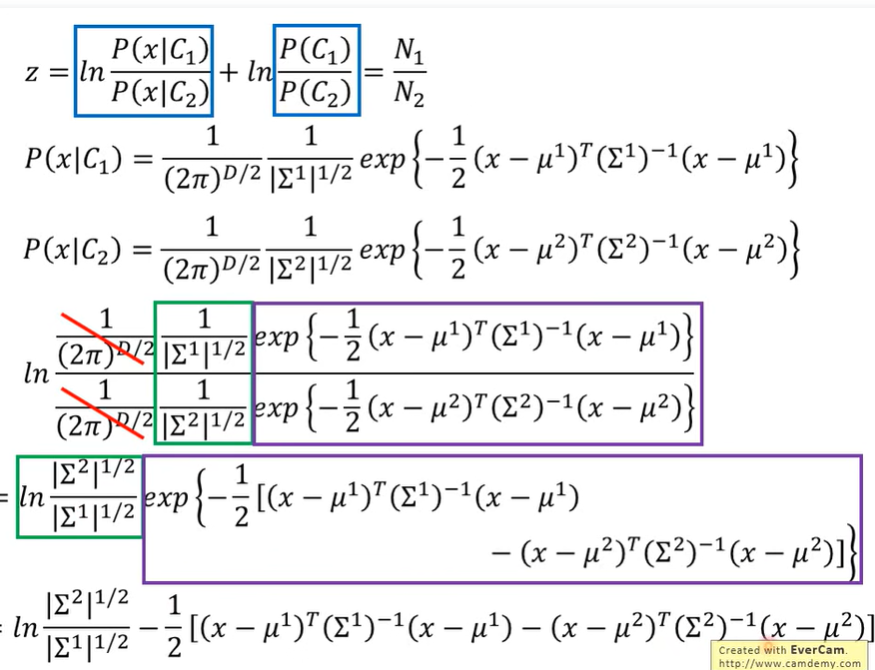

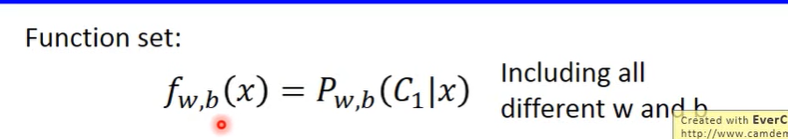

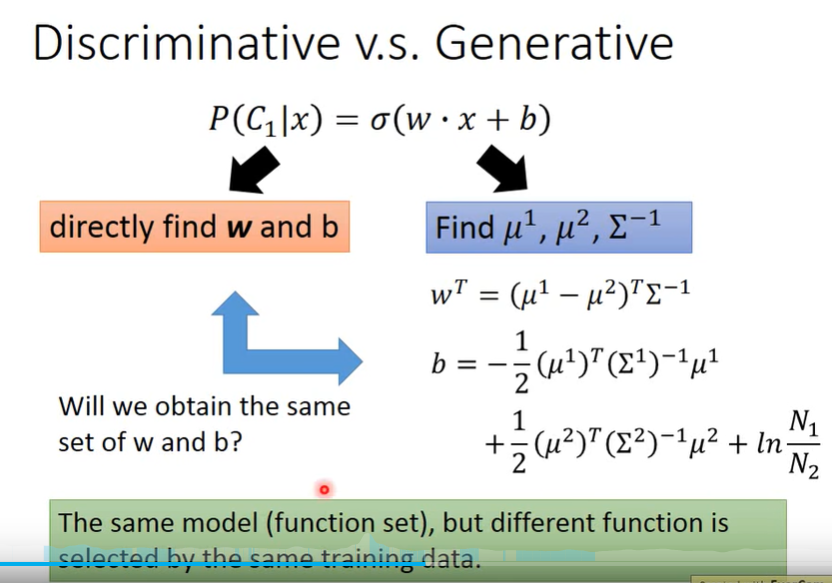

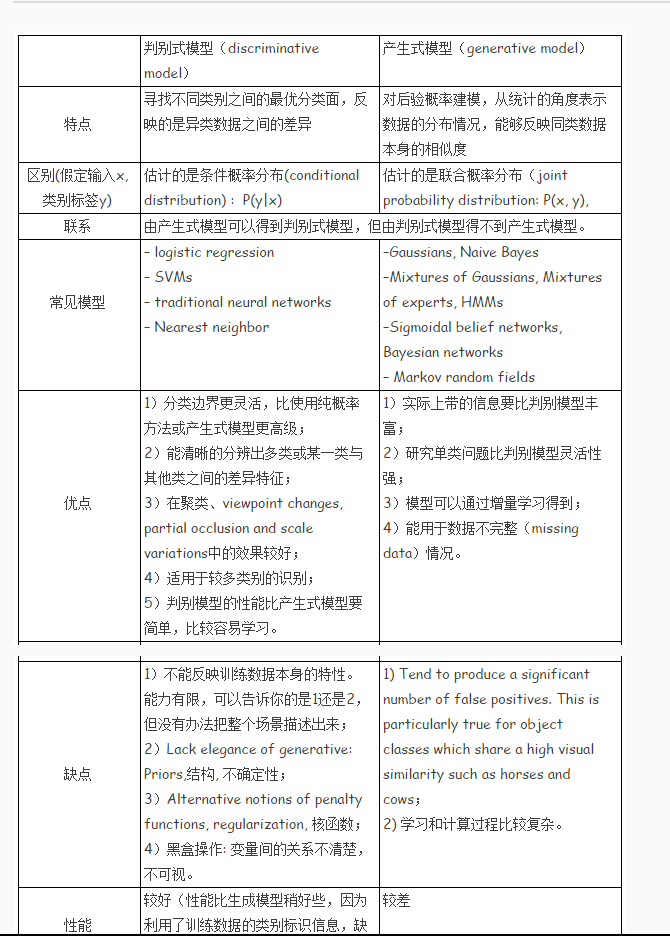

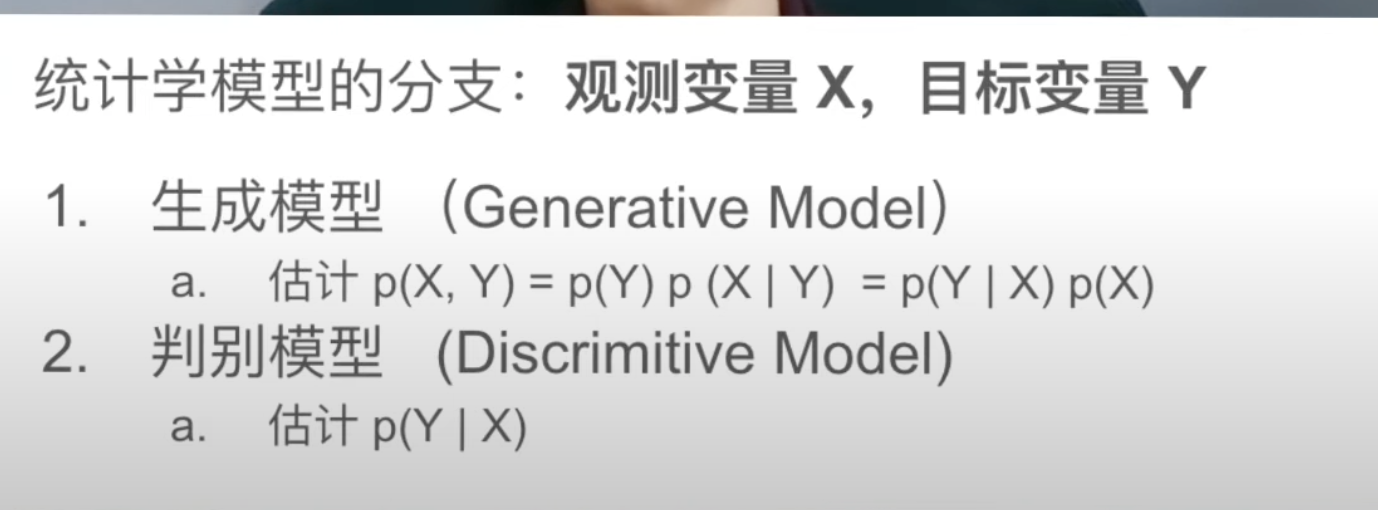

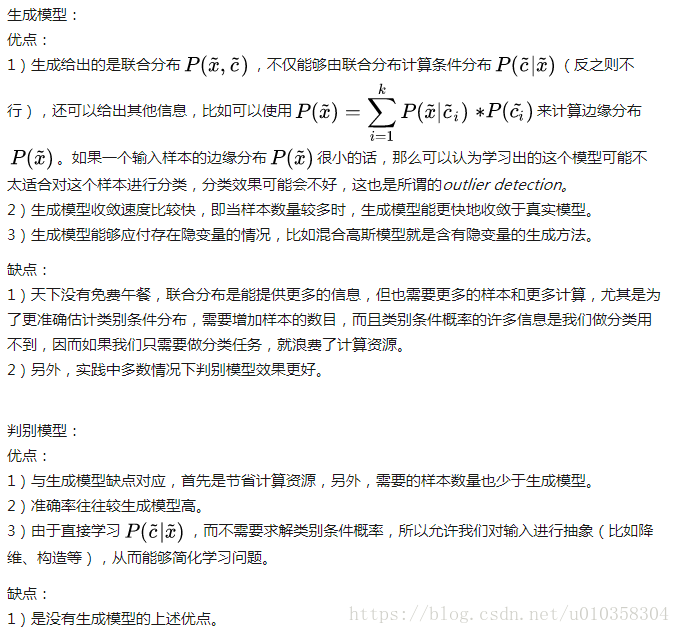

理解使用生成式模型f(x)=sigmoid(wx+b) 进行二分类所蕴含的数学意义

实际就是这里不用求两个高斯分布的参数’

所以给定一个 x,属于C1类的概率就可以用sigmoid(w*x+b)来表示

用一张图形象展示判别模型和生成模型的区别

(要结合上面的知识点)

模型是一样的,但是生成模型不同训练样本找出来的模型参数(根据不同的假设找出不同的w和b)是不一样的,而判别模型是一样的

生成模型 :源头导向型,关注数据时如何生成的,然后再对一个信号进行分类。(信号输入时,生成模型判断哪个类别最有可能产生这个信号,则这个信号就属于哪个类别。

判别模型 :结果导向型,关注类别之间的差别,并不关心样本的数据时怎么生成的,根据样本之间的“分界线"来简单对给定的样本进行分类。

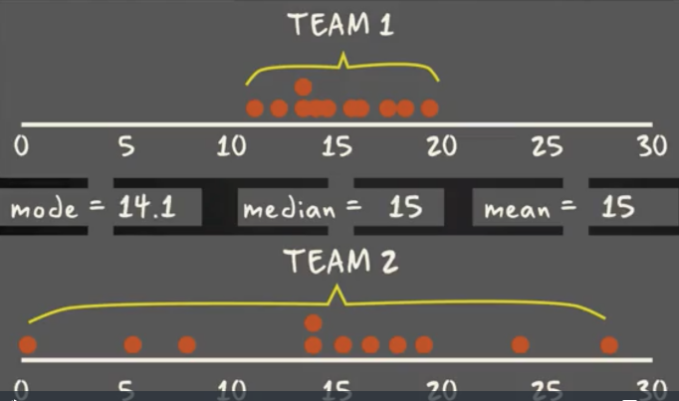

偏差和方差

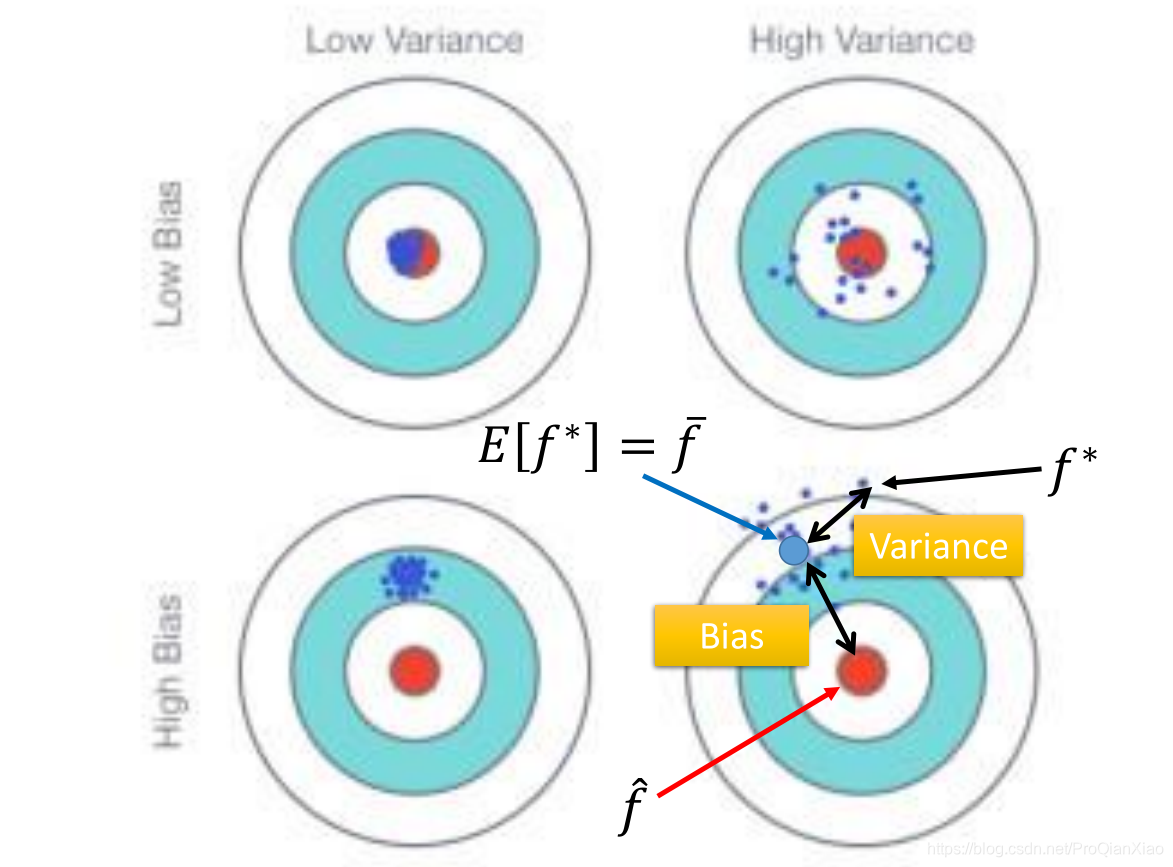

这篇博客介绍机器学习中误差(error)的来源,知道我们的模型中产生的误差来自于哪一部分,才能更好地进行模型的调整。一般来说,误差的来源有两部分:偏差(bias)和方差(variance)。偏差和方差——用来衡量模型泛化能力的工具,所以我的理解是在测试集上面根据偏差和方差来对模型进行一个评估。

回顾之前回归问题中的例子,简单模型对于数据的拟合能力比较差,在训练集和测试集上面效果均不好;但同时不是越复杂的模型越好,因为有可能产生过拟合的现象,所以需要选择合适的模型。偏差-方差分析可以帮我们诊断模型中存在的问题(过于复杂或者过于简单)。

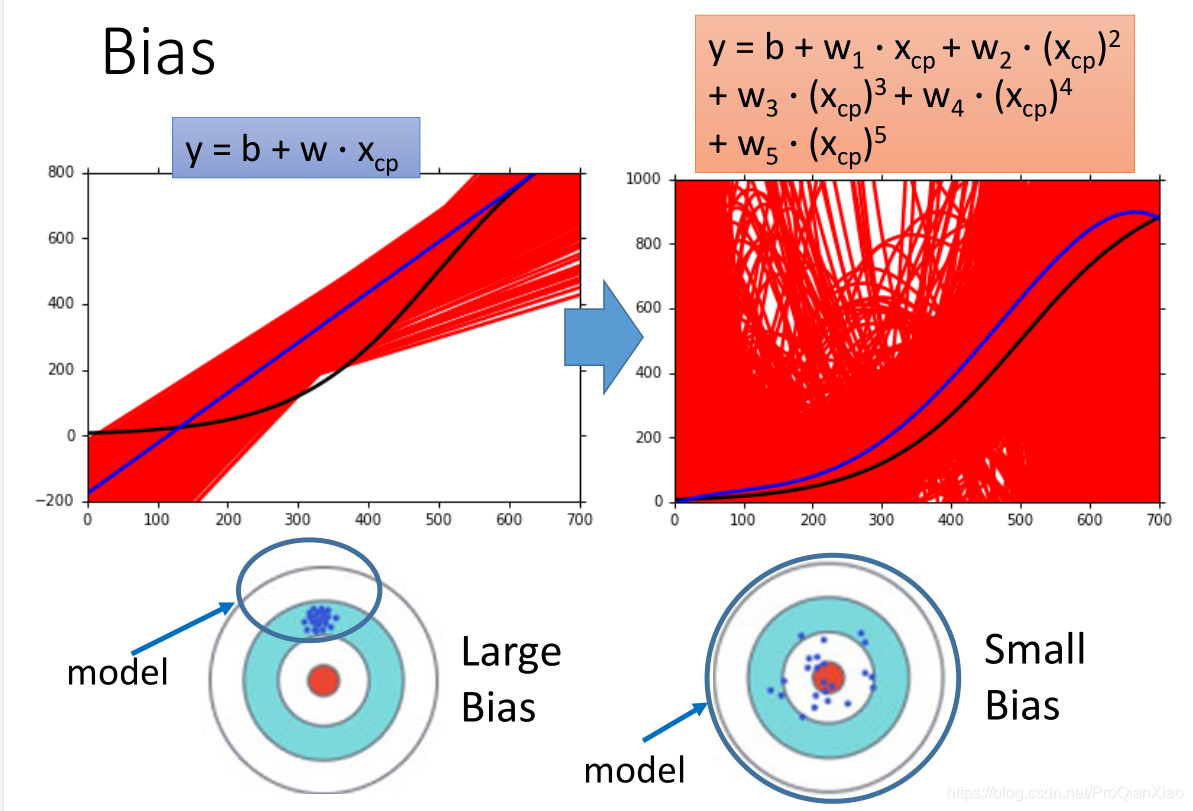

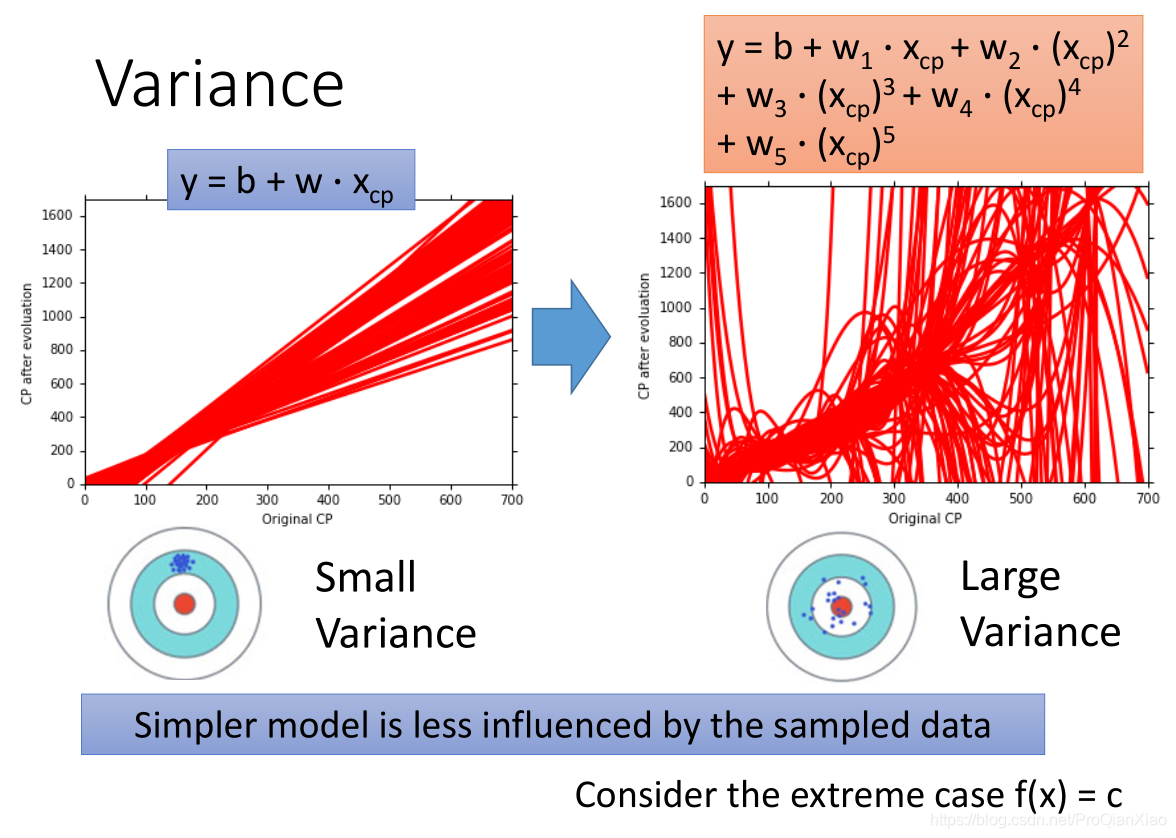

偏差就是:预测输出的期望值 - 真实值,(描述模型的拟合能力)

方差就是:(每个模型实例的预测输出 - 模型预测输出的期望值)^ 2 (描述模型的稳定性,即受数据扰动的影响程度)

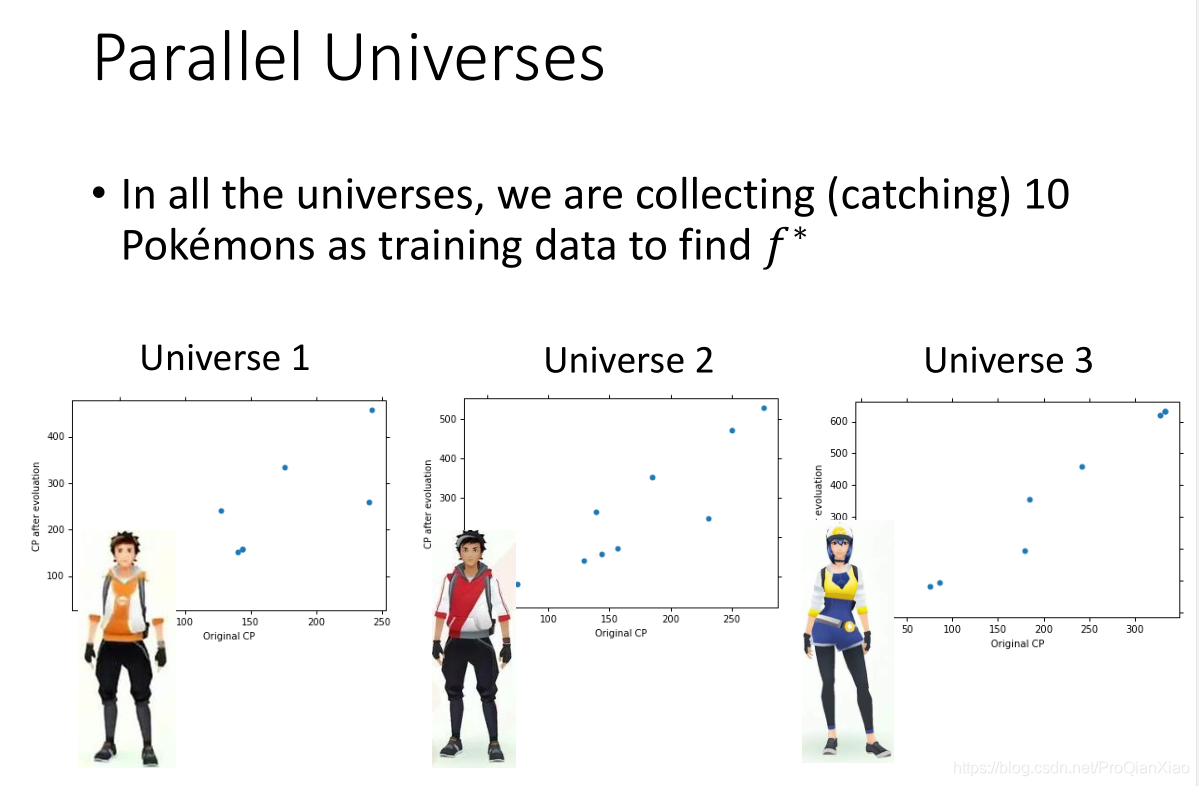

还是以宝可梦进化之后的CP值预测为例,如果我们有一些不同的训练数据(也就是李宏毅老师PPT中所说从若干个平行世界中收集的不同的宝可梦),

实质上是指有几个不同的训练集(TrainData_1,TrainData_2,TrainData_3),模型分别在不同的训练集上面训练,然后在同样的测试集(TestData)上面测试。对于不同的训练集,我们会得到一个模型的实例,比如有一次模型和五次模型,训练结果:(这里,“模型”表示具体的模型类别(比如一次模型,二次模型);“模型实例”表示一个模型在不同训练集上面训练得到的最终模型,有几个训练集就会有几个模型实例。)

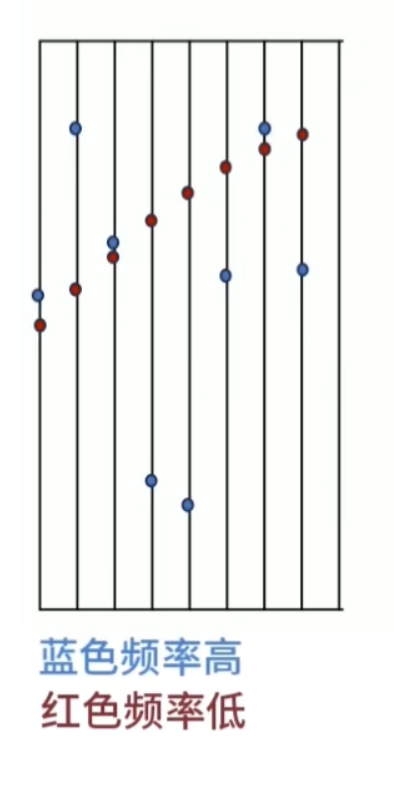

图片中,红色线表示在100个不同的训练集上面得到的模型的实例,蓝色线表示模型的预测输出的期望,黑色线是真实值。

可以看出,一次模型的偏差较大,方差较小;五次模型的偏差较小,方差较大。

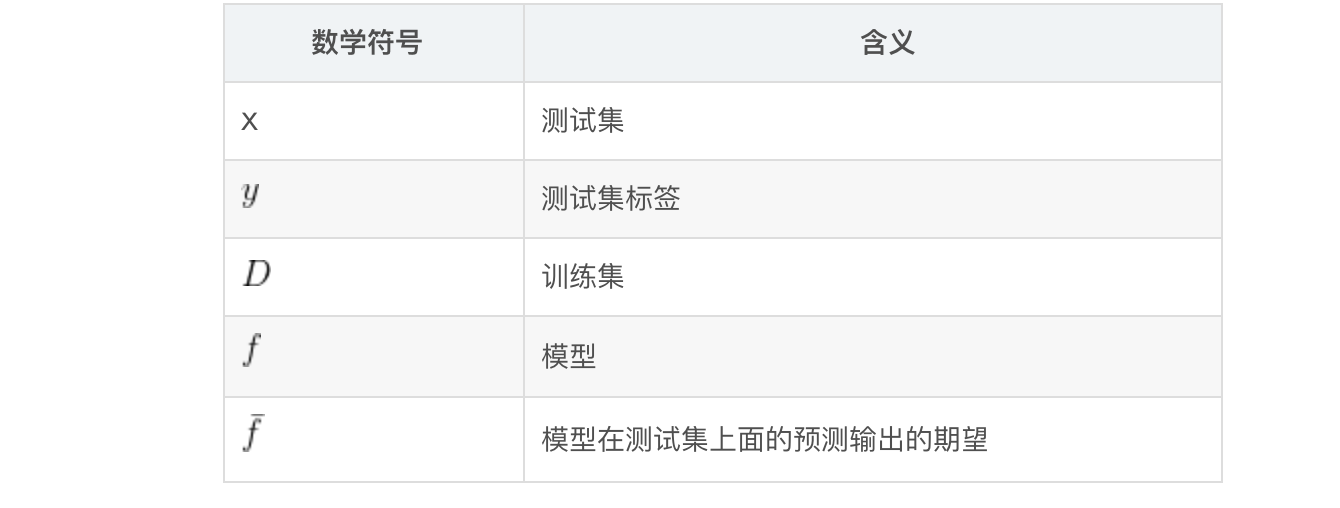

数学定义

上面是偏差和方差一个比较直观的理解,接下来给出数学形式的定义:

偏差-方差与模型复杂度

偏差和方差的几种情况:

偏差小,方差小:追求的目标,理想的模型。 偏差小,方差大:模型比较复杂,在训练集上面过拟合,导致在测试集上面泛化效果不好。 偏差大,方差小:模型比较简单,拟合能力较差,在训练集上面欠拟合,导致在测试集上面泛化效果不好。 偏差大,方差大:最糟的情况,模型需要重新进行设计,不适合于现有数据集。

很直观的一个解释,因为偏差度量了学习算法的期望预测与真实结果的偏离程度,即刻画了学习算法本身的拟合能力,所以偏差大的模型拟合能力差,模型简单,容易欠拟合;方差度量数据扰动所造成的影响(在不同的训练集上面训练得到的模型在测试集上面效果表现相差很大),说明模型过于拟合训练集,模型复杂。

调整方法

综上,根据模型在测试集上的表现,可以得出结论:

偏差大,方差小:模型欠拟合

偏差小,方差大:模型过拟合

对于偏差大(欠拟合)的情况,常用的解决方法:

• 重新设计模型,使用更复杂的模型结构

• 输入中使用更多的特征

对于方差大(过拟合)的情况,常用的解决方法:

• 参数正则化(减小模型的复杂程度)

• 使用更多的训练数据

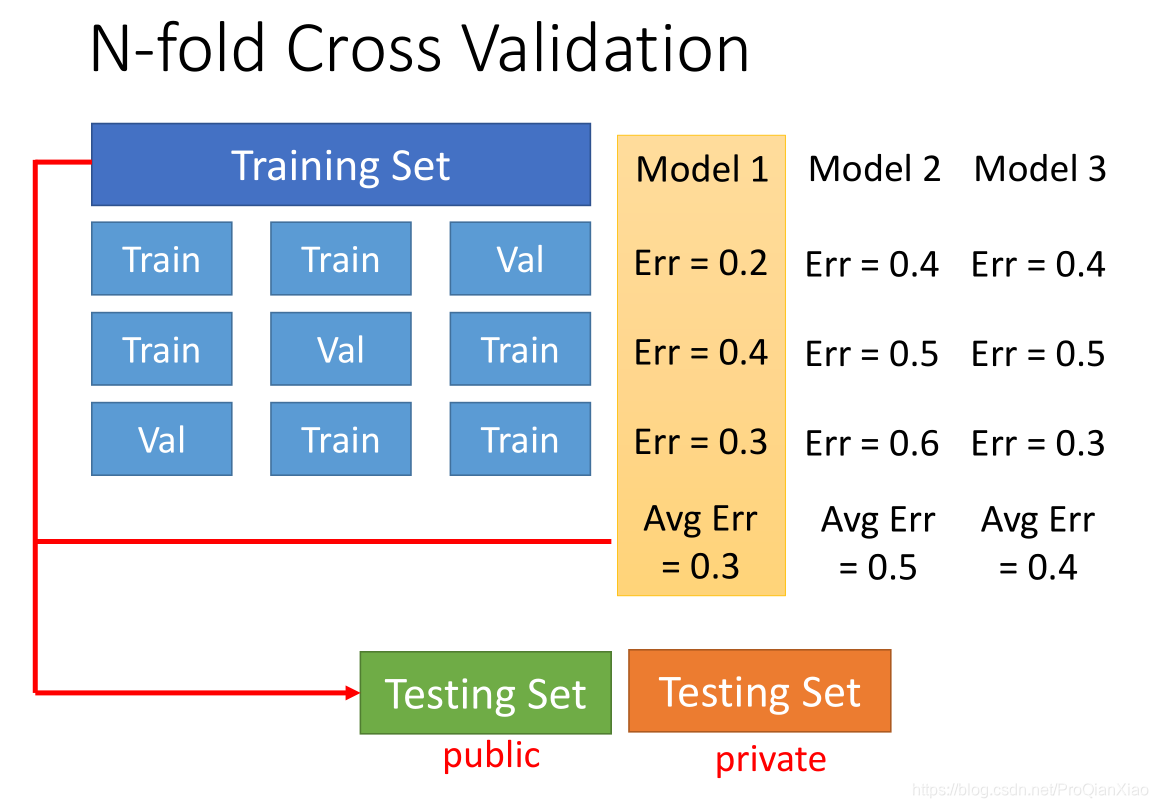

K-折交叉验证

模型的设计选择需要在偏差和方差之间进行平衡,在选择合适的模型(比如一次模型还是二次模型)时,常用的方法是进行K-折交叉验证。将训练集的数据等分成K份,每次使用(K-1)份数据进行训练,余下的1份数据进行验证,进行K次,保证每份数据均做过验证集,统计K次验证集上面的loss,取loss均值最小的模型作为使用的模型。

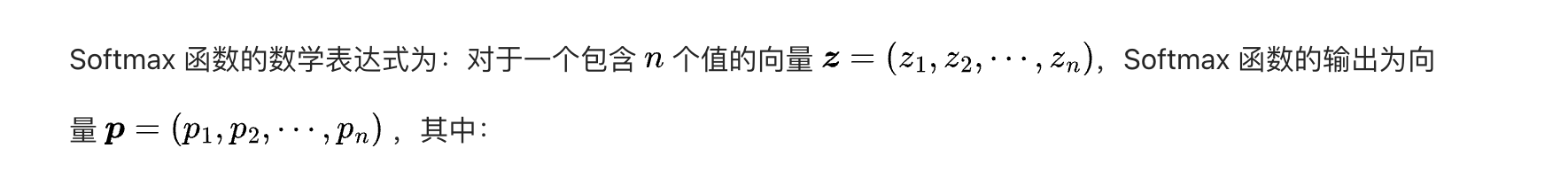

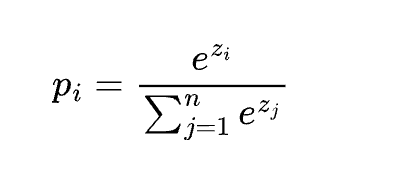

softmax

主要用途:

softmax是深度学习任务中常用于计算最终输出类别的函数。

Softmax 函数主要用于多分类问题中,将多个神经元的输出值转换为概率分布。

Softmax 函数在很多机器学习任务中都有广泛的应用,比如图像分类、文本分类等,它有助于将模型的输出转化为可解释的类别概率。

- softmax和我们普通意义上的max函数不同,每一个元素都有一个概率,而不是其中一个元素为1,其余为0。它的含义是对于输入向量,有多大的概率去选择元素1、元素2、元素3等,主要的目的是使得概率计算过程可导。

以下是对 Softmax 函数的一些关键理解点:

- 输出值在 0 到 1 之间:Softmax 函数确保每个输出值都在 0 和 1 之间。

- 输出值总和为 1:所有输出值的总和为 1,这使得它们可以被解释为概率。

- 强调相对大小:Softmax 函数会放大输入值之间的差异。较大的输入值在经过 Softmax 计算后会得到更大的概率值,较小的输入值则会得到较小的概率值。

例如,假设有一个神经网络的输出为 [1, 2, 0],经过 Softmax

函数计算后,得到的概率分布可能是

[0.269, 0.731, 0.0]。这意味着模型预测第二个类别是最有可能的,第一个类别有一定的可能性,而第三个类别几乎不可能。

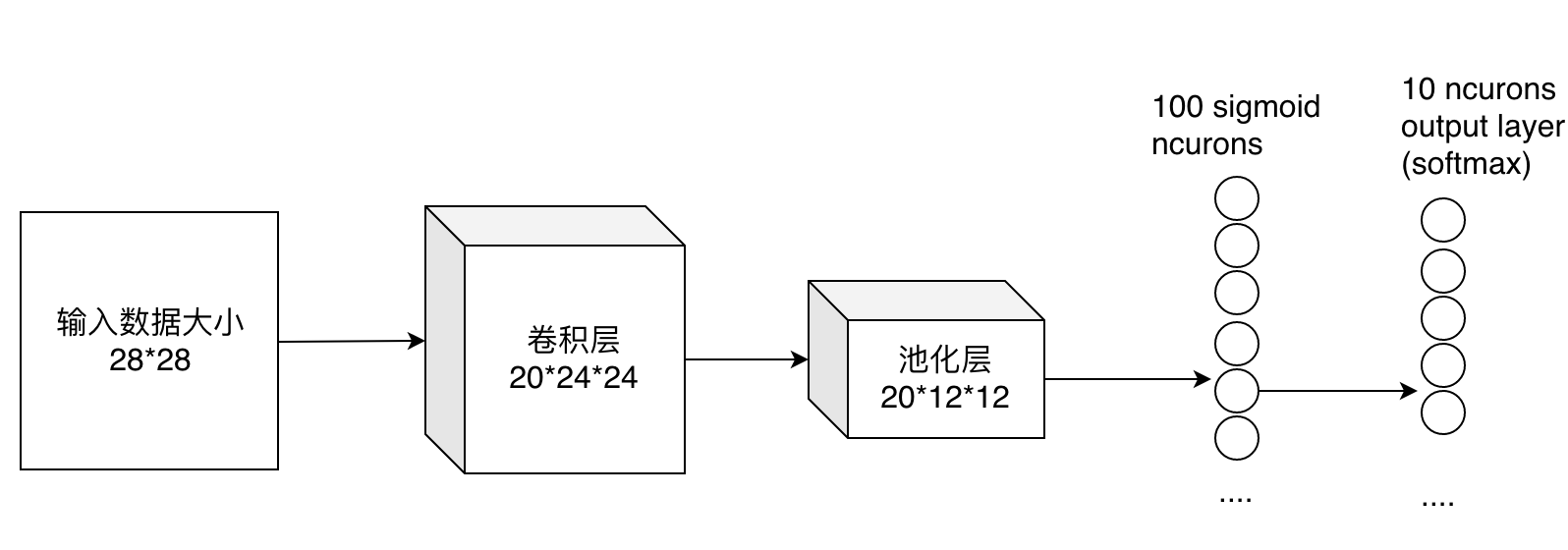

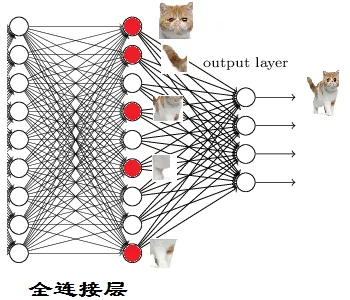

全连接层(Fully Connected Layer)

全连接层(Fully Connected Layer),也称为密集层(Dense Layer),是一种在深度学习中广泛使用的神经网络层。

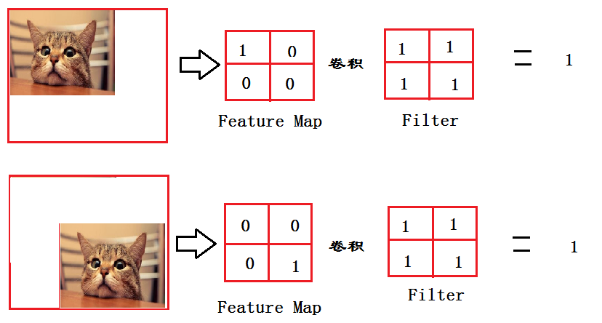

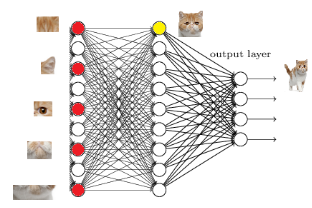

全连接层在整个网络卷积神经网络中起到“分类器”的作用。如果说卷积层、池化层和激活函数等操作是将原始数据映射到隐层特征空间的话, 全连接层则起到将学到的特征表示映射到样本的标记空间的作用 。

在 CNN 中,全连接常出现在最后几层,用于对前面设计的特征做加权和。比如 mnist,前面的卷积和池化相当于做特征工程,后面的全连接相当于做特征加权。(卷积相当于全连接的有意弱化,按照局部视野的启发,把局部之外的弱影响直接抹为零影响;还做了一点强制,不同的局部所使用的参数居然一致。弱化使参数变少,节省计算量,又专攻局部不贪多求全;强制进一步减少参数。少即是多) 在 RNN 中,全连接用来把 embedding 空间拉到隐层空间,把隐层空间转回 label 空间等。

一段来自知乎的通俗理解:

从卷积网络谈起,卷积网络在形式上有一点点像咱们正在召开的“人民代表大会”。卷积核的个数相当于候选人,图像中不同的特征会激活不同的“候选人”(卷积核)。池化层(仅指最大池化)起着类似于“合票”的作用,不同特征在对不同的“候选人”有着各自的喜好。

全连接相当于是“代表普选”。所有被各个区域选出的代表,对最终结果进行“投票”,全连接保证了receiptive field 是整个图像,既图像中各个部分(所谓所有代表),都有对最终结果影响的权利。

在实际使用中,全连接层可由卷积操作实现 :对前层是全连接的全连接层可以转换为卷积核为1*1的卷积;而前层是卷积层的全连接层可以转换为卷积核为前层卷积输出结果的高和宽一样大小的全局卷积。

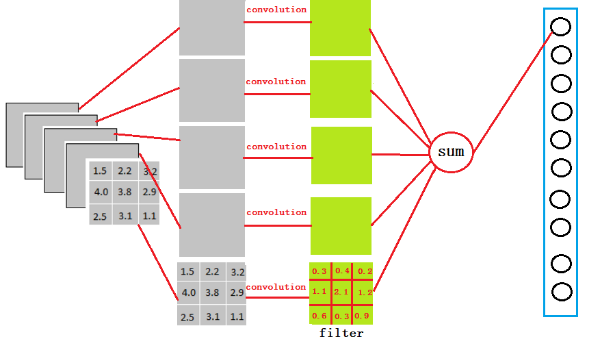

最后的两列小圆球就是两个全连接层,在最后一层卷积结束后,进行了最后一次池化,输出了20个12*12的图像,然后通过了一个全连接层变成了1*100的向量。

这是怎么做到的呢,其实就是 有20*100个12*12的不同卷积核卷积出来的 ,我们也可以这样想,就是 每个神经元的输出是12*12*20个输入值与对应的权值乘积的和 。对于输入的 每一张图,用了一个和图像一样大小的核卷积,这样整幅图就变成了一个数了 ,如果厚度是20就是那20个核卷积完了之后相加求和。这样就能把一张图高度浓缩成一个数了。

一、结构与原理

全连接层中的每个神经元都与上一层的所有神经元相连接。这意味着如果上一层有\(n\)个神经元,那么全连接层中的每个神经元都有\(n\)个输入权重。

在全连接层中,输入数据通常是一个一维向量,它是通过将上一层的多维特征图展平得到的。每个神经元对输入向量进行加权求和,并通过一个激活函数得到输出。

数学表达式可以表示为:\(y = f(Wx + b)\),其中\(x\)是输入向量,\(W\)是权重矩阵,\(b\)是偏置项,\(f(\cdot)\)是激活函数,\(y\)是输出。

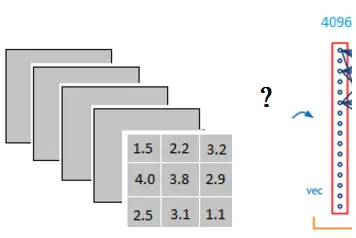

它是怎么样把3x3x5的输出,转换成1x4096的形式

很简单,可以理解为在中间做了一个卷积

从上图我们可以看出,我们用一个3x3x5的filter 去卷积激活函数的输出,得到的结果就是一个fully connected layer 的一个神经元的输出,这个输出就是一个值

因为我们有4096个神经元

我们实际就是用一个3x3x5x4096的卷积层去卷积激活函数的输出

以VGG-16再举个例子吧

再VGG-16全连接层中

对224x224x3的输入,最后一层卷积可得输出为7x7x512,如后层是一层含4096个神经元的FC,则可用卷积核为7x7x512x4096的全局卷积来实现这一全连接运算过程。

很多人看到这,可能就恍然大悟

哦,我懂了,就是做个卷积呗

不

你不懂

这一步卷积一个非常重要的作用

就是把分布式特征representation映射到样本标记空间

什么,听不懂

那我说人话

就是它把特征representation整合到一起,输出为一个值

这样做,有一个什么好处?

就是大大减少特征位置对分类带来的影响

来,让我来举个简单的例子

这个例子可能过于简单了点

可是我懒得画了,大家将就着看吧

从上图我们可以看出,猫在不同的位置,输出的feature值相同,但是位置不同

对于电脑来说,特征值相同,但是特征值位置不同,那分类结果也可能不一样

而这时全连接层filter的作用就相当于

喵在哪我不管

我只要喵

于是我让filter去把这个喵找到

实际就是把feature map 整合成一个值

这个值大

哦,有喵

这个值小

那就可能没喵

和这个喵在哪关系不大了有没有

鲁棒性有大大增强了有没有

喵喵喵

因为空间结构特性被忽略了,所以全连接层不适合用于在方位上找Pattern的任务,比如segmentation

ok, 我们突然发现全连接层有两层1x4096fully connected layer平铺结构(有些网络结构有一层的,或者二层以上的)

好吧也不是突然发现,我只是想增加一点戏剧效果

但是大部分是两层以上呢

这是为啥子呢

泰勒公式都知道吧

意思就是用多项式函数去拟合光滑函数

我们这里的全连接层中一层的一个神经元就可以看成一个多项式

我们用许多神经元去拟合数据分布

但是只用一层fully connected layer 有时候没法解决非线性问题

而如果有两层或以上fully connected layer就可以很好地解决非线性问题了

说了这么多,我猜你应该懂的

听不懂?

那我换个方式给你讲

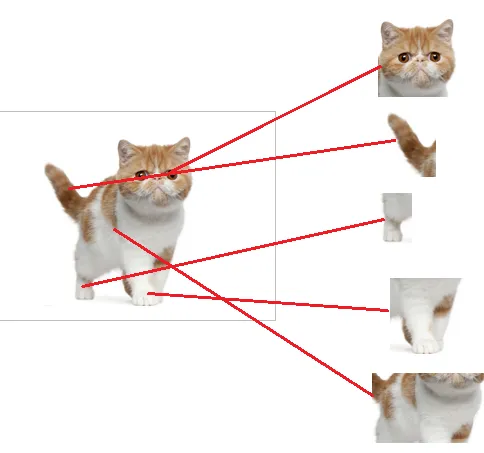

我们都知道,全连接层之前的作用是提取特征

全理解层的作用是分类

我们现在的任务是去区别一图片是不是猫

假设这个神经网络模型已经训练完了

全连接层已经知道

当我们得到以上特征,我就可以判断这个东东是猫了

因为全连接层的作用主要就是实现分类(Classification)

从下图,我们可以看出

红色的神经元表示这个特征被找到了(激活了)

同一层的其他神经元,要么猫的特征不明显,要么没找到

当我们把这些找到的特征组合在一起,发现最符合要求的是猫

ok,我认为这是猫了

那我们现在往前走一层

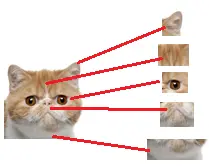

那们现在要对子特征分类,也就是对猫头,猫尾巴,猫腿等进行分类

比如我们现在要把猫头找出来

猫头有这么些个特征

于是我们下一步的任务

就是把猫头的这么些子特征找到,比如眼睛啊,耳朵啊

道理和区别猫一样

当我们找到这些特征,神经元就被激活了(上图红色圆圈)

这细节特征又是怎么来的?

就是从前面的卷积层,下采样层来的

至此,关于全连接层的信息就简单介绍完了

全连接层参数特多(可占整个网络参数80%左右),近期一些性能优异的网络模型如ResNet和GoogLeNet等均用全局平均池化(global average pooling,GAP)取代全连接层来融合学到的深度特征

需要指出的是,用GAP替代FC的网络通常有较好的预测性能

于是还出现了

[1411.4038] Fully Convolutional Networks for Semantic Segmentationarxiv.org/abs/1411.4038

以后会慢慢介绍的

.

.

.

二、作用

- 特征融合与变换

- 全连接层可以将上一层学习到的局部特征进行融合和变换,提取更高级别的全局特征。通过调整权重和偏置,全连接层可以学习到不同特征之间的复杂关系。

- 分类与回归

- 在神经网络的最后几层,全连接层通常用于分类或回归任务。通过将学习到的特征映射到输出类别或数值,全连接层可以对输入数据进行预测。

三、特点

- 参数数量多

- 由于全连接层中的每个神经元都与上一层的所有神经元相连接,因此全连接层通常具有大量的参数。这使得全连接层在训练过程中需要大量的计算资源和数据,并且容易过拟合。

- 可解释性差

- 全连接层中的权重和偏置通常难以解释,因为它们是通过复杂的优化过程学习得到的。这使得全连接层在一些需要可解释性的应用中受到限制。

四、应用场景

- 图像分类

- 在图像分类任务中,全连接层通常用于将卷积神经网络学习到的图像特征映射到不同的类别。例如,在ResNet等经典的图像分类网络中,最后几层通常是全连接层。

- 自然语言处理

- 在自然语言处理任务中,全连接层可以用于将词向量或句子向量映射到不同的语义类别或情感标签。例如,在文本分类、情感分析等任务中,全连接层通常是神经网络的最后几层。

- 语音识别

- 在语音识别任务中,全连接层可以用于将声学特征映射到不同的音素或单词。例如,在深度神经网络语音识别系统中,全连接层通常用于将学习到的声学特征进行分类。

嵌入(embedding)层的理解

embedding层作用:①降维②对低维的数据进行升维时,可能把一些其他特征给放大了,或者把笼统的特征给分开了。

Embedding其实就是一个映射,从原先所属的空间映射到新的多维空间中,也就是把原先所在空间嵌入到一个新的空间中去。

嵌入层的一个作用——降维

首先,我们有一个one-hot编码的概念。

假设,我们中文,一共只有10个字。。。只是假设啊,那么我们用0-9就可以表示完

比如,这十个字就是“我从哪里来,要到何处去”

其分别对应“0-9”,如下:

我 从 哪 里 来 要 到 何 处 去

0 1 2 3 4 5 6 7 8 9

那么,其实我们只用一个列表就能表示所有的对话

如:我 从 哪 里 来 要 到 何 处 去 ——>>>[0 1 2 3 4 5 6 7 8 9]

或:我 从 何 处 来 要 到 哪 里 去 ——>>>[0 1 7 8 4 5 6 2 3 9]

但是,我们看看one-hot编码方式(详见:https://blog.csdn.net/tengyuan93/article/details/78930285)

他把上面的编码方式弄成这样

--我从哪里来,要到何处去

[ [1 0 0 0 0 0 0 0 0 0] [0 1 0 0 0 0 0 0 0 0] [0 0 1 0 0 0 0 0 0 0] [0 0 0 1 0 0 0 0 0 0] [0 0 0 0 1 0 0 0 0 0] [0 0 0 0 0 1 0 0 0 0] [0 0 0 0 0 0 1 0 0 0] [0 0 0 0 0 0 0 1 0 0] [0 0 0 0 0 0 0 0 1 0] [0 0 0 0 0 0 0 0 0 1]]

--我从何处来,要到哪里去

[ [1 0 0 0 0 0 0 0 0 0] [0 1 0 0 0 0 0 0 0 0] [0 0 0 0 0 0 0 1 0 0] [0 0 0 0 0 0 0 0 1 0] [0 0 0 0 1 0 0 0 0 0] [0 0 0 0 0 1 0 0 0 0] [0 0 0 0 0 0 1 0 0 0] [0 0 1 0 0 0 0 0 0 0] [0 0 0 1 0 0 0 0 0 0] [0 0 0 0 0 0 0 0 0 1]] 即:把每一个字都对应成一个十个(样本总数/字总数)元素的数组/列表,其中每一个字都用唯一对应的数组/列表对应,数组/列表的唯一性用1表示。如上,“我”表示成[1。。。。],“去”表示成[。。。。1],这样就把每一系列的文本整合成一个稀疏矩阵。

那问题来了,稀疏矩阵(二维)和列表(一维)相比,有什么优势。

很明显,计算简单嘛,稀疏矩阵做矩阵计算的时候,只需要把1对应位置的数相乘求和就行,也许你心算都能算出来;而一维列表,你能很快算出来?何况这个列表还是一行,如果是100行、1000行和或1000列呢?

所以,one-hot编码的优势就体现出来了,计算方便快捷、表达能力强。

然而,缺点也随着来了。

比如:中文大大小小简体繁体常用不常用有十几万,然后一篇文章100W字,你要表示成100W X 10W的矩阵???

这是它最明显的缺点。过于稀疏时,过度占用资源。

比如:其实我们这篇文章,虽然100W字,但是其实我们整合起来,有99W字是重复的,只有1W字是完全不重复的。那我们用100W X 10W的岂不是白白浪费了99W X 10W的矩阵存储空间。

那怎么办???

这时,Embedding层横空出世。

接下来给大家看一张图

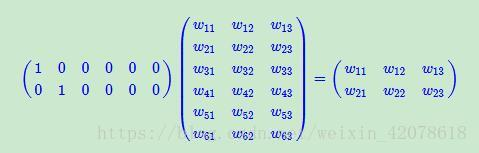

假设:我们有一个2 x 6的矩阵,然后乘上一个6 x 3的矩阵后,变成了一个2 x 3的矩阵。

先不管它什么意思,这个过程,我们把一个12个元素的矩阵变成6个元素的矩阵,直观上,大小是不是缩小了一半?

也许你已经想到了!!!对!!!不管你想的对不对,但是embedding层,在某种程度上,就是用来降维的,降维的原理就是矩阵乘法。在卷积网络中,可以理解为特殊全连接层操作,跟1x1卷积核异曲同工!!!484很神奇!!!

也就是说,假如我们有一个100W X10W的矩阵,用它乘上一个10W X 20的矩阵,我们可以把它降到100W X 20,瞬间量级降了。。。10W/20=5000倍!!!

这就是嵌入层的一个作用——降维。

然后中间那个10W X 20的矩阵,可以理解为查询表,也可以理解为映射表,也可以理解为过度表,whatever。

嵌入层的一个作用——升维

接着,既然可以降维,当然也可以升维。为什么要升维?------------可能把一些其他特征给放大了,或者把笼统的特征给分开了

这张图,我要你在10米开外找出五处不同!。。。What?烦请出题者走近两步,我先把我的刀拿出来,您再说一遍题目我没听清。

当然,目测这是不可能完成的。但是我让你在一米外,也许你一瞬间就发现衣服上有个心是不同的,然后再走近半米,你又发现左上角和右上角也是不同的。再走近20厘米,又发现耳朵也不同,最后,在距离屏幕10厘米的地方,终于发现第五个不同的地方在耳朵下面一点的云。

但是,其实无限靠近并不代表认知度就高了,比如,你只能距离屏幕1厘米远的地方找,找出五处不同。。。出题人你是不是脑袋被门挤了。。。

由此可见,距离的远近会影响我们的观察效果。同理也是一样的,

低维的数据可能包含的特征是非常笼统的,我们需要不停地拉近拉远来改变我们的感受野,让我们对这幅图有不同的观察点,找出我们要的茬。

embedding的又一个作用体现了。对低维的数据进行升维时,可能把一些其他特征给放大了,或者把笼统的特征给分开了。同时,这个embedding是一直在学习在优化的,就使得整个拉近拉远的过程慢慢形成一个良好的观察点。比如:我来回靠近和远离屏幕,发现45厘米是最佳观测点,这个距离能10秒就把5个不同点找出来了。

回想一下为什么CNN层数越深准确率越高,卷积层卷了又卷,池化层池了又升,升了又降,全连接层连了又连。因为我们也不知道它什么时候突然就学到了某个有用特征。但是不管怎样,学习都是好事,所以让机器多卷一卷,多连一连,反正错了多少我会用交叉熵告诉你,怎么做才是对的我会用梯度下降算法告诉你,只要给你时间,你迟早会学懂。因此,理论上,只要层数深,只要参数足够,NN能拟合任何特征。总之,它类似于虚拟出一个关系对当前数据进行映射。这个东西也许一言难尽吧,但是目前各位只需要知道它有这些功能的就行了。

接下来,继续假设我们有一句话,叫“公主很漂亮”,如果我们使用one-hot编码,可能得到的编码如下:

公 [0 0 0 0 1] 主 [0 0 0 1 0] 很 [0 0 1 0 0] 漂 [0 1 0 0 0] 亮 [1 0 0 0 0] 乍一眼看过似乎没毛病,其实本来人家也没毛病,或者假设咱们的词袋更大一些

公 [0 0 0 0 1 0 0 0 0 0] 主 [0 0 0 1 0 0 0 0 0 0] 很 [0 0 1 0 0 0 0 0 0 0] 漂 [0 1 0 0 0 0 0 0 0 0] 亮 [1 0 0 0 0 0 0 0 0 0] 假设吧,就假设咱们的词袋一共就10个字,则这一句话的编码如上所示。

这样的编码,最大的好处就是,不管你是什么字,我们都能在一个一维的数组里用01给你表示出来。并且不同的字绝对不一样,以致于一点重复都没有,表达本征的能力极强。

(缺陷)但是,因为其完全独立,其劣势就出来了。表达关联特征的能力几乎为0!!!

我给你举个例子,我们又有一句话“王妃很漂亮”

那么在这基础上,我们可以把这句话表示为

王 [0 0 0 0 0 0 0 0 0 1] 妃 [0 0 0 0 0 0 0 0 1 0] 很 [0 0 1 0 0 0 0 0 0 0] 漂 [0 1 0 0 0 0 0 0 0 0] 亮 [1 0 0 0 0 0 0 0 0 0] 从中文表示来看,我们一下就跟感觉到,王妃跟公主其实是有很大关系的,比如:公主是皇帝的女儿,王妃是皇帝的妃子,可以从“皇帝”这个词进行关联上;公主住在宫里,王妃住在宫里,可以从“宫里”这个词关联上;公主是女的,王妃也是女的,可以从“女”这个字关联上。

但是呢,我们用了one-hot编码,公主和王妃就变成了这样:

公 [0 0 0 0 1 0 0 0 0 0] 主 [0 0 0 1 0 0 0 0 0 0] 王 [0 0 0 0 0 0 0 0 0 1] 妃 [0 0 0 0 0 0 0 0 1 0] 你说,你要是不看前面的中文注解,你知道这四行向量有什么内部关系吗?看不出来,那怎么办?

既然,通过刚才的假设关联,我们关联出了“皇帝”、“宫里”和“女”三个词,那我们尝试这么去定义公主和王妃

公主一定是皇帝的女儿,我们假设她跟皇帝的关系相似度为1.0;公主从一出生就住在宫里,直到20岁才嫁到府上,活了80岁,我们假设她跟宫里的关系相似度为0.25;公主一定是女的,跟女的关系相似度为1.0;

王妃是皇帝的妃子,没有亲缘关系,但是有存在着某种关系,我们就假设她跟皇帝的关系相似度为0.6吧;妃子从20岁就住在宫里,活了80岁,我们假设她跟宫里的关系相似度为0.75;王妃一定是女的,跟女的关系相似度为1.0;

于是公主王妃四个字我们可以这么表示:

皇 宫 帝 里 女 公主 [ 1.0 0.25 1.0] 王妃 [ 0.6 0.75 1.0] 这样我们就把公主和王妃两个词,跟皇帝、宫里、女这几个字(特征)关联起来了,我们可以认为:

**公主=1.0 皇帝 +0.25宫里 +1.0*女**

**王妃=0.6 皇帝 +0.75宫里 +1.0*女**

或者这样,我们假设没歌词的每个字都是对等(注意:只是假设,为了方便解释):

皇 宫 帝 里 女 公 [ 0.5 0.125 0.5] 主 [ 0.5 0.125 0.5] 王 [ 0.3 0.375 0.5] 妃 [ 0.3 0.375 0.5] 这样,我们就把一些词甚至一个字,用三个特征给表征出来了。然后,我们把皇帝叫做特征(1),宫里叫做特征(2),女叫做特征(3),于是乎,我们就得出了公主和王妃的隐含特征关系:

王妃=公主的特征(1) * 0.6 +公主的特征(2) * 3 +公主的特征(3) * 1

于是乎,我们把文字的one-hot编码,从稀疏态变成了密集态,并且让相互独立向量变成了有内在联系的关系向量。

所以,embedding层做了个什么呢?它把我们的稀疏矩阵,通过一些线性变换(在CNN中用全连接层进行转换,也称为查表操作),变成了一个密集矩阵,这个密集矩阵用了N(例子中N=3)个特征来表征所有的文字,在这个密集矩阵中,表象上代表着密集矩阵跟单个字的一一对应关系,实际上还蕴含了大量的字与字之间,词与词之间甚至句子与句子之间的内在关系(如:我们得出的王妃跟公主的关系)。他们之间的关系,用的是嵌入层学习来的参数进行表征。

从稀疏矩阵到密集矩阵的过程,叫做embedding,很多人也把它叫做查表,因为他们之间也是一个一一映射的关系。

更重要的是,这种关系在反向传播的过程中,是一直在更新的,因此能在多次epoch后,使得这个关系变成相对成熟,即:正确的表达整个语义以及各个语句之间的关系。这个成熟的关系,就是embedding层的所有权重参数。

Embedding是NPL领域最重要的发明之一,他把独立的向量一下子就关联起来了。这就相当于什么呢,相当于你是你爸的儿子,你爸是A的同事,B是A的儿子,似乎跟你是八竿子才打得着的关系。结果你一看B,是你的同桌。Embedding层就是用来发现这个秘密的武器。

torch.nn.Embedding是PyTorch中的一个嵌入层,它可以将离散的输入(如单词的索引)映射到连续的向量空间中。下面是一些使用

torch.nn.Embedding的例子:

1. 单词嵌入(Word Embedding)

在自然语言处理(NLP)任务中,我们通常将单词表示为一个整数索引,然后使用嵌入层将这些索引映射到一个连续的向量空间中。这样,语义上相似的单词会被映射到向量空间中的相近位置。

1 | import torch |

2. 位置嵌入(Positional Embedding)

在序列数据中,位置信息非常重要,因为序列中的元素顺序会影响其含义。位置嵌入层的作用就是给每个位置分配一个唯一的向量,这样模型就可以学习到位置信息。

1 | import torch |

3. 图像嵌入(Image Embedding)

在计算机视觉任务中,我们通常将图像表示为一个像素值的张量。然后,我们可以使用嵌入层将这些像素值映射到一个连续的向量空间中,以便进行进一步的处理或分析。

1 | import torch |

在这些例子中,我们使用

torch.nn.Embedding将离散的输入(如单词索引、位置索引或像素索引)映射到连续的向量空间中。这些向量可以捕捉到输入值的一些语义信息,从而更好地处理数据。

池化层

池化层夹在连续的卷积层中间, 用于压缩数据和参数的量,减小过拟合

简而言之,如果输入是图像的话,那么池化层的最主要作用就是压缩图像

池化层的作用

主要是两个作用:

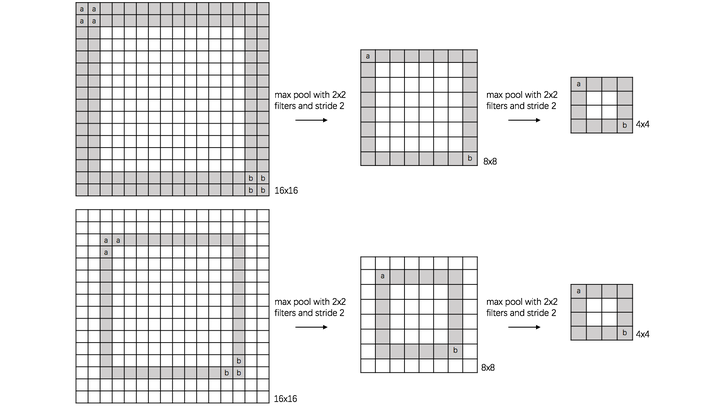

- invariance(不变性),这种不变性包括translation(平移),rotation(旋转),scale(尺度)

- 保留主要的特征同时减少参数(降维,效果类似PCA)和计算量,防止过拟合,提高模型泛化能力

A: 特征不变性,也就是我们在图像处理中经常提到的特征的尺度不变性,池化操作就是图像的resize,平时一张狗的图像被缩小了一倍我们还能认出这是一张狗的照片,这说明这张图像中仍保留着狗最重要的特征,我们一看就能判断图像中画的是一只狗,图像压缩时去掉的信息只是一些无关紧要的信息,而留下的信息则是具有尺度不变性的特征,是最能表达图像的特征。

B. 特征降维,我们知道一幅图像含有的信息是很大的,特征也很多,但是有些信息对于我们做图像任务时没有太多用途或者有重复,我们可以把这类冗余信息去除,把最重要的特征抽取出来,这也是池化操作的一大作用

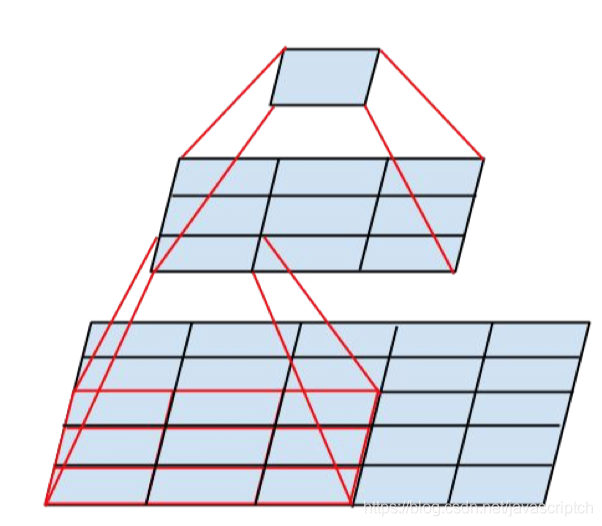

translation invariance: 这里举一个直观的例子(数字识别),假设有一个16x16的图片,里面有个数字1,我们需要识别出来,这个数字1可能写的偏左一点(图1),这个数字1可能偏右一点(图2),图1到图2相当于向右平移了一个单位,但是图1和图2经过max pooling之后它们都变成了相同的8x8特征矩阵,主要的特征我们捕获到了,同时又将问题的规模从16x16降到了8x8,而且具有平移不变性的特点。图中的a(或b)表示,在原始图片中的这些a(或b)位置,最终都会映射到相同的位置。

rotation invariance: 下图表示汉字“一”的识别,第一张相对于x轴有倾斜角,第二张是平行于x轴,两张图片相当于做了旋转,经过多次max pooling后具有相同的特征 ————————————————

版权声明:本文为博主原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接和本声明。

原文链接:https://blog.csdn.net/weixin_38145317/article/details/89310404

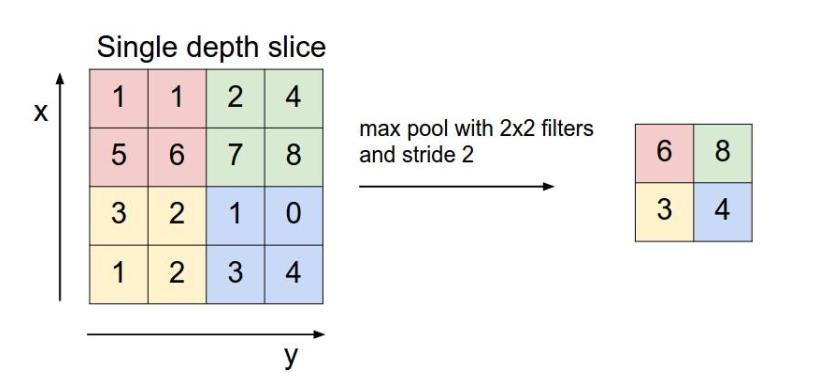

池化层用的方法有Max pooling 和 average pooling

Max pooling:

对于每个22的窗口选出最大的数作为输出矩阵的相应元素的值,比如输入矩阵第一个22窗口中最大的数是6,那么输出矩阵的第一个元素就是6,如此类推。

逻辑回归

1. 什么是逻辑回归

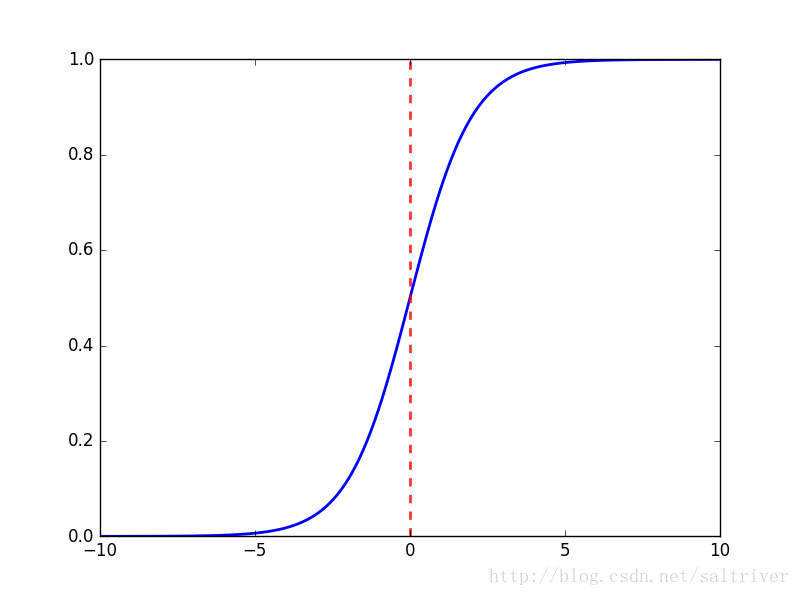

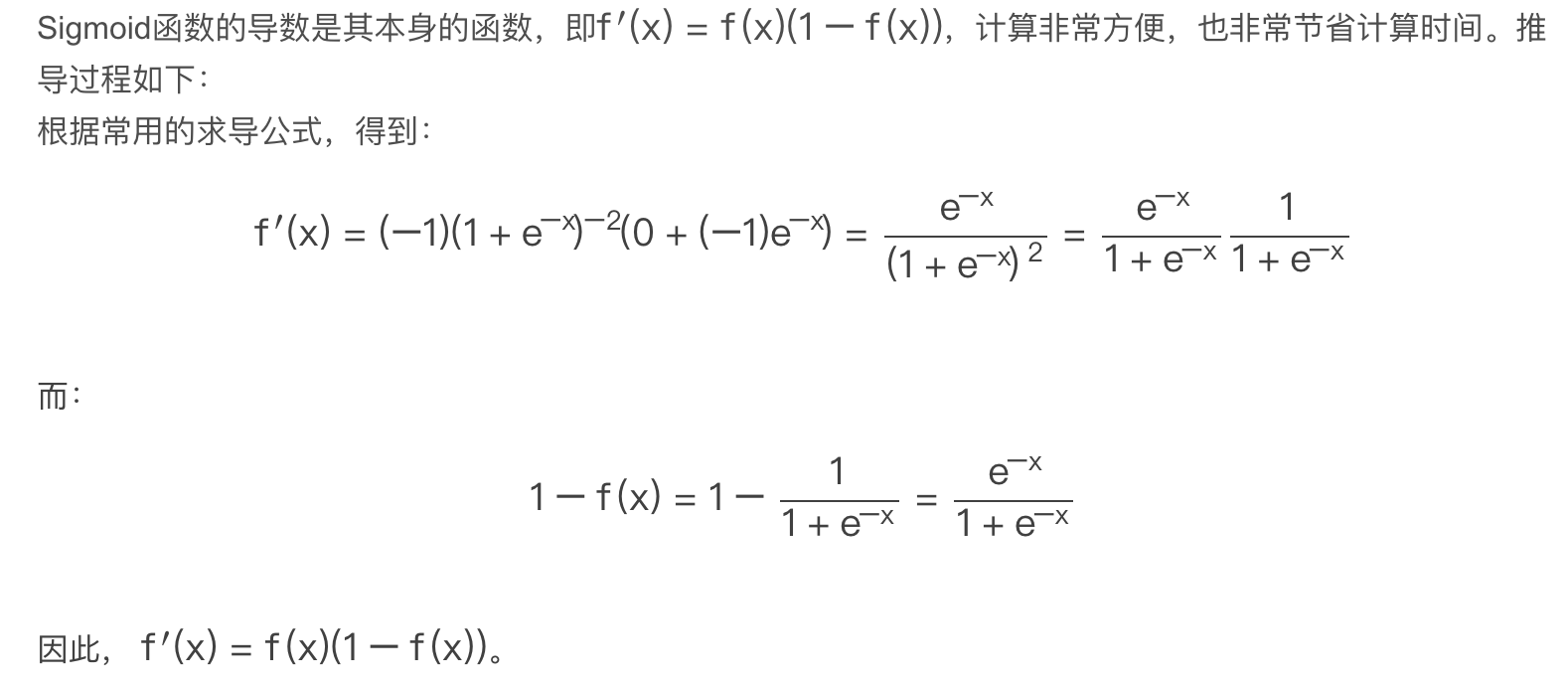

逻辑回归是用来做分类算法的,大家都熟悉线性回归,一般形式是Y=aX+b,y的取值范围是[-∞, +∞],有这么多取值,怎么进行分类呢?不用担心,伟大的数学家已经为我们找到了一个方法。

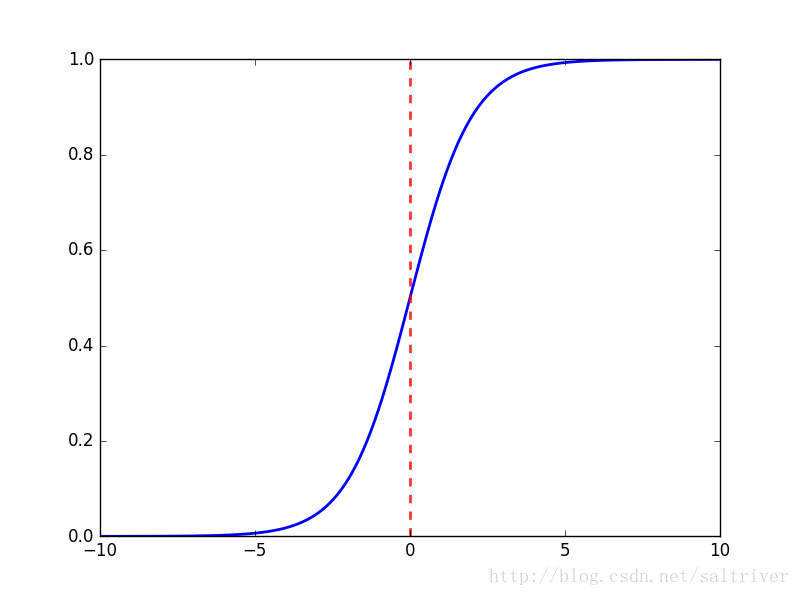

也就是把Y的结果带入一个非线性变换的Sigmoid函数中,即可得到[0,1]之间取值范围的数S,S可以把它看成是一个概率值,如果我们设置概率阈值为0.5,那么S大于0.5可以看成是正样本,小于0.5看成是负样本,就可以进行分类了。

2. 什么是Sigmoid函数

函数公式如下:

函数中t无论取什么值,其结果都在[0,-1]的区间内,回想一下,一个分类问题就有两种答案,一种是“是”,一种是“否”,那0对应着“否”,1对应着“是”,那又有人问了,你这不是[0,1]的区间吗,怎么会只有0和1呢?这个问题问得好,我们假设分类的阈值是0.5,那么超过0.5的归为1分类,低于0.5的归为0分类,阈值是可以自己设定的。

好了,接下来我们把aX+b带入t中就得到了我们的逻辑回归的一般模型方程:

结果P也可以理解为概率,换句话说概率大于0.5的属于1分类,概率小于0.5的属于0分类,这就达到了分类的目的。

3. 损失函数是什么

逻辑回归的损失函数是 log loss ,也就是 对数似然函数 ,函数公式如下:

公式中的 y=1 表示的是真实值为1时用第一个公式,真实 y=0 用第二个公式计算损失。为什么要加上log函数呢?可以试想一下,当真实样本为1是,但h=0概率,那么log0=∞,这就对模型最大的惩罚力度;当h=1时,那么log1=0,相当于没有惩罚,也就是没有损失,达到最优结果。所以数学家就想出了用log函数来表示损失函数。

最后按照梯度下降法一样,求解极小值点,得到想要的模型效果。

4.可以进行多分类吗?

可以的,其实我们可以从二分类问题过度到多分类问题(one vs rest),思路步骤如下:

1.将类型class1看作正样本,其他类型全部看作负样本,然后我们就可以得到样本标记类型为该类型的概率p1。

2.然后再将另外类型class2看作正样本,其他类型全部看作负样本,同理得到p2。

3.以此循环,我们可以得到该待预测样本的标记类型分别为类型class i时的概率pi,最后我们取pi中最大的那个概率对应的样本标记类型作为我们的待预测样本类型。

总之还是以二分类来依次划分,并求出最大概率结果.

5.逻辑回归有什么优点

- LR能以概率的形式输出结果,而非只是0,1判定。

- LR的可解释性强,可控度高(你要给老板讲的嘛…)。

- 训练快,feature engineering之后效果赞。

- 因为结果是概率,可以做ranking model。

6. 逻辑回归有哪些应用

- CTR预估/推荐系统的learning to rank/各种分类场景。

- 某搜索引擎厂的广告CTR预估基线版是LR。

- 某电商搜索排序/广告CTR预估基线版是LR。

- 某电商的购物搭配推荐用了大量LR。

- 某现在一天广告赚1000w+的新闻app排序基线是LR。

7. 逻辑回归常用的优化方法有哪些

7.1 一阶方法

梯度下降、随机梯度下降、mini 随机梯度下降降法。随机梯度下降不但速度上比原始梯度下降要快,局部最优化问题时可以一定程度上抑制局部最优解的发生。

7.2 二阶方法:牛顿法、拟牛顿法:

这里详细说一下牛顿法的基本原理和牛顿法的应用方式。牛顿法其实就是通过切线与x轴的交点不断更新切线的位置,直到达到曲线与x轴的交点得到方程解。

在实际应用中我们因为常常要求解凸优化问题,也就是要求解函数一阶导数为0的位置,而牛顿法恰好可以给这种问题提供解决方法。实际应用中牛顿法首先选择一个点作为起始点,并进行一次二阶泰勒展开得到导数为0的点进行一个更新,直到达到要求,这时牛顿法也就成了二阶求解问题,比一阶方法更快。我们常常看到的x通常为一个多维向量,这也就引出了Hessian矩阵的概念(就是x的二阶导数矩阵)。

缺点:牛顿法是定长迭代,没有步长因子,所以不能保证函数值稳定的下降,严重时甚至会失败。还有就是牛顿法要求函数一定是二阶可导的。而且计算Hessian矩阵的逆复杂度很大。

拟牛顿法: 不用二阶偏导而是构造出Hessian矩阵的近似正定对称矩阵的方法称为拟牛顿法。拟牛顿法的思路就是用一个特别的表达形式来模拟Hessian矩阵或者是他的逆使得表达式满足拟牛顿条件。主要有DFP法(逼近Hession的逆)、BFGS(直接逼近Hession矩阵)、 L-BFGS(可以减少BFGS所需的存储空间)。

8. 逻辑斯特回归为什么要对特征进行离散化。

- 非线性!非线性!非线性!逻辑回归属于广义线性模型,表达能力受限;单变量离散化为N个后,每个变量有单独的权重,相当于为模型引入了非线性,能够提升模型表达能力,加大拟合; 离散特征的增加和减少都很容易,易于模型的快速迭代;

- 速度快!速度快!速度快!稀疏向量内积乘法运算速度快,计算结果方便存储,容易扩展;

- 鲁棒性!鲁棒性!鲁棒性!离散化后的特征对异常数据有很强的鲁棒性:比如一个特征是年龄>30是1,否则0。如果特征没有离散化,一个异常数据“年龄300岁”会给模型造成很大的干扰;

- 方便交叉与特征组合:离散化后可以进行特征交叉,由M+N个变量变为M*N个变量,进一步引入非线性,提升表达能力;

- 稳定性:特征离散化后,模型会更稳定,比如如果对用户年龄离散化,20-30作为一个区间,不会因为一个用户年龄长了一岁就变成一个完全不同的人。当然处于区间相邻处的样本会刚好相反,所以怎么划分区间是门学问;

- 简化模型:特征离散化以后,起到了简化了逻辑回归模型的作用,降低了模型过拟合的风险。

9. 逻辑回归的目标函数中增大L1正则化会是什么结果。

所有的参数w都会变成0。

10. 代码实现

.

把数据切分成训练集和测试集

1 | from sklearn import model_selection |

使用logistic regression/决策树/SVM/KNN...等sklearn分类算法进行分类,尝试查sklearn API了解模型参数含义,调整不同的参数。

1 | from sklearn.linear_model import LogisticRegression |

1 | 0.9323730412572769 |

.

在测试集上进行预测,计算准确度

1 | from sklearn.metrics import accuracy_score |

1 | 训练集准确率: 0.9323730412572769 |

.

查看sklearn的官方说明,了解分类问题的评估标准,并对此例进行评估。

例如,如果这是一个将水果分为苹果、香蕉、橙子的多分类问题。召回率衡量的是对于每个类别,模型正确预测为该类别的样本数量占实际该类别样本数量的比例。通过计算训练集和测试集的召回率,可以评估模型在不同数据集上对各类别样本的预测能力,从而判断模型是否过拟合或欠拟合,以及模型在新数据上的泛化能力。

1 | ##召回率 |

1 | 训练集召回率: 0.4999938302834368 |

.

银行通常会有更严格的要求,因为fraud带来的后果通常比较严重,一般我们会调整模型的标准。 比如在logistic regression当中,一般我们的概率判定边界为0.5,但是我们可以把阈值设定低一些,来提高模型的“敏感度”,试试看把阈值设定为0.3,再看看这时的评估指标(主要是准确率和召回率)。

tips:sklearn的很多分类模型,predict_prob可以拿到预估的概率,可以根据它和设定的阈值大小去判断最终结果(分类类别)

1 | import numpy as np |

1 | 0.9333179935572941 |

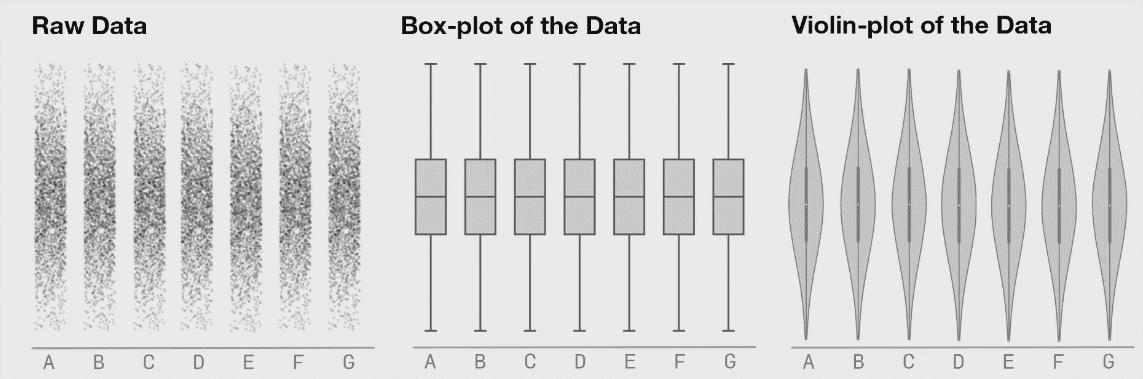

各种图示

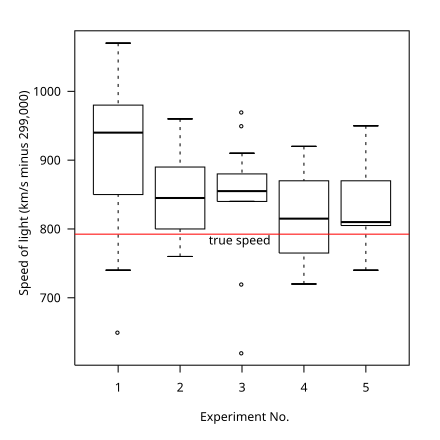

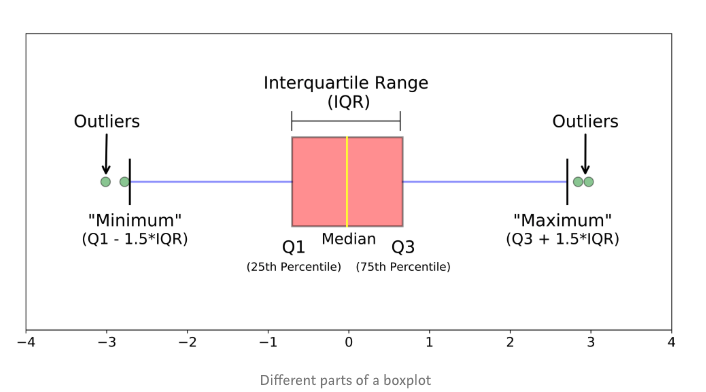

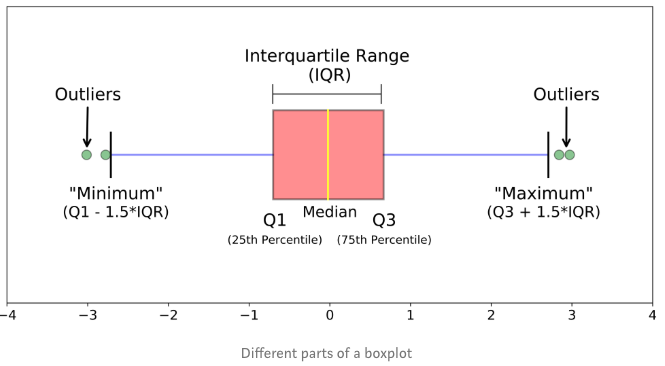

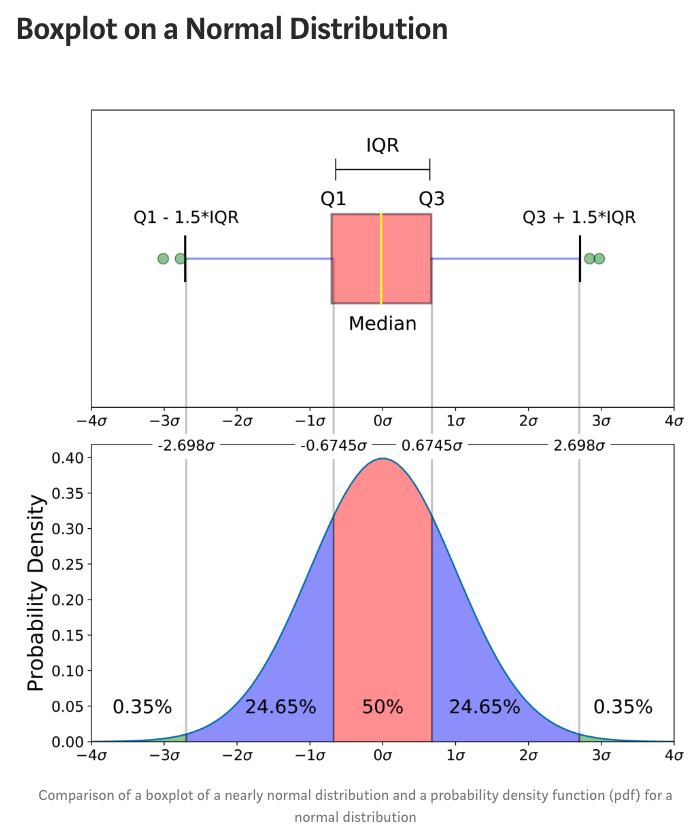

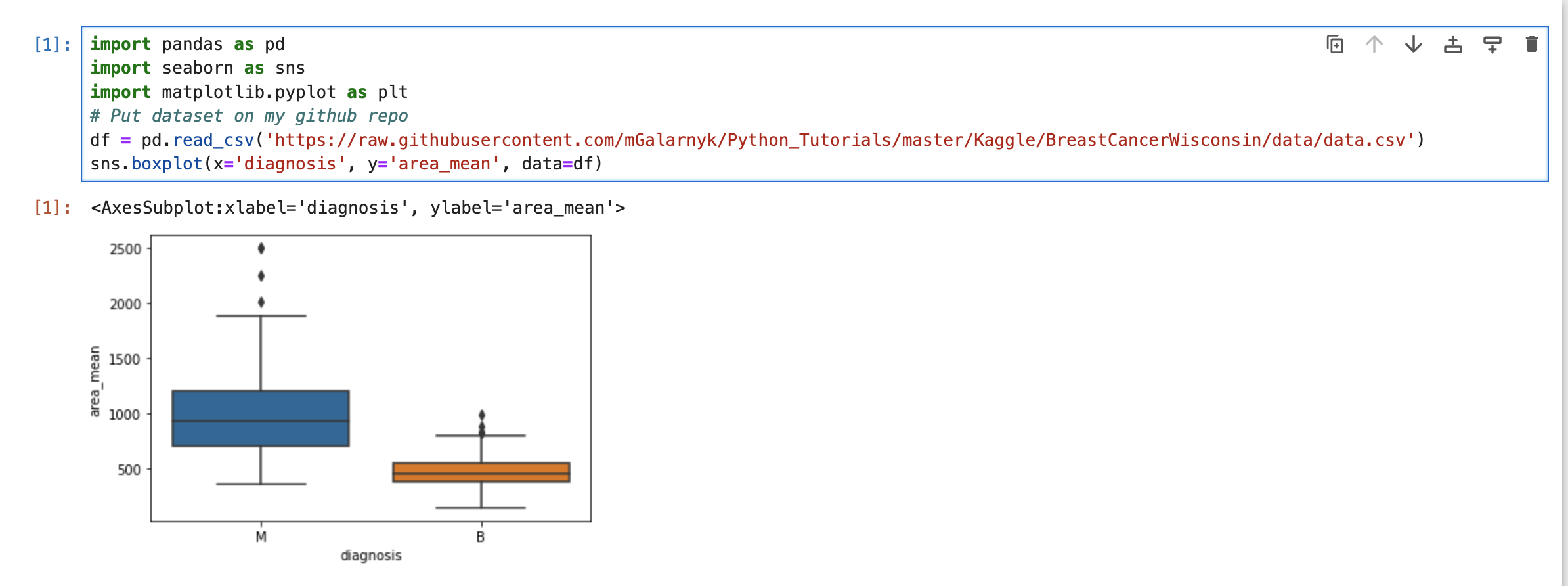

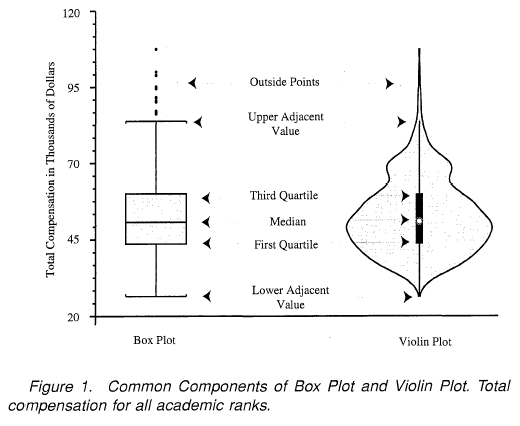

箱线图/箱型图/箱形图

如上图箱线图,箱线图是一个能够通过5个数字来描述数据的分布的标准方式,这5个数字包括:最小值,第一分位,中位数,第三分位数,最大值,箱线图能够明确的展示离群点的信息,同时能够让我们了解数据是否对称,数据如何分组、数据的峰度;

1. 什么是箱线图?

对于某些分布/数据集,您会发现除了集中趋势(中位数,均值和众数)的度量之外,您还需要更多信息。

您需要有关数据变异性或分散性的信息。 箱形图是一张图表,它为您很好地指示数据中的值如何分布,尽管与直方图或密度图相比,箱线图似乎是原始的,但它们具有占用较少空间的优势,这在比较许多组或数据集之间的分布时非常有用。

箱线图是一种基于五位数摘要(“最小”,第一四分位数(Q1),中位数,第三四分位数(Q3)和“最大”)显示数据分布的标准化方法。

- 中位数(Q2 / 50th百分位数):数据集的中间值;

- 第一个四分位数(Q1 / 25百分位数):最小数(不是“最小值”)和数据集的中位数之间的中间数;

- 第三四分位数(Q3 / 75th Percentile):数据集的中位数和最大值之间的中间值(不是“最大值”);

- 四分位间距(IQR):第25至第75个百分点的距离;

- 晶须(蓝色显示)

- 离群值(显示为绿色圆圈)

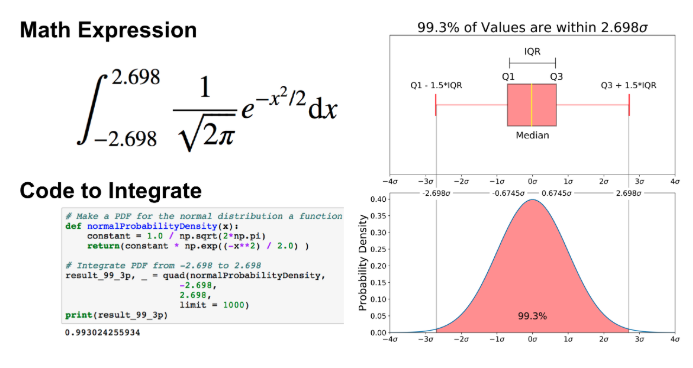

- “最大”:Q3 + 1.5 * IQR

- “最低”:Q1 -1.5 * IQR

离群值,“最小”或“最大”的内容可能尚不清楚。下一节将尽力为您解决问题;

上图是近似正态分布的箱线图与正态分布的概率密度函数(pdf)的比较,我向您显示此图像的原因是,查看统计分布比查看箱形图更为普遍。换句话说,它可以帮助您理解箱线图;

本节将涵盖许多内容,包括:

- 对于正态分布而言,0.7%的数据异常值;

- 什么是“最小”和“最大”

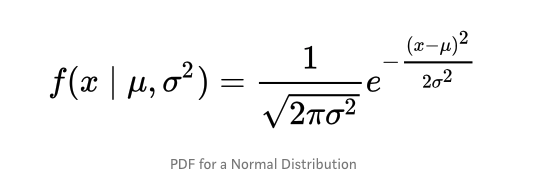

概率密度函数

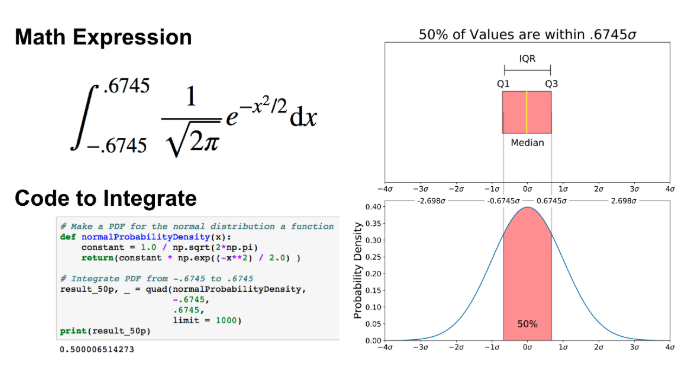

帖子的这一部分与68–95–99.7规则文章非常相似,但适用于箱线图,为了了解百分比的来源,重要的是要了解概率密度函数(PDF),PDF用于指定随机变量落入特定值范围内的概率,而不是任何一个具体值,该概率由该变量在该范围内的PDF的积分得出,也就是说,它是由密度函数下方但水平轴上方以及范围的最小值和最大值之间的面积给出的,这个定义可能没有多大意义,因此让我们通过绘制正态分布的概率密度函数来理解它,下式是正态分布的概率密度函数:

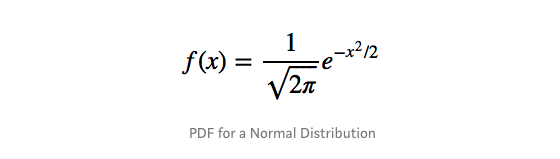

让我们简化一下,假设我们的平均值(μ)为0,标准偏差(σ)为1:

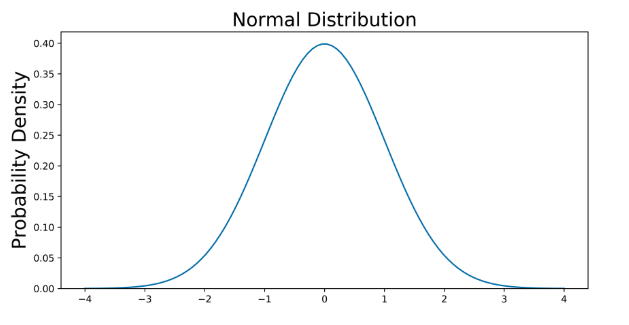

可以使用任何图形进行绘制,但是我选择使用Python进行图形绘制

1 | # Import all libraries for this portion of the blog post |

上图没有显示事件的概率,而是事件的概率密度,为了获得事件在给定范围内的概率,我们需要进行积分,假设我们感兴趣的是寻找随机数据点落在四分位数范围内的概率。平均值的.6745标准偏差,我们需要将-0.6745集成到0.6745。这可以用SciPy完成.

1 | # Make PDF for the normal distribution a function |

可以对“最小”和“最大”执行相同的操作

1 | # Make a PDF for the normal distribution a function |

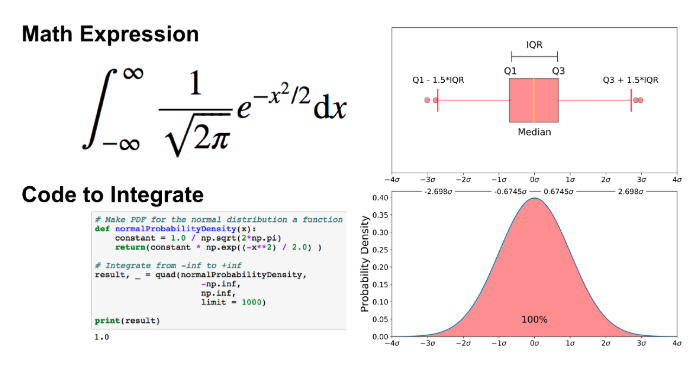

如前所述,离群值是数据的剩余0.7%. 请务必注意,对于任何PDF,曲线下的面积必须为1(从函数范围内绘制任何数字的概率始终为1)

本部分主要基于我的Python for Data Visualization课程的免费预览视频。在上一节中,我们介绍了正态分布的箱线图,但是由于您显然并不总是具有基本的正态分布,因此让我们研究一下如何在真实数据集上利用箱形图。为此,我们将利用乳腺癌威斯康星州(诊断)数据集.

读取数据

1 | import pandas as pd |

箱线图

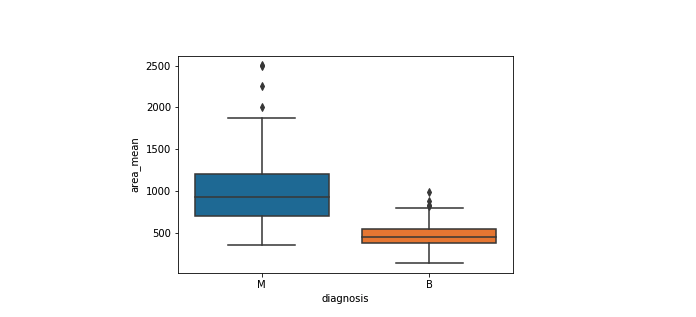

下面使用箱线图来分析分类特征(恶性或良性肿瘤)和连续特征(area_mean)之间的关系。

seaborn

1 | sns.boxplot(x='diagnosis', y='area_mean', data=df) |

使用该图,我们可以比较Area_mean的范围和分布,以进行恶性和良性诊断。我们观察到,恶性肿瘤的Area_mean以及较大的异常值存在较大的变异性。 另外,由于箱线图中的凹口不重叠,因此可以得出结论,在95%的置信度下,真实中位数确实有所不同.

关于箱线图,还有一些其他注意事项:

- 请记住,如果您想知道箱线图不同部分的数值是什么,可以随时从箱线图中提取数据。

- Matplotlib不会首先估计正态分布,而是根据估计的分布参数计算四分位数,中位数和四分位数直接从数据中计算得出。换句话说,您的箱形图看起来可能会有所不同,具体取决于数据的分布和样本的大小,例如,不对称且具有或多或少的异常值

1.3箱型图的缺点 1.箱型图虽然能显示出数据的分布偏态,但是不能提供关于数据分布偏态和尾重程度的精确度量;

2.对于批量较大的数据批,箱线图反映的形状信息更加模糊;

3.用中位数代表总体平均水平有一定的局限性。

所以,应用箱线图最好结合其它描述统计工具如均值、标准差、偏度、分布函数等来描述数据批的分布形状。

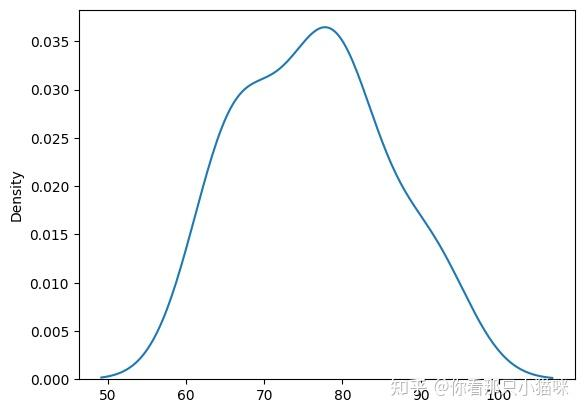

核密度图

why-为什么需要做核密度图?

- 核密度图(kernel density plot)是一种很重要的数据可视化图形

- 它可以直观展示出数据分布的形状,以及可以帮助识别异常值

- 相较于柱状图(histogram),它所展示的数据分布并不受bins影响

- 它是根据有限的样本数据对总体数据概率密度的估计

总而言之,它可以展示出数据的整体分布,且比柱状图更具有优势

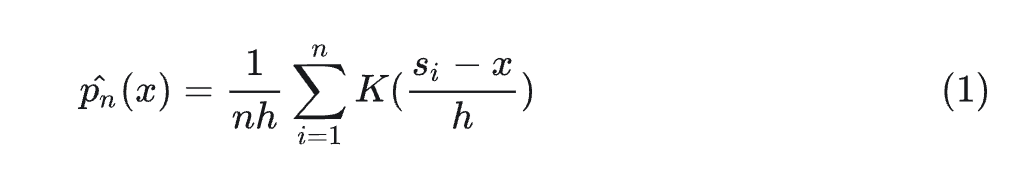

what-核密度图是什么?

核密度图本质上是根据有限的数据样本,运用核密度函数,对整体数据的密度进行估计;即已知有限的数据样本和一个核函数,输出整体数据的概率密度,并通过图形展示出结果

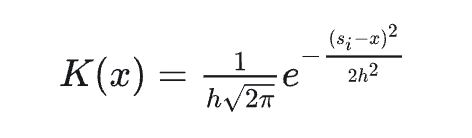

其中

x是属于整体数据中的任一变量

n是样本数据中数据点的个数

h是平滑带宽,控制平滑量,h值越大,数据越平滑;且h>0

K是核密度函数

si是样本数据中的一个数据点

核密度函数必须满足以下三个属性:

- 核密度函数必须是对称的

- 核密度函数曲线下的面积必须为1

- 核函数值要大于等于0

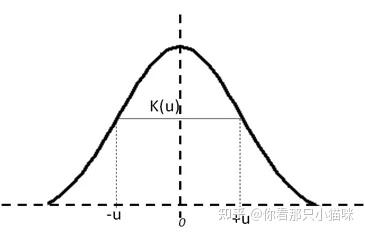

目前常用的核函数为

高斯(Gaussian)分布概率密度函数

- 均匀(Uniform)分布概率密度函数

- Epanechnikov密度函数

- ...

How-怎么做核密度图?

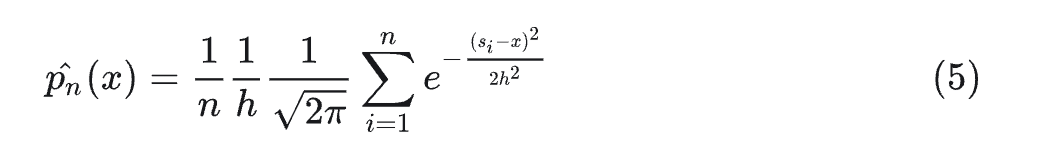

以高斯核为例,我们将公式4带入到公式1中,可以得到高斯核密度函数为

也可以写成

其中

我们从公式6就可以看出,我们是对多个概率密度求了平均

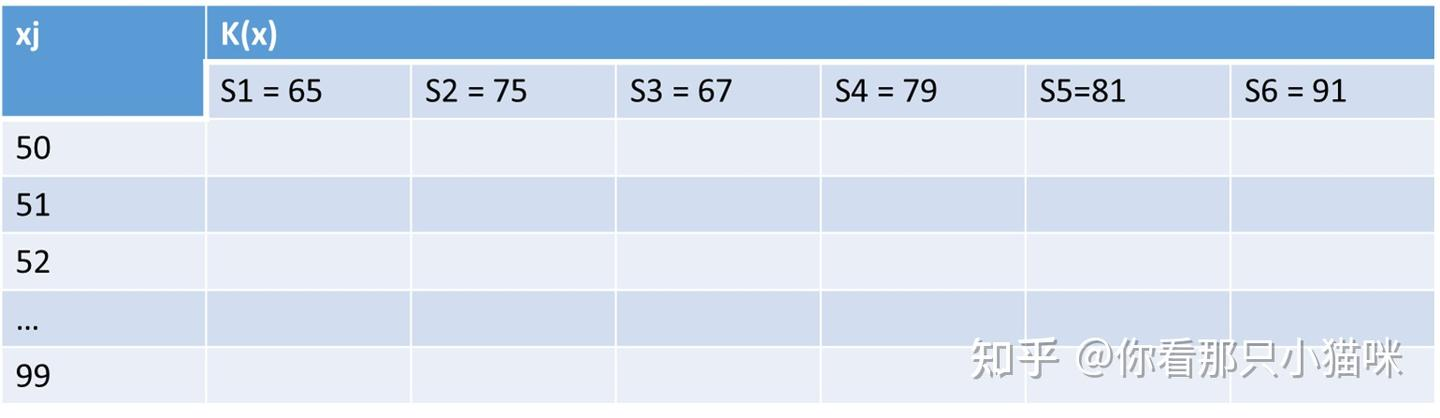

接下来我们以一组数据为例,展示其在高斯核密度函数计算过程

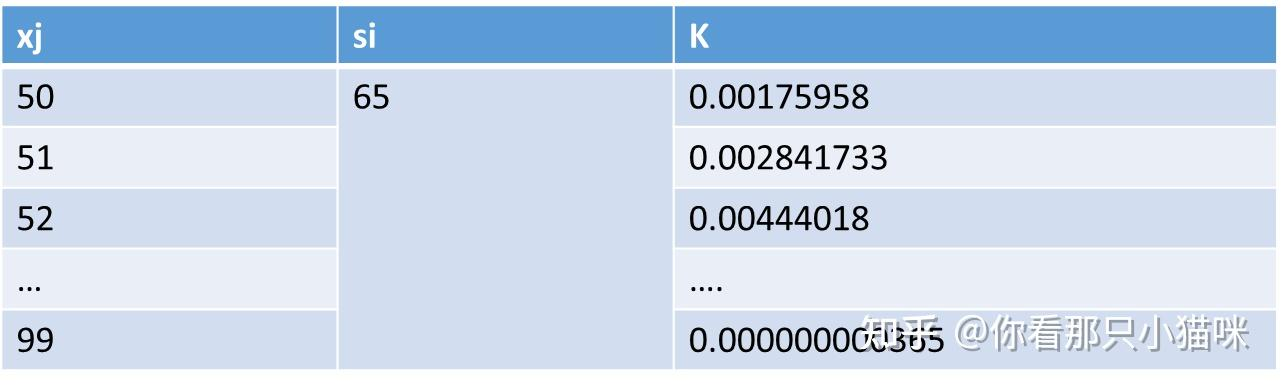

我们在计算之前已知的数据如下:

- 一组样本数据S = {65,75,67,79,81,91}, 即s1= 65, s2=75.....

- 预先设置好h值,比如h = 5.5

- 一组线性间隔的数据点且该数据点包含S内的数据,记为X = 50,51,52...99

对于一个样本点si, 我们计算公式6中的K(x),x在X中取值

按照上述方法,我们依次计算S内的其他样本点,最终,每一个样本点都有一个这样的表格,汇总起来就是下表,假设里面是有数值的

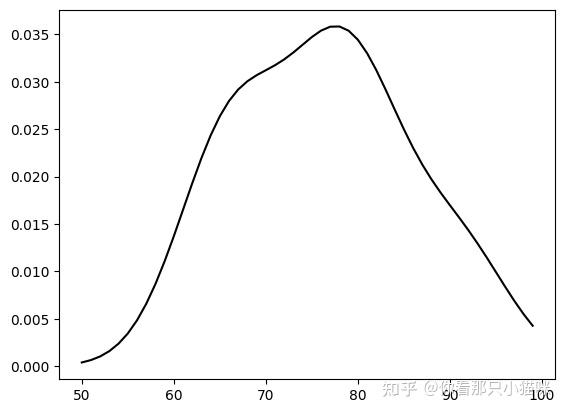

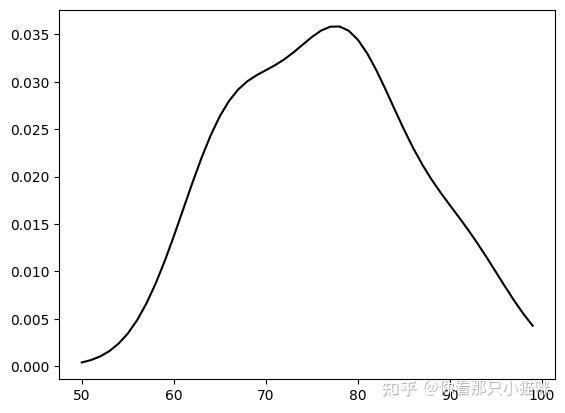

如果我们画出图形就是下图

对于某一点xj来说,其概率密度为上述6个样本点在xj处所计算出的概率密度值的平均

下面是代码实现过程

1 |

|

1 | ## 实现版本2, 根据seaborn内的函数kdeplot |

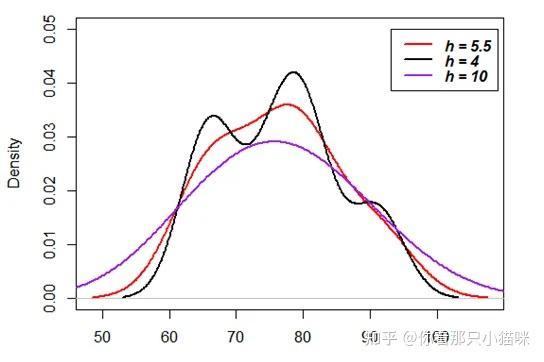

注意: bw_method 是设置h值,这里当设置为5.5时,与版本1的结果不同,这是因为sns.kdeplot还进行了一些矫正

需要注意

- h是很重要的参数,h值越大,平滑程度越高;具体见下图

该密度估计方法是一种有偏估计

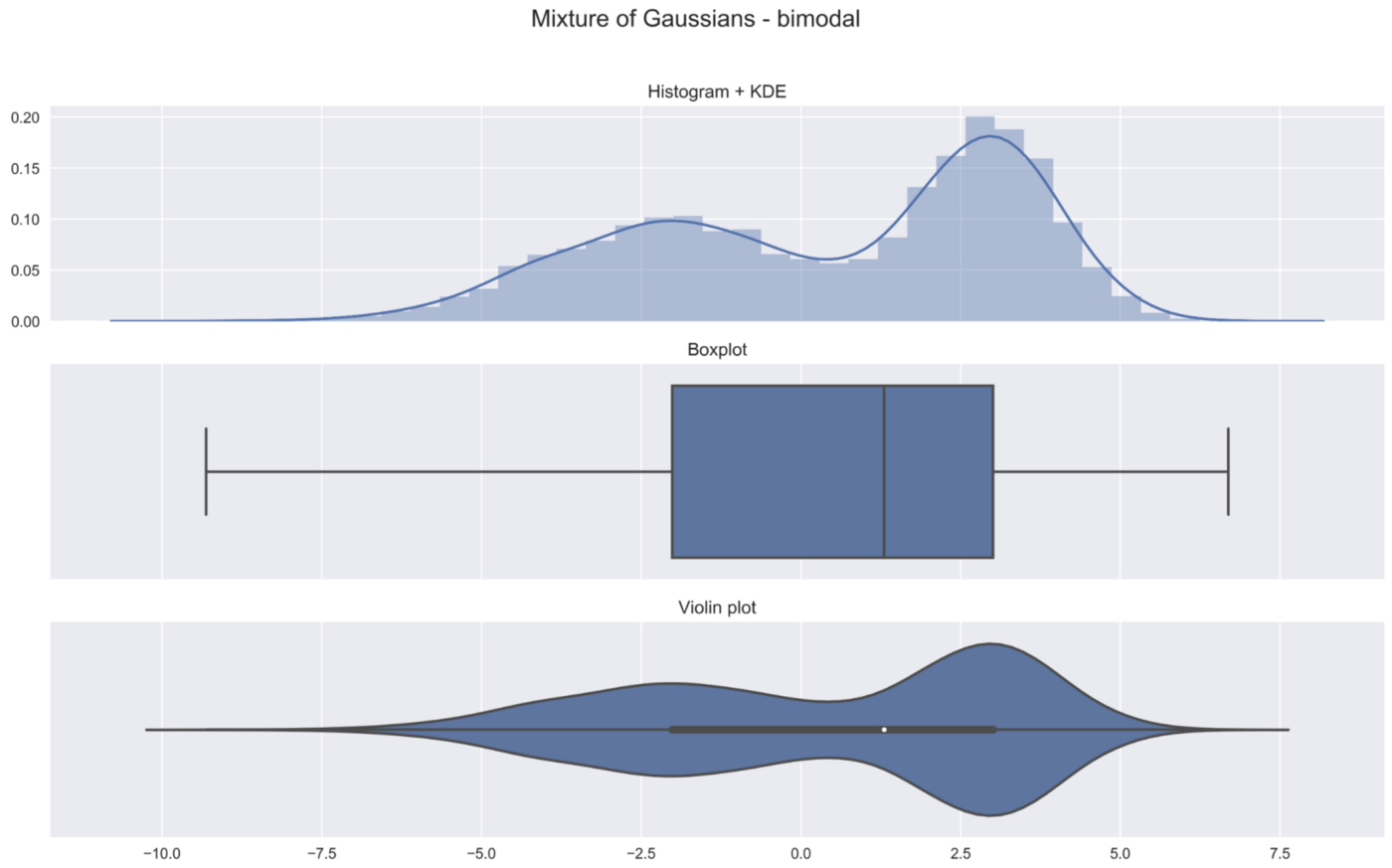

小提琴图

般来说,小提琴图是一种绘制连续型数据的方法,可以认为是箱形图与核密度图的结合体。当然了,在小提琴图中,我们可以获取与箱形图中相同的信息。

- 中位数(小提琴图上的一个白点)

- 四分位数范围(小提琴中心的黑色条)。

- 较低/较高的相邻值(黑色条形图)--分别定义为第一四分位数-1.5 IQR和第三四分位数+1.5 IQR。这些值可用于简单的离群值检测技术,即位于这些 "栅栏"之外的值可被视为离群值。

与箱形图相比,小提琴图毫无疑问的优势在于:除了显示上述的统计数据外,它还显示了数据的整体分布。这个差异点很有意义,特别是在处理多模态数据时,即有多峰值的分布。

用Python实现 在这篇文章中,我们使用了以下库:

- seaborn

- numpy

- pandas

- matplotlib

我们首先定义了我们随机观测值的数量,以及为结果的设置的随机种子。

1 | N = 10 ** 4 |

然后,我们定义一个函数来绘制以下内容。

- 带有内核密度估计的直方图(KDE)。

- 波谱图

- 一个小提琴图 我们将使用这个函数来描述随机创建的样本特性。

1 | def plot_comparison(x, title): |

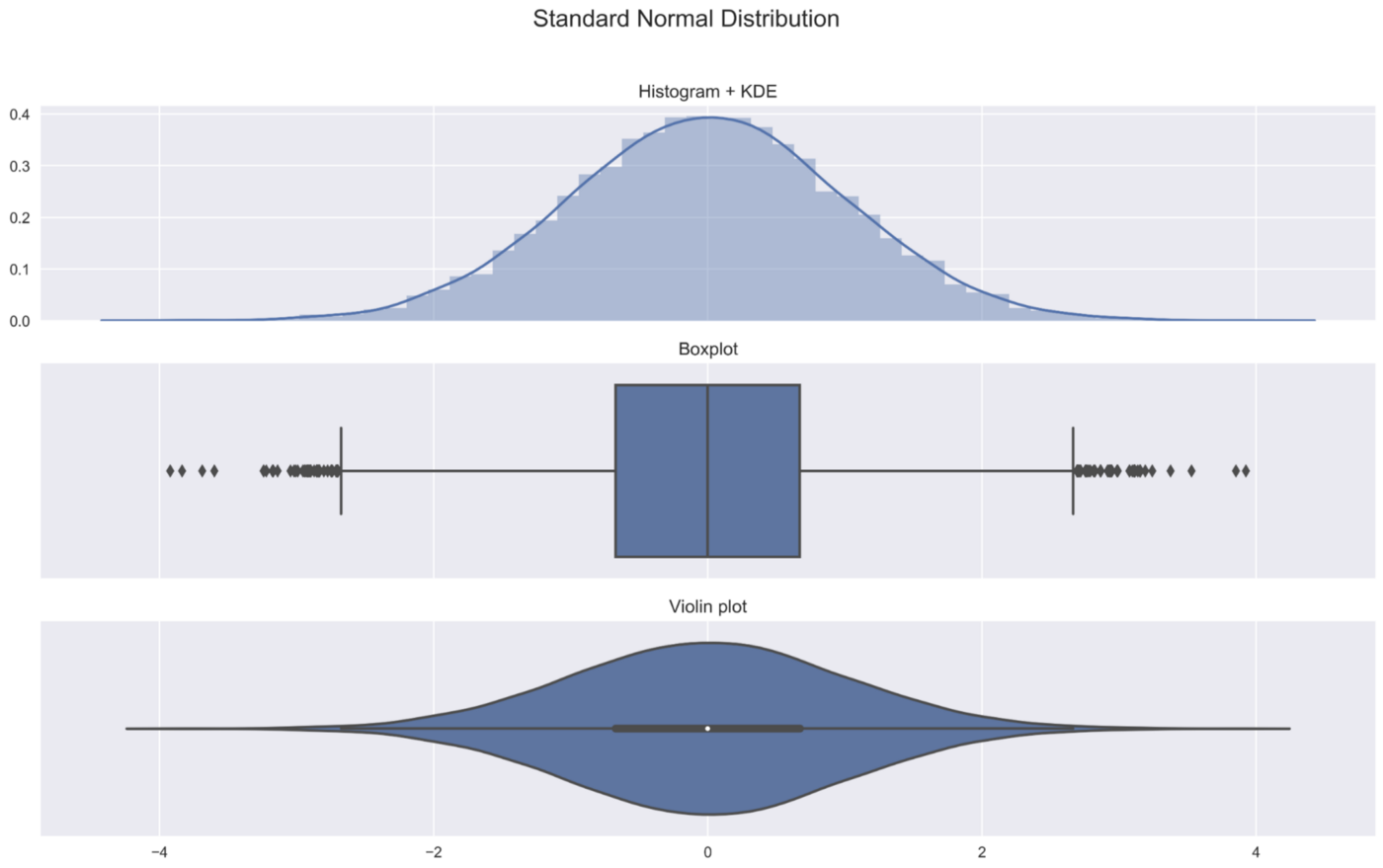

1. 标准正态分布

我们从最基本的分布开始--标准正态分布。我们随机抽取10000个数字,并绘制结果。

正态分布参考:如何通俗的理解正态分布 - 知乎 (zhihu.com)

1 | sample_gaussian = np.random.normal(size=N) |

可以得到一些直观感受:

- 在直方图中,我们看到分布的对称形状

- 我们可以在箱形图和小提琴图中看到前面提到的指标(中位数、IQR)。

- 用于创建小提琴图的核密度图与添加在直方图上的核密度图是一样的。小提琴图中较宽的部分代表观测值取值的概率较高,较窄的部分则对应于较低的概率。 我相信,将这三张图放在一起展示,可以清晰的看到小提琴图什么样子以及它包含什么样的直觉信息。

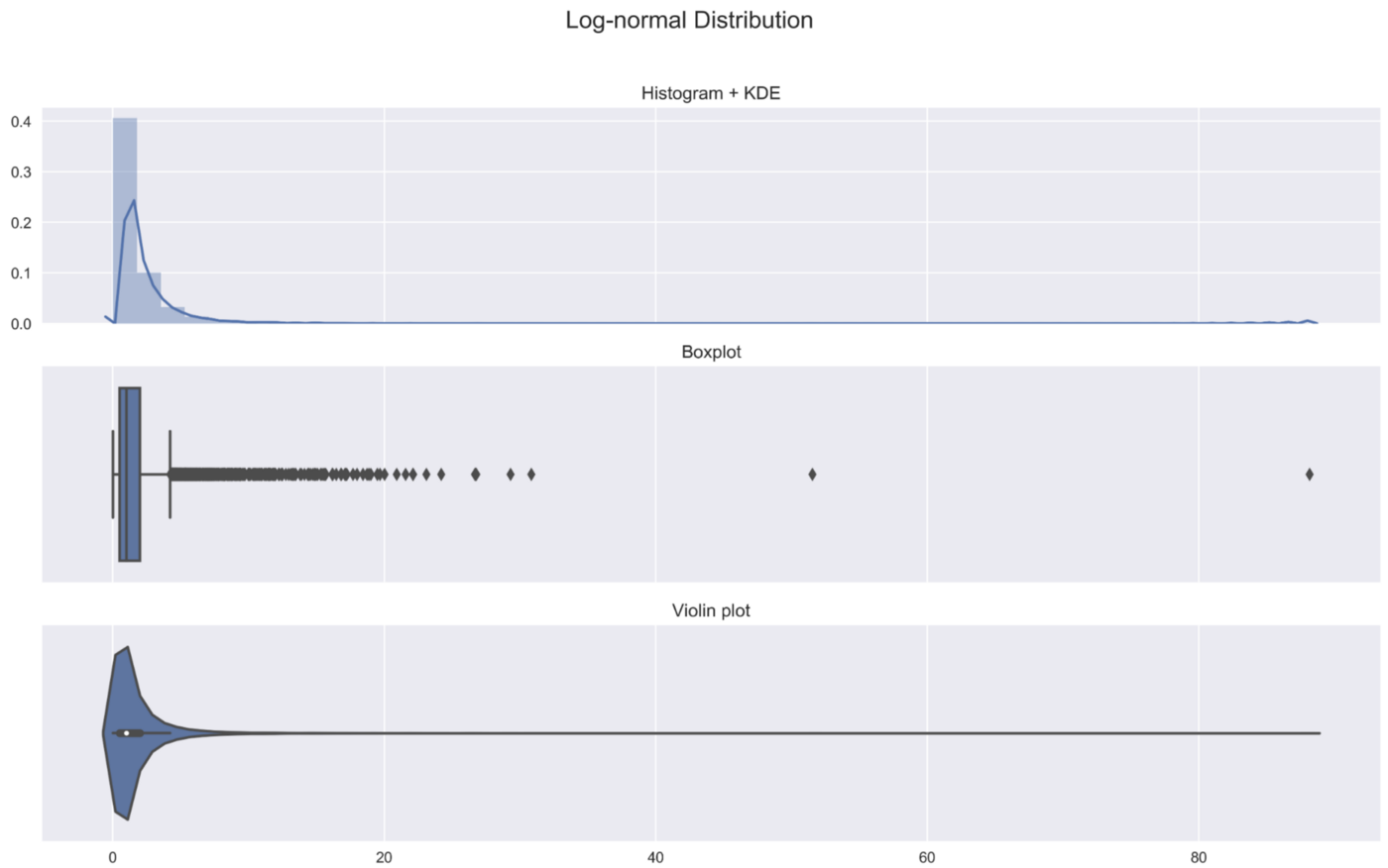

2. 对数正态分布

在第二个例子中,我们考虑对数正态分布,它肯定比正态分布更加偏斜。

1 | sample_lognormal = np.random.lognormal(size=N) |

3. 高斯的混合体--双峰型

在前面两个例子中,我们已经看到小提琴图比箱形图包含更多的信息。当我们考虑一个多模态分布时,这一点就更加明显了。在这个例子中,我们创建了一个双模分布,作为两个高斯分布的混合体。

高斯混合模型可以参考:如何通俗的理解高斯混合模型(Gaussian Mixture Models) - 知乎 (zhihu.com)

如果不看直方图/密度图,就不可能发现我们数据中的两个峰值。

4. 高级用法

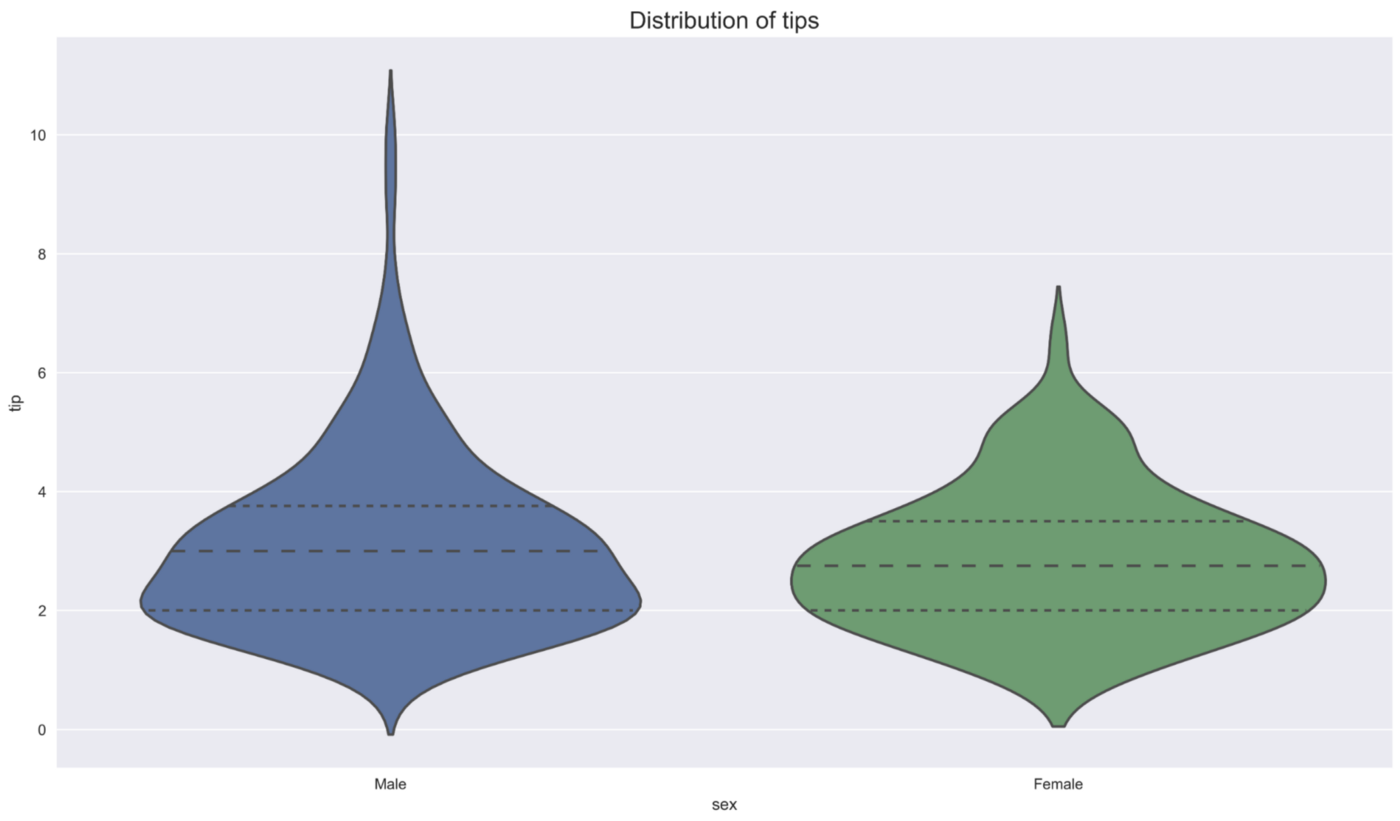

小提琴图经常被用来比较一个给定变量在某些类别中的分布。我们在下面介绍一些可能性。要做到这一点,我们从seaborn加载tips数据集。

1 | tips = sns.load_dataset("tips") |

在第一个例子中,我们可以看到每个性别的分布。此外,我们改变小提琴图的结构,只显示四分位数。其他一些包括显示所有观测值的点或在小提琴图内画一个小方框图。

1 | ax = sns.violinplot(x="sex", y="tip", inner='quartile', data=tips) |

我们看到,两种性别的tips的总体形状和分布是相似的(四分位数非常接近),但在男性中有更多的离群值。

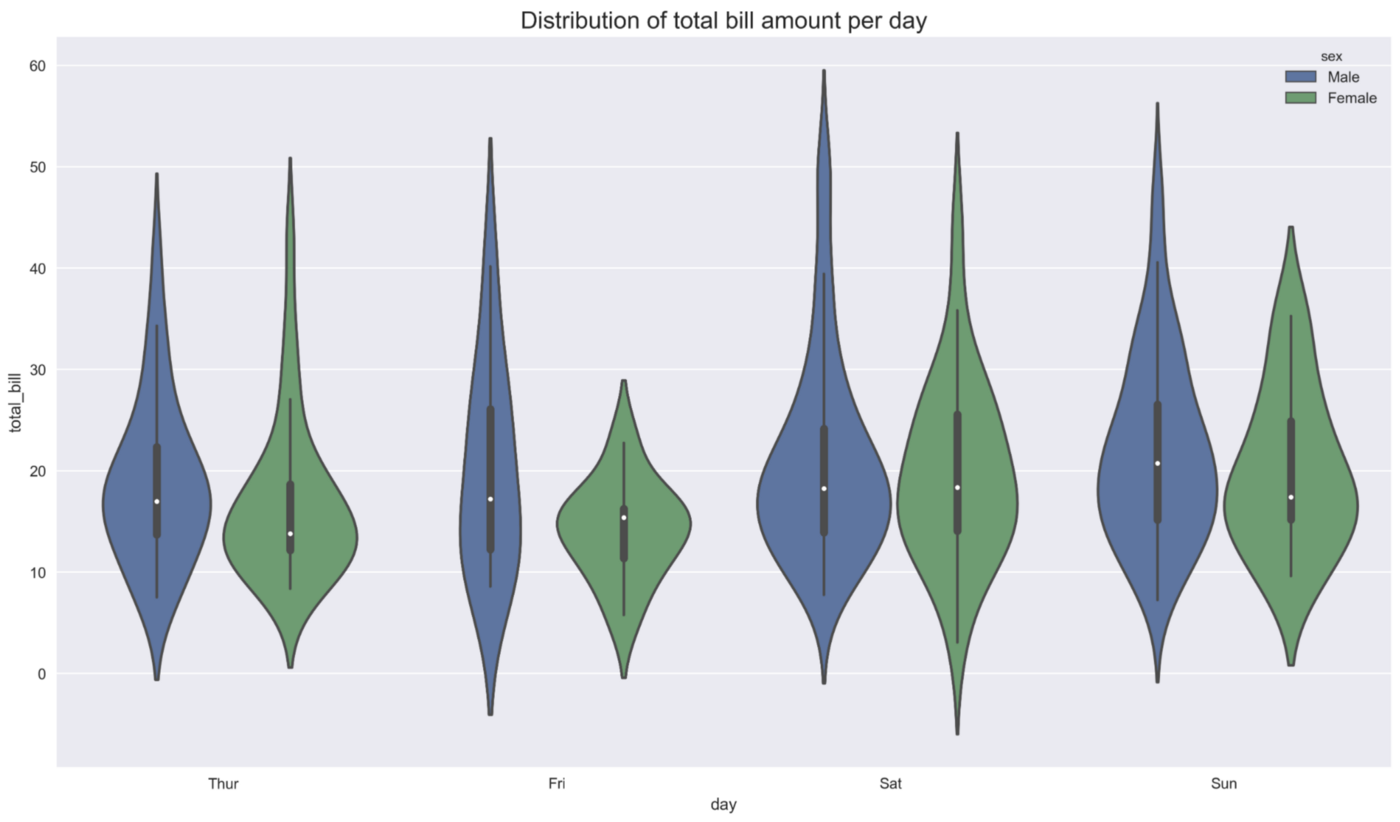

在第二个例子中,我们查看每天总账单金额的分布。此外,我们按性别划分。我们就立马能够看到,性别之间分布形状的最大差异发生在星期五。

1 | ax = sns.violinplot(x="day", y="total_bill", hue="sex", data=tips) |

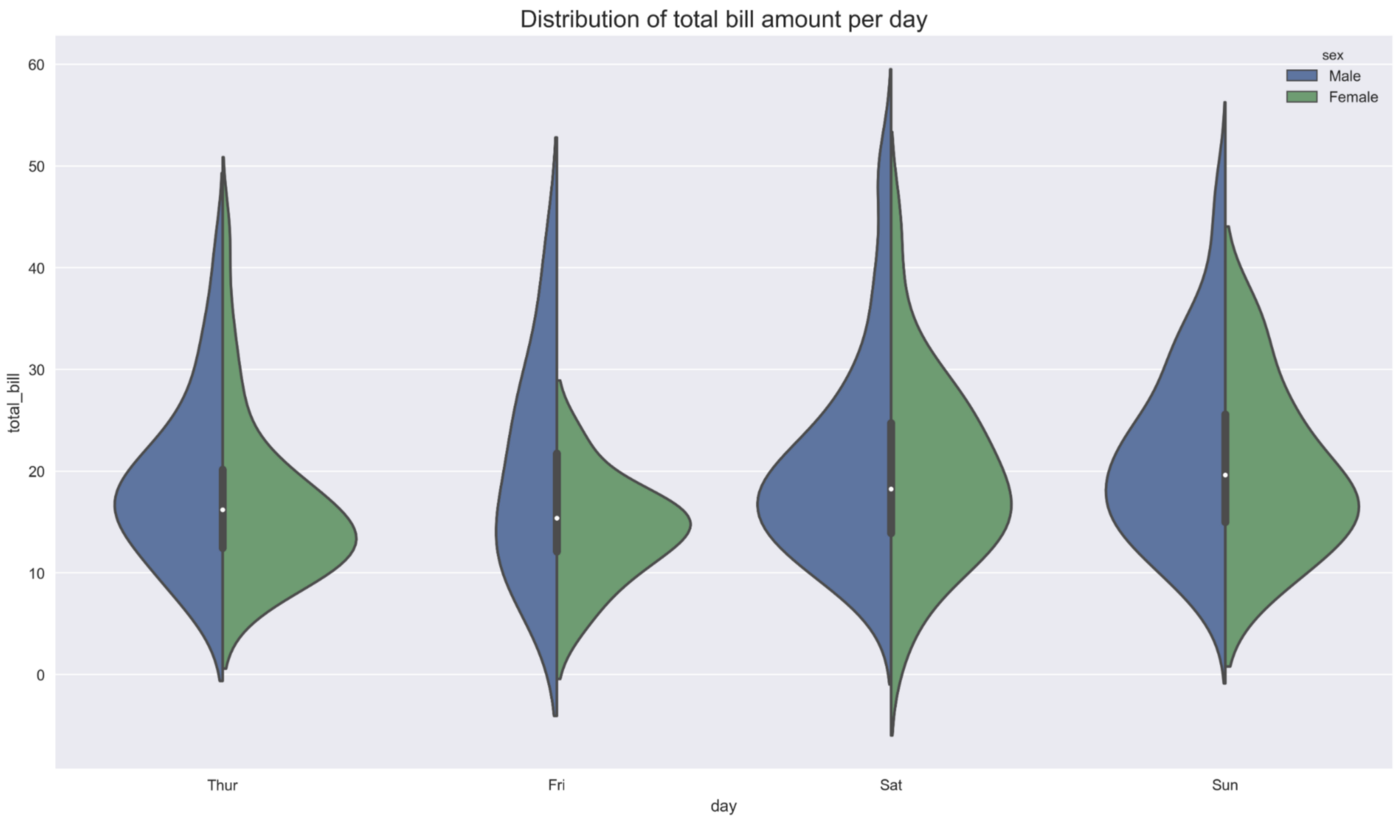

在最后一个例子中,我们调查的内容与前面的情况相同,但是,我们设置split=True。设置之后,我们最终得到的不是8把小提琴,而是4把--小提琴的每一侧都对应着不同的性别。

1 | ax = sns.violinplot(x="day", y="total_bill", hue="sex", split=True, data=tips) |

结论 在这篇文章中,我展示了什么是小提琴图,如何解释它们,以及它们比箱形图有什么优势。最后值得一提的是,如果数据的四分位数保持不变,箱形图就不会改变。那么,我们可以对数据进行修改,使四分位数不发生变化,但分布的形状会发生很大的变化。下面的GIF图说明了这一点。

t-SNE(t-distributed Stochastic Neighbor Embedding)

数学原理设计 t-分布和联合概率分布见 https://www.cnblogs.com/BlairGrowing/p/15400721.html

t-SNE(t-distributed Stochastic Neighbor Embedding)是一种用于降维和数据可视化的机器学习算法。

一、主要原理

t-SNE 的目标是将高维数据映射到低维空间(通常是二维或三维),同时尽可能保持数据点之间的相似性。

它通过将高维空间中的欧氏距离转换为概率分布,然后在低维空间中也构建一个概率分布,并最小化这两个概率分布之间的差异来实现。

具体来说,t-SNE 首先计算高维空间中数据点之间的相似性,通常使用高斯分布来计算两个点之间的相似度。然后,在低维空间中使用 t 分布来计算数据点之间的相似性。通过优化一个损失函数,使得低维空间中的相似性尽可能接近高维空间中的相似性。

二、应用场景

- 数据可视化:t-SNE 能够将高维数据可视化在二维或三维空间中,帮助人们直观地理解数据的分布和结构。例如,在图像分类任务中,可以将高维的图像特征映射到二维平面上,观察不同类别的图像在低维空间中的分布情况。

- 特征提取:t-SNE 可以作为一种特征提取方法,将高维数据映射到低维空间后,提取低维空间中的特征用于后续的分析和建模。

- 异常检测:通过观察数据在低维空间中的分布,可以发现异常点或离群点,这些点可能代表了数据中的异常情况或错误。

三、优势与局限性

优势:

- 能够有效地捕捉高维数据中的局部和全局结构,对于复杂的数据分布具有较好的可视化效果。

- 可以处理大规模数据集,通过随机采样和近似计算方法,减少计算时间和内存消耗。

局限性:

- 计算复杂度较高,尤其是对于大规模数据集,可能需要较长的计算时间。

- 结果具有一定的随机性,每次运行可能会得到不同的可视化结果。

- 在低维空间中的距离并不完全等同于高维空间中的距离,因此不能直接根据低维空间中的距离进行精确的度量和分析。

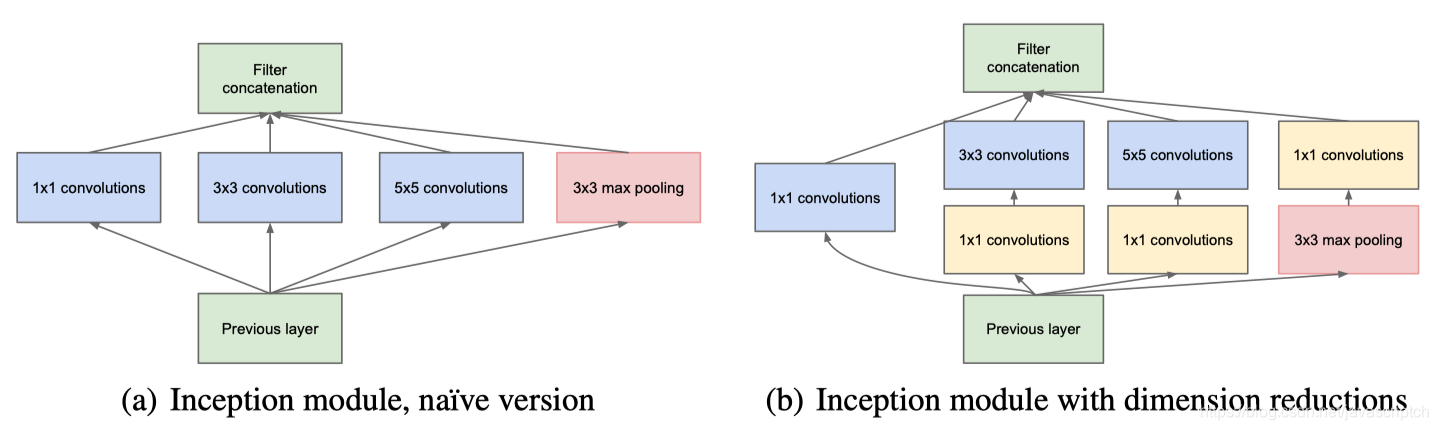

Inception思想

1. Inception-v1

1.1 为什么提出Inception

一般来说,提升网络性能最保险的方法就是增加网络的深度和宽度,但这样做同时也会伴随着副作用:

1、当越深越宽的网络往往会有着巨大的参数量,当数据量很少的时候,训练出来的网络容易过拟合

2、需要更多的计算资源

3、网络越深,梯度容易消失,优化困难(这时还没有提出BN时,网络的优化极其困难)

基于此,我们的目标就是,提高网络计算资源的利用率,在计算量不变的情况下,提高网络的宽度和深度。作者认为,解决这种困难的方法就是,把全连接改成稀疏连接,卷积层也是稀疏连接,但是不对称的稀疏数据数值计算效率低下,因为硬件全是针对密集矩阵优化的,所以,我们要找到卷积网络可以近似的最优局部稀疏结构,并且该结构下可以用现有的密度矩阵计算硬件实现,产生的结果就是Inception。

1.2 网络结构

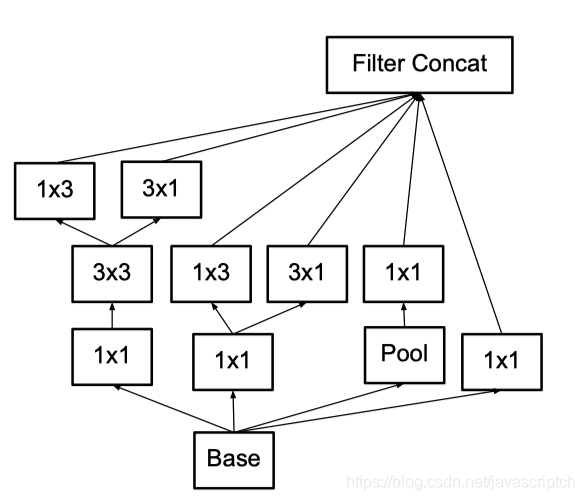

Inception Module基本组成结构有四个成分。1x1卷积核,3x3卷积核,5x5卷积核,3x3最大池化。最后对四个成分运算结果进行通道上组合。

Inception结构如下图:

1.3 作用

Inception的核心思想:通过多个卷积核提取图像不同尺度的信息,最后进行融合,可以得到图像更好的表征

具体来说,假设我们要提取狗的脸部特征,不同图片中狗脸占比显然是不一样的,那么我们就需要使用不同大小的卷积核提取不同的信息。信息分布比较全局性的图像采用大卷积核,信息分布比较局部性的图像采用小卷积核。

作者提出的Inception的优点:

1、显著增加了每一步的单元数目,计算复杂度不会不受限制,尺度较大的特征在卷积之前先降维

2、视觉信息在不同尺度上进行处理融合,这样下一步可以从不同尺度提取特征

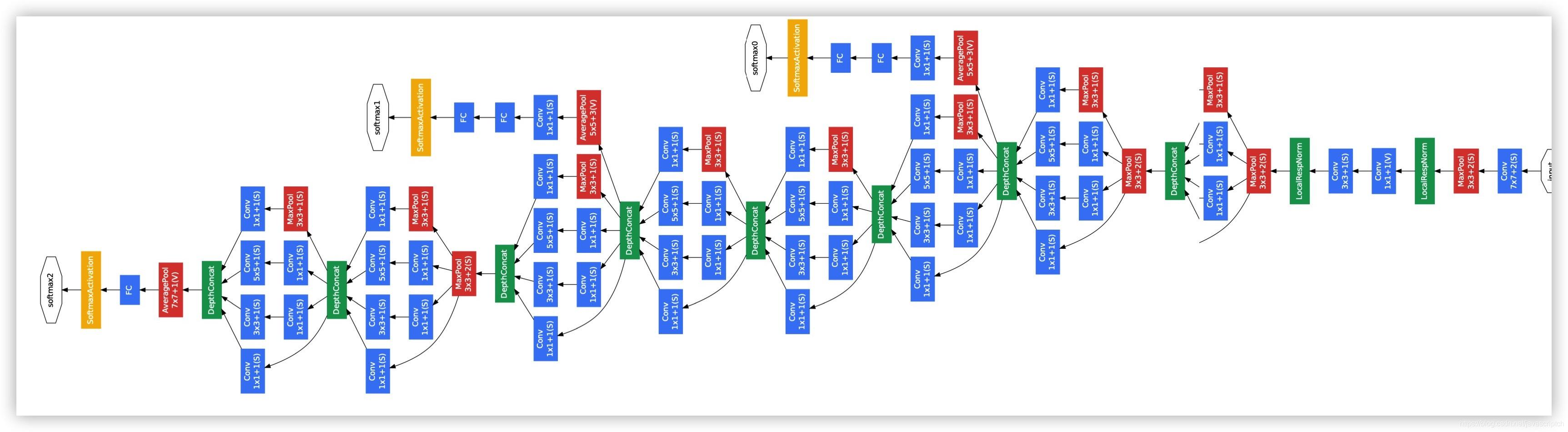

1.4 GoogLeNet

GoogLeNet是由Inception Module组成的,它的结构图:

它的特点:

1、采用模块化结构,方便增加和修改。整个网络结构其实就是叠加Inception Module

2、使用Dropout层,防止过拟合

3、使用Averagepool来代替全连接层的思想。实际在最后一层还是添加了一个全连接层,是为了大家做finetune。

4、另外增加了两个辅助的softmax分支,作用有两点,一是为了避免梯度消失,用于向前传导梯度。反向传播时如果有一层求导为0,链式求导结果则为0。二是将中间某一层输出用作分类,起到模型融合作用。最后的loss=loss_2 + 0.3 * loss_1 + 0.3 * loss_0。实际测试时,这两个辅助softmax分支会被去掉。

Inception-v2

2.1 创新点 谷歌团队在2015年提出了Inception-v2,首次提出了批量归一化(Batch Normalization)方法,同时也改进了网络结构。具体的创新点:

2.1.1 Batch Normalization 在神经网络的每层计算中,参数变化导致数据分布不一致,会产生数据的协方差偏移问题,通过对第i层的数据进行BN操作,也就是对数据进行归一化。可以将数据控制在一定的范围内,在输入到第i+1层。可以提高网络的收敛能力,减少dropout的使用。

2.1.2 拆分卷积核 问题:

减少特征的表征性瓶颈。直观上来说,当卷积不会大幅度改变输入维度时,神经网络可能会执行地更好。过多地减少维度可能会造成信息的损失,这也称为「表征性瓶颈」。

使用更优秀的因子分解方法,卷积才能在计算复杂度上更加高效。

解决方法:

使用小的感受野代替大的感受野,v1版本中使用了5x5的卷积核,v2版本使用两个3x3的卷积核可以替代它。这样保证了感受野的范围还减少了参数量。并且增加了网络的深度,使表达能力更强。

2.2 作用

1、批量归一化解决了协方差偏移的问题。让数据可控。即使使用大的学习率,网络也不会发生梯度消失或梯度爆炸的问题。减少了梯度对参数大小或初始值的依赖。还可以使用非线性饱和激活函数,因为可以避免陷入饱和状态。

2、卷积核的替换则可以保证感受野的同时,增加网络的表达能力。

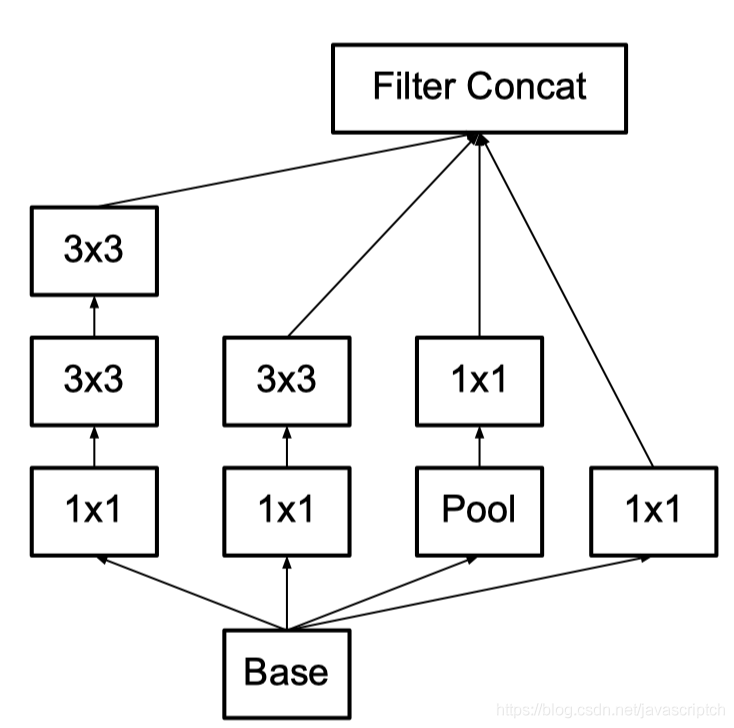

Inception-v3

3.1 创新点 Inception V3对 Inception V2 主要进行了两个方面的改进。

首先,Inception V3 对 Inception Module 的结构进行了优化,现在 Inception Module有了更多的种类(有 35 × 35 、 1 7× 17 和 8× 8 三种不同结构),并且 Inception V3 还在 Inception Module 的分支中使用了分支(主要体现在 8x8 的结构中),如下图所示。

其次,在 Inception V3 中还引入了将一个较大的二维卷积拆成两个较小的一维卷积的做法。例如, 7× 7 卷积可以拆成 1×7 卷积和7 × l卷积。当然3x3 卷积也可以拆成 Ix3 卷积和 3 × l卷积。这被称为Factorizationinto small convolutions 思想。在论文中作者指出,这种非对称的卷积结构拆分在处理更多、更丰富的空间特征以及增加特征多样性等方面的效果能够比对称的卷积结构拆分更好,同时能减少计算量。例如,2个33代替1个55减少28%的计算量,如下图所示。

3.2 作用 1、由于 Inception 网络是全卷积的, 每一个权重都会与多处响应相关联, 计算成本的降低会带来参数量的降低. 这意味着通过恰当的因式分解(factorizationinto convolutions), 作者可以得到更多解耦的参数, 从而可以带来更快的训练速度。

2、论文中也提了辅助分类器的效用。带有辅助分类器和不带辅助分类器的两个网络,在模型达到较高精度以前,他们的性能看起来是差不多的。但是当到了训练后期,带有辅助分支的网络开始超越没有任何辅助分支的网络,进而达到更高的精度。

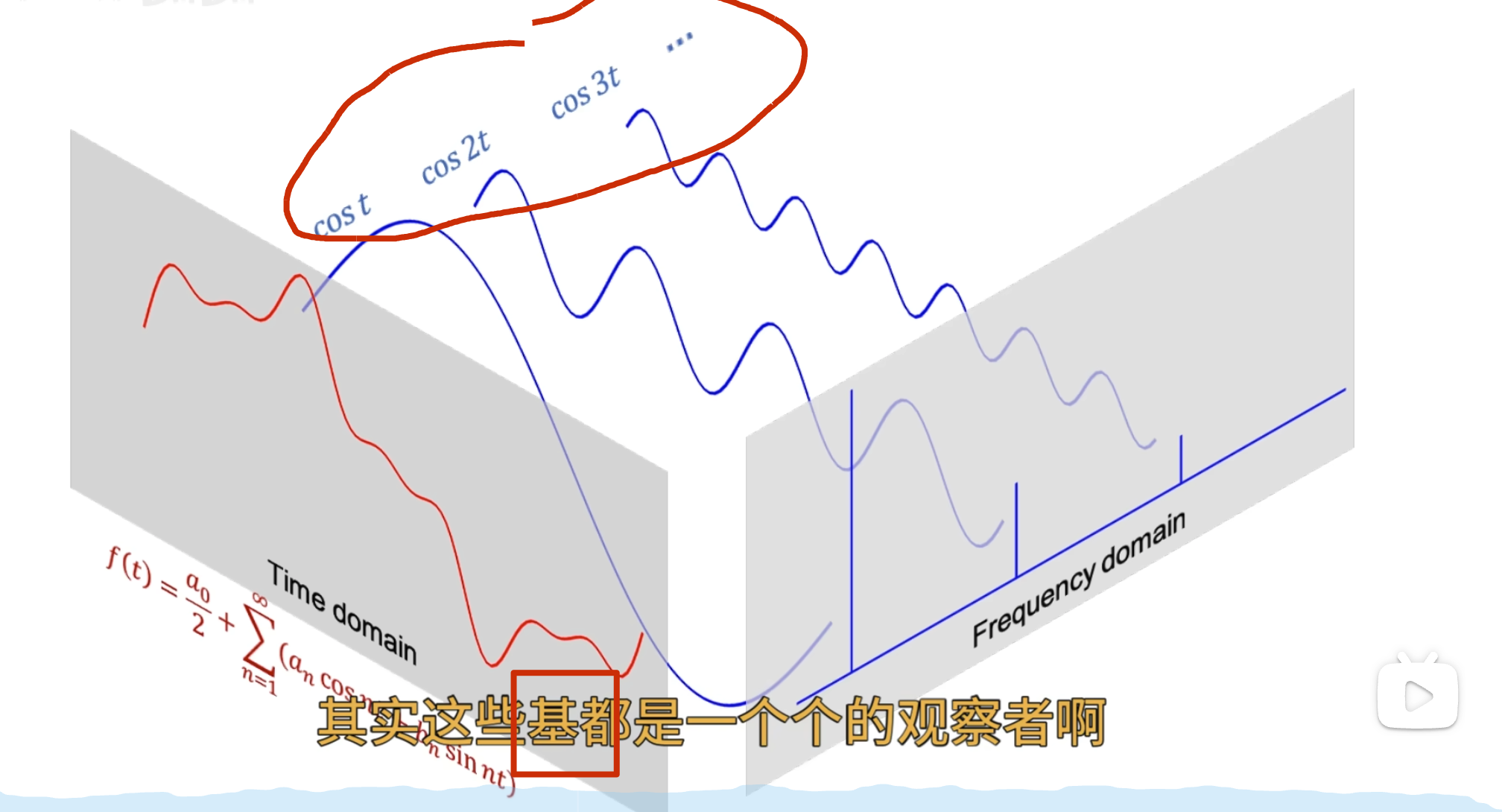

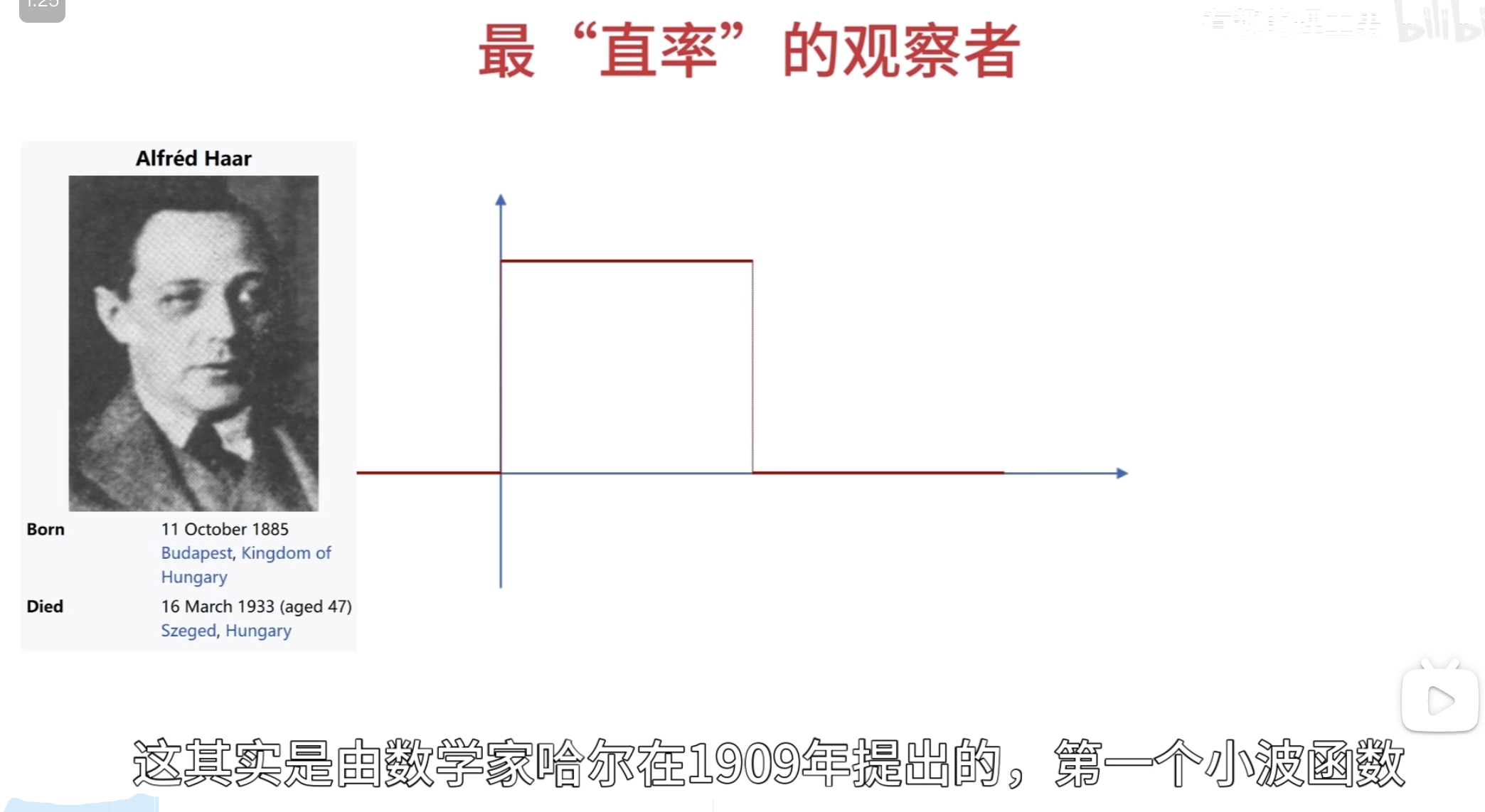

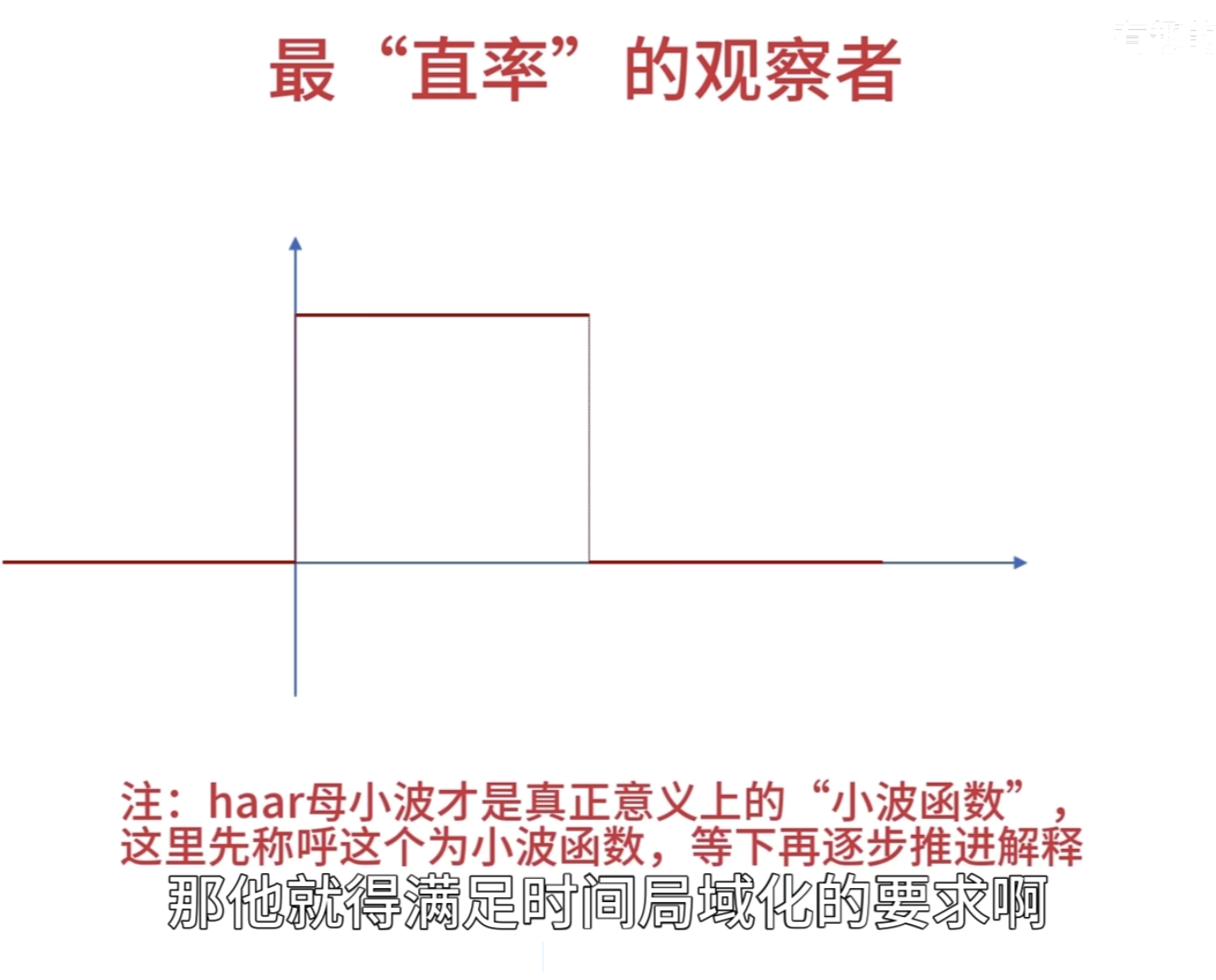

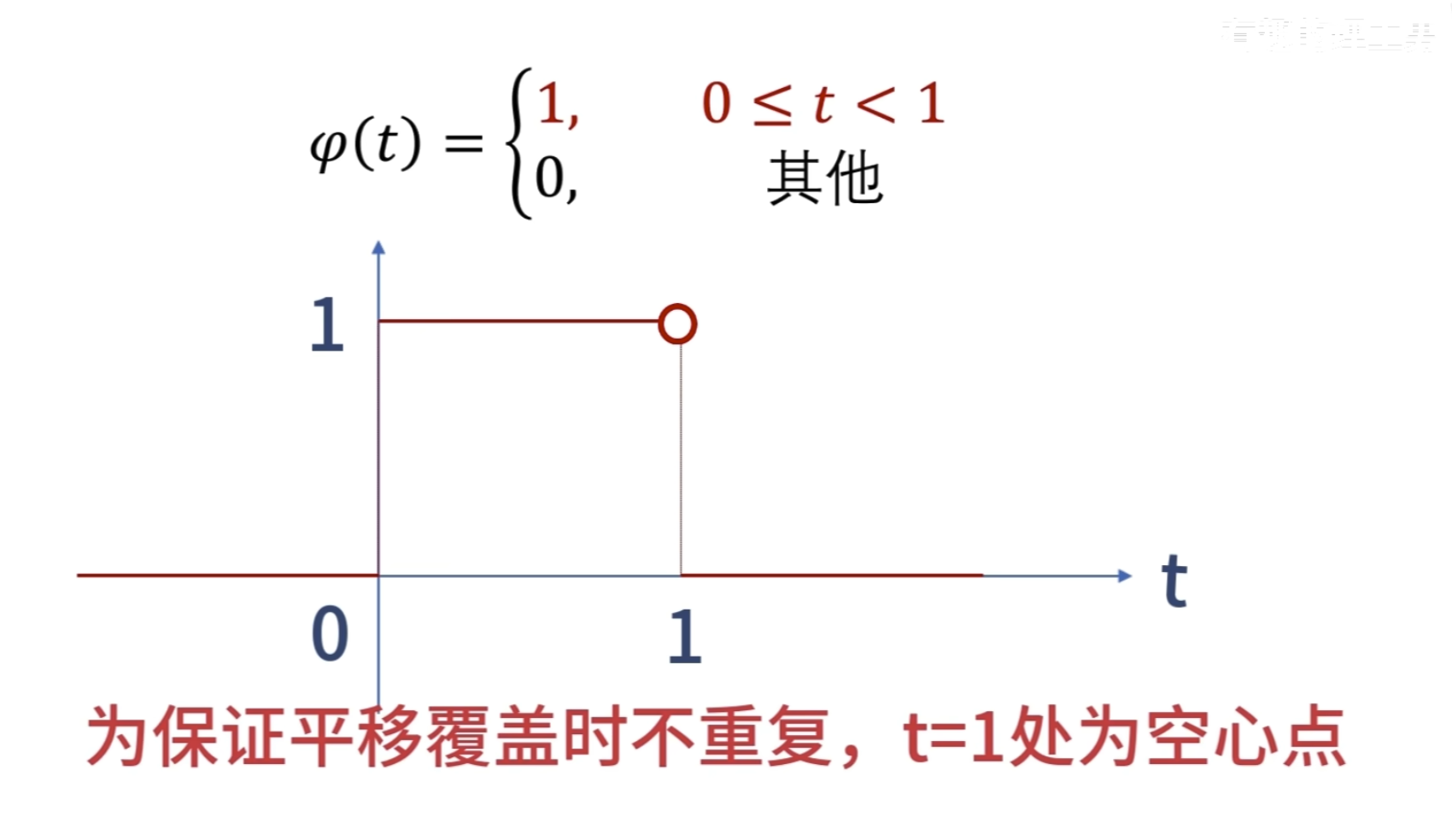

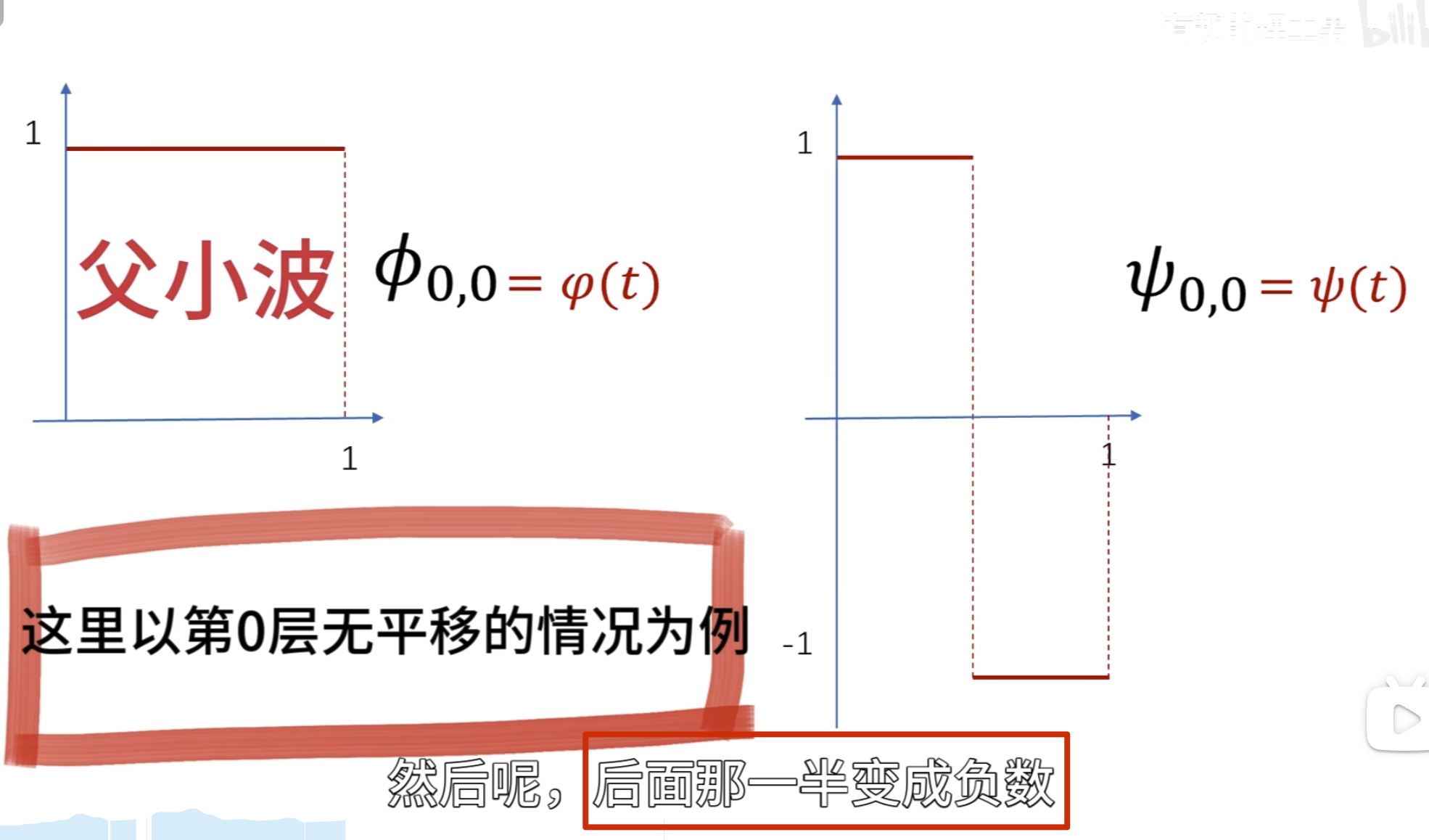

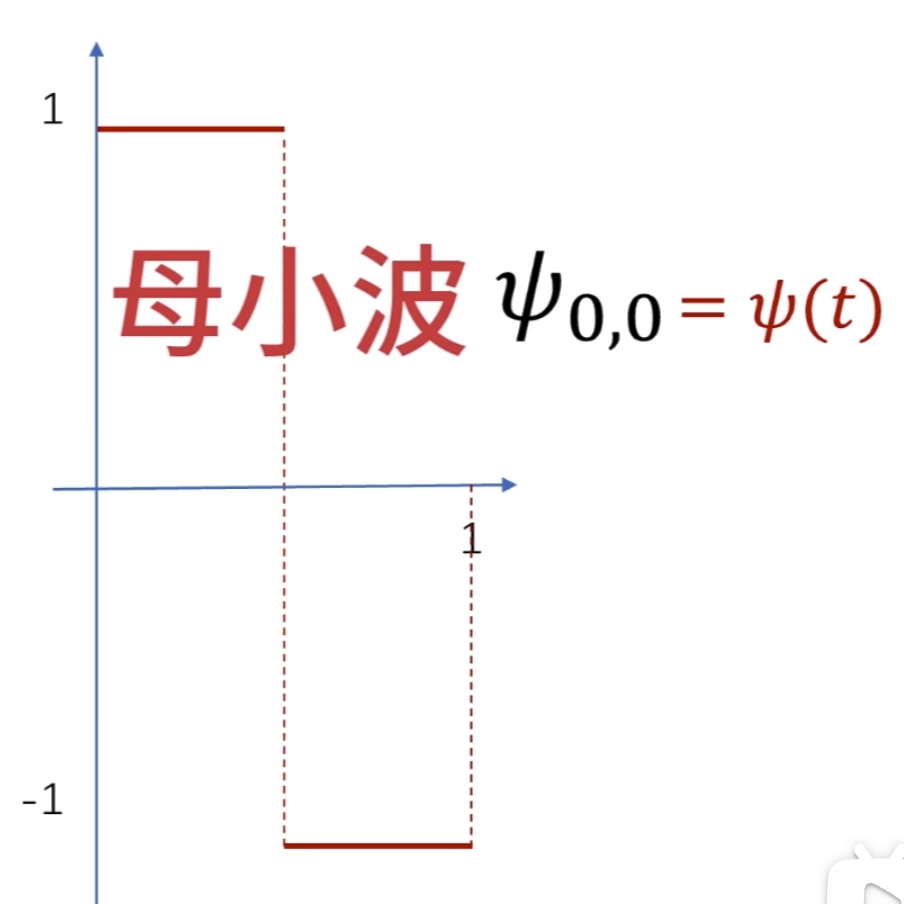

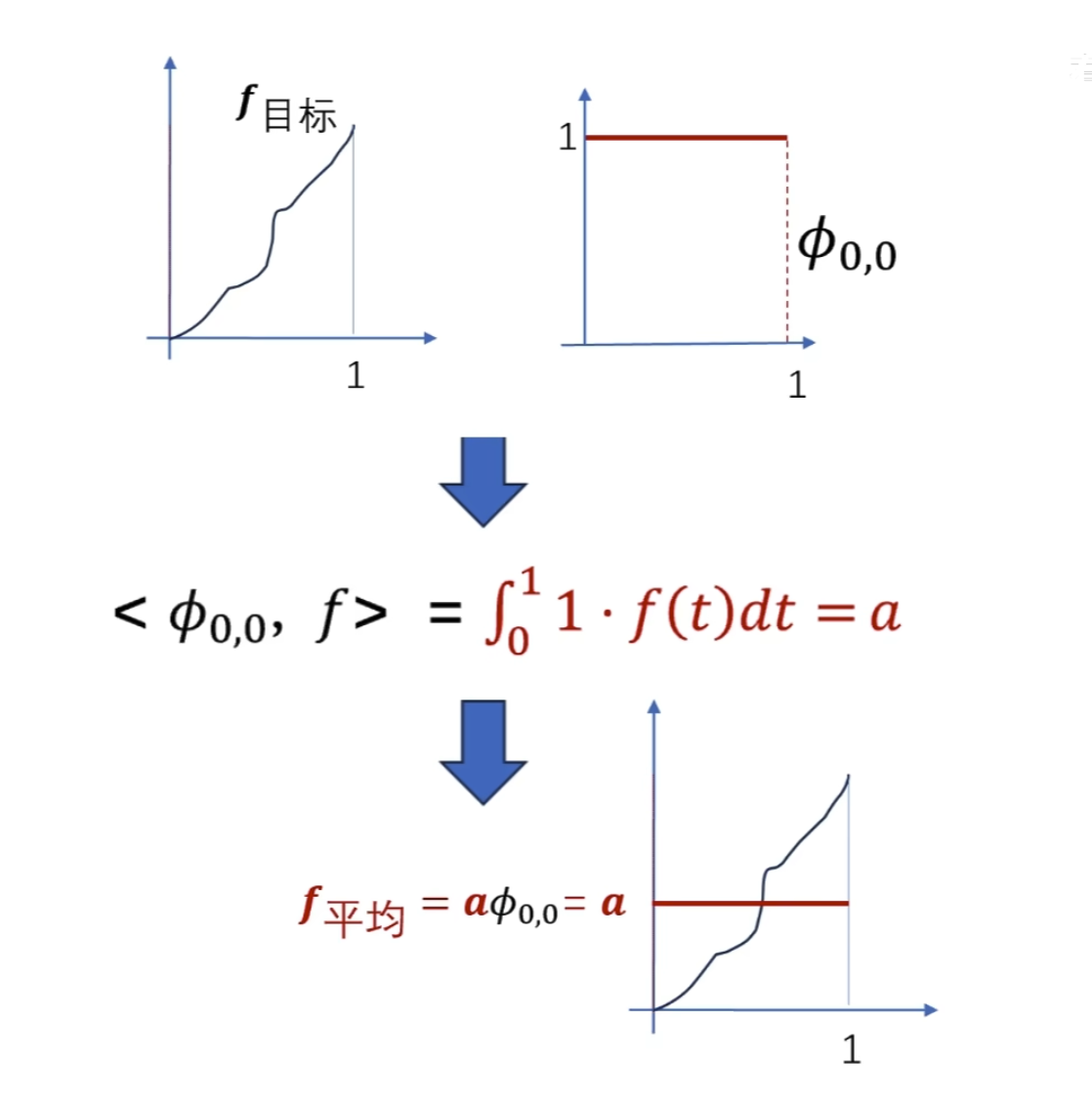

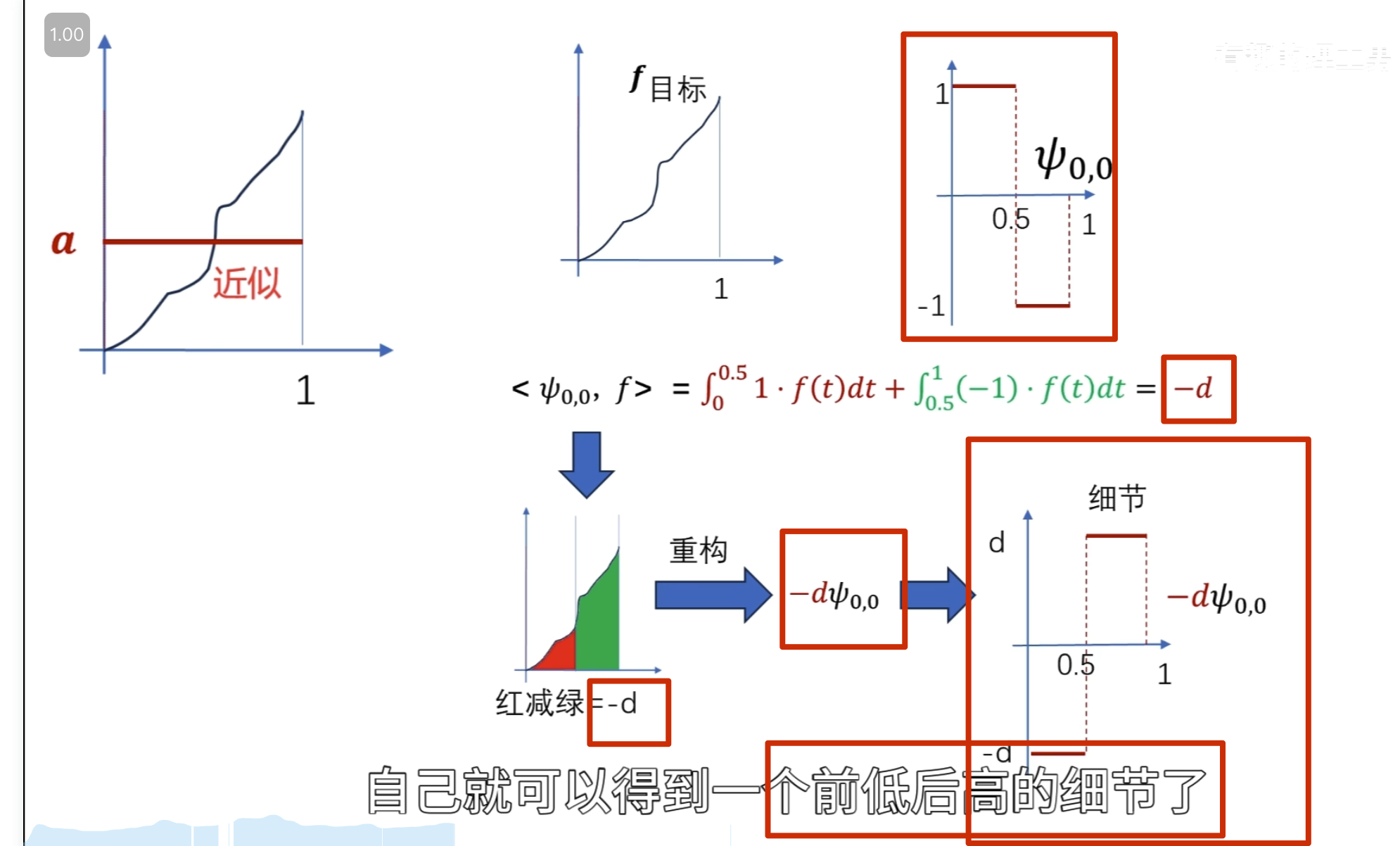

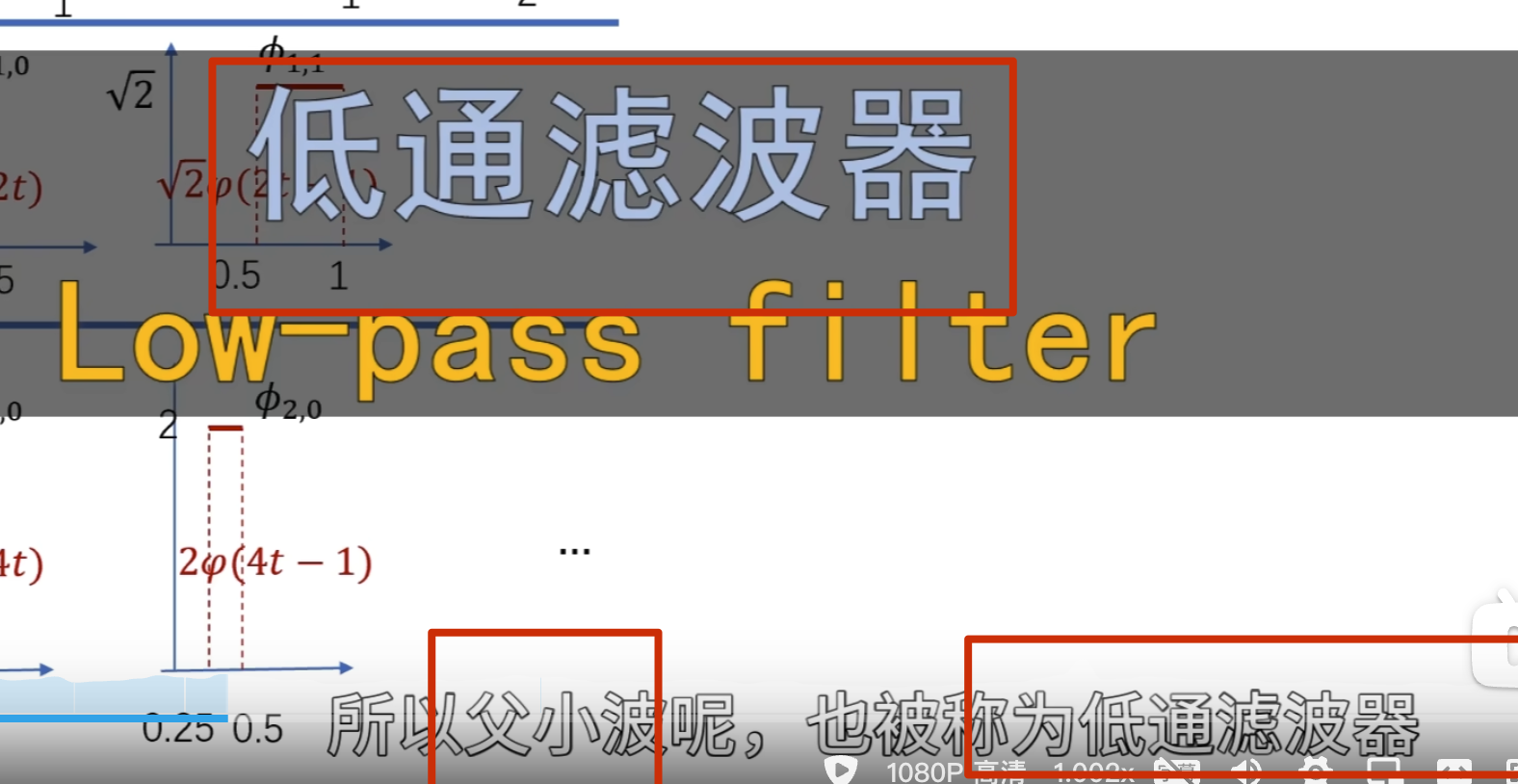

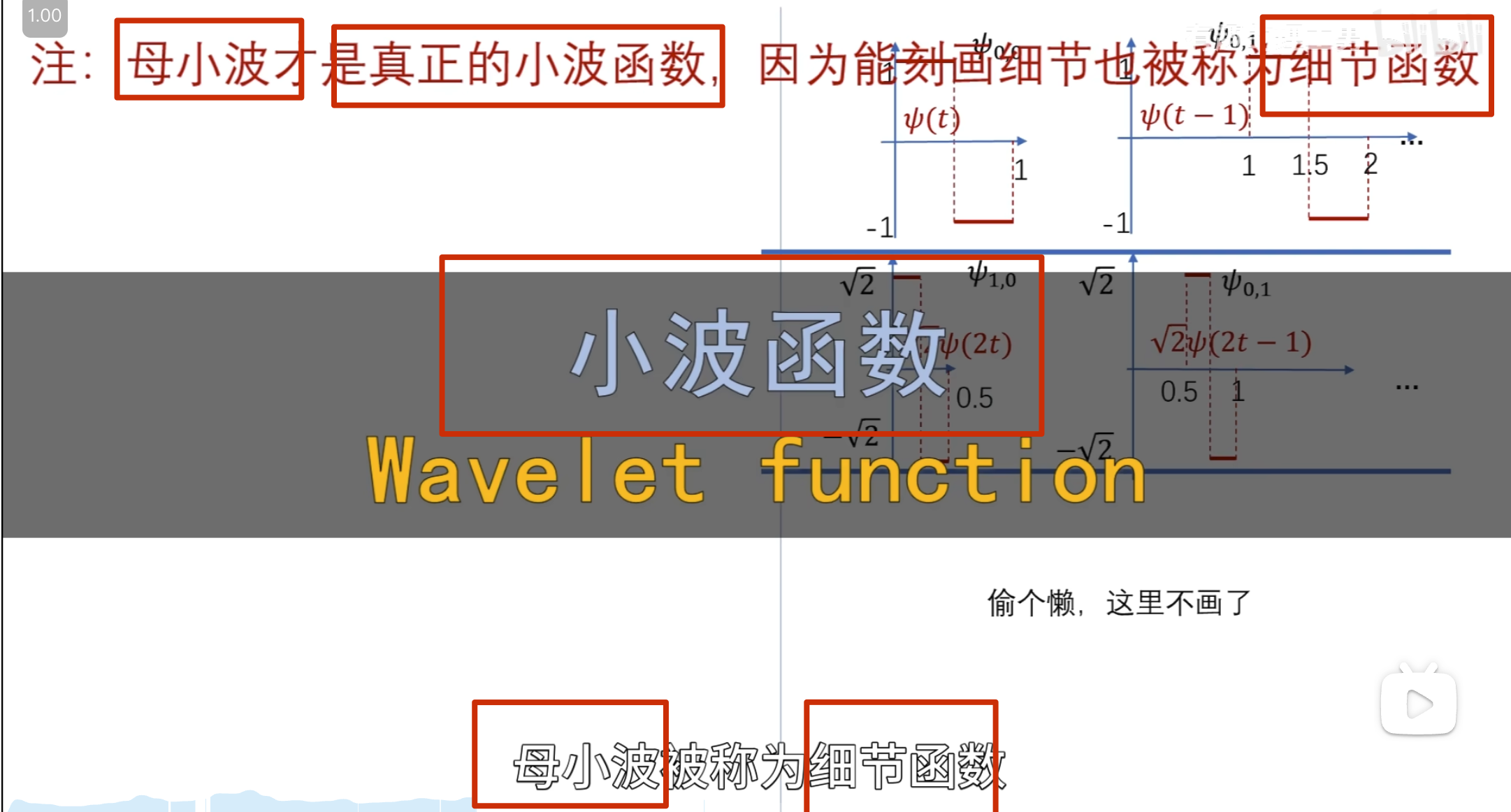

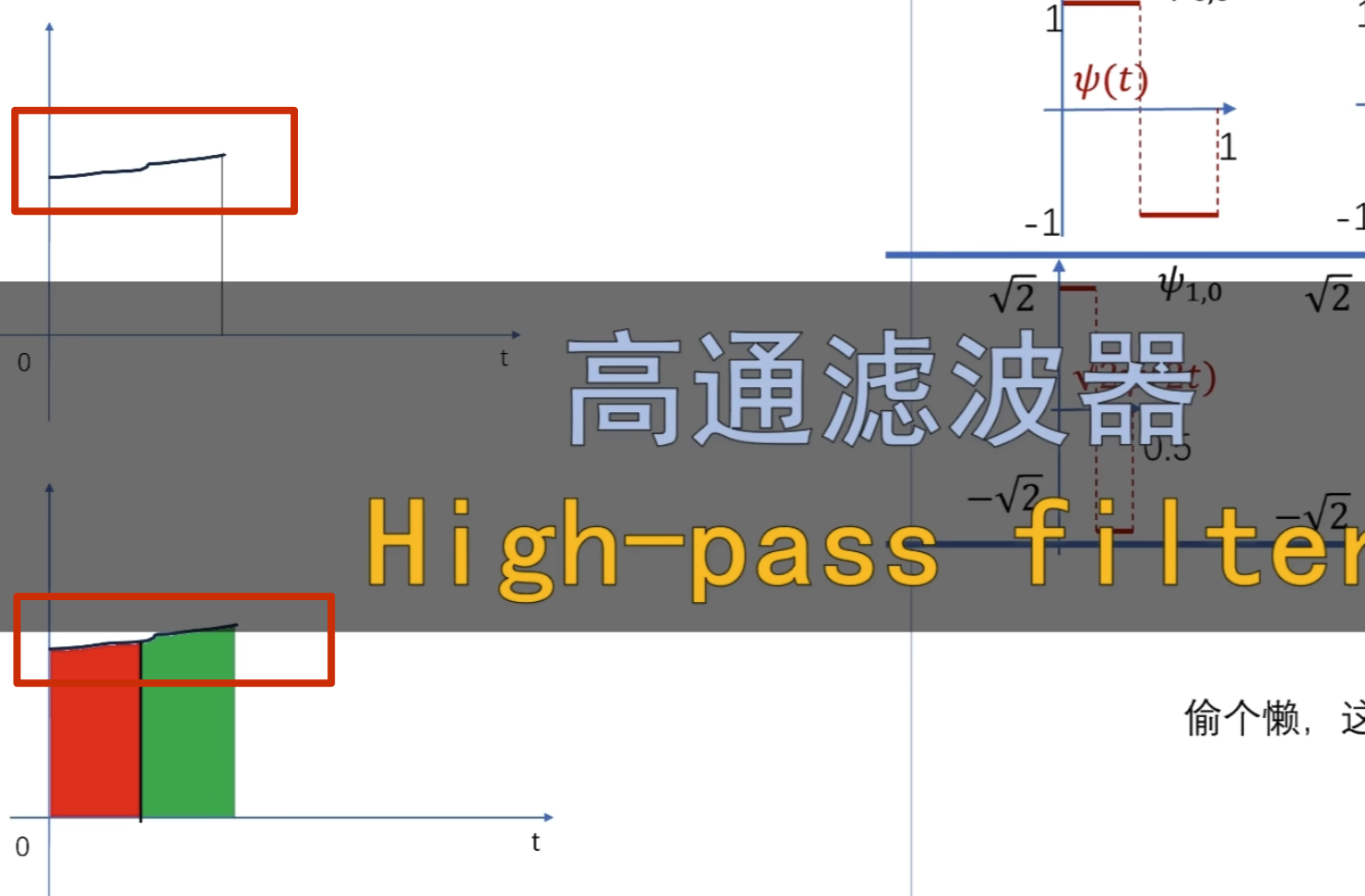

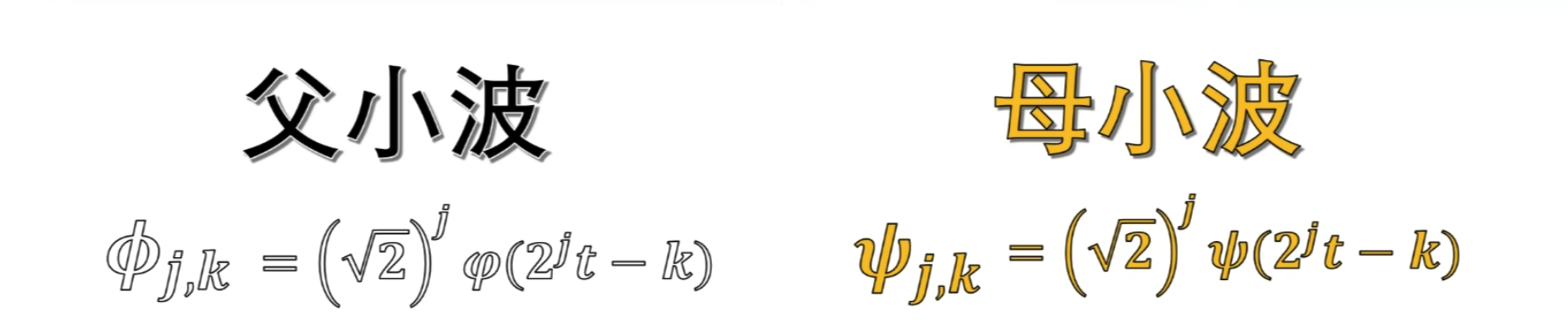

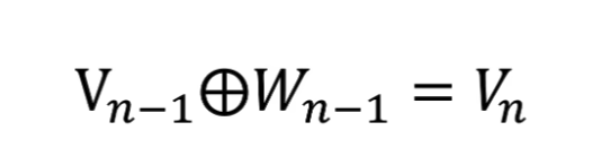

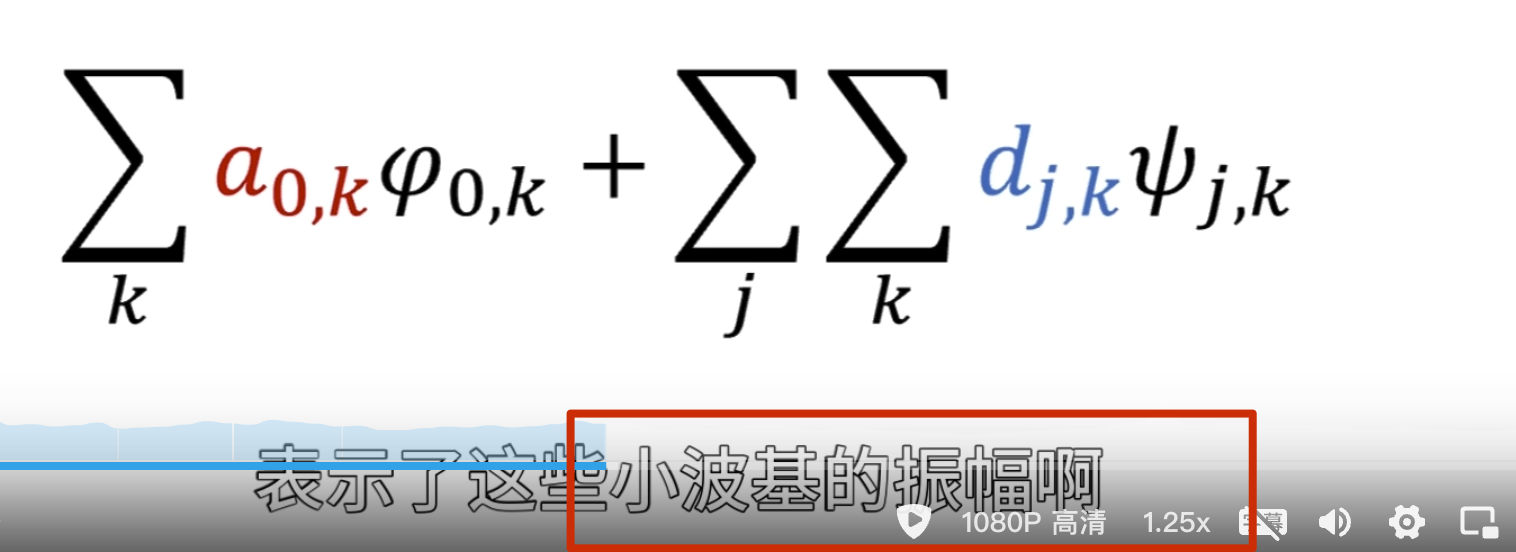

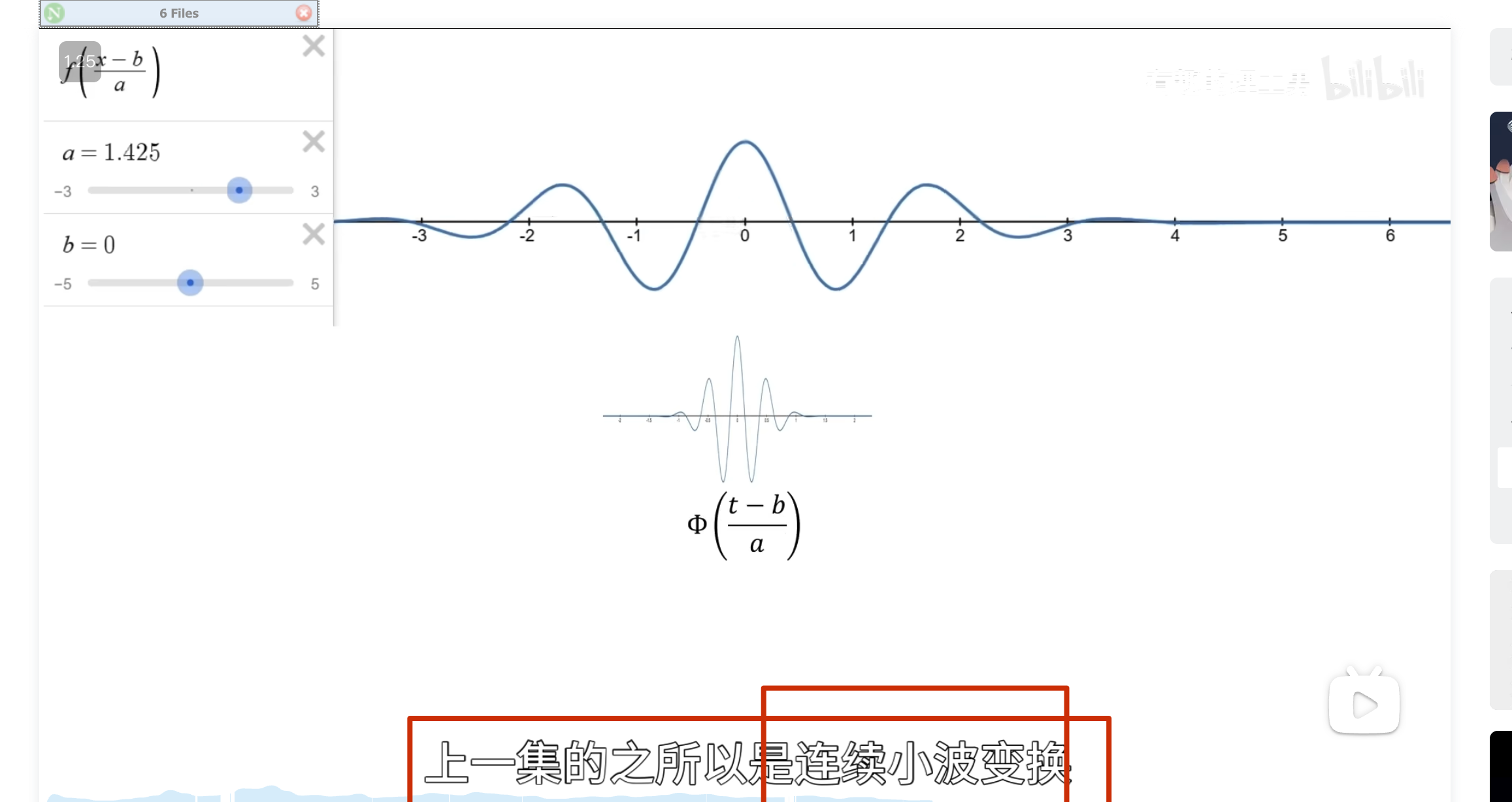

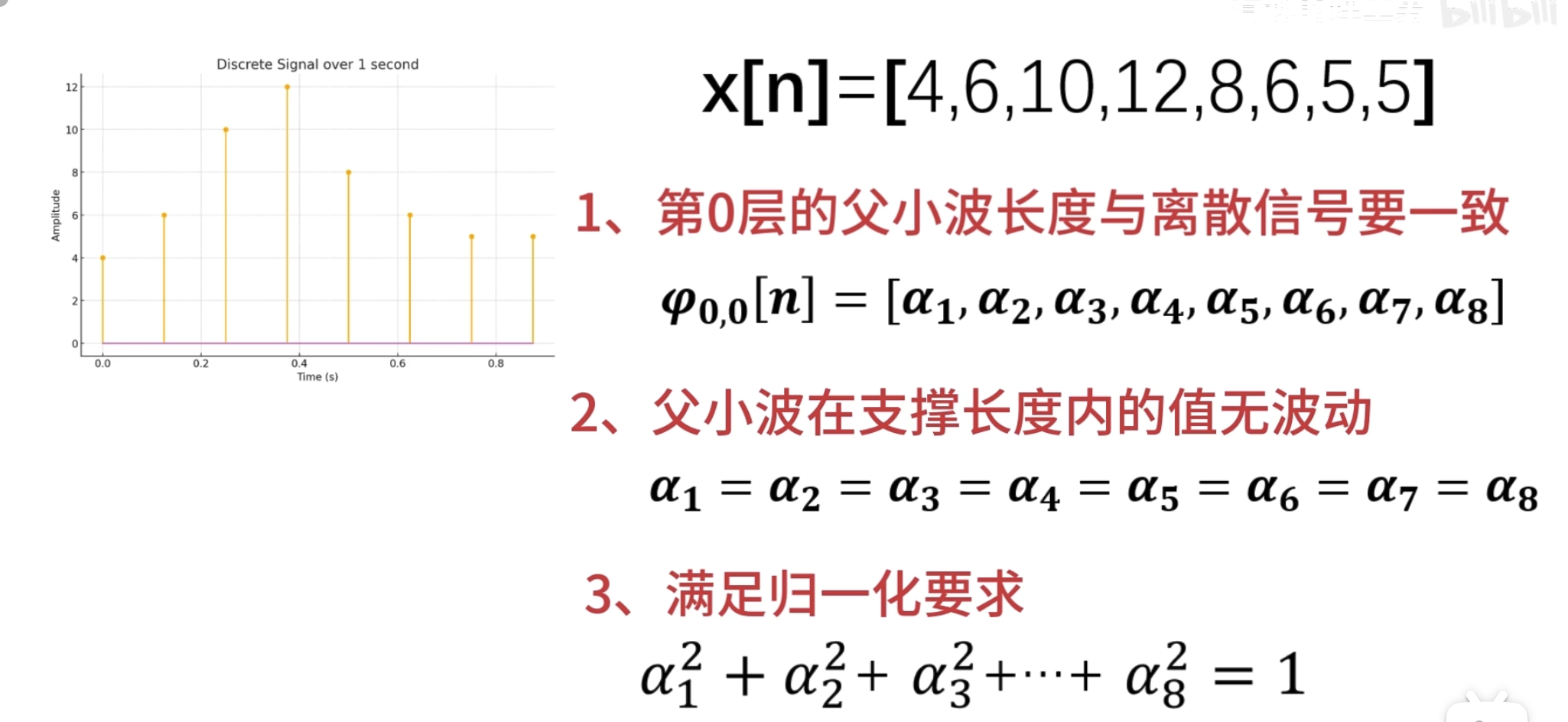

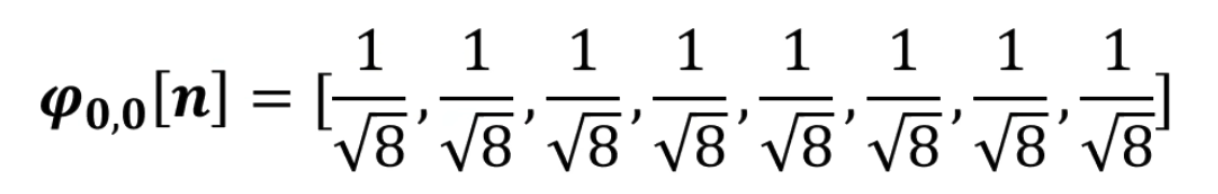

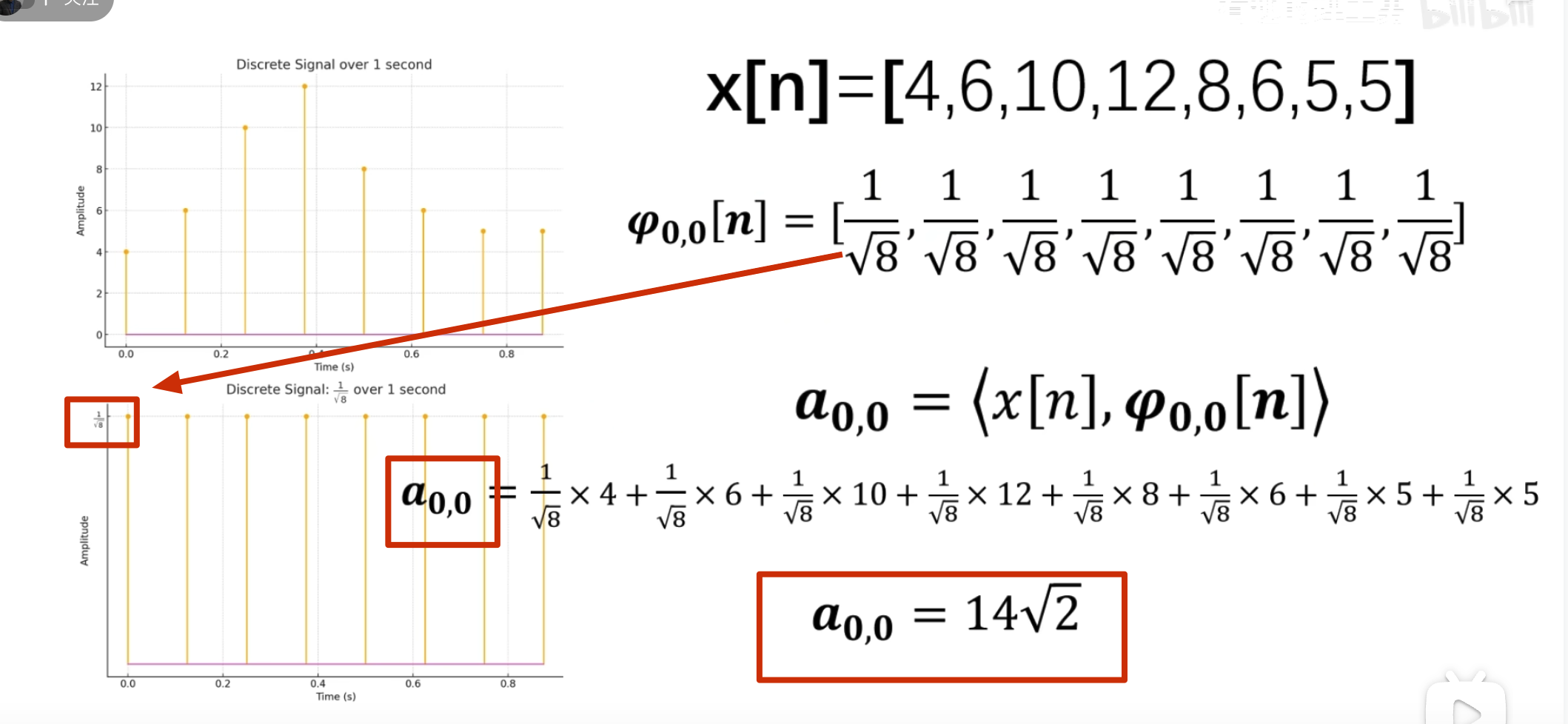

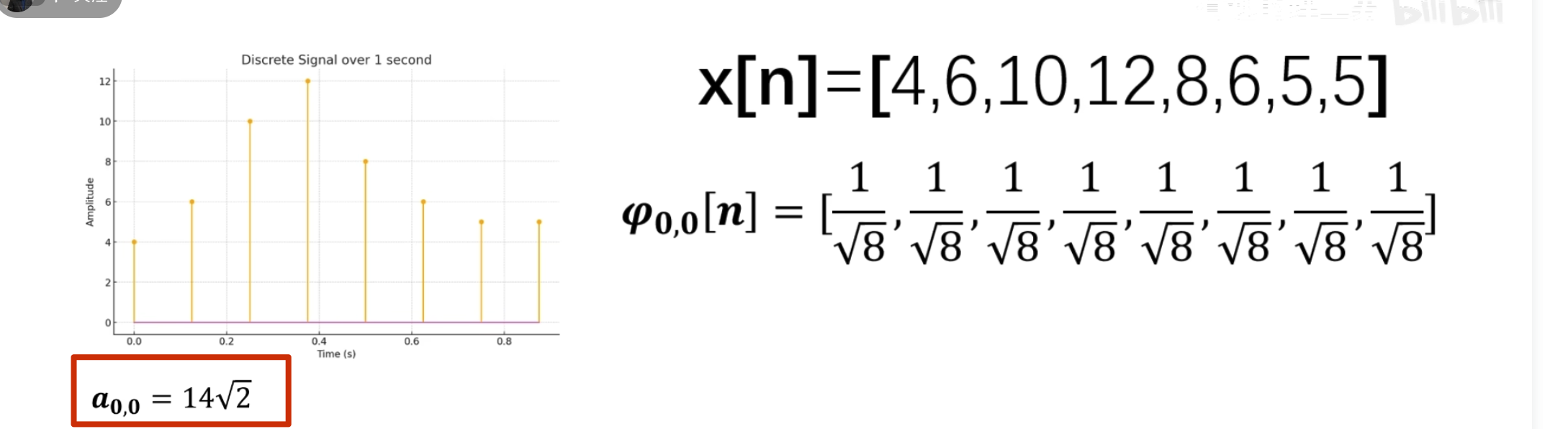

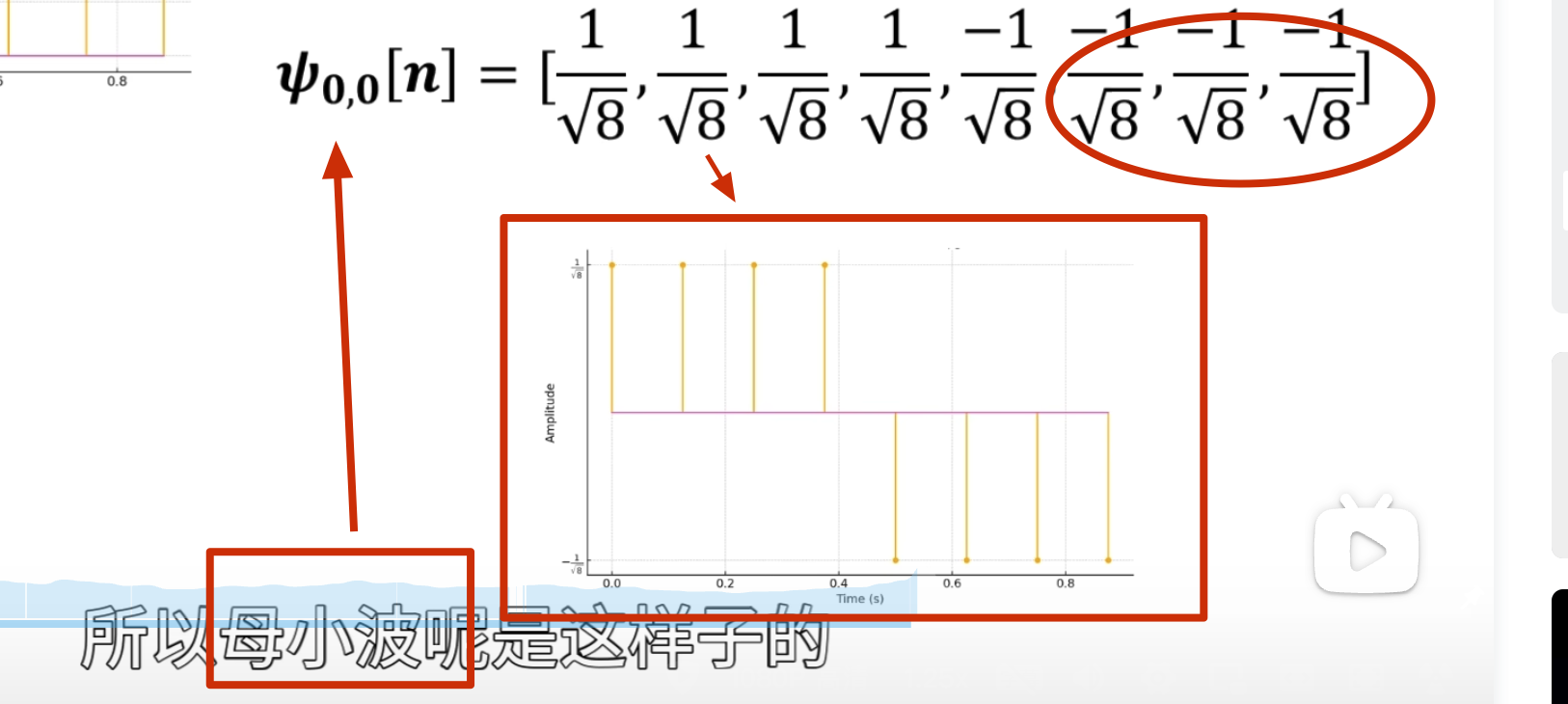

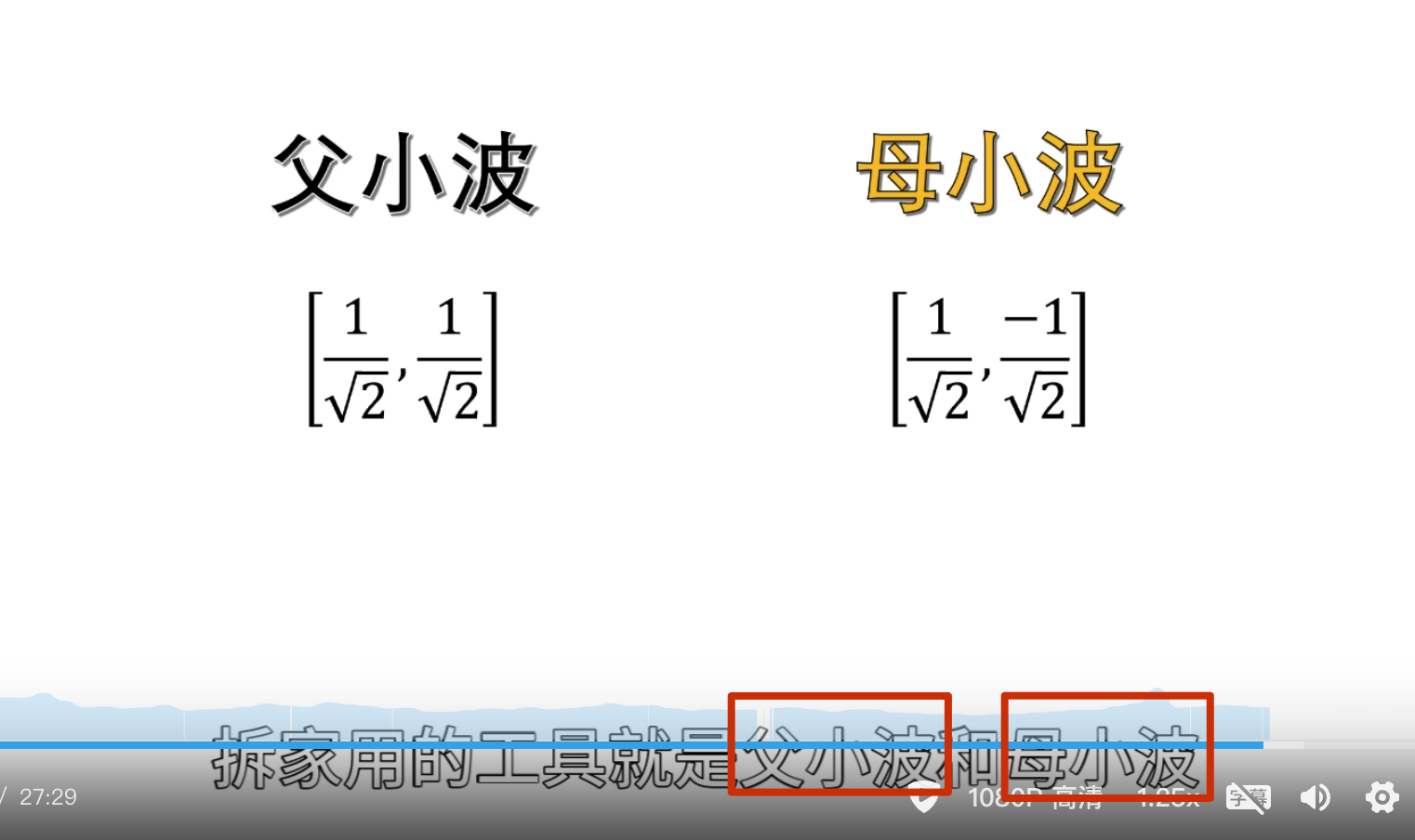

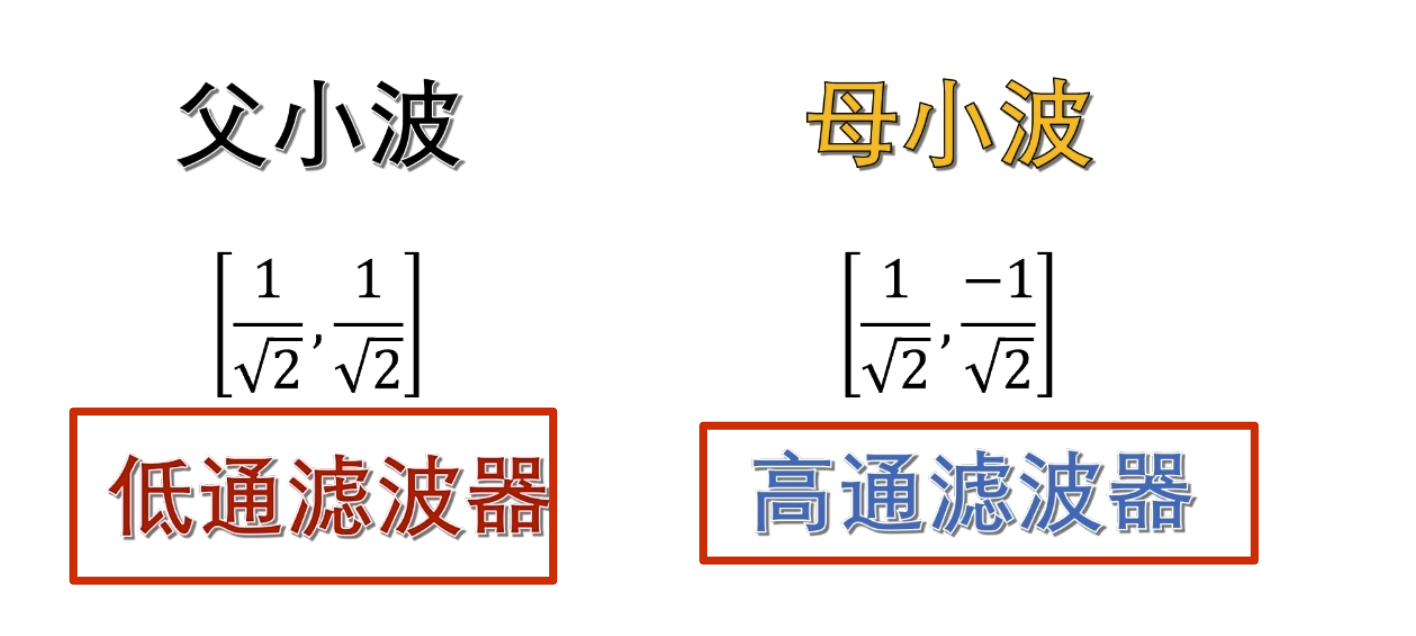

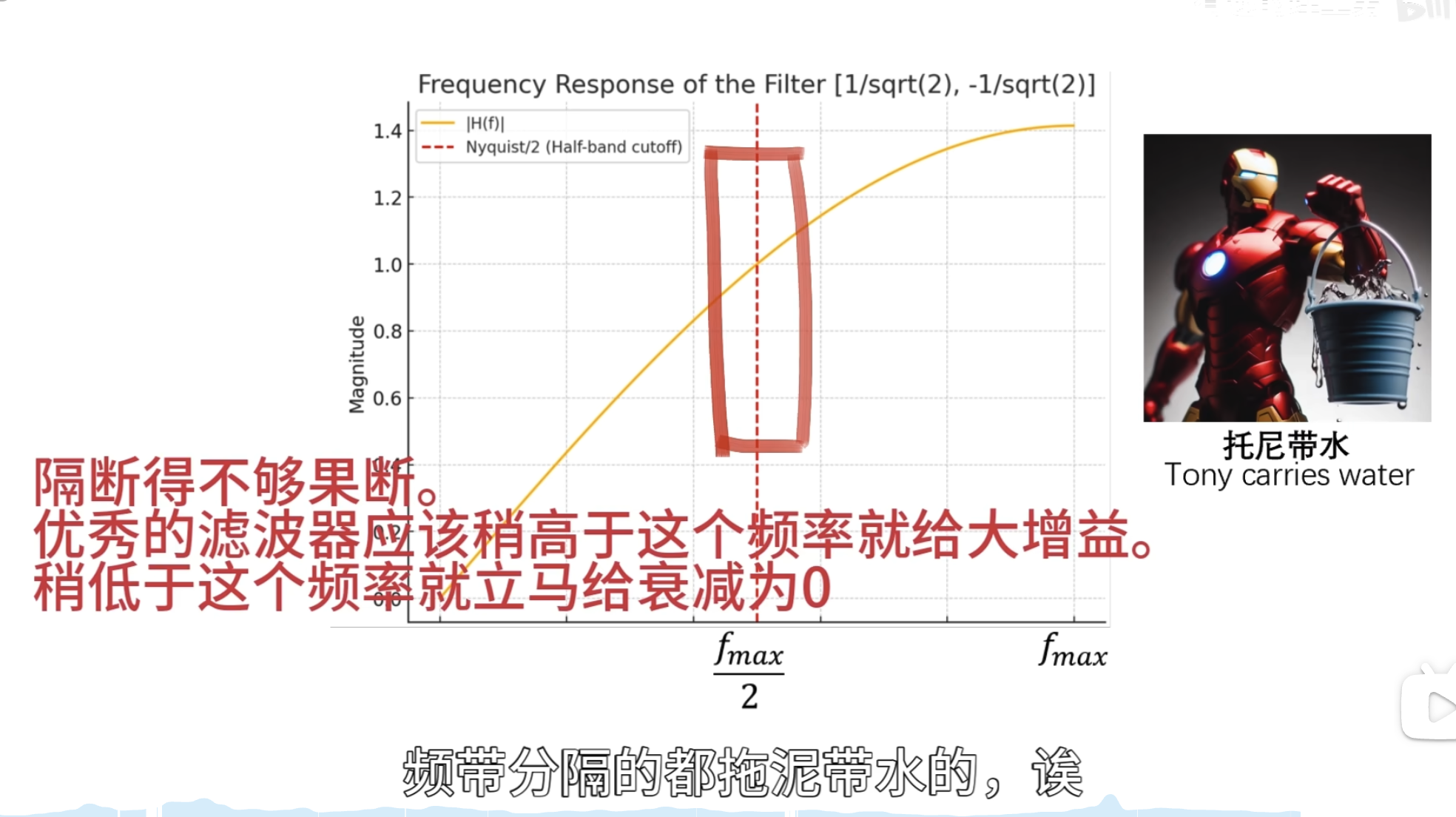

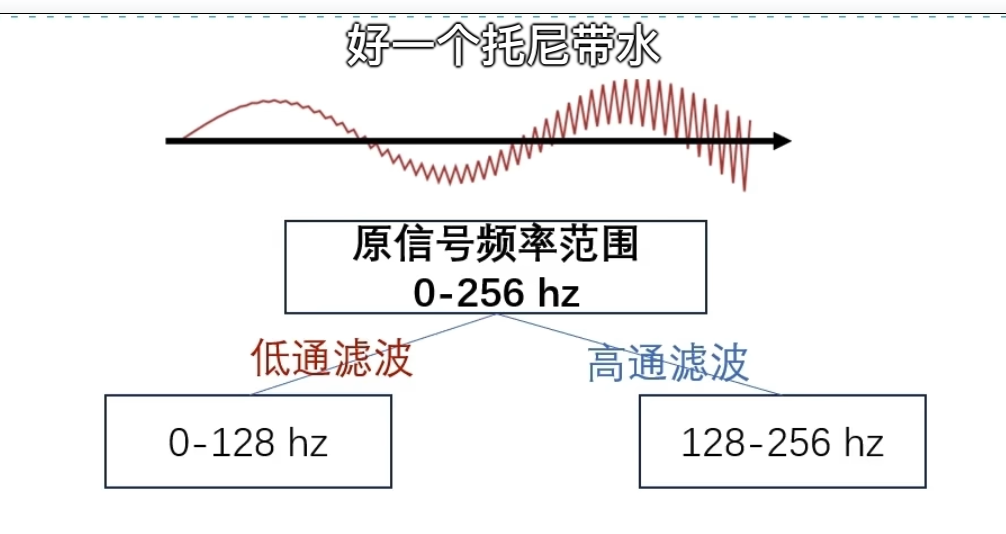

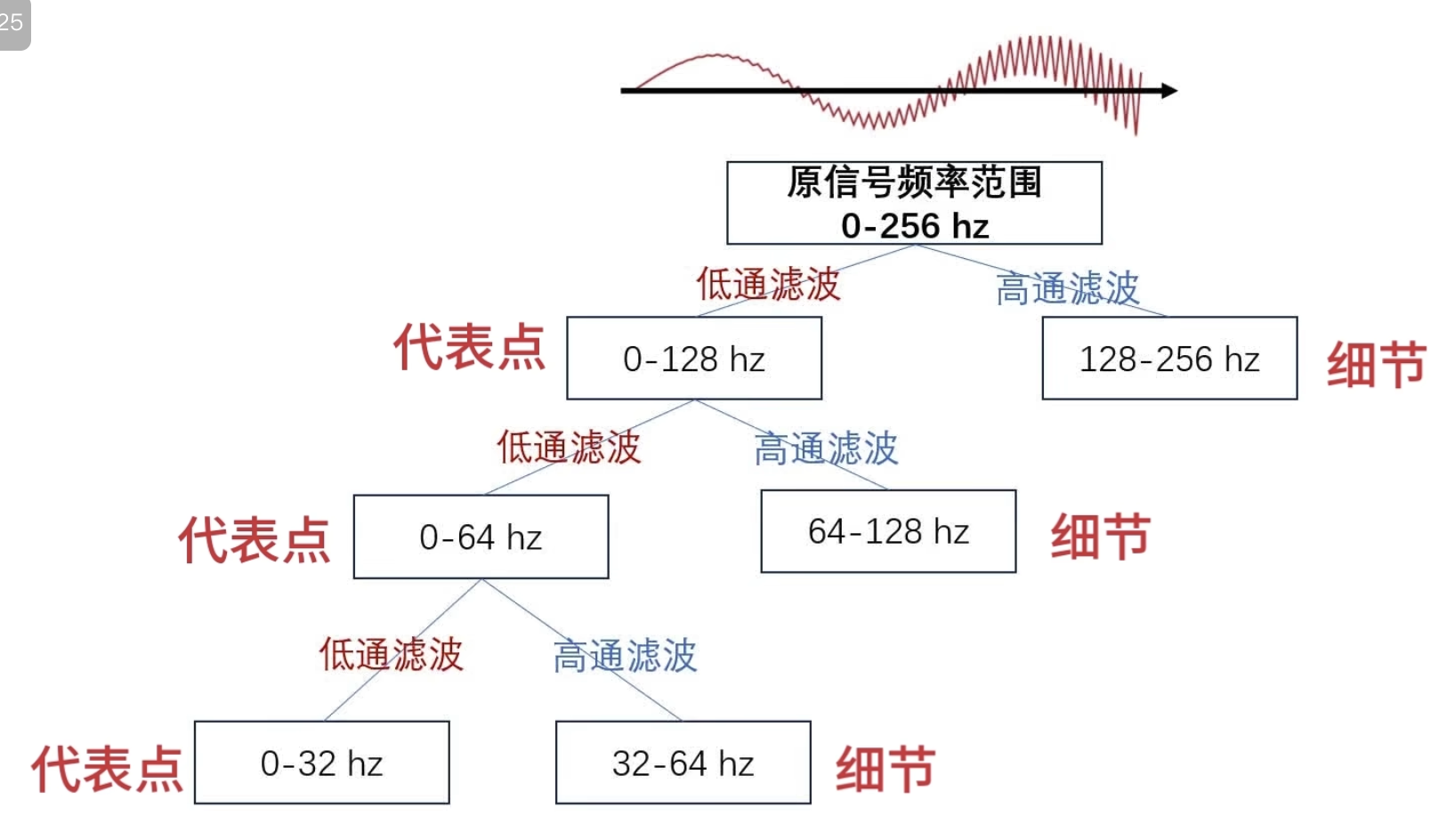

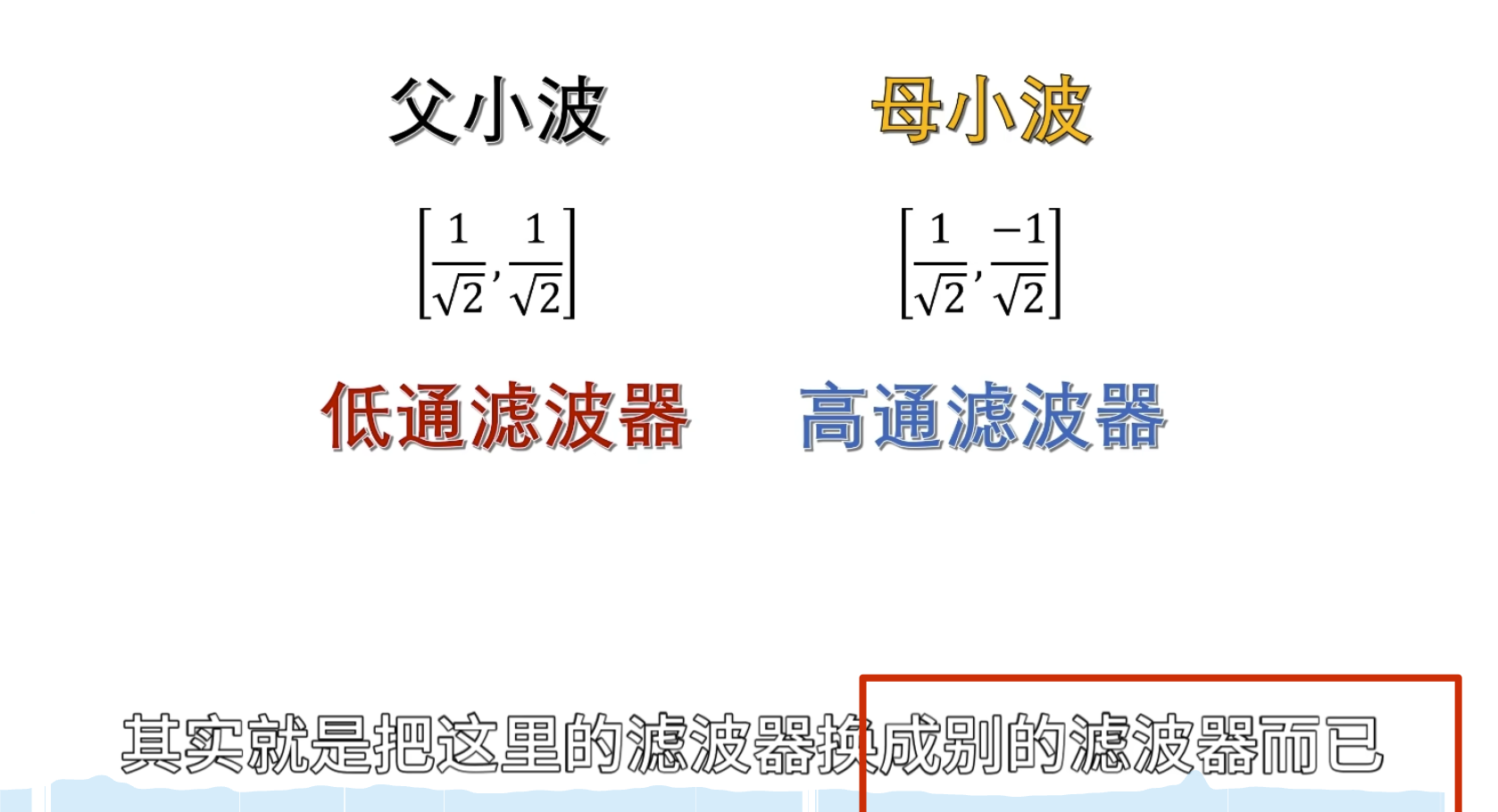

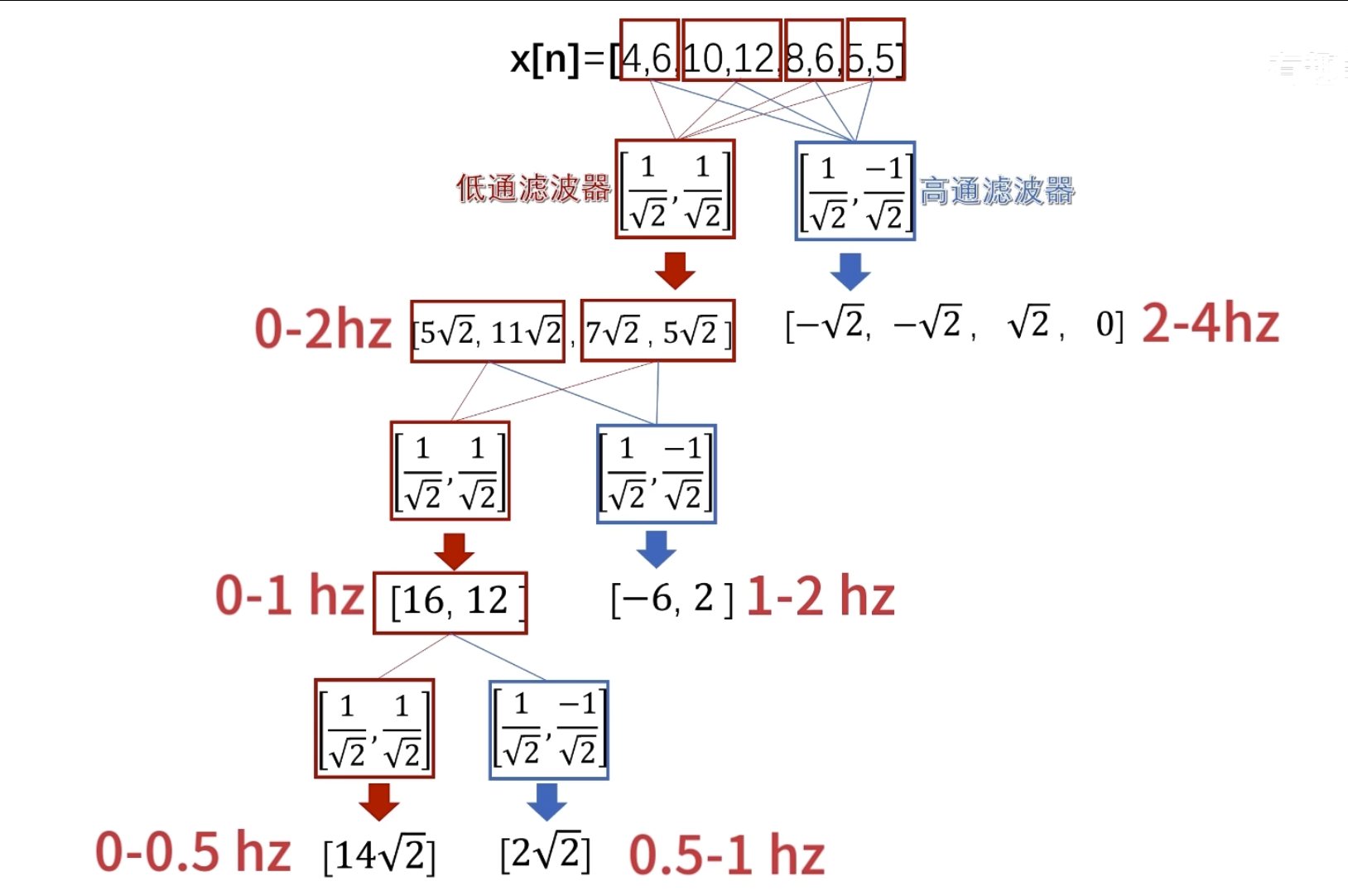

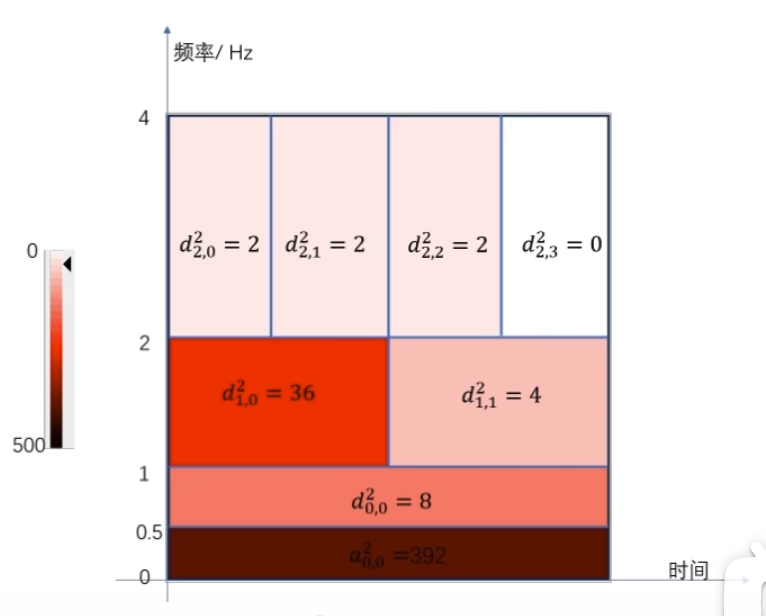

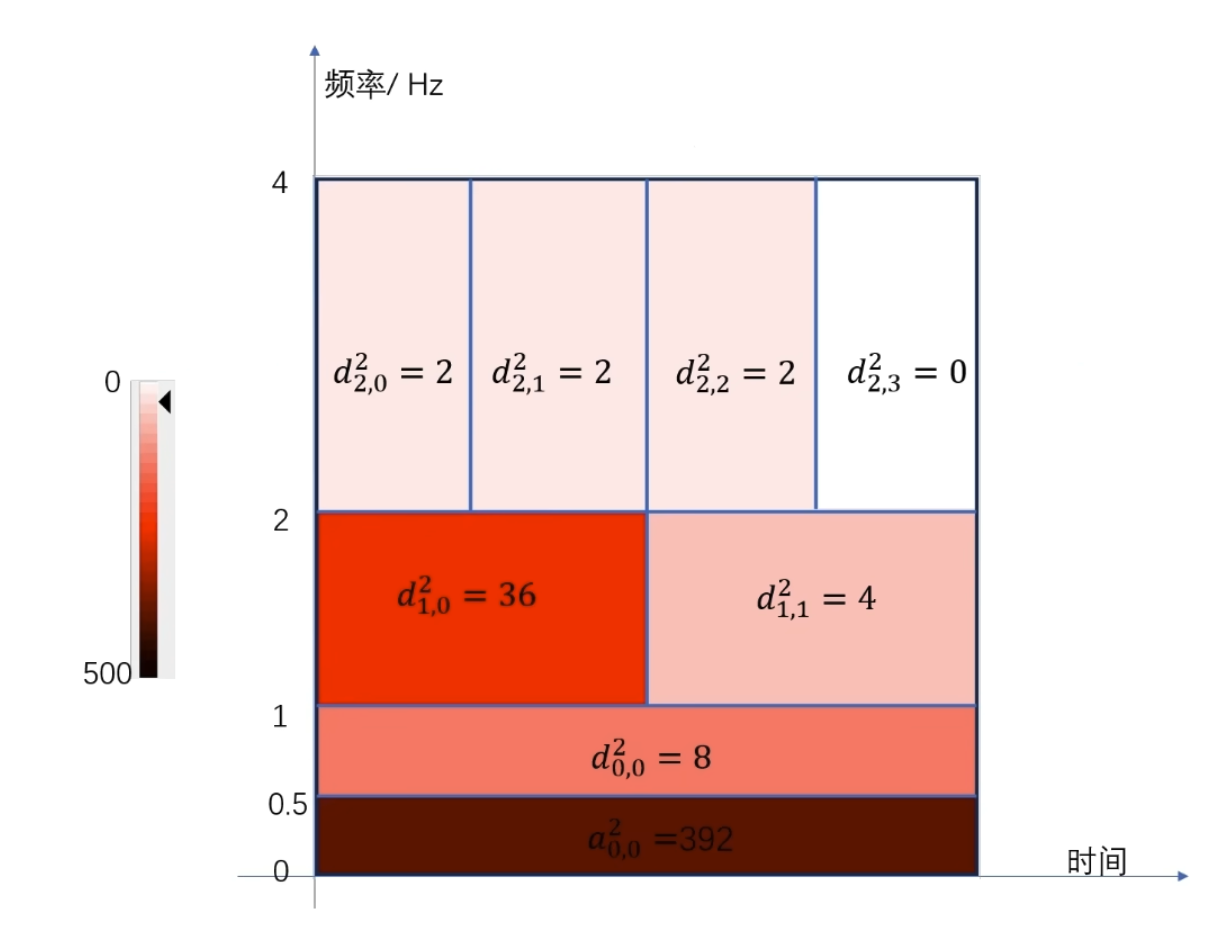

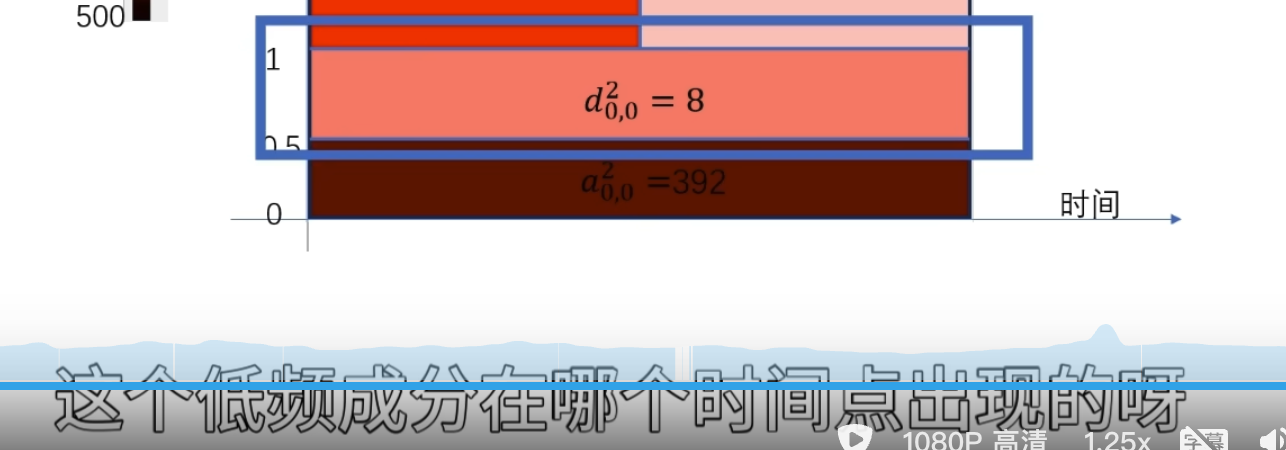

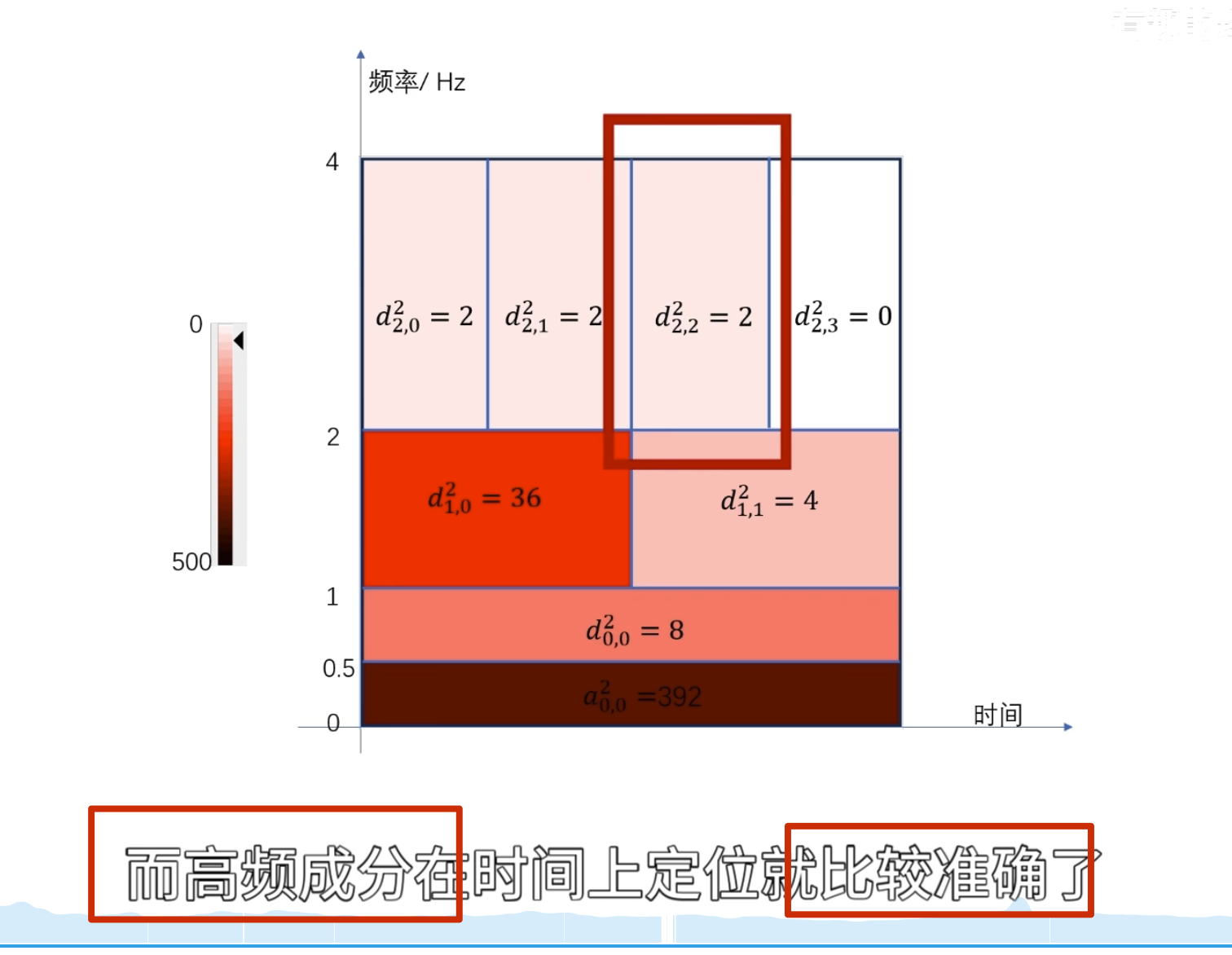

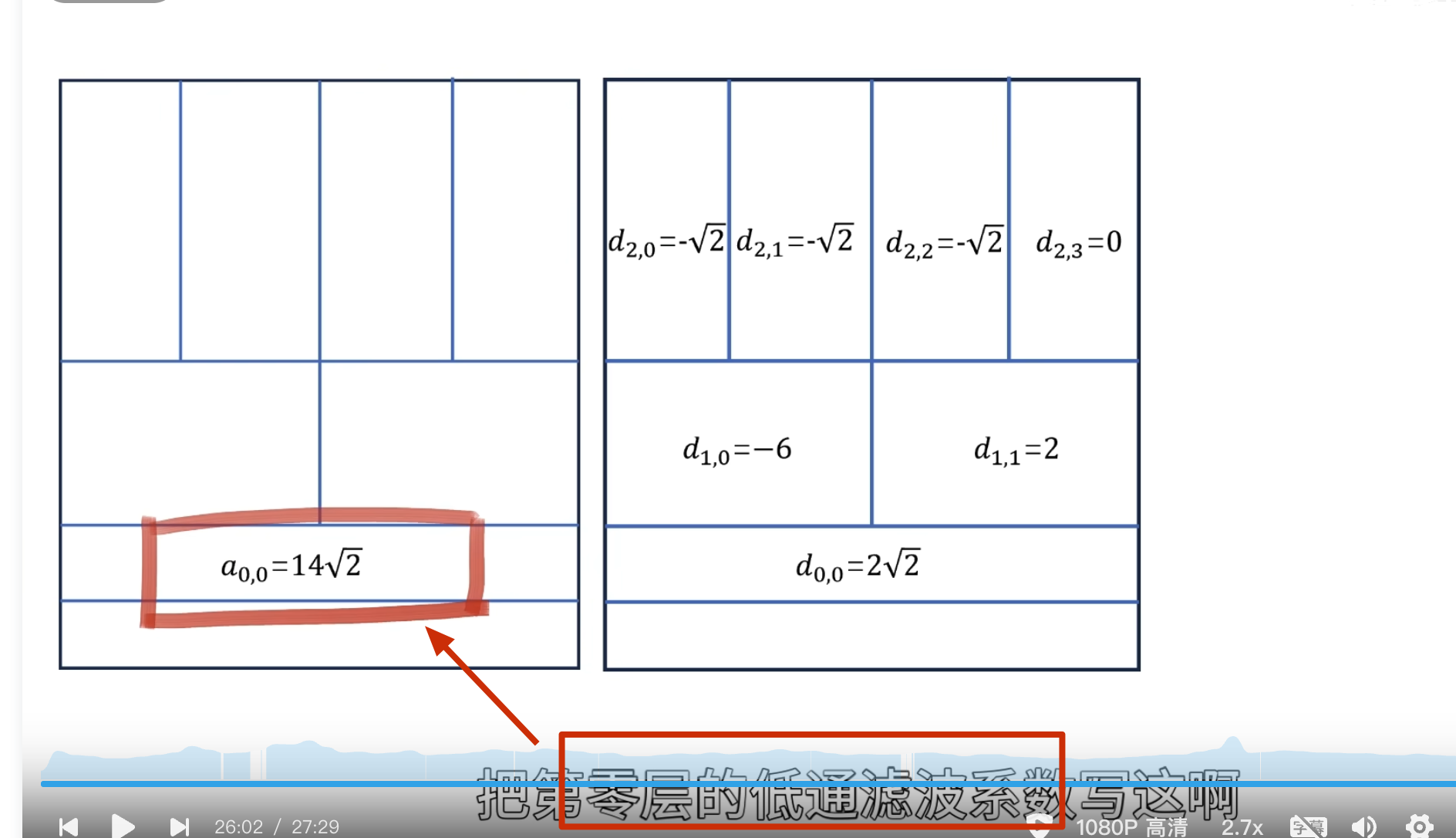

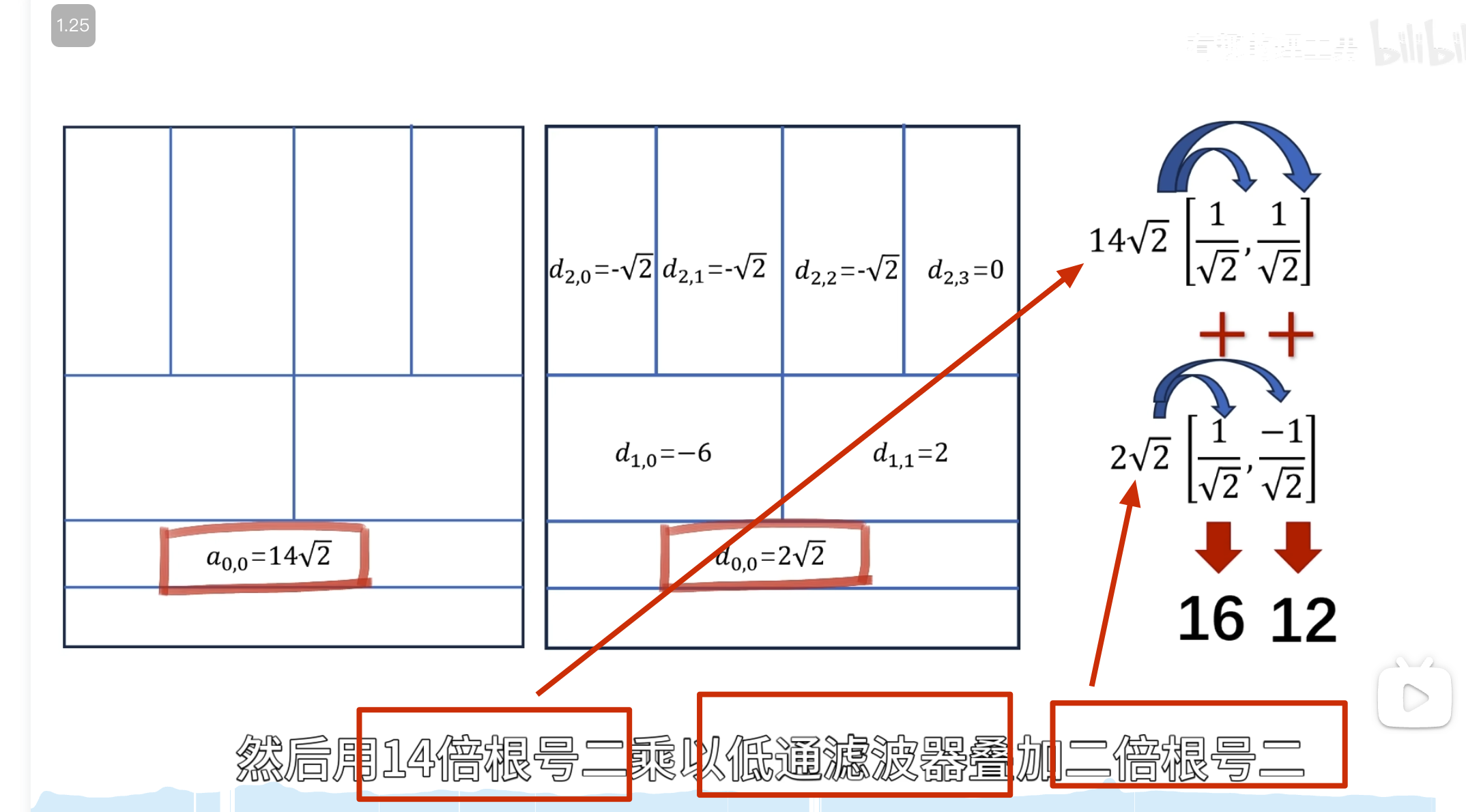

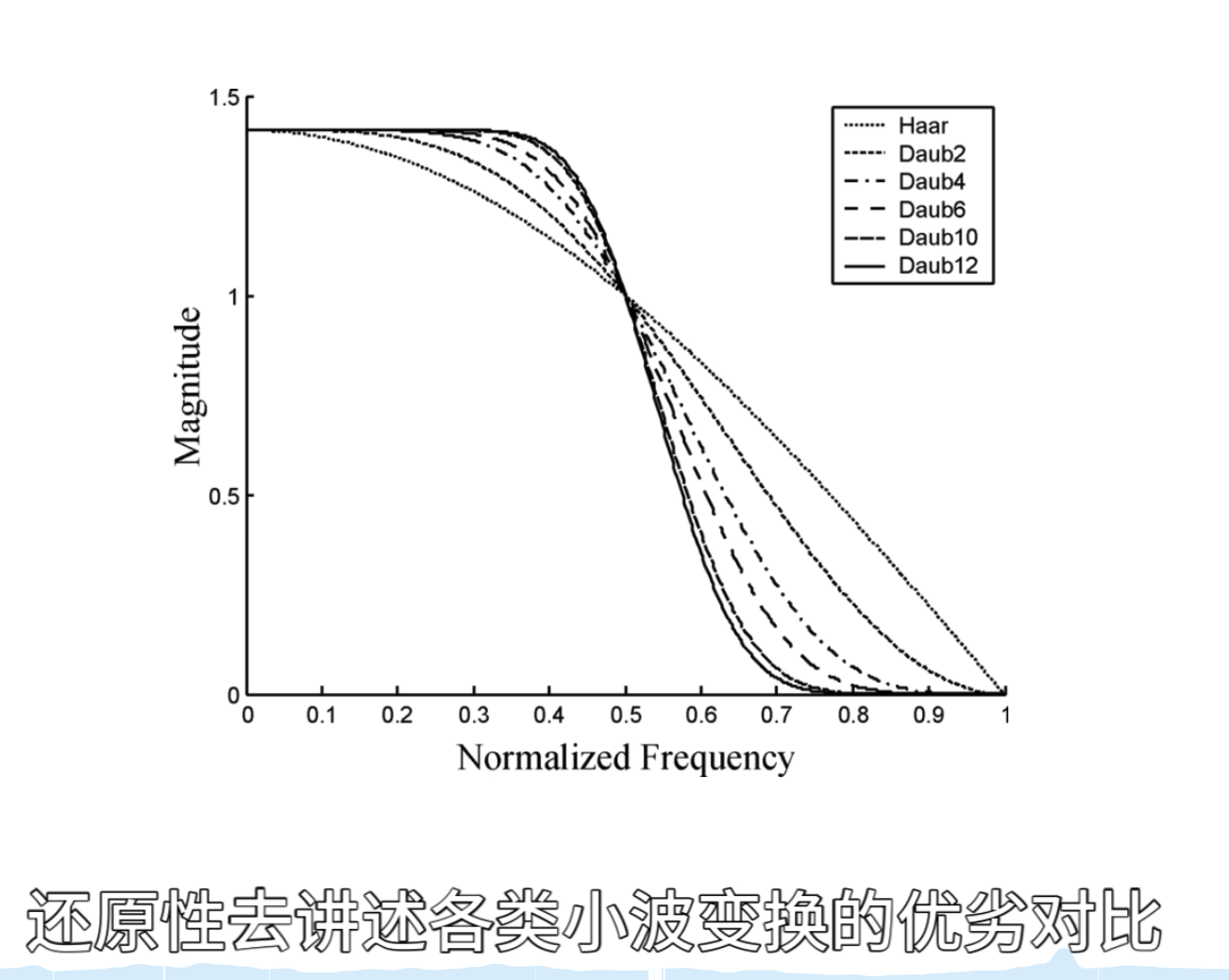

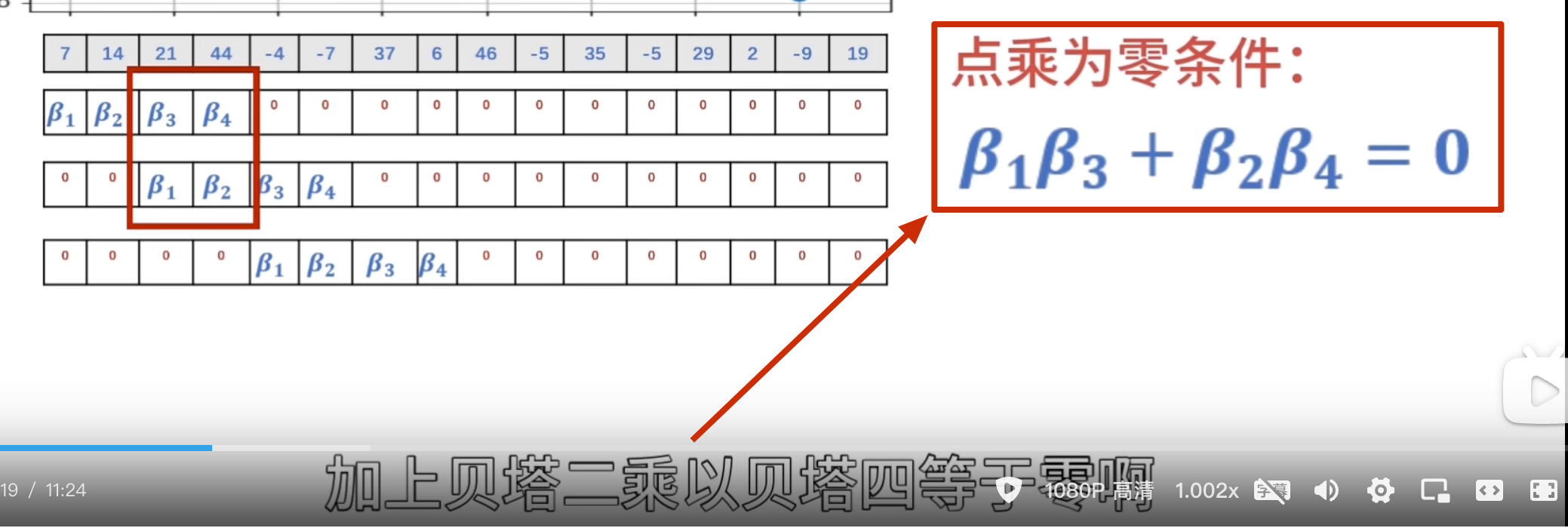

小波变换

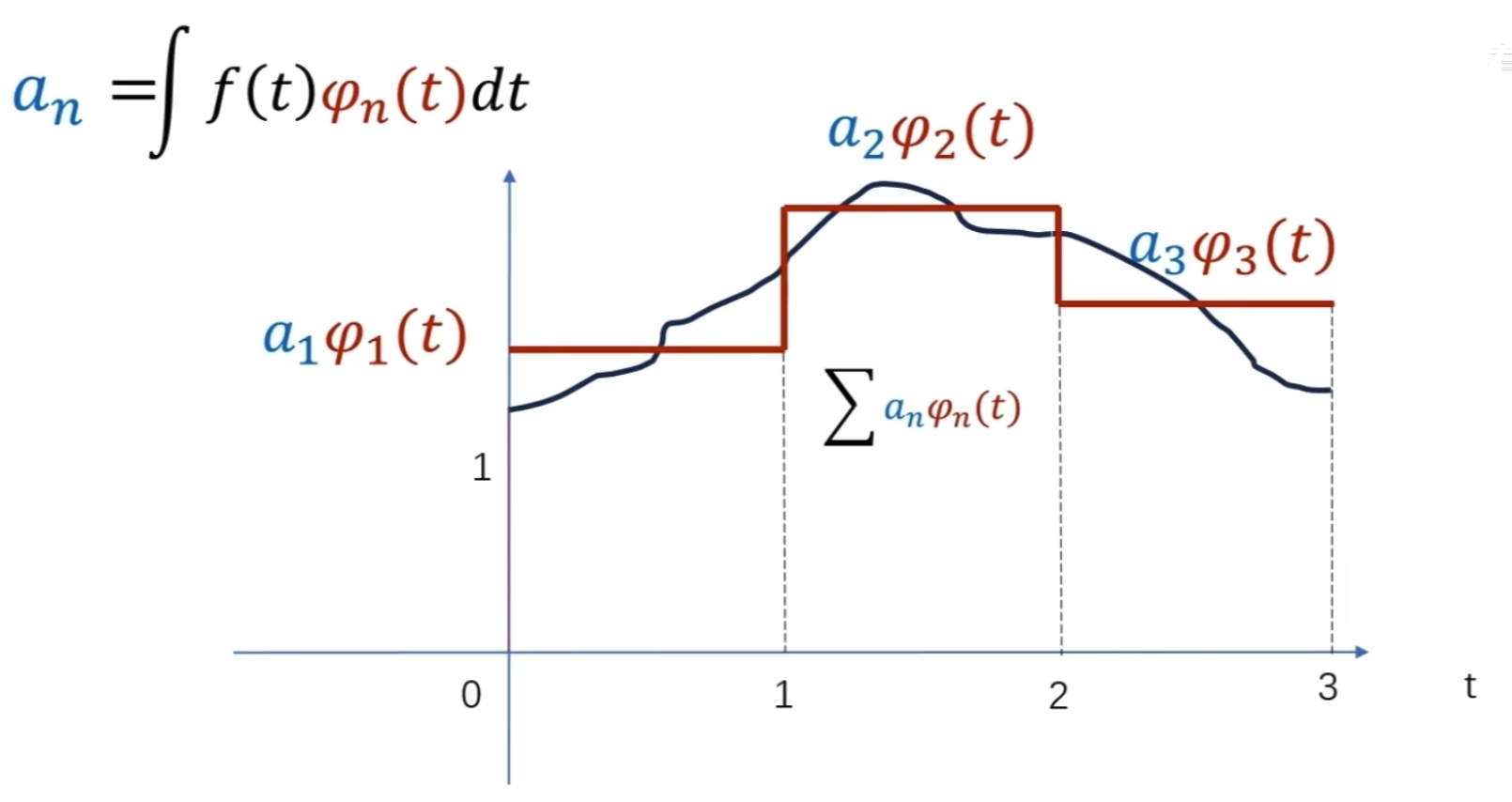

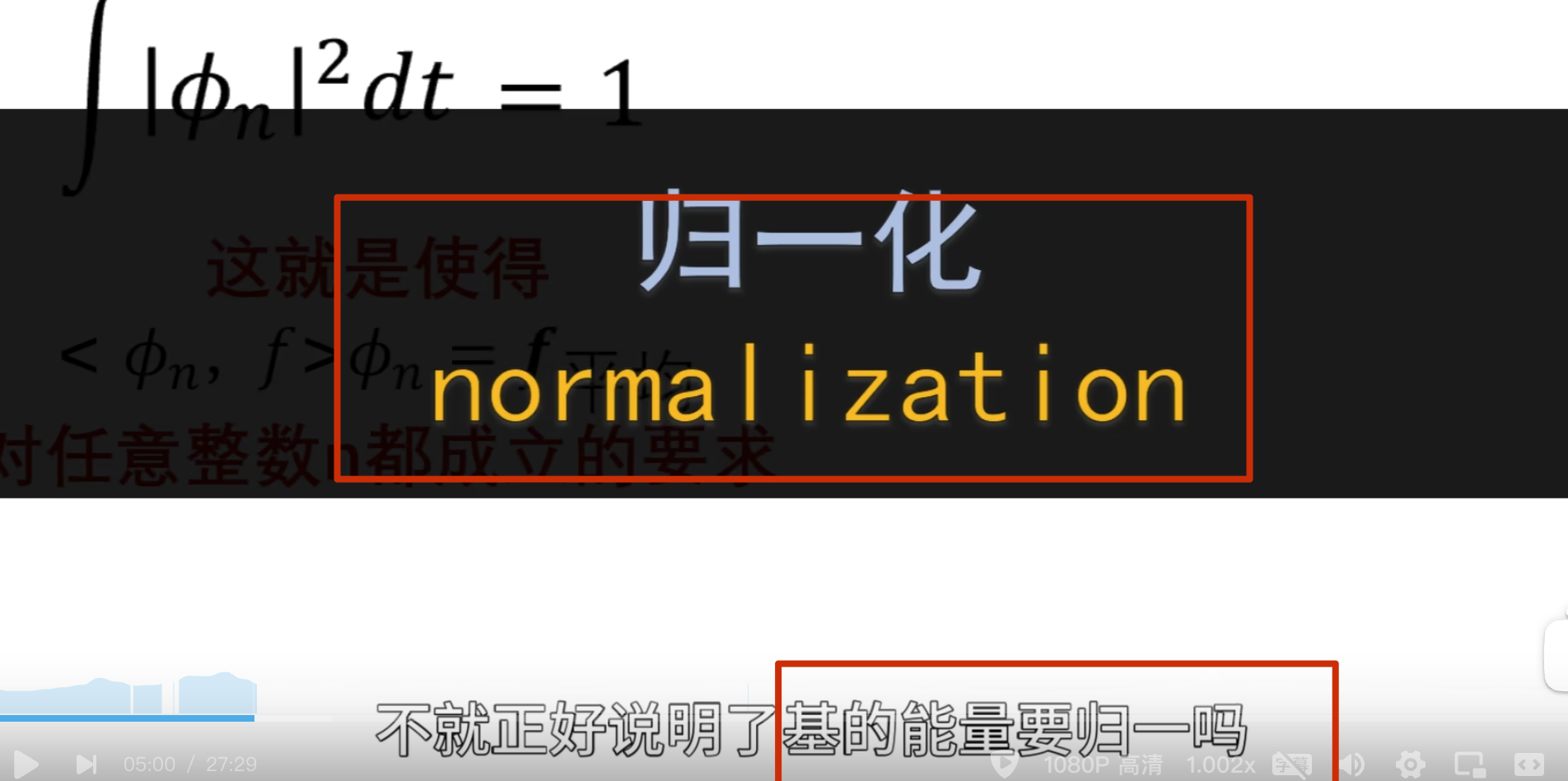

小波变换的原理

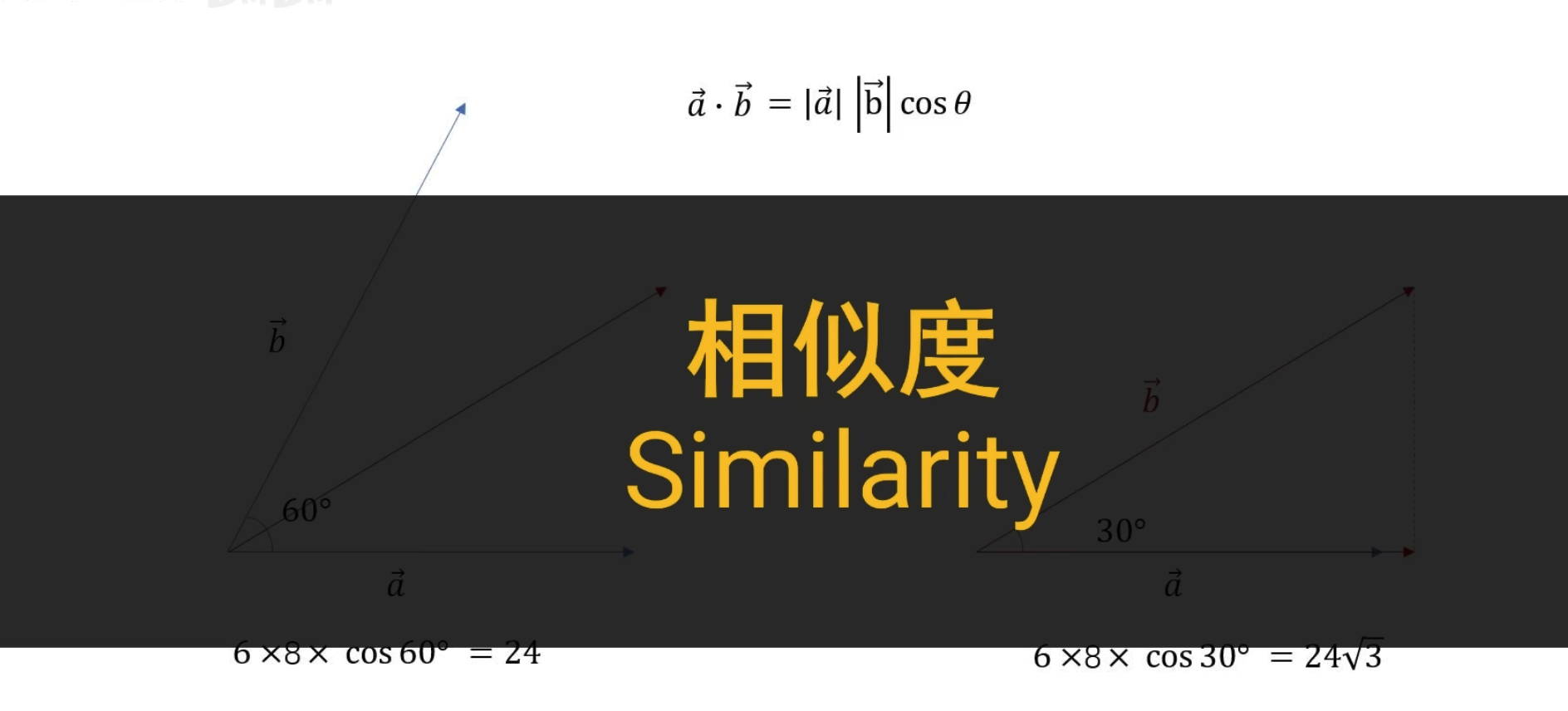

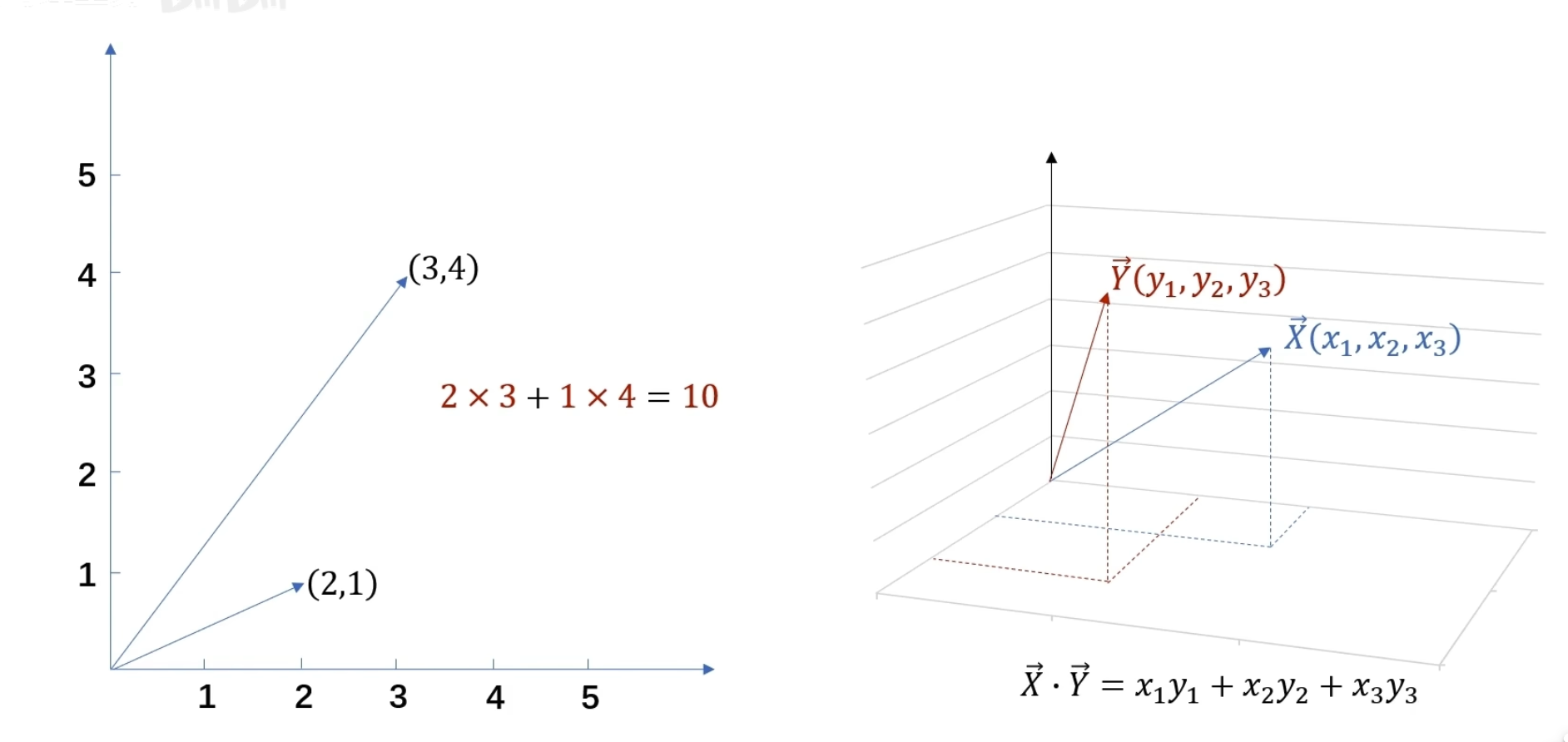

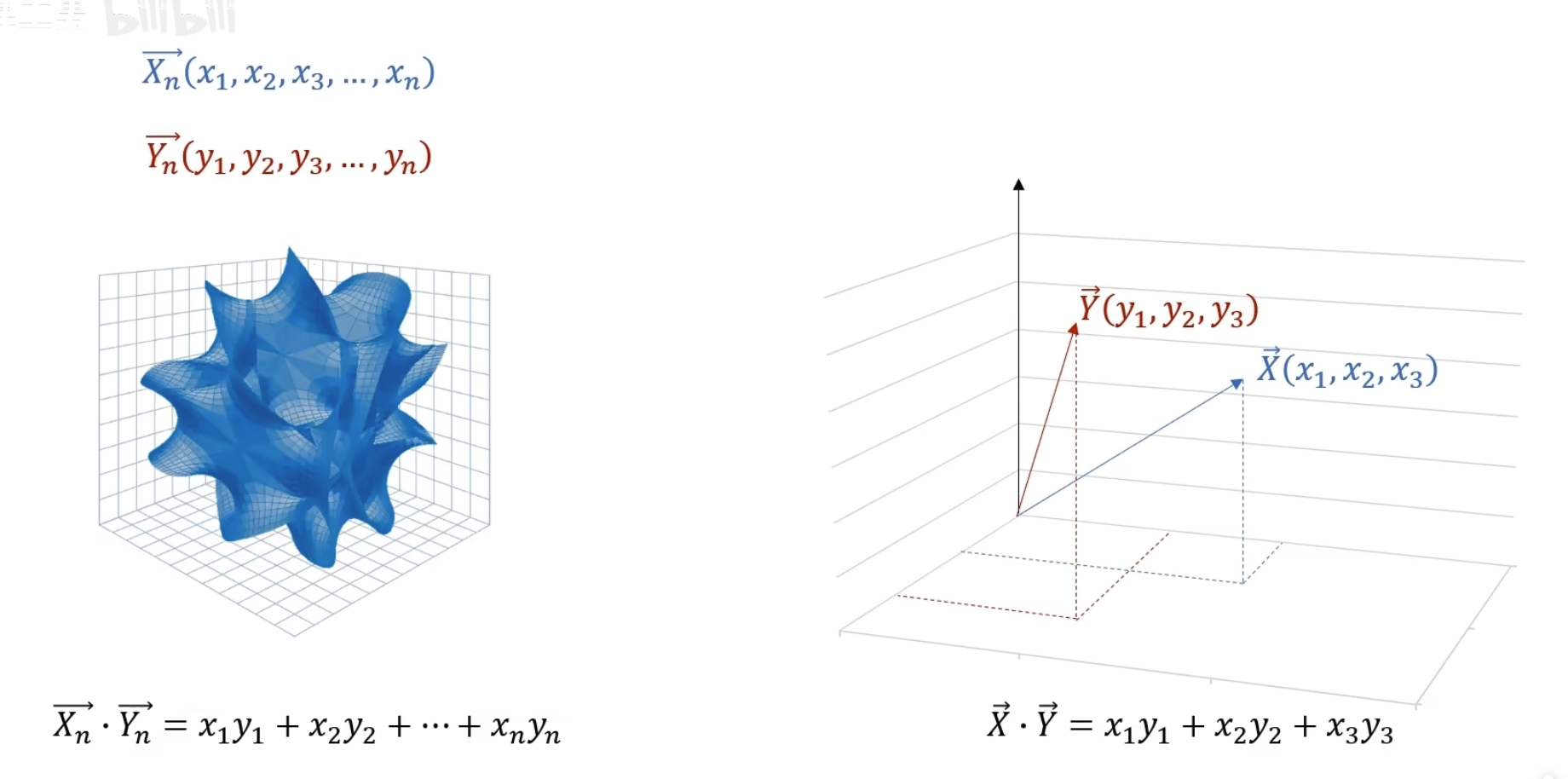

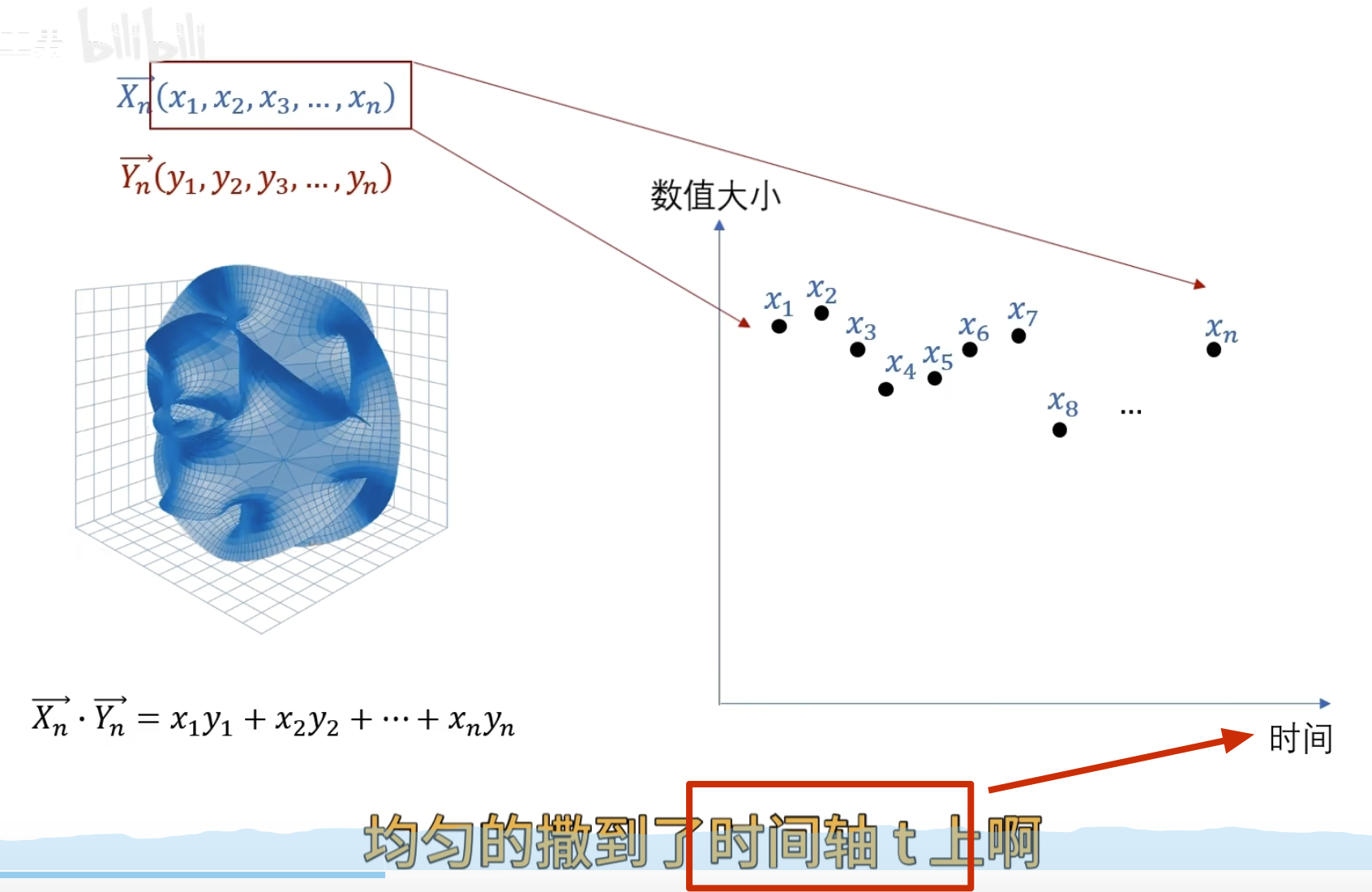

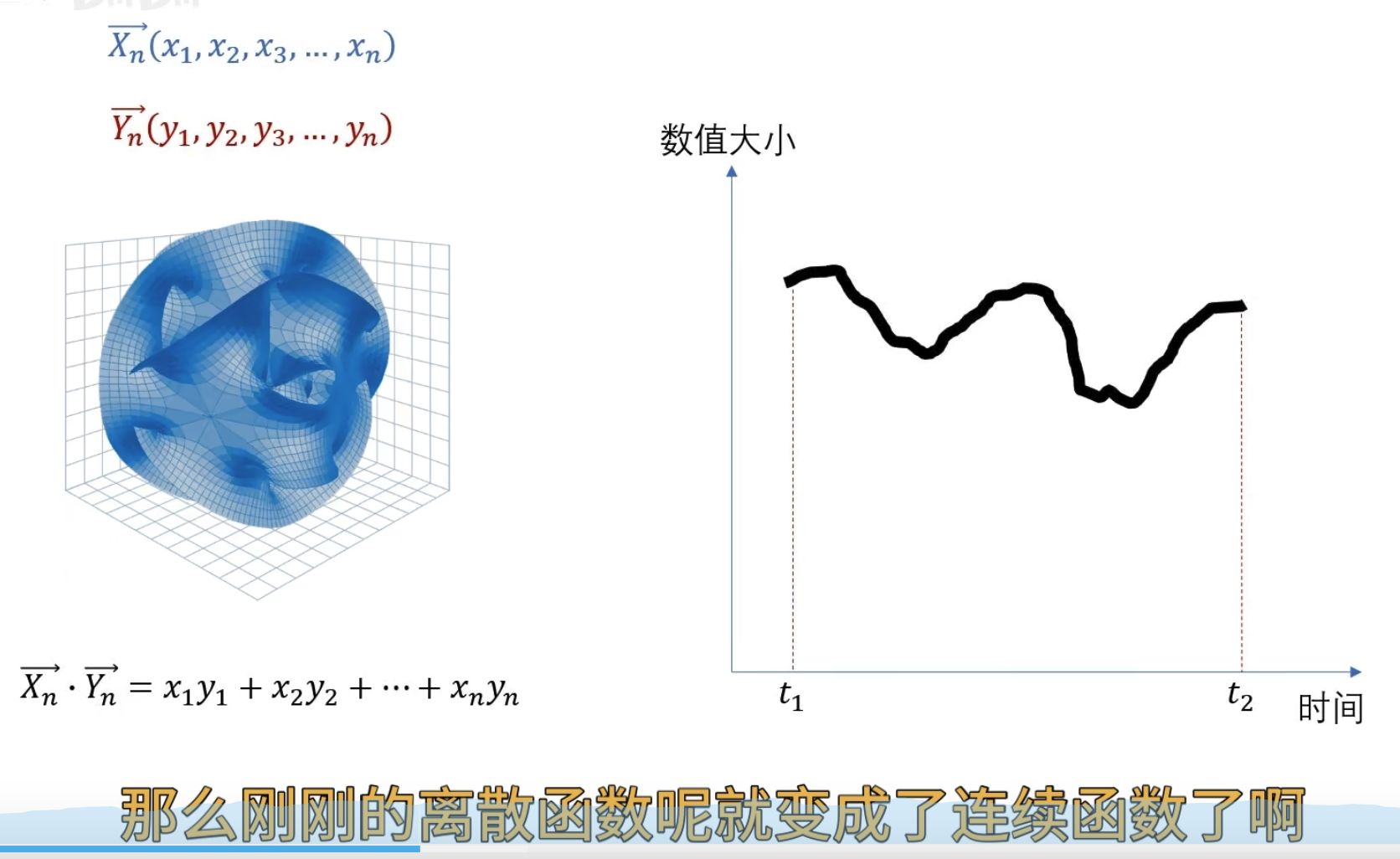

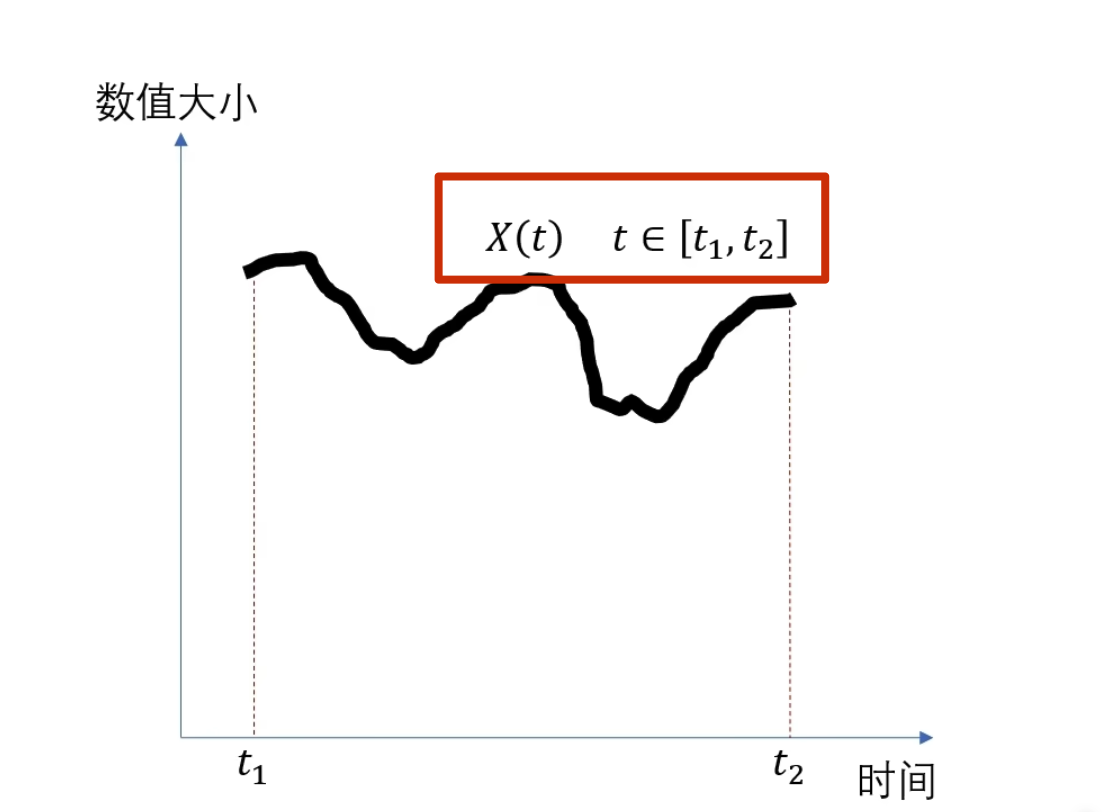

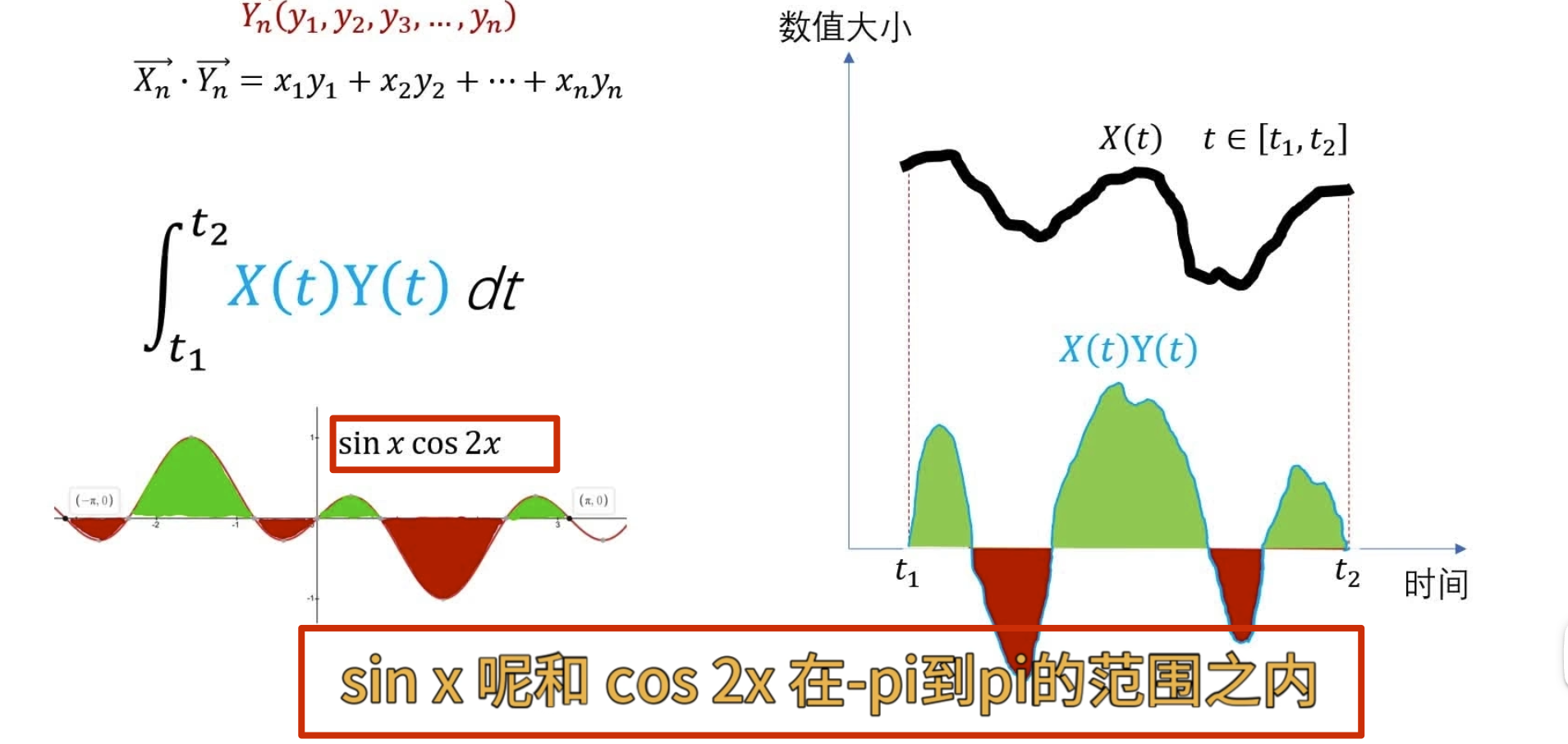

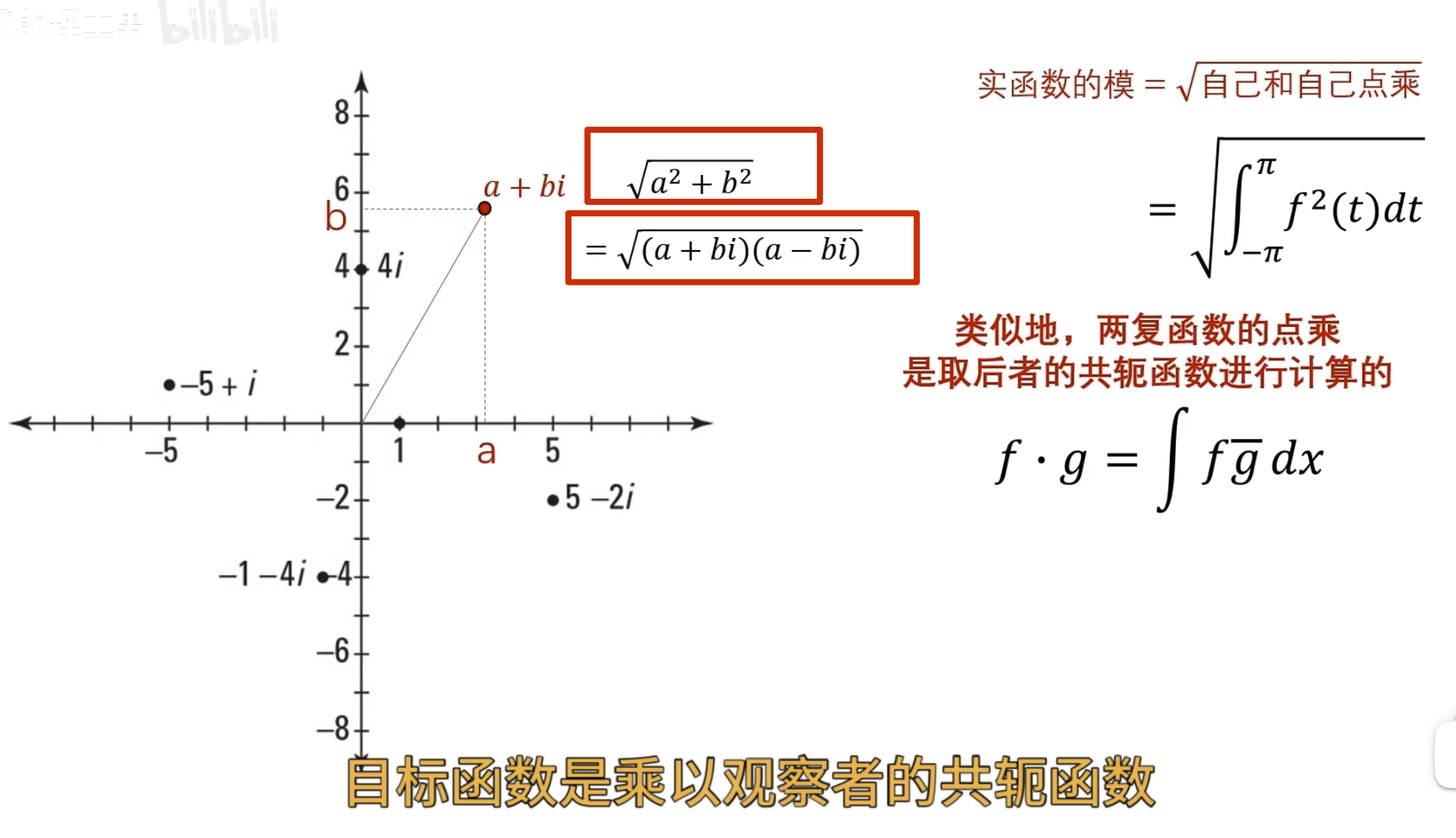

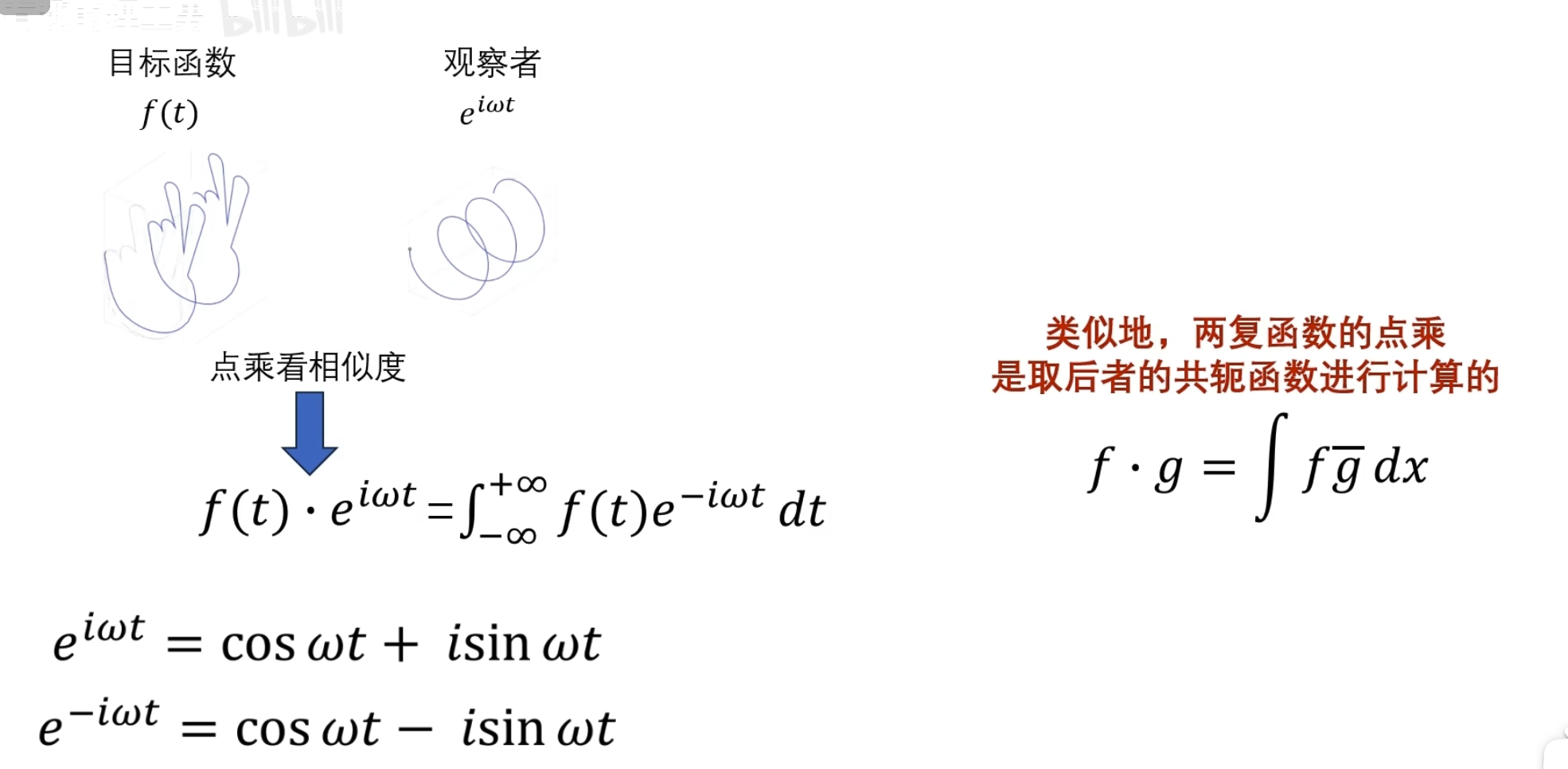

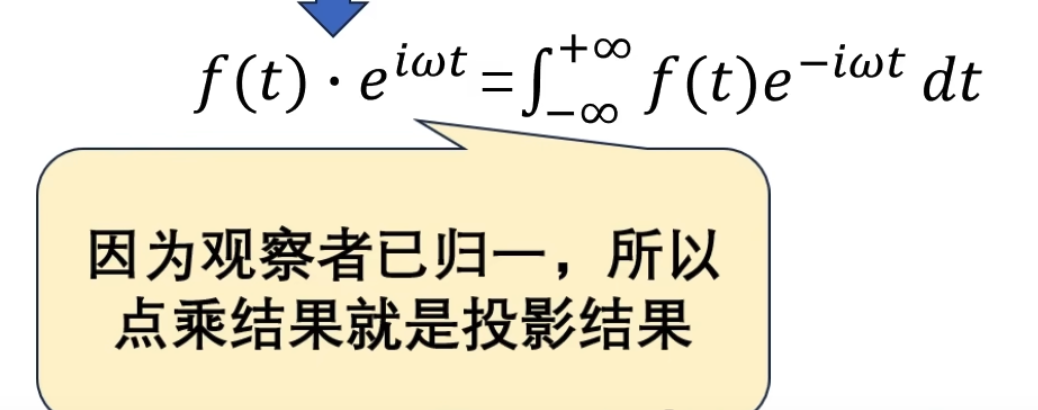

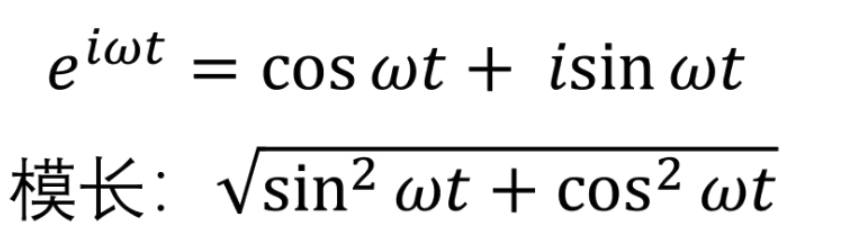

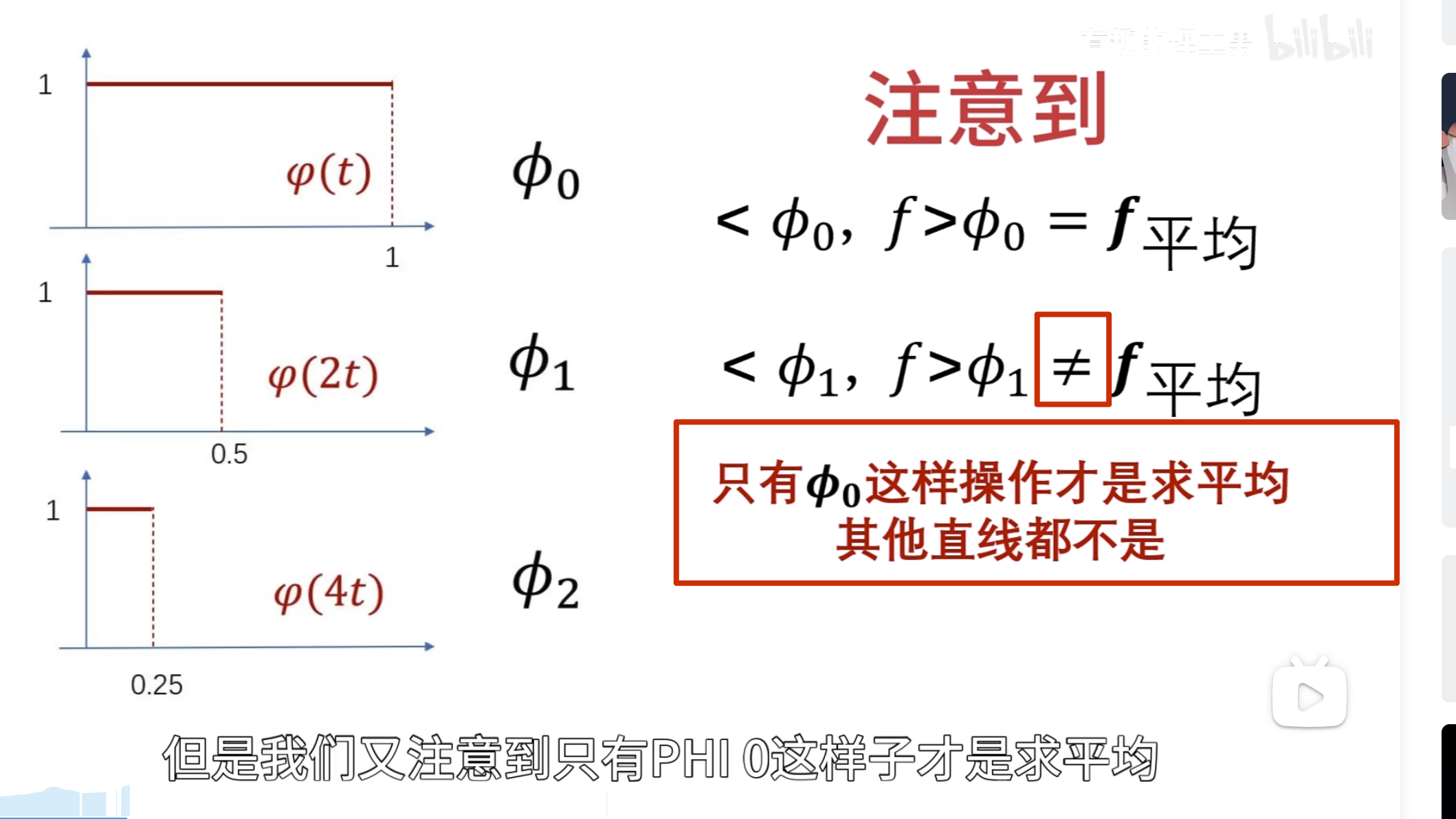

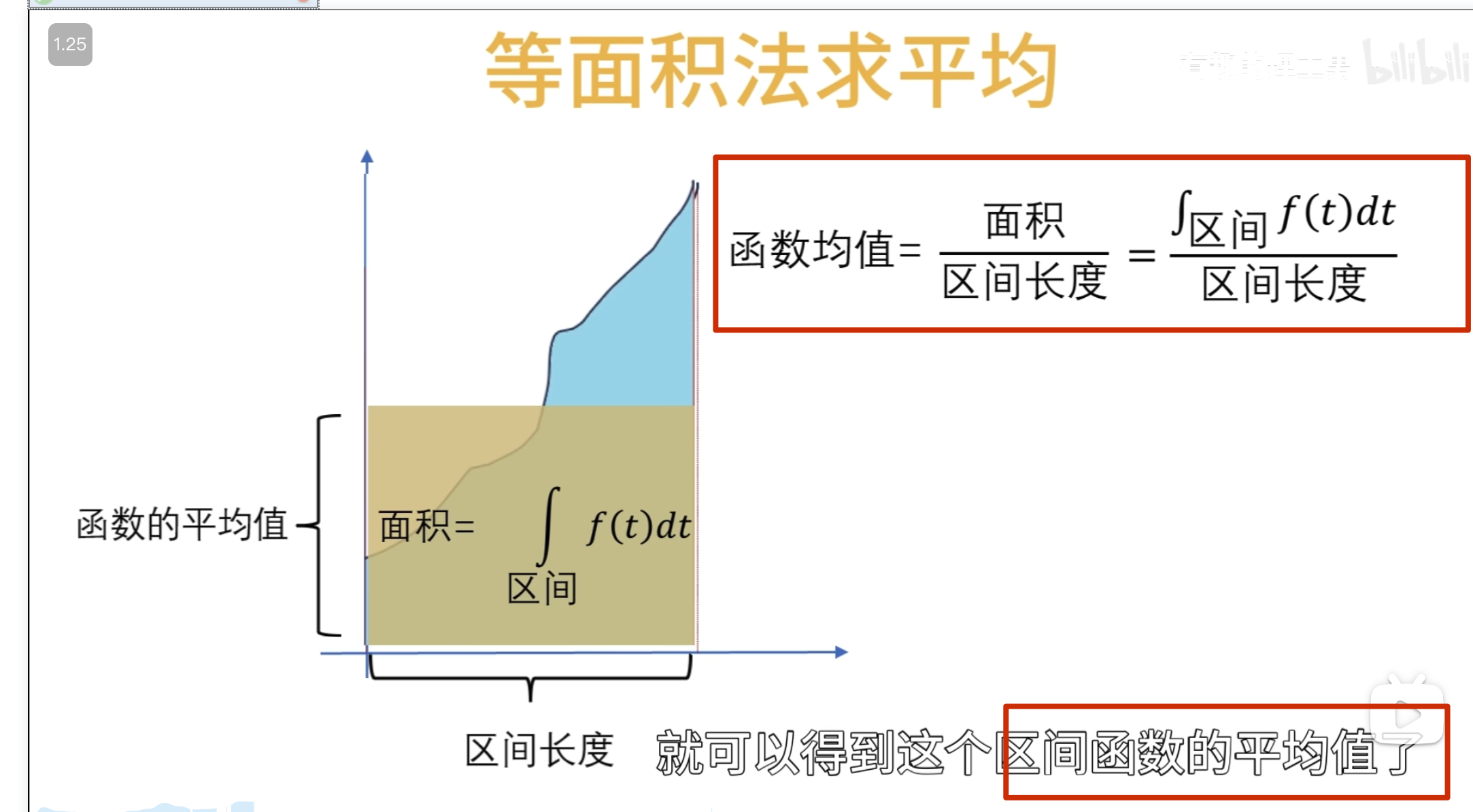

先介绍相似度

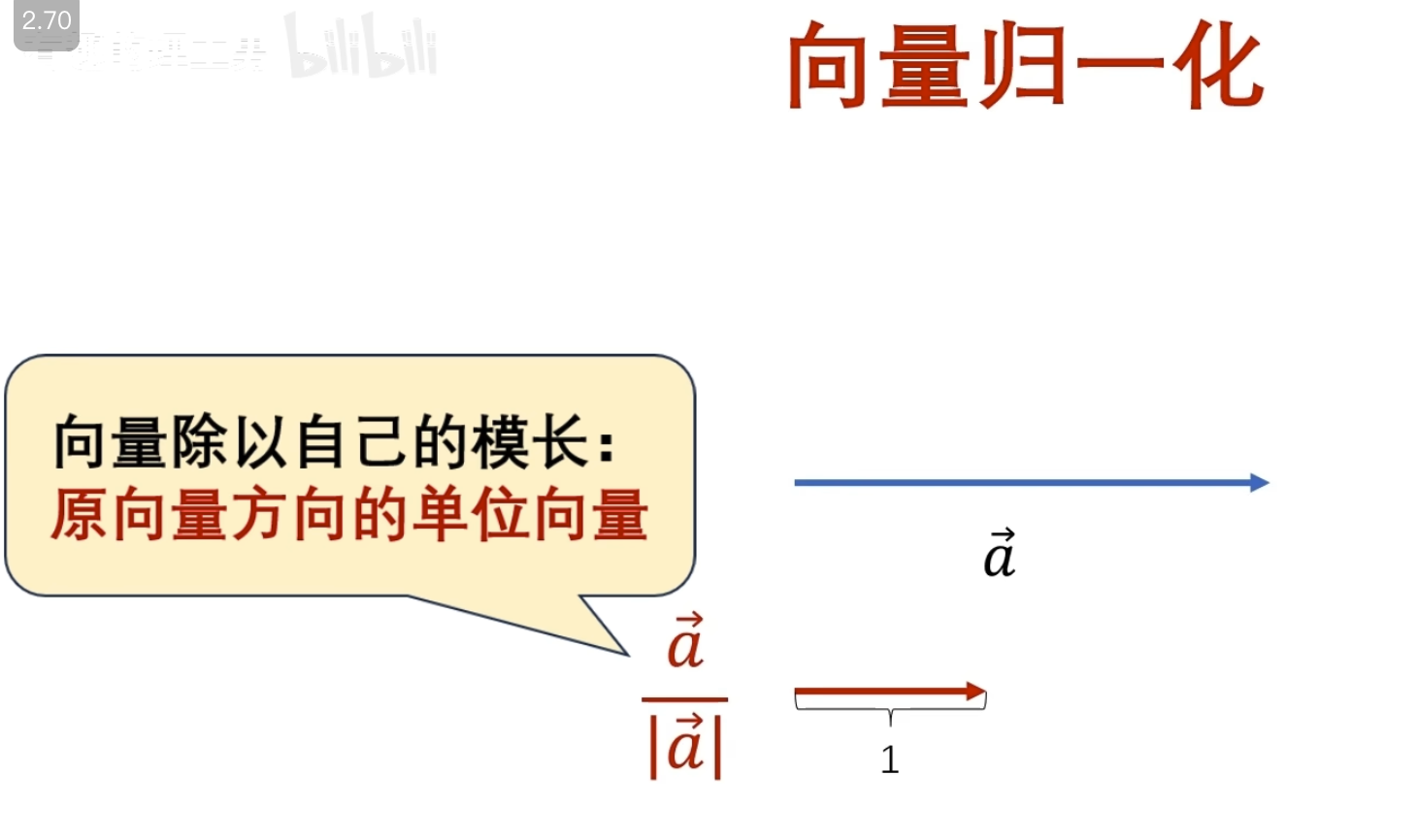

归一化的作用:

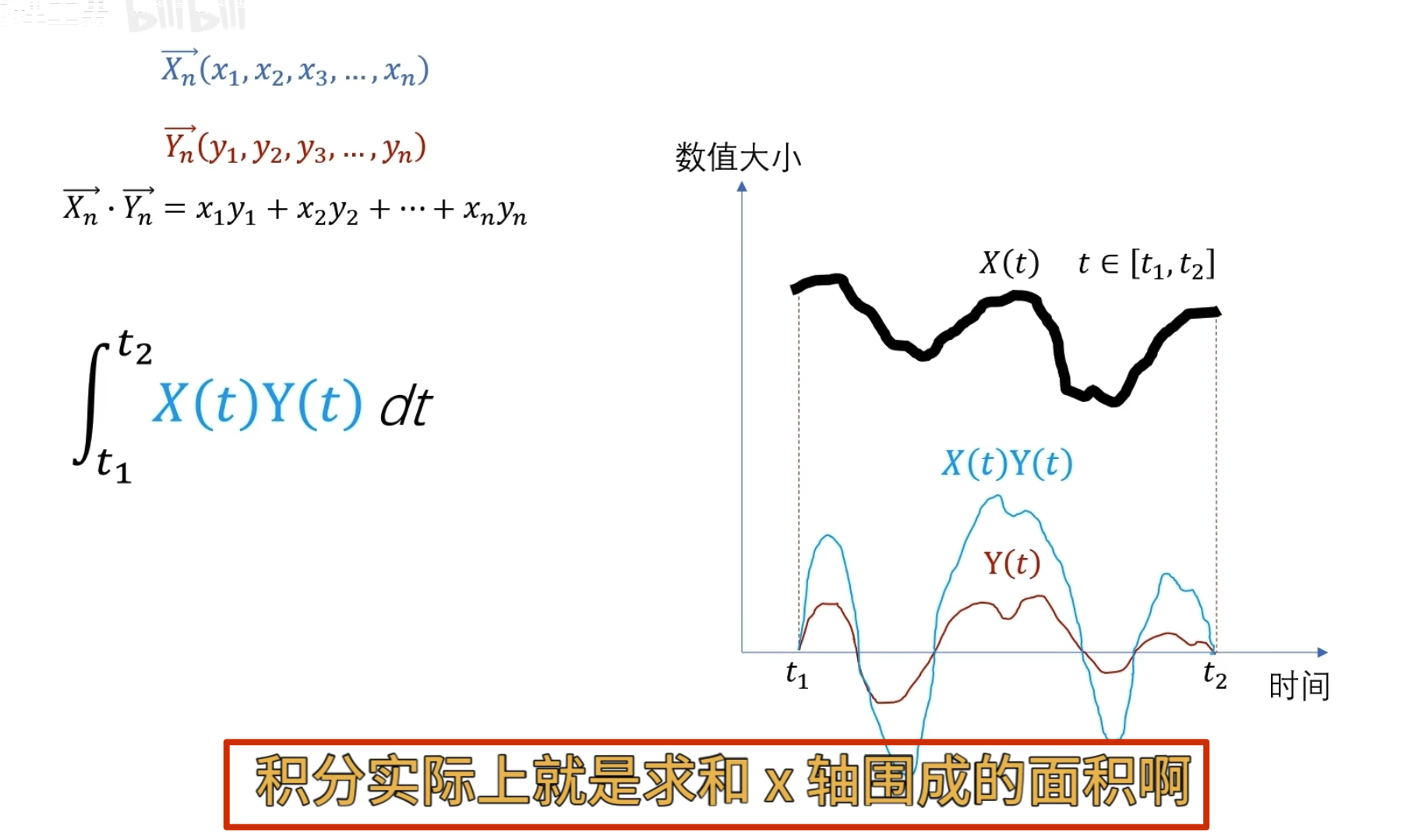

当 n 越来越大直到无穷的时候

当 n 越来越大直到无穷的时候

可以讲一个连续函数看成一个连续无穷维向量

求点乘

可以认为 sin x和 cos 2x 在-pi 到 pi 的范围内一点都不像(点乘为 0)

这就是两个连续函数点乘的定义

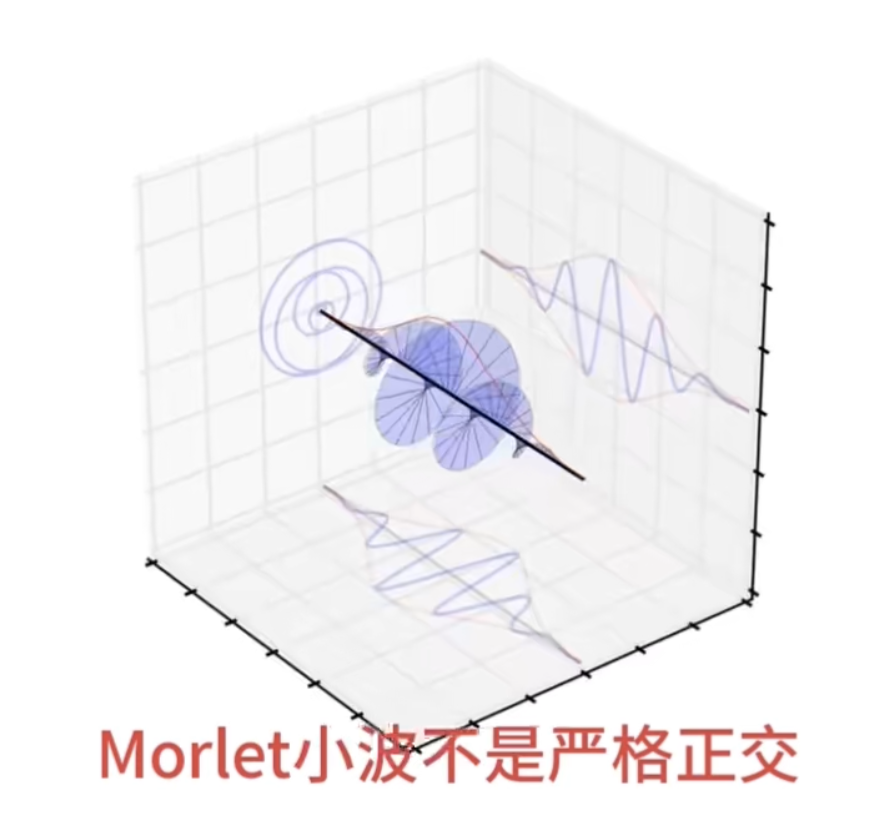

一、基

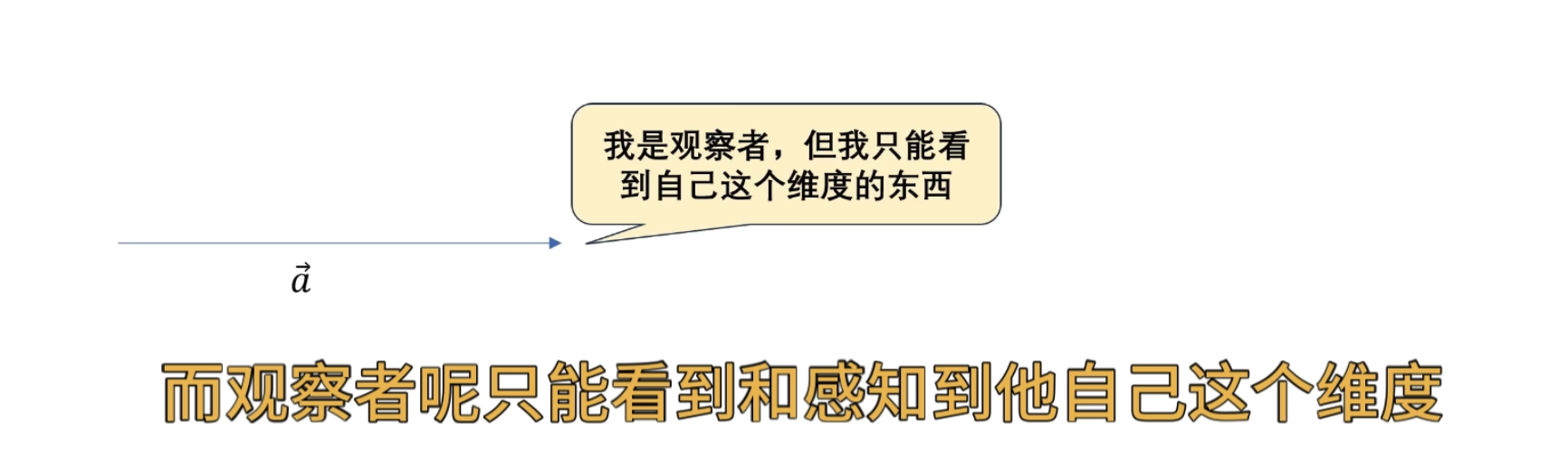

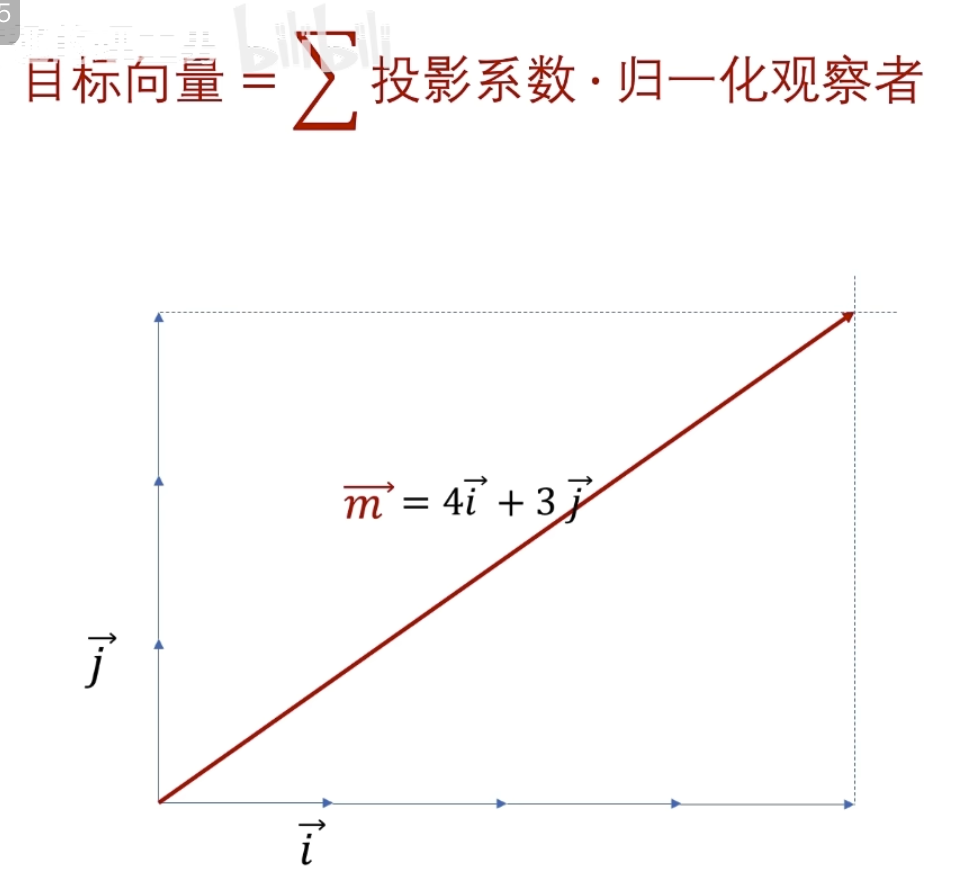

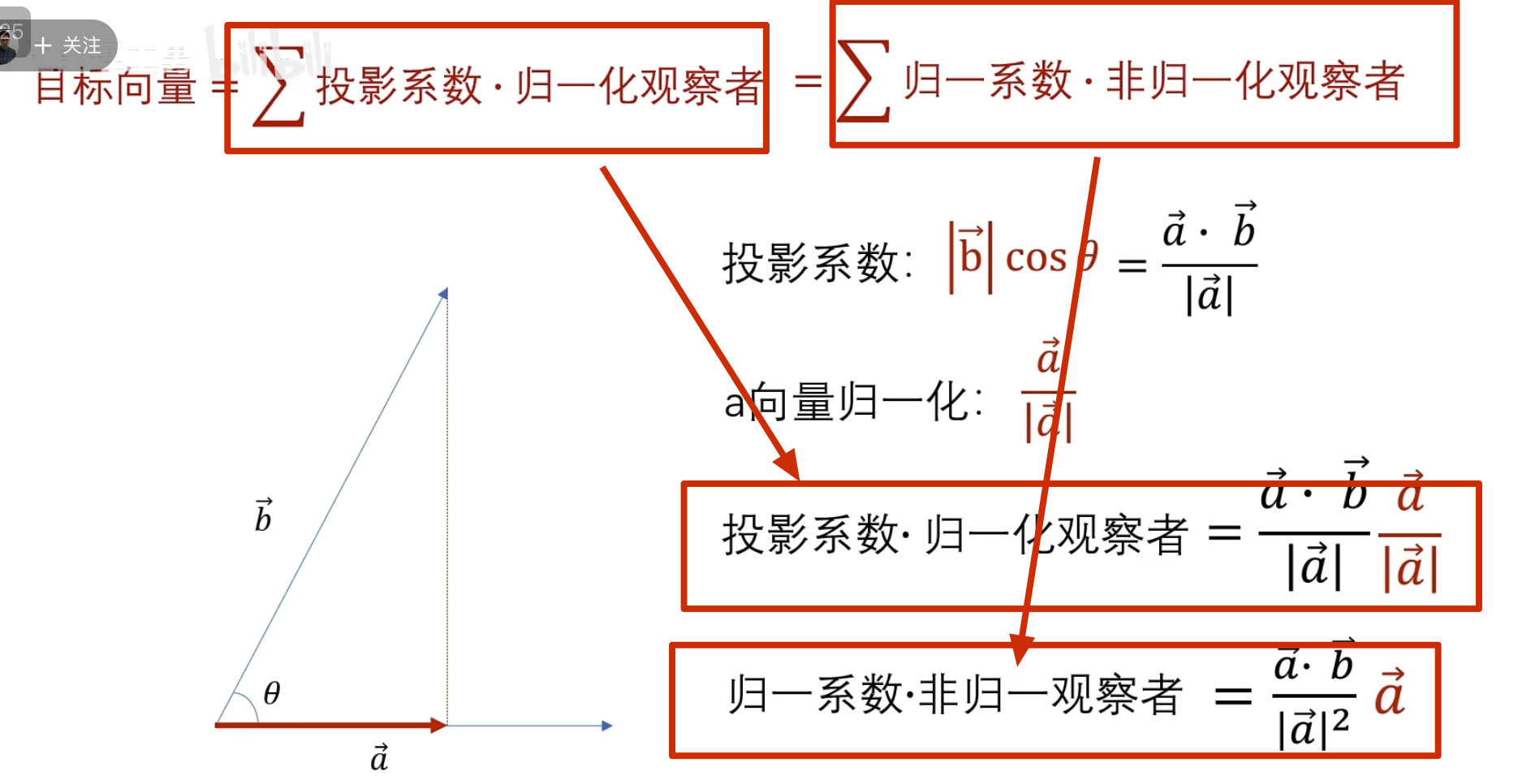

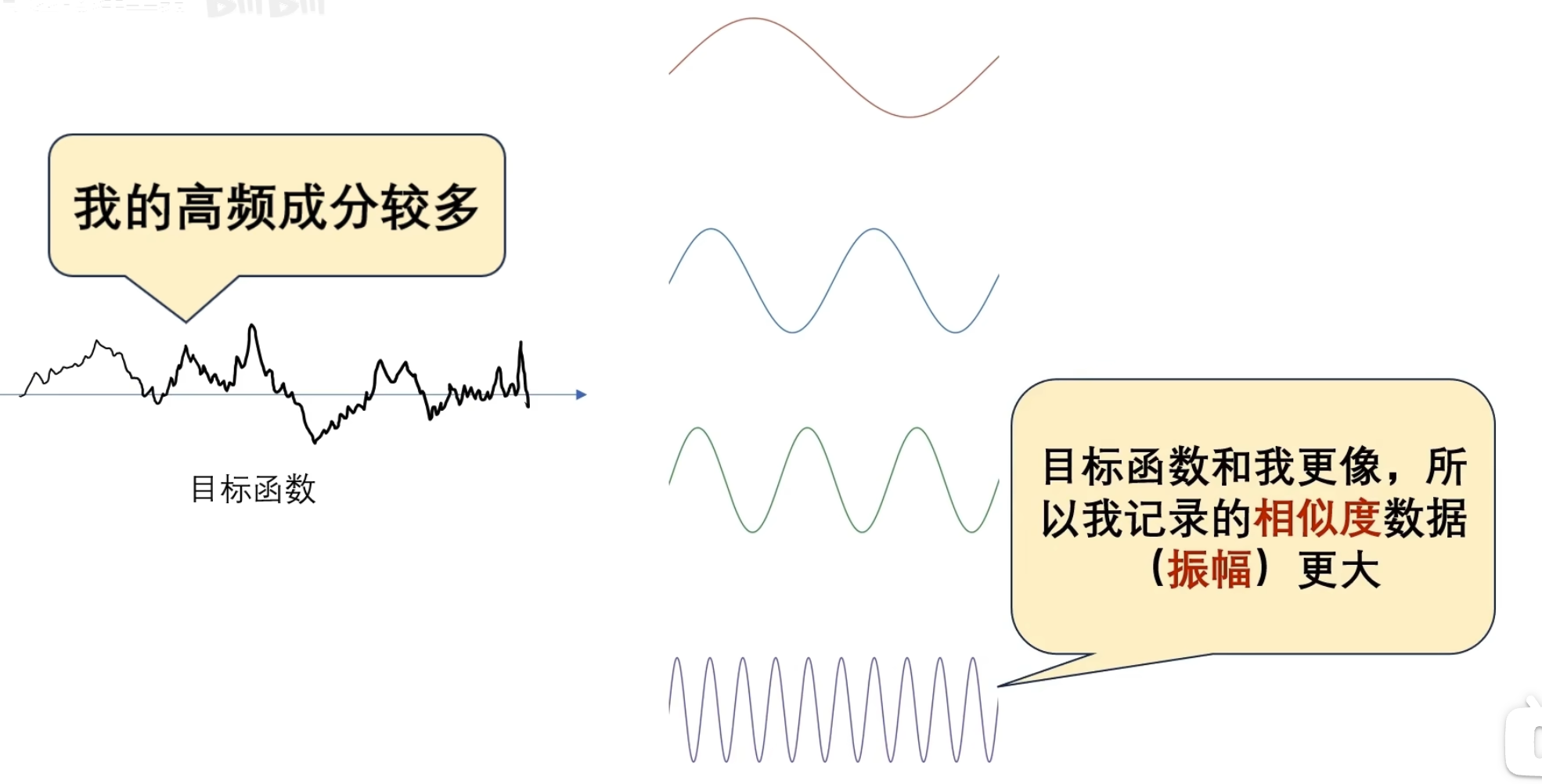

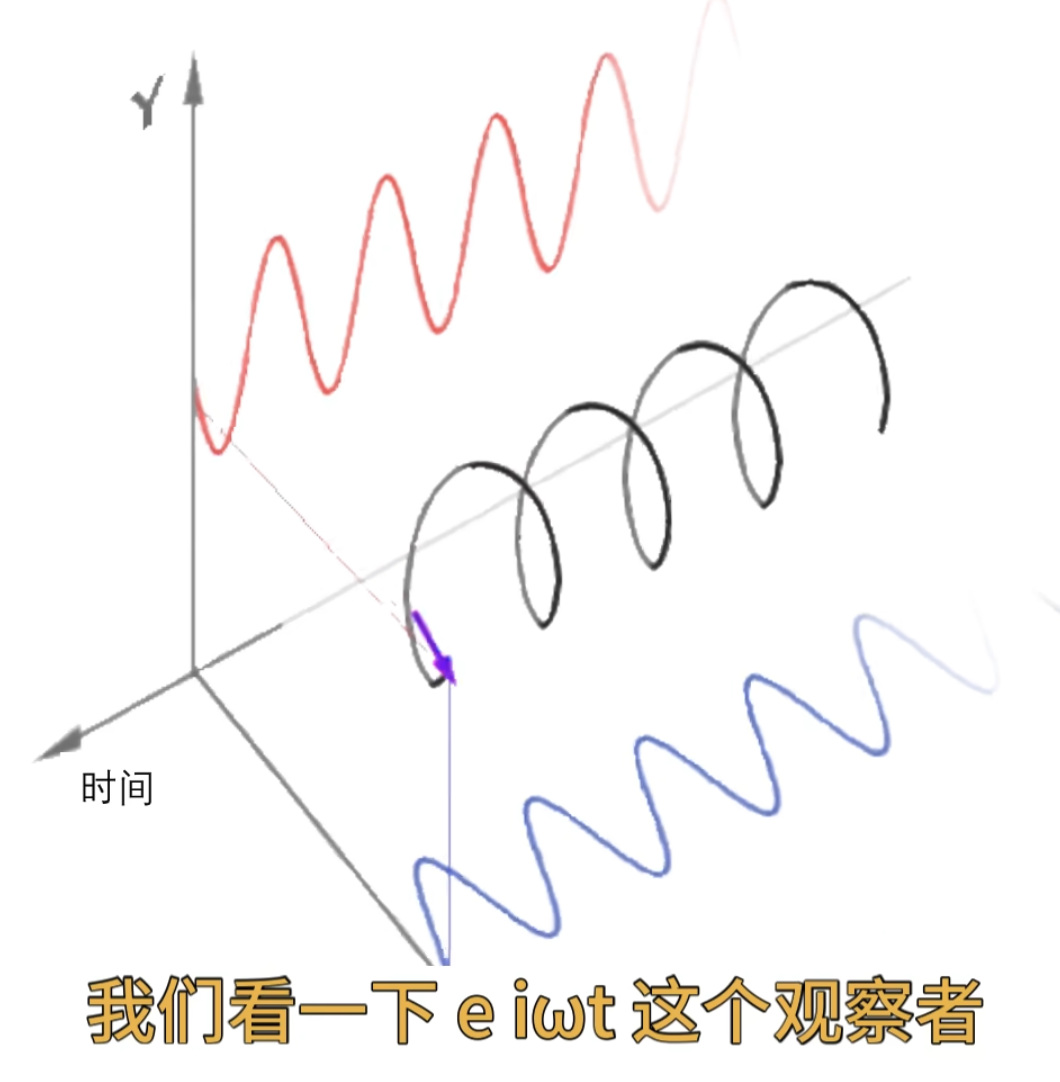

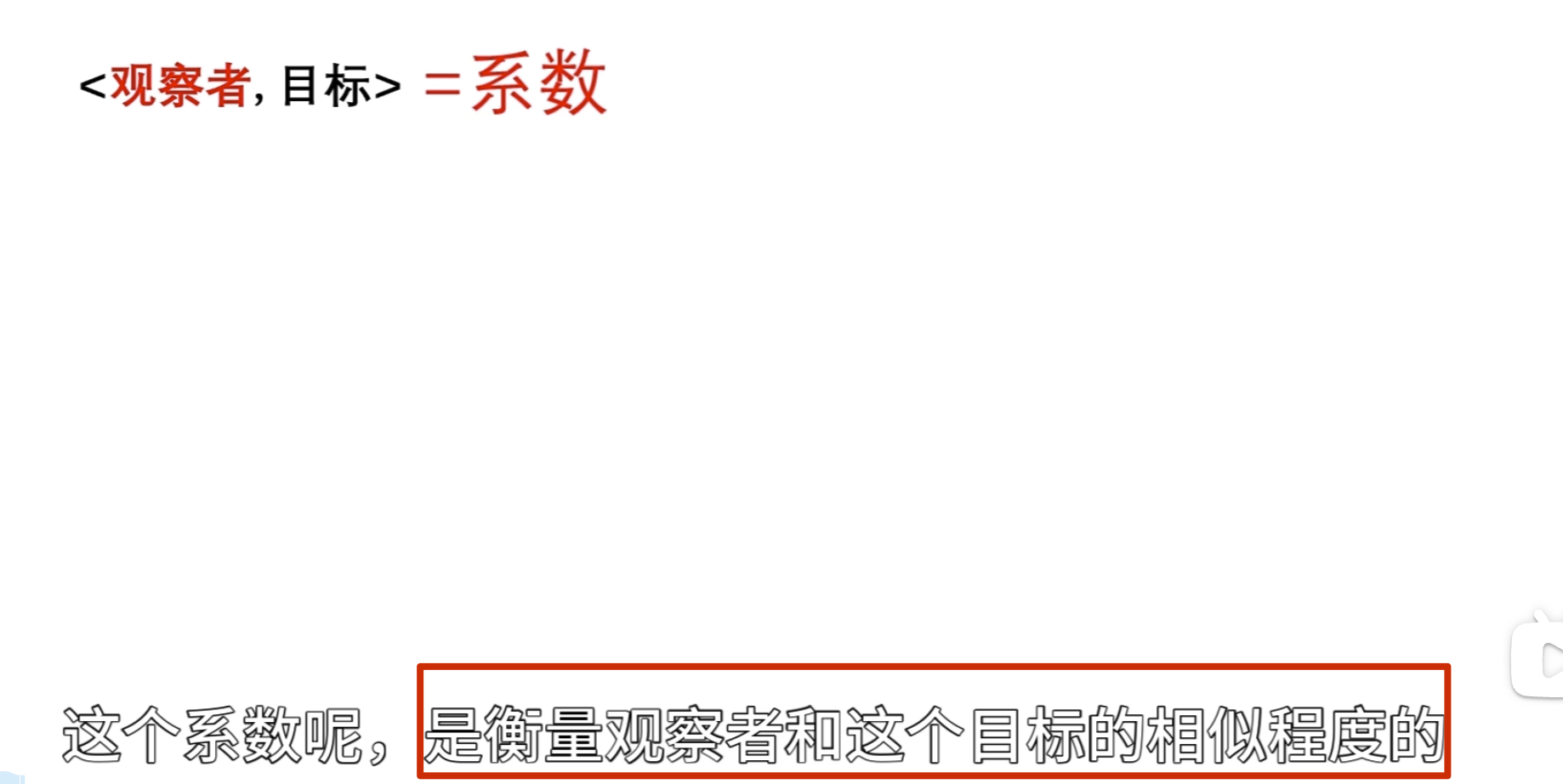

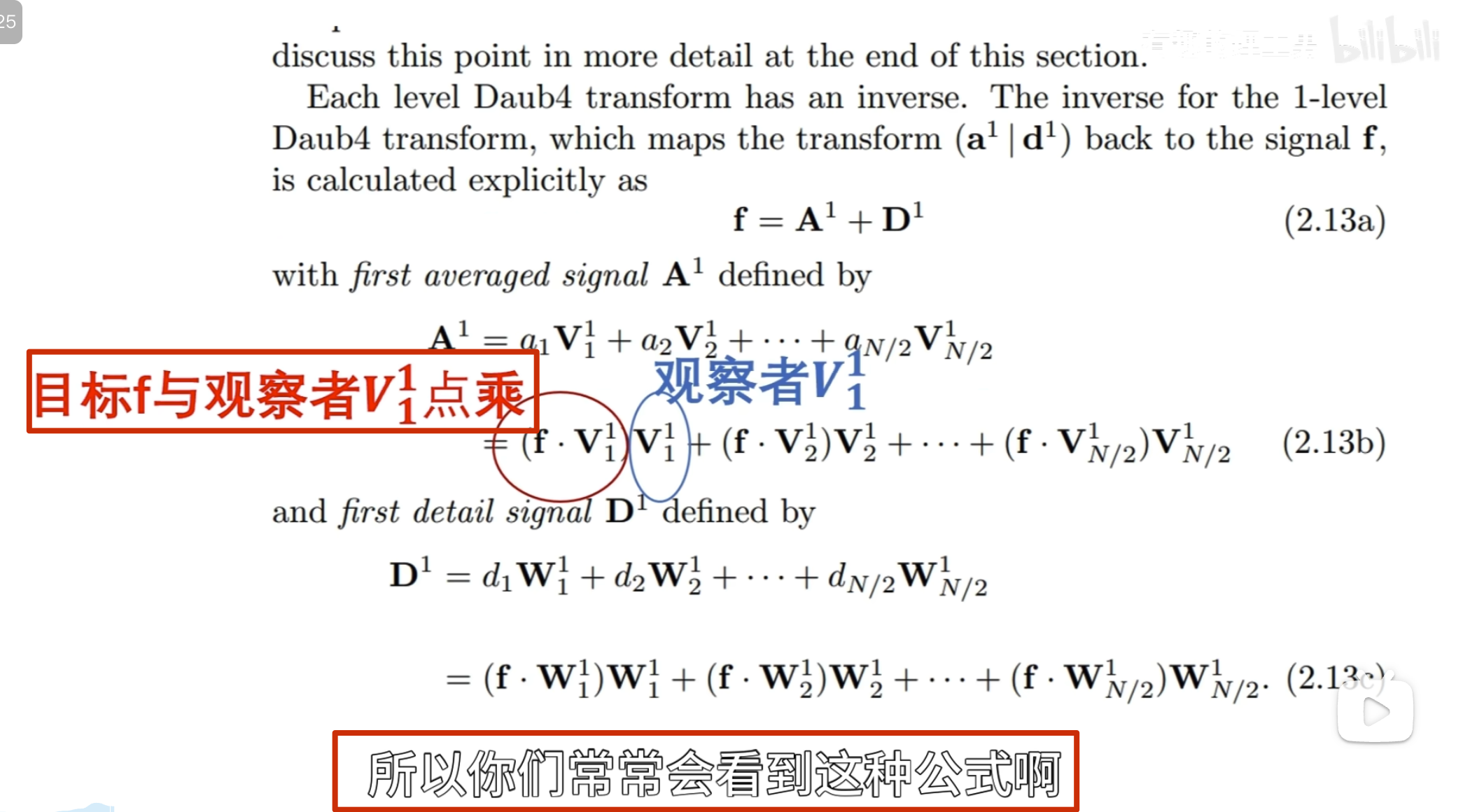

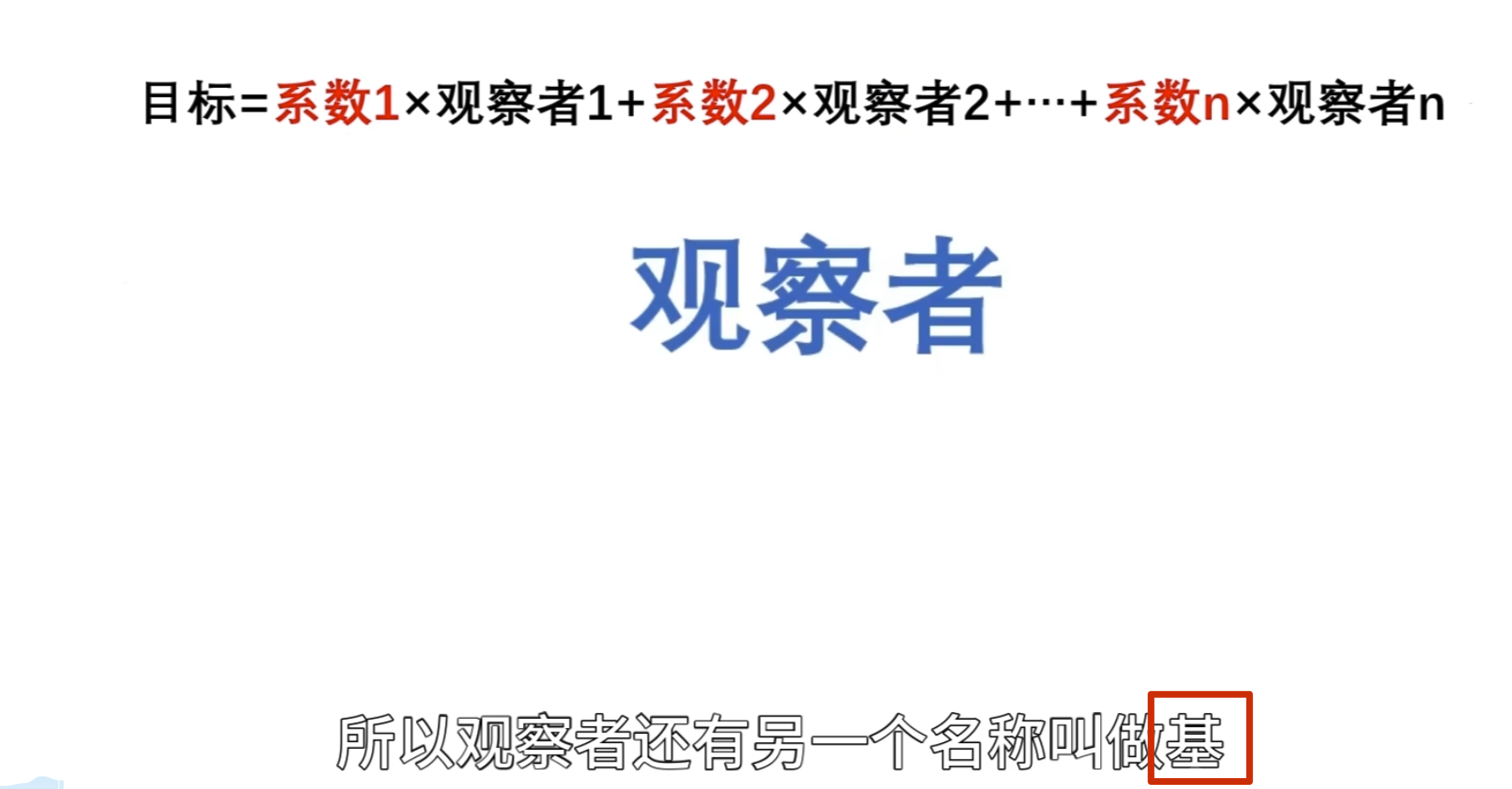

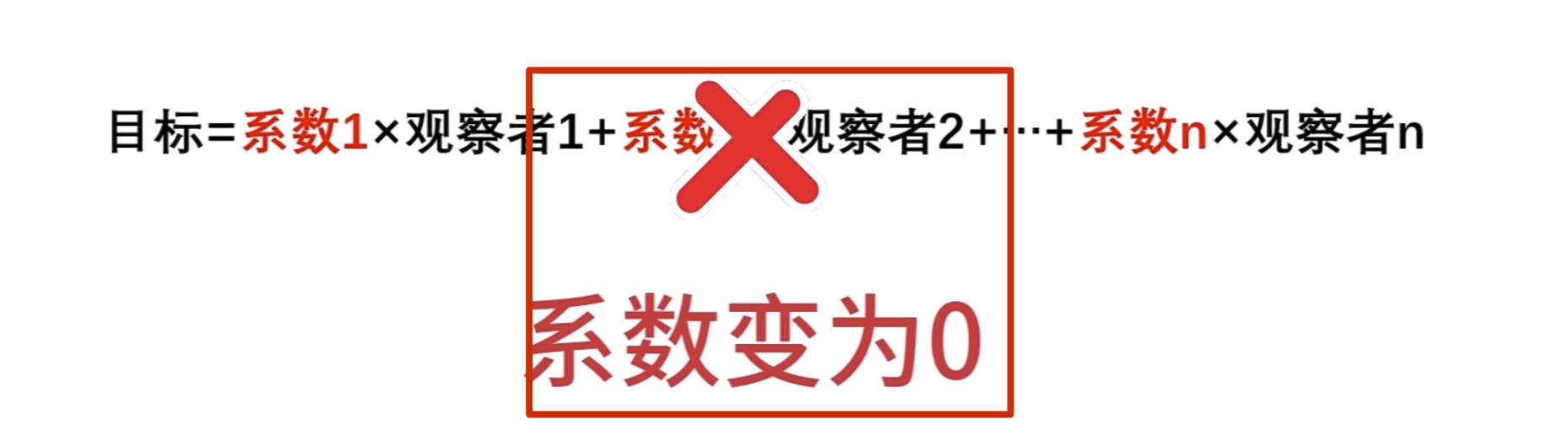

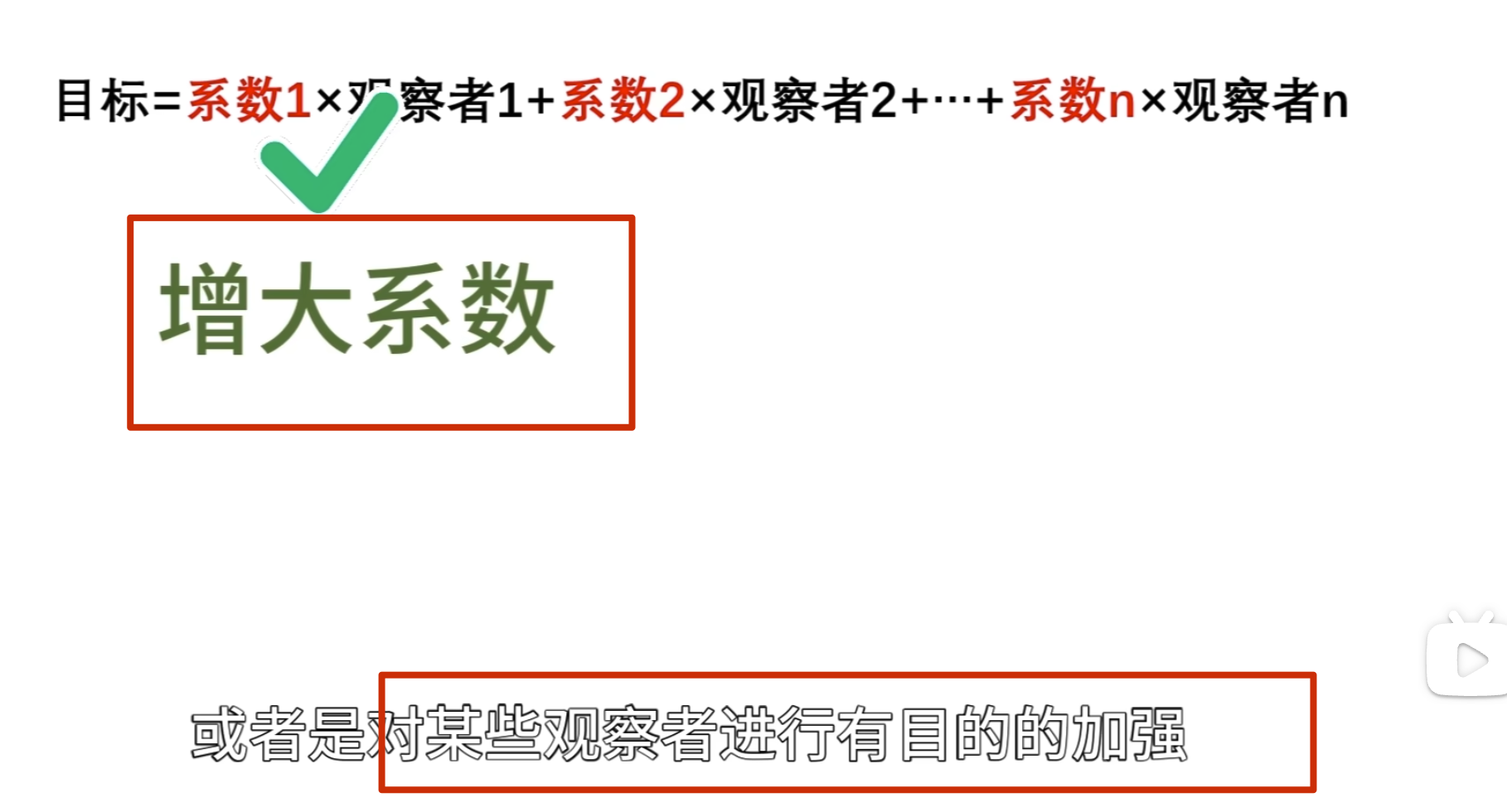

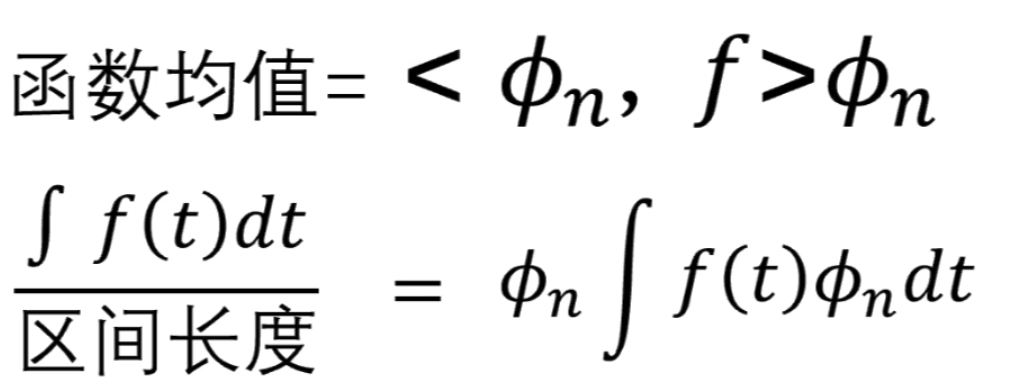

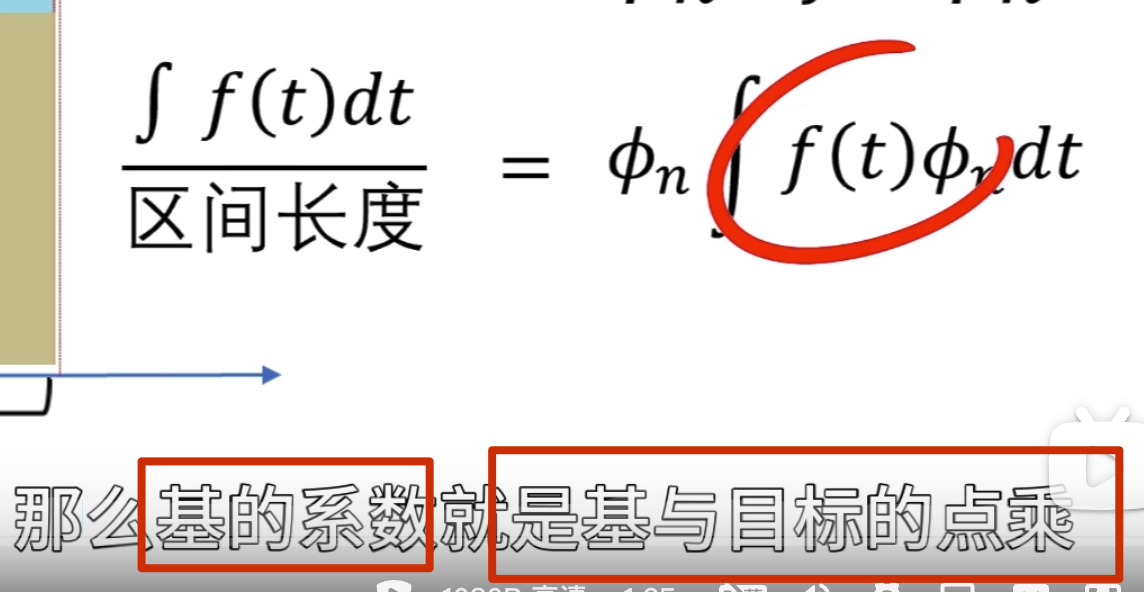

傅立叶变换和小波变换,都会听到分解和重构,其中这个就是根本,因为他们的变化都是将信号看成由若干个东西组成的,而且这些东西能够处理还原成比原来更好的信号。那怎么分解呢?那就需要一个分解的量,也就是常说的基,基的了解可以类比向量,向量空间的一个向量可以分解在x,y方向,同时在各个方向定义单位向量e1、e2,这样任意一个向量都可以表示为a=xe1+ye2,这个是二维空间的基,

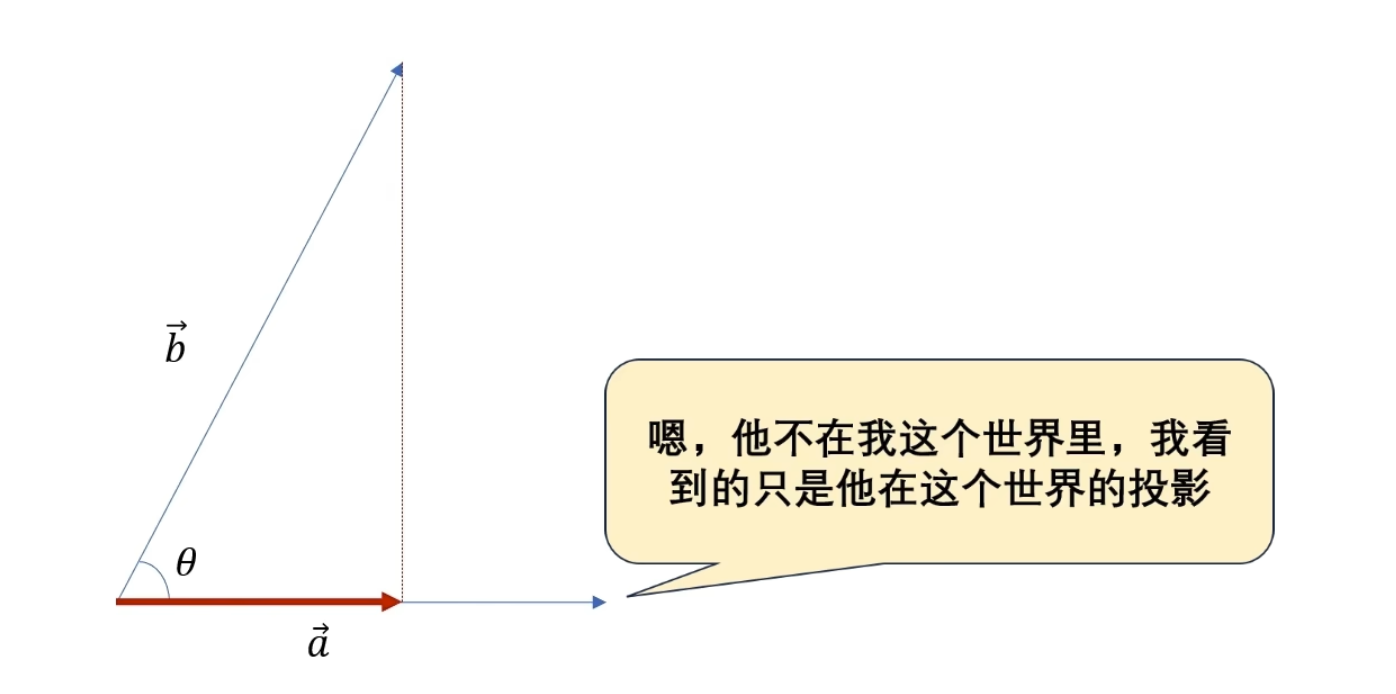

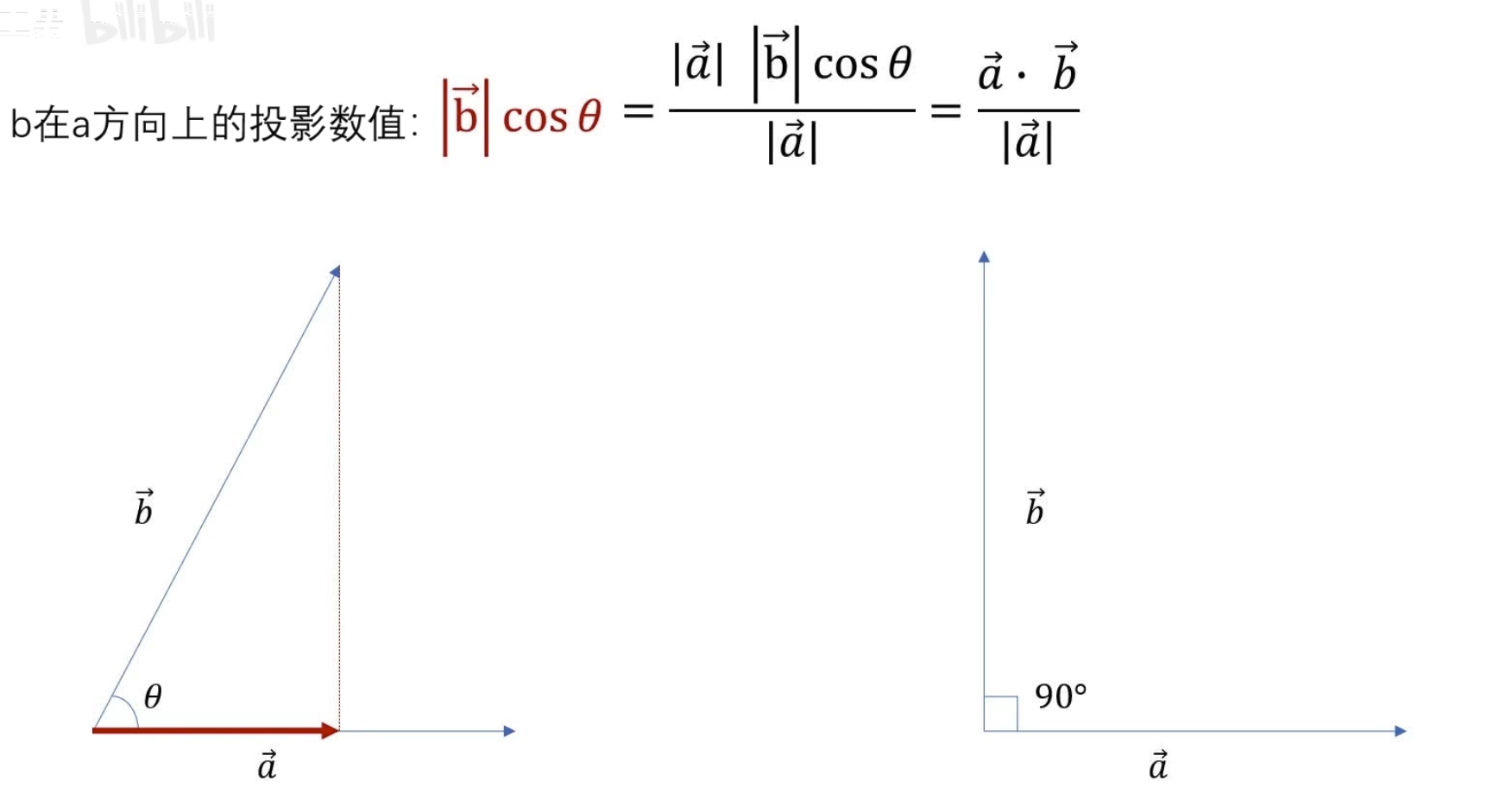

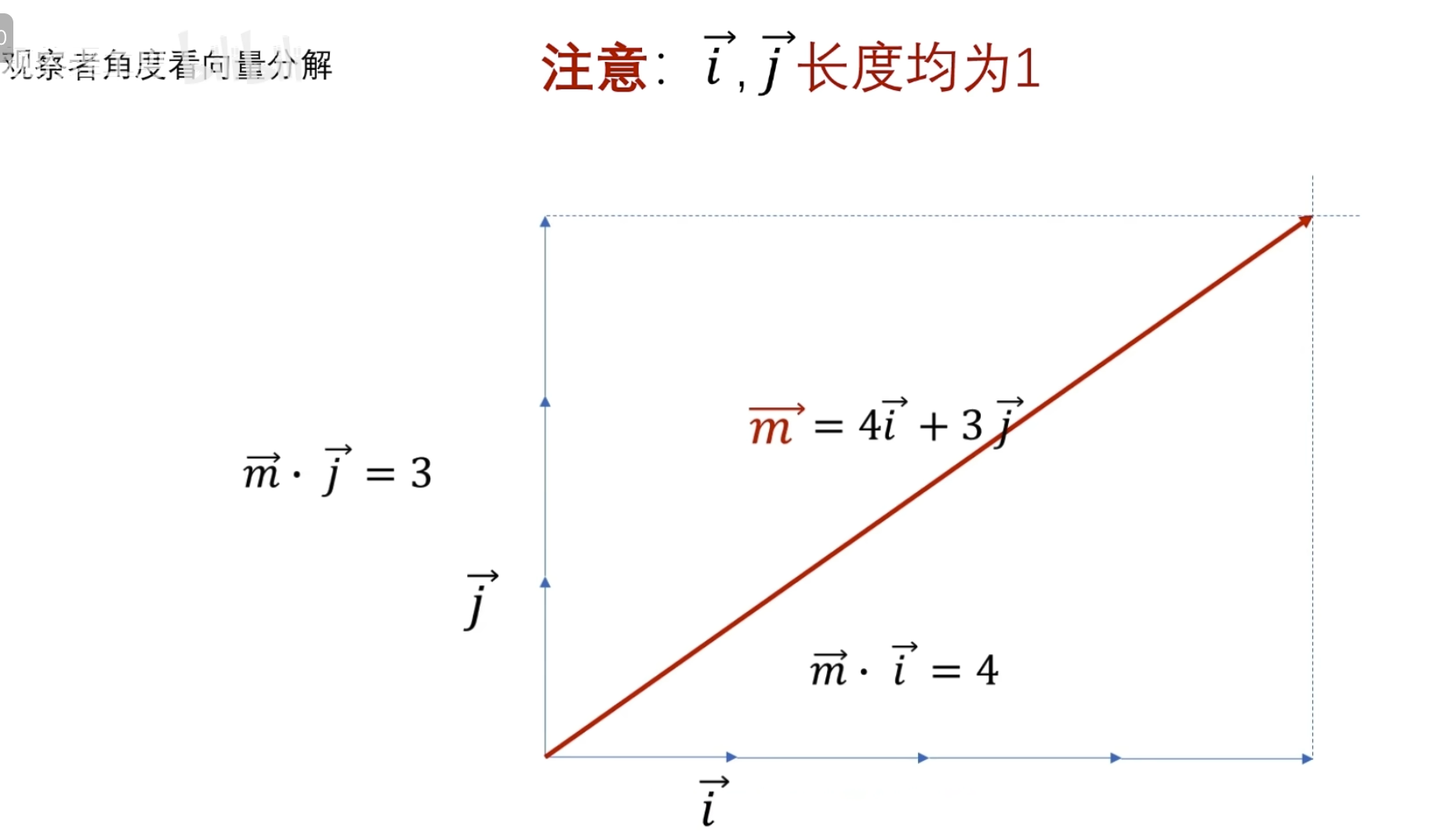

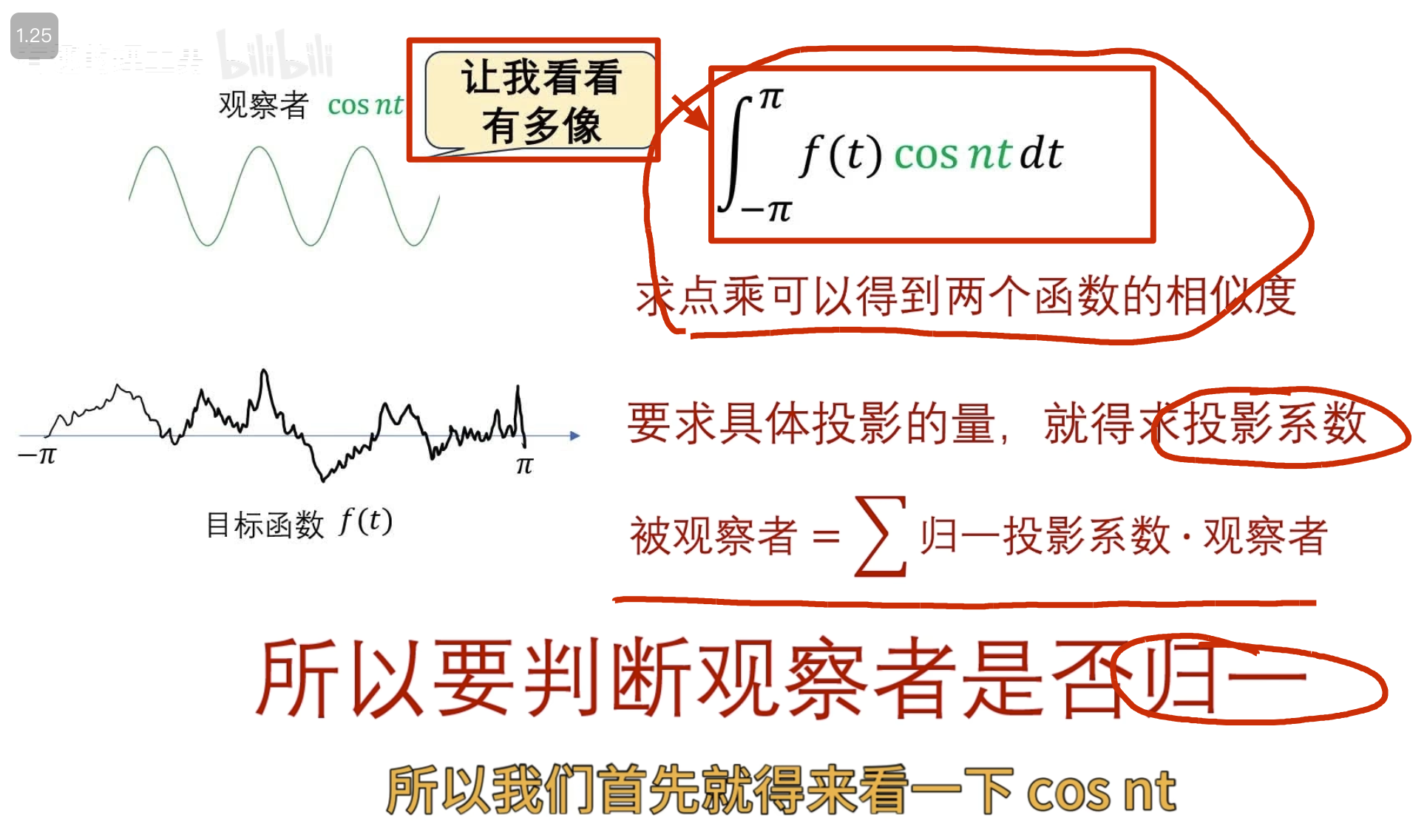

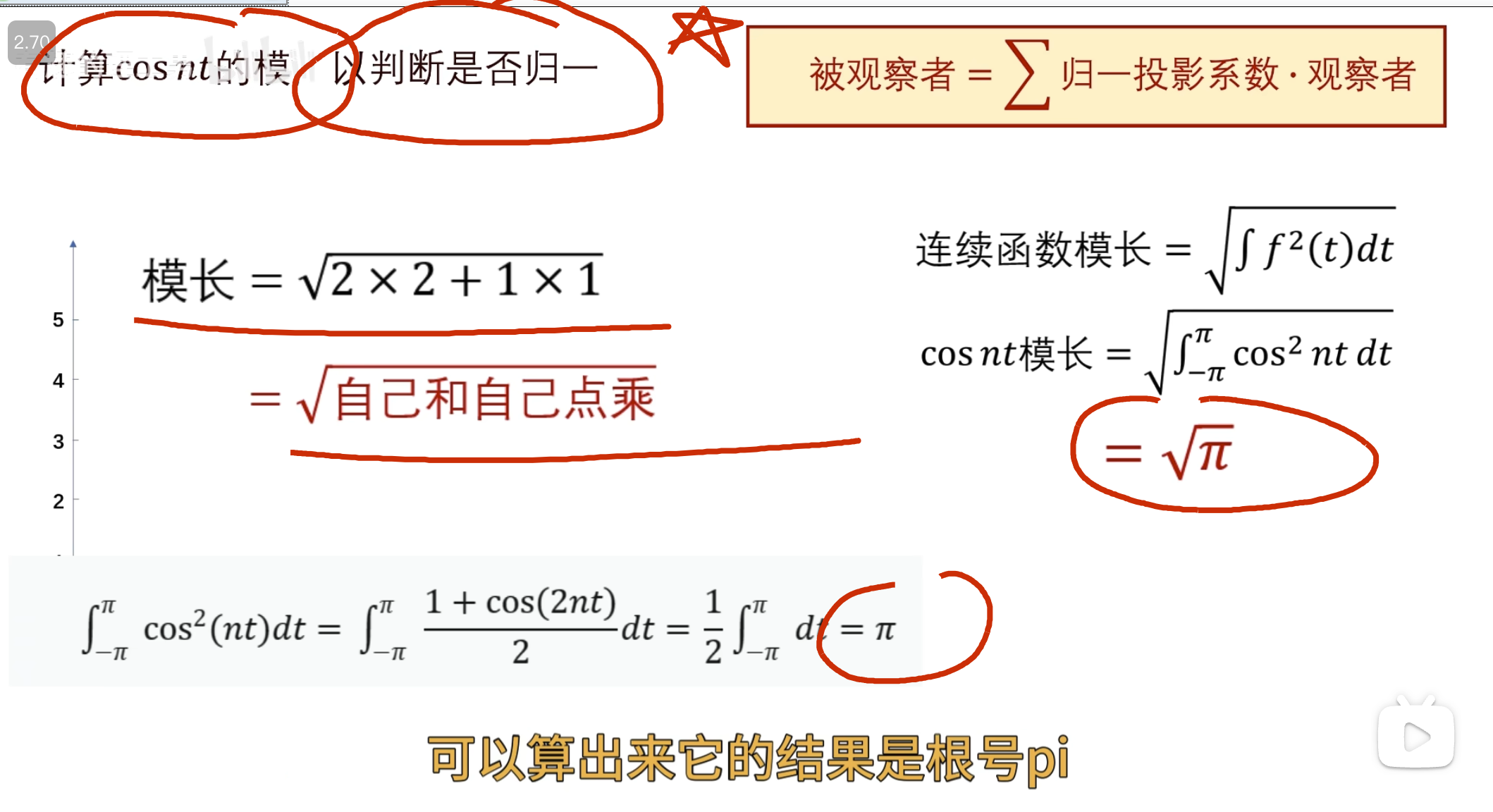

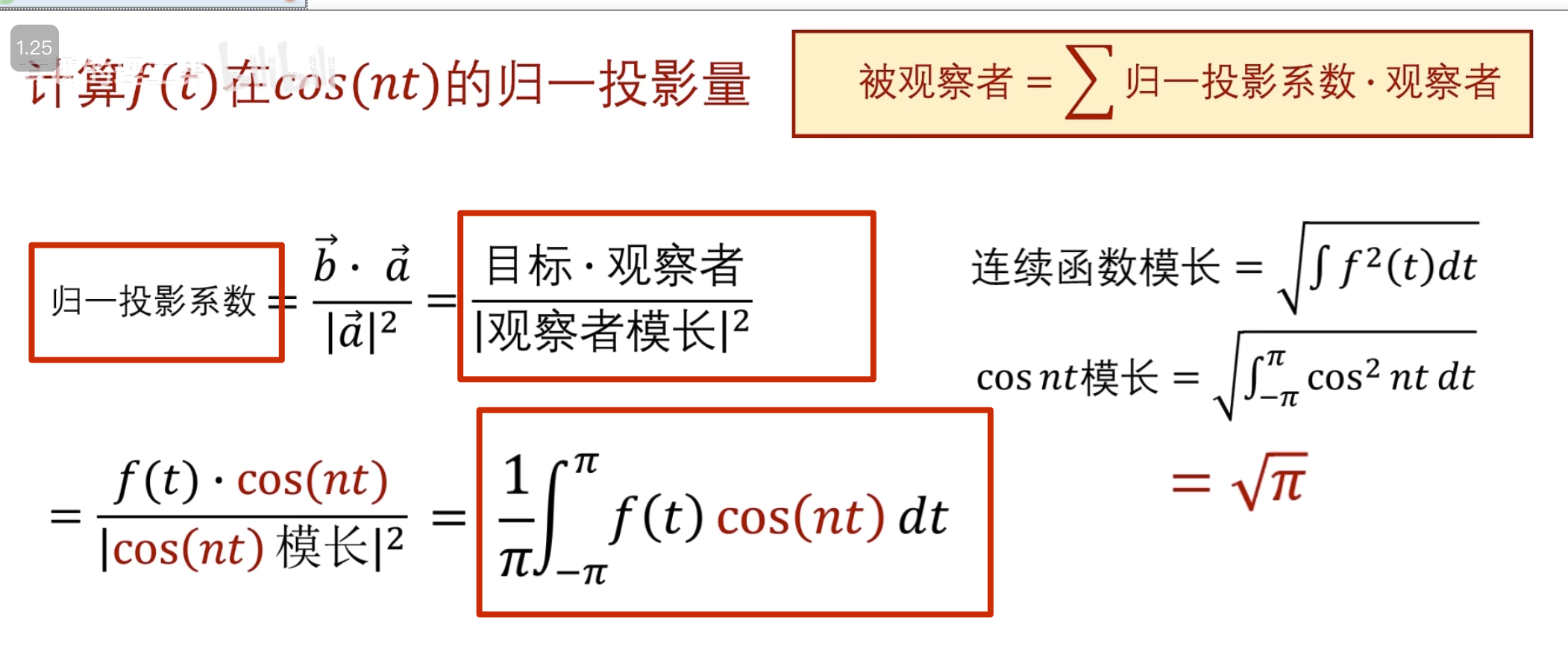

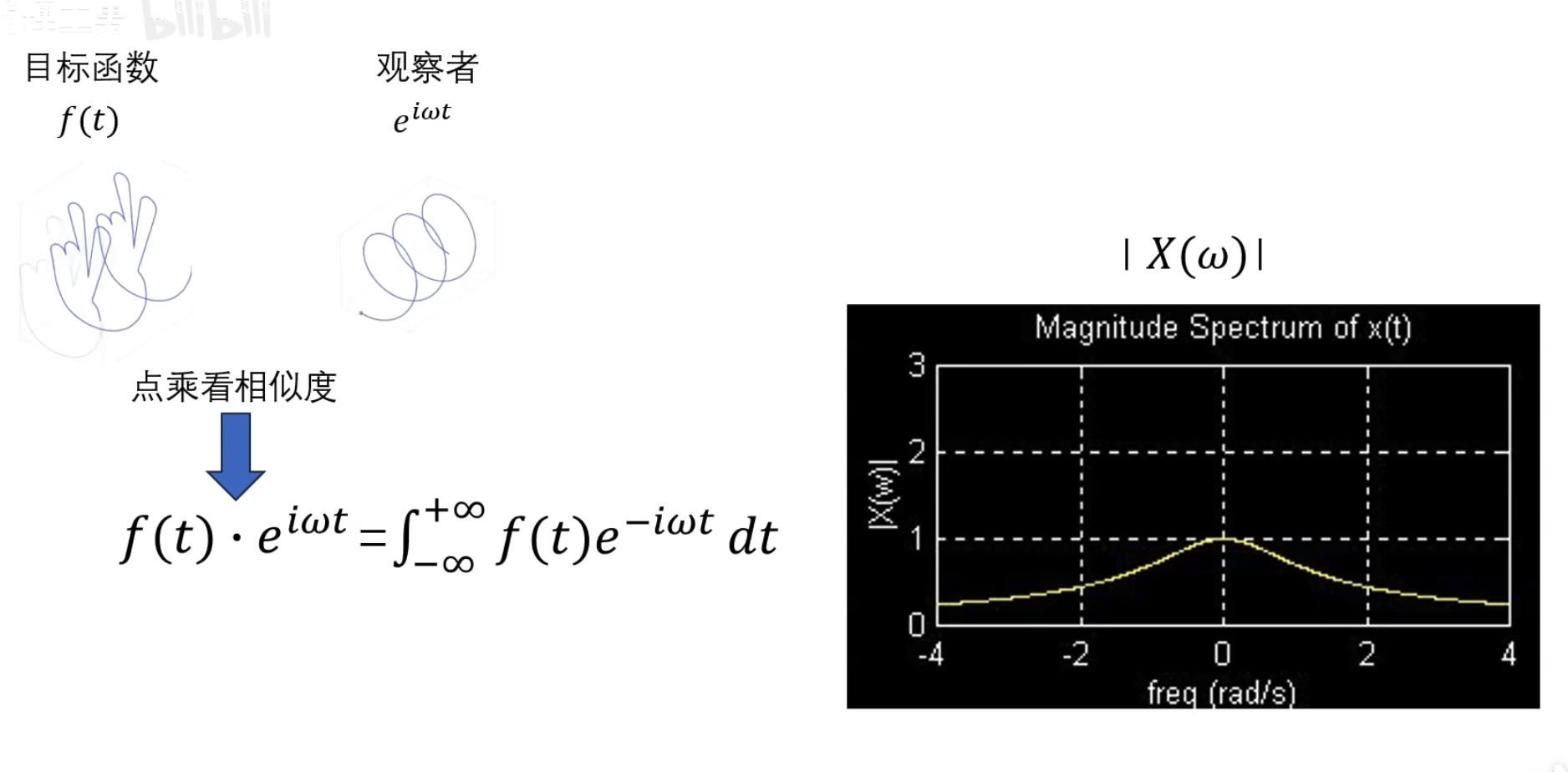

可以看到目标函数到自己频率的世界中的投影(目标函数和观察者的相似度是多少 )

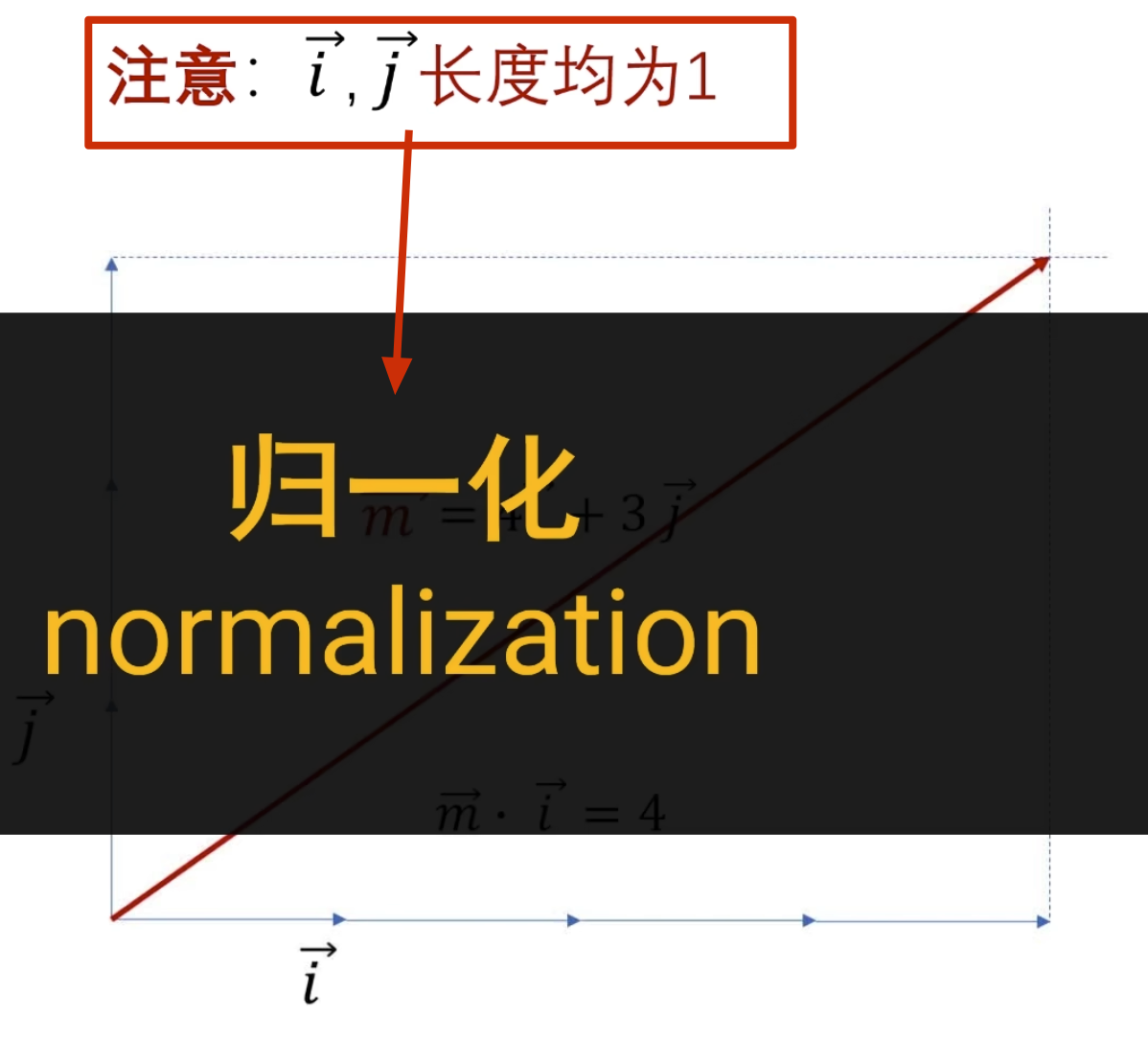

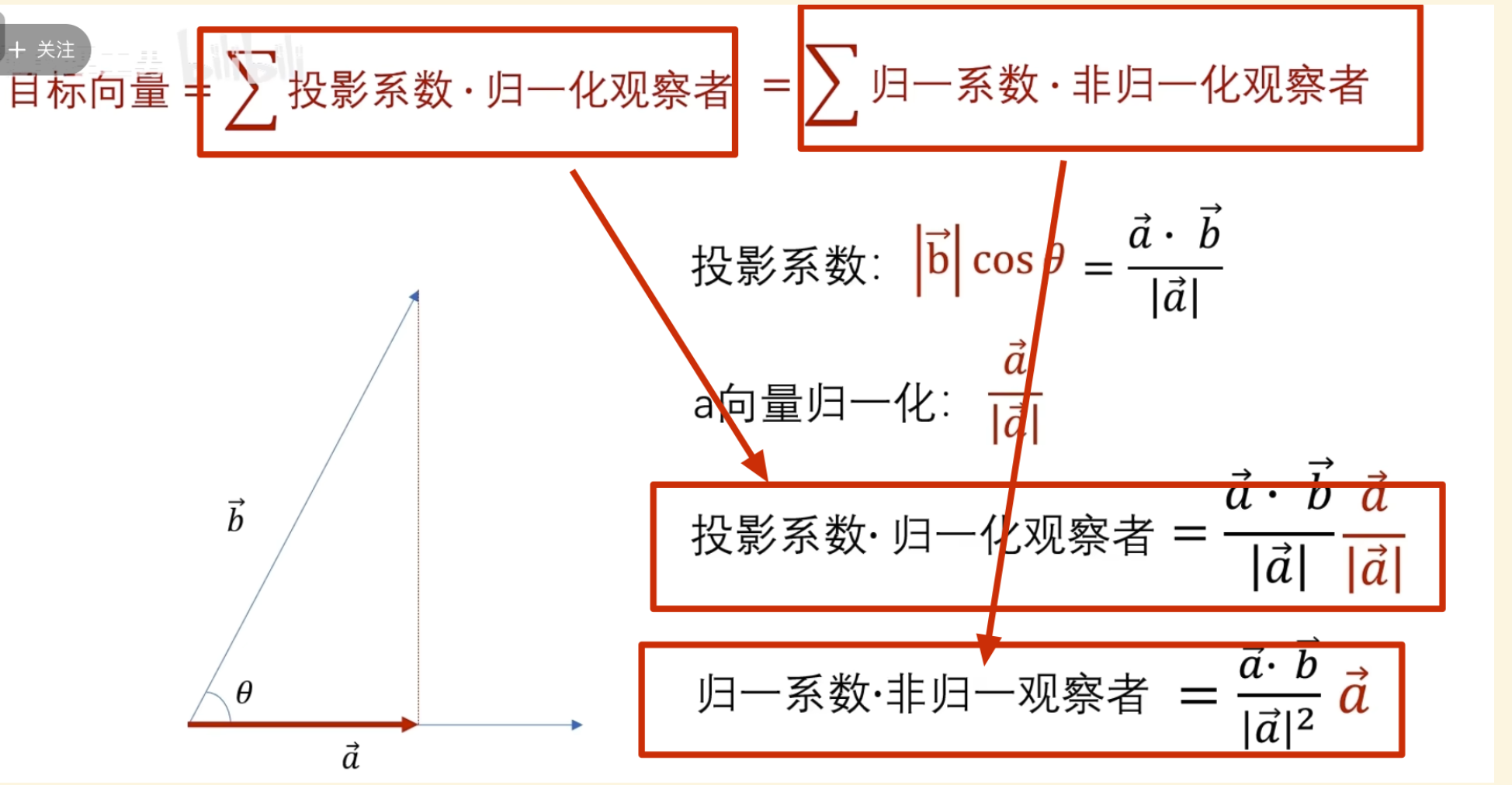

这里已经讲过了要么观察者是归一的,要么投影系数是归一的

其实对于连续函数一般不叫模长,而叫 2-范数

这里显然 cos nt 未归一,所以需要对投影系数进行归一

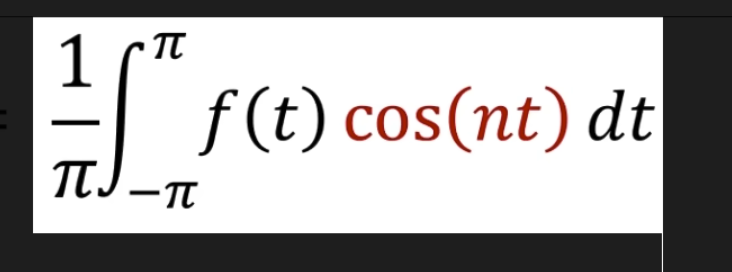

所以最终得到的归一投影系数(这就是我们之前学的傳里叶级数求A n 的公式,对应到不同频率基的振幅 )

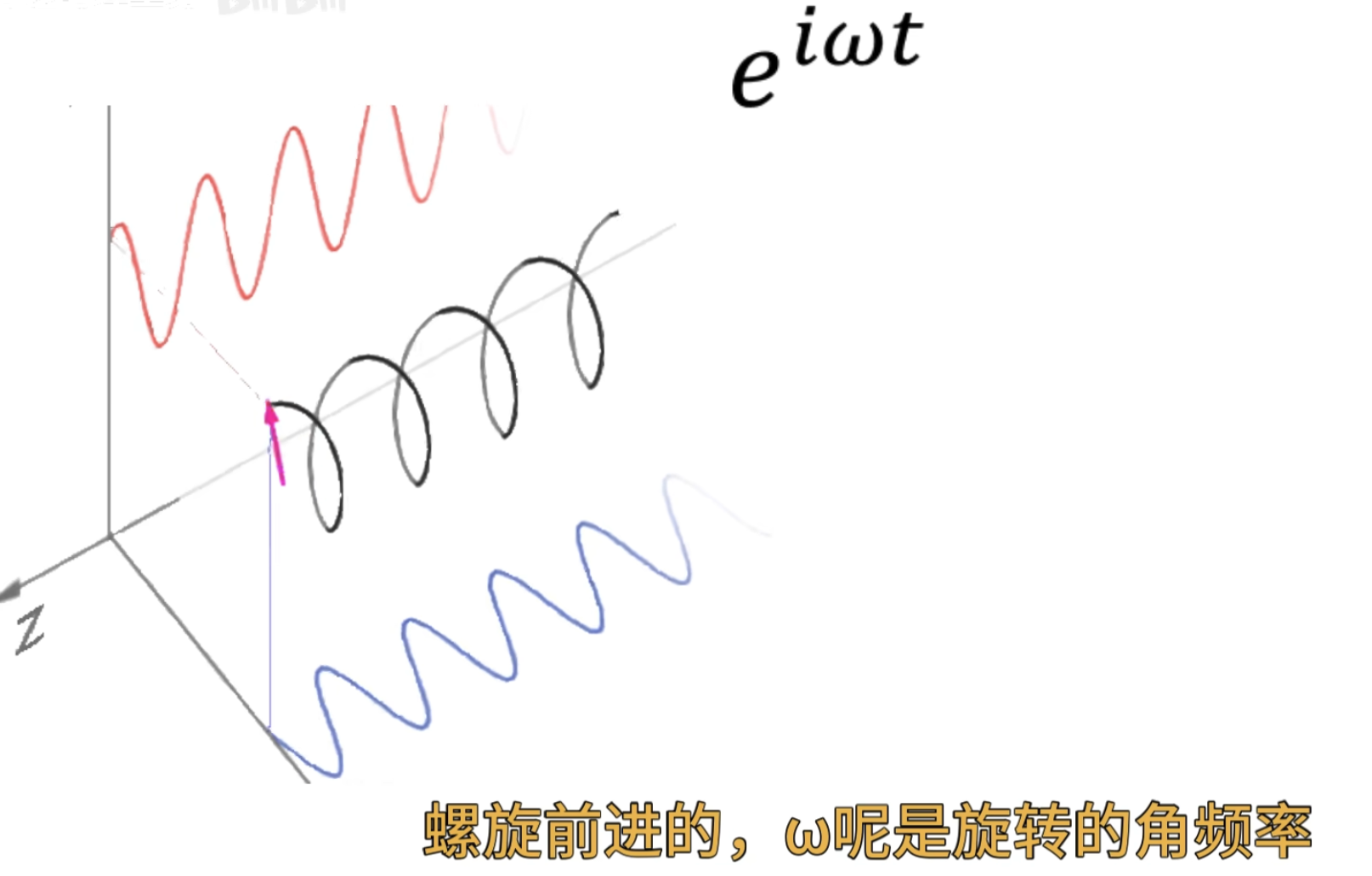

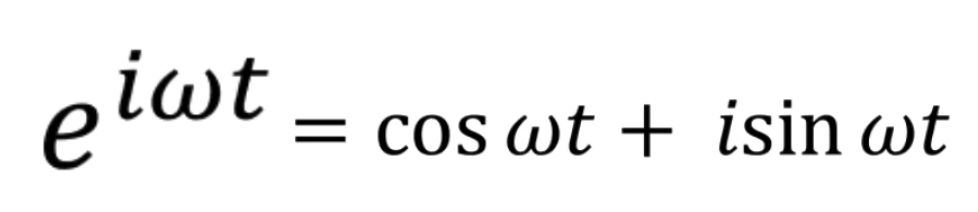

再进一步到傅里叶变换的负指数形式

思想是一样的,只是观察者由余弦函数变成了下面的(观察者由实数域拓展到了虛数的复数域)

\(w\)越大,旋转越快 (不过观察者旋转的半径都是 1,即观察者已经是归一化的了)

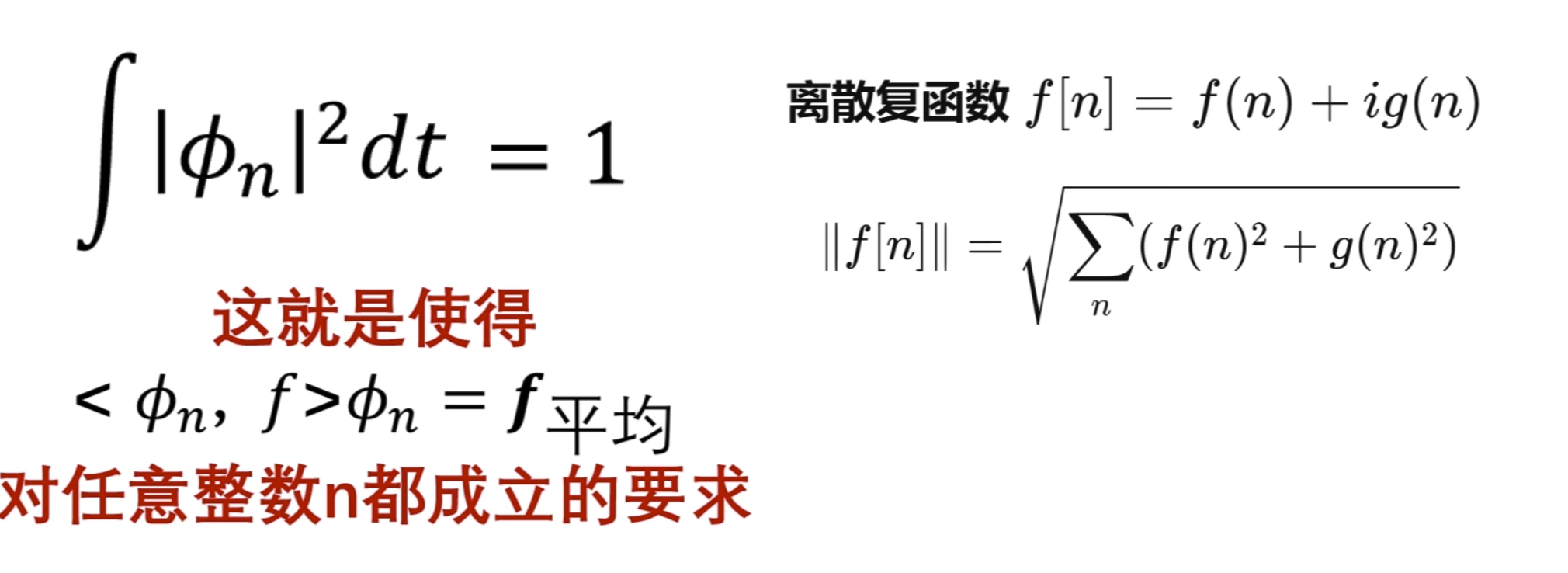

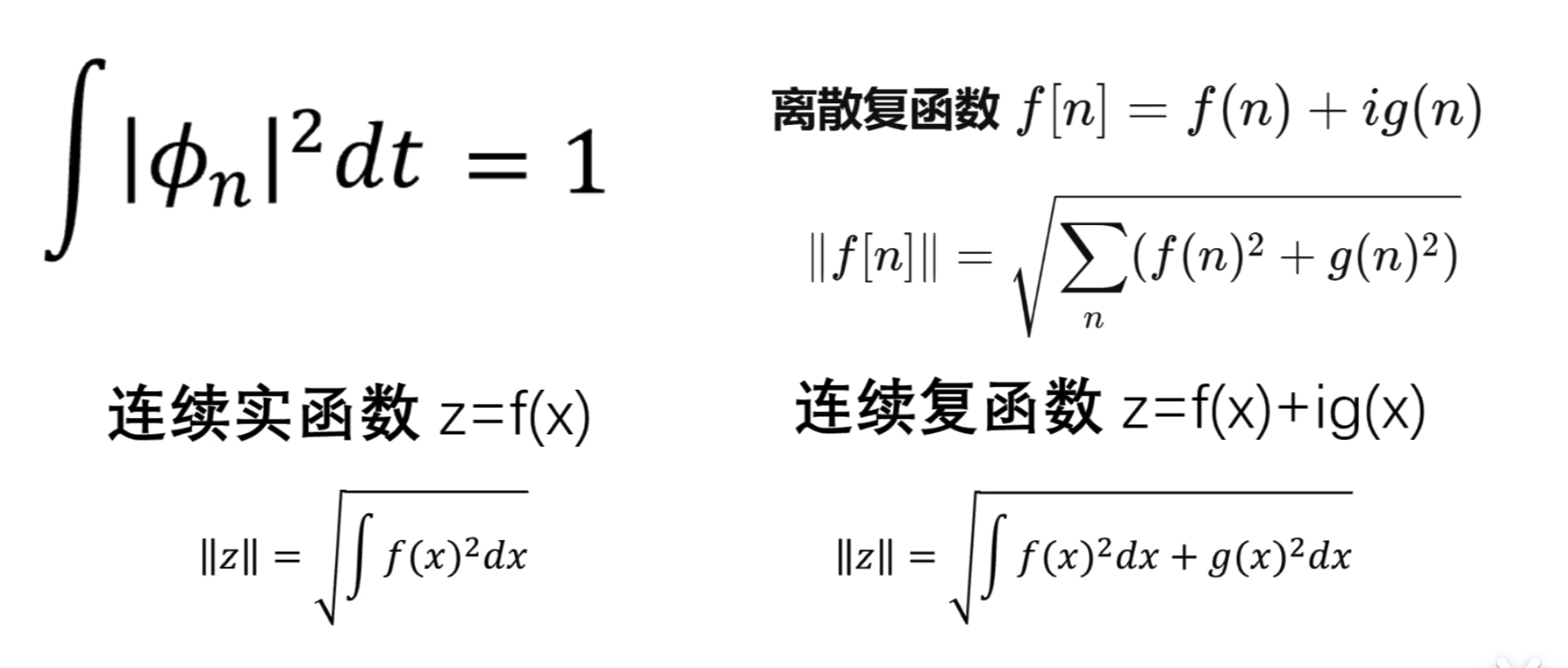

这是一个复数

对于复数,计算模长有两个公式,所以计算虚函数的模长(应该也叫 2-范数)的公式也有变化 ,点乘计算相似度的公式也有变化

点乘计算目标函数和观察者的相似度

上面已经讲了,观察者旋转半径都是 1,所以是已经归一的了,只是旋转的快慢不同

当然用定义也能验证是已经归一化了的

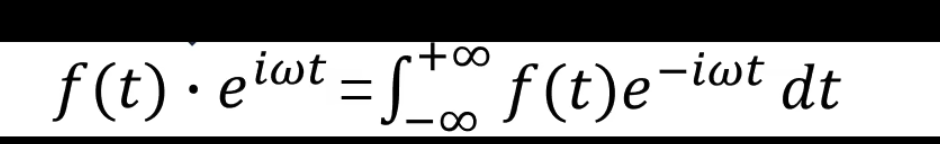

总结连续函数相似度计算公式如下(也就是常用的连续函数的傅里叶变换公式 )

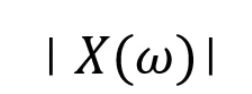

我们积分出来的结果通常是一个关子频率\(w\)的复凾数 ,而这个复函数的模啊就加个绝对值就可以㻫解为前们前面所说过的投影数,也就是该频率下的震动的幅度

,而这个复函数的模啊就加个绝对值就可以㻫解为前们前面所说过的投影数,也就是该频率下的震动的幅度

以上就是傅里叶变换,但是事情并非我们想象的那么美好 ,问 题呢就出现在了观察者的身上

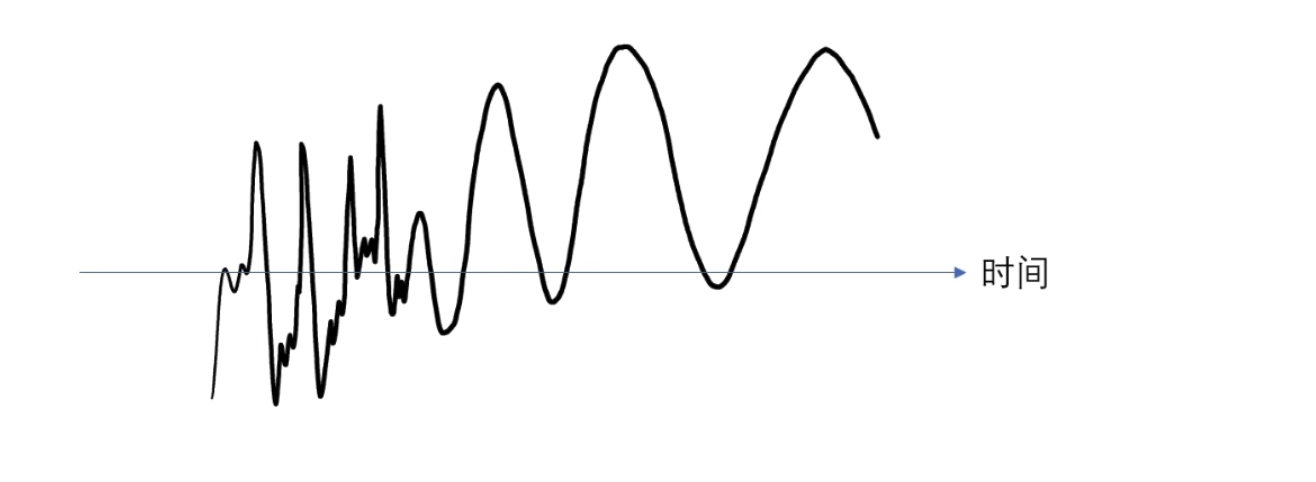

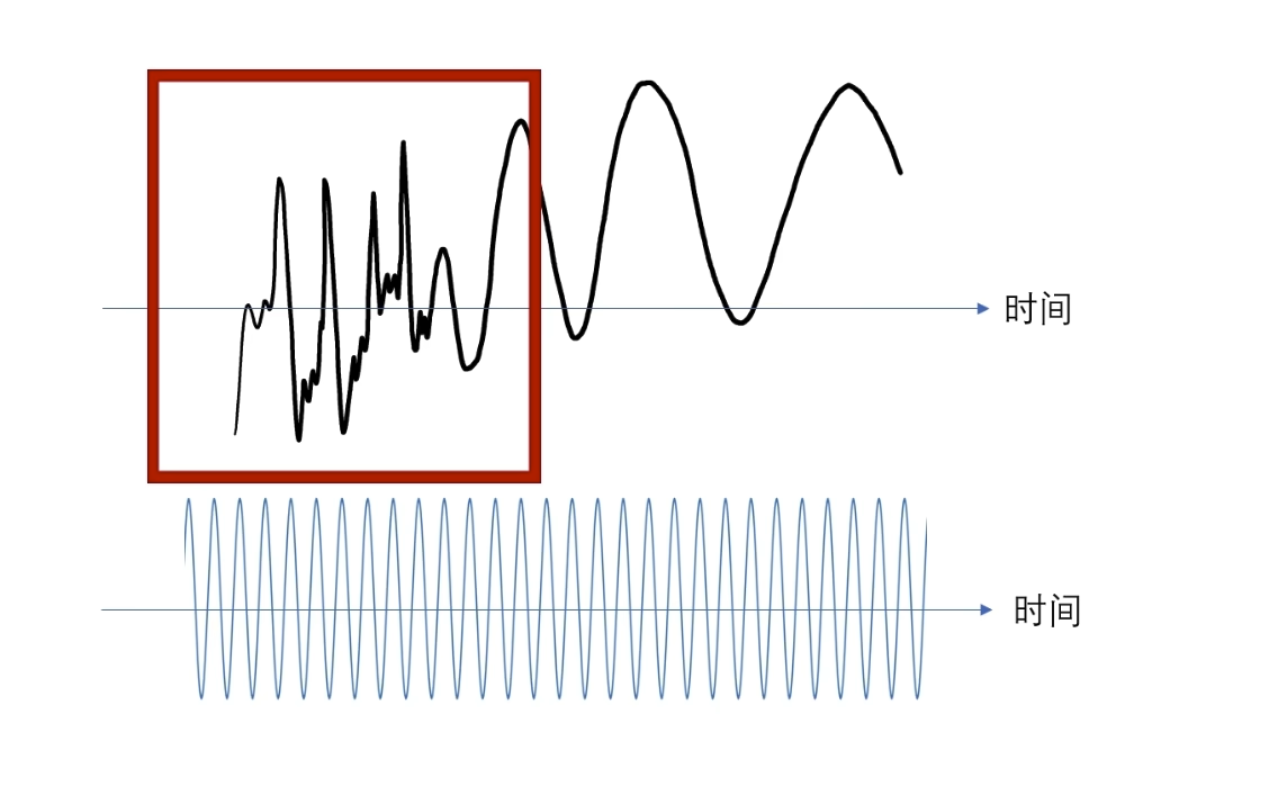

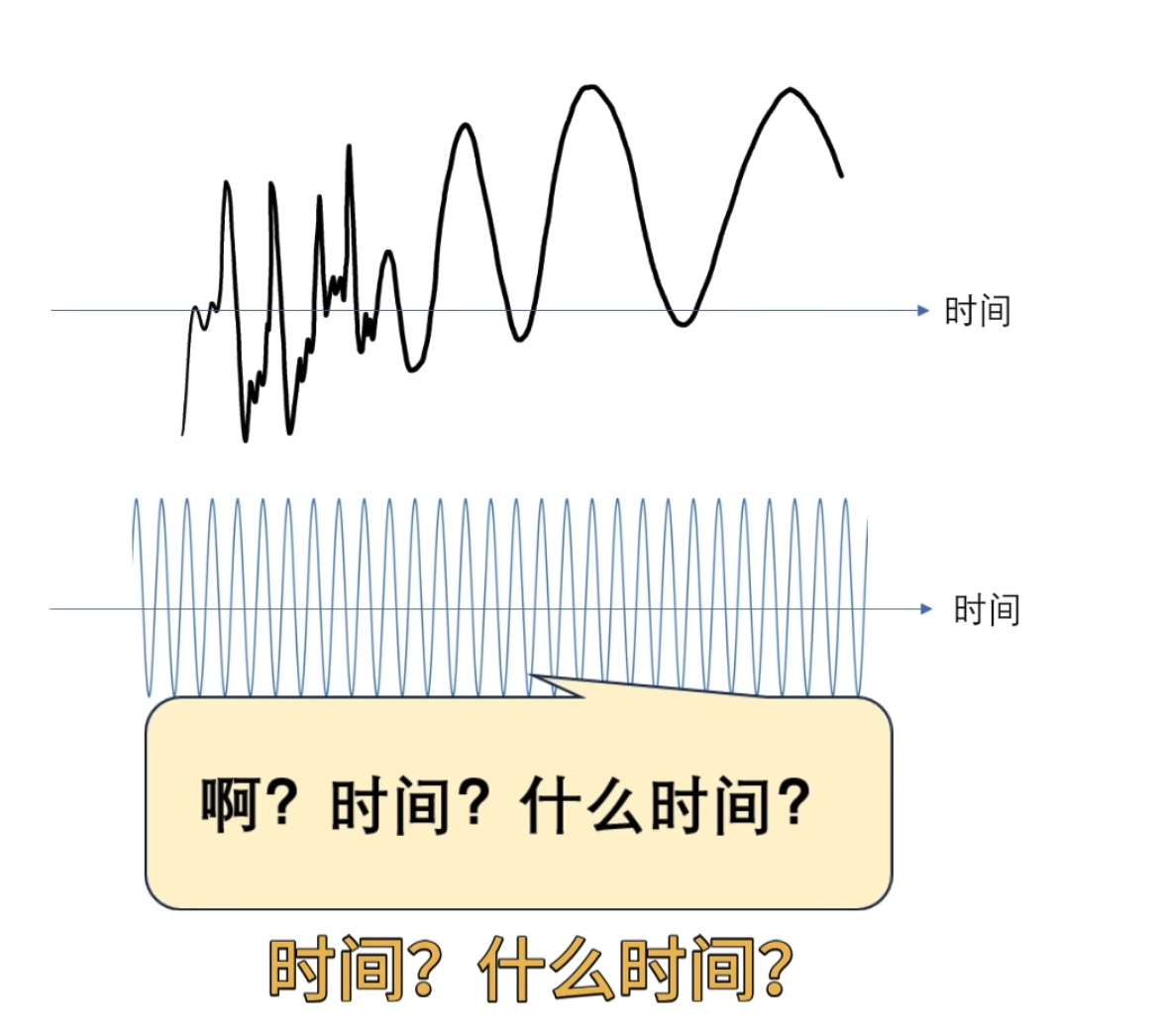

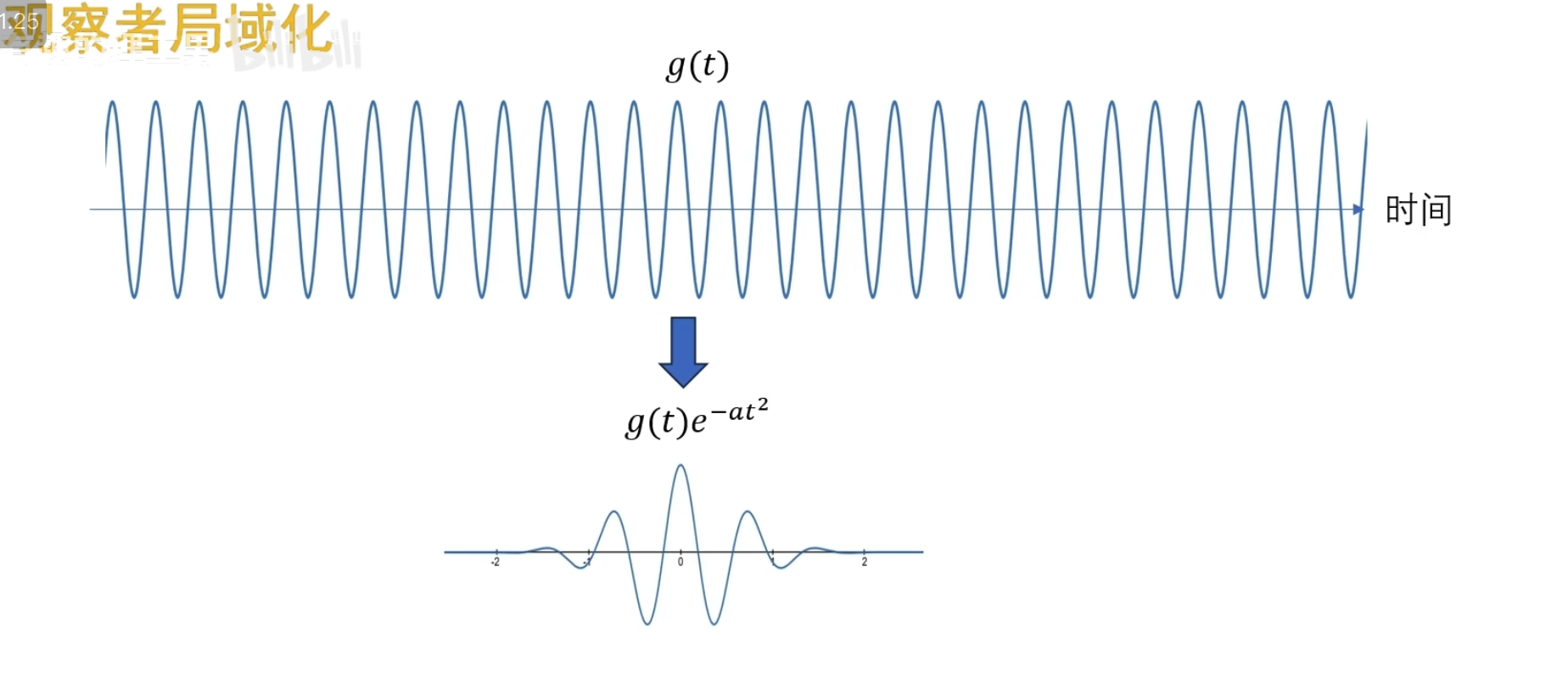

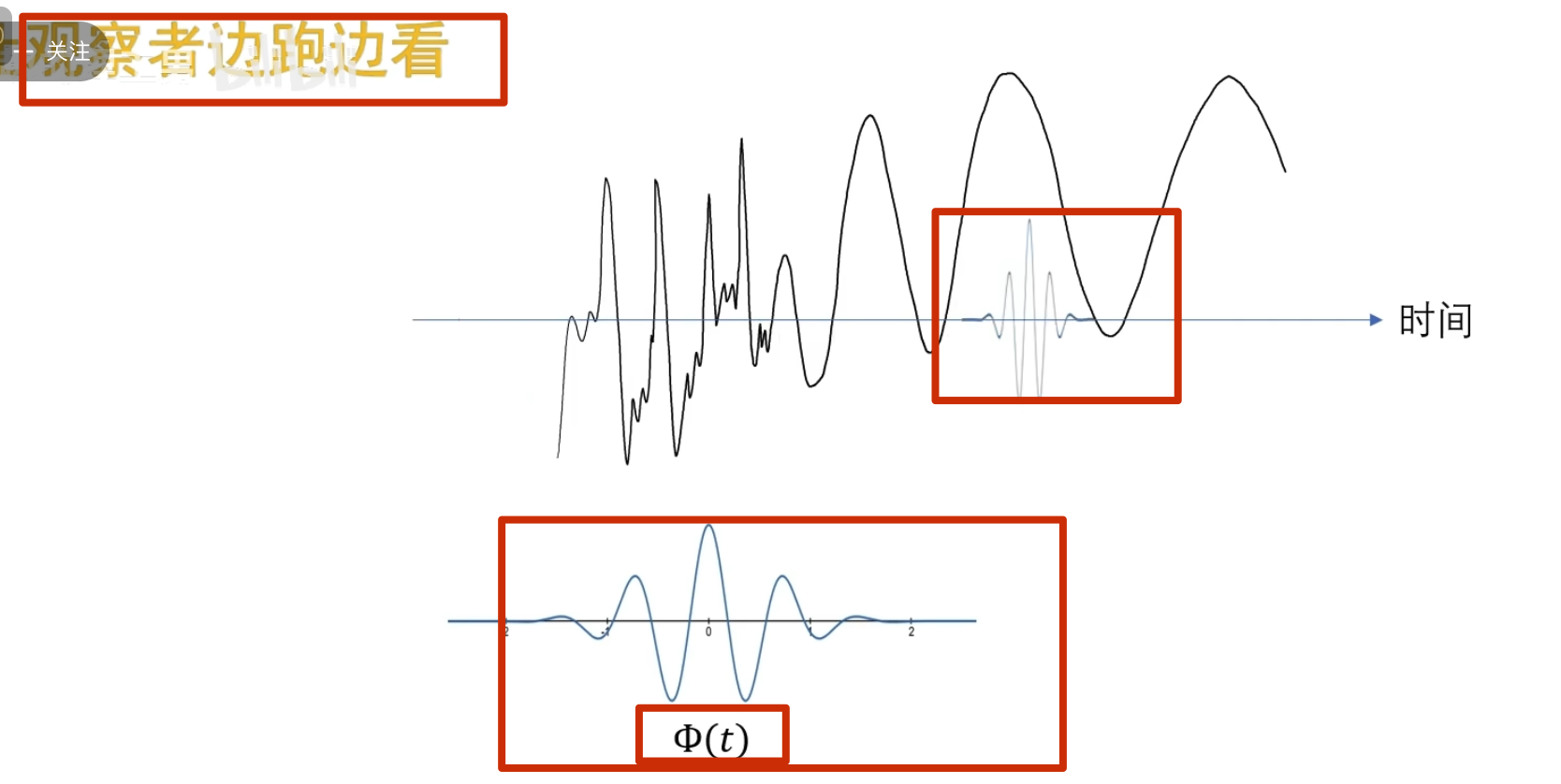

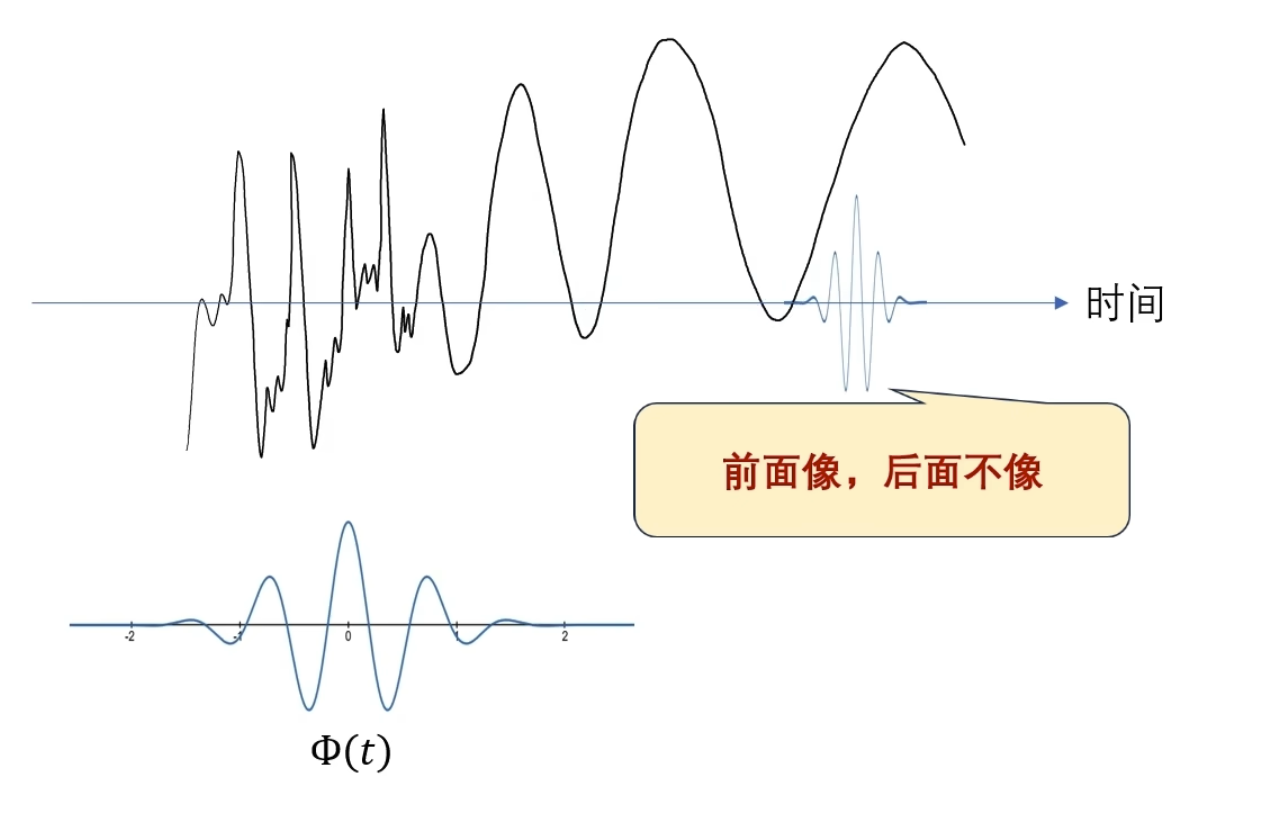

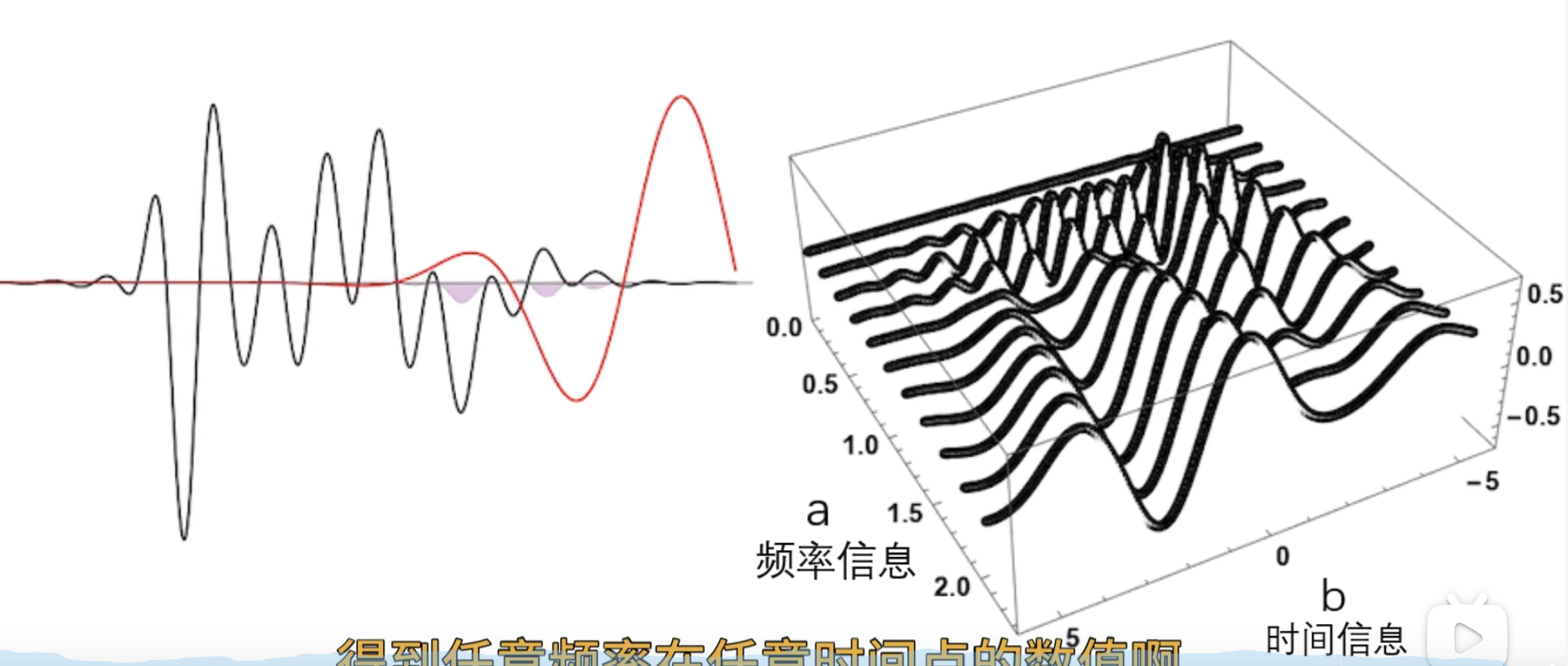

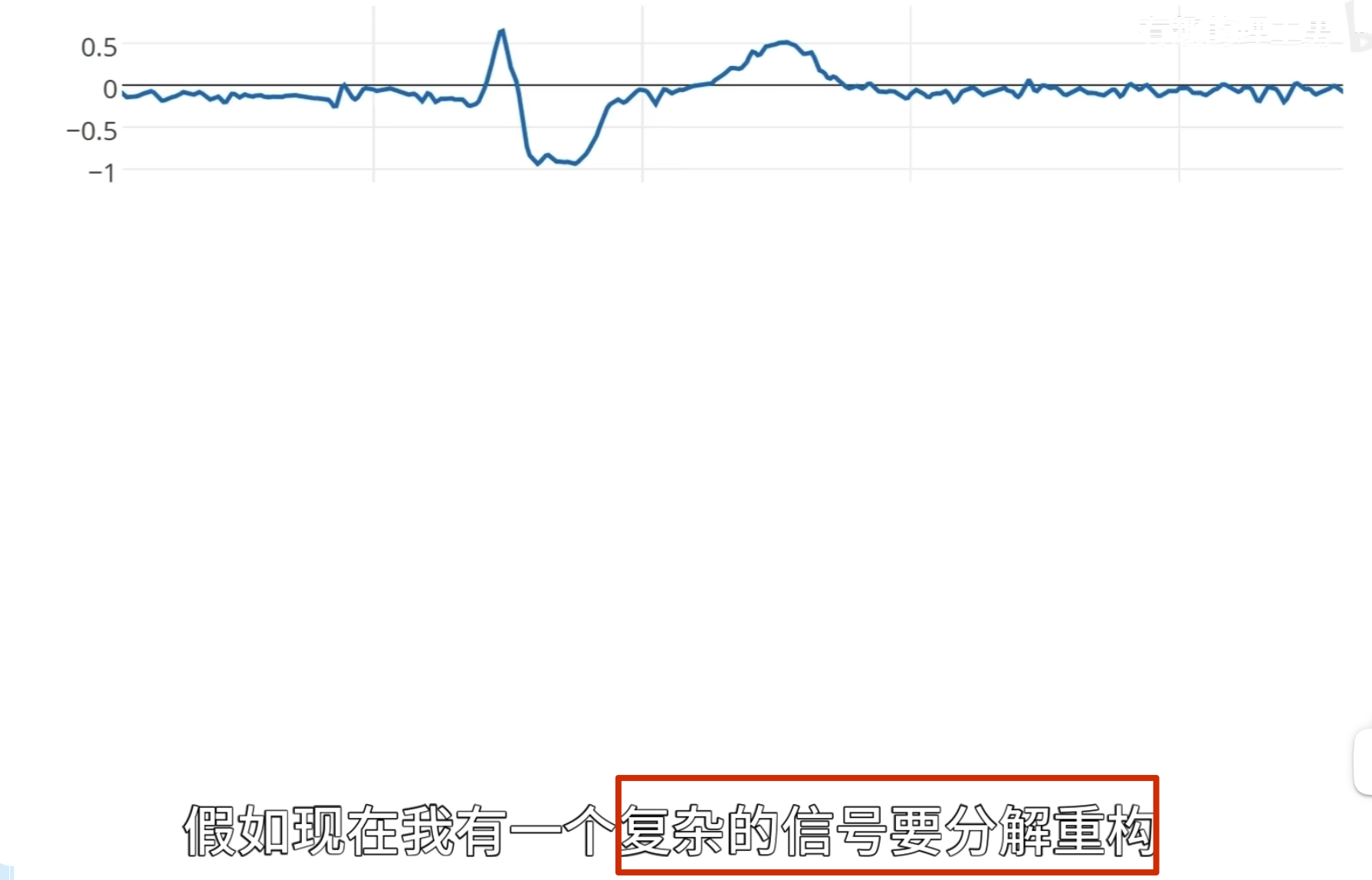

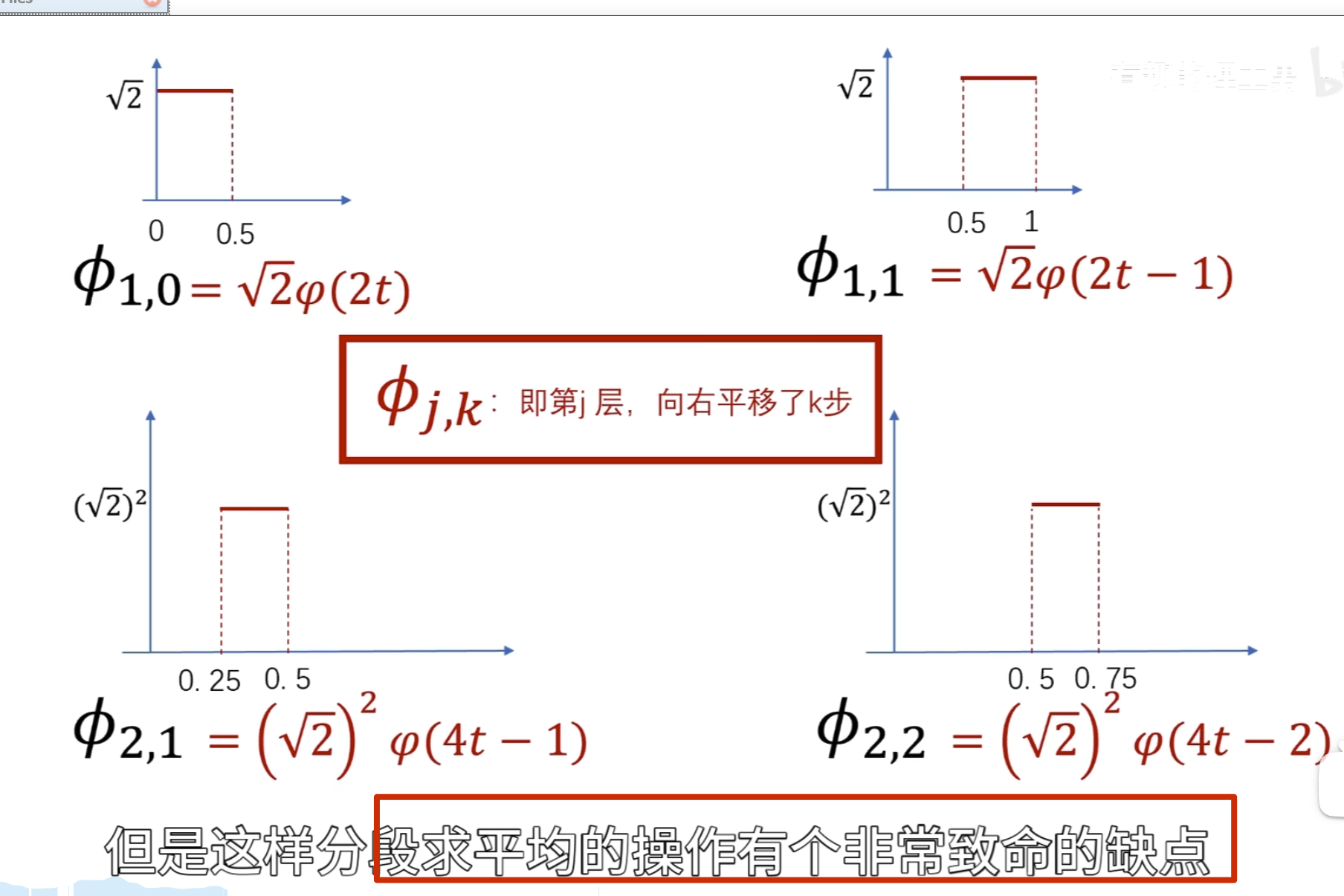

观察者\(e^{iwt}\)它在时间轴上是无穷无尽的,如果我们的目标函数是长这样的,在前面一小段振动频率很高,而后面时间的振动几乎都是低频的振动

这个时候使用一个高频的观察者观察它,问两个函数的相似度

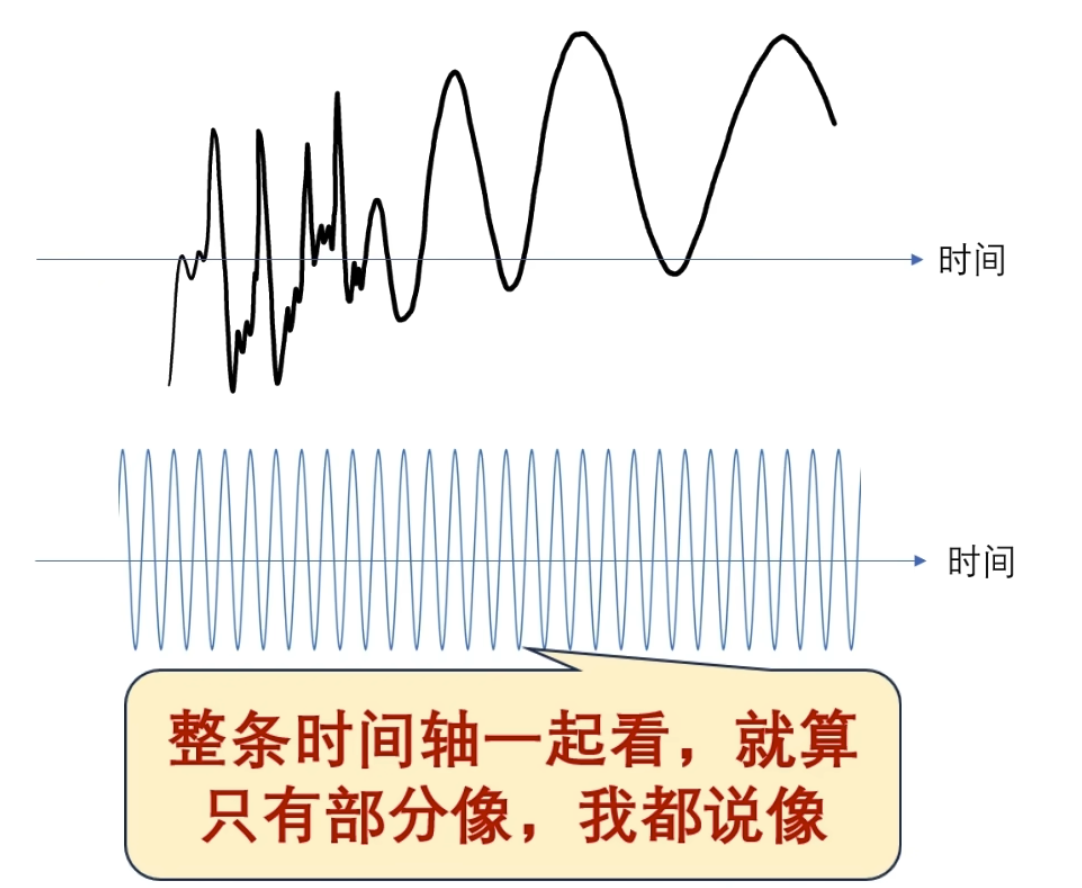

问哪个时间段像?它回答不了因为对于这个观察者来说它是在整个时间轴展开的,无穷无尽的, 观察者 一变呢就是整个时间轴一起变的啊

所以尝试改造观察者

观察者局域化,这个褒減过的观察者,在时间轴上就不再是无穷无尽的啦

,它其实呢就是把它给局域化了哈 ,我们可以把这个观察者写作

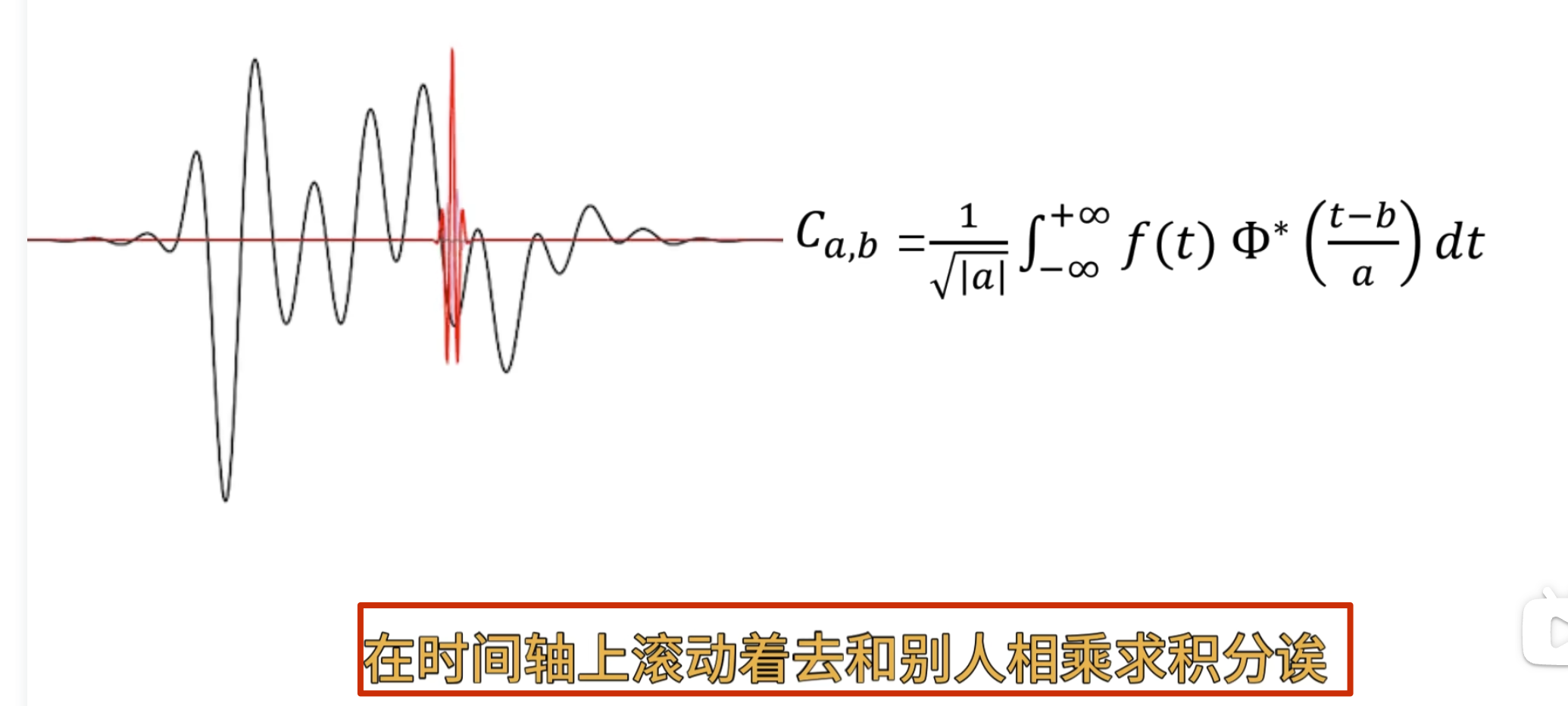

这个时候我可以让这个观察者顺着时间轴去巡逻,再把不同的时闻点观察剄的结果 反馈给我

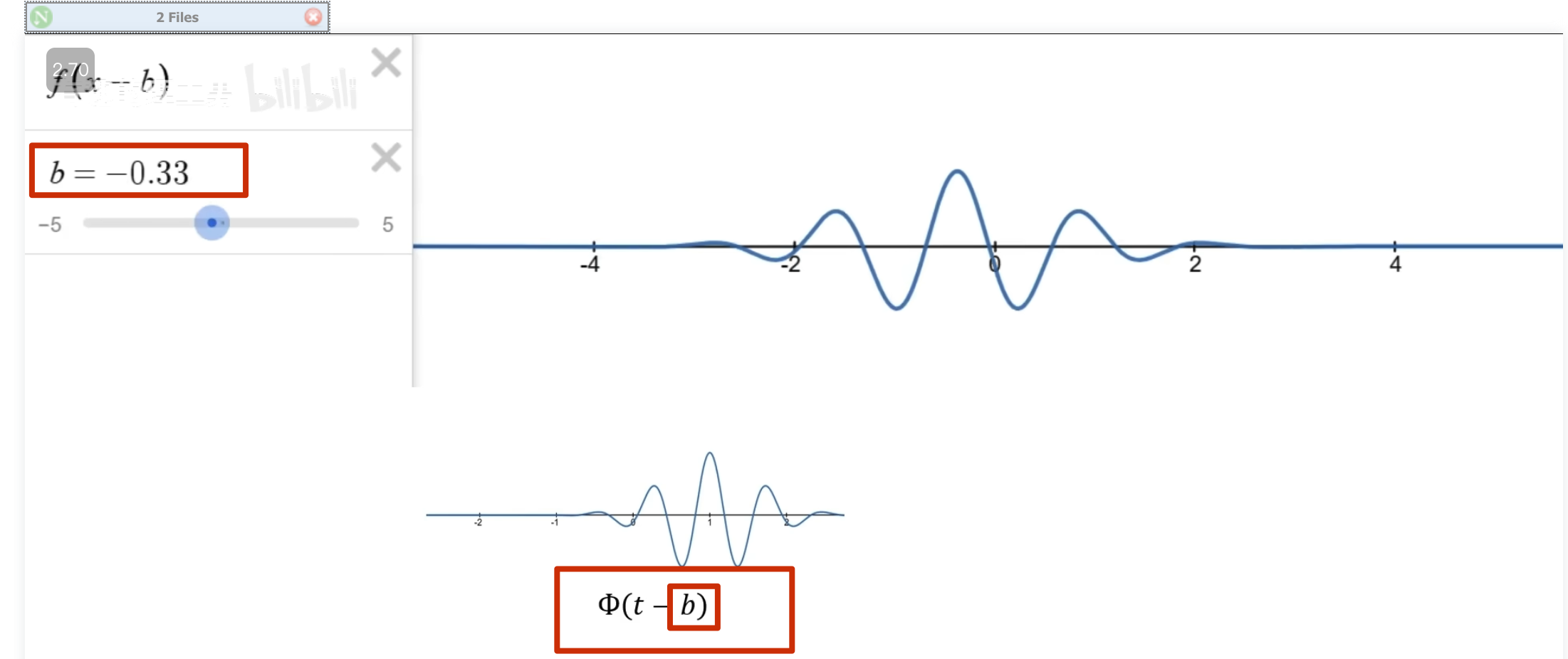

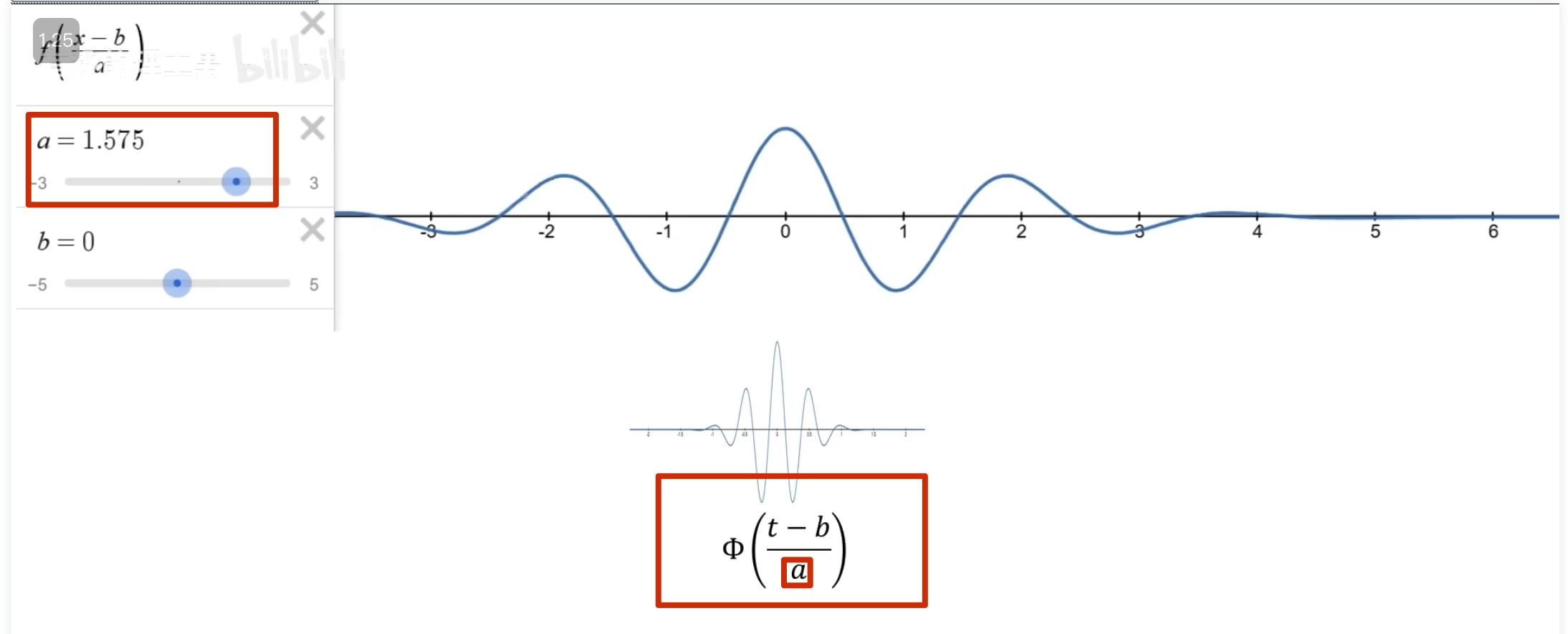

怎么实现巡逻呢?——函数的平移,b 为平移因子

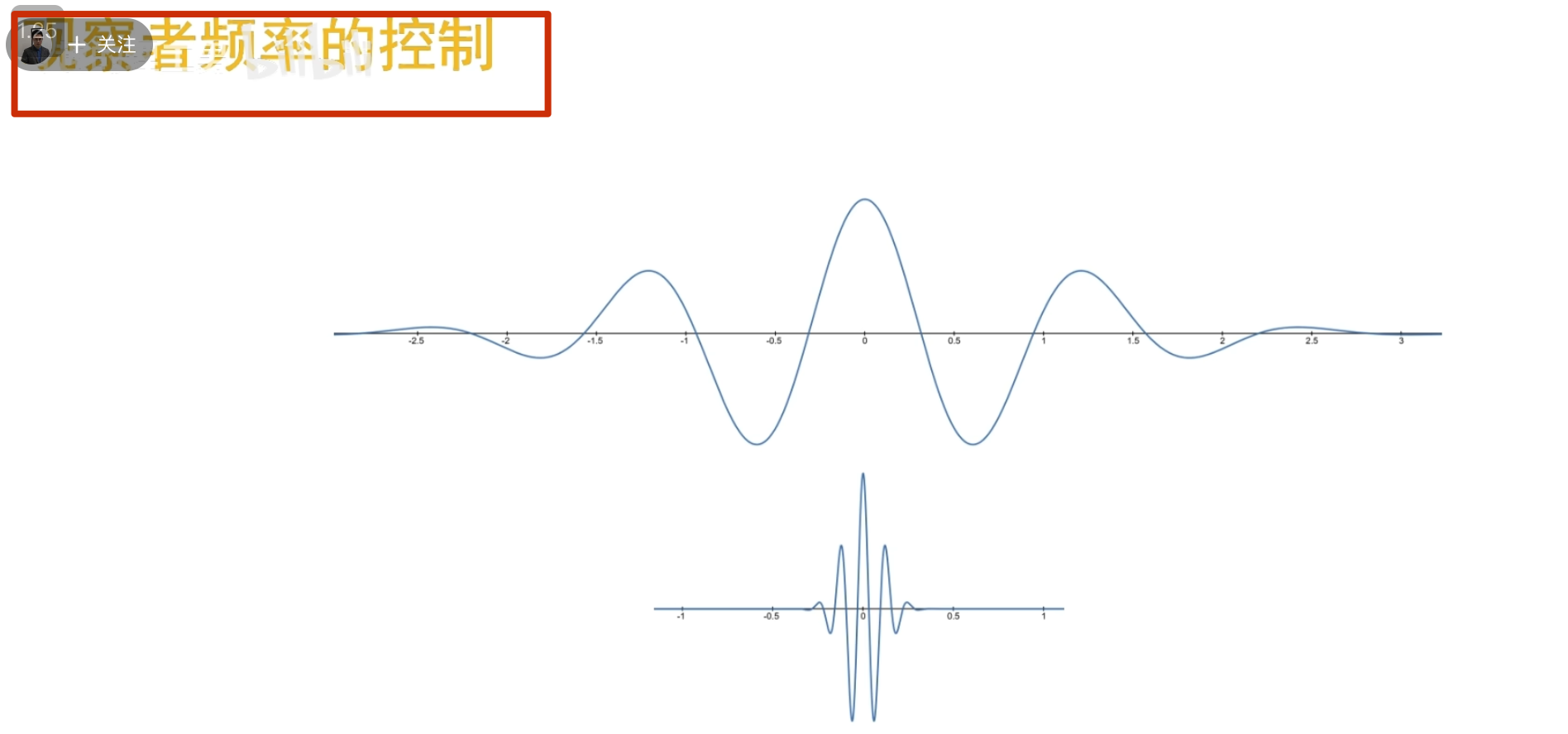

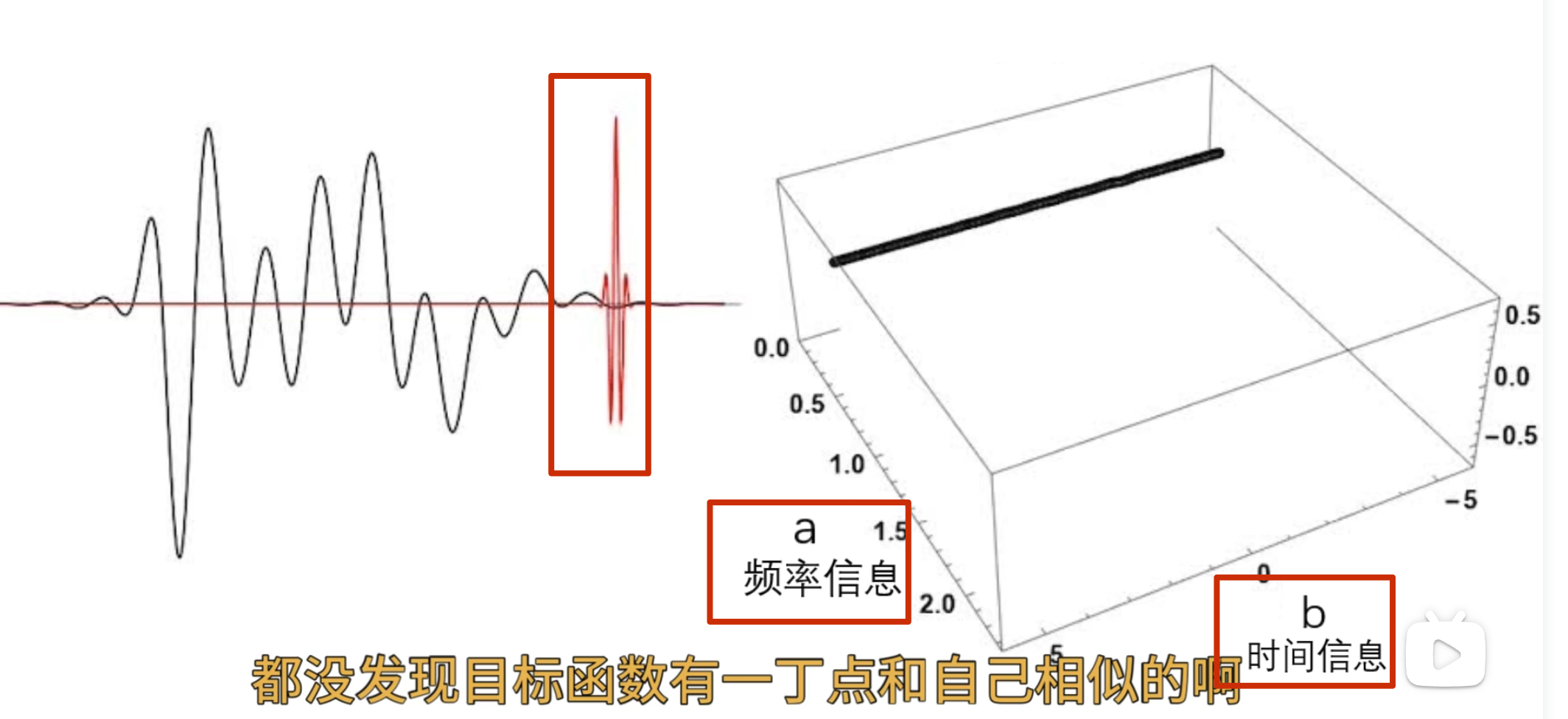

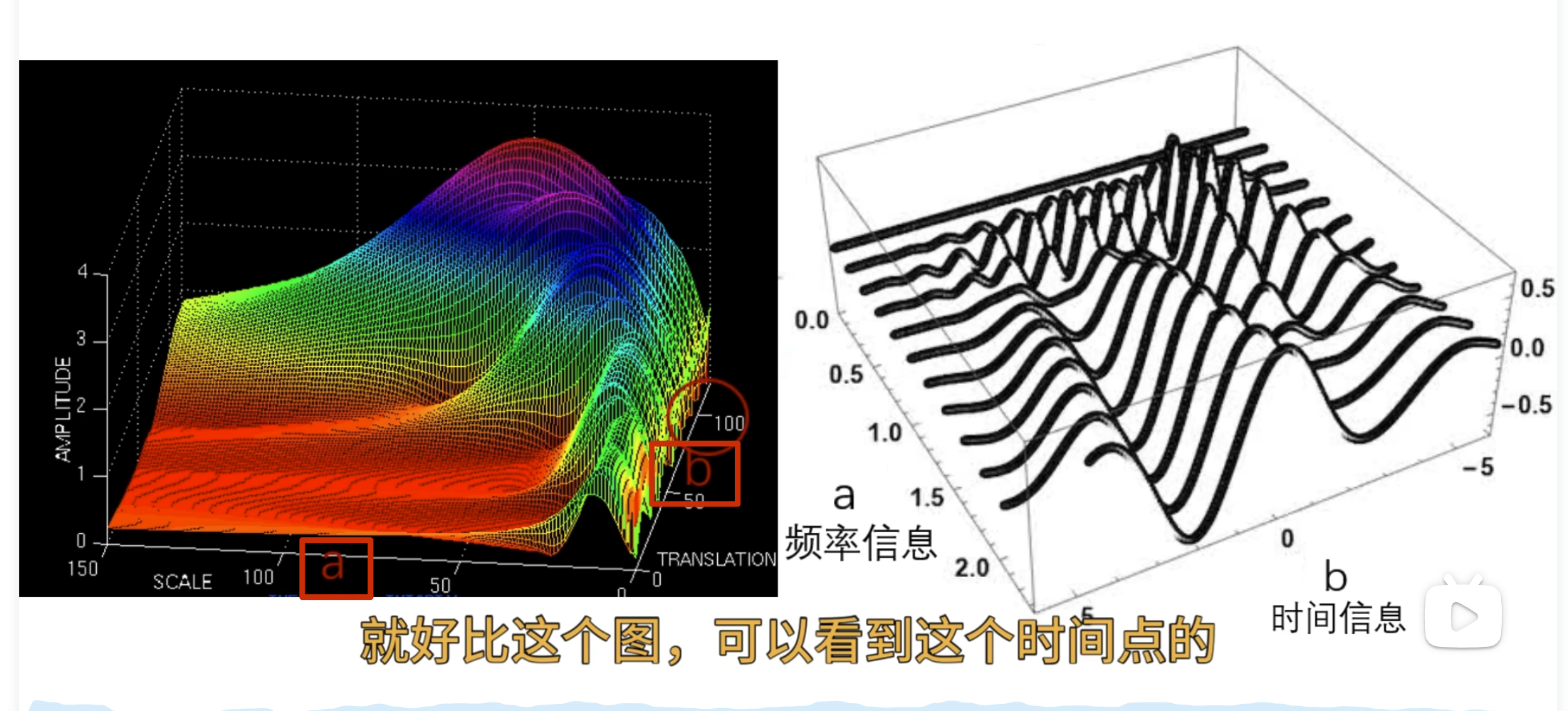

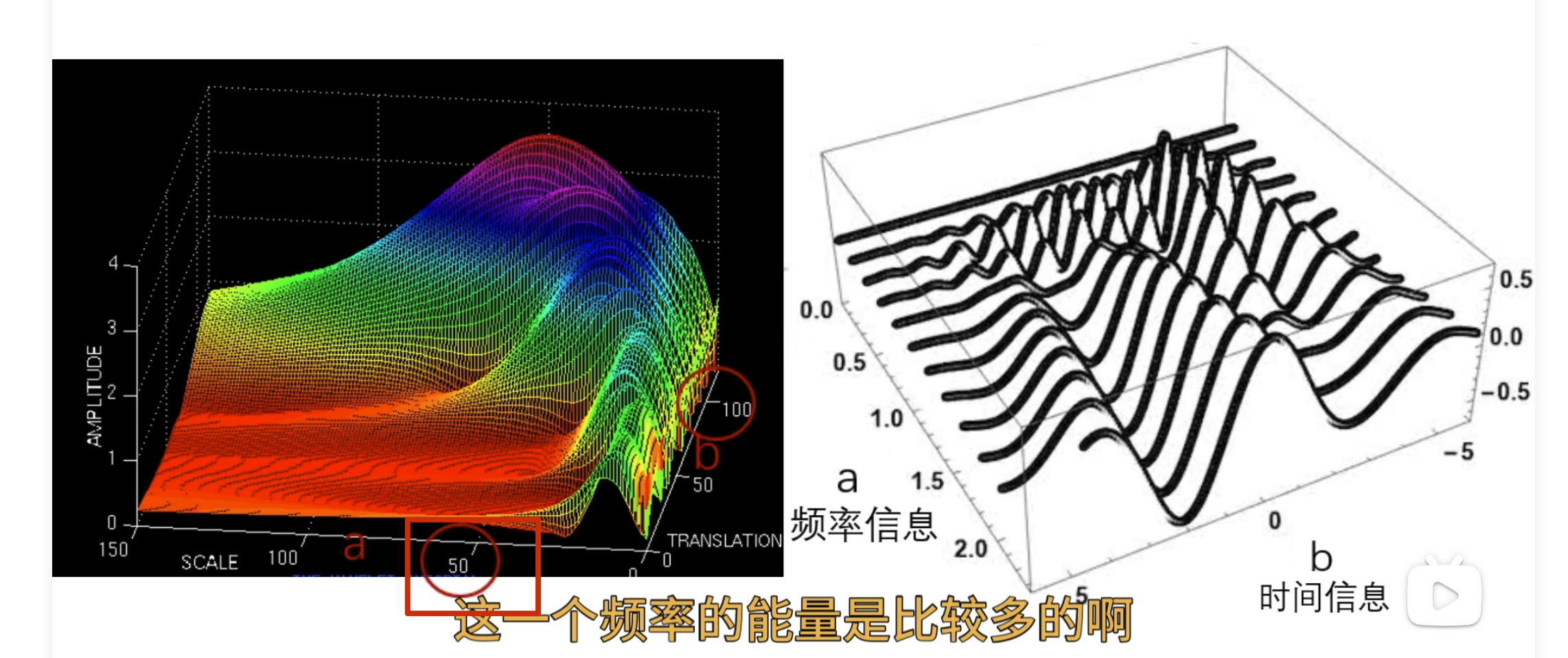

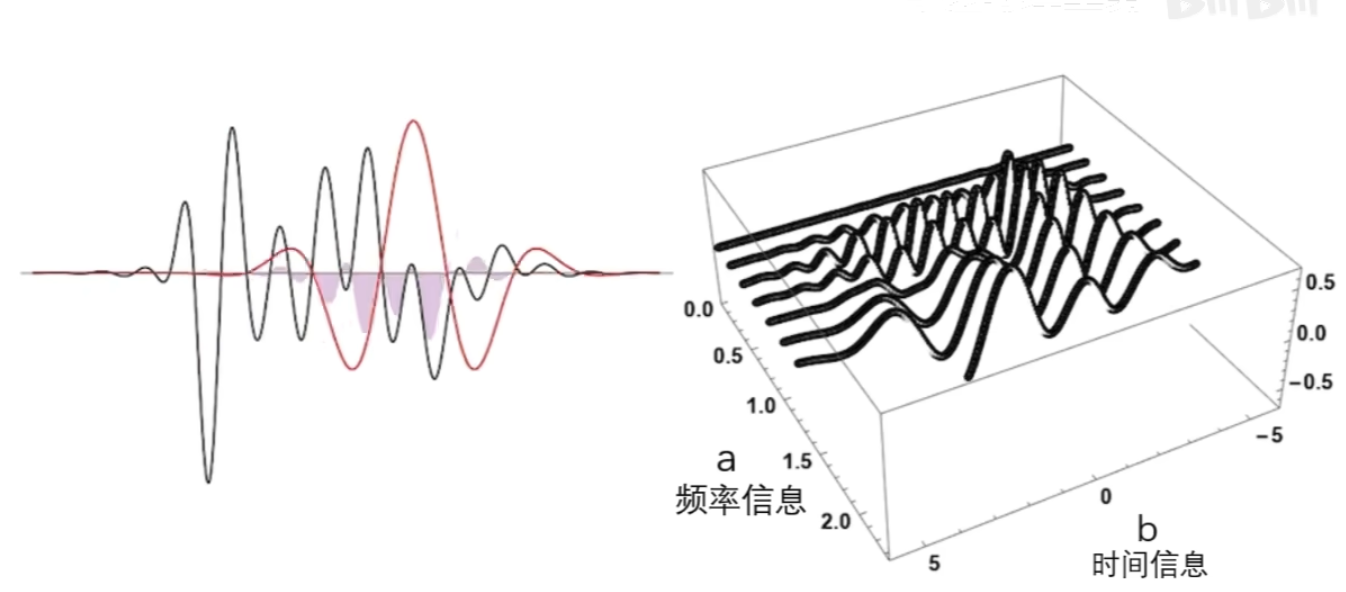

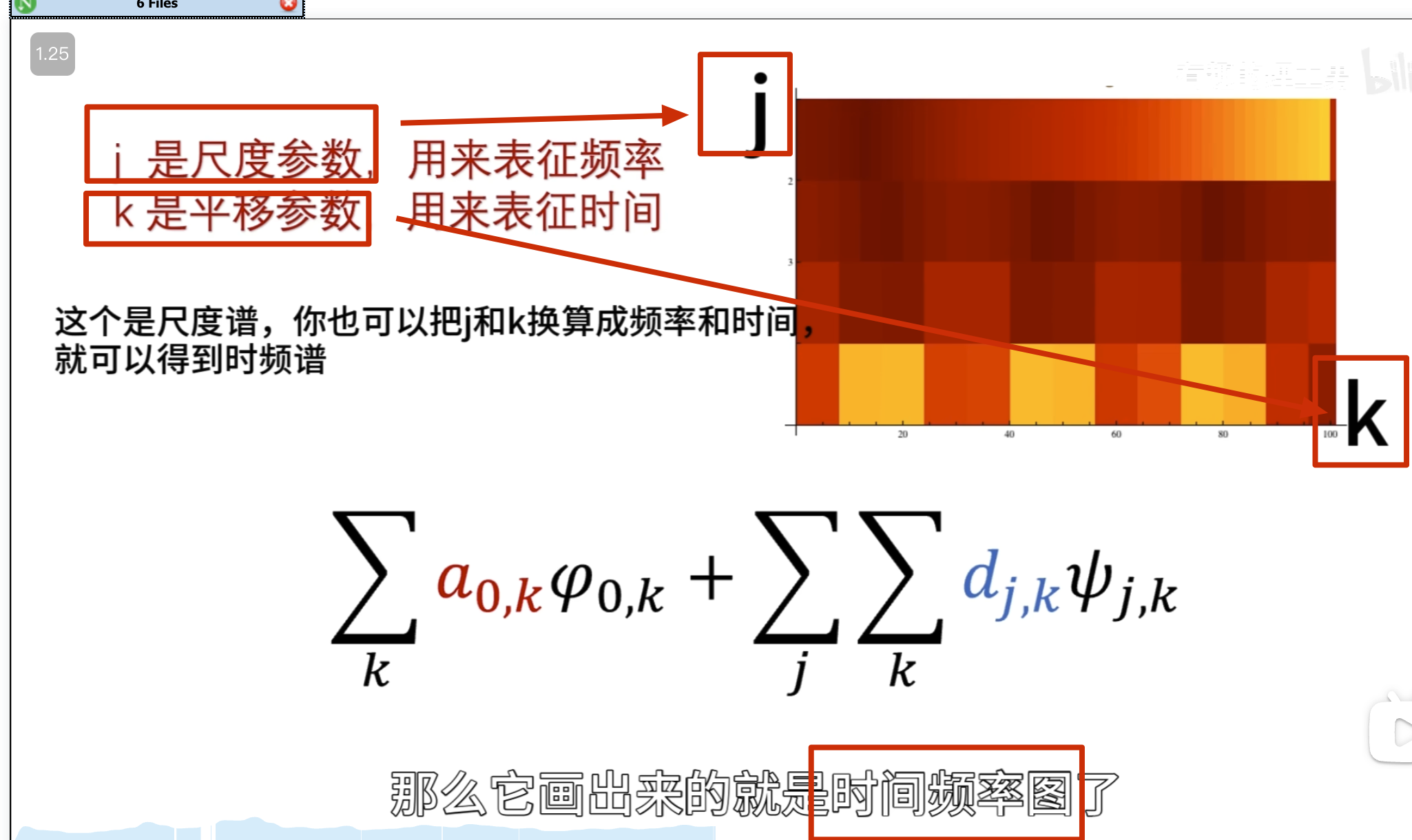

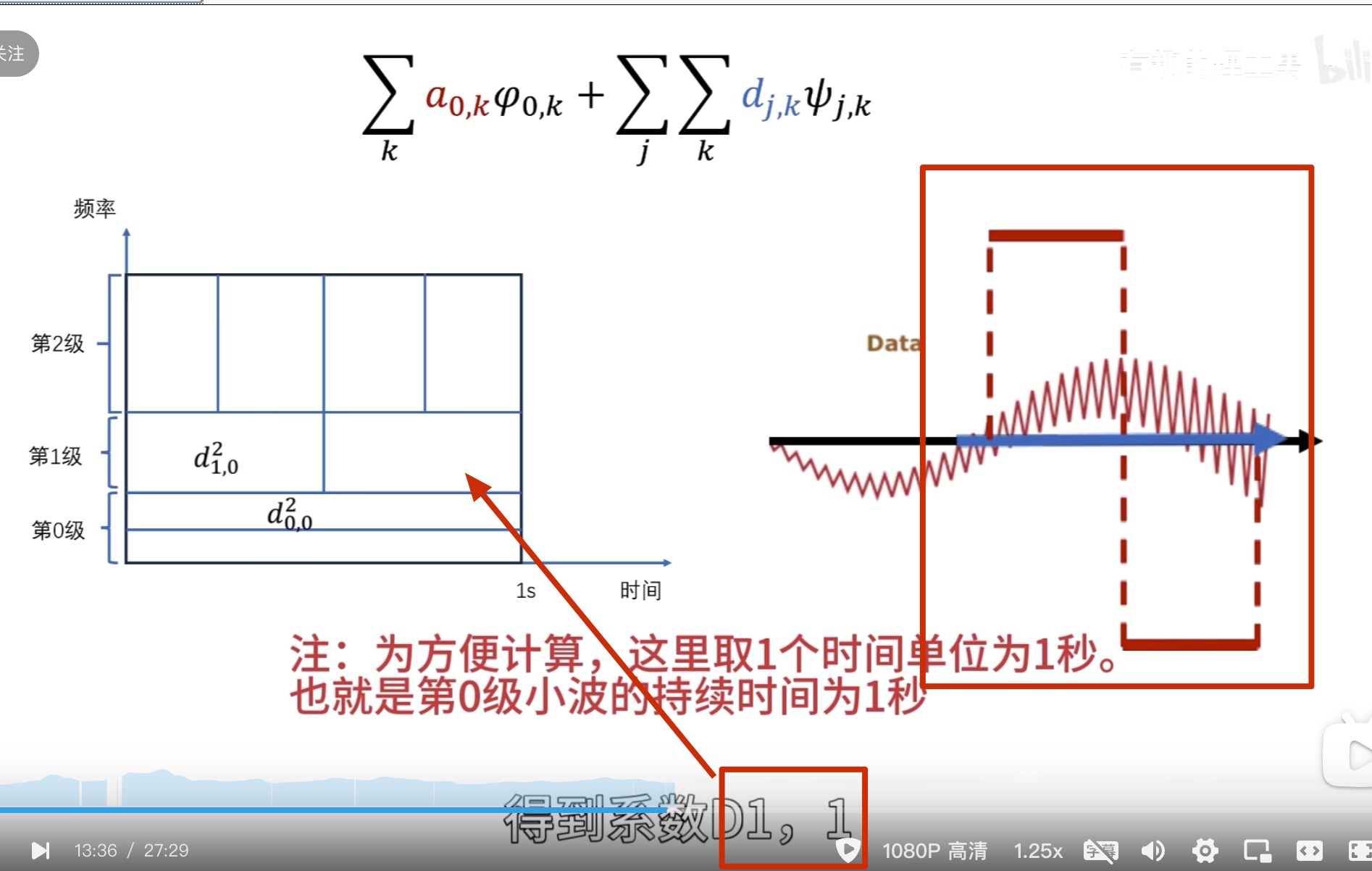

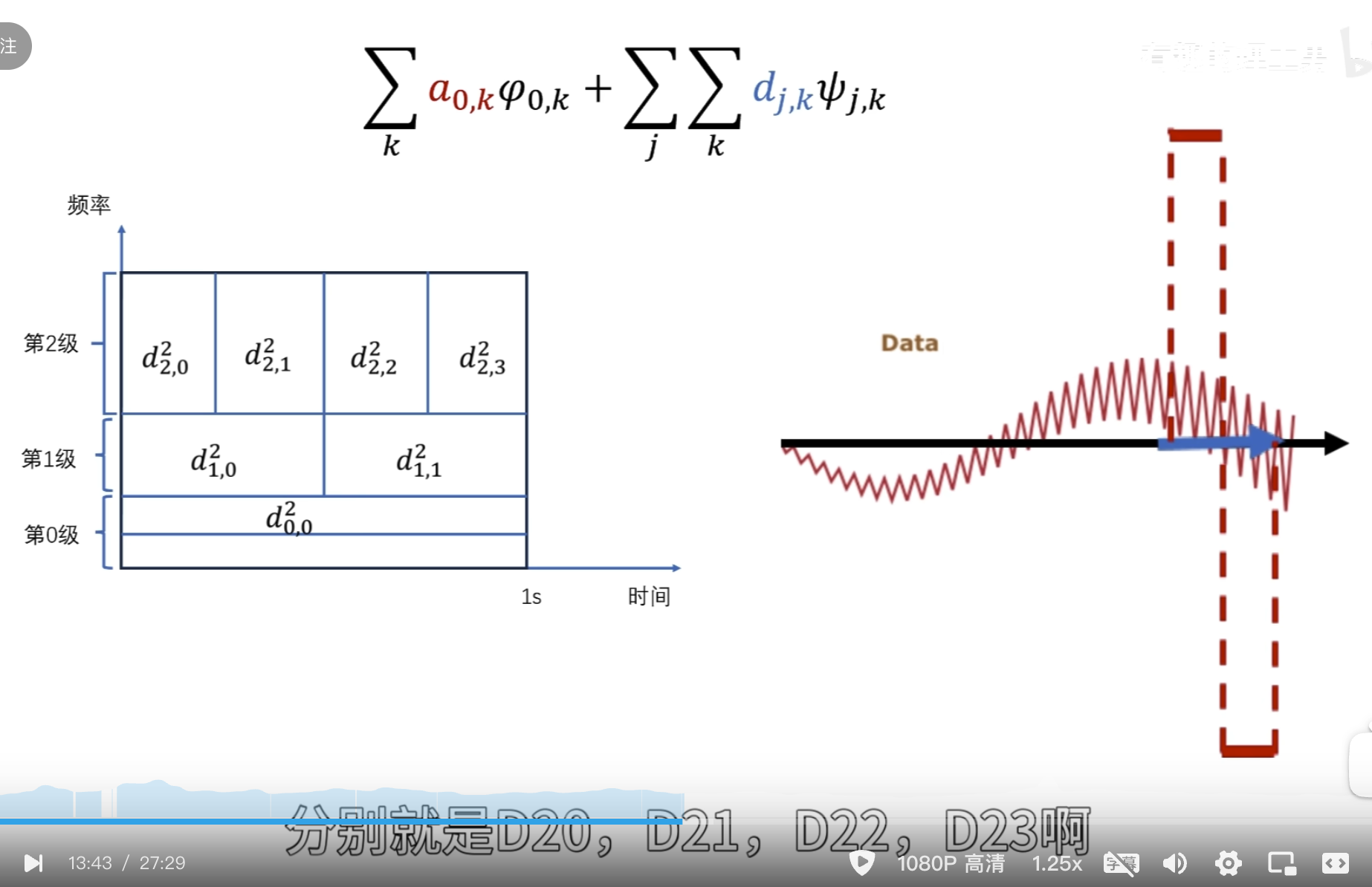

还有个问题,观察者的高低频怎么控制?——增加 a 尺度因子,a 越小表示频率越高

左边是目标函数,右边记录观察结果 ,a 越小表示频率越高

可以看到 50 这个频率的能量比较多

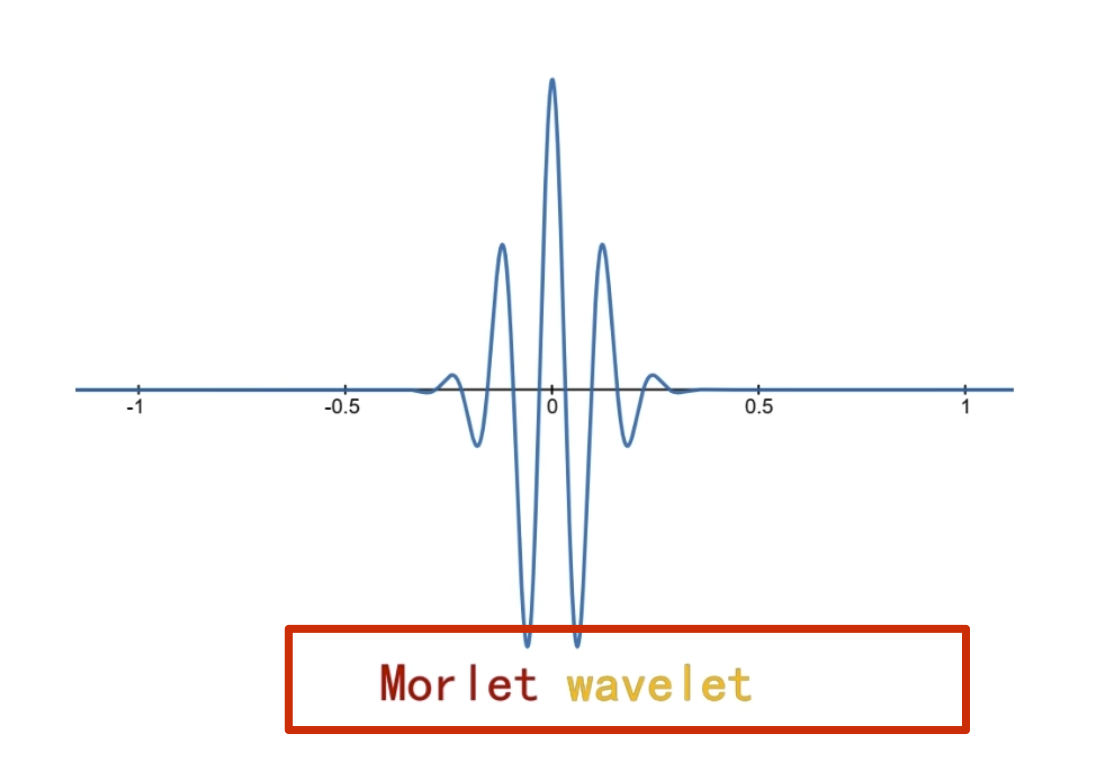

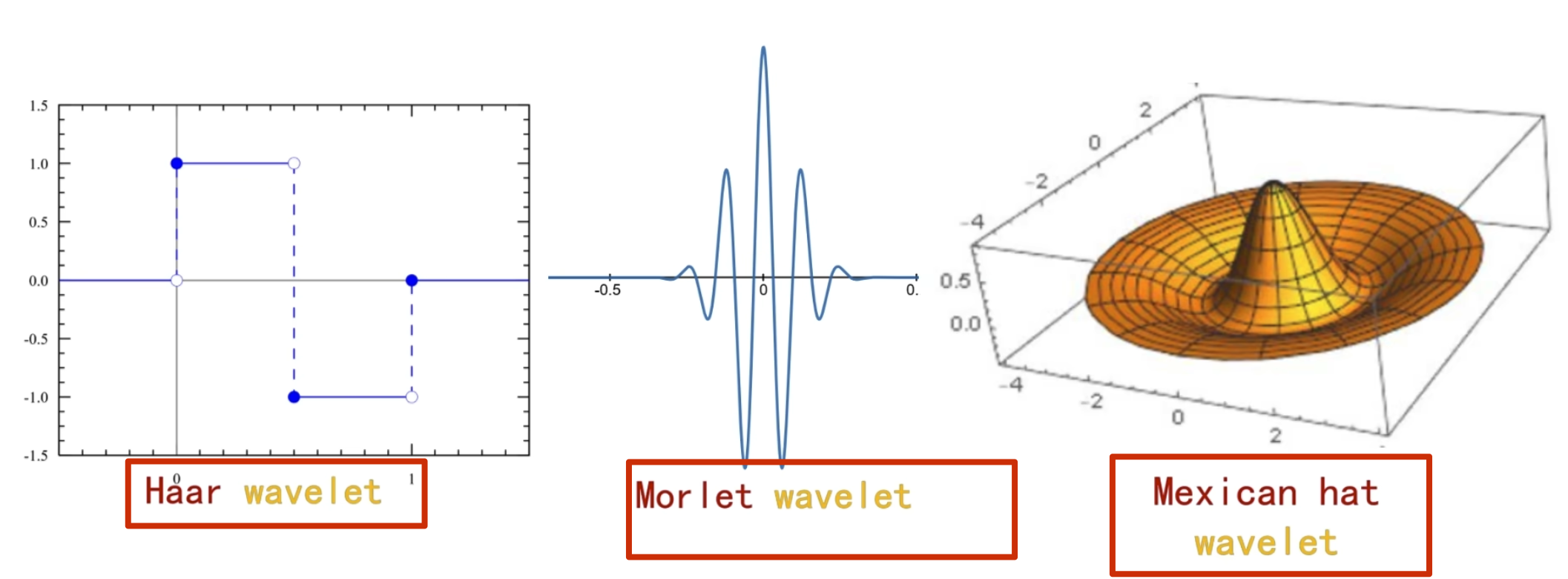

这些一系列在时间轴上做了局域化的观察者就叫小波

小波函数其实是一个非常庞大的家族,根据应閛场景和所䴉的特性不同,所选的小波也不同

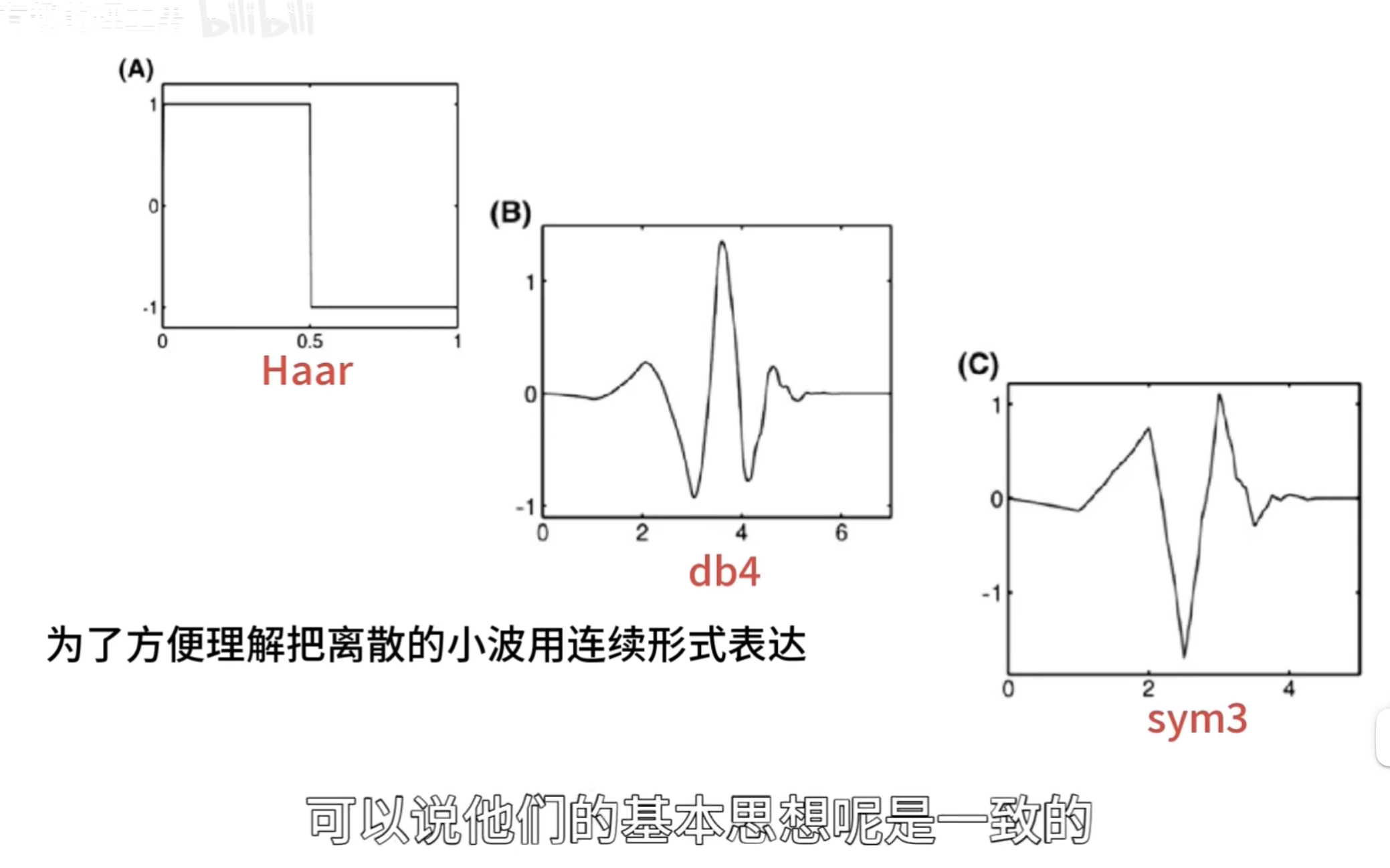

对于小波变换就是把一个信号分解成一系列的小波,这里时候,也许就会问,小波变换的小波是什么啊,定义中就是告诉我们小波,因为这个小波实在是太多,一个是种类多,还有就是同一种小波还可以尺度变换,但是小波在整个时间范围的幅度*均值是0,具有有限的持续时间和突变的频率和振幅,可以是不规则,也可以是不对称,很明显正弦波就不是小波,什么的是呢,看下面几个图就是

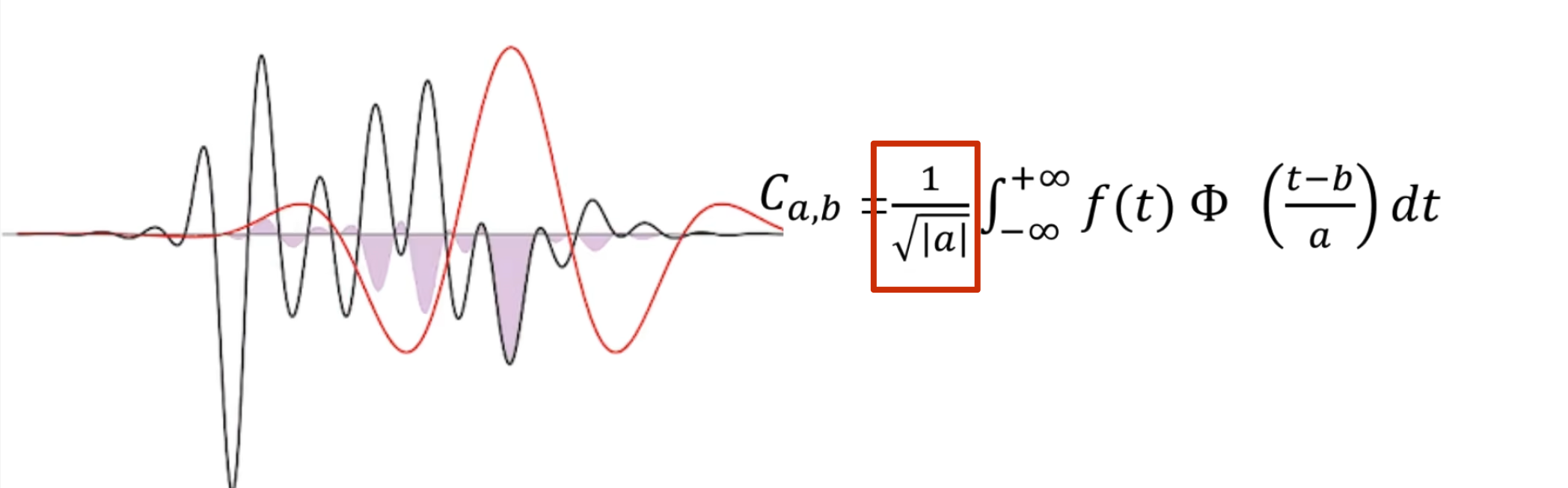

最终计算相似度的公式如下(因为能量不同,所以还是需要归一化)

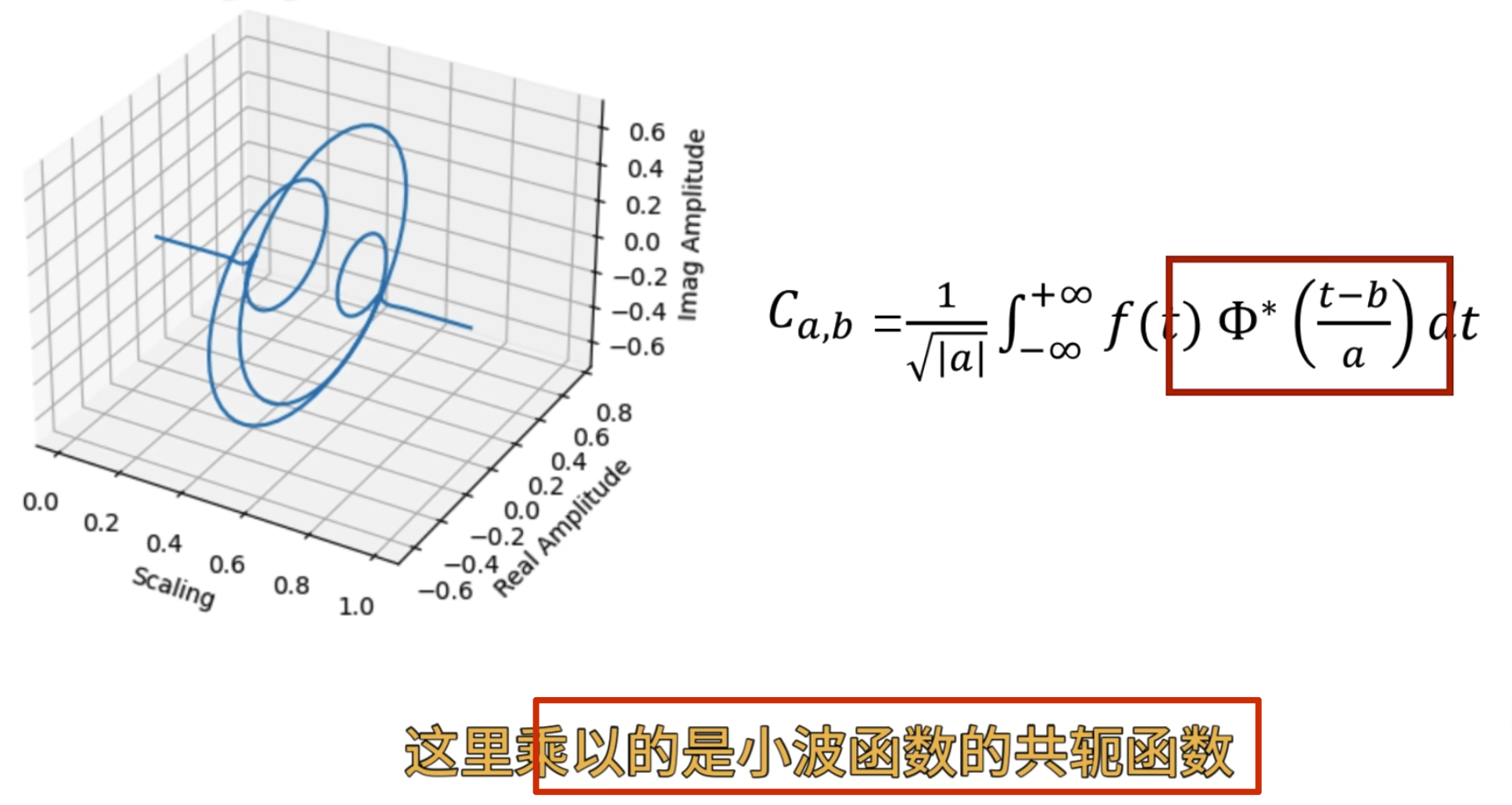

同时上面 演示的还是实函数的小波变换,对于虚函数的小波变换如下

再从另卷积的角度看小波变换:

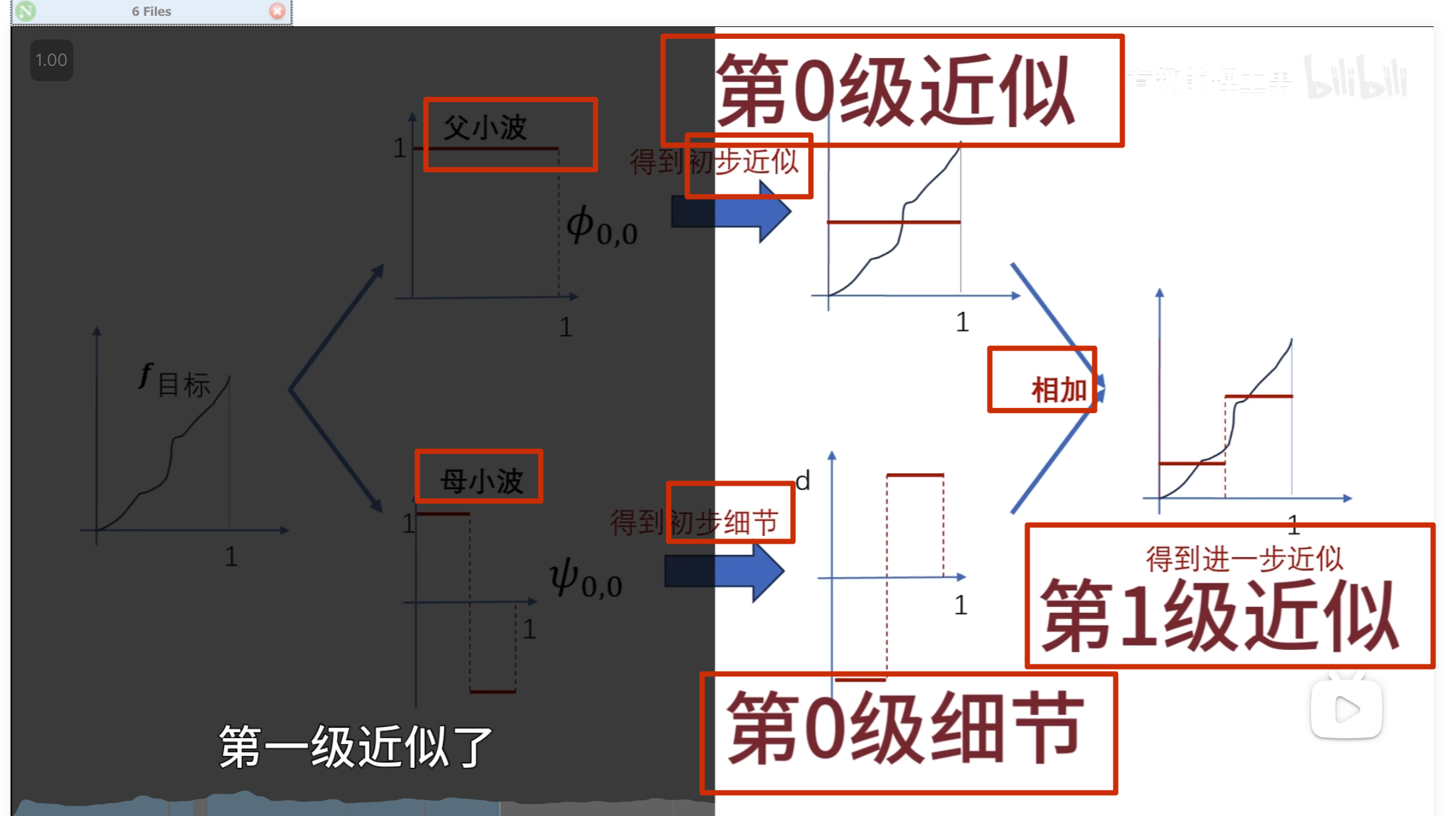

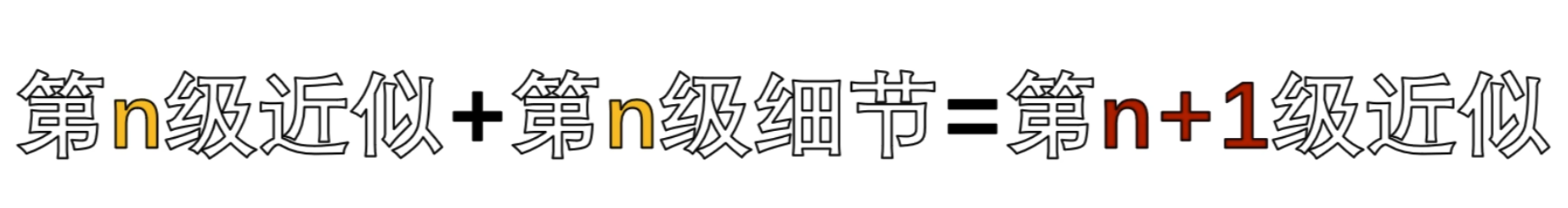

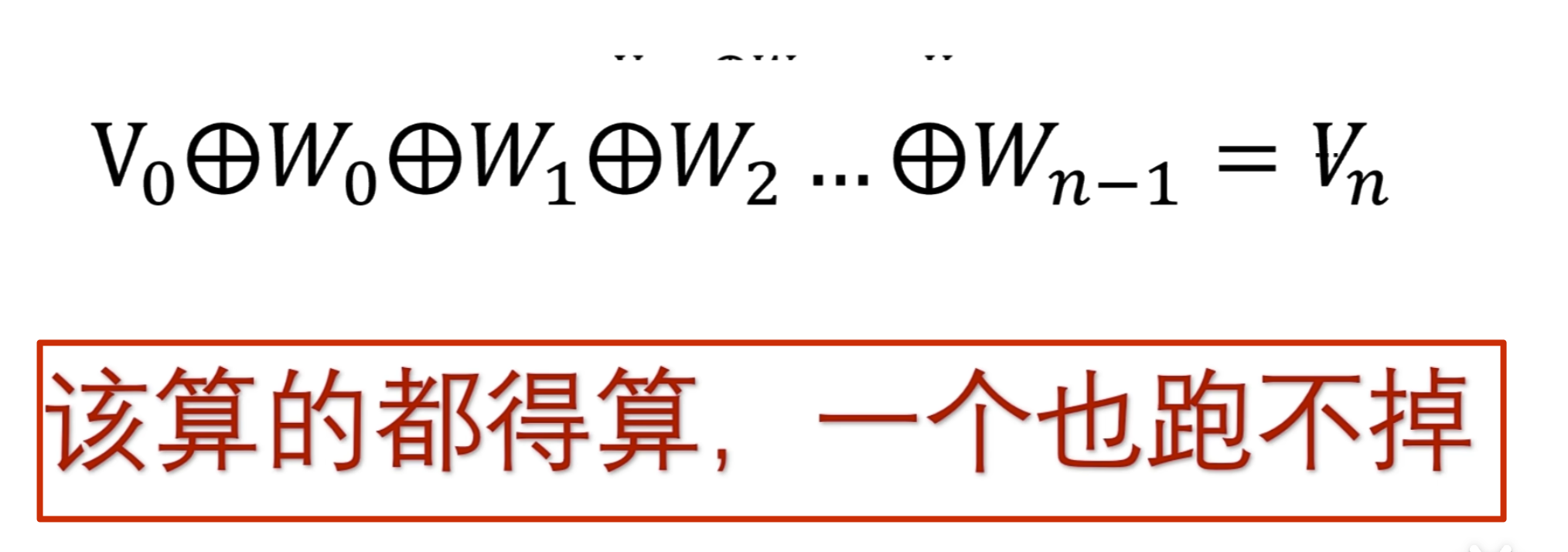

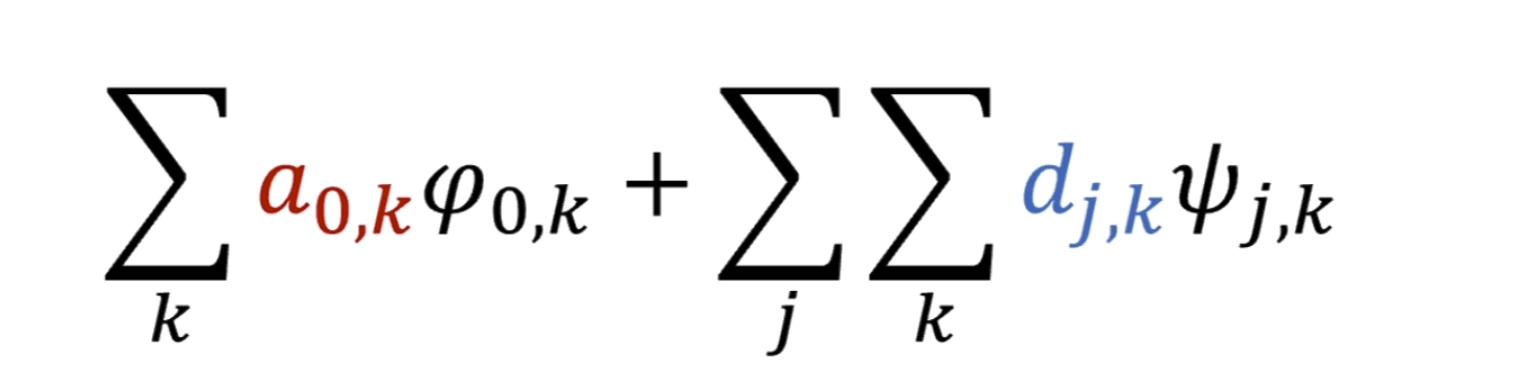

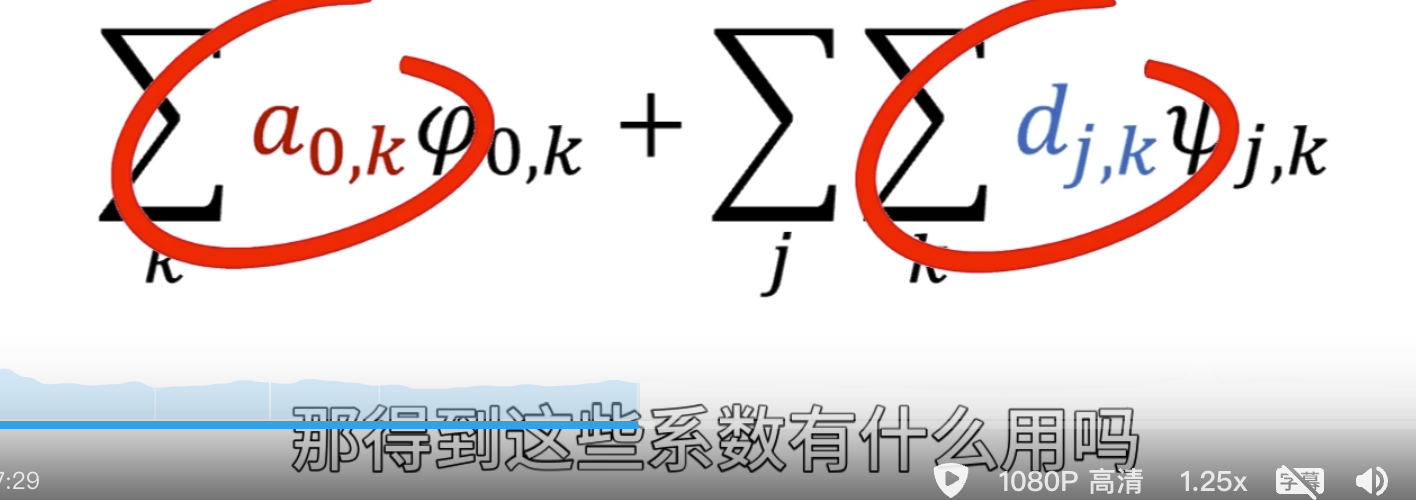

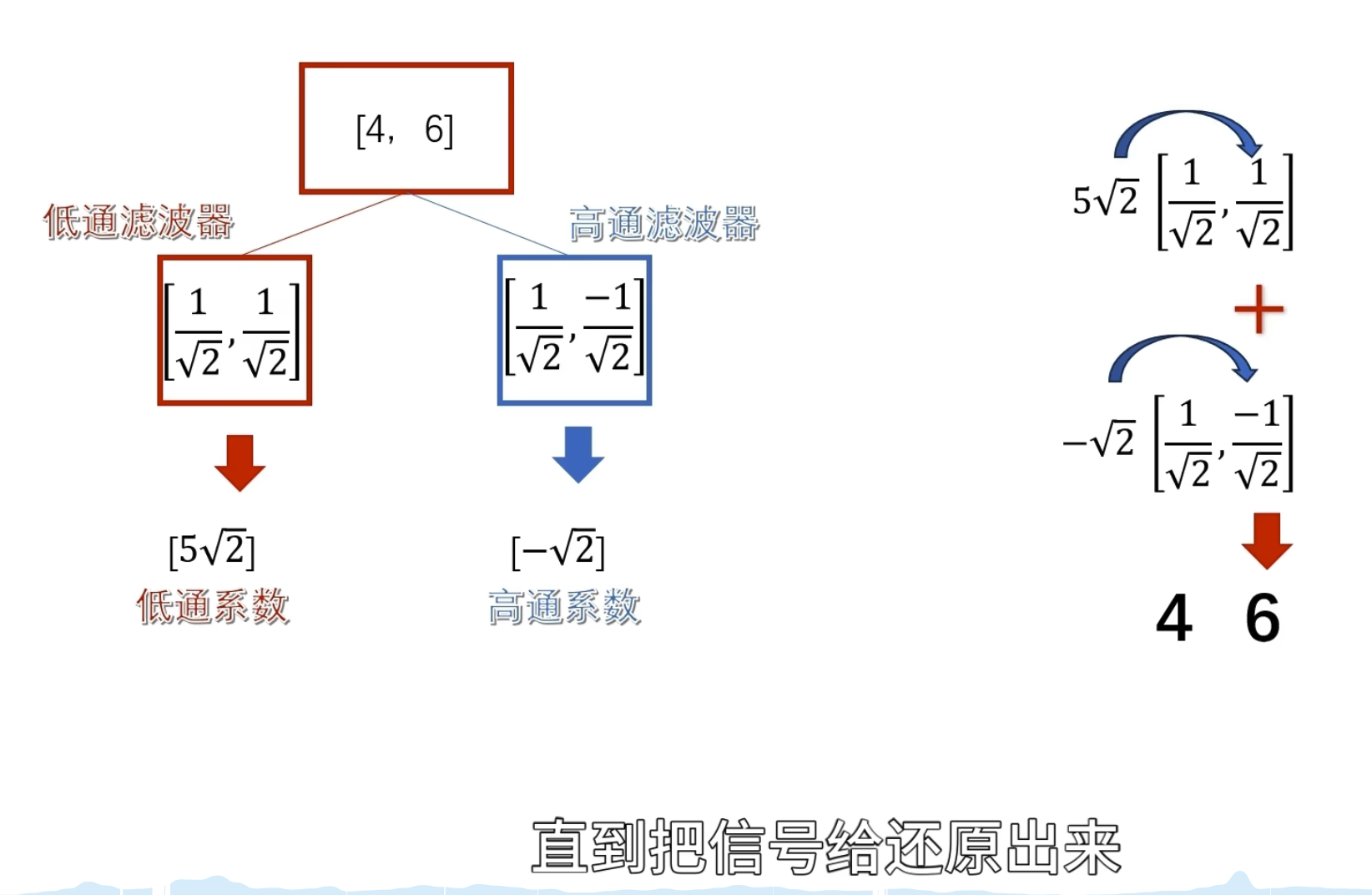

小波变换应用——重建目标函数

上面只是观察了一个序列的相似程度,但是有什么用呢? ——将目标函数给还原回来

上面观察者的使命还没有完成,因为我们不会无缘无故地观察一个东西的

当我们要还原目标的时候,用这些柔数乘以观察者再把他们给加起来啊,就可以对目标进行完美的复制还原了

这种公式其实是观察者对目标 进行了重构,观察者同时叉是建造者

关键在于可以在重构的时候动手脚,可以把你认为的无用的观察者给抹掉,或者是对某些观察者进行有目的的加强,然后再重构

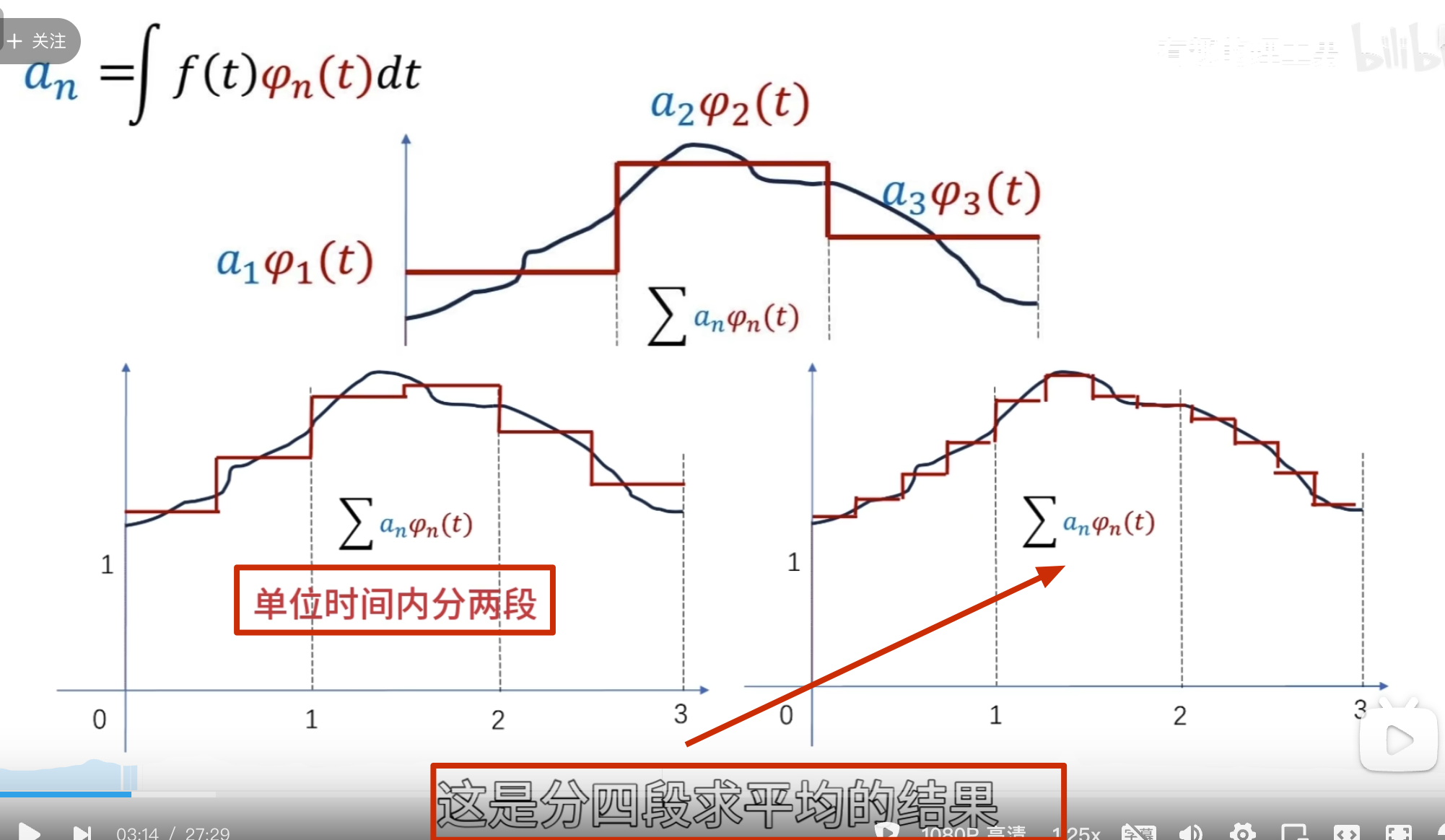

要把下面这条曲线重新绘制出来怎么做?

方法一:轮廓加细节

方法二:

这就是 haar 小波

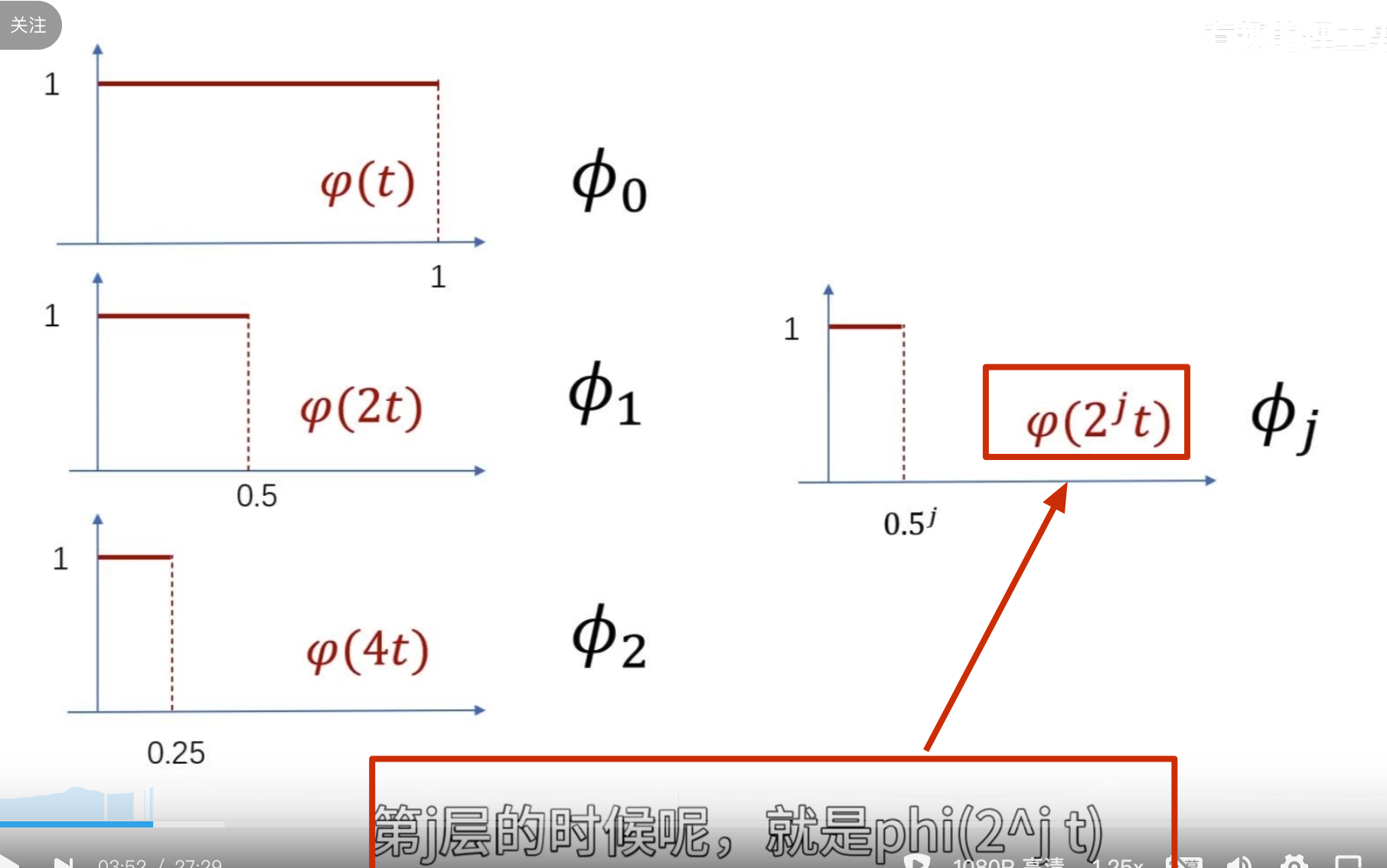

小波函数需要满足时间局域化的要求

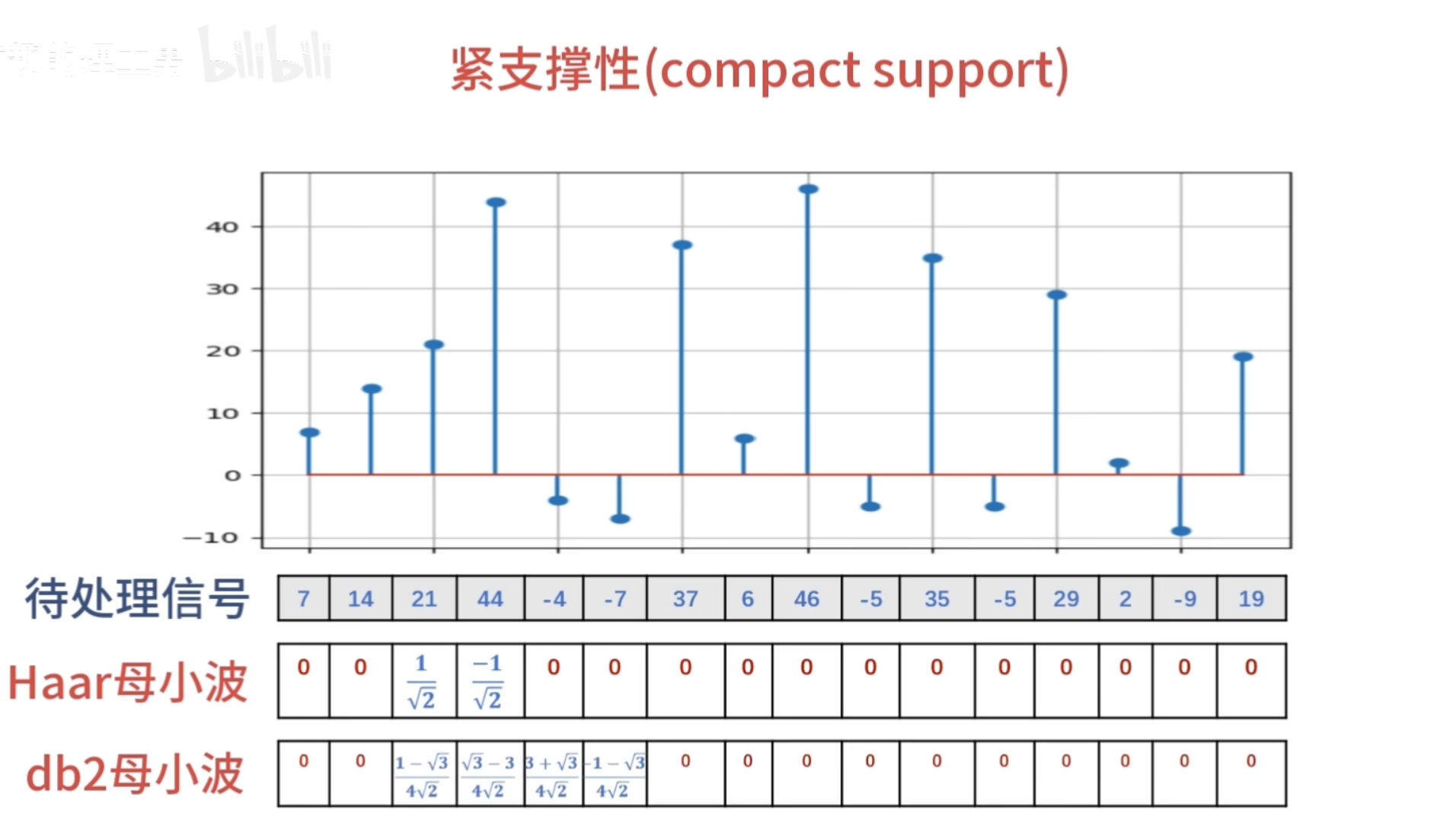

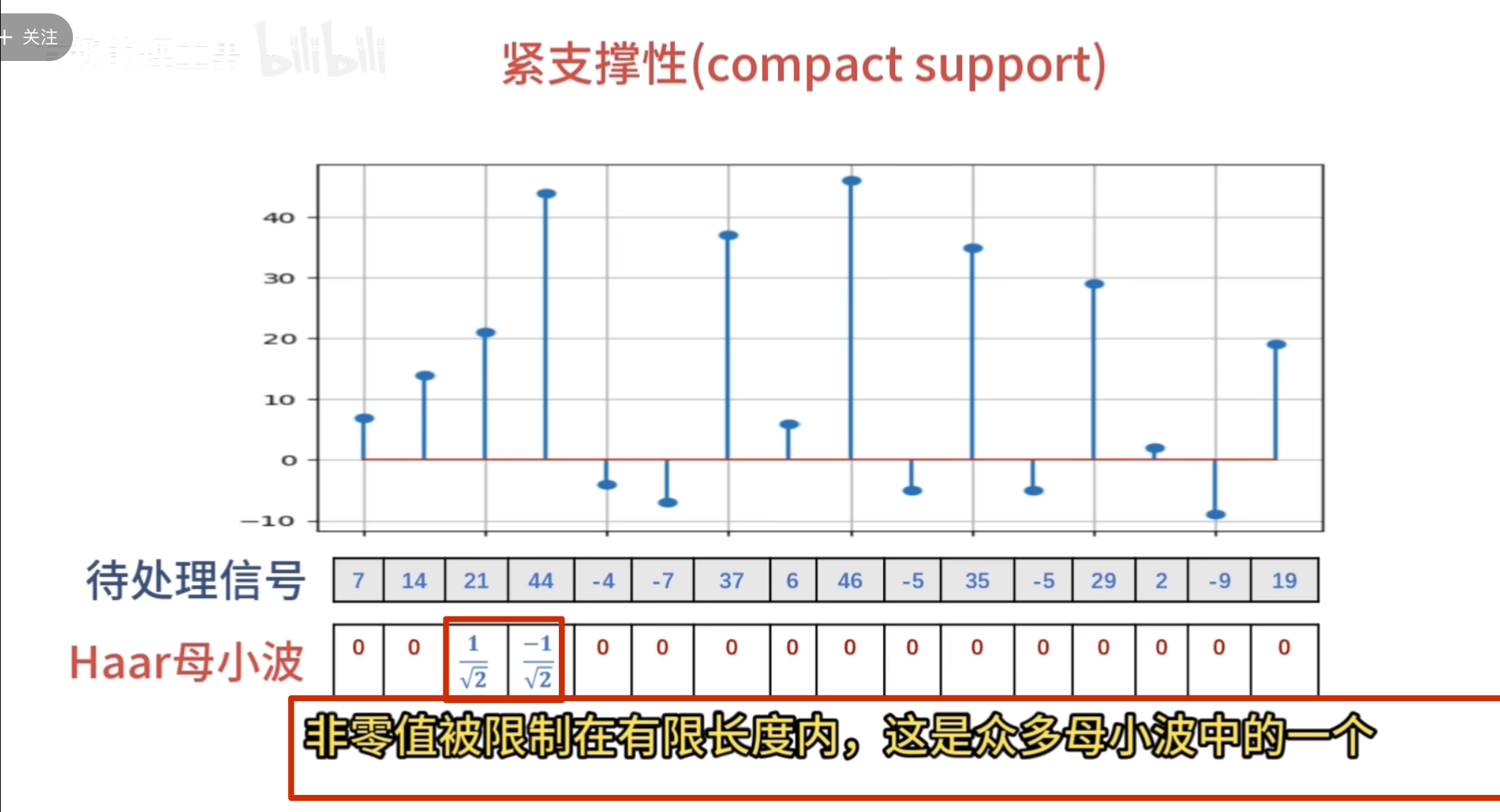

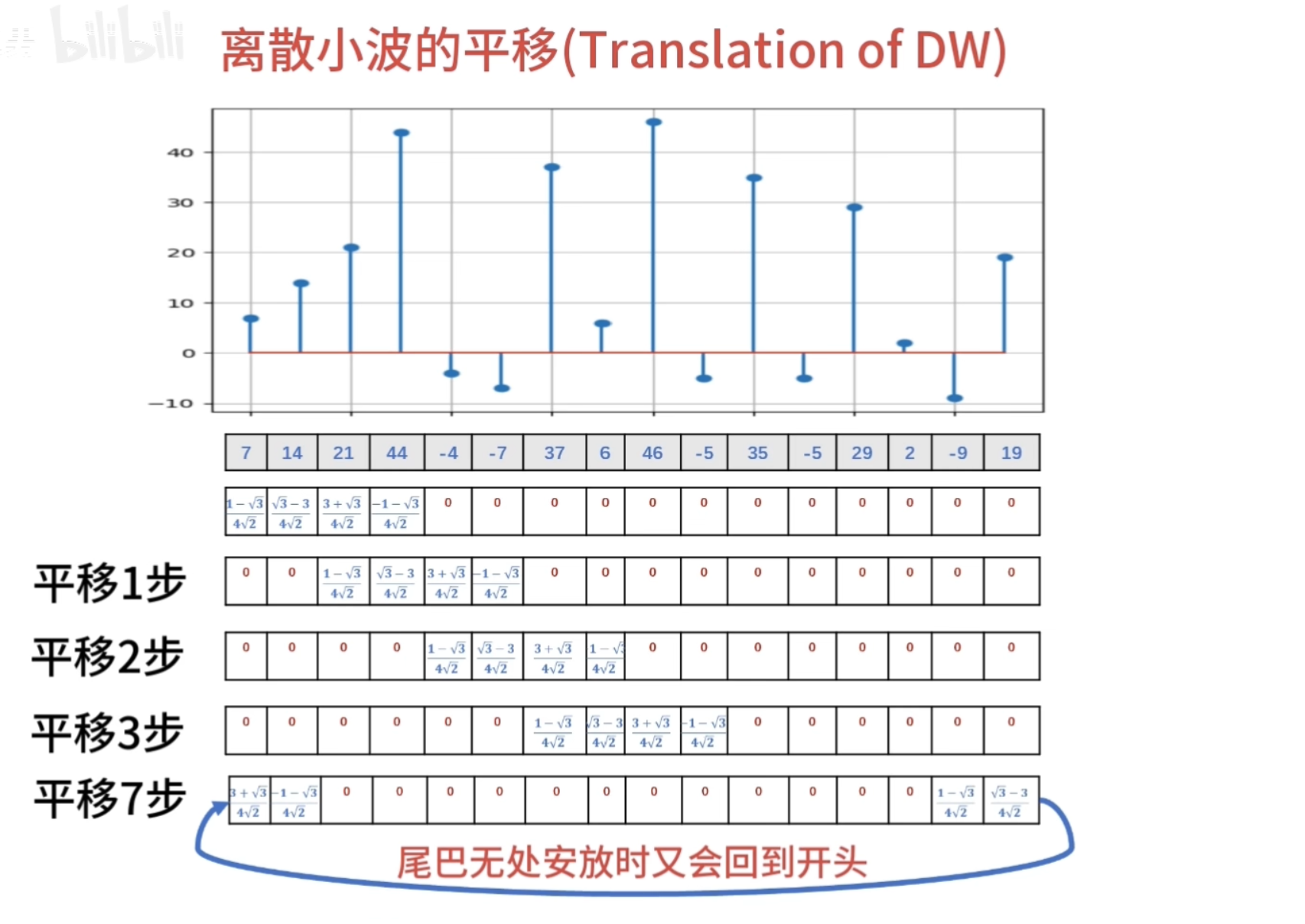

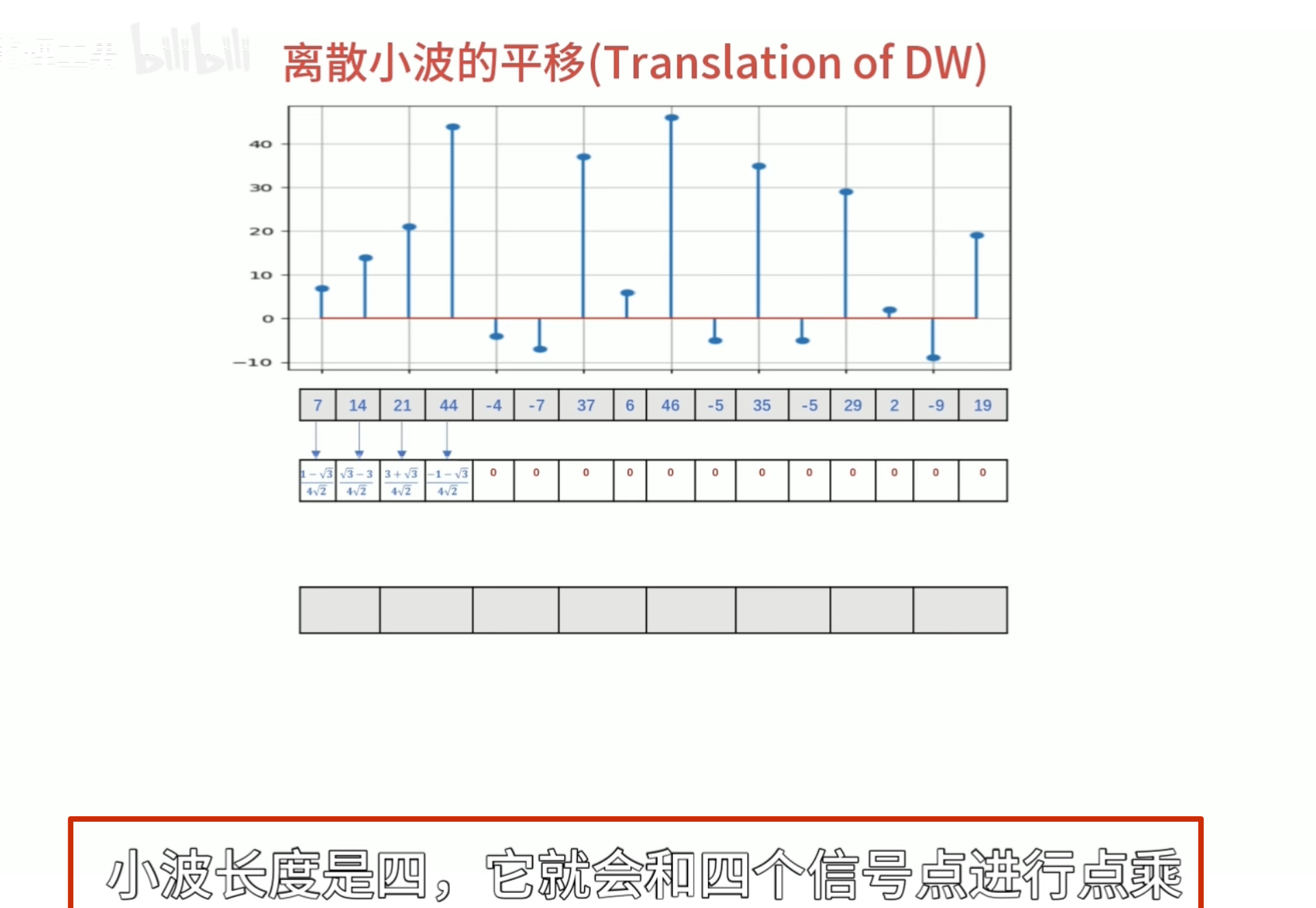

这种仅在某个区域有值,其他区域为 0的性质 数学术语叫做紧支撑性

细化的方法采用二分法

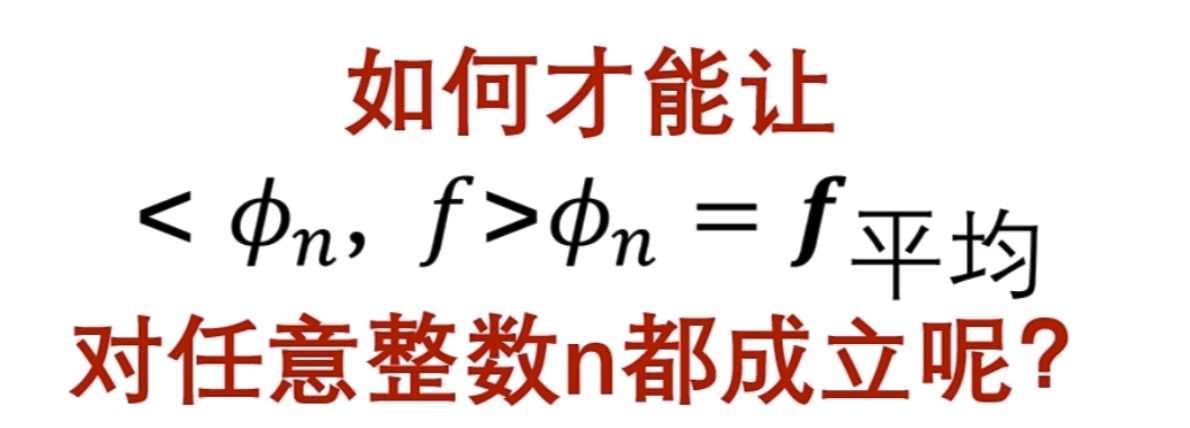

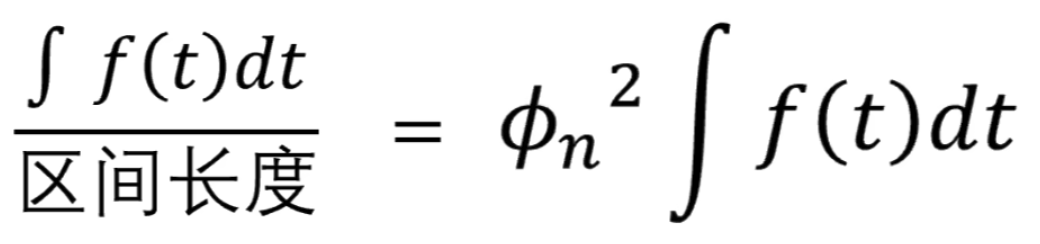

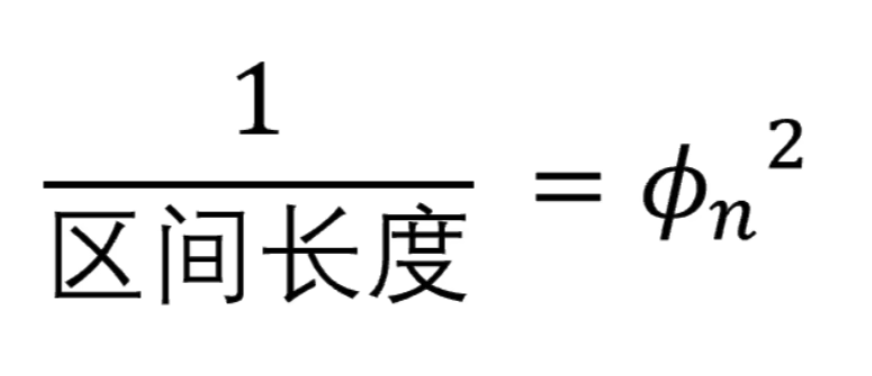

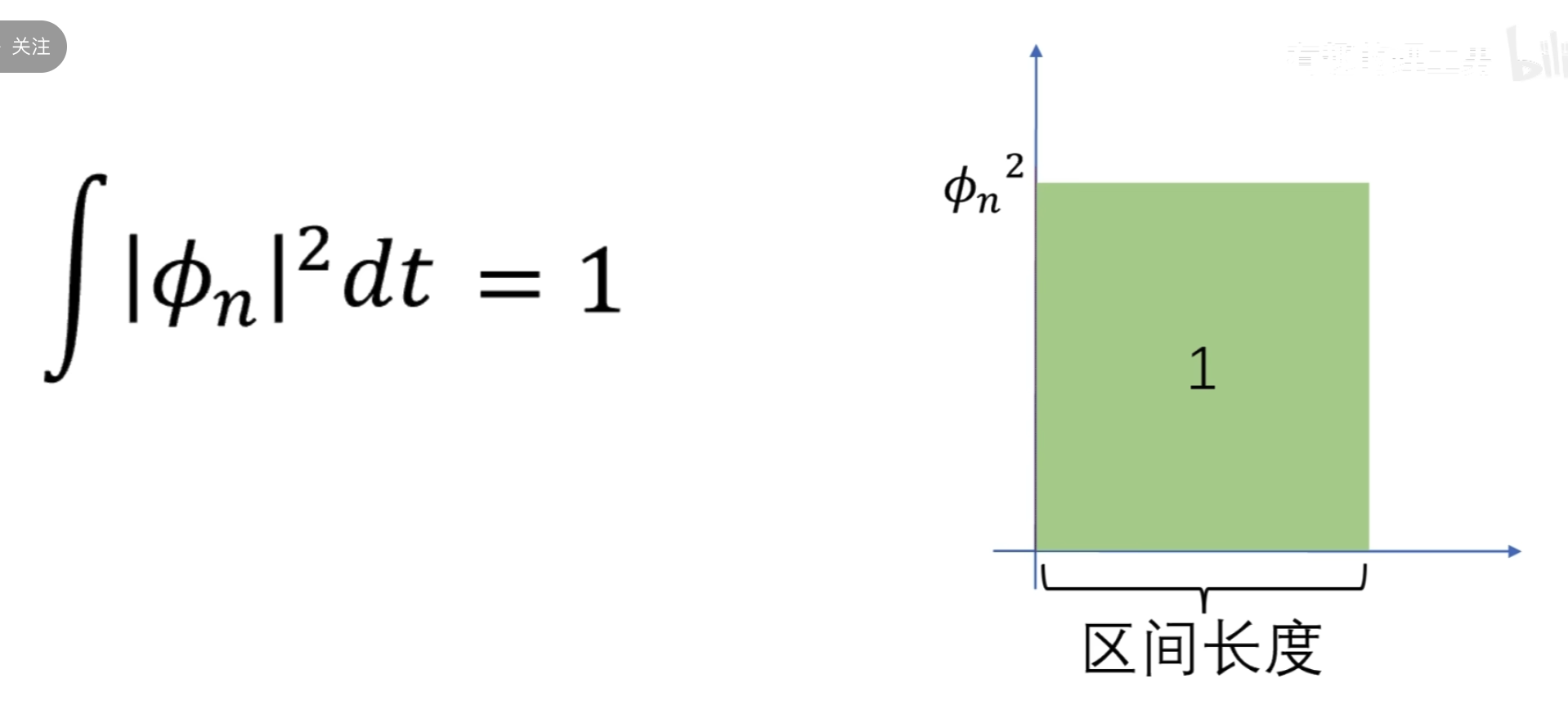

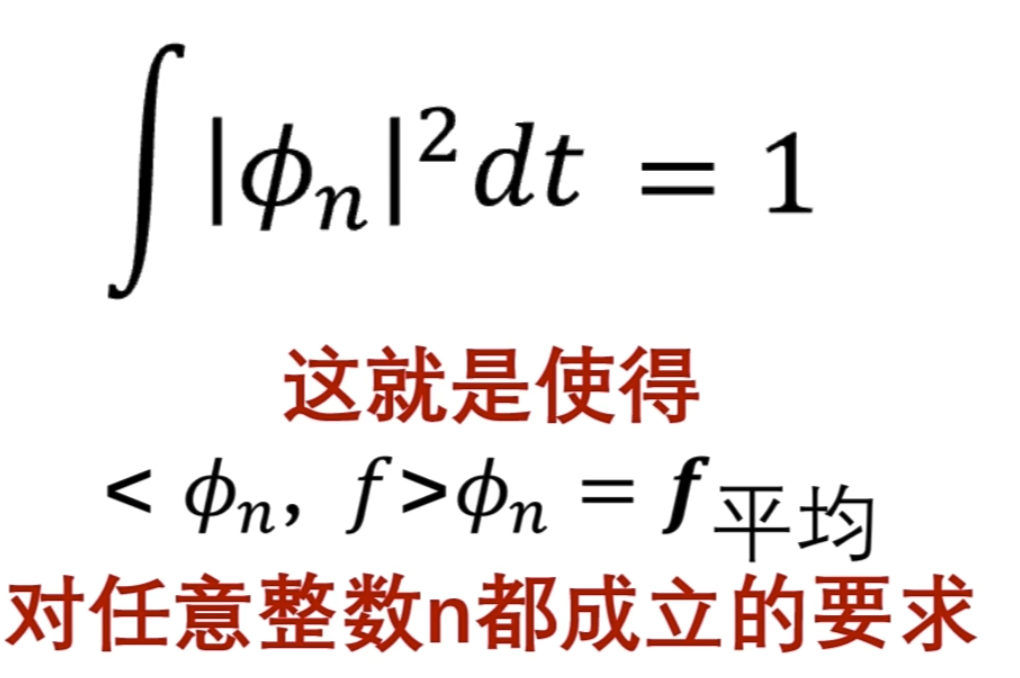

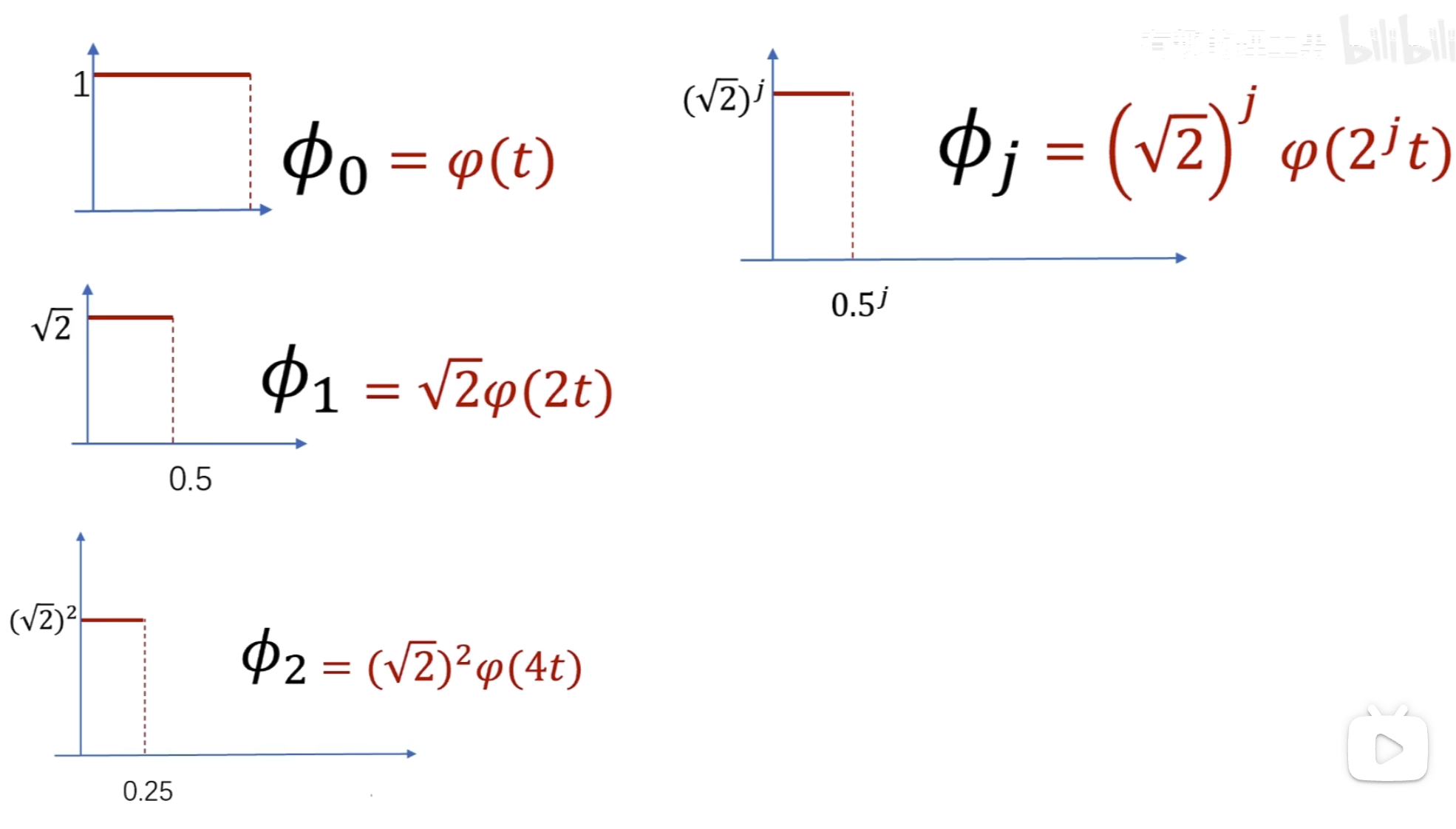

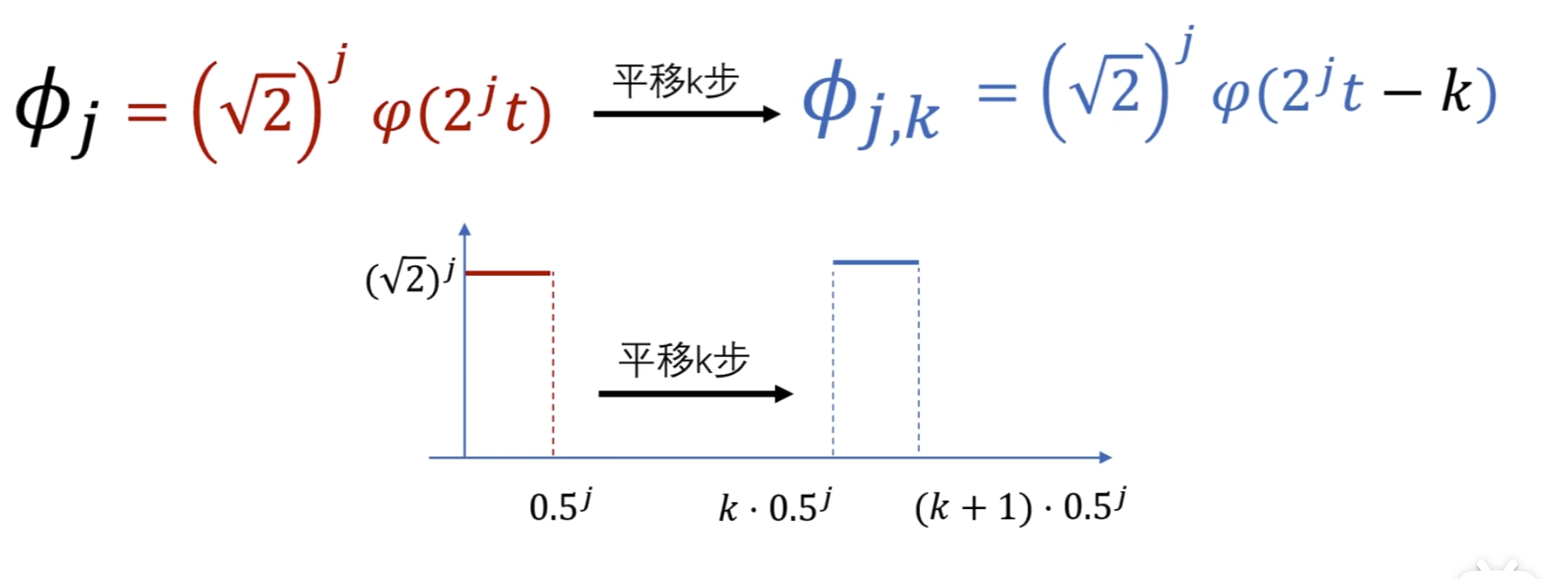

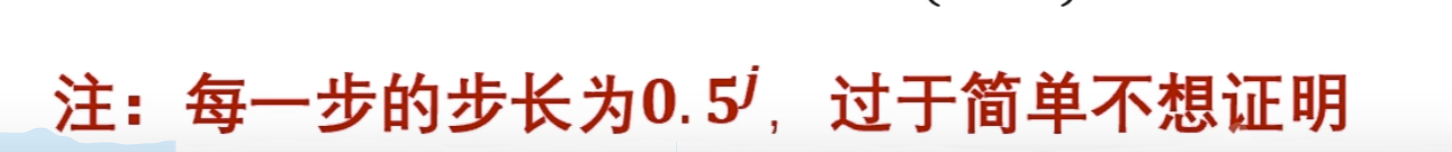

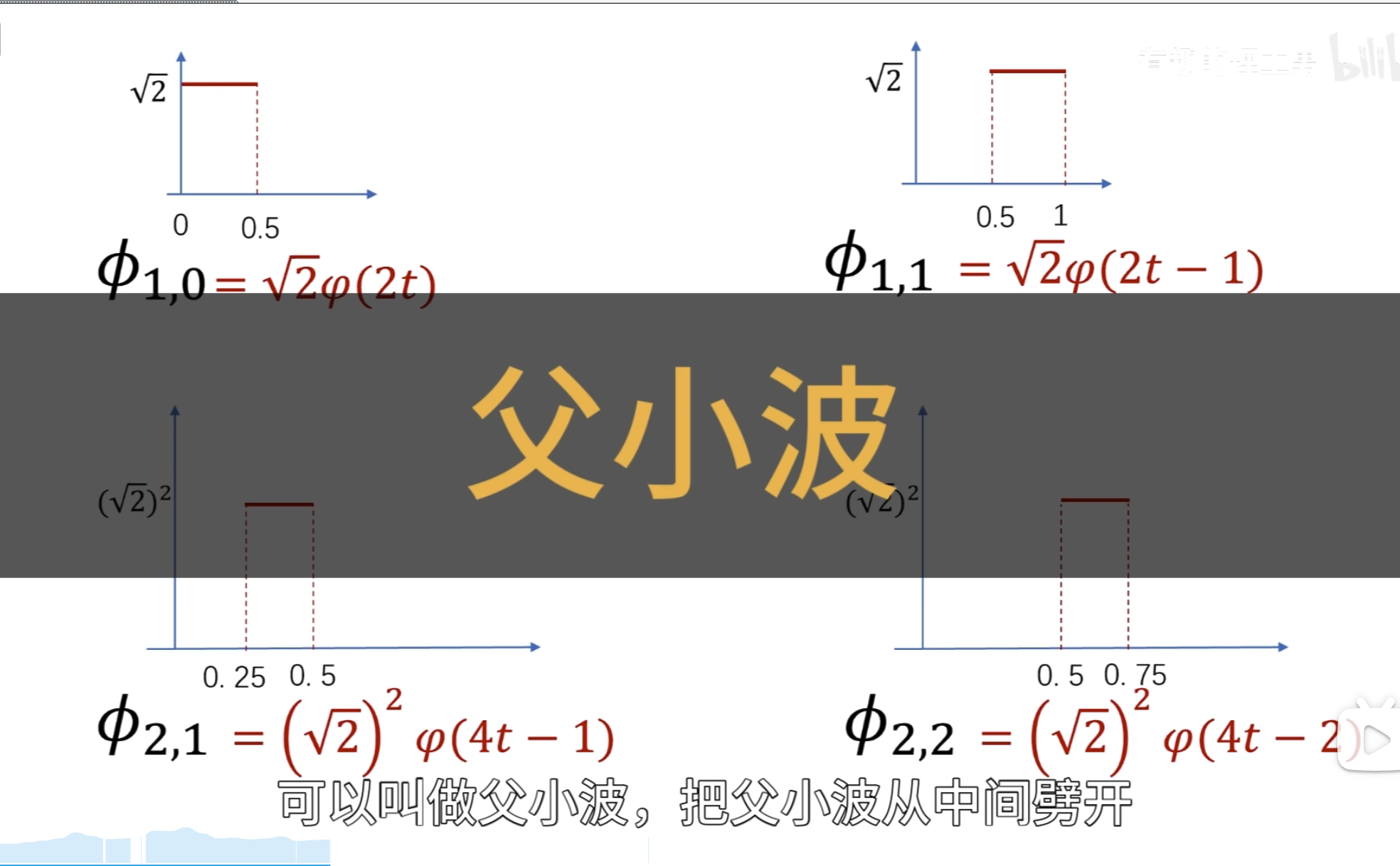

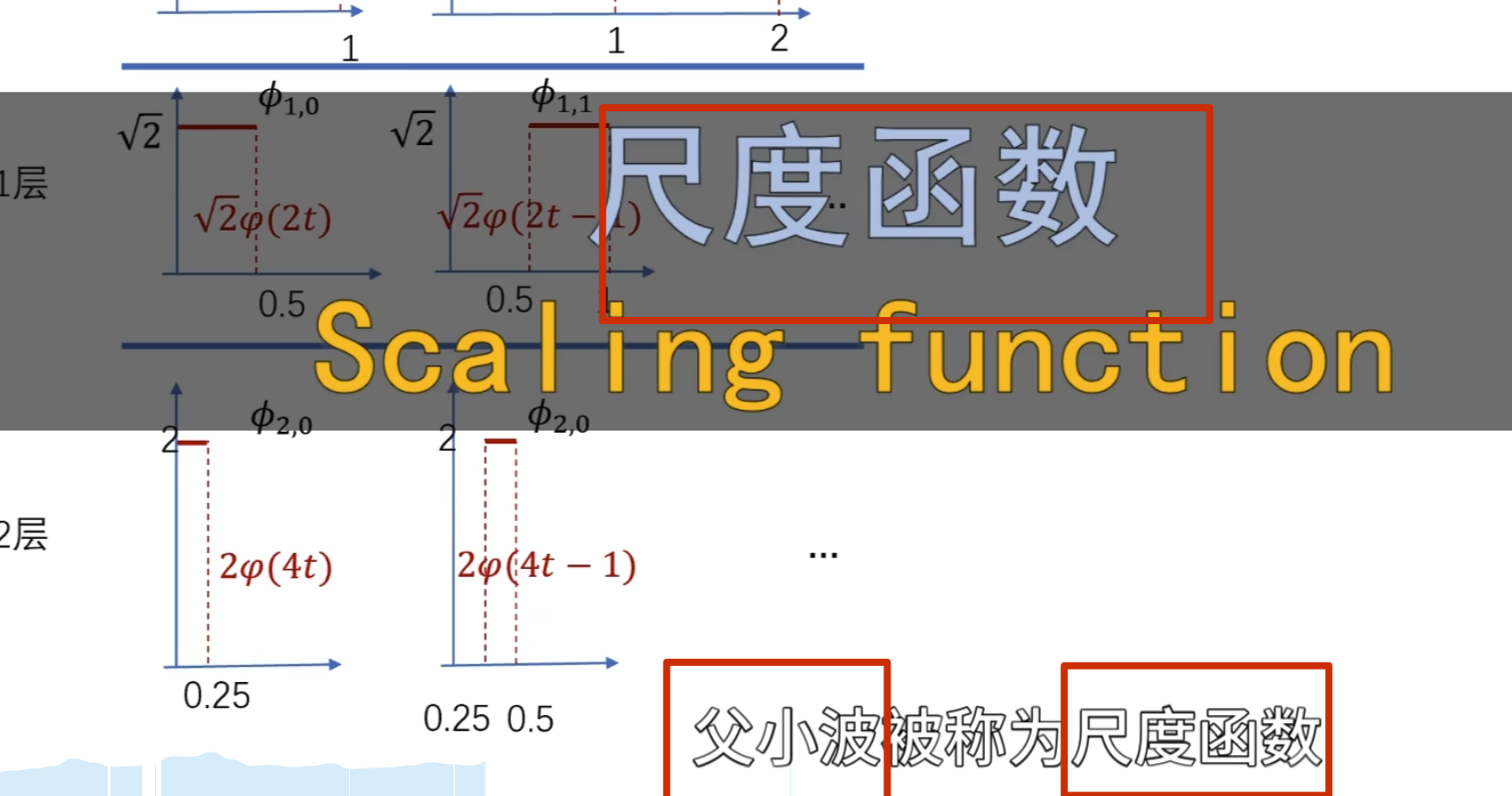

所以这里的 \(\phi_n\)的公式有问题,需要求\(\phi_n\)的公式(重点啊,不然后面看不懂了)

,可以提出来

,可以提出来

所以可以得出

所以归一化后有

如下所示

给个例子看是如何解决这个问题的:

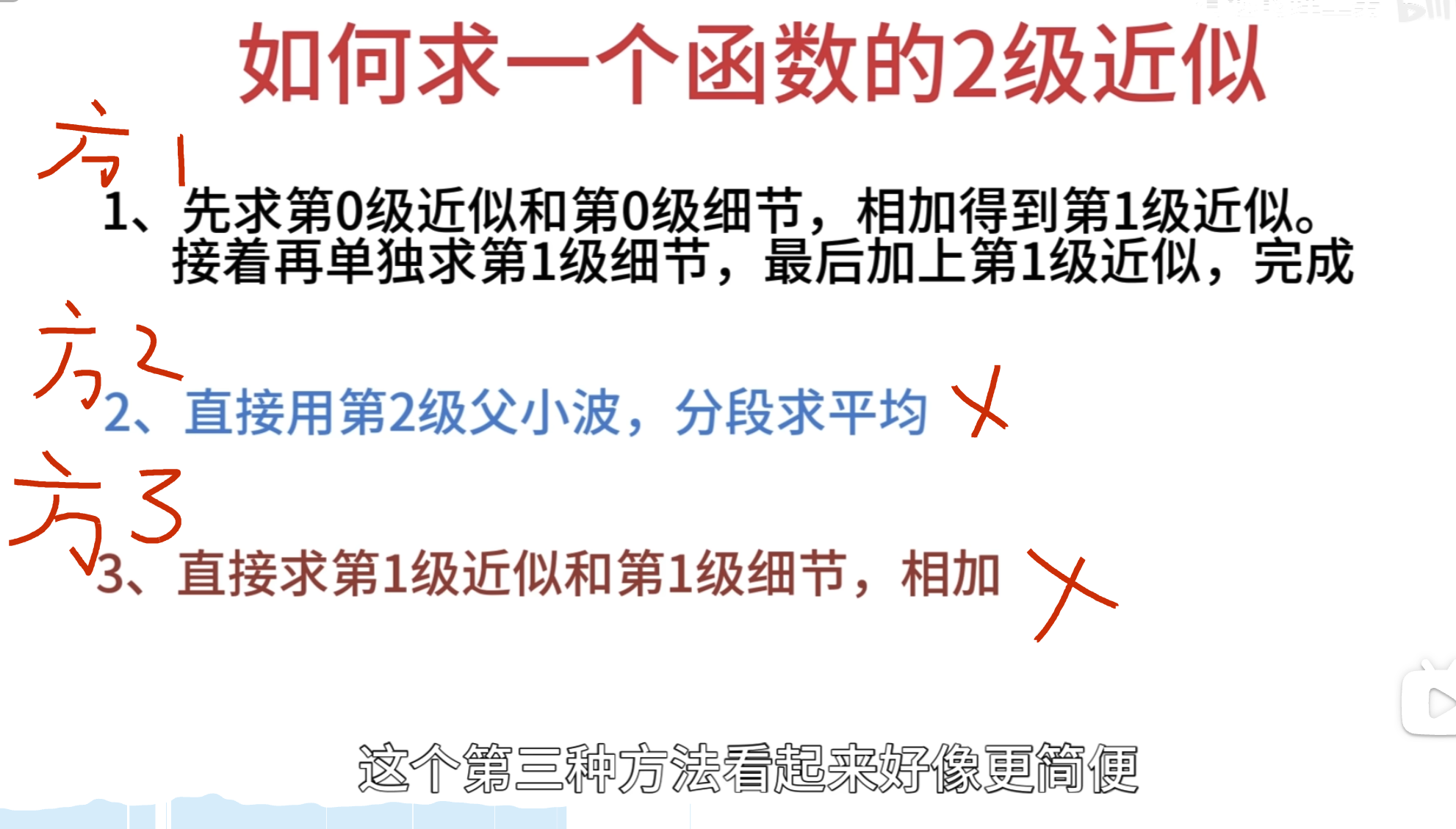

不用第三种方法,原因如下:

可以得到

这里按第三种方法其实并没有更快

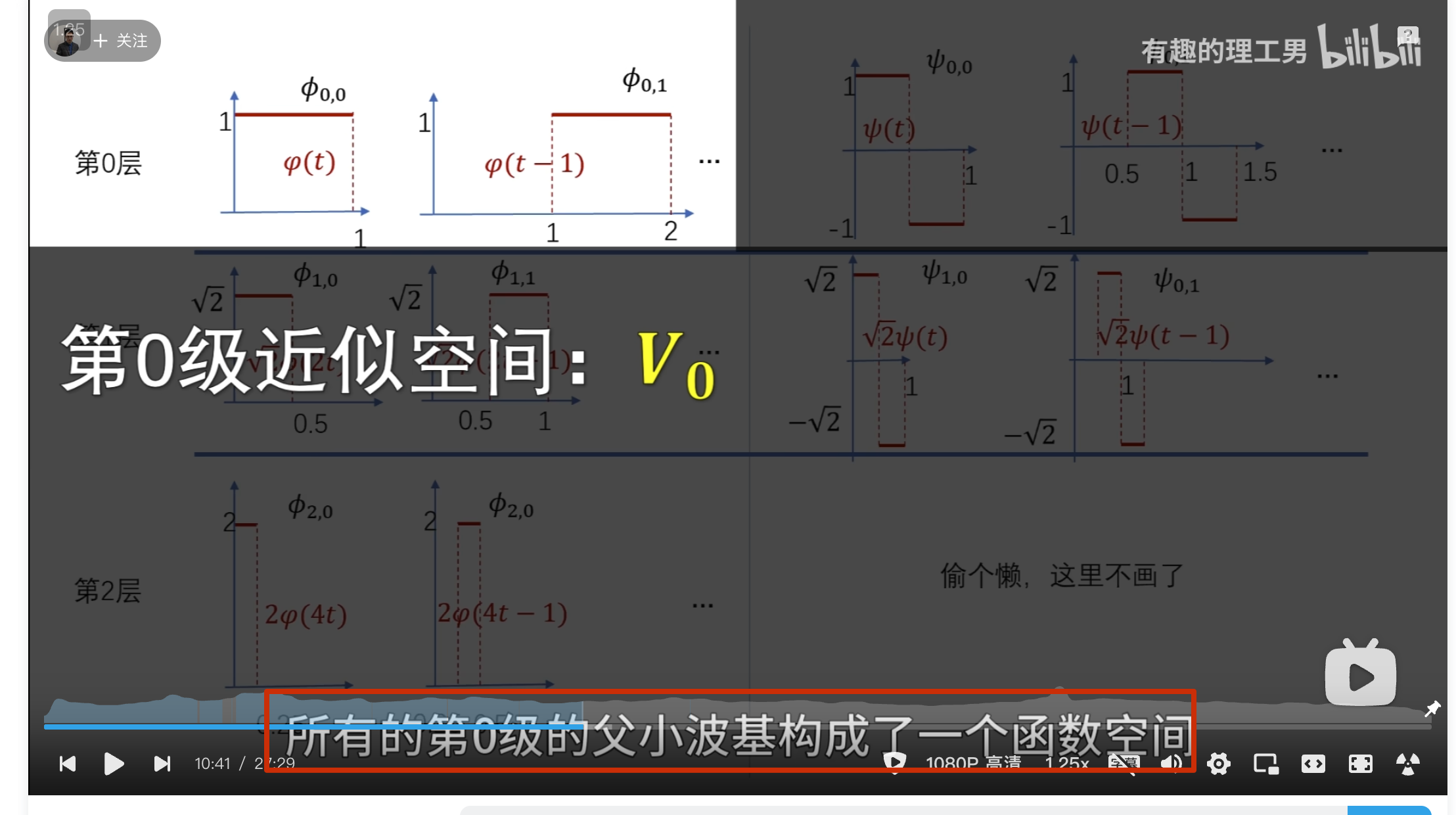

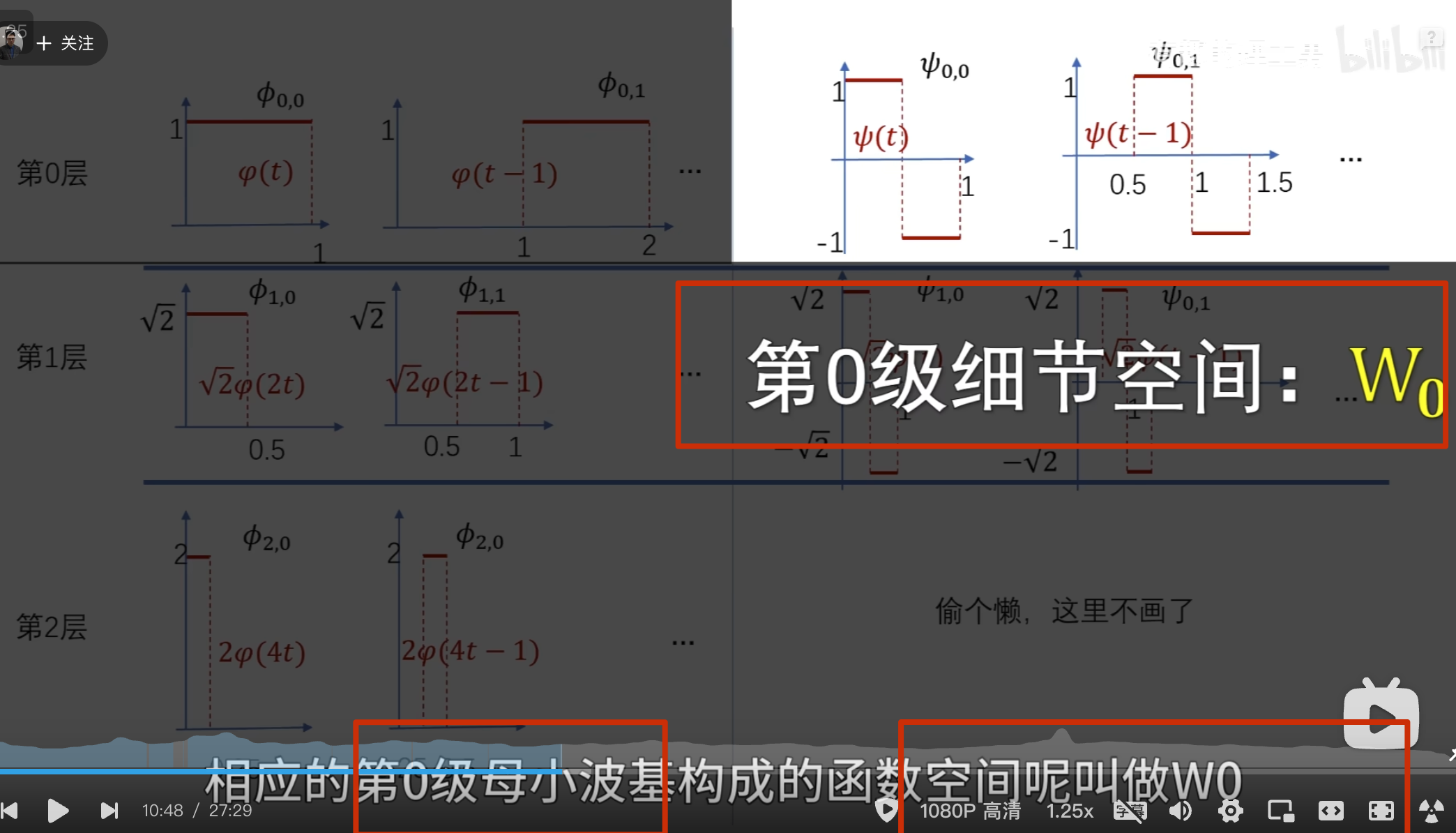

下面的没啥用,但是后面高低通滤波的时候要用到

点乘结果

点乘结果

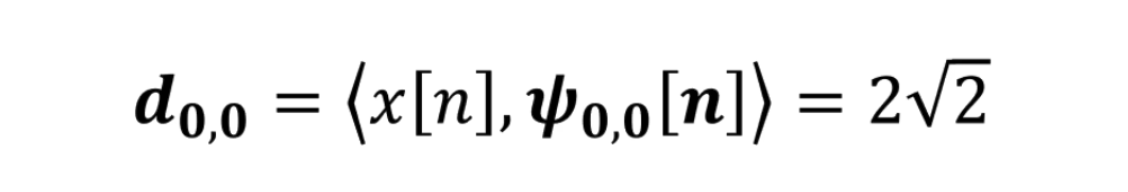

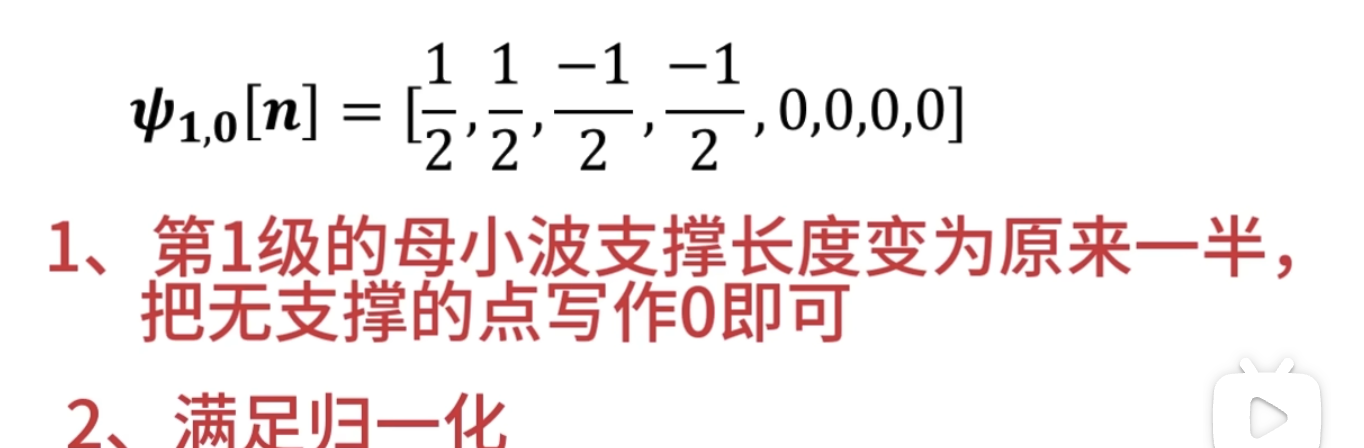

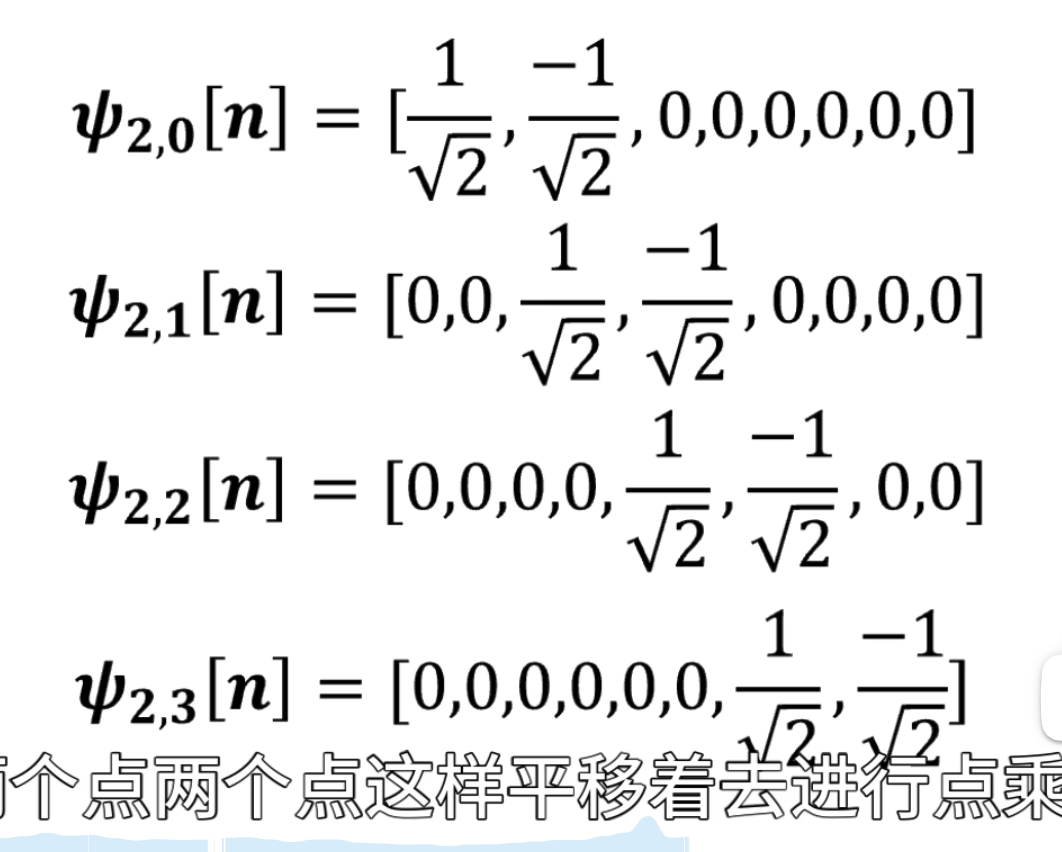

第二级母小波

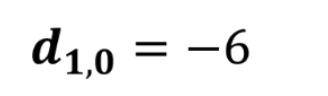

点乘结果

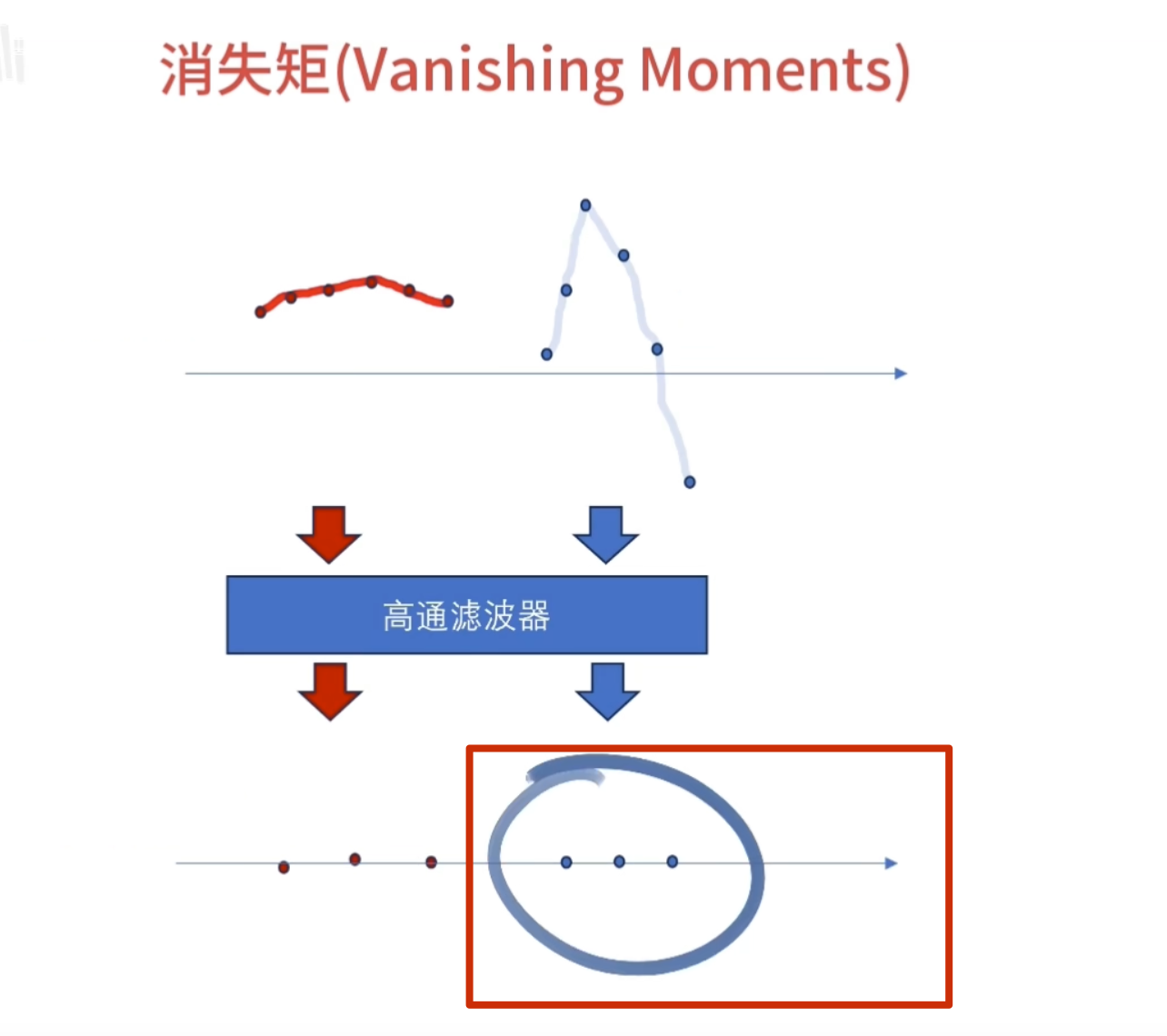

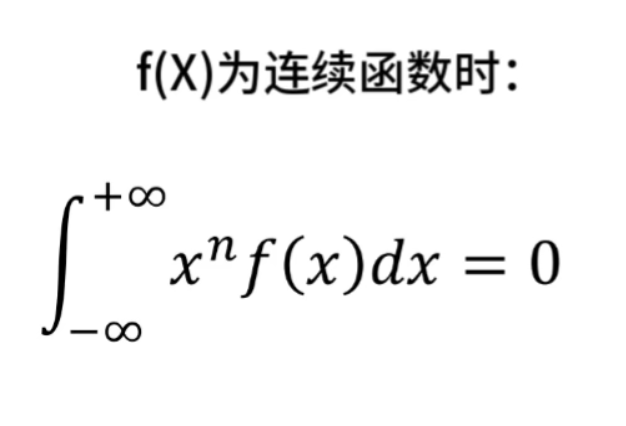

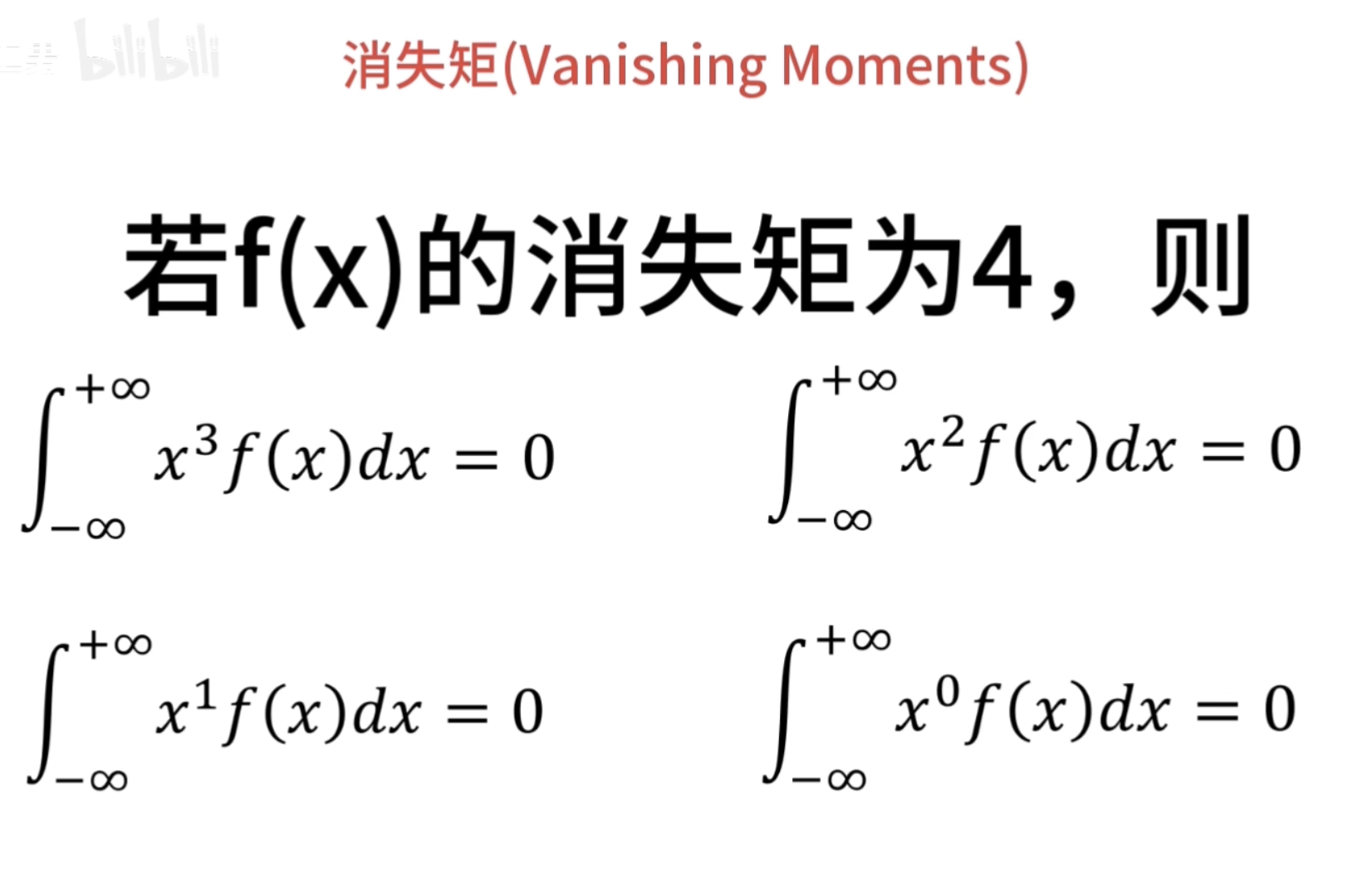

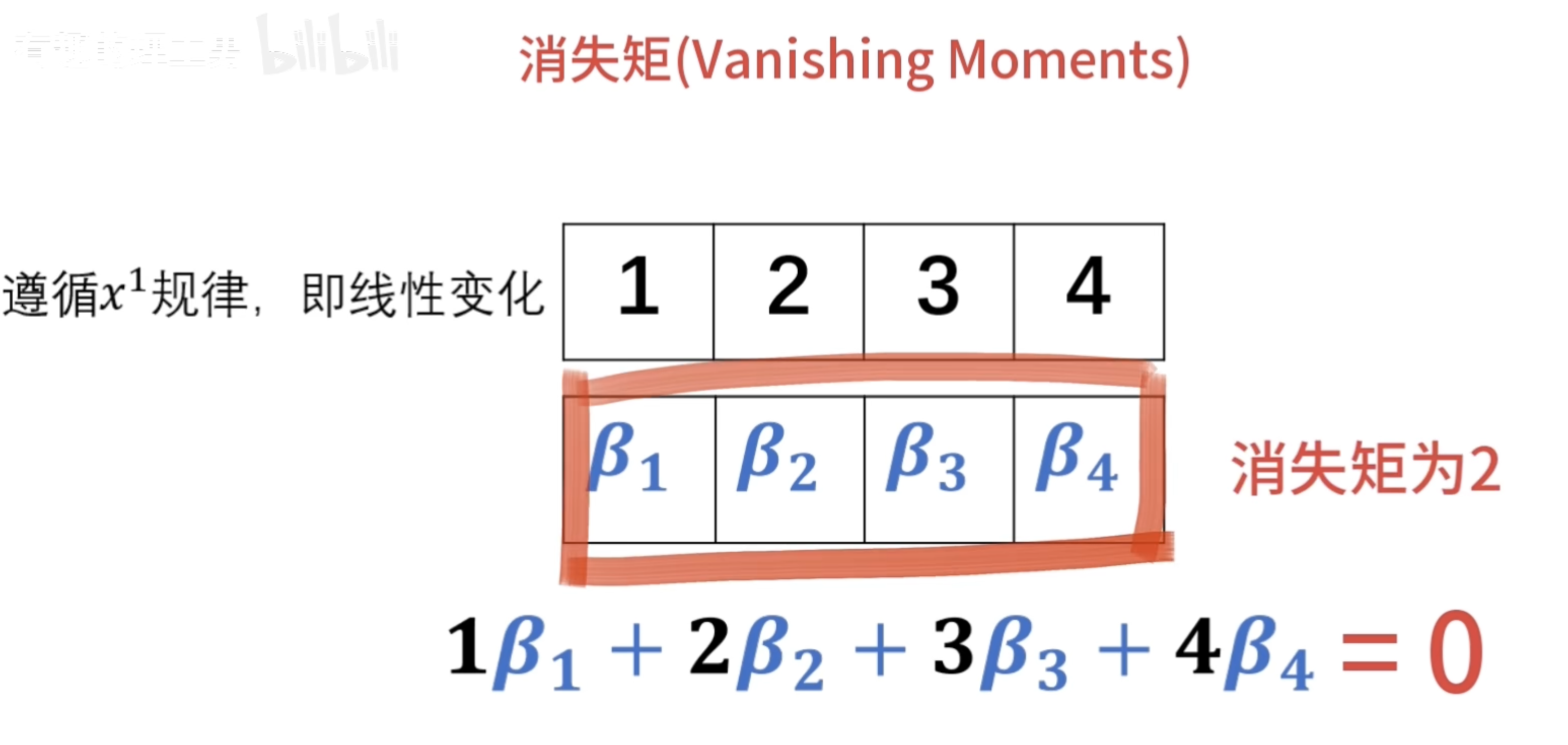

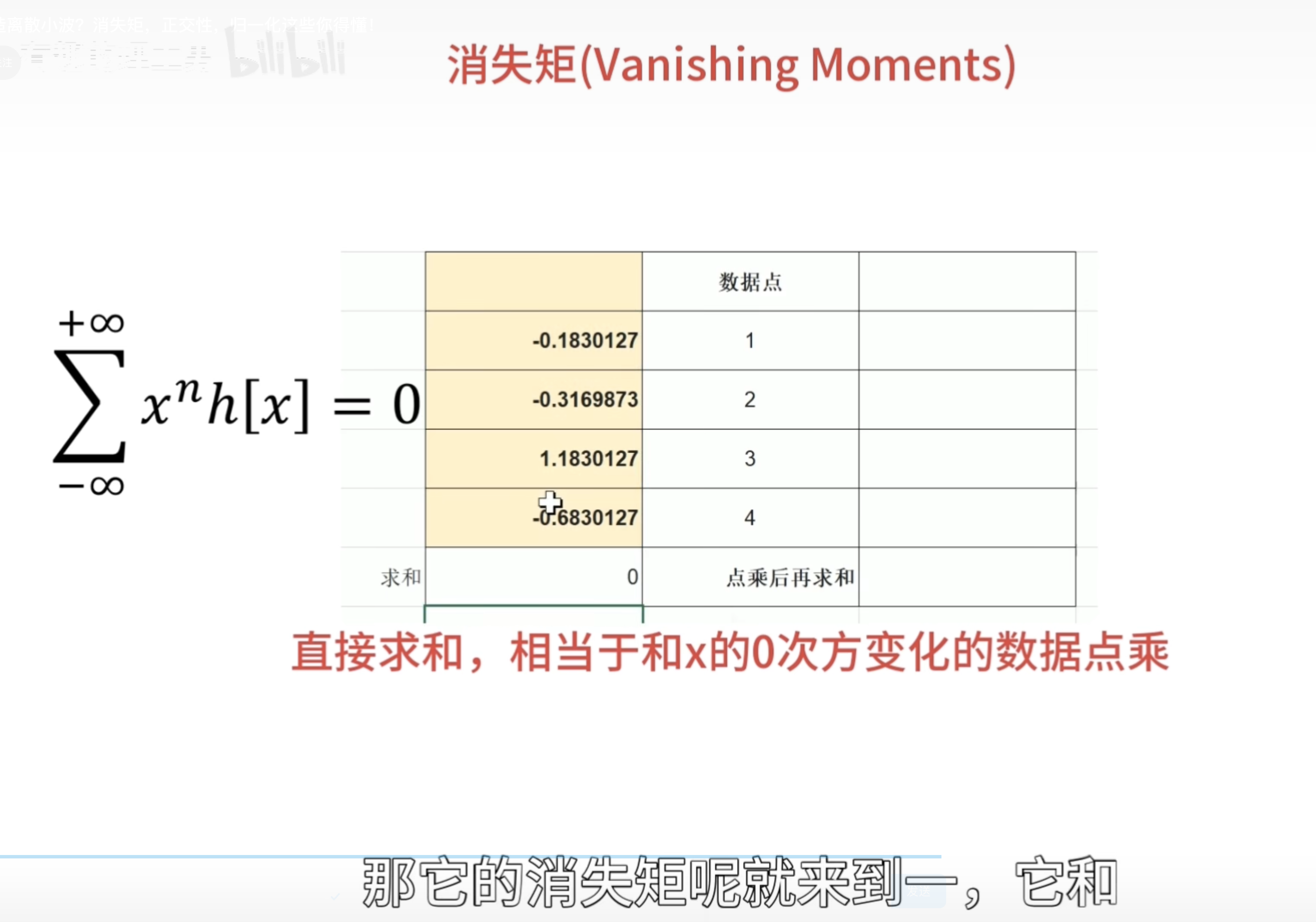

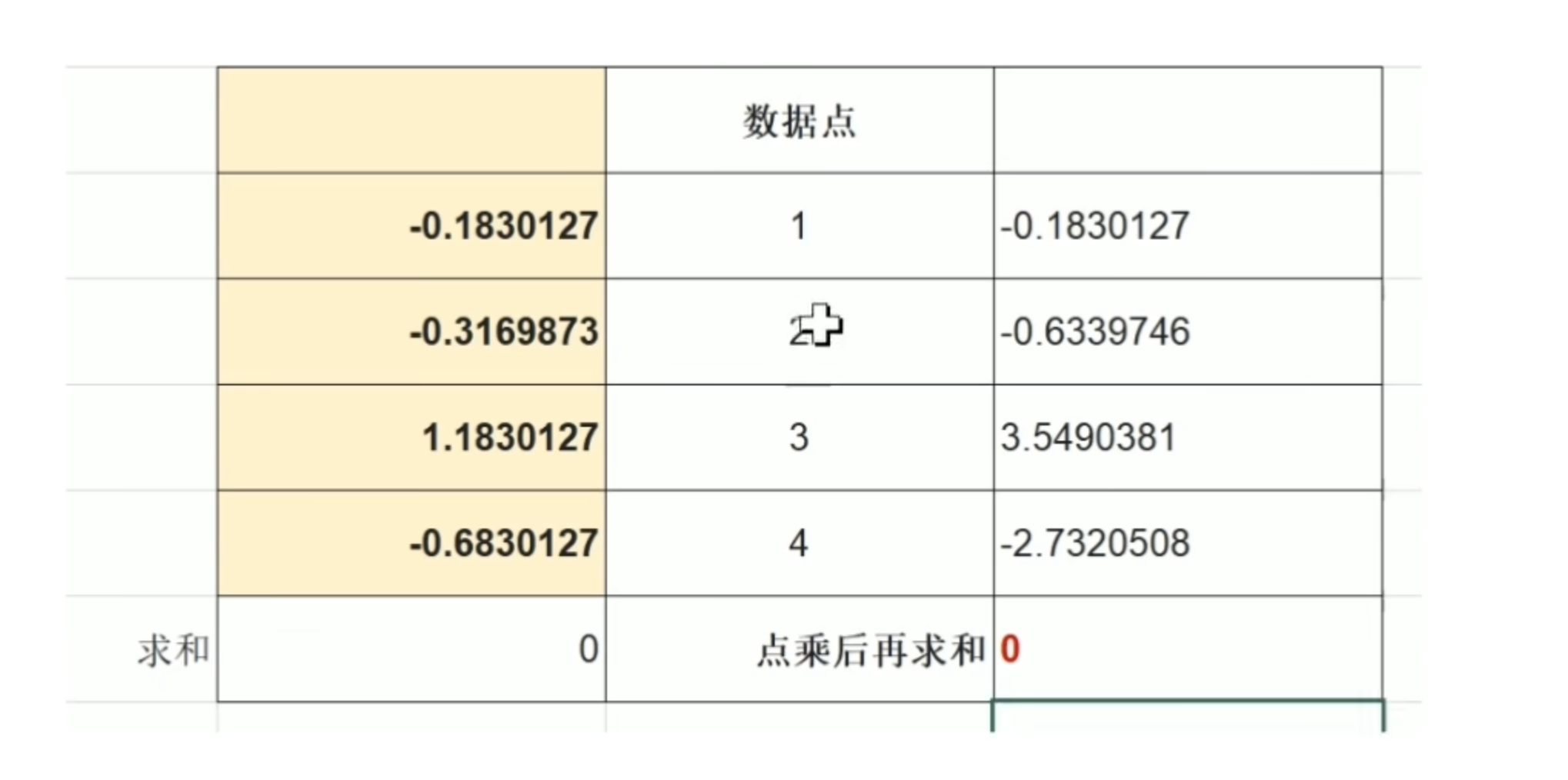

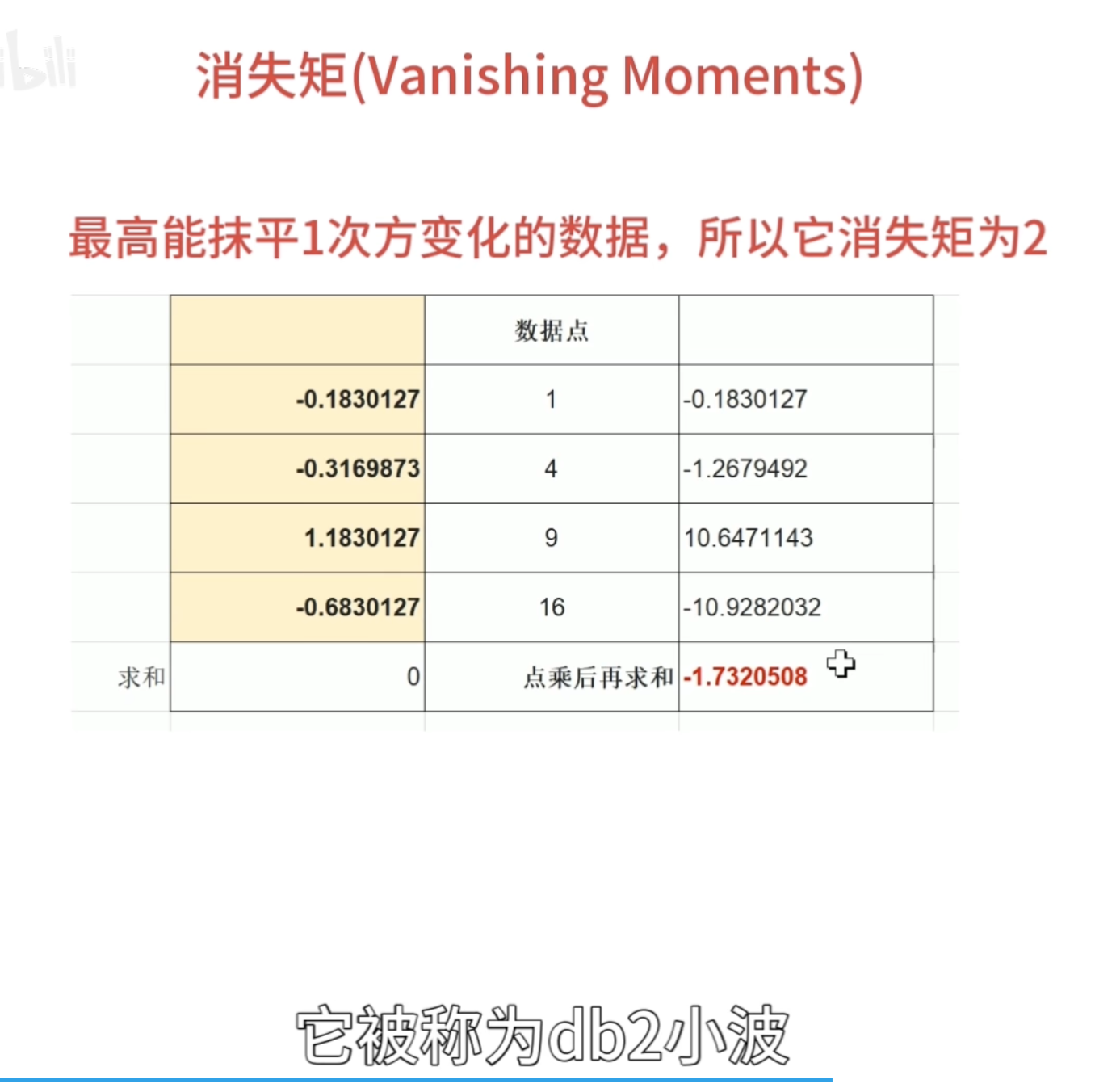

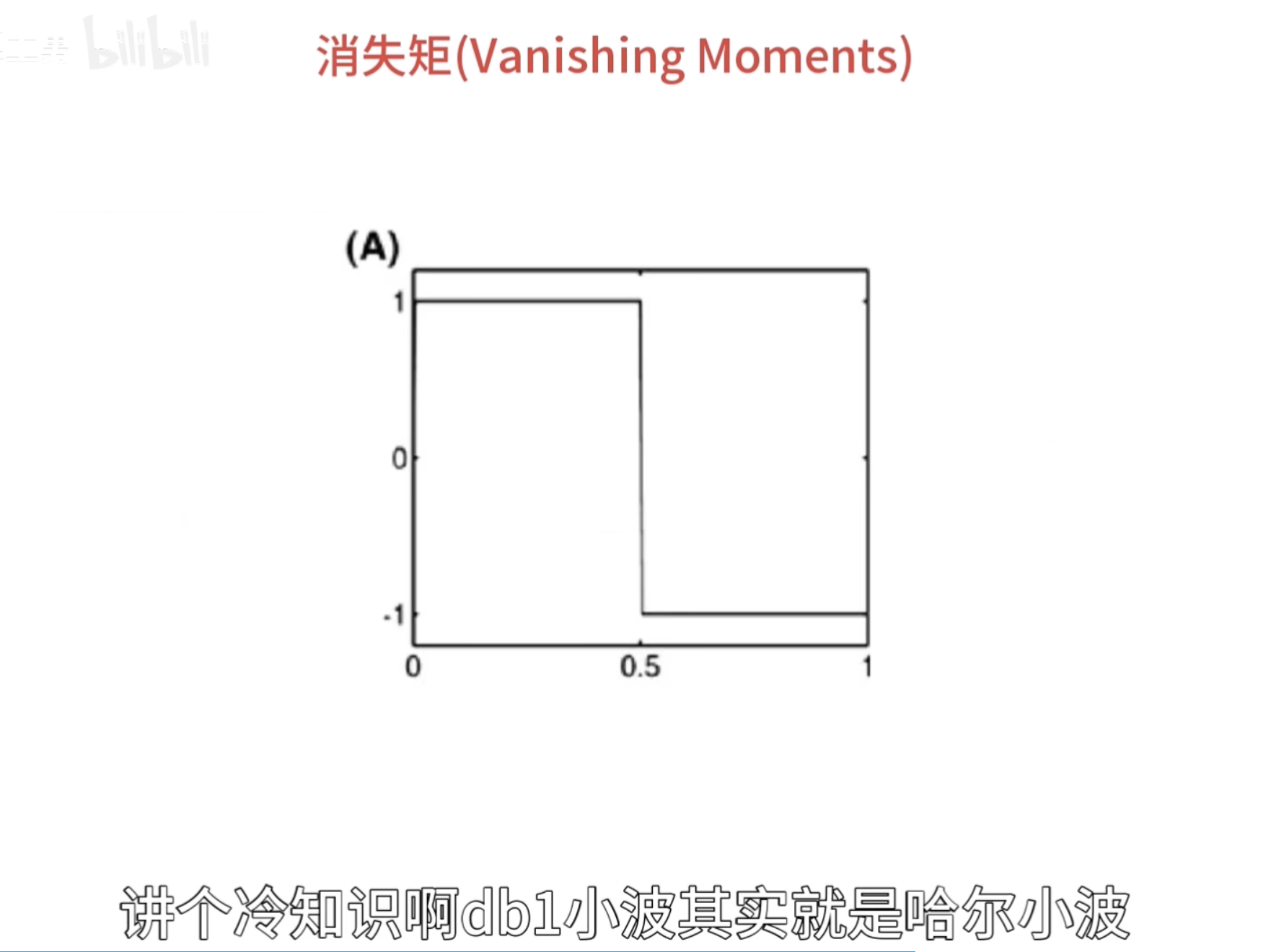

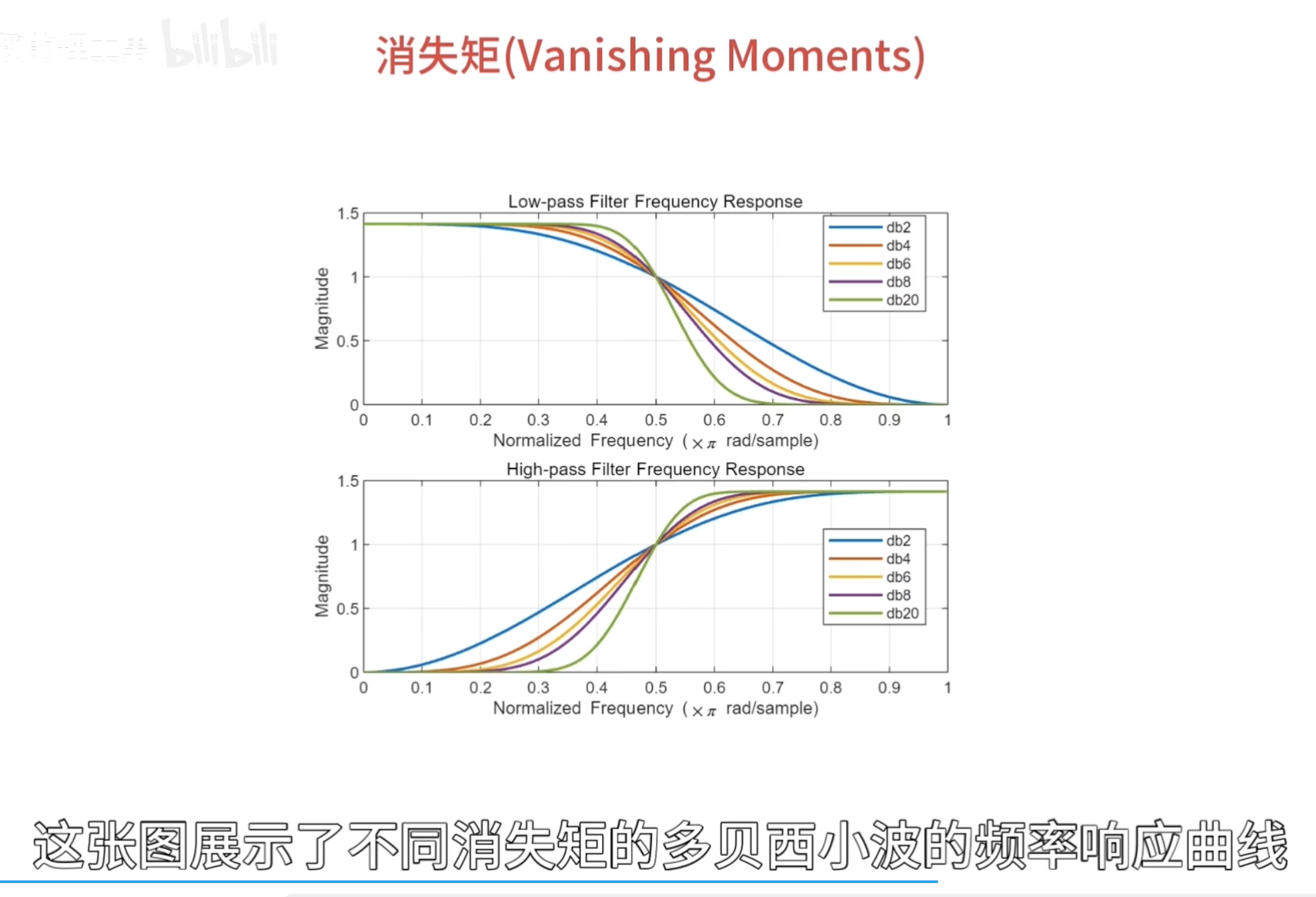

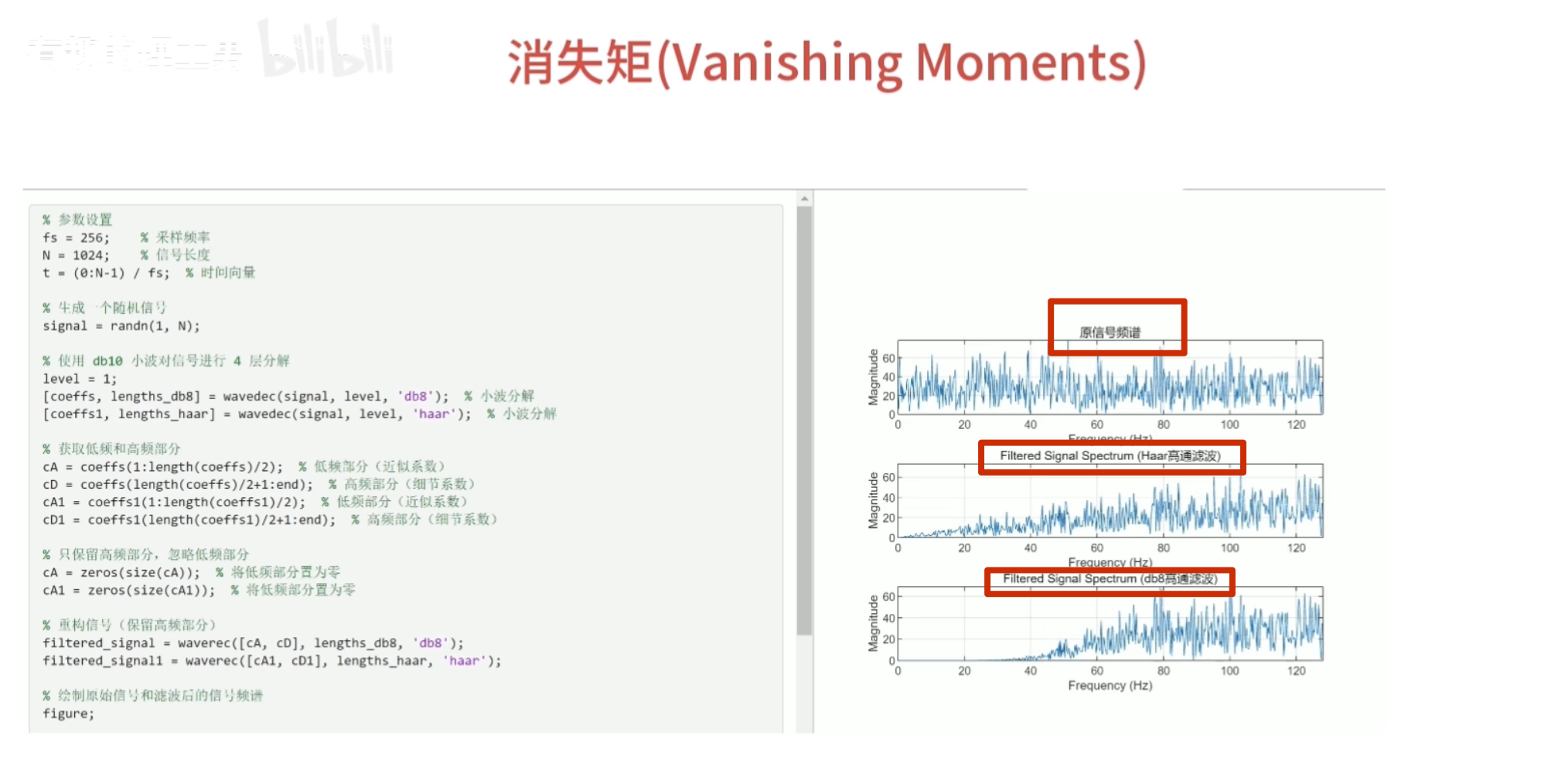

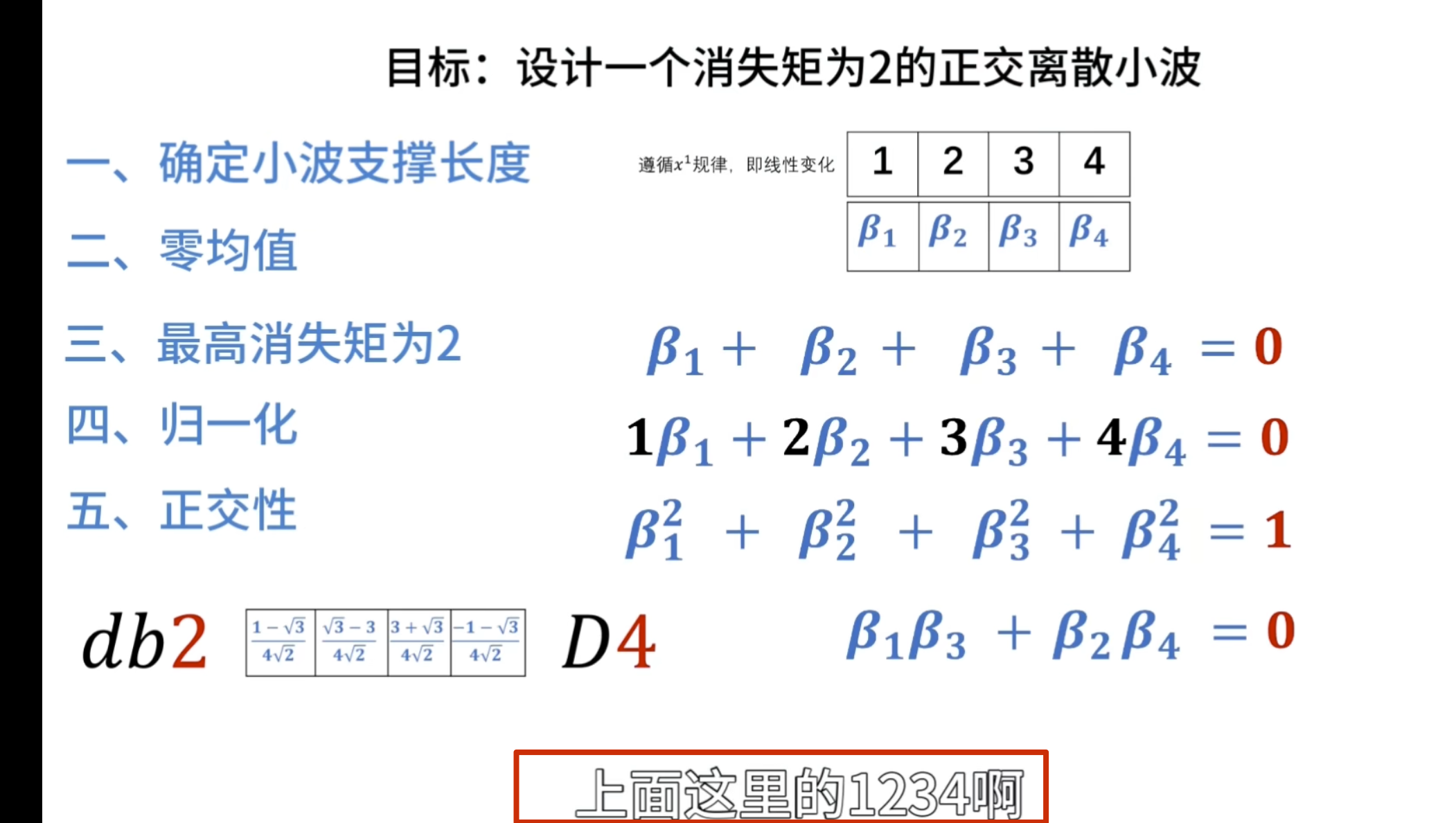

消失矩

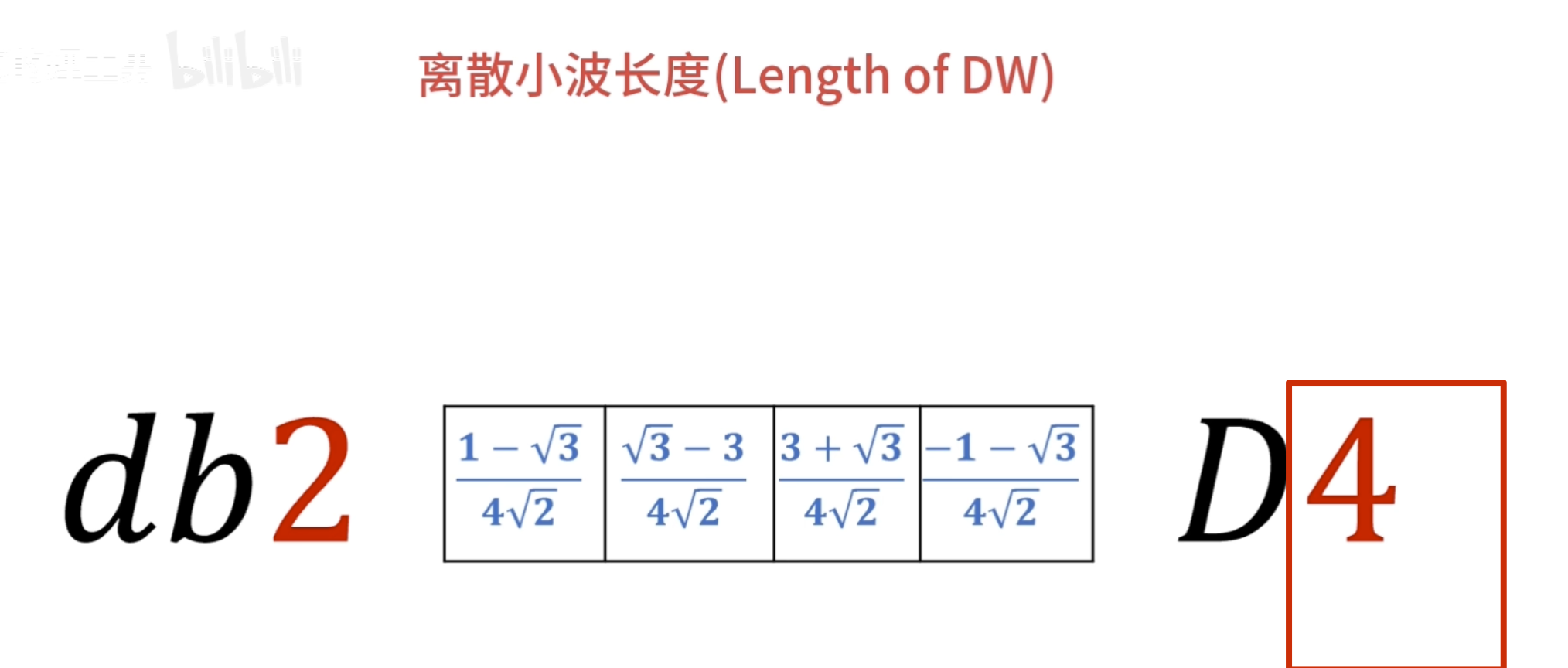

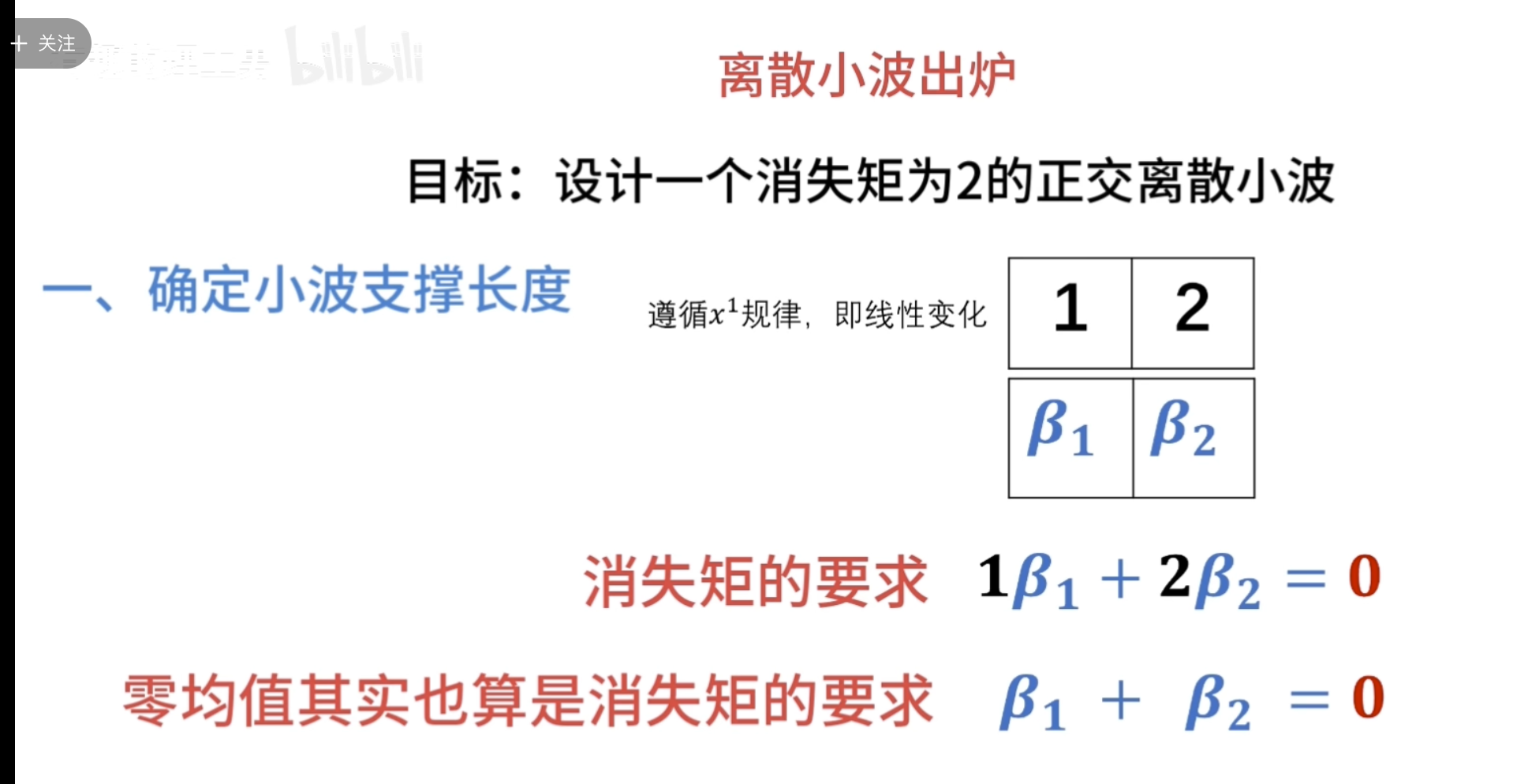

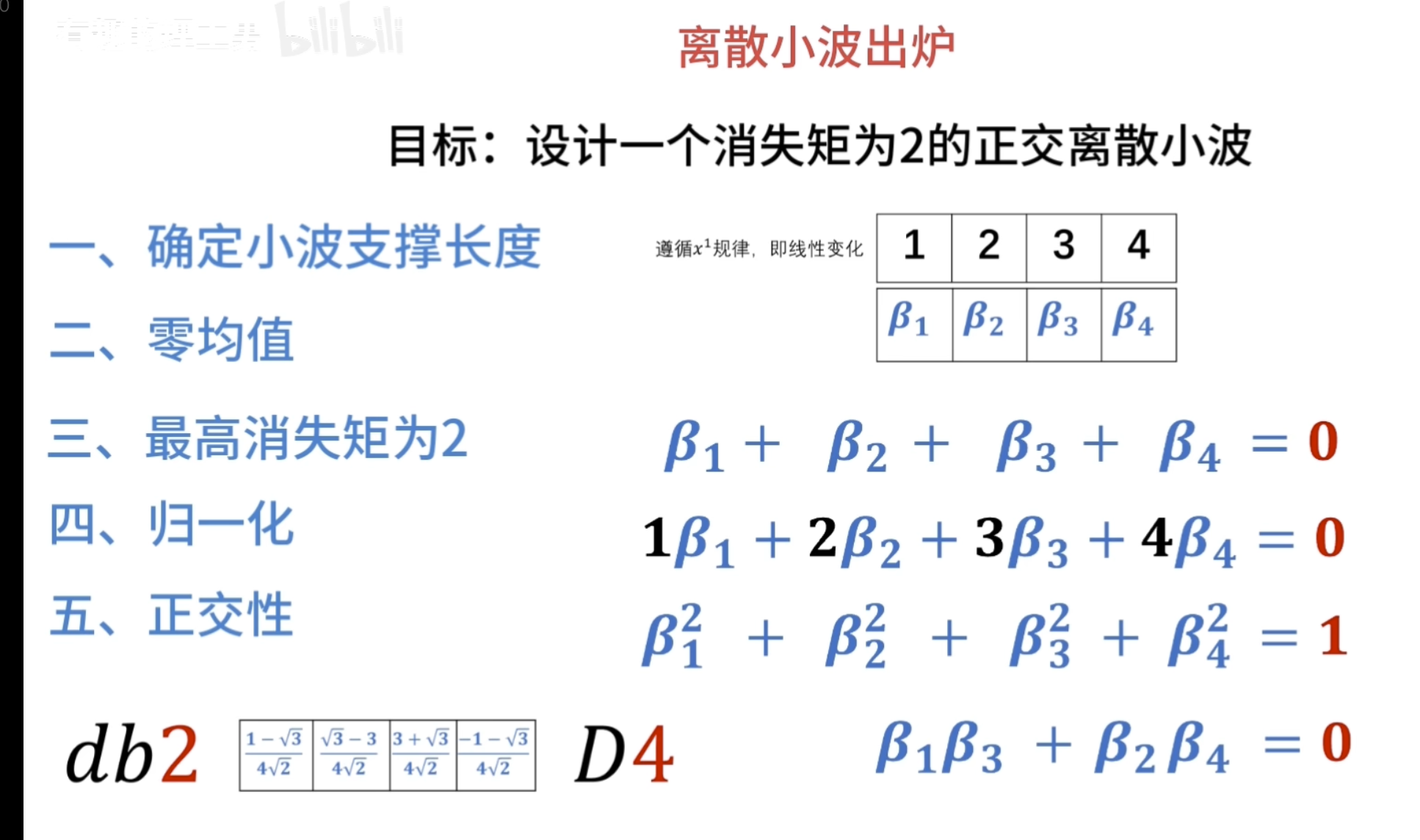

如何自己构造离散小波

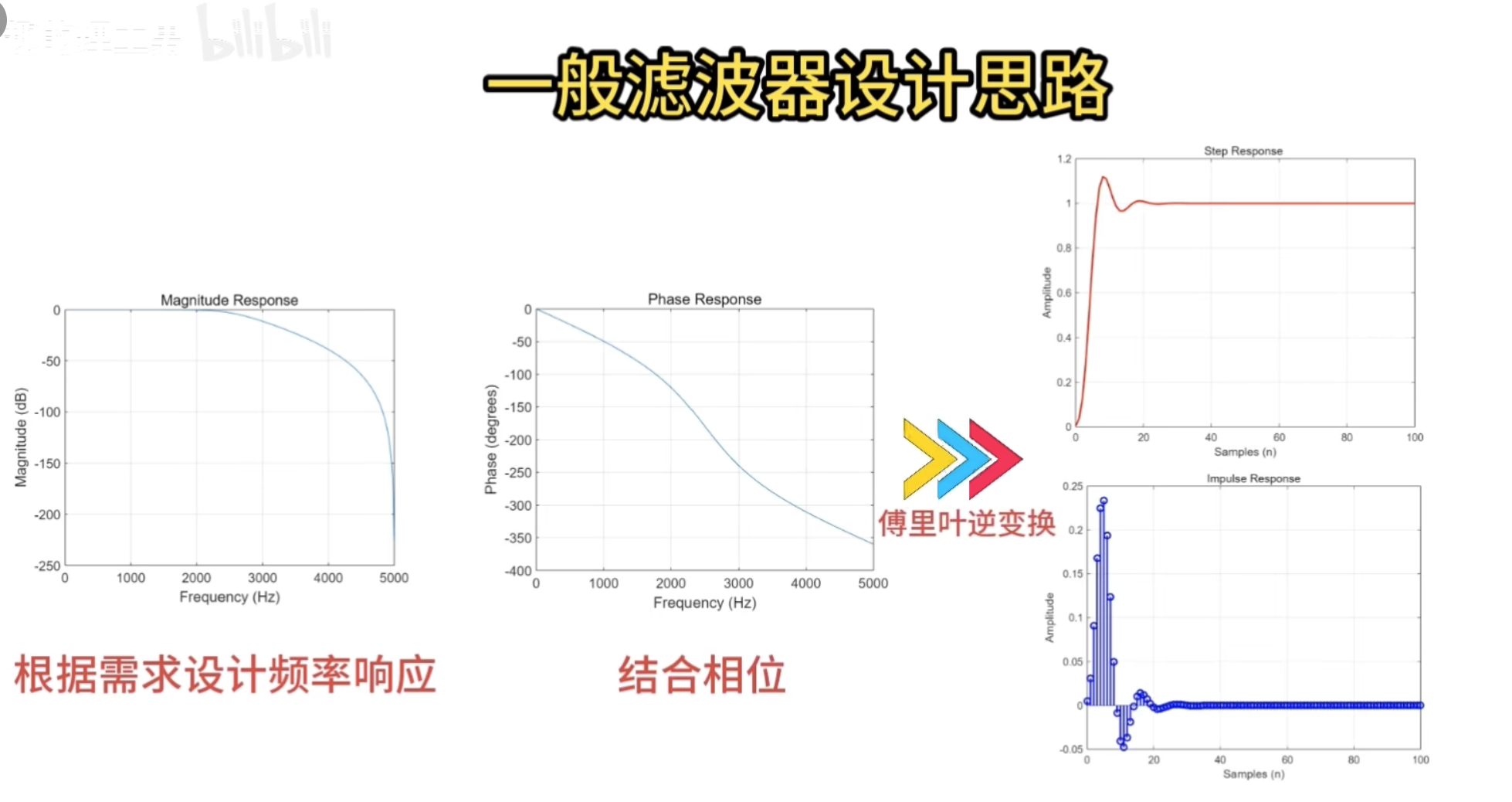

一般滤波器的设计思路

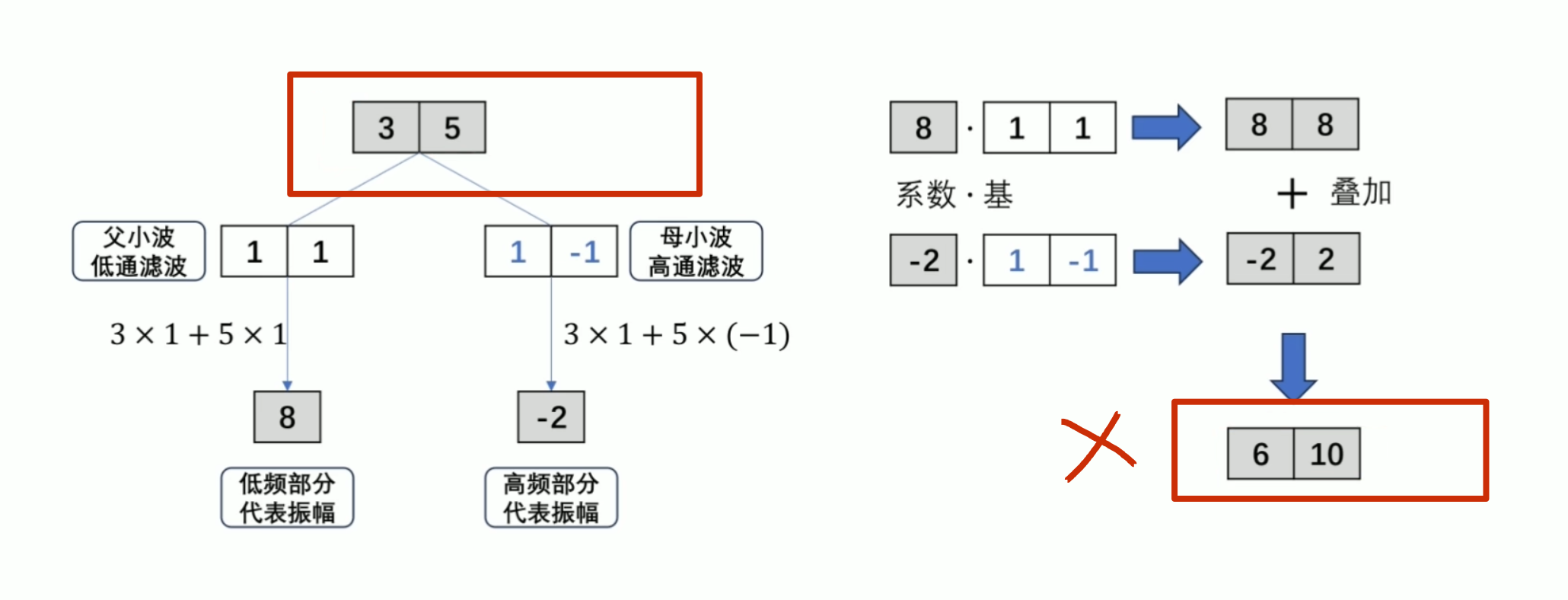

离散小波滤波器

紧支撑性

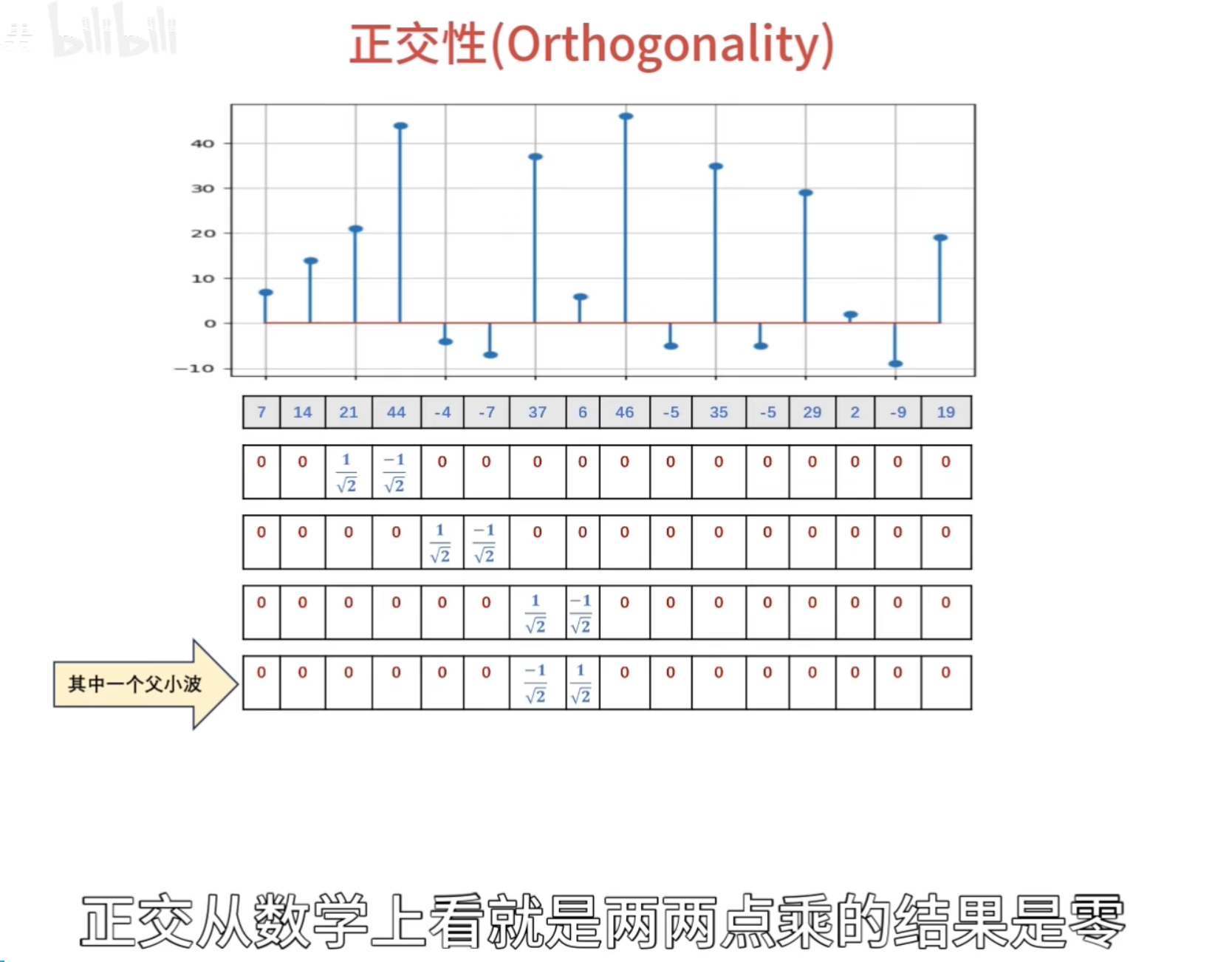

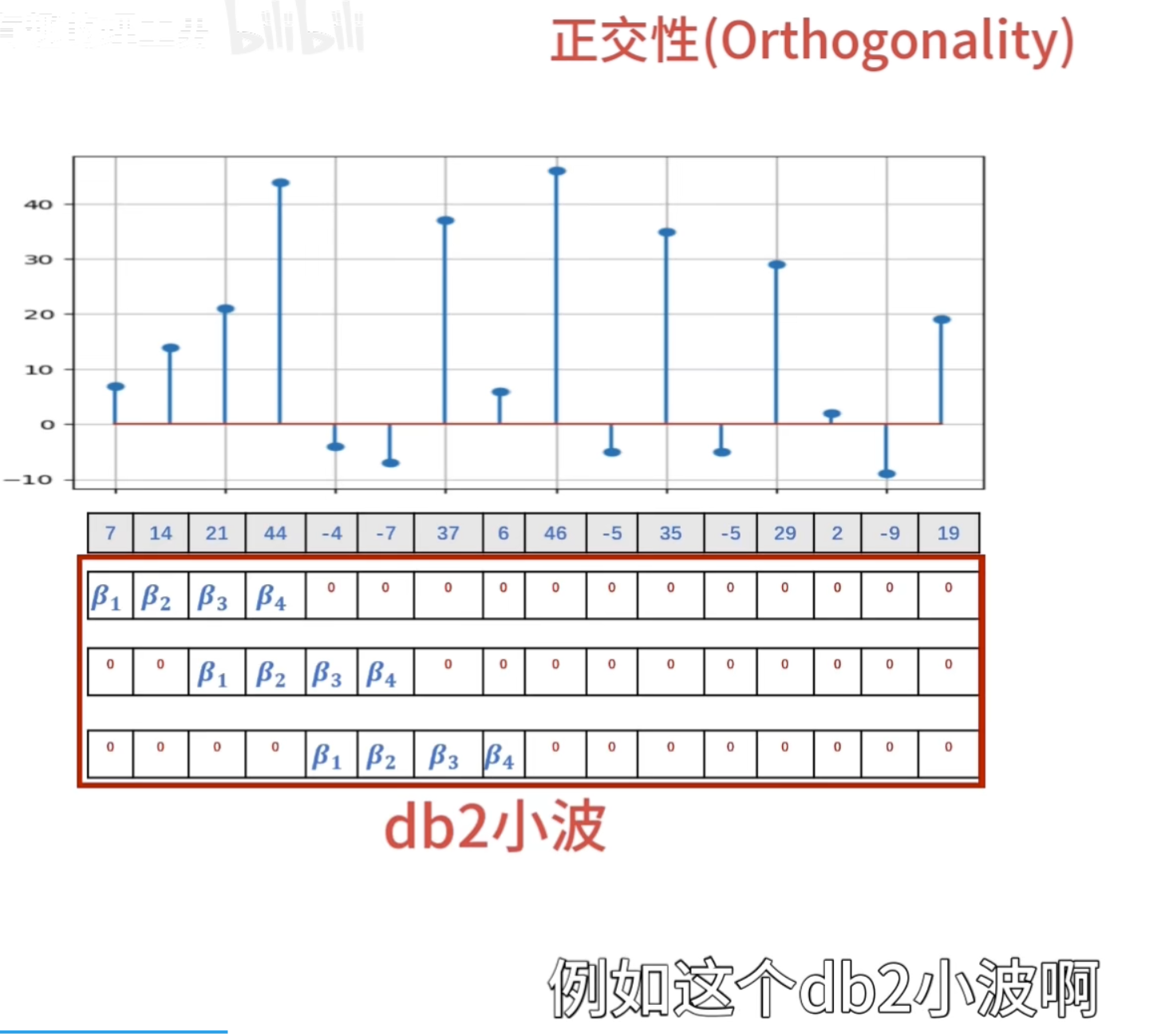

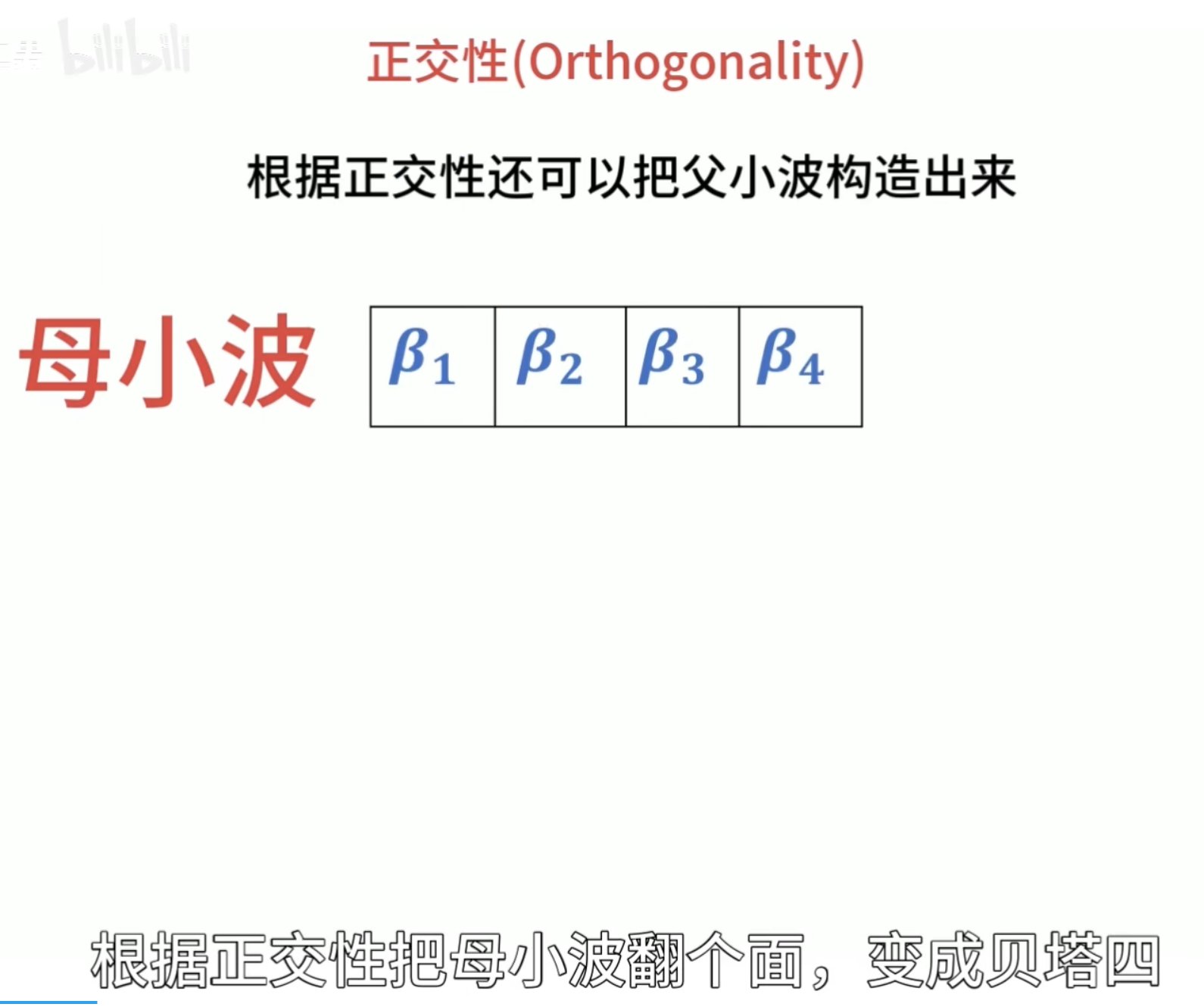

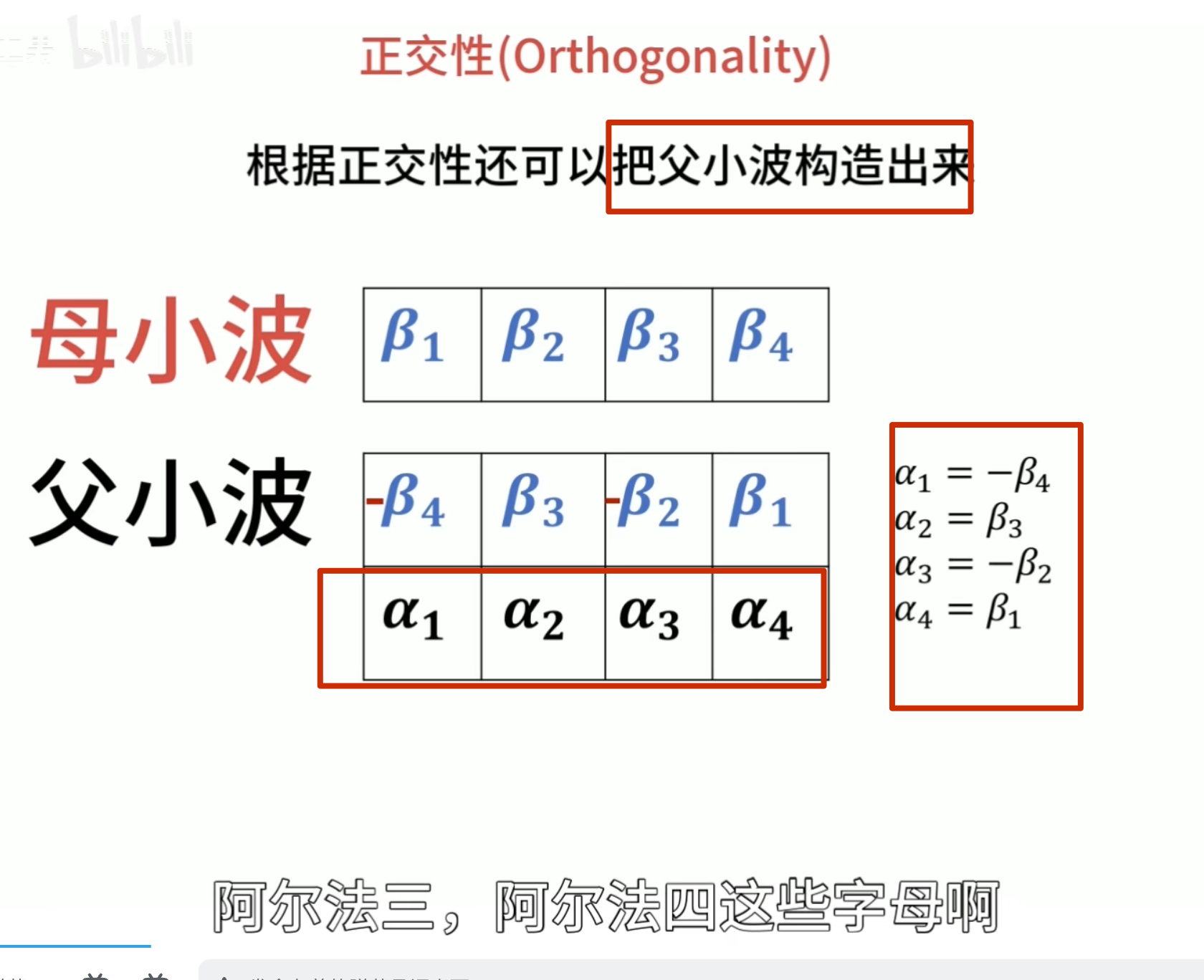

正交性

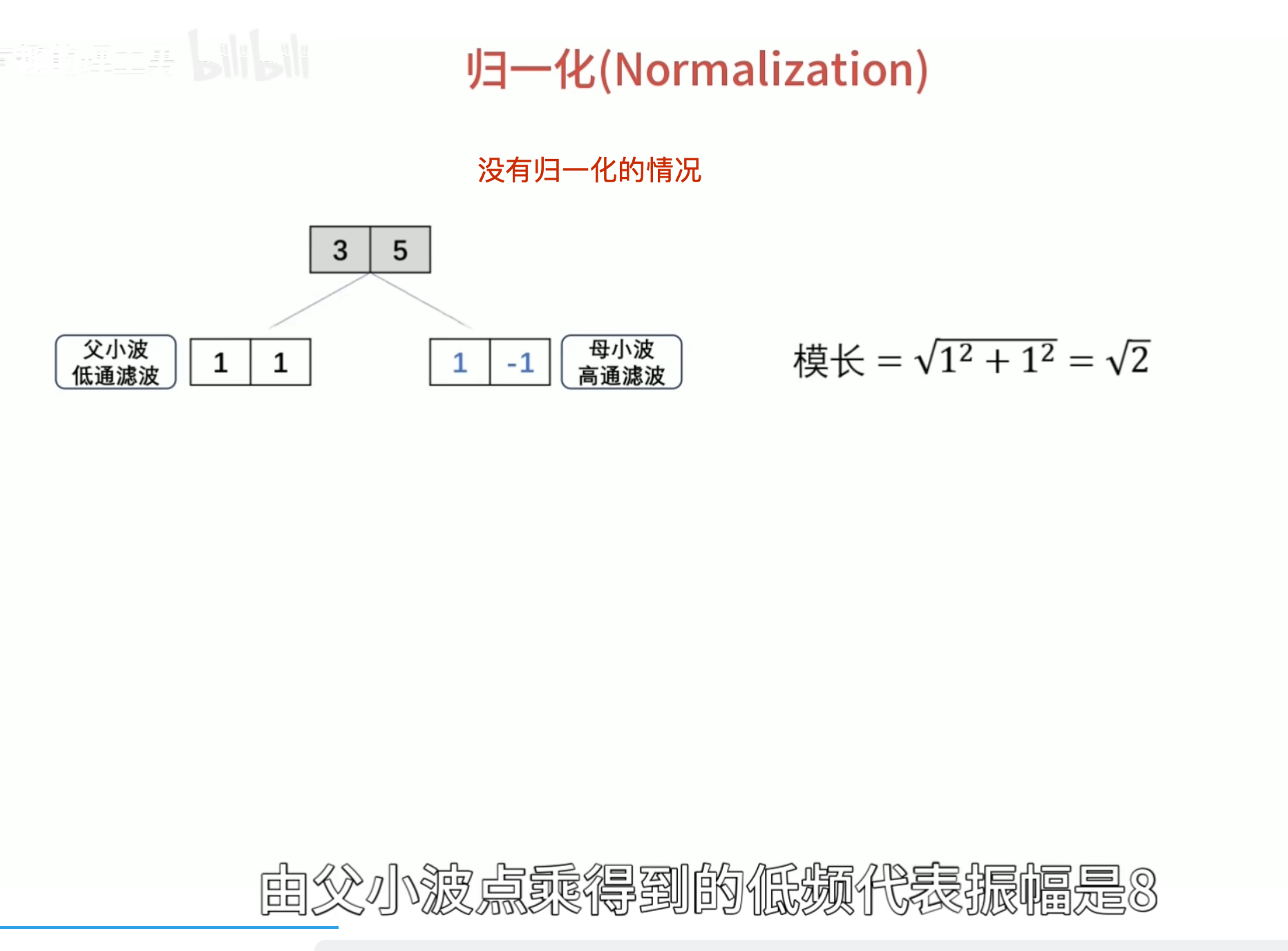

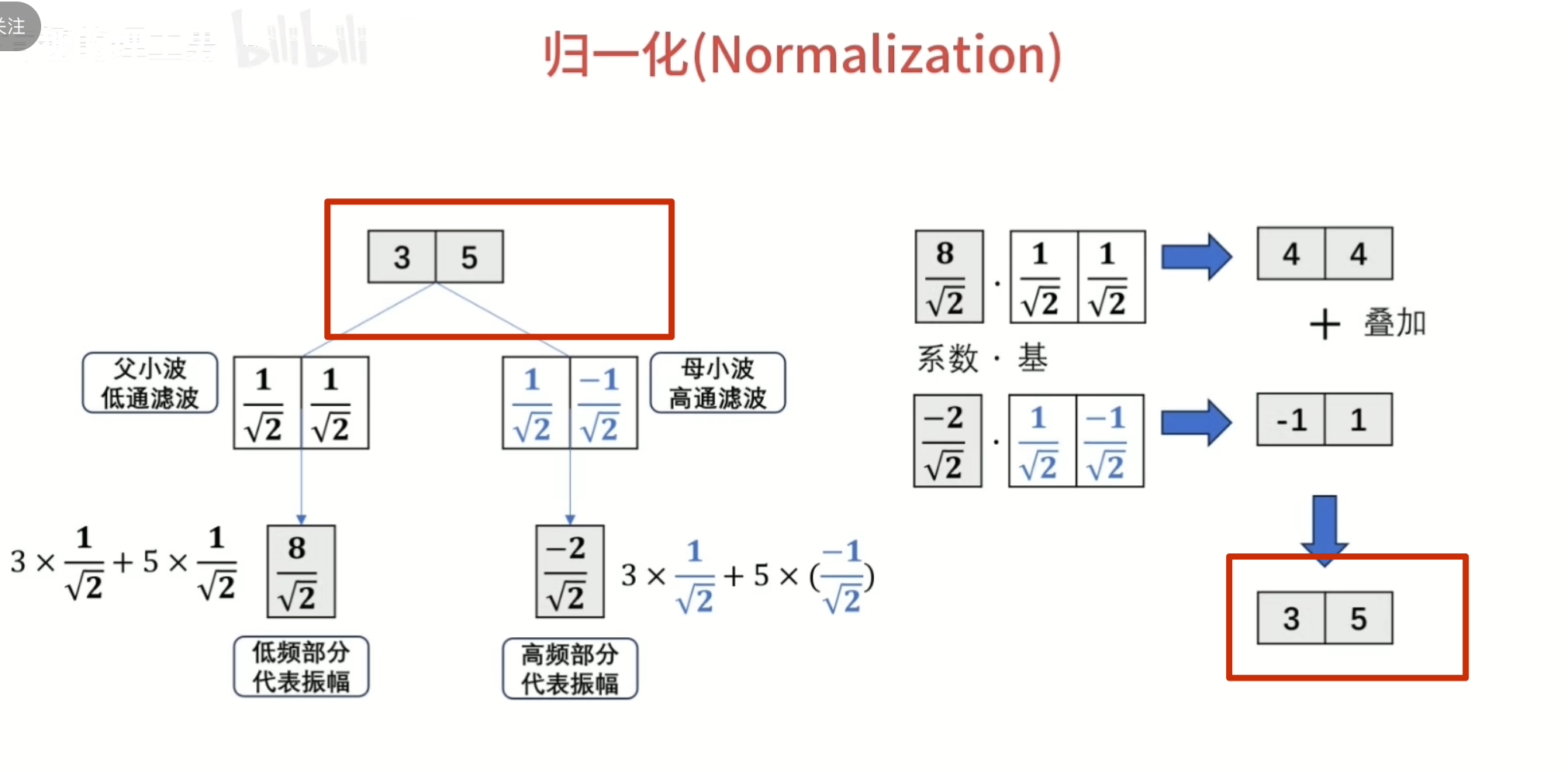

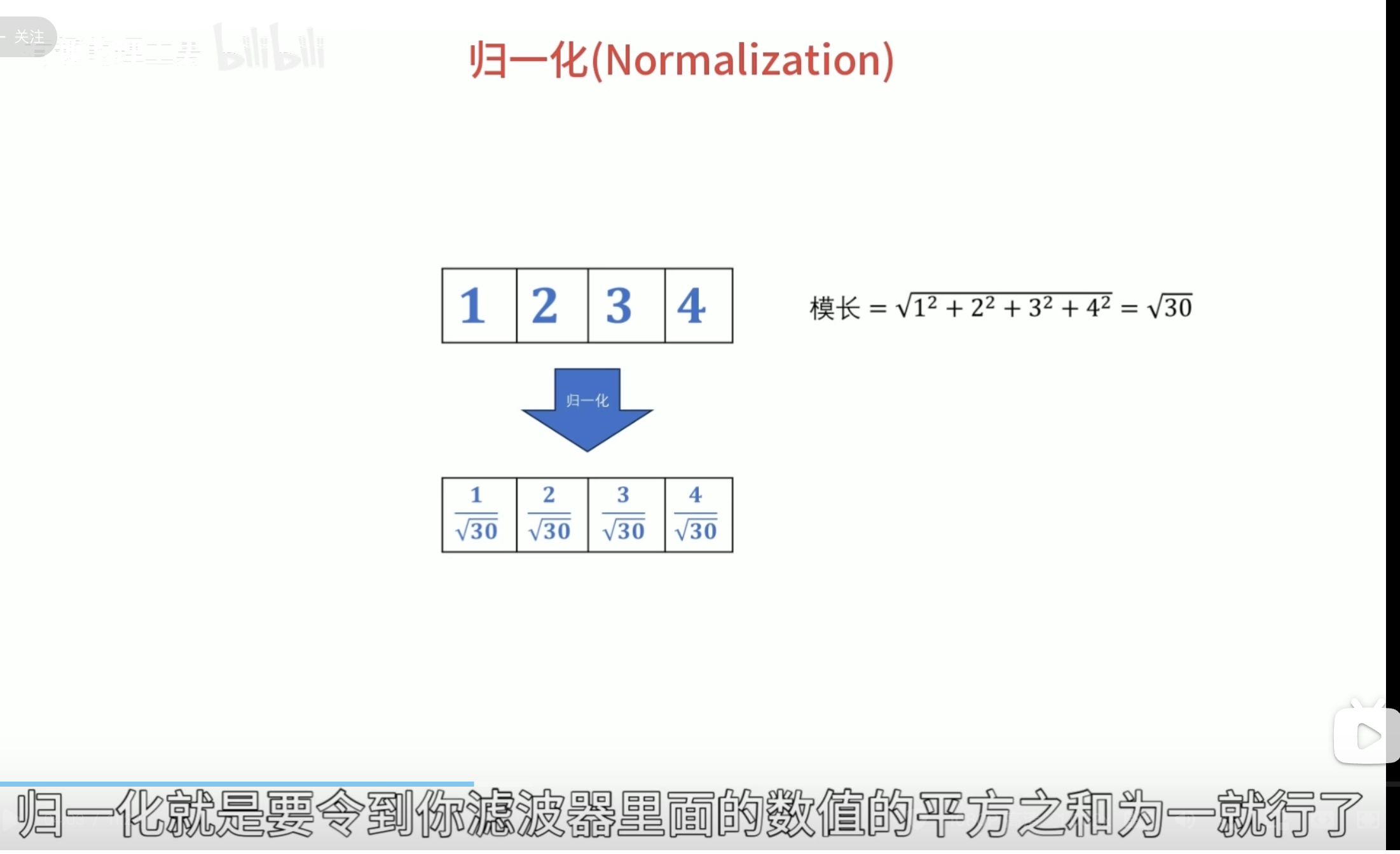

归一化

还原的结果是错的

有归一化的结果

怎么归一化?

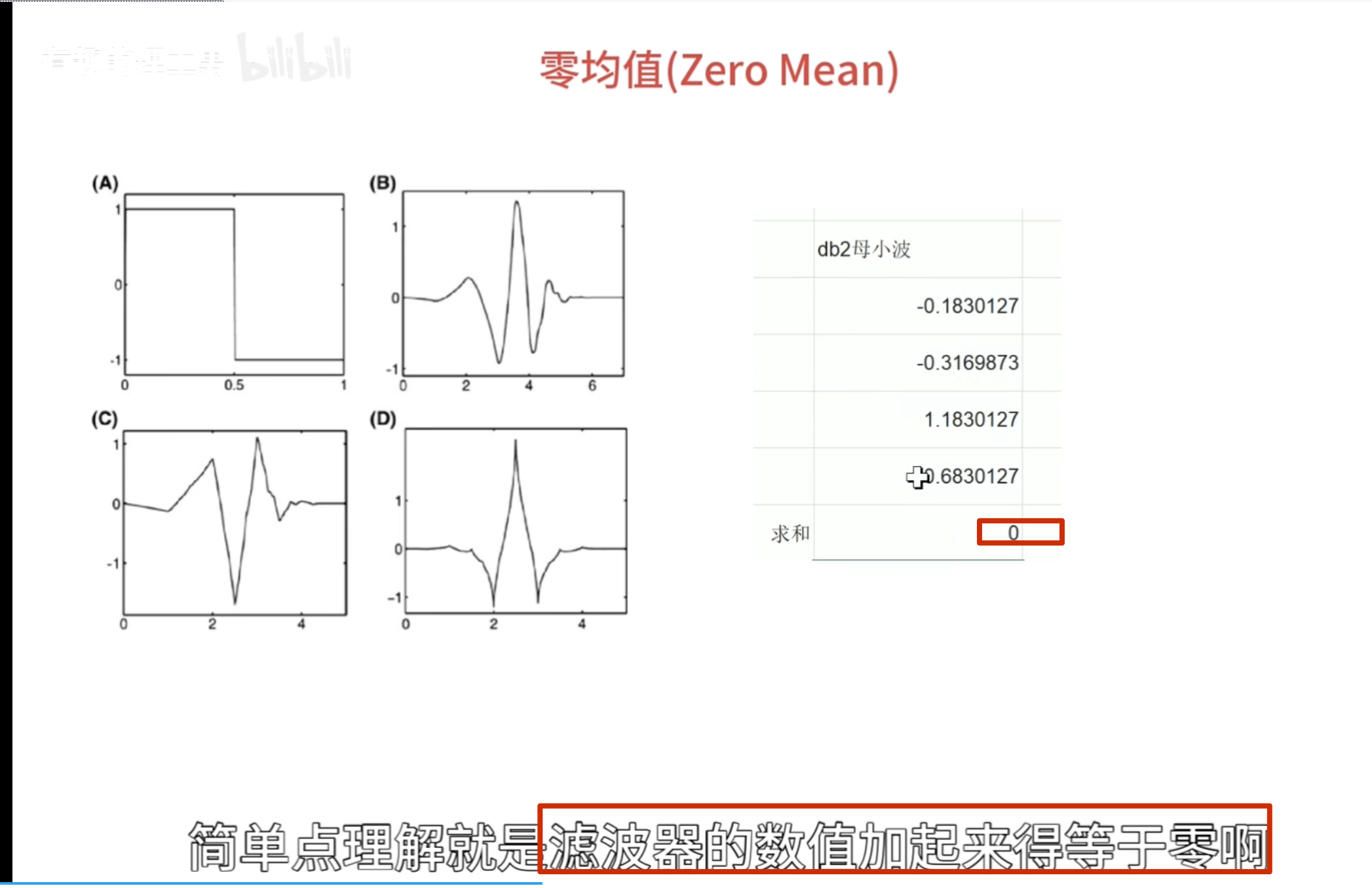

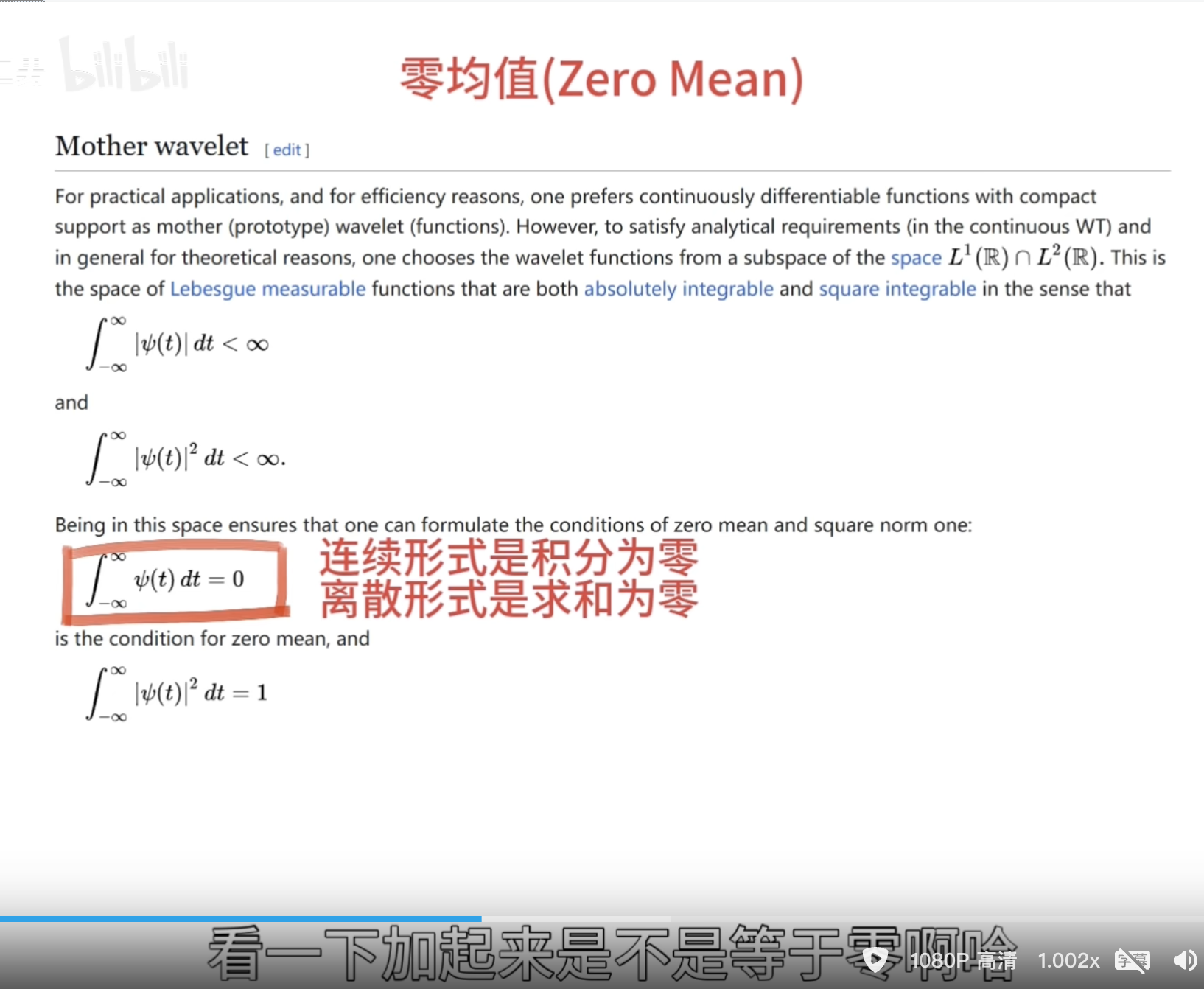

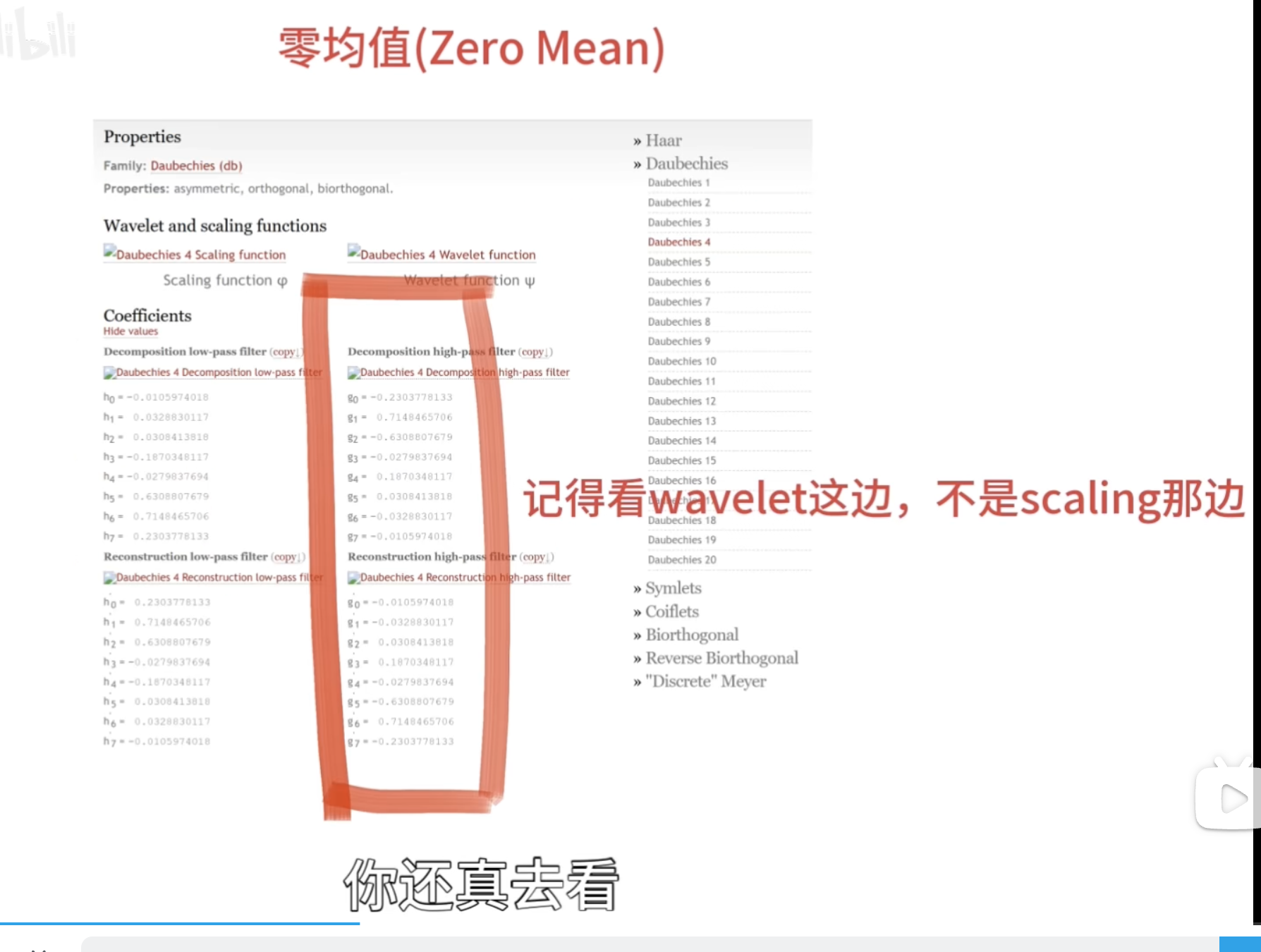

零均值(Zero Mean)

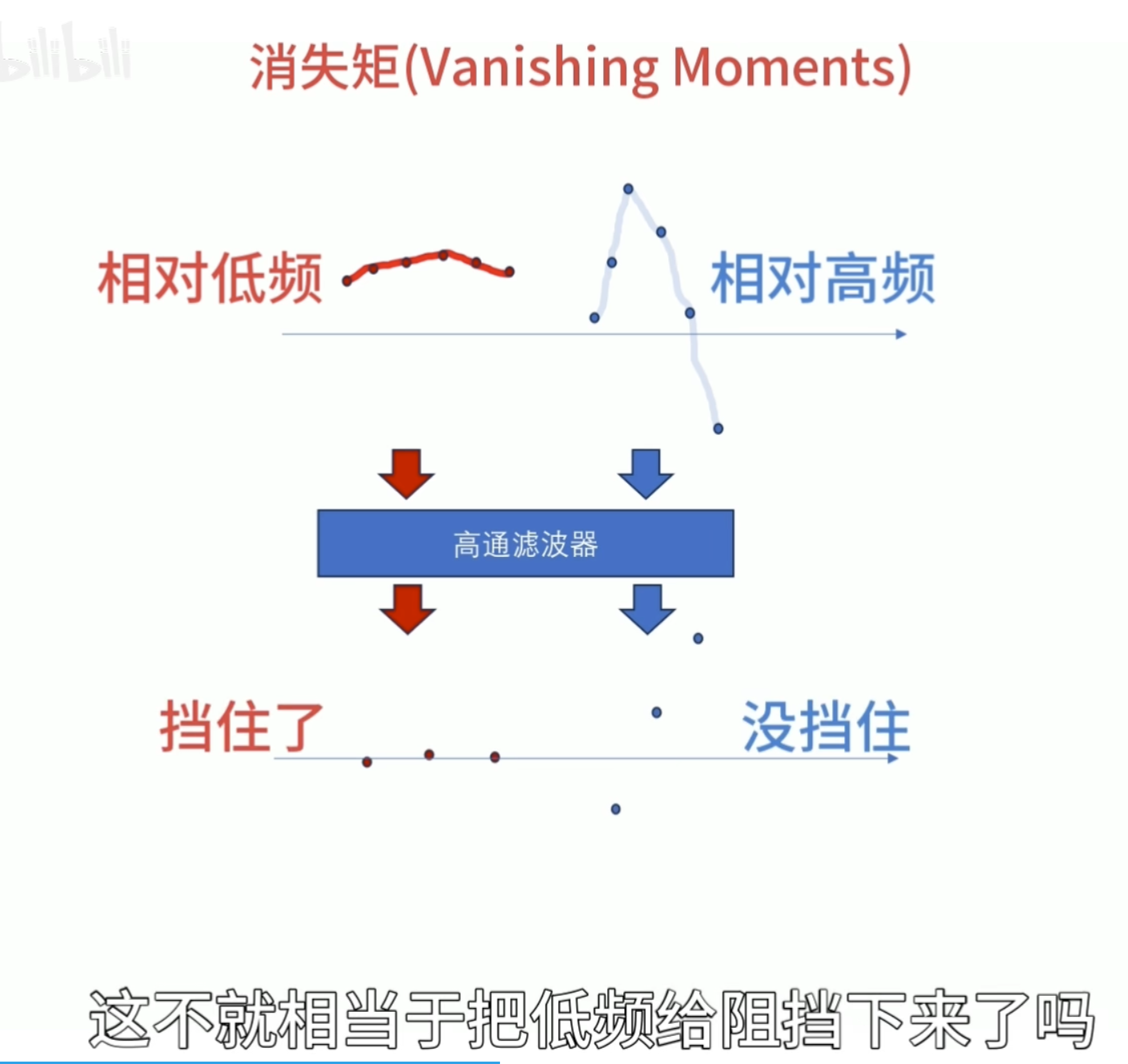

消失矩(vanishing moments)

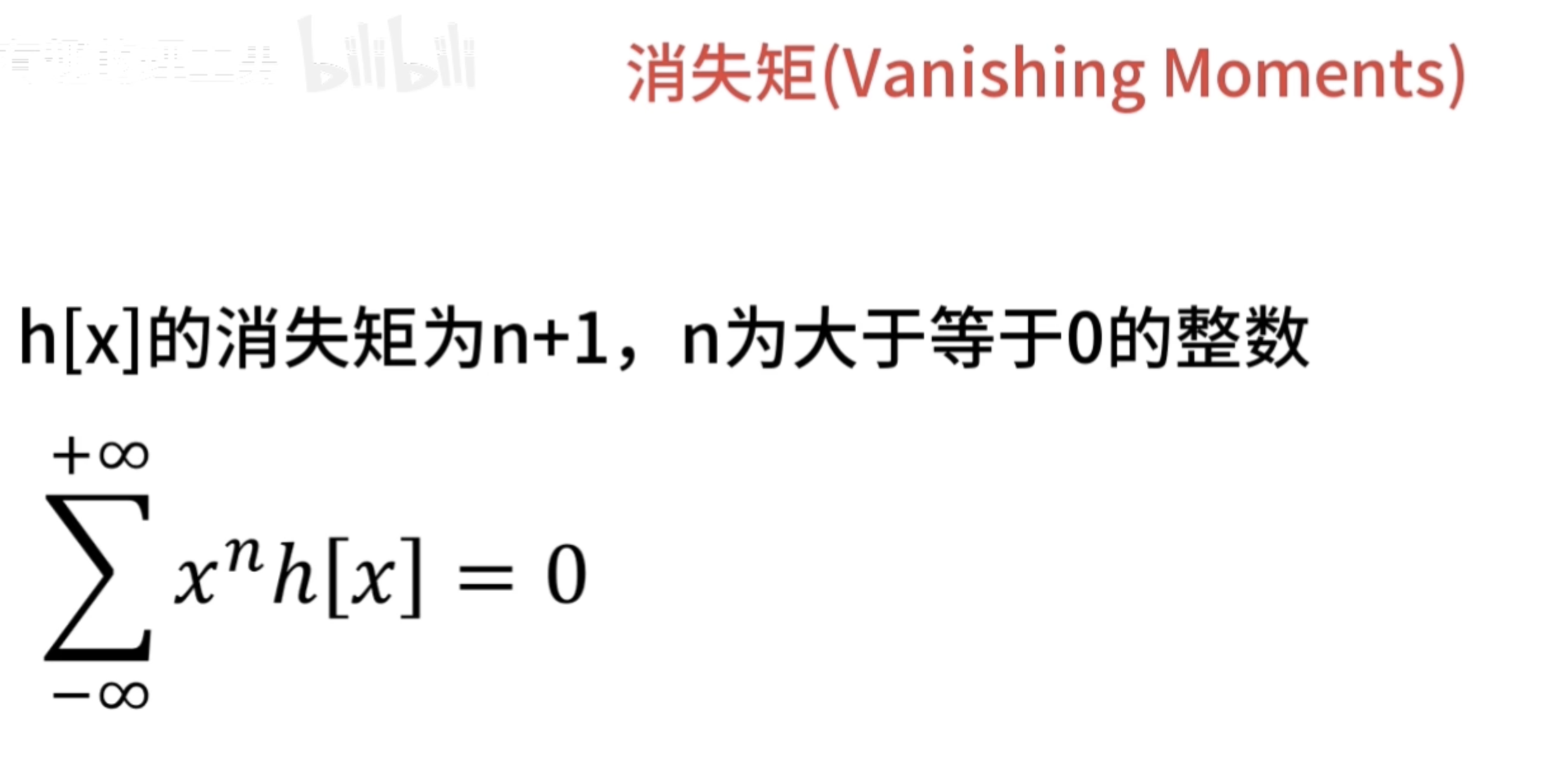

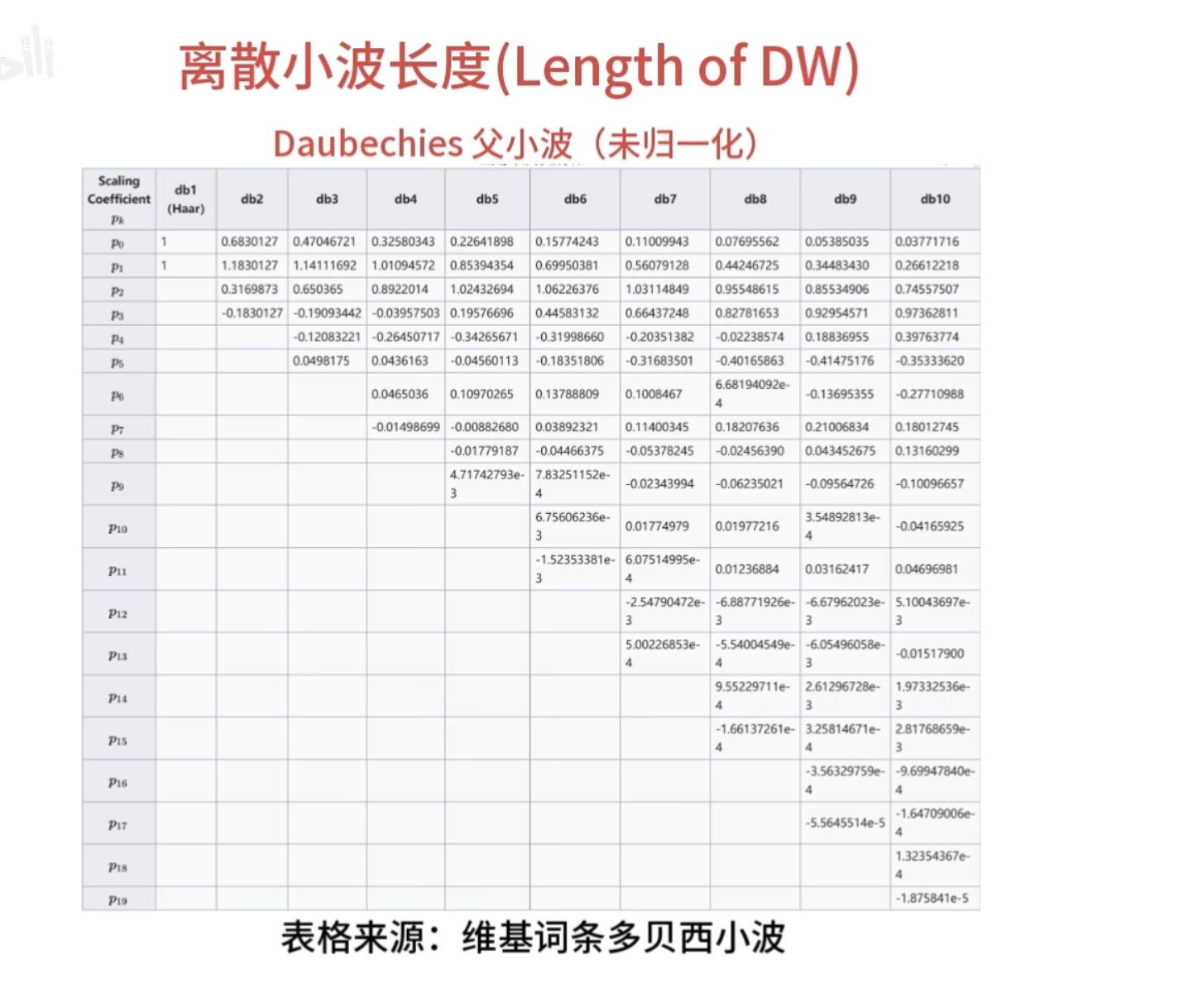

离散滤波器的消失矩

必须为偶数,否则无法正交

所以

训练集、验证集和测试集

在机器学习中,训练集、验证集和测试集都有着重要的作用。

一、训练集(Training Set)

定义:训练集是用来训练模型的数据集合。它包含输入数据和对应的目标输出(标签),模型通过学习这些数据中的模式和规律来调整自身的参数,以最小化预测误差。

作用:

- 模型学习:训练集是模型学习的基础,通过在训练集上进行迭代训练,模型逐渐提高对数据的拟合能力,学习到数据中的特征和规律。

- 参数调整:利用训练集上的误差反馈,通过优化算法(如梯度下降)不断调整模型的参数,使模型能够更好地适应数据的分布。

二、验证集(Validation Set)

定义:验证集是在模型训练过程中用于评估模型性能和调整超参数的数据集合。它独立于训练集,通常从原始数据中划分出来。

作用:

- 性能评估:在模型训练的不同阶段,使用验证集来评估模型的性能,如准确率、损失值等指标。通过观察模型在验证集上的表现,可以了解模型是否过拟合或欠拟合。

- 超参数调整:验证集用于调整模型的超参数,如学习率、层数、节点数等。通过在验证集上进行实验,选择性能最佳的超参数组合。

- 早停法(Early Stopping):当模型在验证集上的性能不再提升时,可以停止训练,防止过拟合。

三、测试集(Test Set)

定义:测试集是用于最终评估模型性能的数据集合。它与训练集和验证集完全独立,在模型训练过程中不被使用。

作用:

- 最终性能评估:测试集提供了一个客观的评估标准,用于衡量模型在未知数据上的泛化能力。通过在测试集上的表现,可以确定模型的实际性能。

- 模型比较:当有多个模型时,可以使用测试集来比较它们的性能,选择性能最佳的模型。

- 模型部署决策:测试集的结果可以帮助决定是否将模型部署到实际应用中。如果模型在测试集上的性能不理想,可能需要进一步改进模型或重新收集数据。

总之,训练集用于模型学习和参数调整,验证集用于性能评估和超参数调整,测试集用于最终评估模型的泛化能力和做出模型部署决策。合理划分和使用这三个数据集对于构建有效的机器学习模型至关重要。

自注意力机制(Self-Attention Mechanism)

自注意力机制(Self-Attention Mechanism)是一种在深度学习中广泛应用的技术,尤其在自然语言处理和计算机视觉等领域发挥了重要作用。

一、基本概念

自注意力机制主要是让模型能够根据输入数据的不同部分之间的关系,自动地为不同部分分配不同的注意力权重。它可以捕捉输入数据中的长距离依赖关系,而不需要依赖传统的顺序处理方式。

例如,在处理一个句子时,自注意力机制可以让模型根据句子中各个单词之间的关系,确定每个单词的重要程度,从而更好地理解句子的含义。

二、工作原理

计算相似度

- 对于给定的输入序列(如一个句子中的单词向量序列),首先计算每个元素(如单词向量)与其他元素之间的相似度。

- 常用的计算相似度的方法是点积(dot product)或缩放点积(scaled dot product)。

计算注意力权重

- 根据相似度计算结果,通过softmax函数将其转化为注意力权重。

- 注意力权重表示每个元素对其他元素的关注程度。

加权求和

- 最后,将每个元素与对应的注意力权重相乘,并进行求和,得到自注意力机制的输出。

- 输出结果是一个新的向量序列,其中每个向量都融合了输入序列中其他元素的信息,并且根据注意力权重进行了加权。

三、优势

并行计算

- 自注意力机制可以并行地计算每个元素的注意力权重,不像传统的循环神经网络(RNN)需要按顺序处理输入数据,因此可以大大提高计算效率。

长距离依赖捕捉

- 能够有效地捕捉输入数据中的长距离依赖关系,这对于处理长文本或复杂的图像等数据非常重要。

灵活性

- 可以很容易地与其他深度学习模型结合使用,如卷积神经网络(CNN)和循环神经网络,以提高模型的性能。

四、应用领域

自然语言处理

- 机器翻译:帮助模型更好地理解源语言和目标语言之间的关系,提高翻译质量。

- 文本分类:聚焦于文本中的关键信息,提高分类准确性。

- 阅读理解:分析文章中的不同部分,更准确地找到答案。

计算机视觉

- 图像分类:关注图像中的关键区域,提高分类准确性。

- 目标检测:确定图像中不同区域对于检测目标的重要性。

- 图像描述生成:根据图像的不同部分生成更准确的描述。

消融研究(Ablation Study)

消融研究(Ablation Study)是一种在科学研究,特别是在机器学习和计算机科学领域中常用的实验方法。

一、目的

其主要目的是为了理解一个复杂系统中各个组成部分的贡献和重要性。通过逐步去除或修改系统中的特定部分,观察系统性能的变化,从而确定每个部分对整体性能的影响。

二、具体做法

- 确定研究对象:首先明确要进行消融研究的复杂系统,例如一个深度学习模型、一个算法流程等。

- 选择要消融的部分:确定系统中的哪些组成部分将被逐个去除或修改。这些部分可以是模型的特定模块、算法的某个步骤、特定的特征等。

- 进行实验:分别对完整系统和去除特定部分后的系统进行实验。在机器学习中,通常使用相同的数据集和评估指标来比较性能变化。

- 分析结果:观察去除不同部分后系统性能的变化,例如准确率、召回率、F1 分数等指标的变化。通过分析这些结果,可以确定每个部分对整体性能的贡献程度。

三、举例

例如在一个图像分类的深度学习模型中,可能包括卷积层、池化层、全连接层等多个模块。为了研究每个模块的重要性,可以进行消融研究:

- 保留完整模型进行实验,得到基准性能。

- 去除卷积层,观察模型性能的变化,确定卷积层对图像特征提取的贡献。

- 去除池化层,观察性能变化,了解池化层在降低数据维度和提高模型鲁棒性方面的作用。

- 去除全连接层,分析其对最终分类结果的影响。

通过这样的消融研究,可以深入了解模型中各个模块的功能和重要性,为进一步改进和优化模型提供依据。

对比学习(Contrastive Learning)

对比学习(Contrastive Learning)是一种无监督学习方法,旨在通过学习数据的相似性和差异性来提取有效的特征表示。

一、基本原理

对比学习的核心思想是让模型学习如何区分相似的样本对和不相似的样本对。具体来说,它通过构建正负样本对,并让模型学习使得相似样本对之间的距离尽可能小,不相似样本对之间的距离尽可能大。

例如,对于图像数据,可以通过对同一图像进行不同的数据增强操作(如旋转、裁剪、颜色变换等)来生成正样本对,而不同的图像则构成负样本对。模型通过学习区分这些样本对,从而提取出能够反映图像本质特征的表示。

二、方法流程

- 数据准备

- 收集大量未标注的数据,并进行适当的数据增强操作以生成正样本对和负样本对。

- 构建损失函数

- 设计一个对比损失函数,该函数通常基于样本对之间的距离度量。常见的对比损失函数有InfoNCE损失、Triplet损失等。

- 模型训练

- 使用对比损失函数对模型进行训练。在训练过程中,模型不断调整参数以最小化损失函数,使得相似样本对的表示更加接近,不相似样本对的表示更加远离。

- 特征提取

- 训练完成后,可以使用模型提取数据的特征表示。这些特征表示通常具有较好的区分性和鲁棒性,可以用于后续的任务,如分类、聚类等。

三、优势

- 无需大量标注数据

- 对比学习是一种无监督学习方法,因此可以在没有大量标注数据的情况下进行训练,节省了标注数据的成本和时间。

- 学习到有效的特征表示

- 通过学习数据的相似性和差异性,对比学习可以提取出具有区分性和鲁棒性的特征表示,这些特征表示可以提高后续任务的性能。

- 可扩展性强

- 对比学习可以很容易地应用于不同类型的数据,如图像、文本、音频等,并且可以与其他深度学习方法结合使用,具有很强的可扩展性。

四、应用场景

- 计算机视觉

- 在图像分类、目标检测、图像检索等任务中,对比学习可以用于预训练模型,提取有效的图像特征,提高模型的性能。

- 自然语言处理

- 在文本分类、情感分析、机器翻译等任务中,对比学习可以用于学习词向量或句子向量的表示,提高模型的语言理解能力。

- 推荐系统

- 在推荐系统中,对比学习可以用于学习用户和物品的特征表示,提高推荐的准确性和个性化程度。

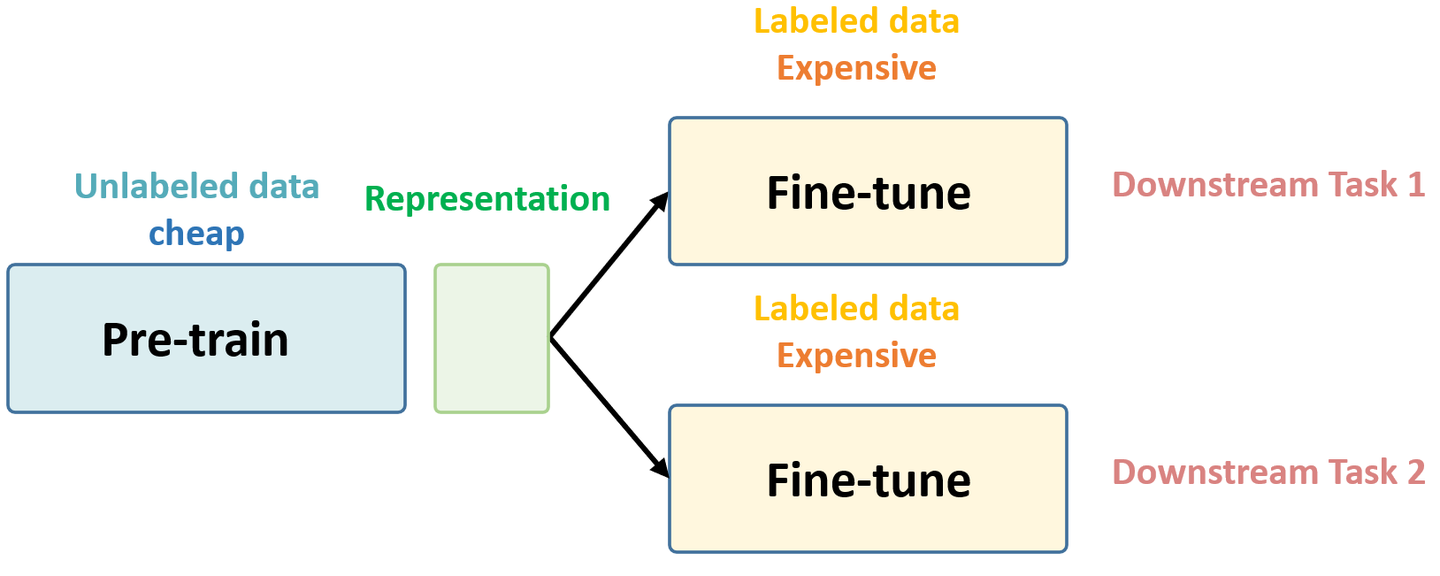

预训练

预训练是一种在特定任务之前对模型进行初步训练的方法。以下是关于预训练的详细介绍:

一、定义与目的

预训练是利用大规模数据对模型进行无监督或自监督学习,使模型学习到通用的特征表示和模式。其主要目的是为了让模型在后续特定任务的训练中能够更快地收敛,并且提高模型的性能和泛化能力。

二、预训练的方式

无监督预训练:

- 这种方式通常利用大量未标注的数据,让模型学习数据的内在结构和模式。例如,自编码器通过学习将输入数据重构为输出数据,从而提取数据的特征表示。

- 语言模型预训练也是一种常见的无监督预训练方法。通过预测句子中的下一个单词或掩码位置的单词,模型可以学习到语言的语法、语义和上下文信息。

自监督预训练:

- 自监督学习任务通常是通过从数据本身自动生成监督信号来进行训练。例如,在图像领域,可以通过对图像进行随机裁剪、旋转或颜色变换等操作,然后让模型预测原始图像的特征,从而进行自监督预训练。

三、预训练的优势

- 利用大规模数据:预训练可以利用大量的无标注数据,这些数据在现实中往往比较容易获取。相比之下,标注数据通常需要耗费大量的时间和人力成本。

- 通用特征表示:通过预训练,模型可以学习到通用的特征表示,这些特征可以在不同的任务中共享。这样可以减少在特定任务中对标注数据的需求,并且提高模型的泛化能力。

- 加速训练过程:由于预训练已经学习到了一些通用的特征和模式,在后续特定任务的训练中,模型可以更快地收敛,从而减少训练时间和计算资源的消耗。

四、预训练的应用领域

- 自然语言处理:在自然语言处理领域,预训练语言模型如 BERT、GPT 等已经取得了巨大的成功。这些模型在大规模文本数据上进行预训练,然后可以在各种自然语言处理任务中进行微调,如文本分类、命名实体识别、机器翻译等。

- 计算机视觉:在计算机视觉领域,预训练模型也被广泛应用。例如,在图像分类任务中,可以使用在大规模图像数据集上预训练的卷积神经网络模型,然后在特定的图像分类数据集上进行微调。

- 语音处理:预训练在语音处理领域也有应用。例如,可以使用在大规模语音数据集上预训练的声学模型和语言模型,然后在特定的语音识别或语音合成任务中进行微调。

总之,预训练是一种有效的模型训练方法,可以利用大规模数据学习通用的特征表示,提高模型的性能和泛化能力,并且加速训练过程。在各个领域中,预训练模型已经成为了一种重要的技术手段。

以下是一些预训练的例子:

一、自然语言处理领域

BERT(Bidirectional Encoder Representations from Transformers):

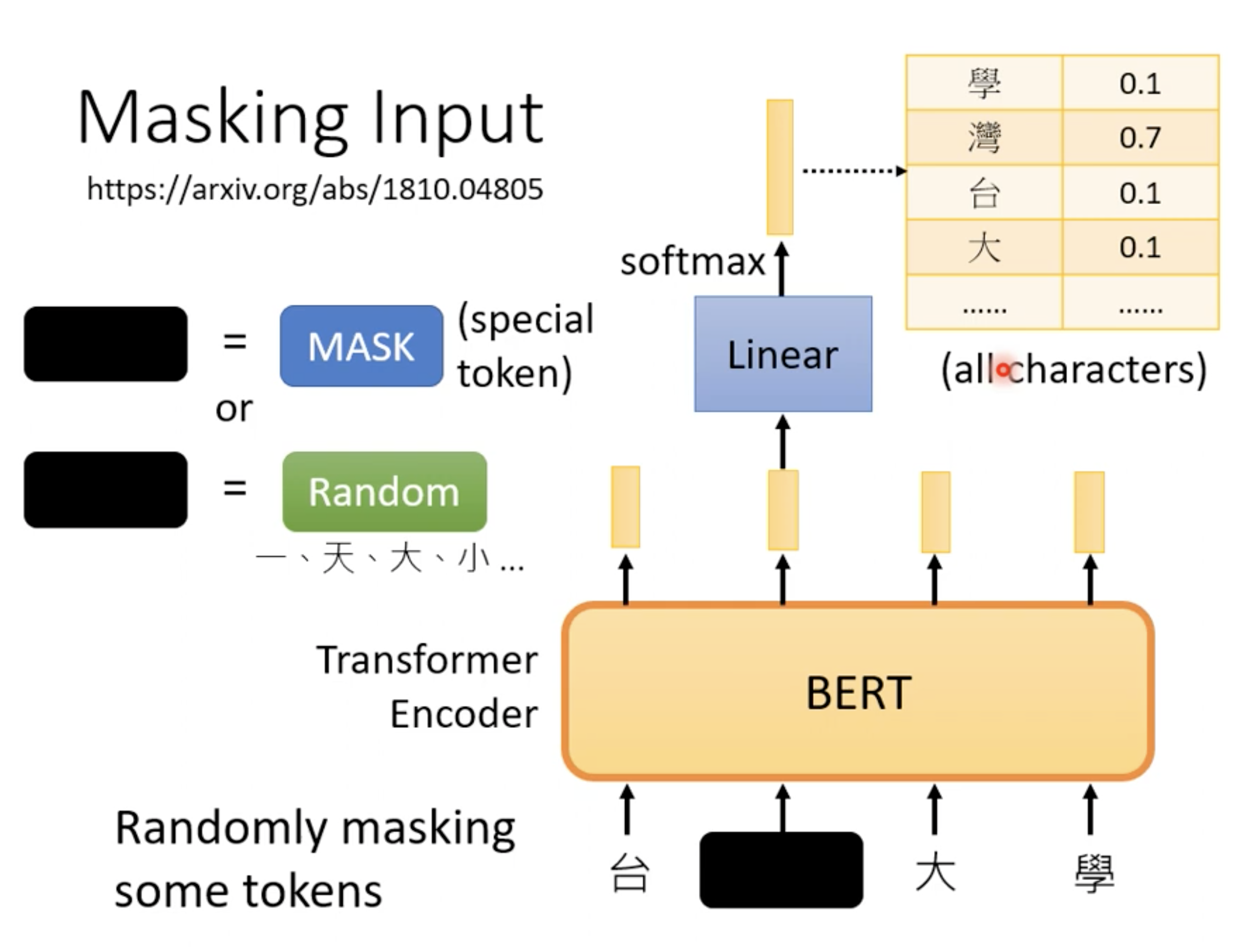

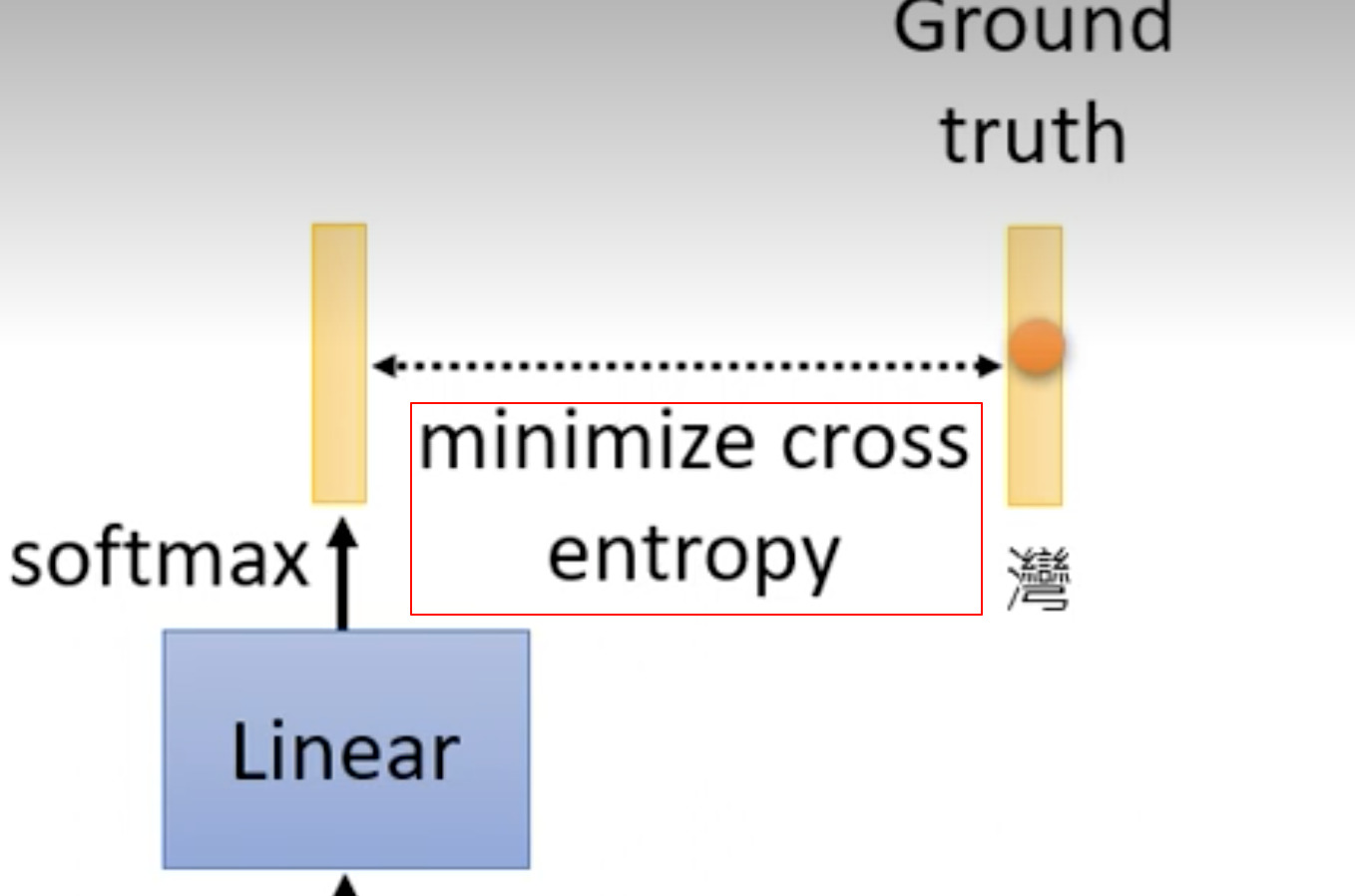

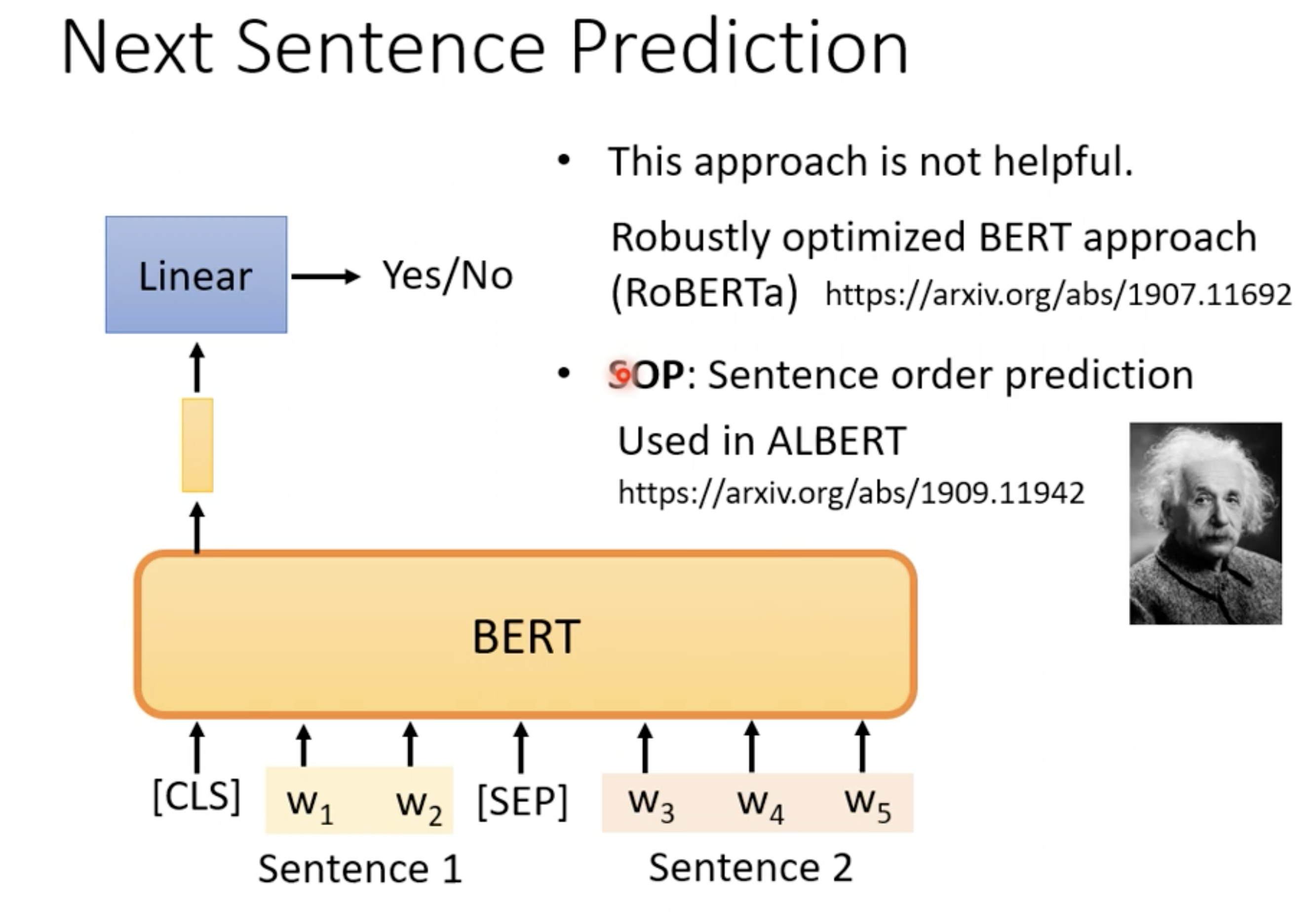

- BERT 由 Google 提出,在大规模文本语料库上进行无监督预训练。它通过掩码语言模型(Masked Language Model,MLM)和下一句预测(Next Sentence Prediction,NSP)两个任务进行预训练。

- 掩码语言模型随机掩盖输入文本中的一些单词,然后让模型预测被掩盖的单词。下一句预测任务则判断两个句子在原文中是否连续出现。

- BERT 在预训练后,可以在各种自然语言处理任务上进行微调,如文本分类、命名实体识别、问答系统等,取得了非常好的效果。

GPT(Generative Pretrained Transformer)系列:

- OpenAI 推出的 GPT 系列模型,包括 GPT、GPT-2、GPT-3 等。这些模型采用无监督的语言模型预训练方法,即通过预测下一个单词来学习语言的统计规律和语义信息。

- GPT-3 是目前最大的语言模型之一,拥有 1750 亿个参数。它在大量的文本数据上进行预训练,可以生成非常自然和流畅的文本,并且在各种自然语言处理任务上表现出色。

二、计算机视觉领域

ImageNet 预训练:

- 在计算机视觉领域,很多模型都是在 ImageNet 数据集上进行预训练。ImageNet 是一个大规模的图像分类数据集,包含超过 1400 万张图像和 2 万多个类别。

- 模型通常在 ImageNet 上进行有监督的预训练,即使用图像的类别标签进行训练。预训练后的模型可以作为特征提取器,在其他计算机视觉任务上进行微调,如目标检测、图像分割等。

自监督学习预训练:

- 近年来,自监督学习在计算机视觉领域也取得了很大的进展。例如,对比学习(Contrastive Learning)方法通过让模型学习区分正样本对和负样本对,从而学习到图像的特征表示。

- 一些著名的自监督学习方法包括 MoCo(Momentum Contrast)、SimCLR(Simple Framework for Contrastive Learning of Visual Representations)等。这些方法在大规模无标注图像数据集上进行预训练,可以学习到通用的图像特征表示,并且在下游任务上取得了很好的效果。

三、语音处理领域

wav2vec 系列:

- Facebook AI 提出的 wav2vec 系列模型采用自监督学习方法在大规模语音数据集上进行预训练。

- wav2vec 2.0 通过预测被掩盖的音频片段来学习语音的特征表示。预训练后的模型可以在语音识别、语音合成等任务上进行微调。

HuBERT(Hidden-Unit BERT):

- HuBERT 也是一种基于自监督学习的语音预训练模型。它通过对音频信号进行聚类,然后让模型预测音频片段所属的聚类类别来进行预训练。

- HuBERT 在语音处理任务上表现出了很高的性能,并且可以与其他语音处理技术相结合,提高语音处理系统的性能。

这些预训练模型在各自的领域中都取得了非常好的效果,并且为人工智能的发展做出了重要贡献。随着技术的不断进步,预训练方法也在不断发展和创新,未来将会有更多更强大的预训练模型出现。

以 BERT(Bidirectional Encoder Representations from Transformers)为例。

一、预训练数据

BERT 使用大规模的文本语料库进行预训练,例如维基百科、书籍等。这些文本数据涵盖了各种领域和主题,为模型提供了丰富的语言知识和模式。

二、预训练任务

掩码语言模型(Masked Language Model,MLM):

- 随机选择输入文本中的一些单词,将其替换为特殊的掩码标记 [MASK]。

- 模型的任务是根据上下文预测被掩码的单词。例如,对于句子“今天天气很[MASK]。”,模型需要预测出被掩码的单词“好”。

- 通过这种方式,模型学习到语言的上下文信息和语义表示。

下一句预测(Next Sentence Prediction,NSP):

- 给定两个句子 A 和 B,模型需要判断句子 B 是否是句子 A 的下一句。

- 例如,对于句子对“我喜欢吃苹果。”和“苹果是一种水果。”,模型应该判断出句子 B 是句子 A 的下一句;而对于句子对“我喜欢吃苹果。”和“我喜欢看电影。”,模型应该判断出句子 B 不是句子 A 的下一句。

- 这个任务帮助模型学习句子之间的关系和连贯性。

三、预训练过程

数据预处理:

- 对输入的文本进行清洗和预处理,包括去除特殊字符、转换为小写等。

- 将文本分割成单词或子词(subword),以便模型更好地处理不同长度的文本。

模型架构:

- BERT 使用 Transformer 架构,由多层编码器组成。

- 每个编码器层包含多头注意力机制(Multi-Head Attention)和前馈神经网络(Feed-Forward Neural Network)。

训练参数设置:

- 设置合适的学习率、批次大小、训练轮数等参数。

- 通常使用大规模的分布式训练,利用多块 GPU 或 TPU 加速训练过程。

优化算法:

- 使用优化算法如 Adam 来更新模型的参数,最小化预训练任务的损失函数。

持续训练:

- 模型在大规模数据上进行多轮训练,不断调整参数以提高在预训练任务上的性能。

- 监控训练过程中的损失值和评估指标,确保模型在训练过程中不断改进。

四、预训练结果

经过预训练后,BERT 学习到了通用的语言表示,可以在各种自然语言处理任务上进行微调。

例如,在文本分类任务中,只需要在预训练的 BERT 模型上添加一个分类层,并在特定的任务数据集上进行微调,就可以得到一个性能良好的文本分类模型。

(

这句话可以从以下几个方面来理解:

一、预训练模型的优势

- 通用语言表示:预训练的 BERT 模型在大规模文本数据上进行了无监督学习,已经学习到了通用的语言表示,包括语法、语义、上下文信息等。这种通用的语言表示可以为各种自然语言处理任务提供一个良好的起点。

- 特征提取能力:BERT 模型具有强大的特征提取能力,能够自动从文本中提取出有用的特征。这些特征可以帮助模型更好地理解文本的含义,从而提高文本分类的准确性。

二、添加分类层

- 特定任务适应:在预训练的 BERT 模型上添加一个分类层,是为了使模型能够适应特定的文本分类任务。分类层通常是一个全连接层,它将 BERT 模型提取的特征映射到不同的类别上。

- 学习任务相关信息:通过添加分类层,模型可以学习到与特定任务相关的信息,例如不同类别的特征、类别之间的关系等。这样可以使模型更加专注于特定的任务,提高分类的准确性。

三、微调过程

- 利用特定任务数据集:在特定的任务数据集上进行微调,是为了让模型进一步适应特定的任务和数据分布。特定任务数据集通常是标注好的文本数据,其中每个文本都被分配了一个类别标签。

- 调整模型参数:微调过程中,模型会根据特定任务数据集的损失函数来调整自身的参数。这个过程类似于在预训练模型的基础上进行有监督学习,使模型能够更好地拟合特定任务的数据。

- 提高性能:通过微调,模型可以利用预训练模型的通用语言表示和特征提取能力,同时学习到特定任务的相关信息,从而提高文本分类的性能。

四、总结

在文本分类任务中,使用预训练的 BERT 模型并添加分类层进行微调,可以充分利用预训练模型的优势,快速构建一个性能良好的文本分类模型。这种方法不仅可以节省大量的训练时间和计算资源,还可以提高模型的泛化能力和准确性。

)

总之,BERT 的预训练过程通过利用大规模文本数据和精心设计的预训练任务,使模型学习到丰富的语言知识和模式,为后续的特定任务应用提供了强大的基础。

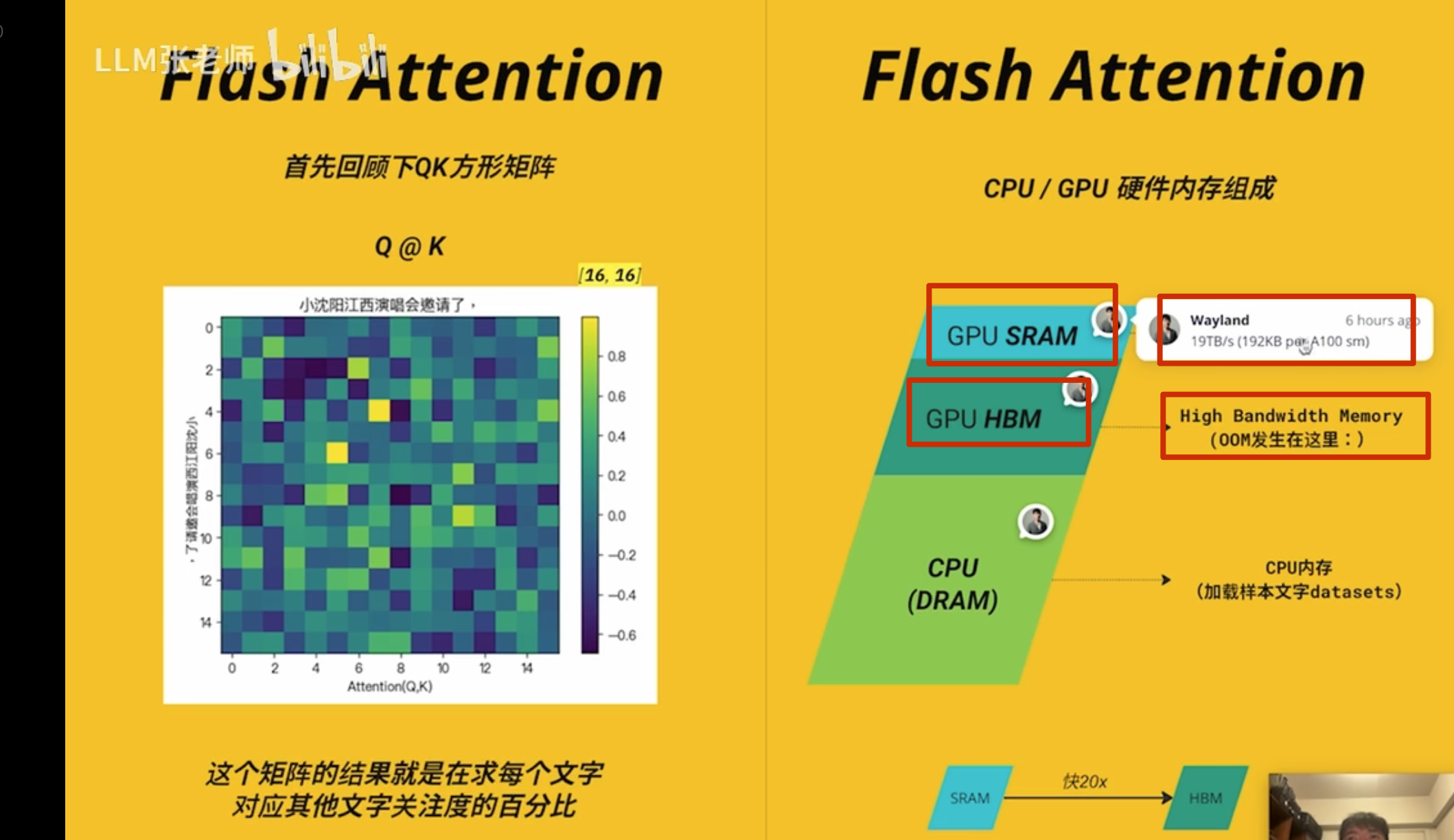

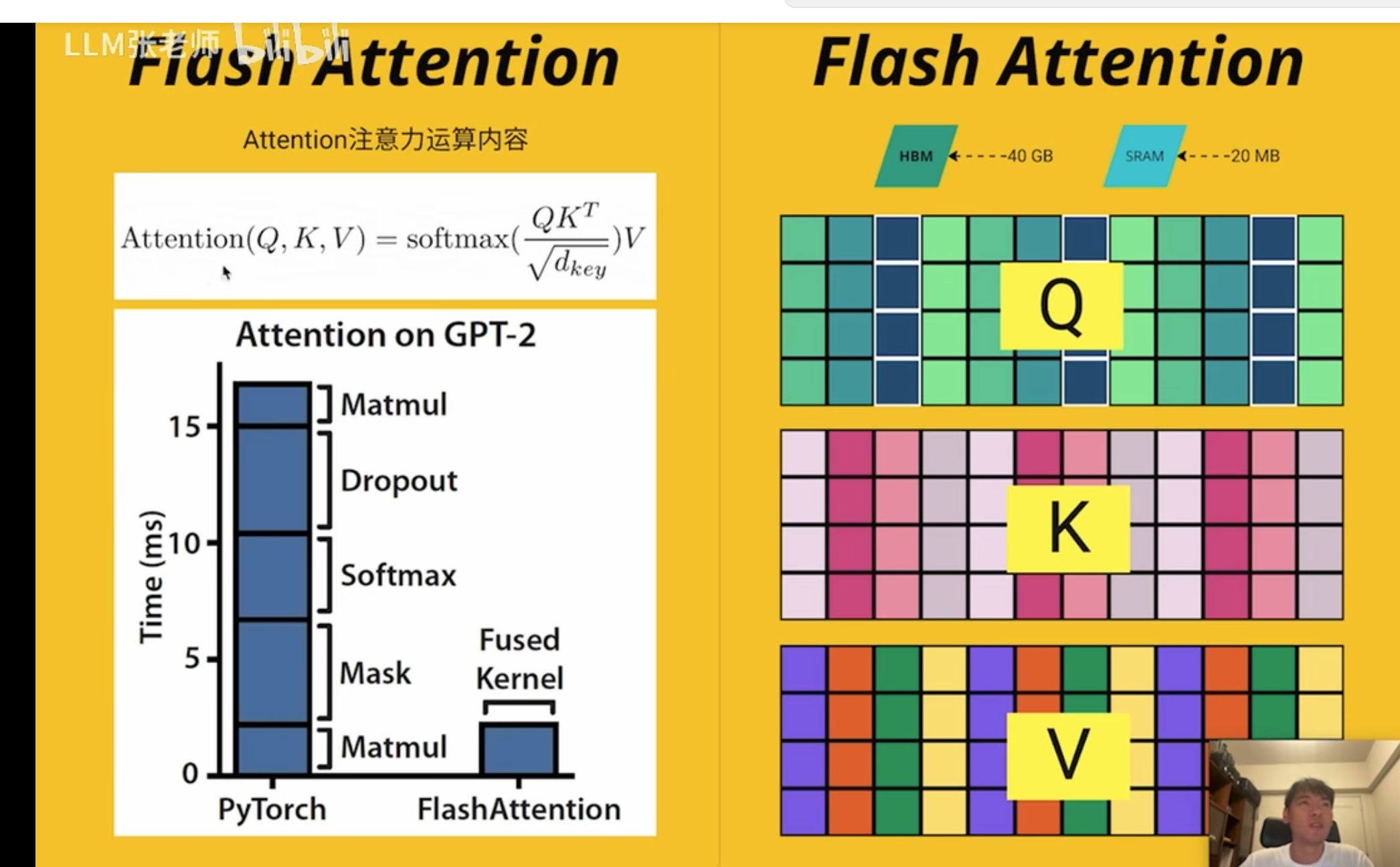

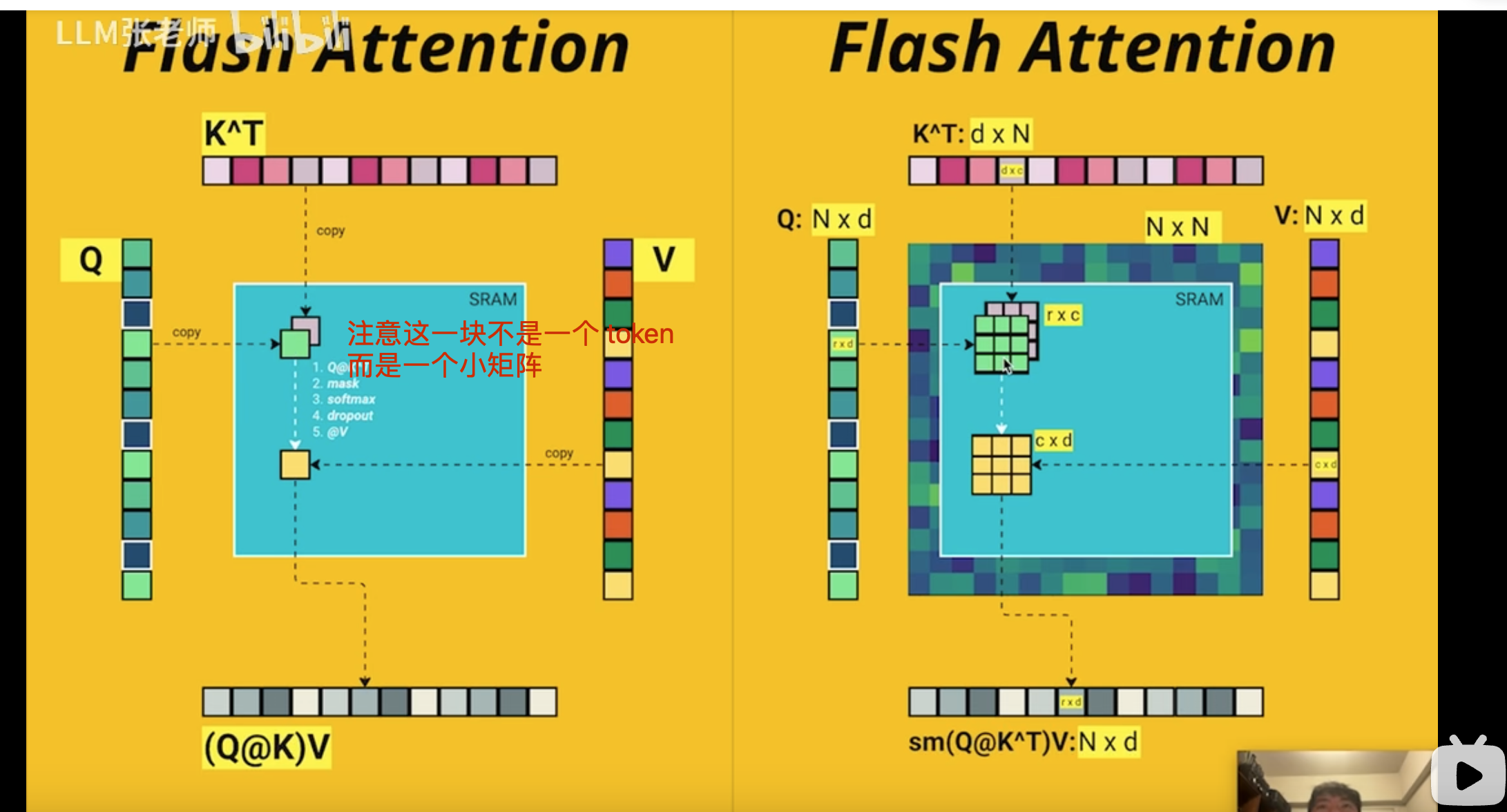

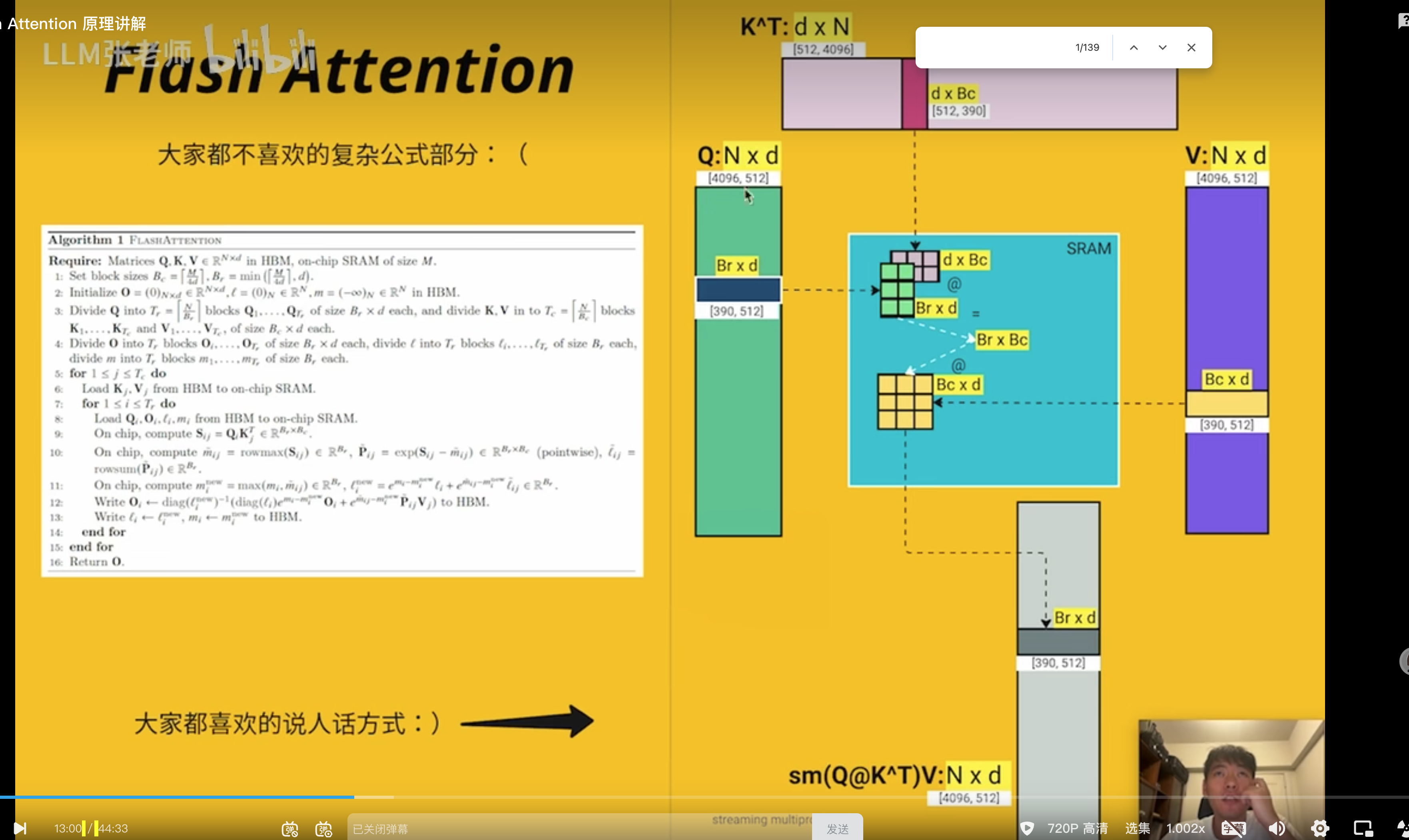

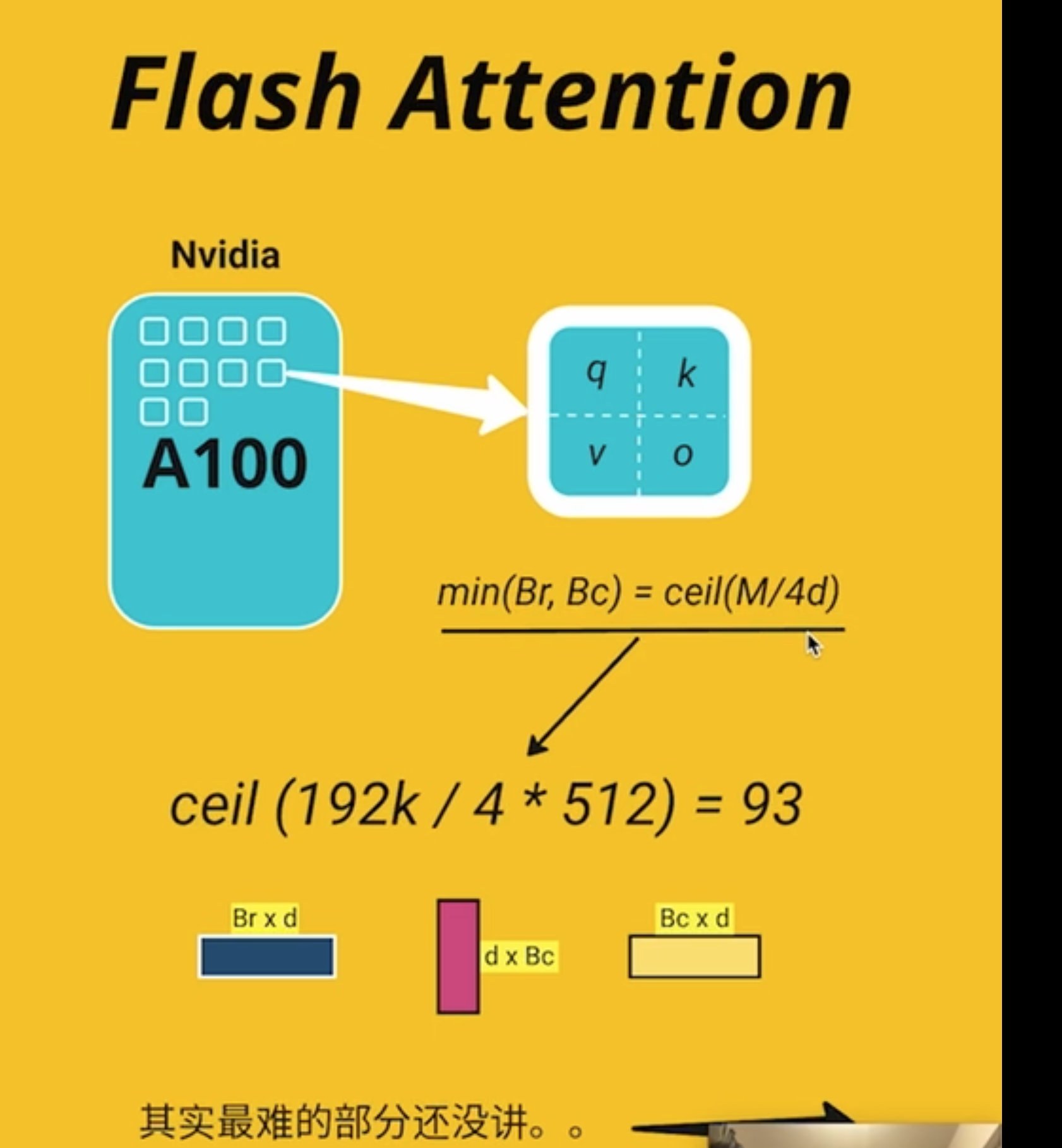

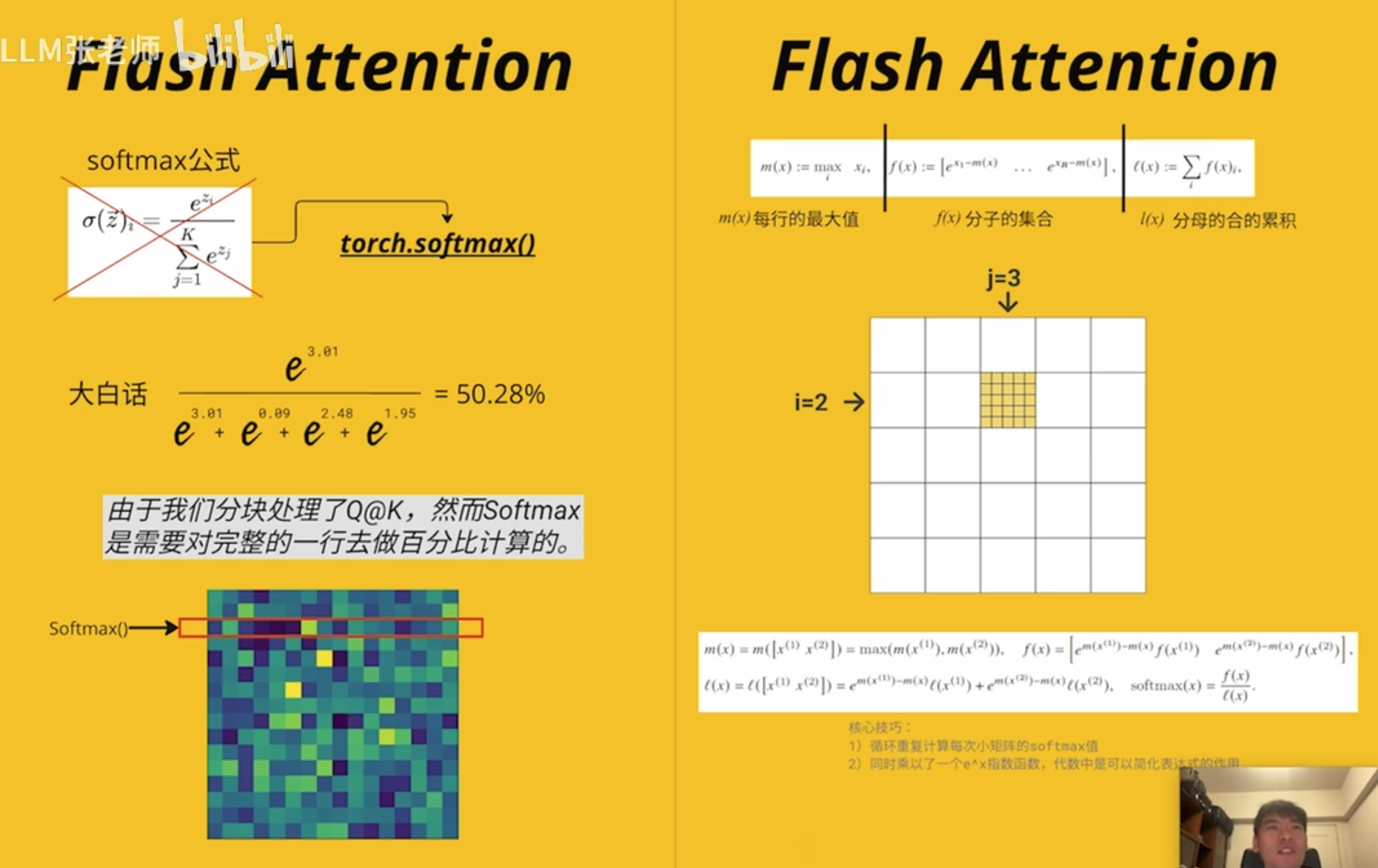

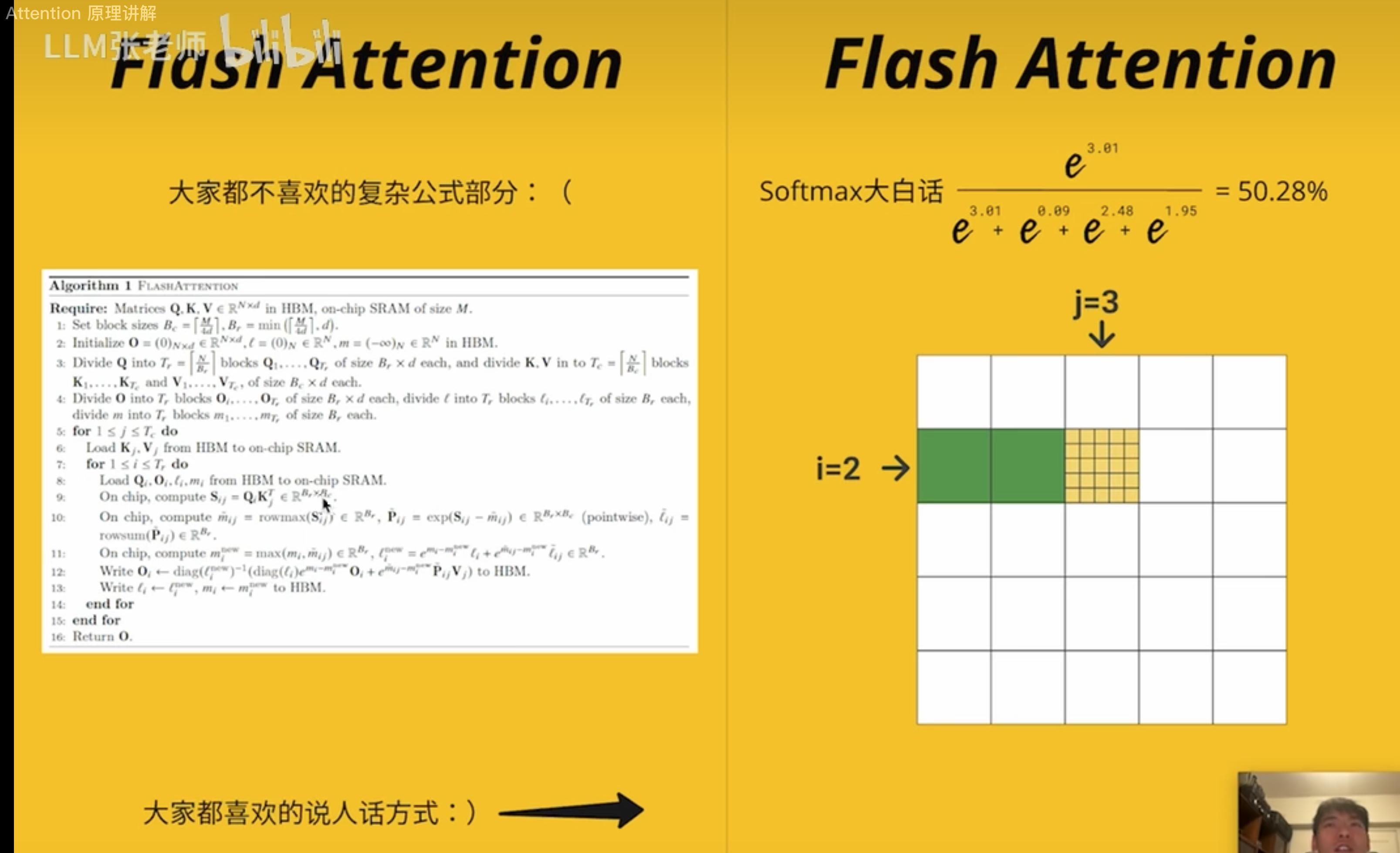

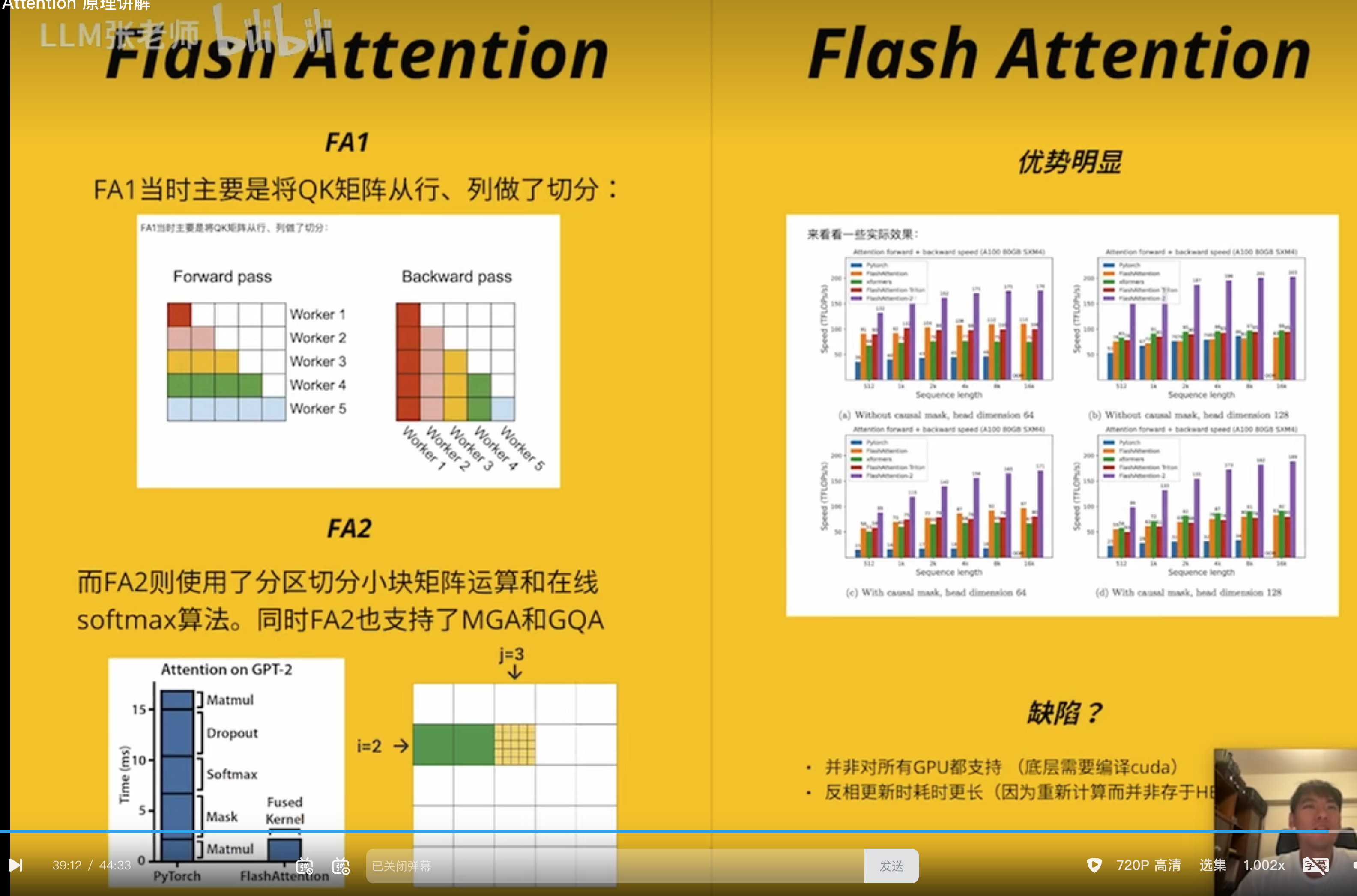

Flash Attention

耗时分析

耗时的反而不是矩阵相乘

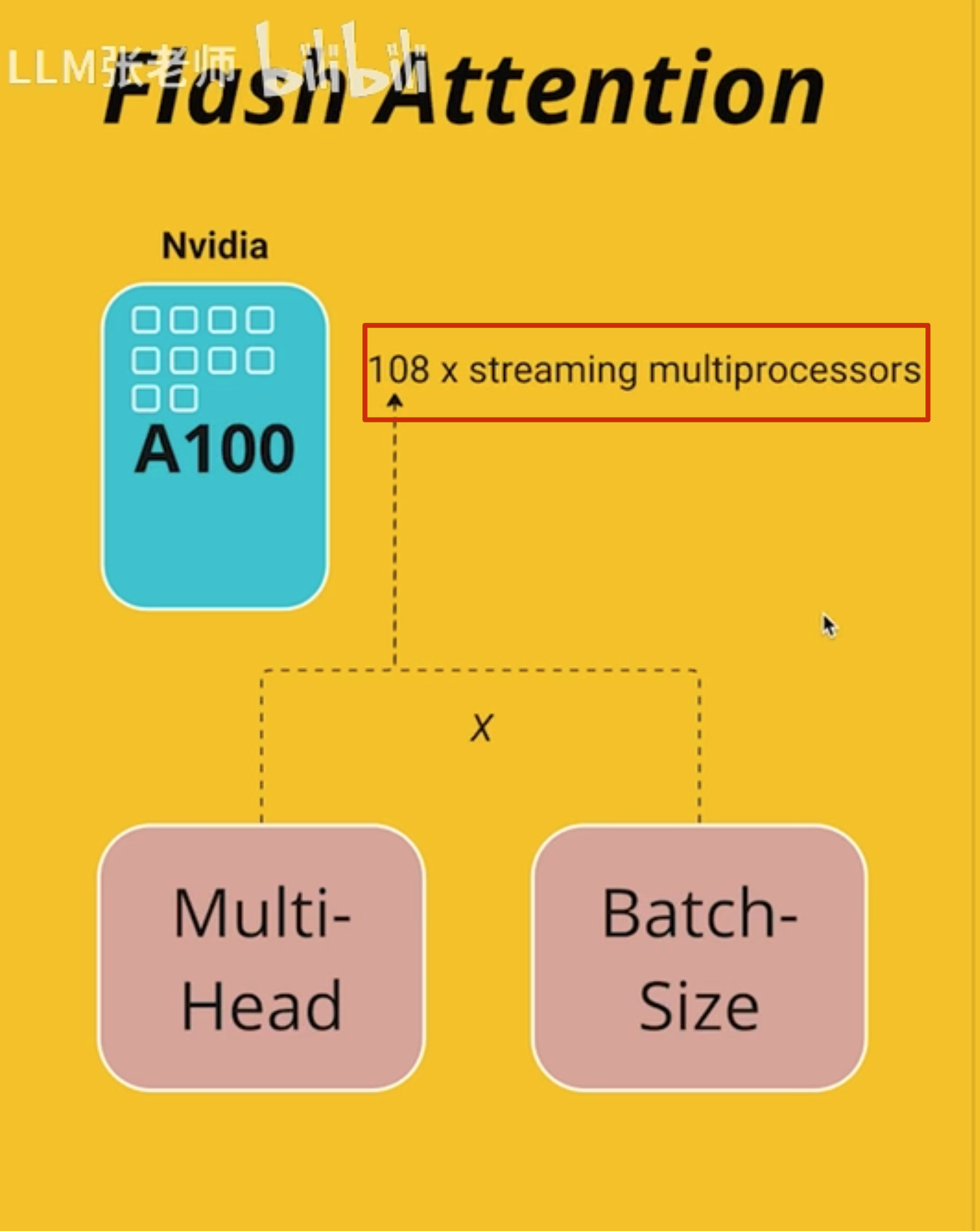

实际是多头和多批次的

A100 有 108 个

最难的是 softmax 运算这部分

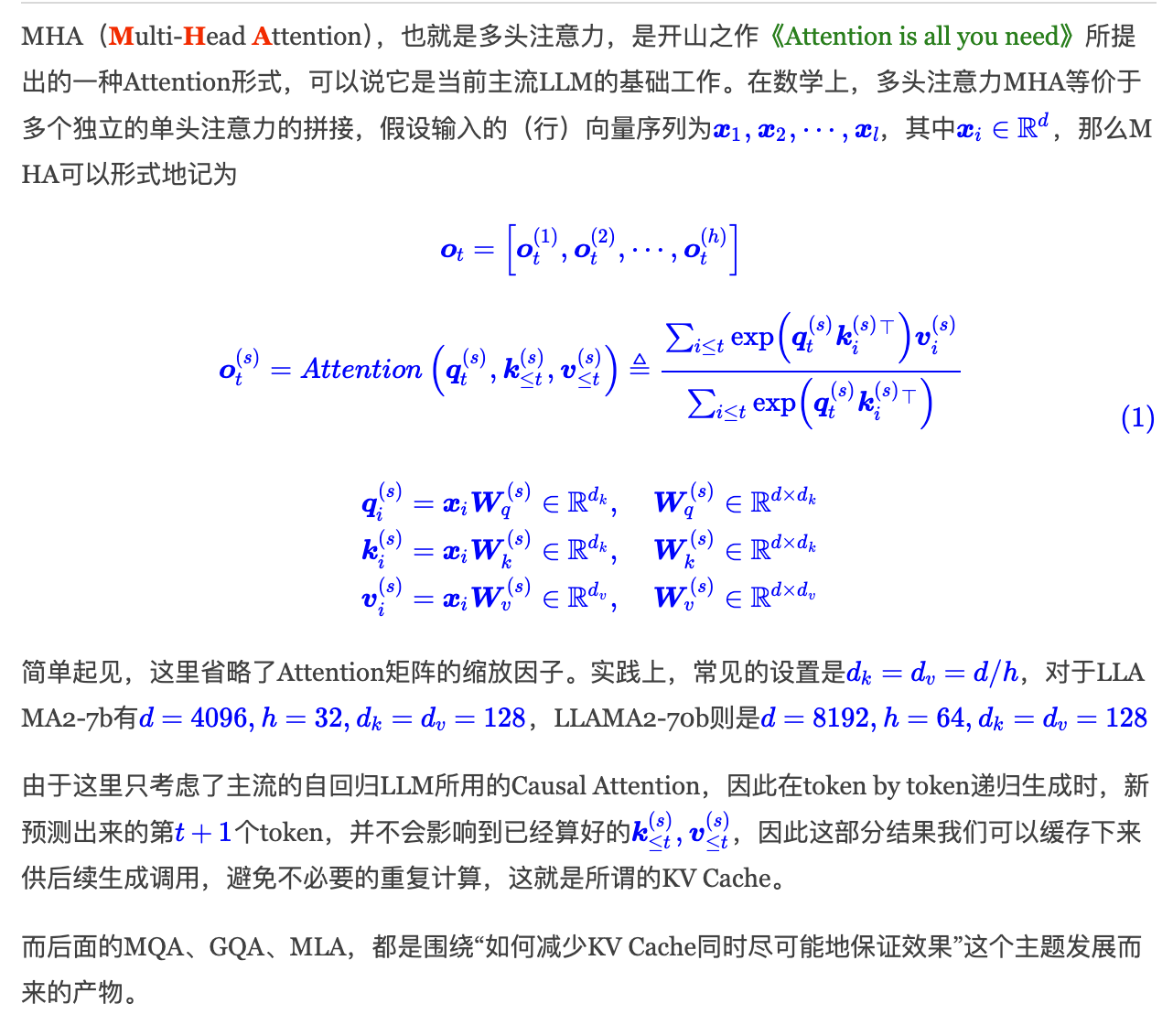

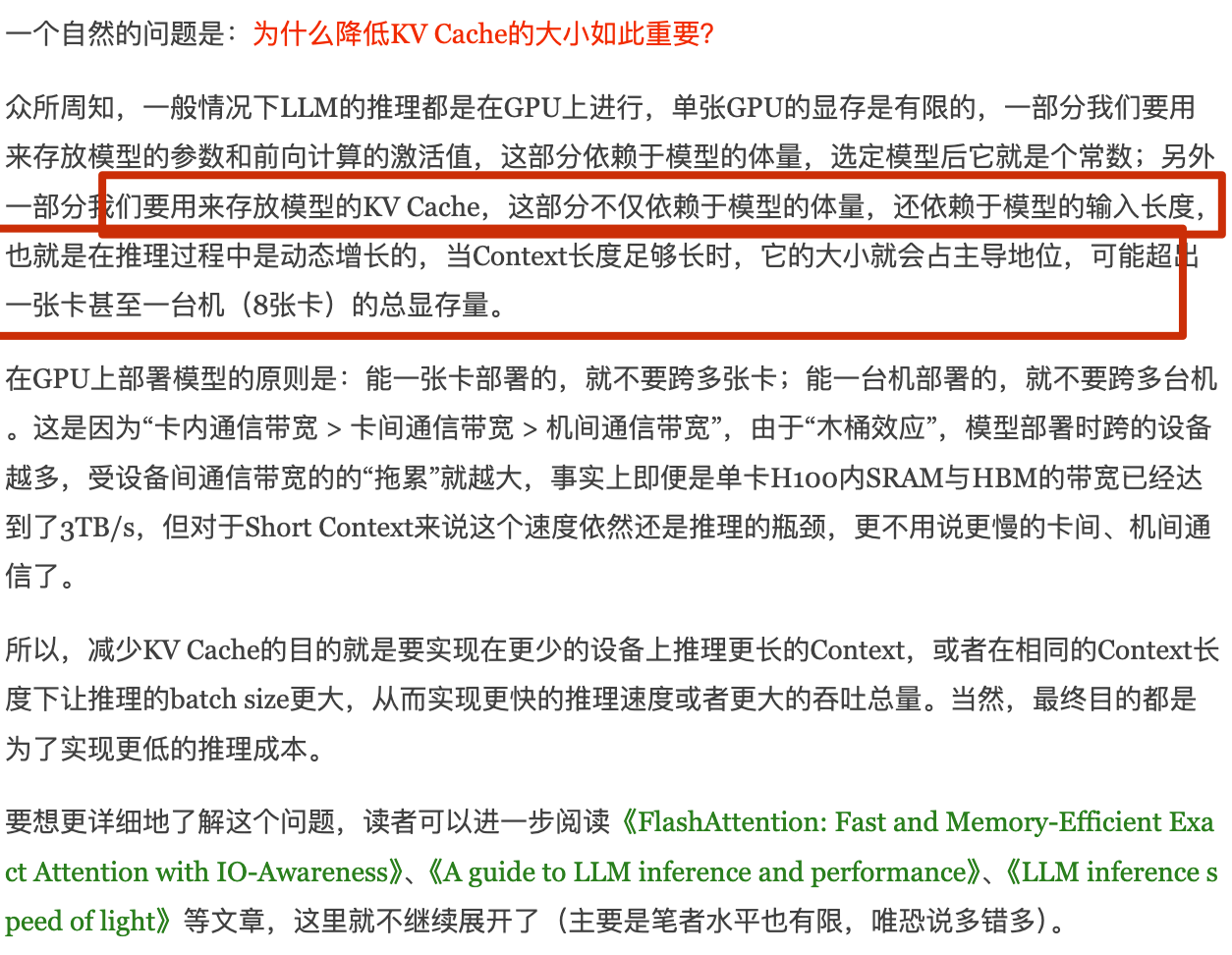

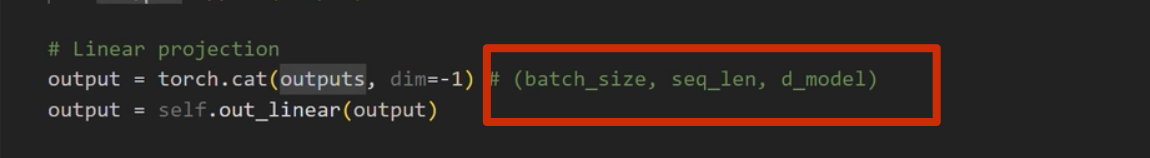

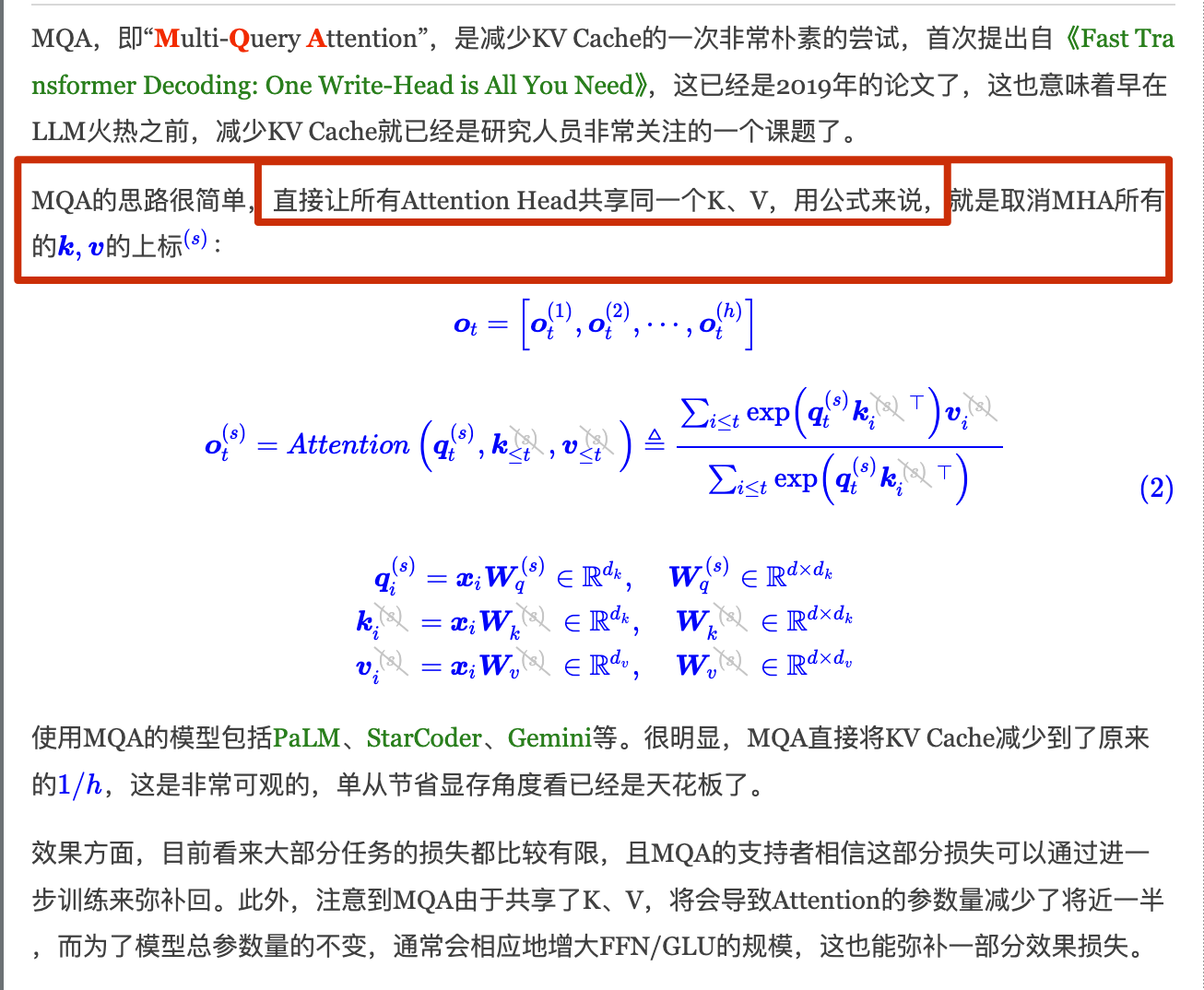

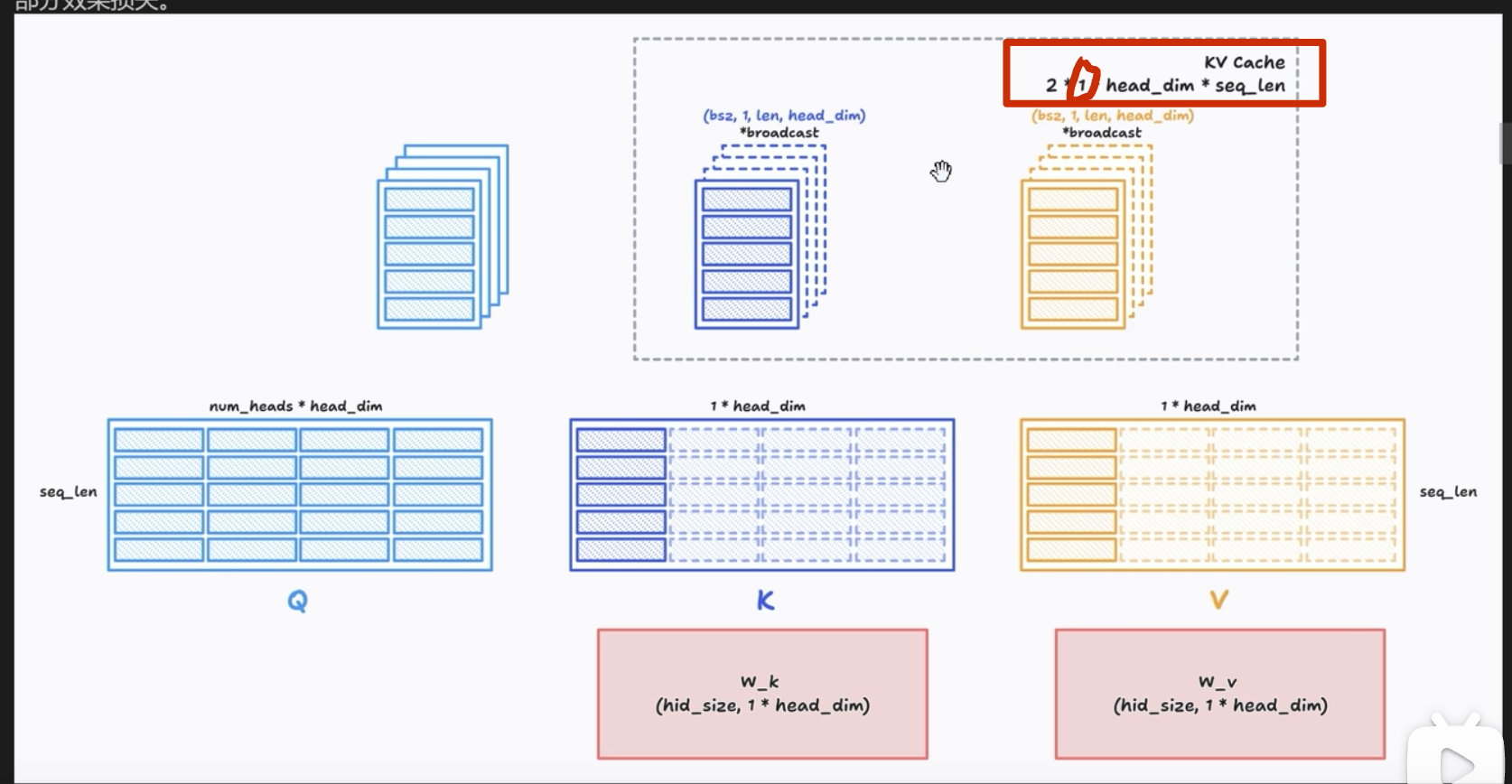

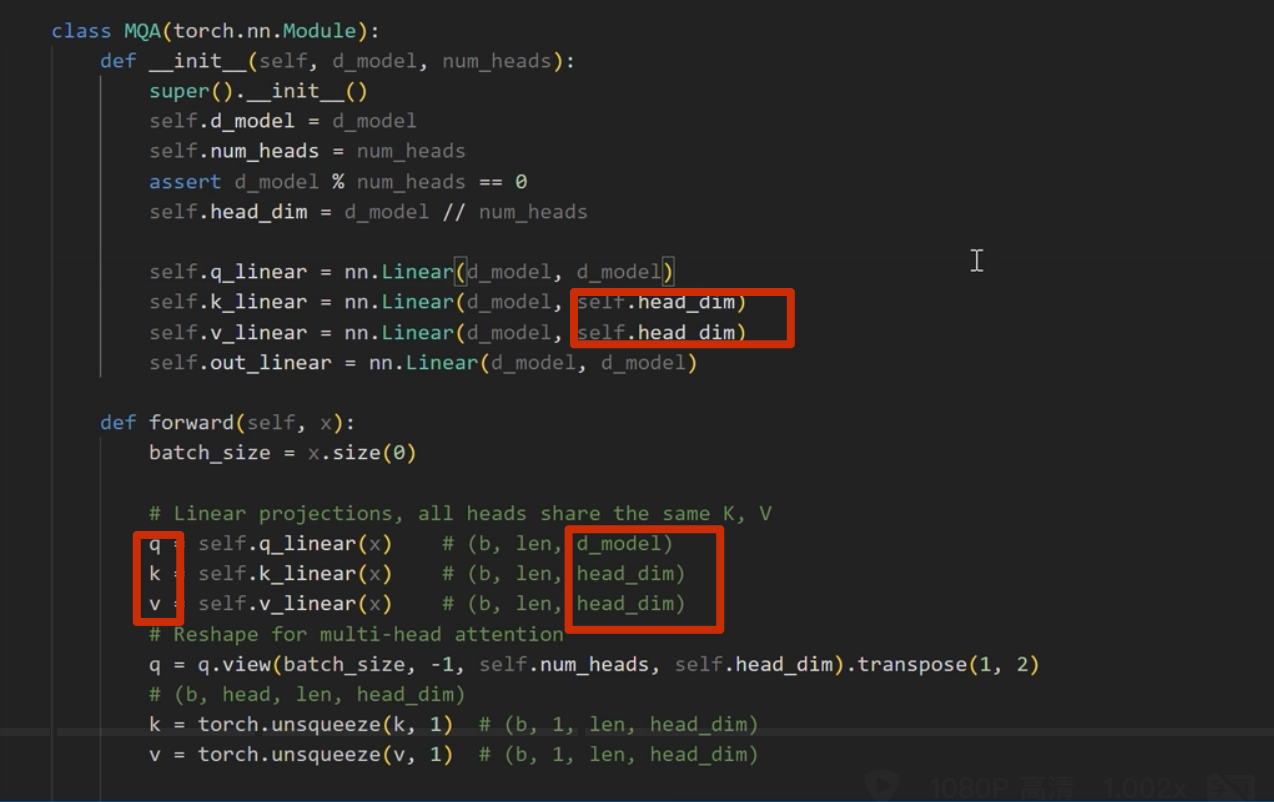

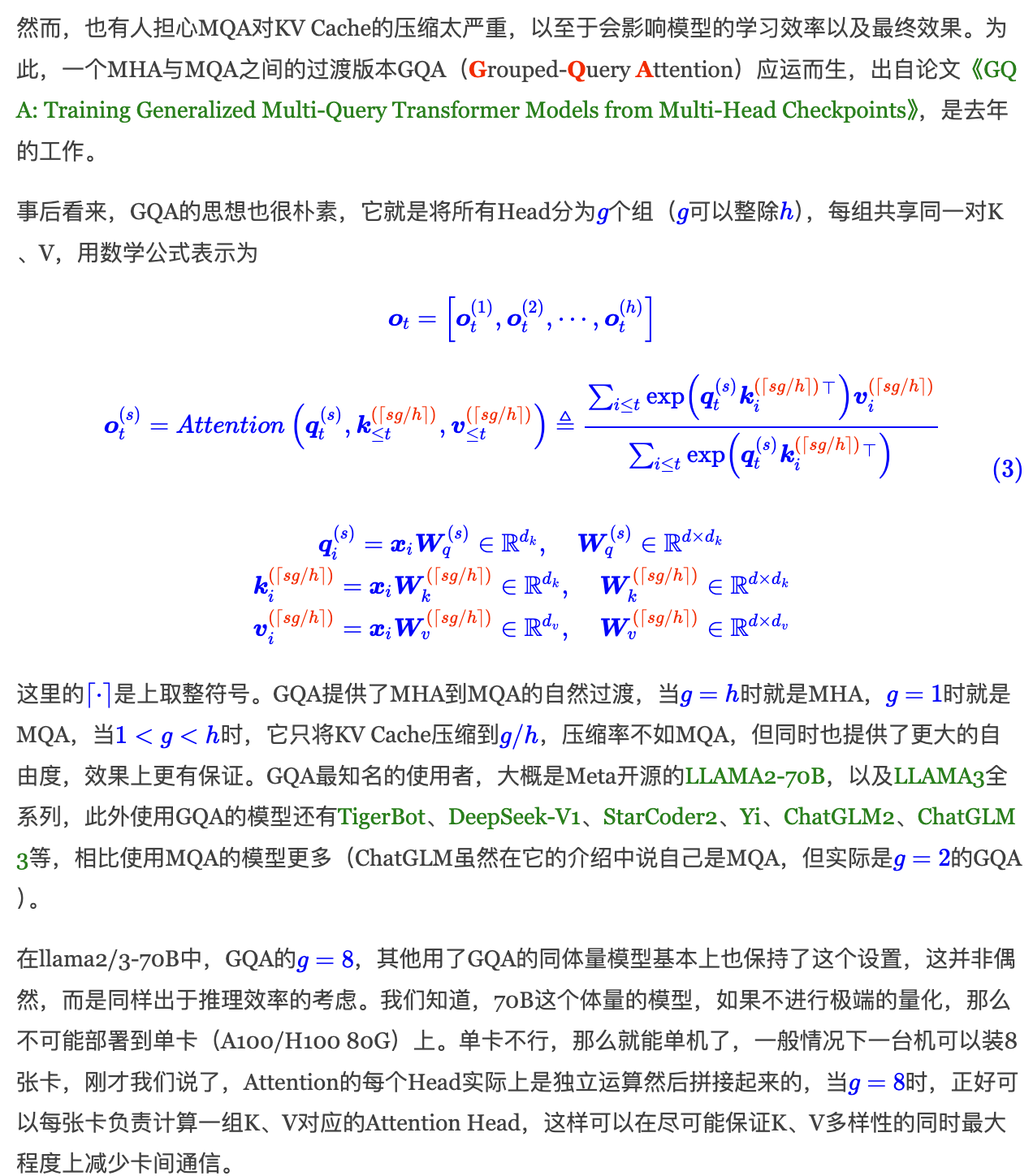

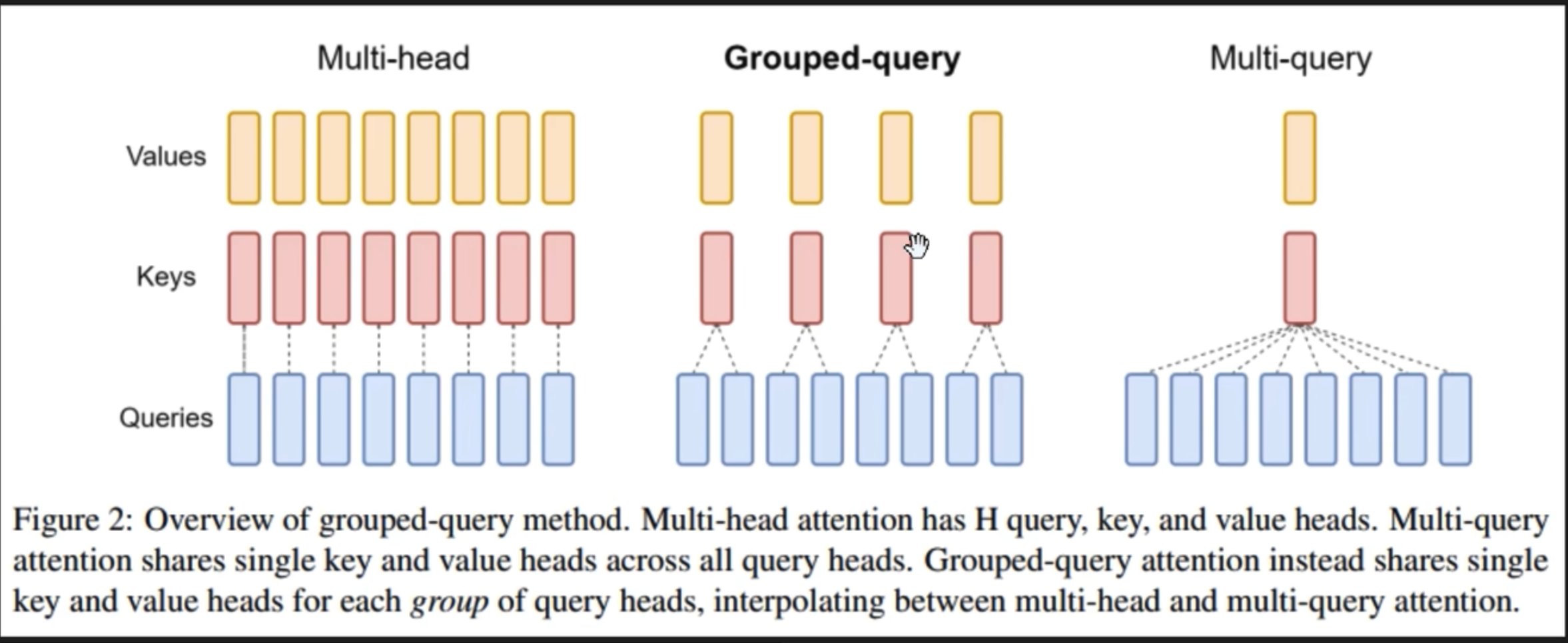

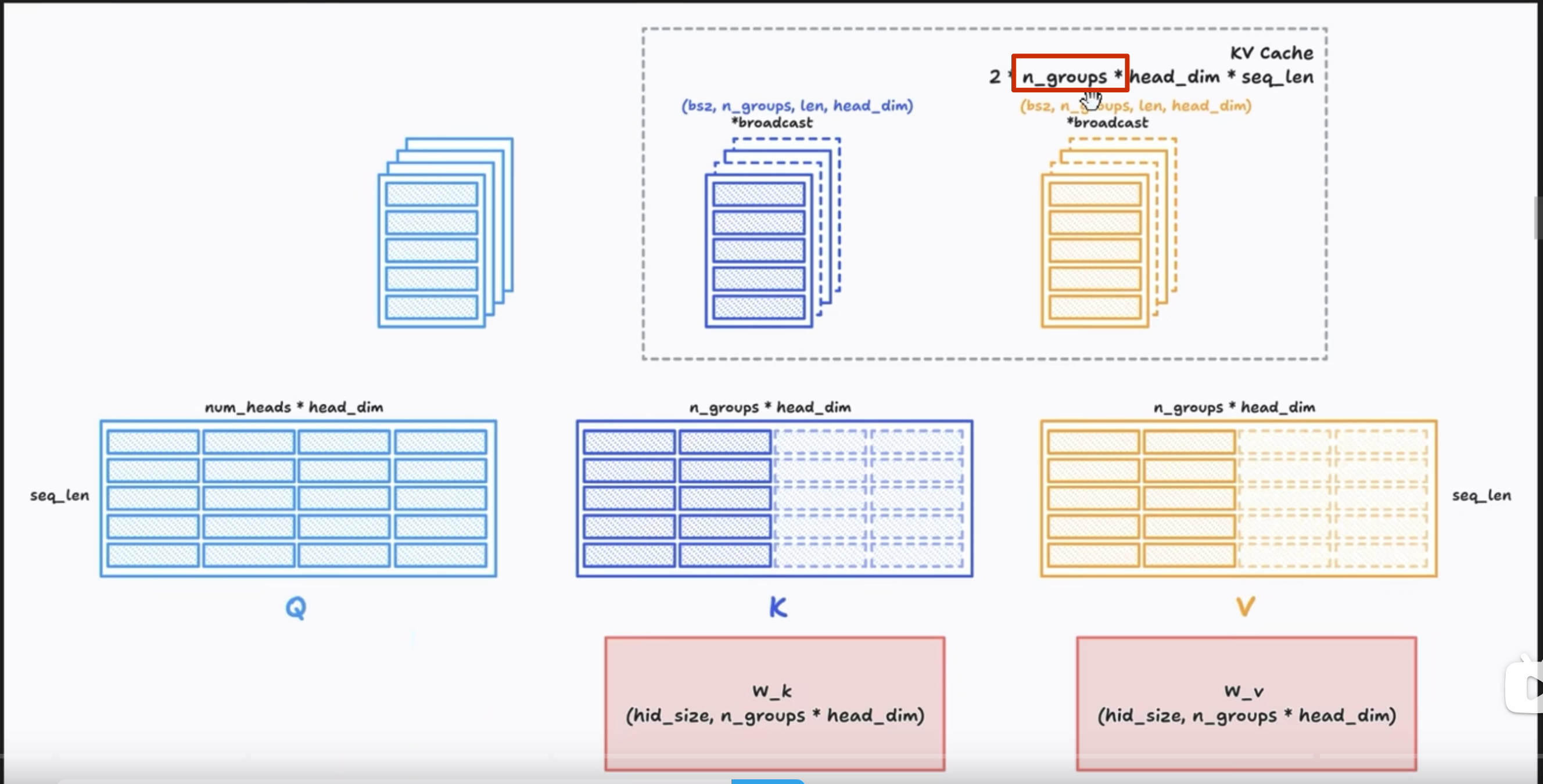

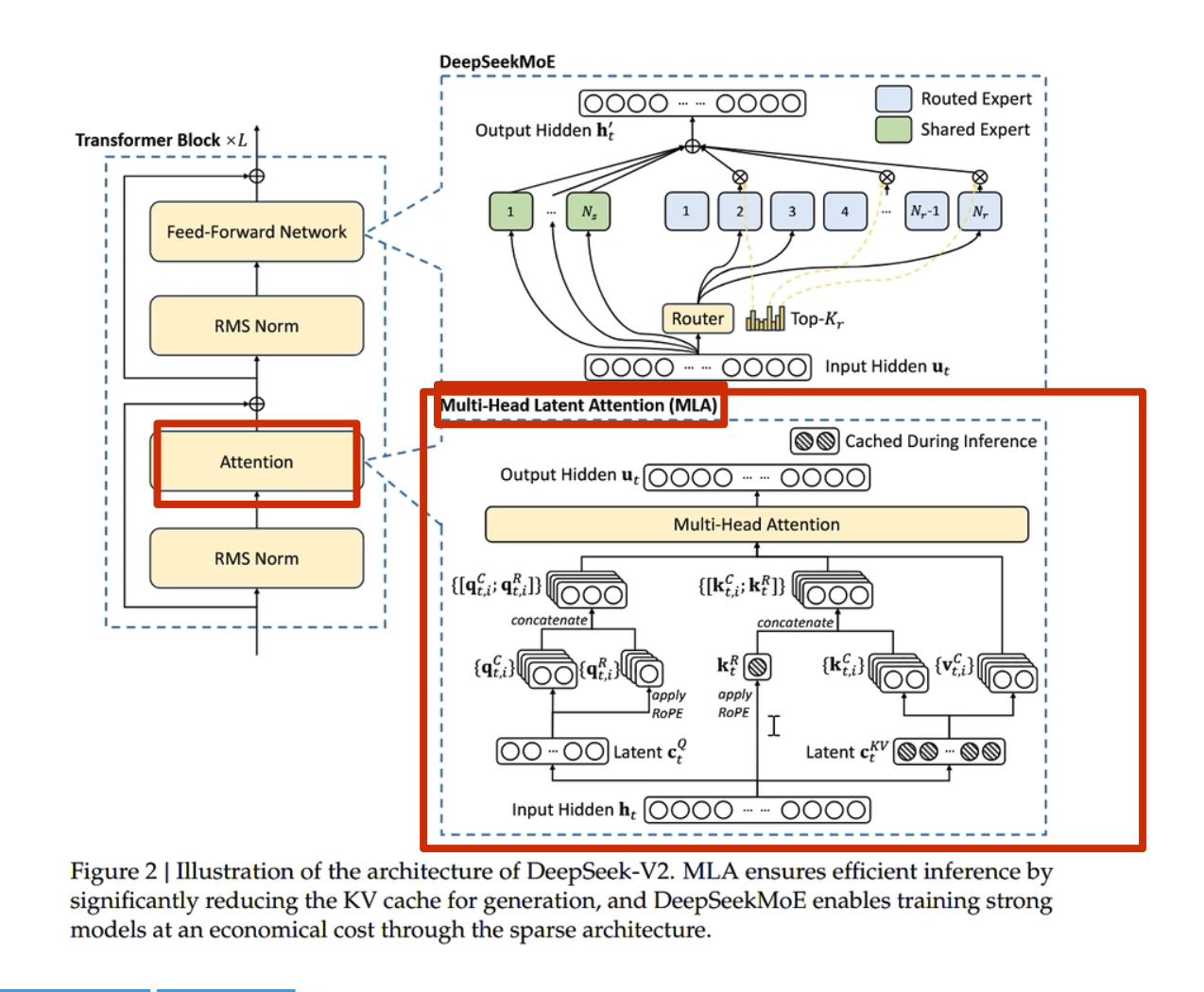

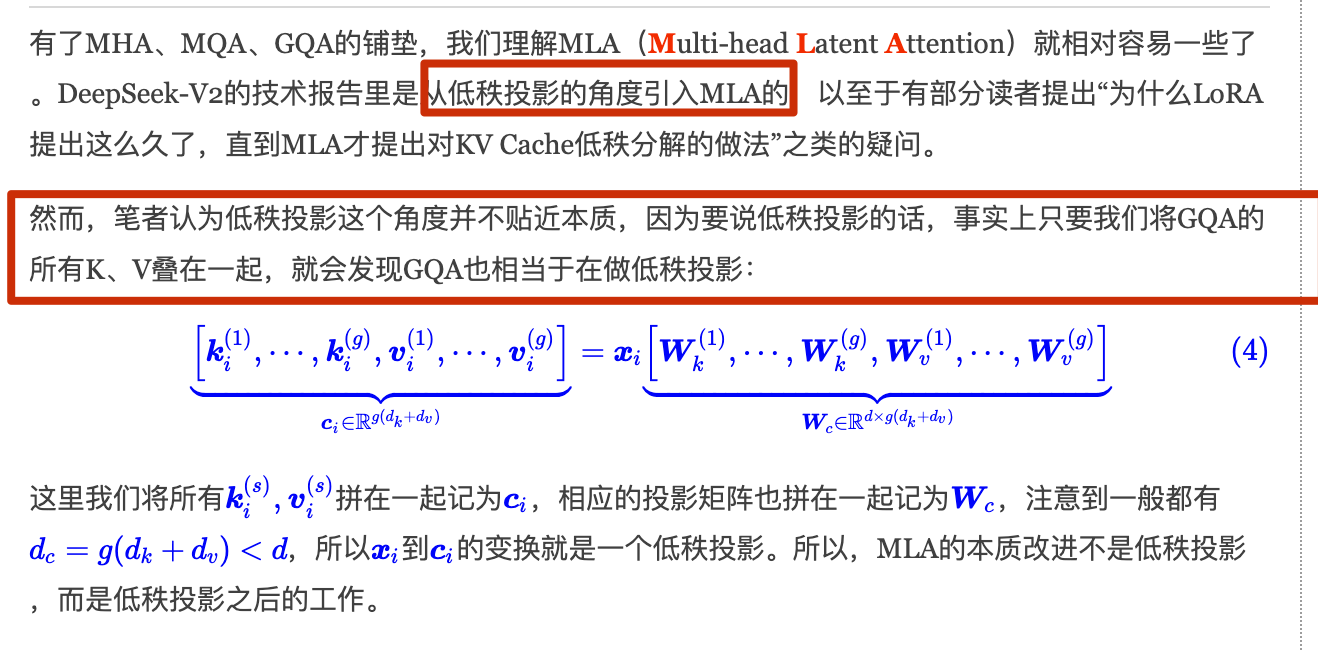

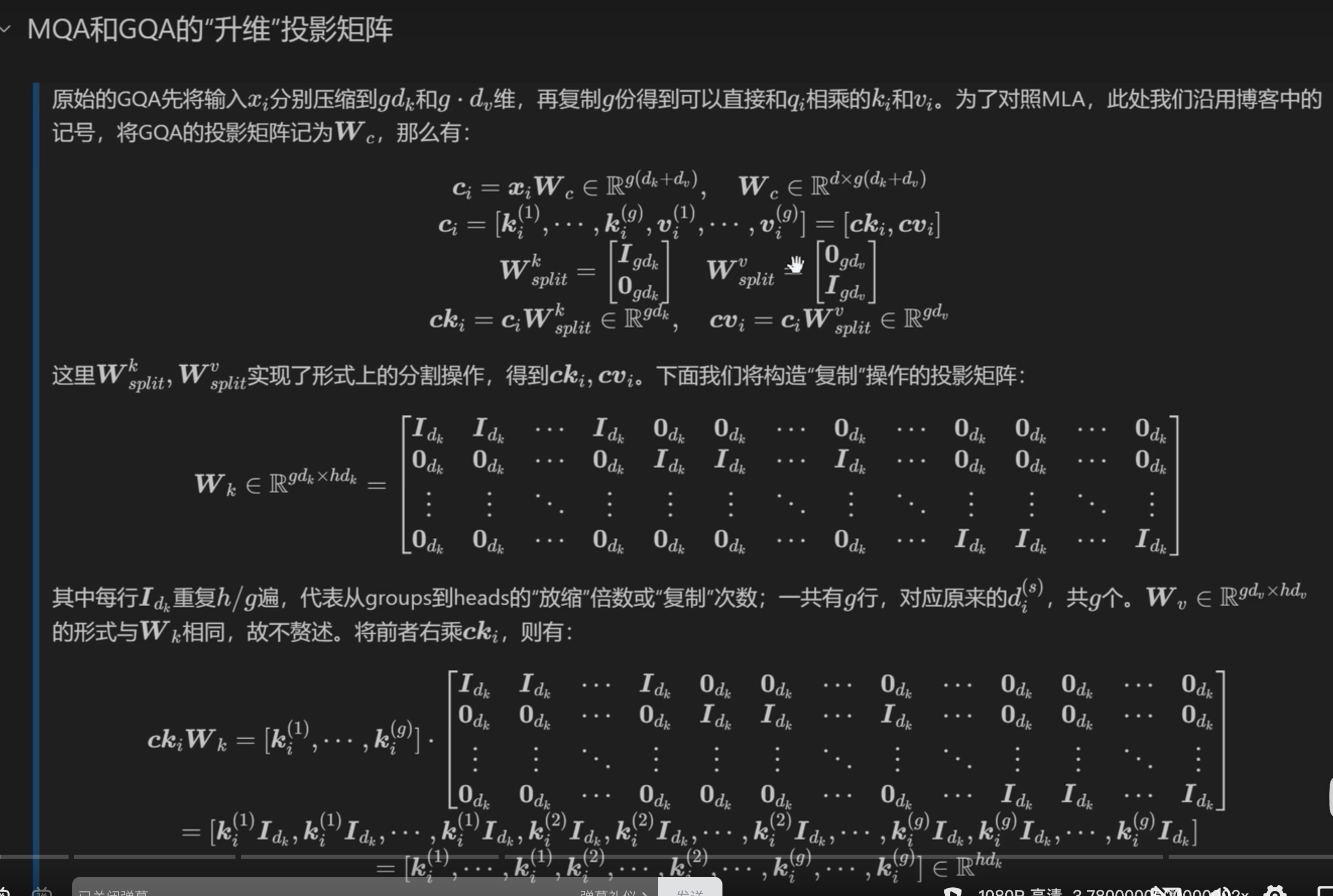

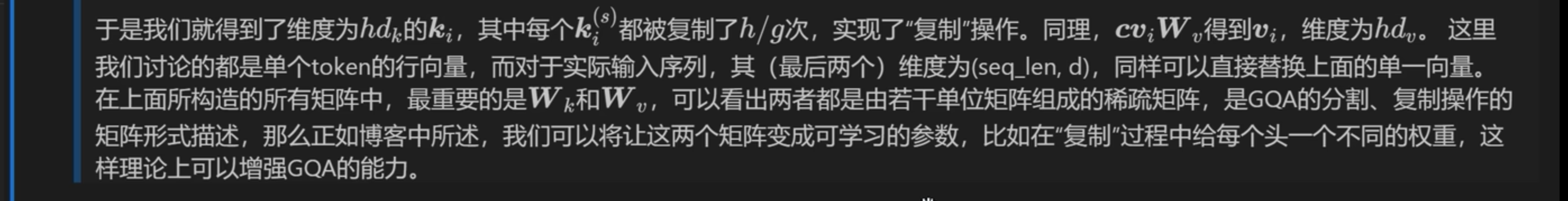

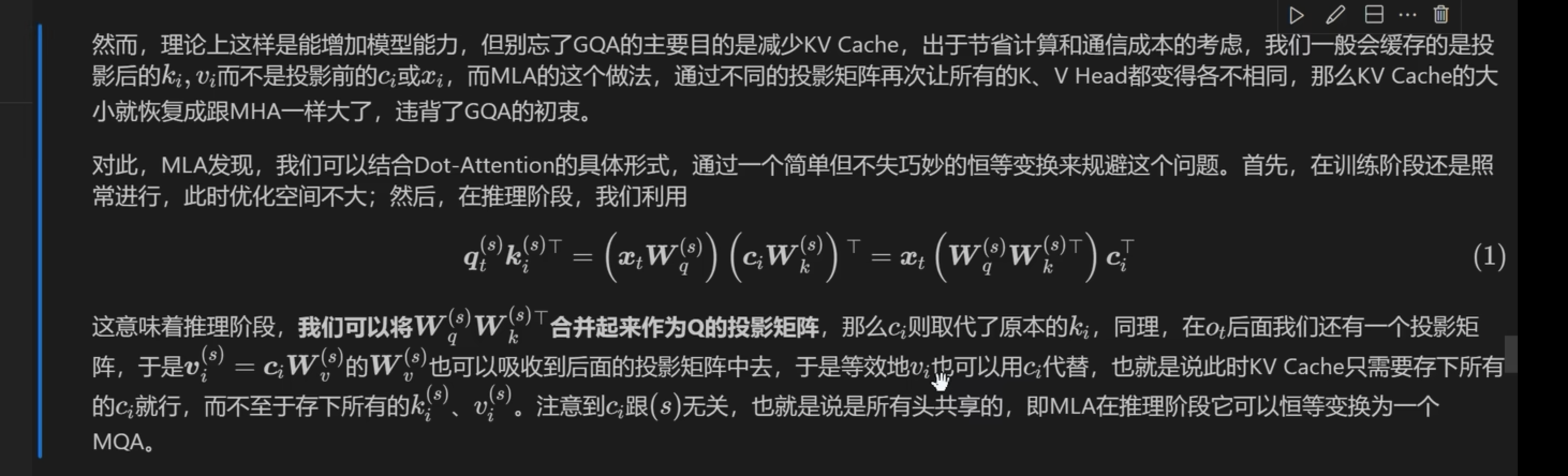

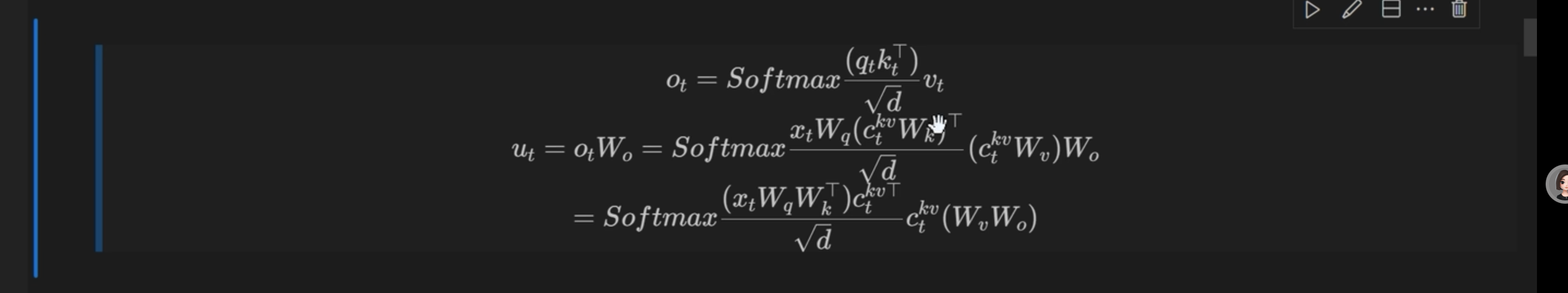

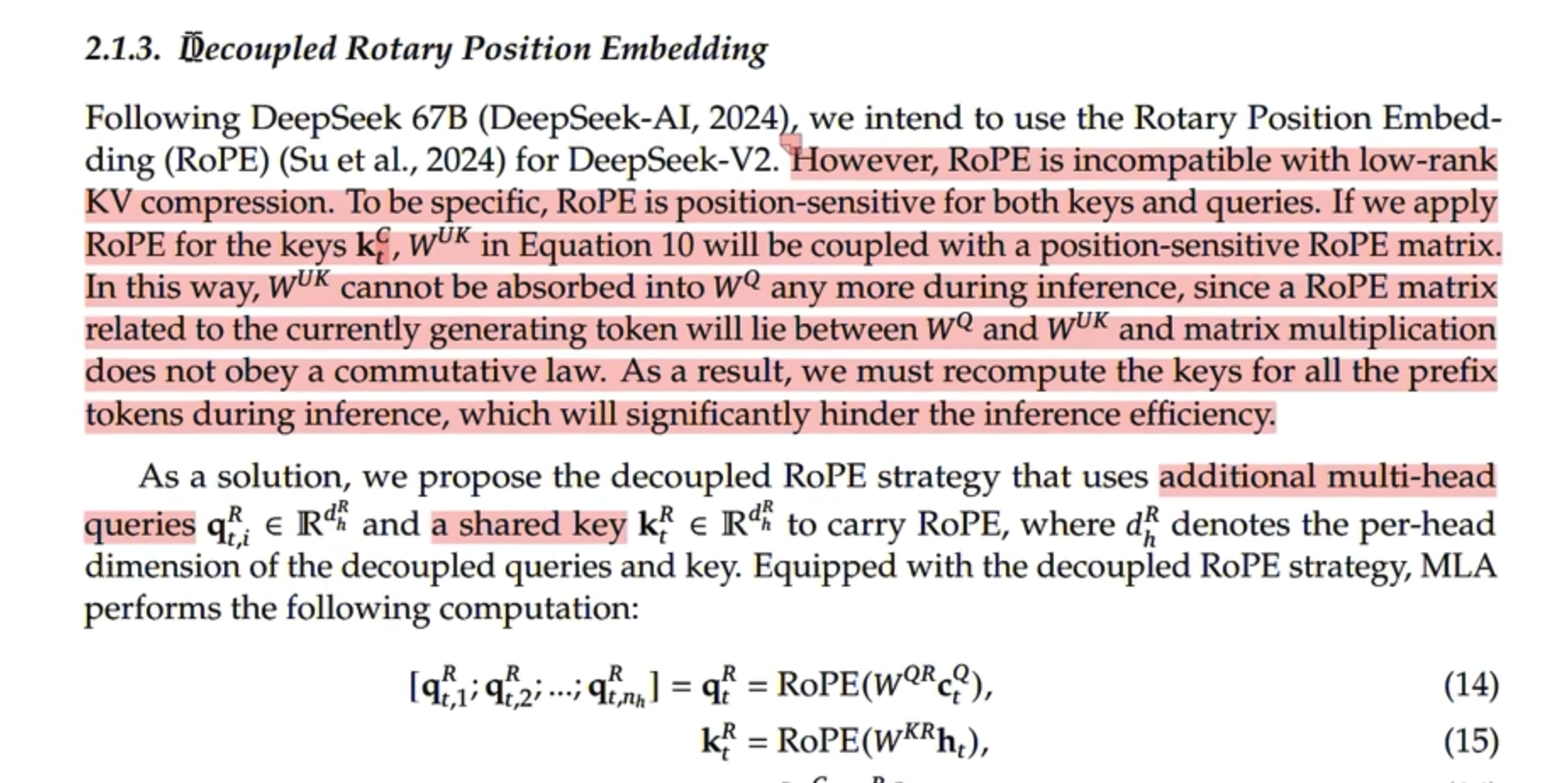

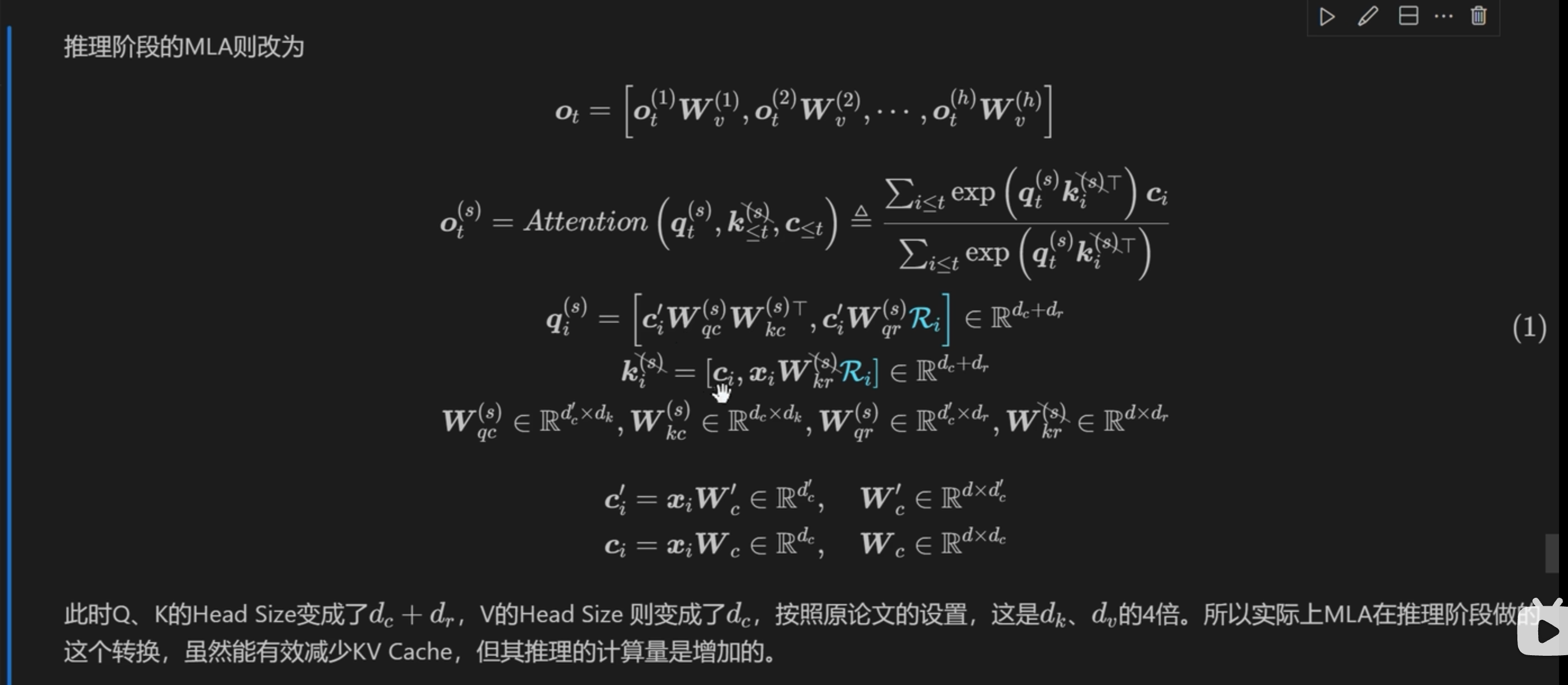

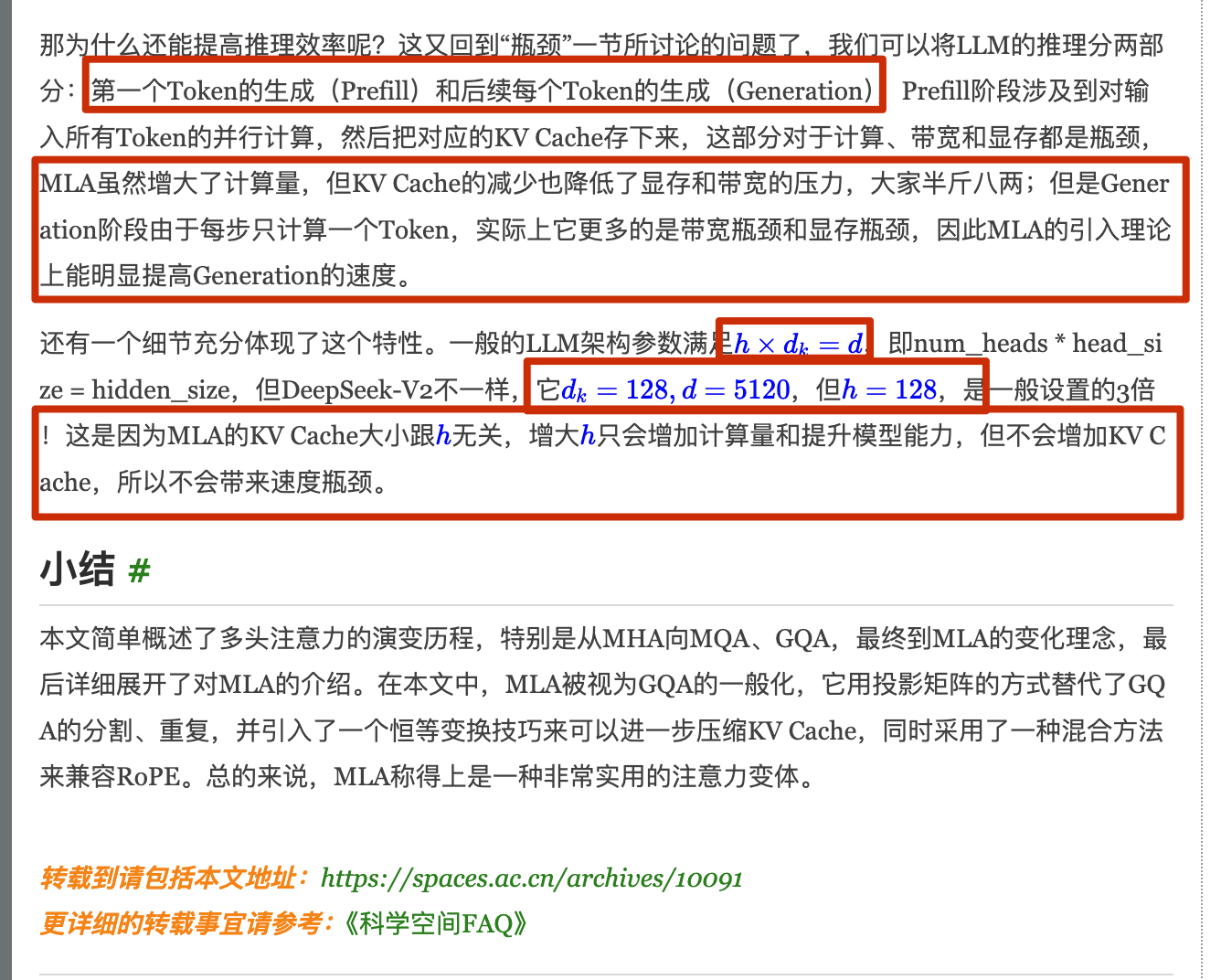

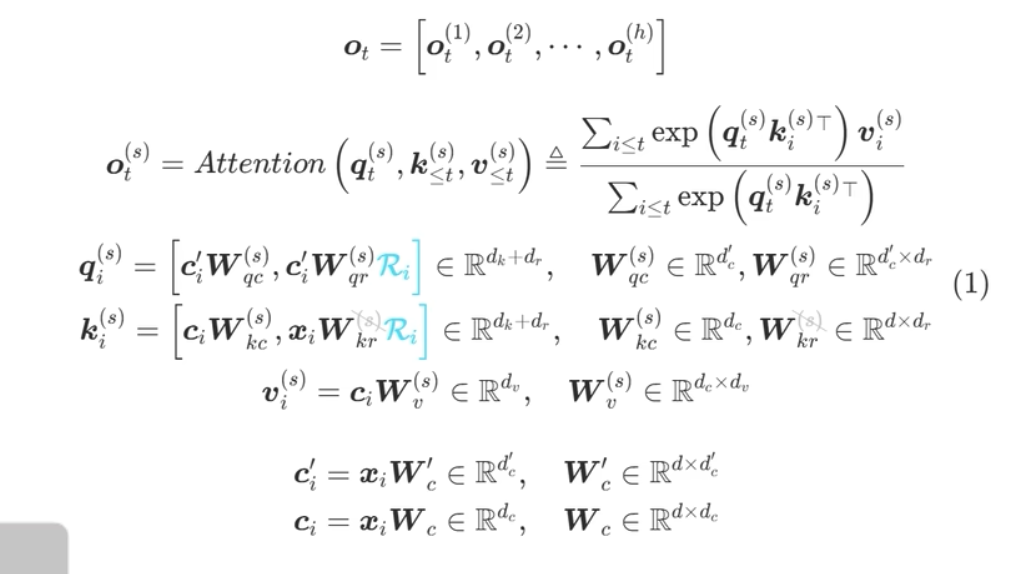

缓存与效果的极限拉扯:从MHA、MQA、GQA到MLA

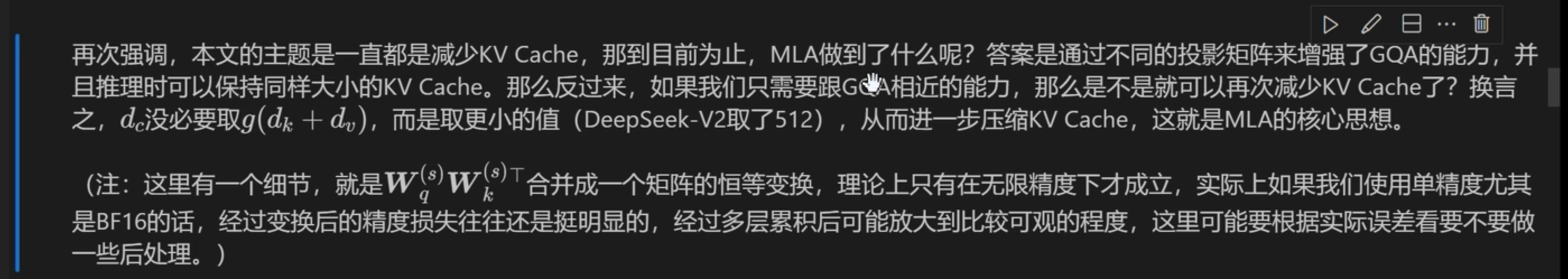

前几天,幻方发布的DeepSeek-V2引起了大家的热烈讨论。首先,最让人哗然的是1块钱100万token的价格,普遍比现有的各种竞品API便宜了两个数量级,以至于有人调侃“这个价格哪怕它输出乱码,我也会认为这个乱码是一种艺术”;其次,从模型的技术报告看,如此便宜的价格背后的关键技术之一是它新提出的MLA(Multi-head Latent Attention),这是对GQA的改进,据说能比GQA更省更好,也引起了读者的广泛关注。

接下来,本文将跟大家一起梳理一下从MHA、MQA、GQA到MLA的演变历程,并着重介绍一下MLA的设计思路。

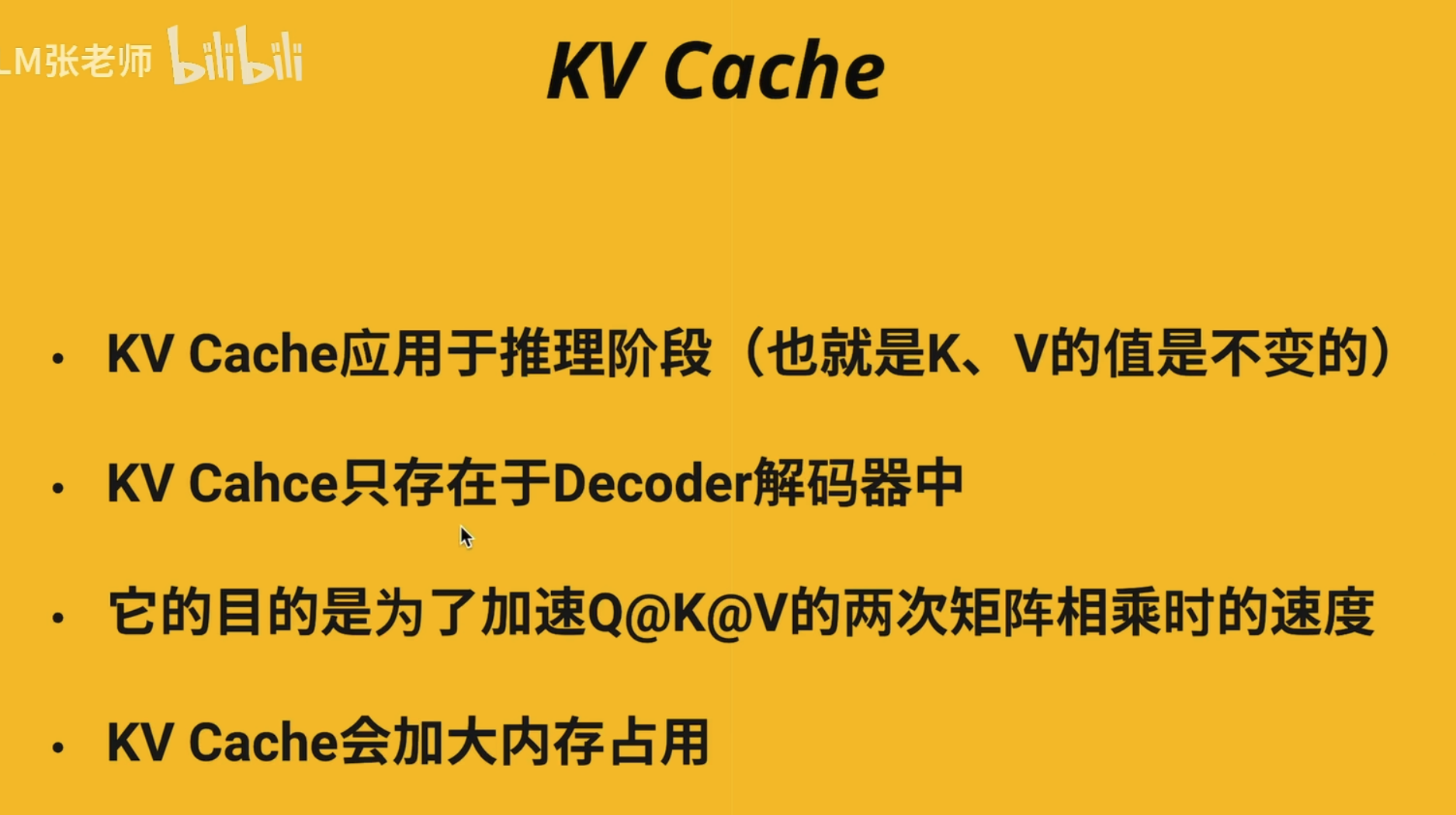

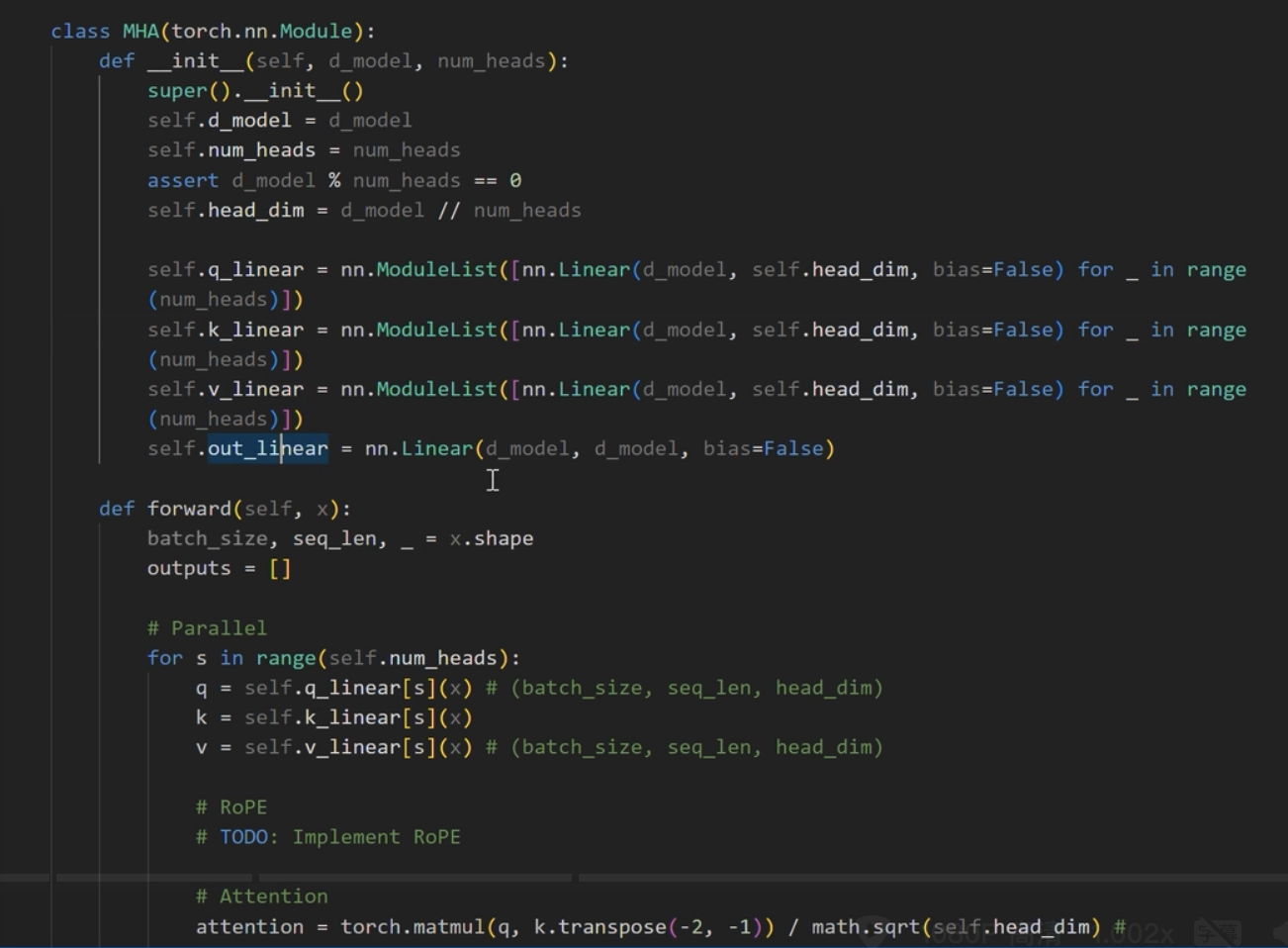

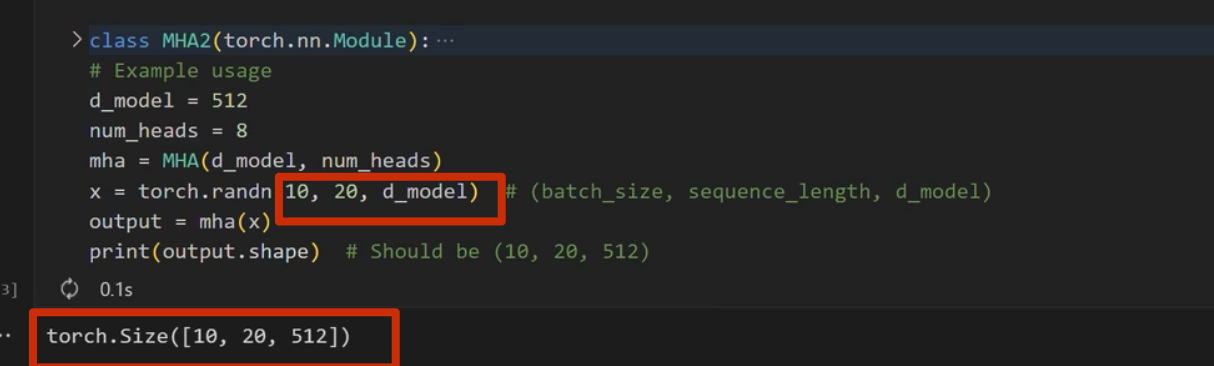

MHA#

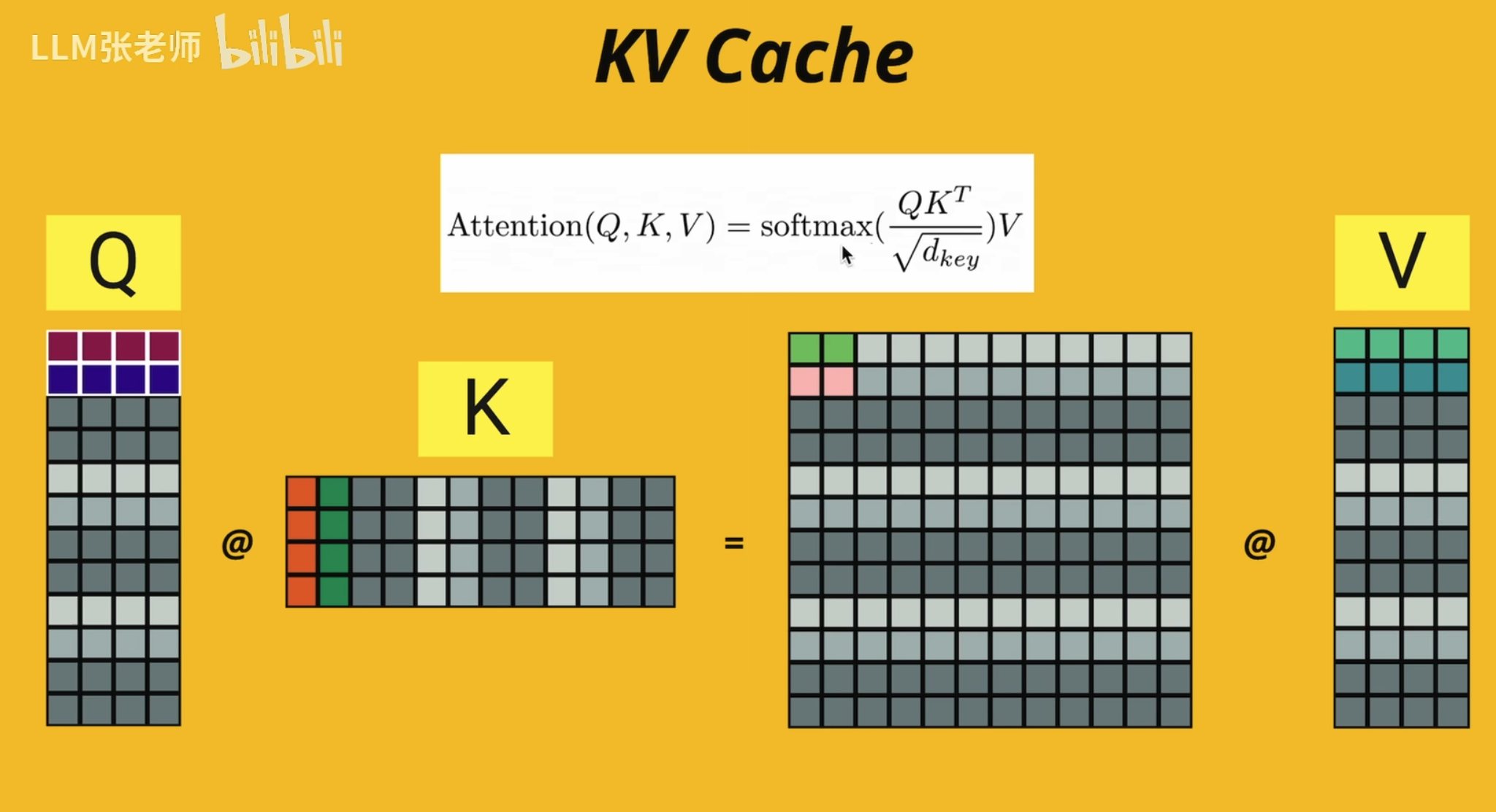

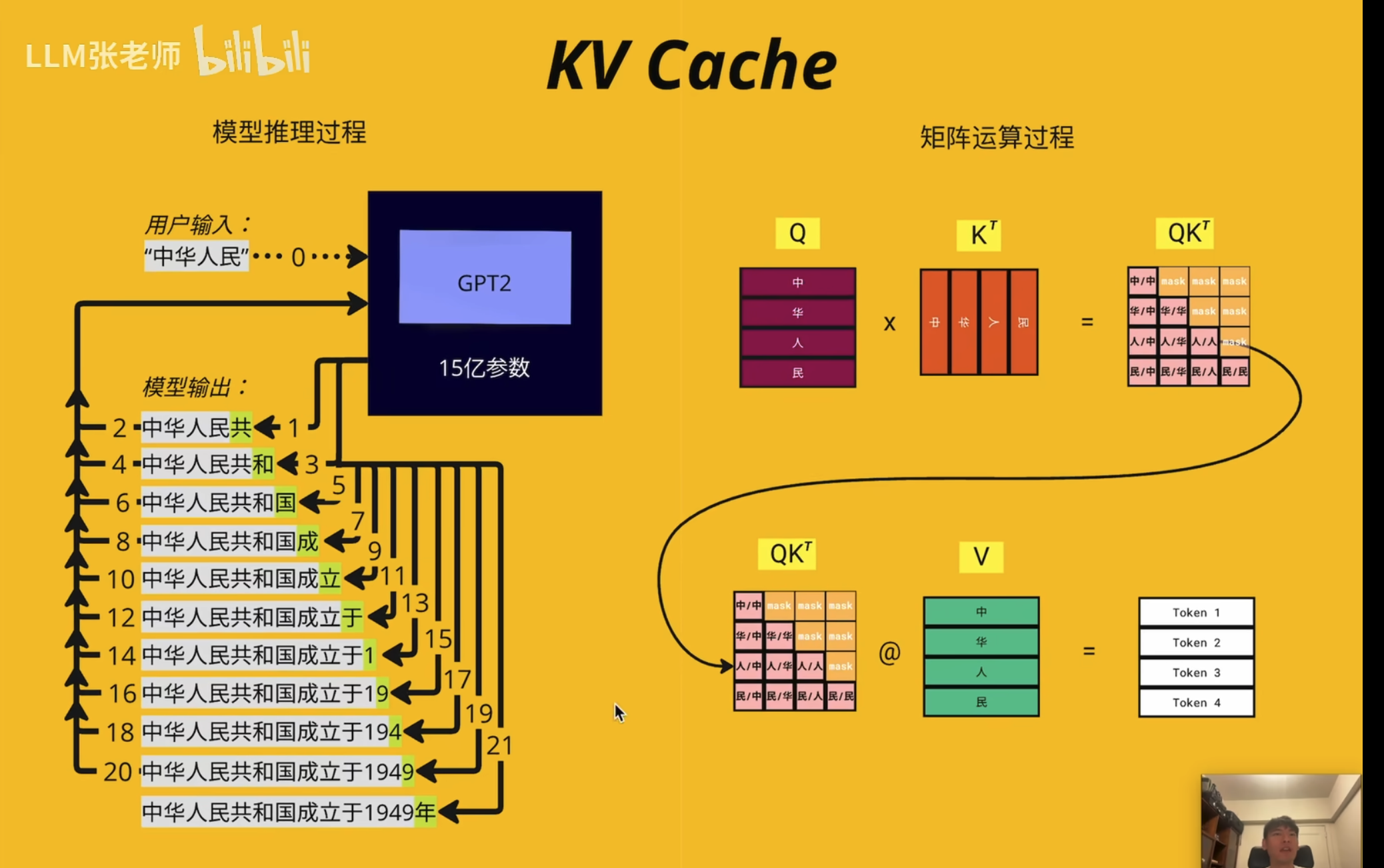

KV Cache(K-V Cache)

瓶颈

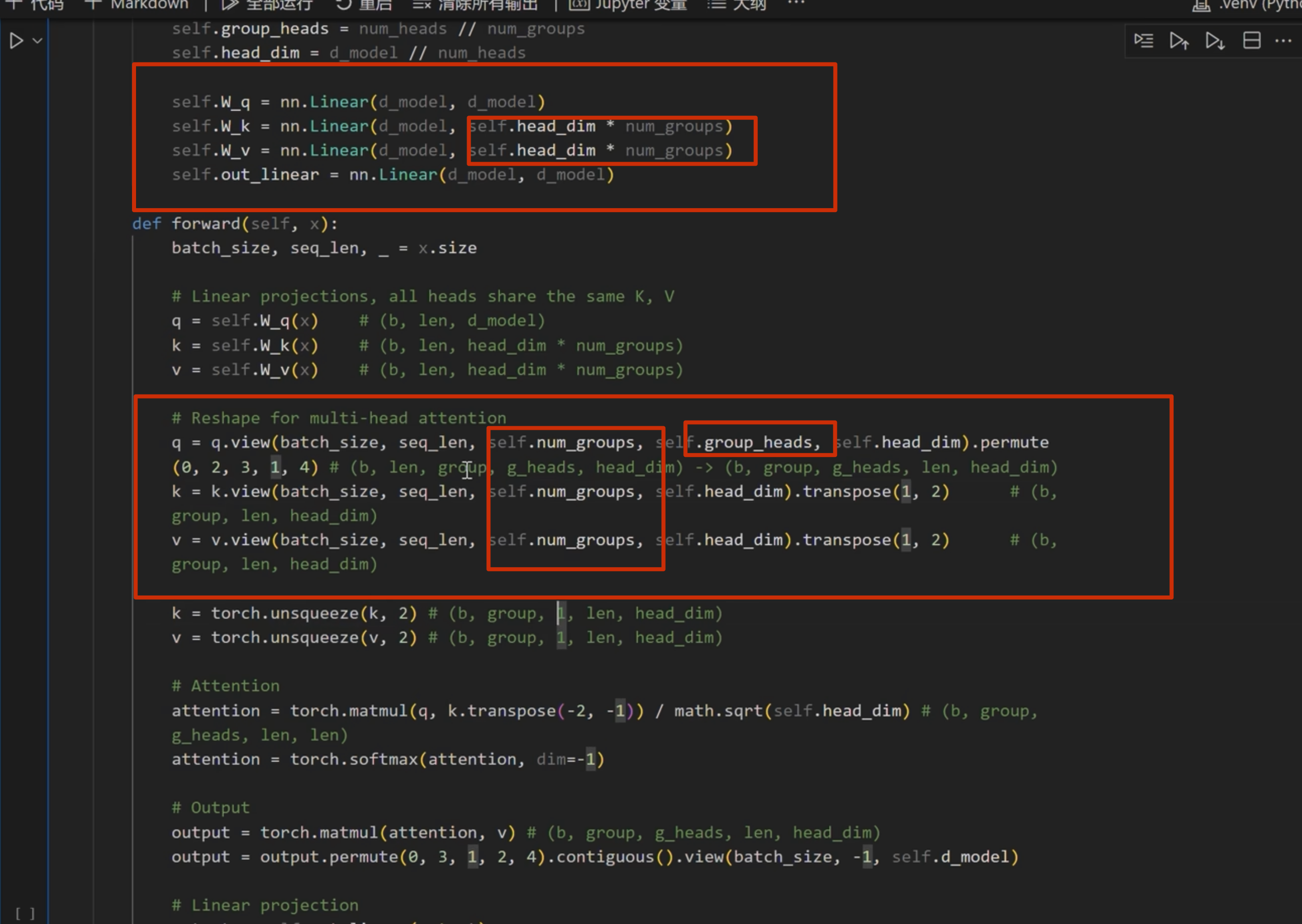

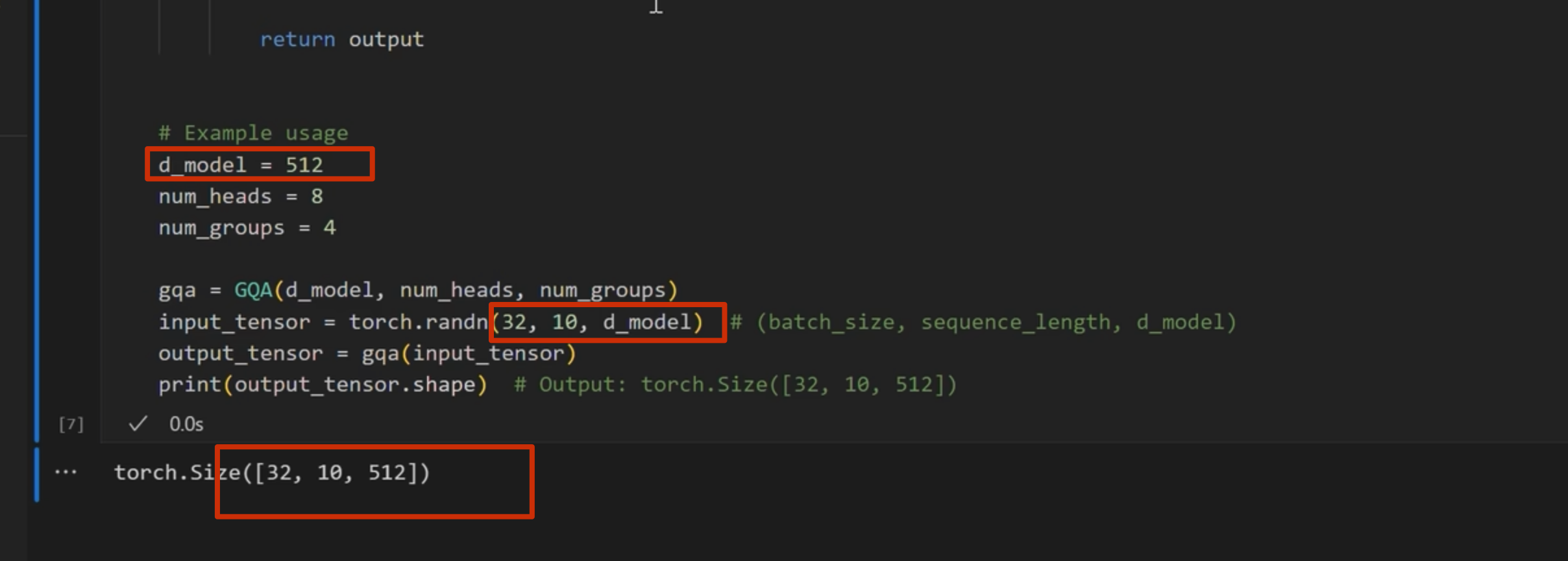

注意这里 d_model = head_dim* n_head

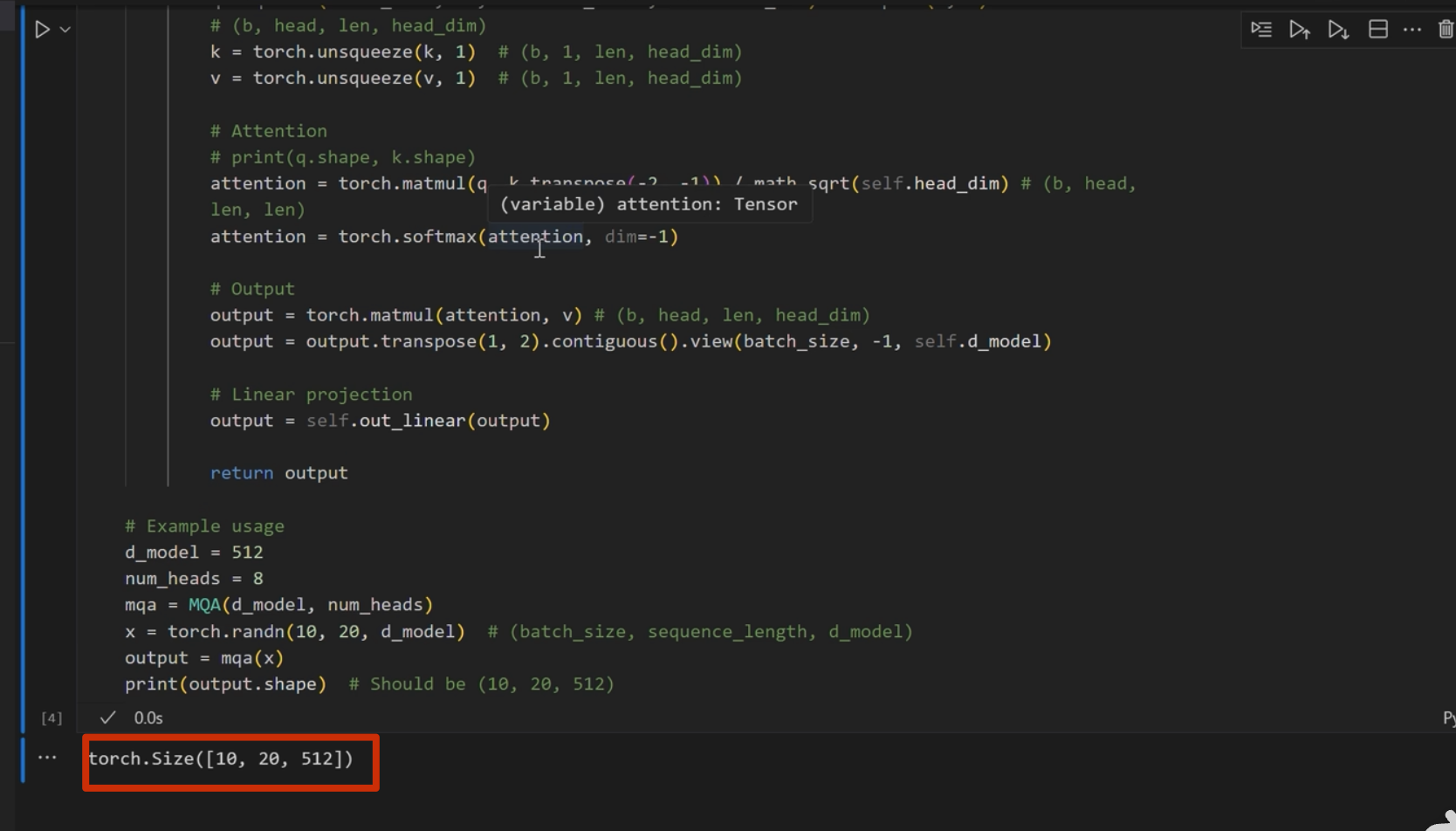

MQA

GQA

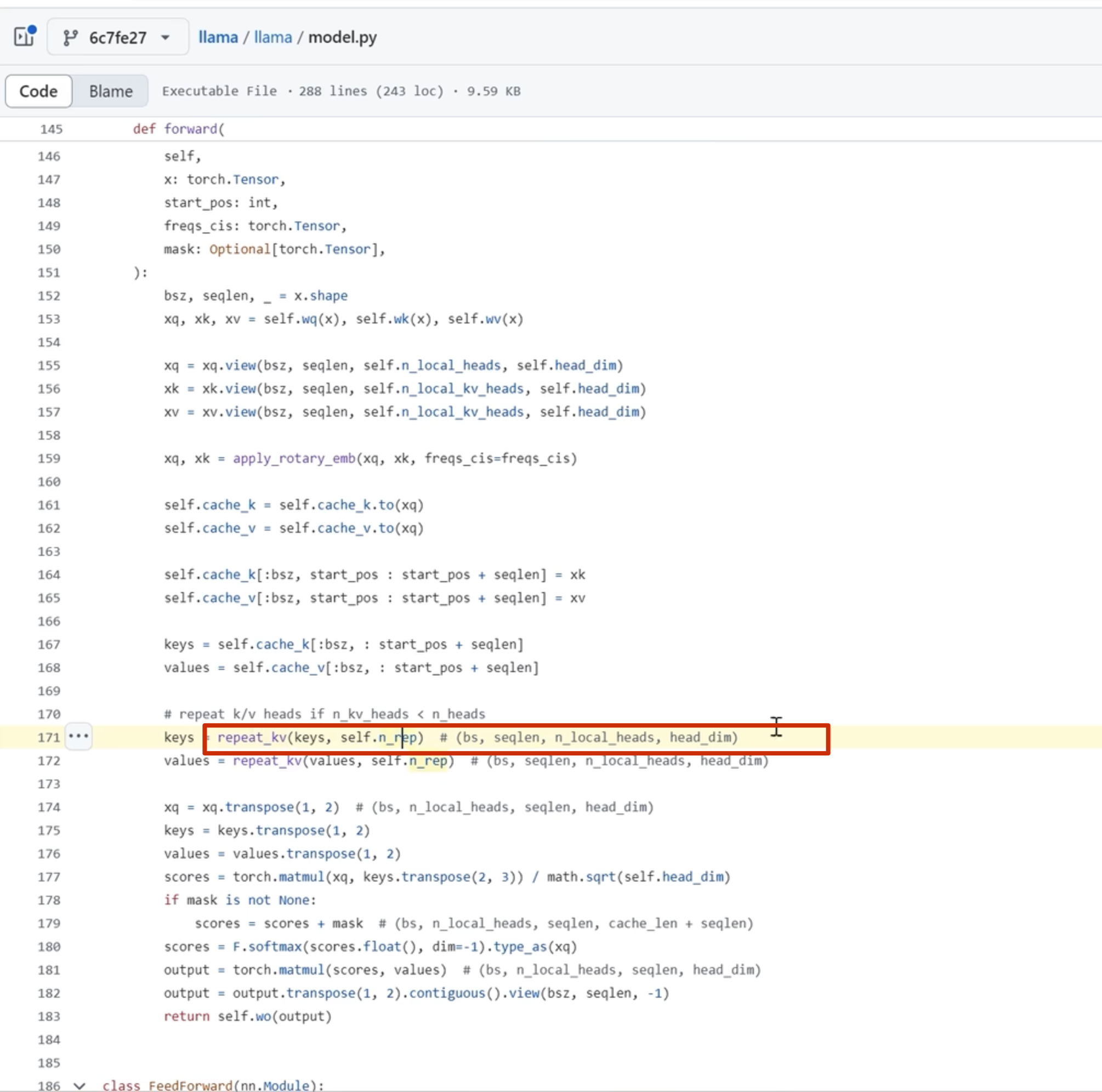

llama 代码如下:

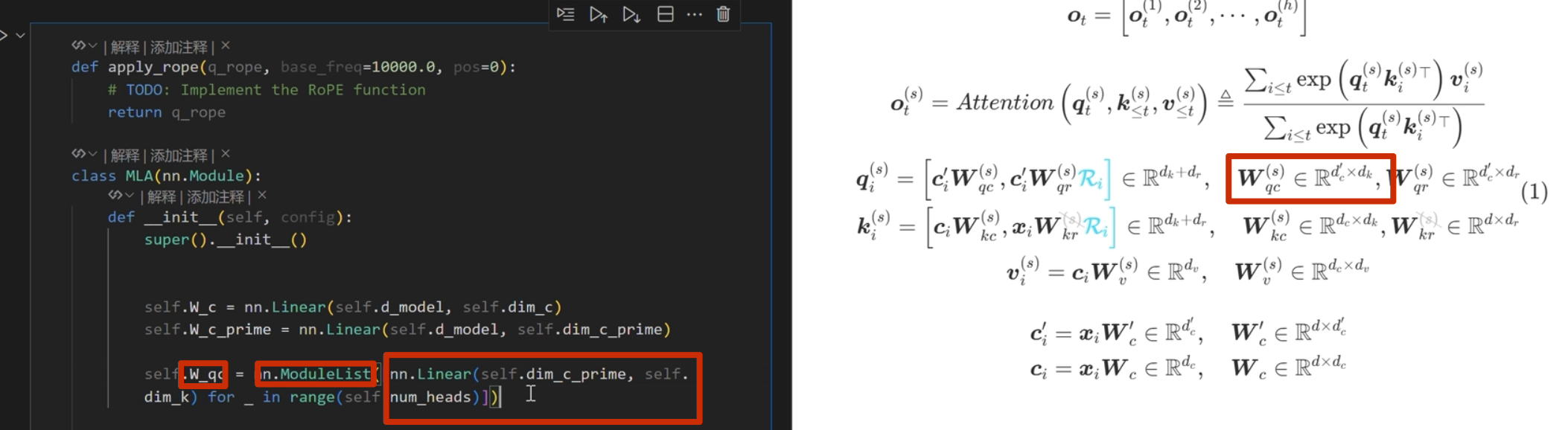

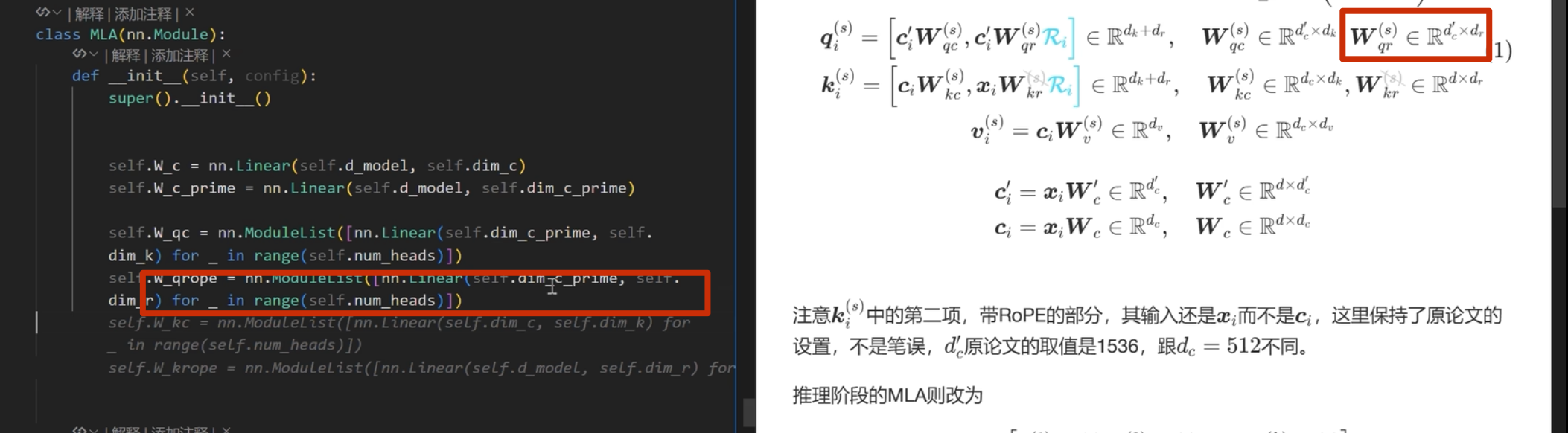

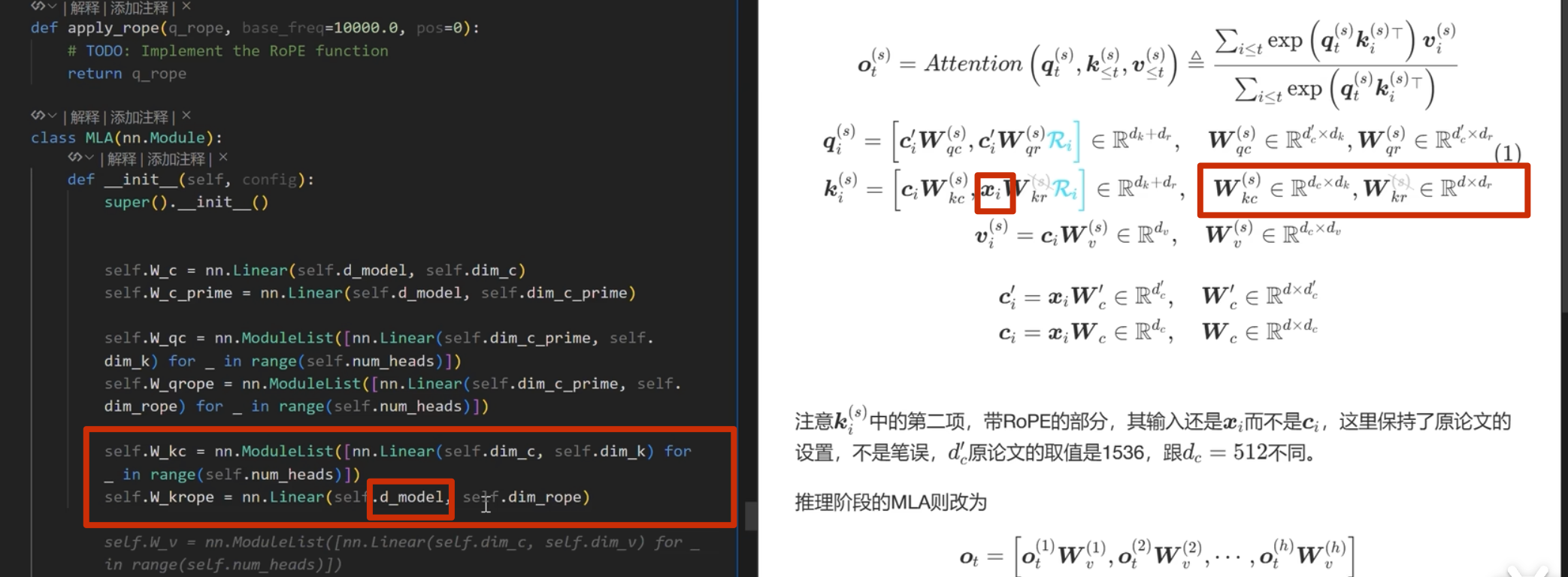

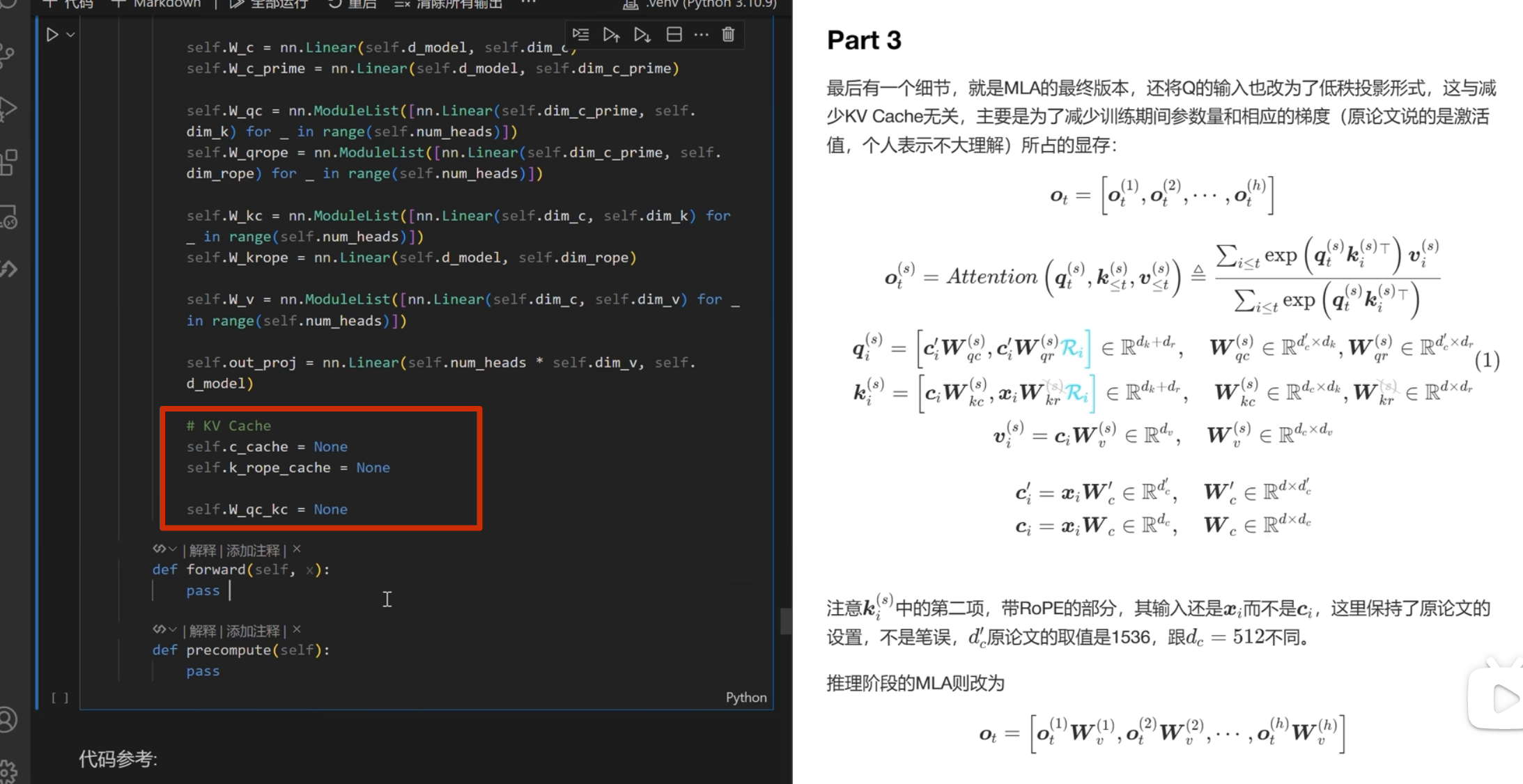

MLA

先看后面 Part1,2,3

(不理解,下面的当我乱说的,没看懂 g 是什么)

g= n_groups(下面说每一份被均分为 g 份),所以\(k_i\) =\([k_i^{(1)},k_i^{(2)}, ....,k_i^{(g)}]\),(\(k_i\)形状为1n_groups) 所以 c_i 为 1x (n_groups x head_dim x 2*)

x_i为 1xd, Wc为d x n_groups x 2 x head_dim

想说n_groups x 2 x head_dim一般小于 d??不一定吧,嘶 不应该相等吗?

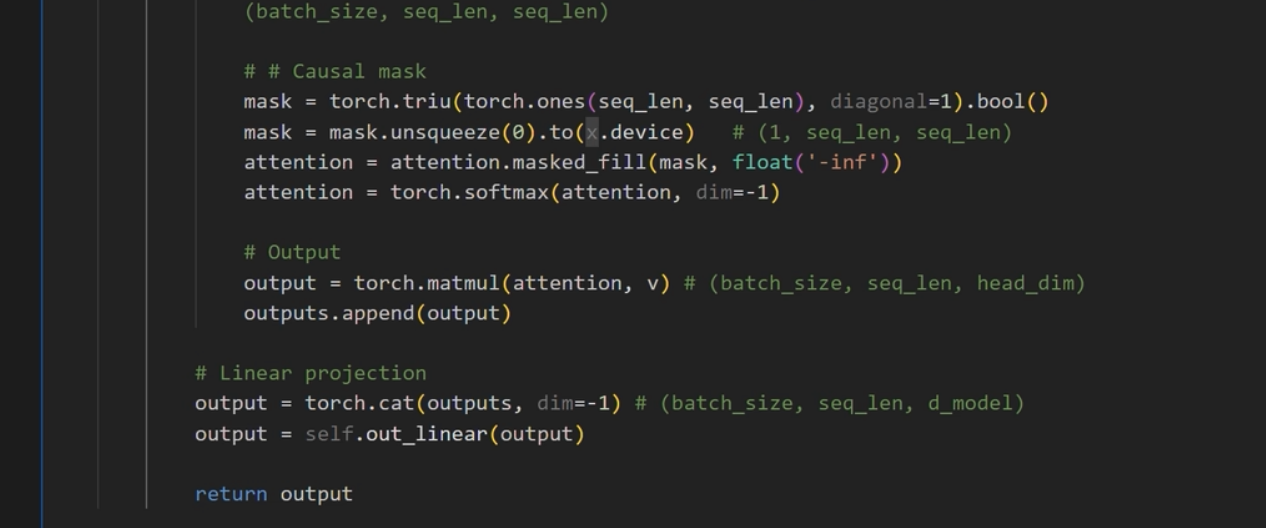

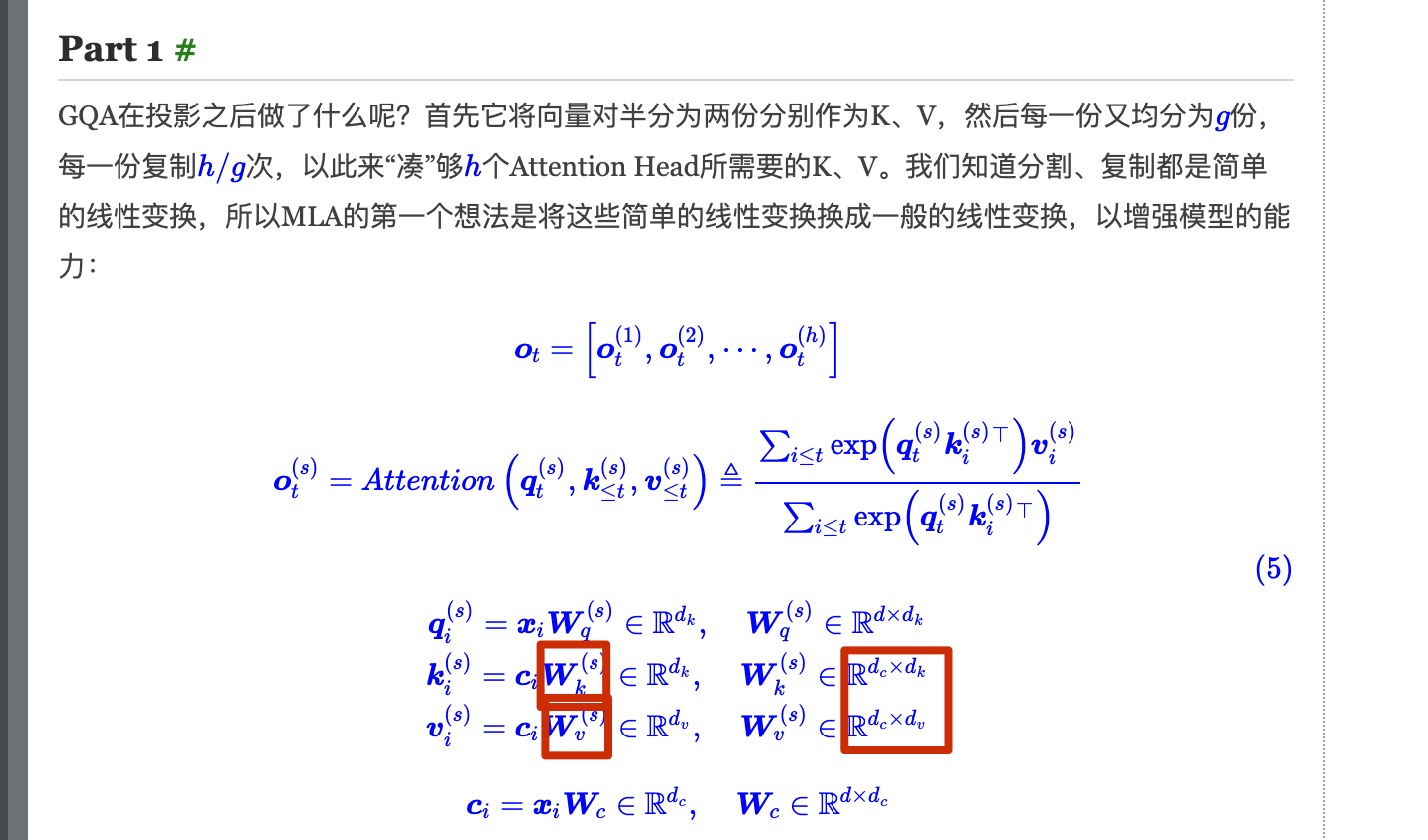

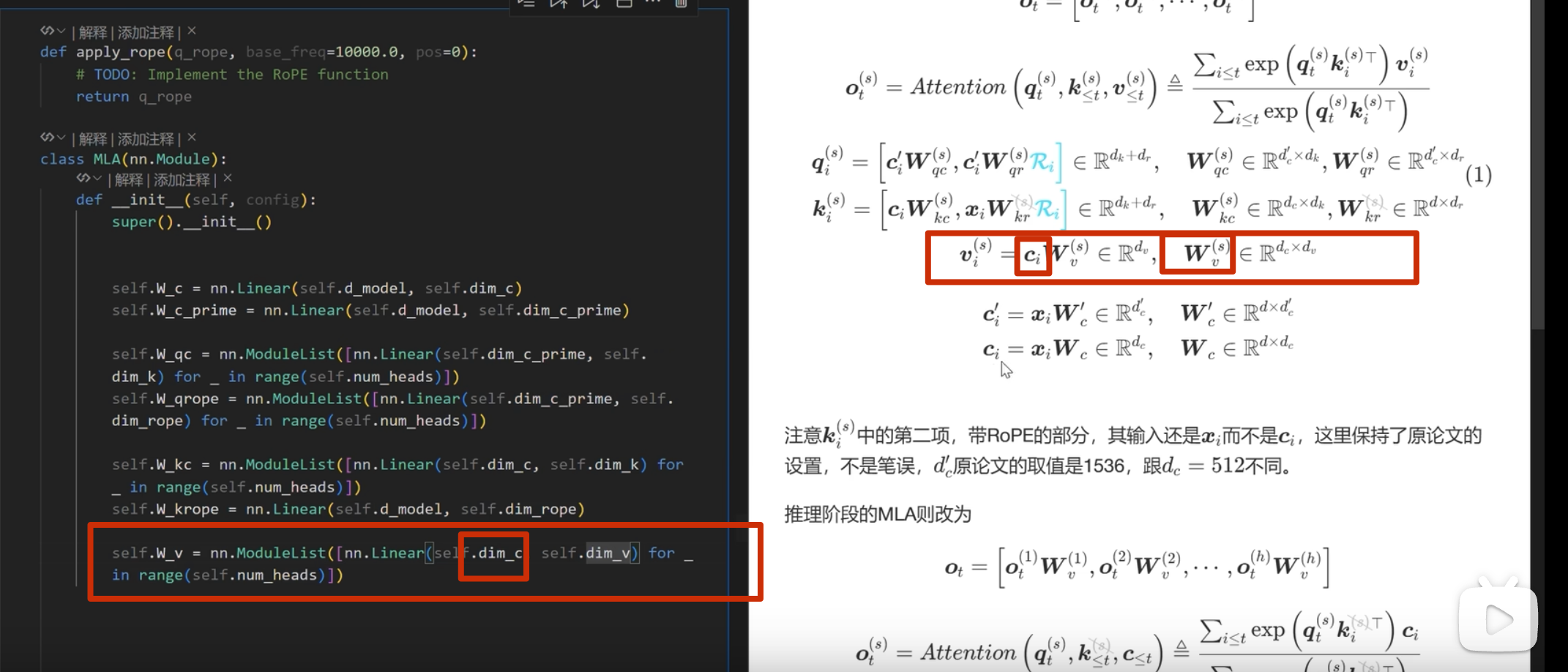

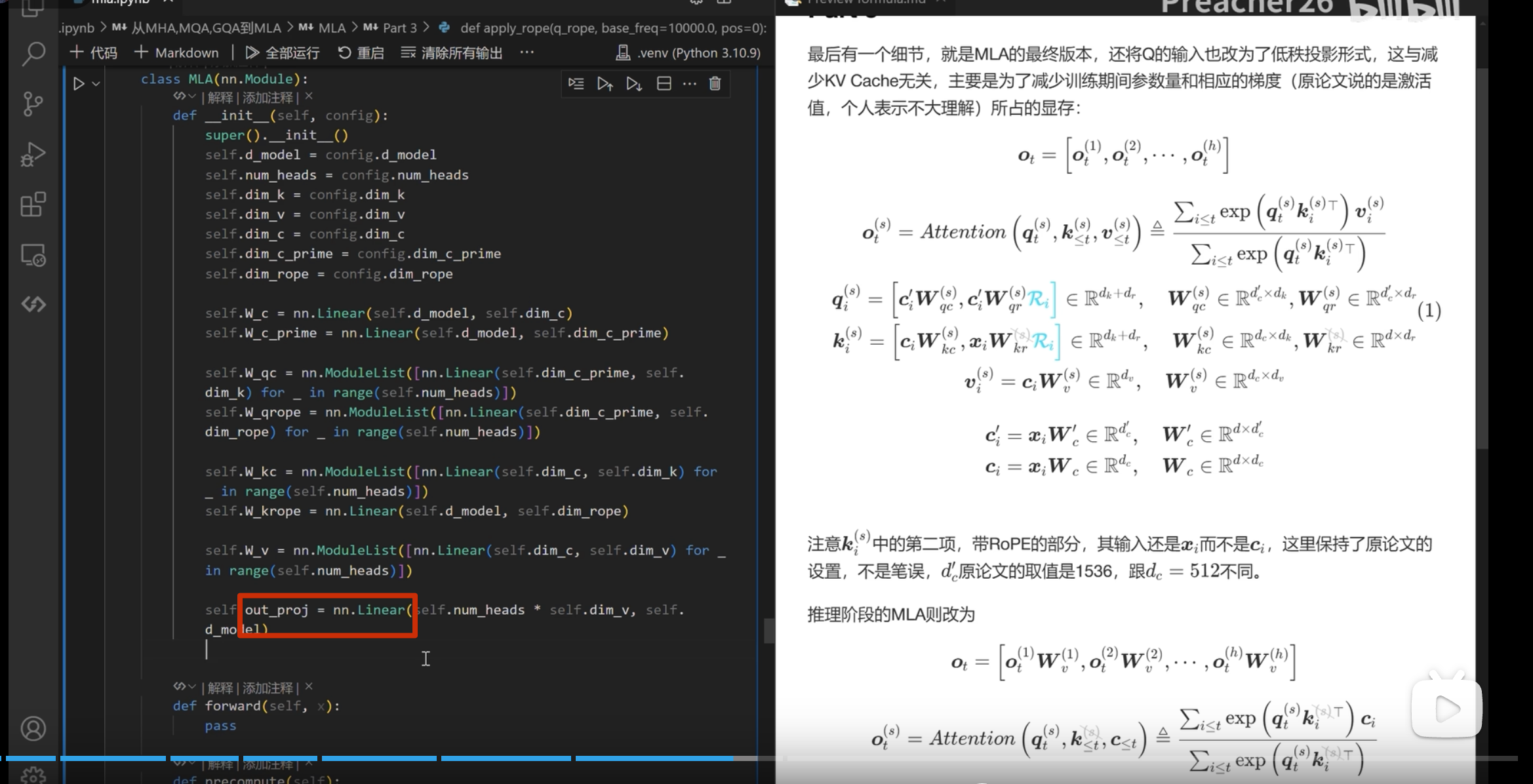

Part1

投影后 对半分->复制(分割、复制)

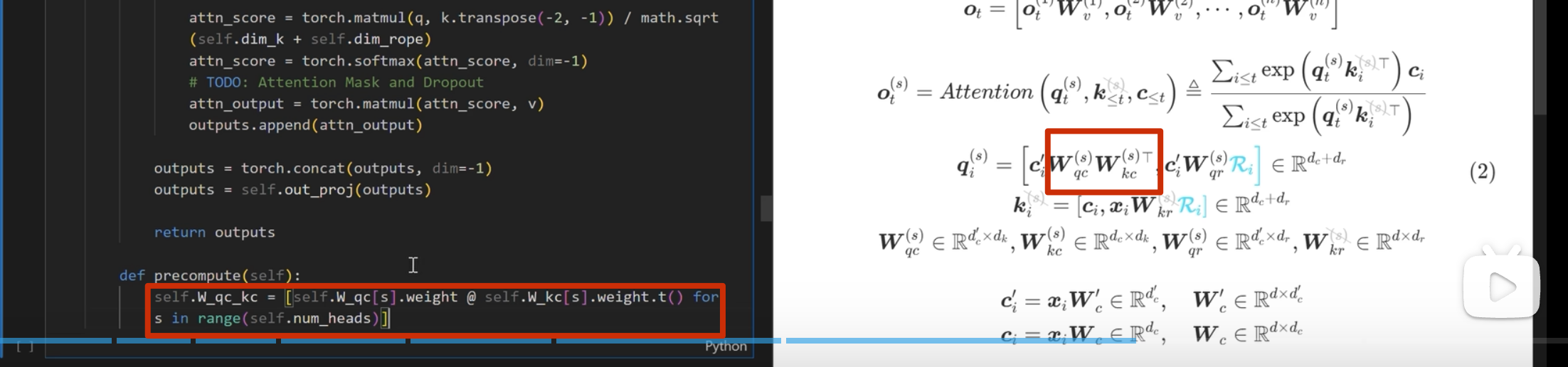

所以要求出上面圈出来的两个矩阵是关键

问题:

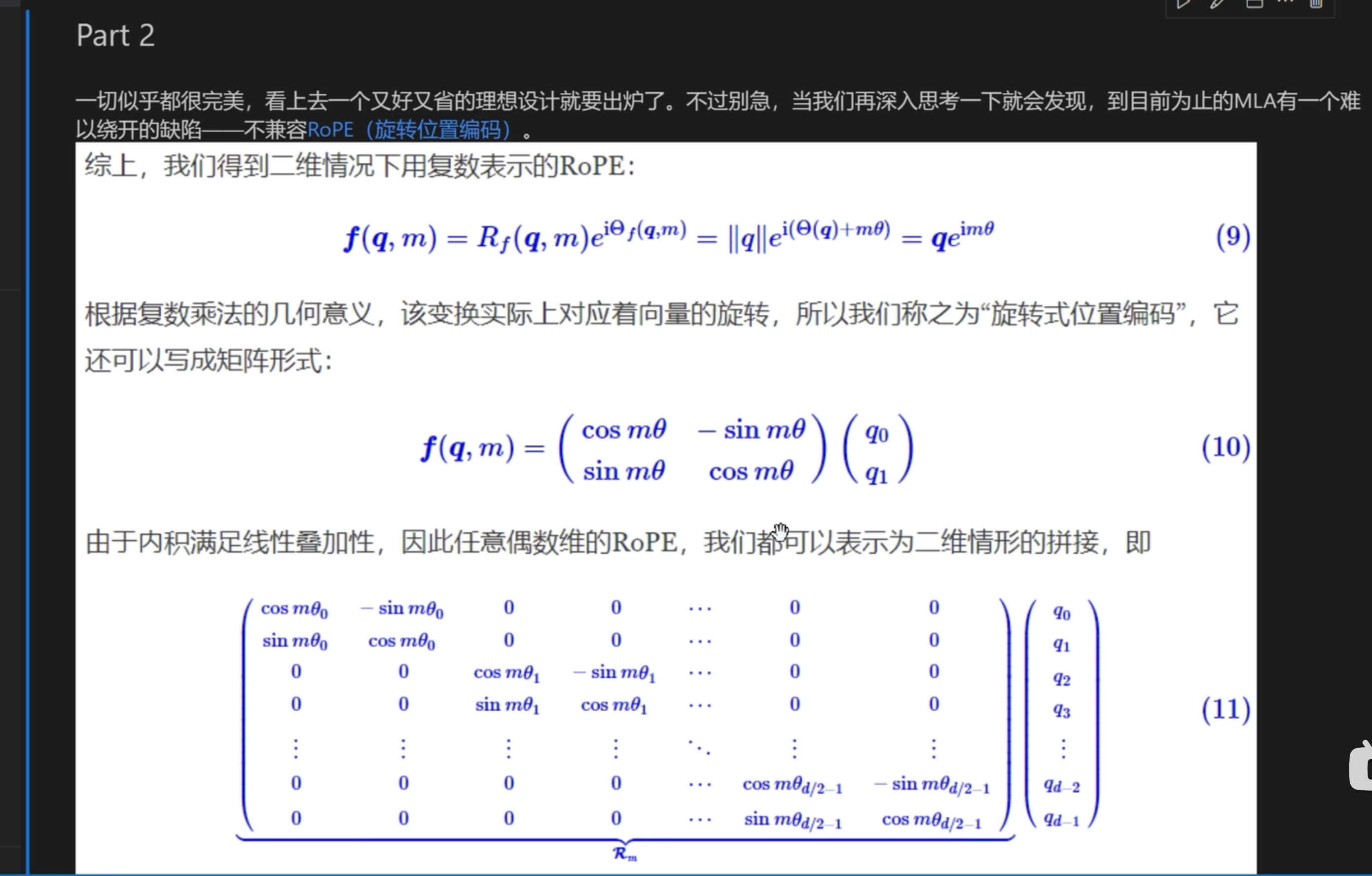

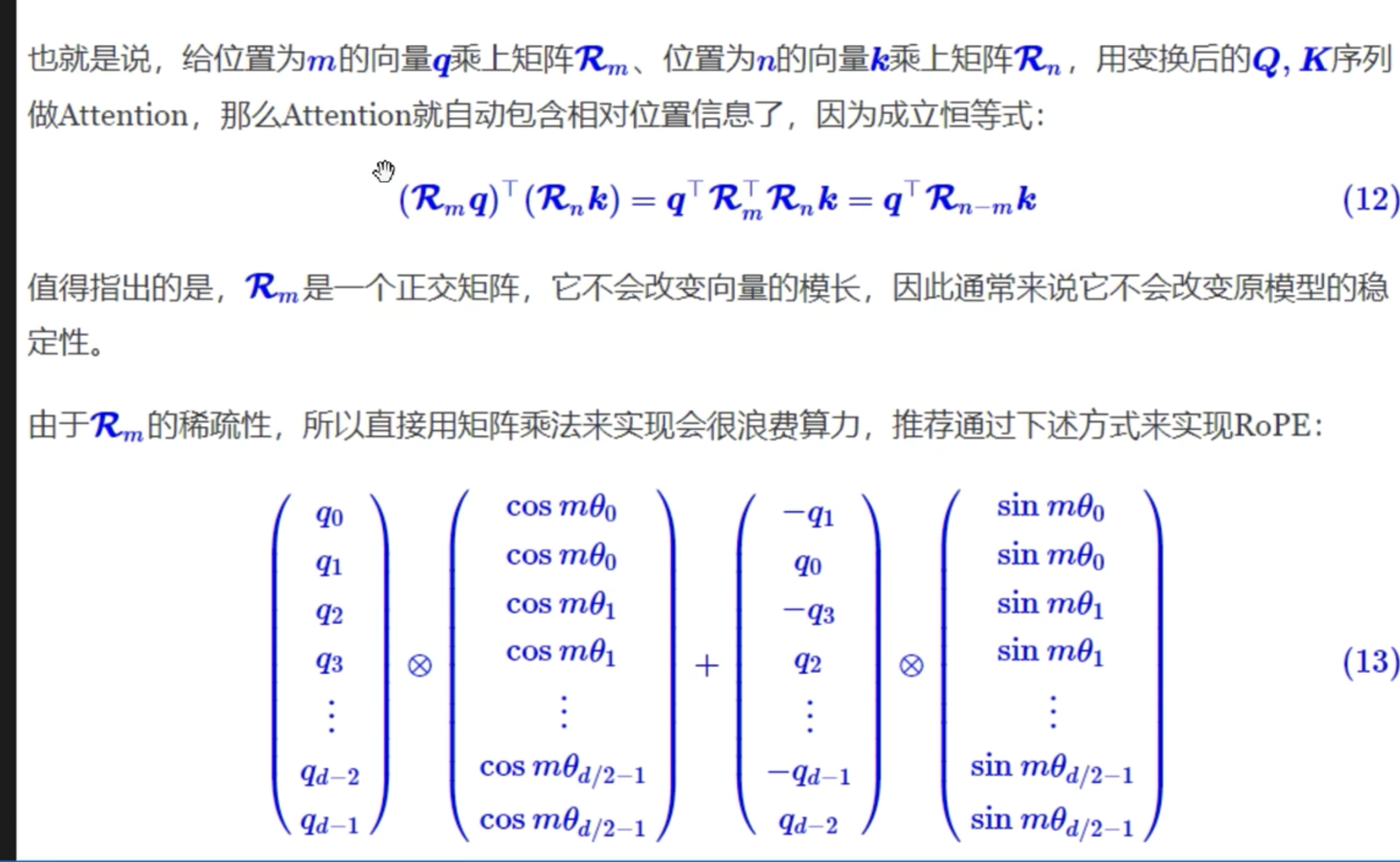

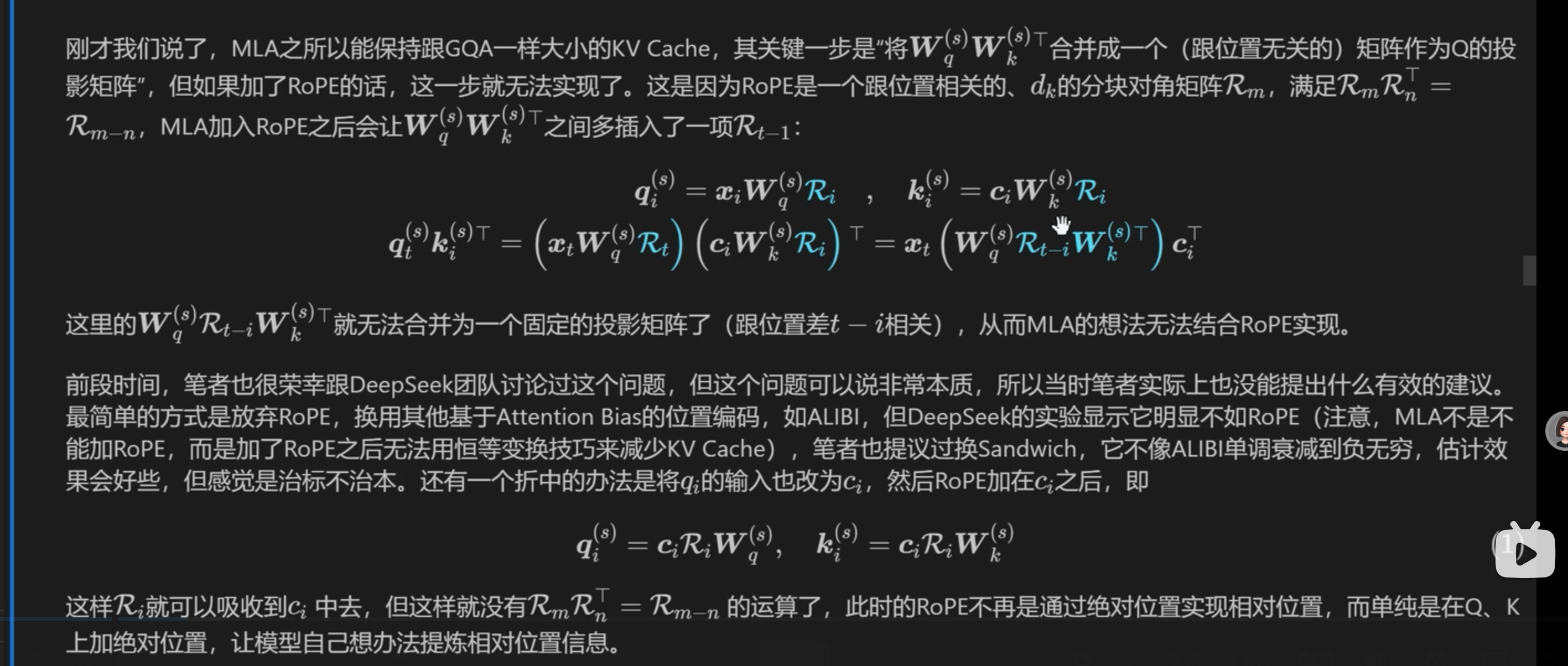

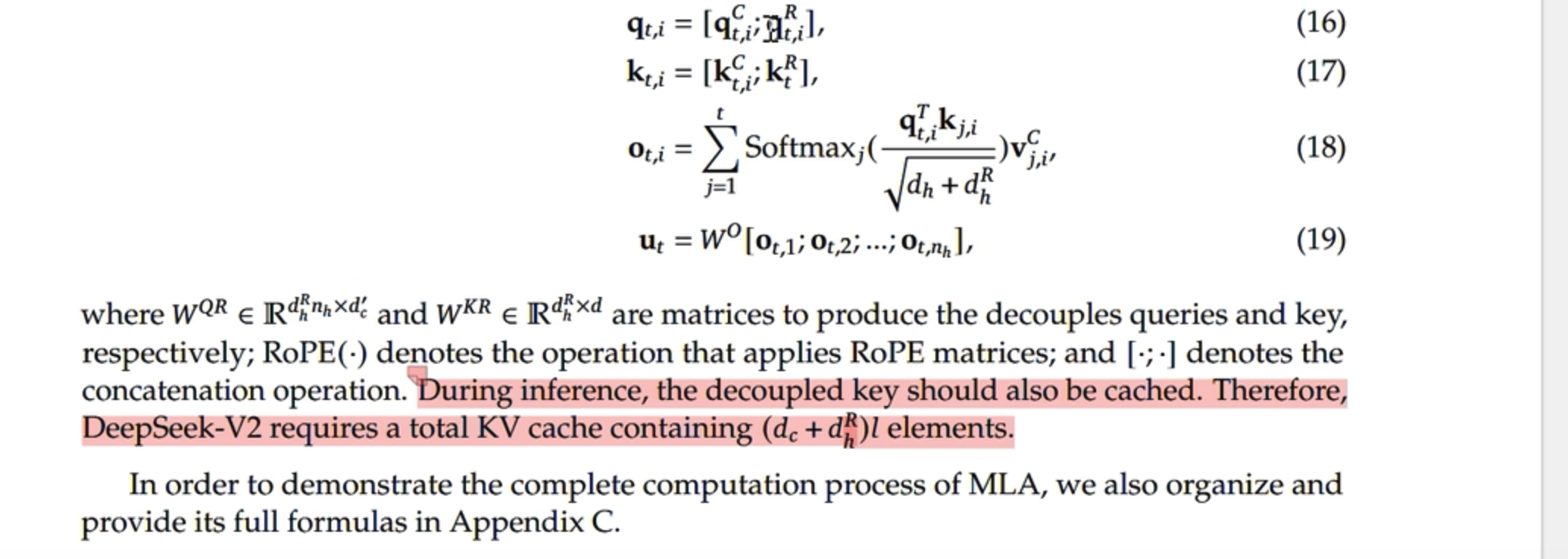

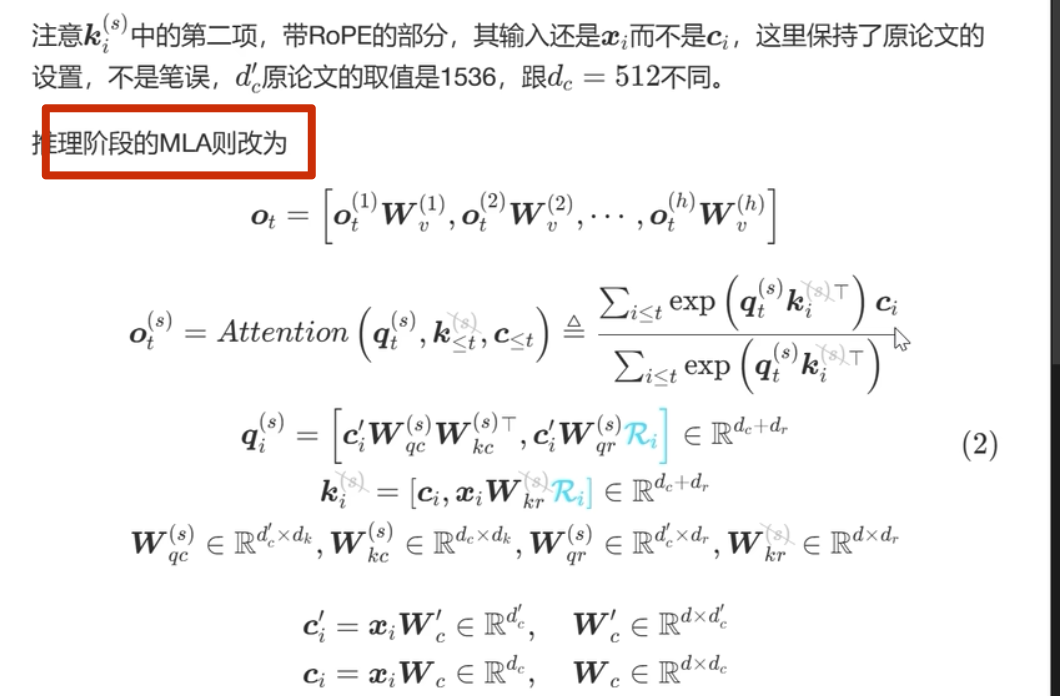

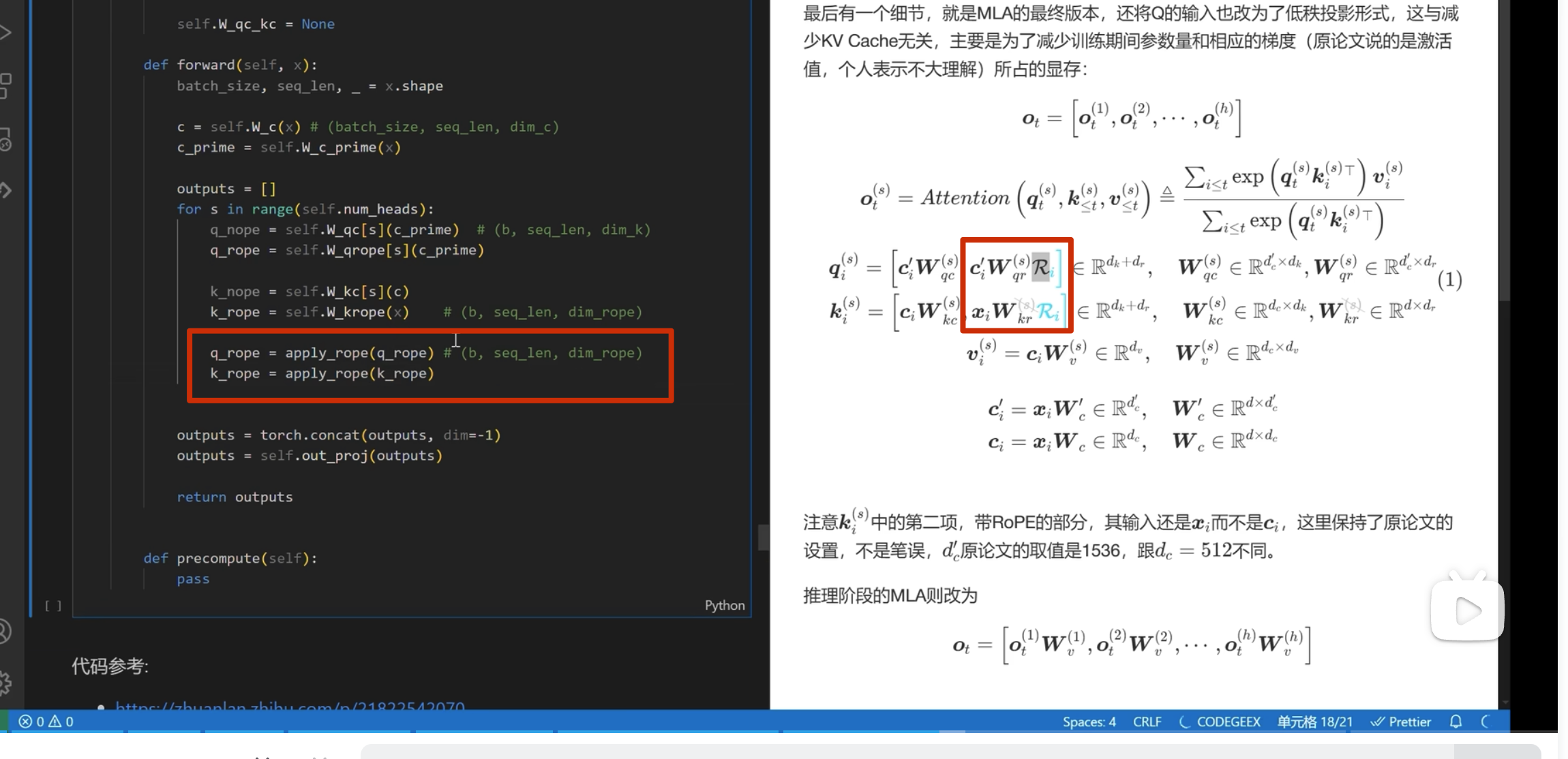

Part2(新问题,不兼容 RoPE(旋转位置编码 ,就是那个位置编码))

最后兼容 RoPE 的方案

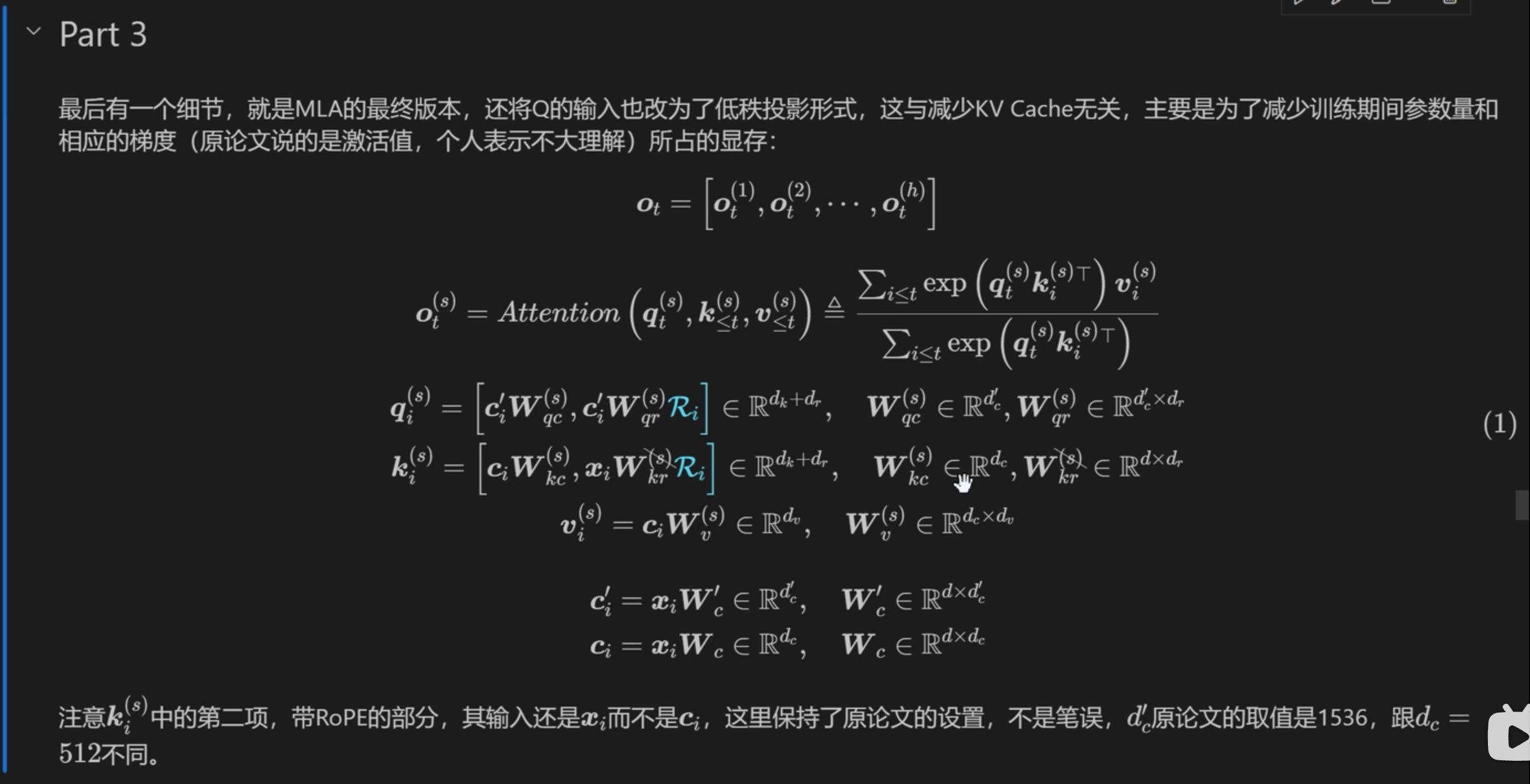

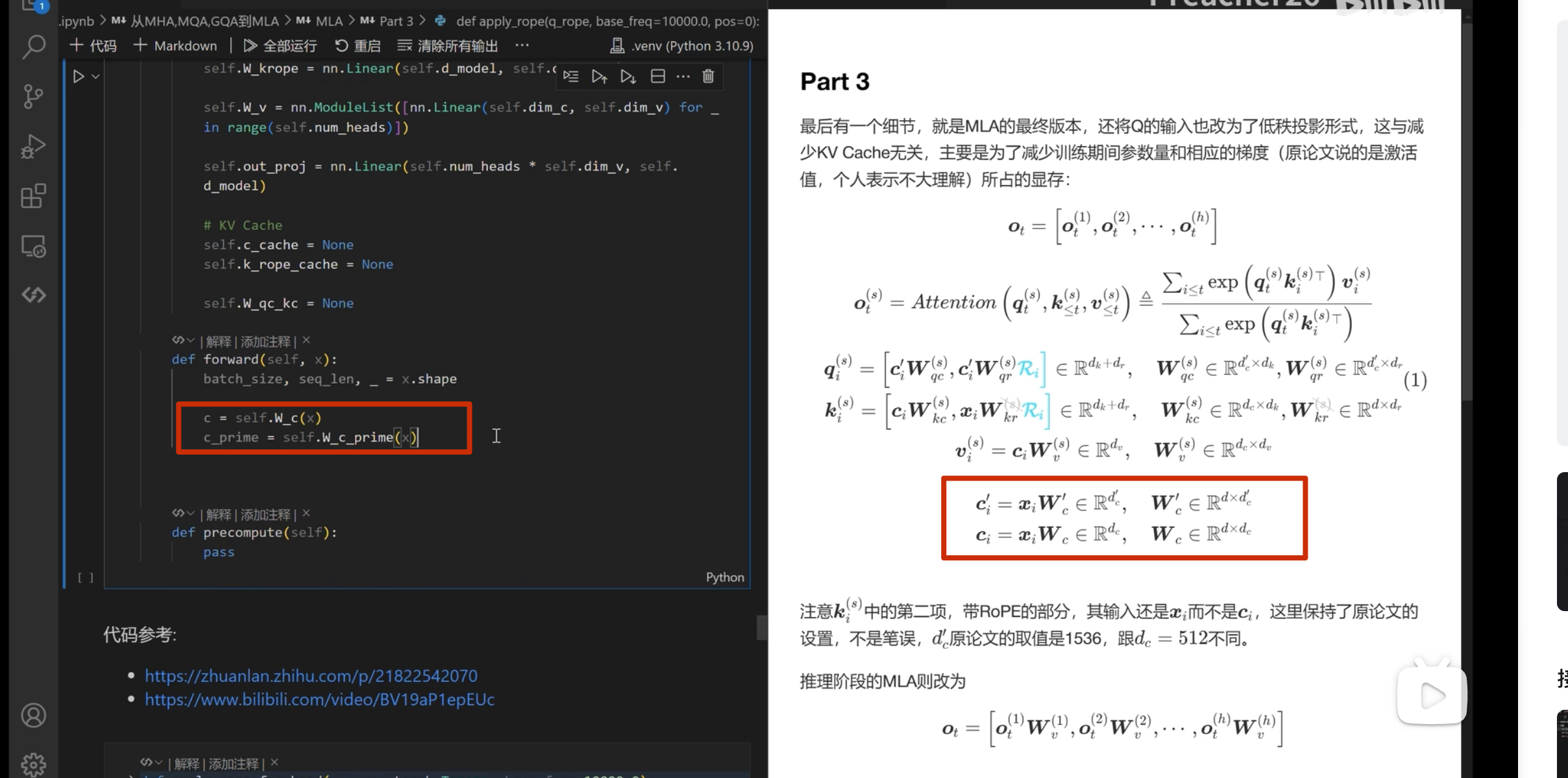

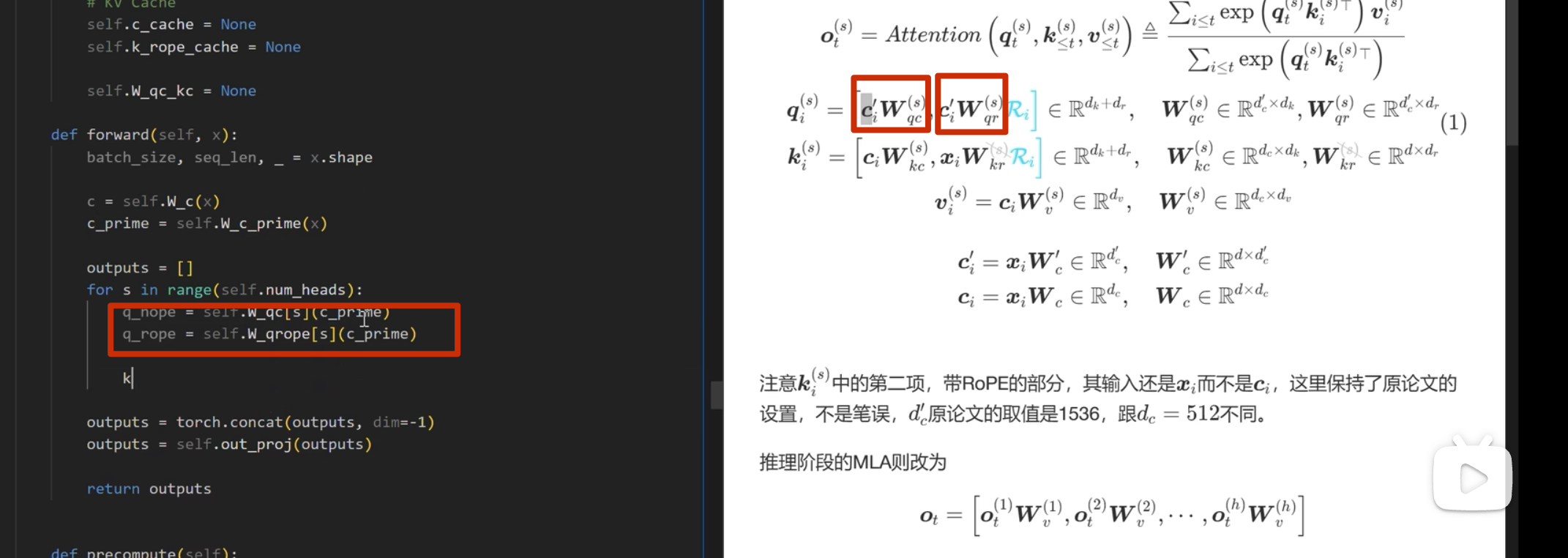

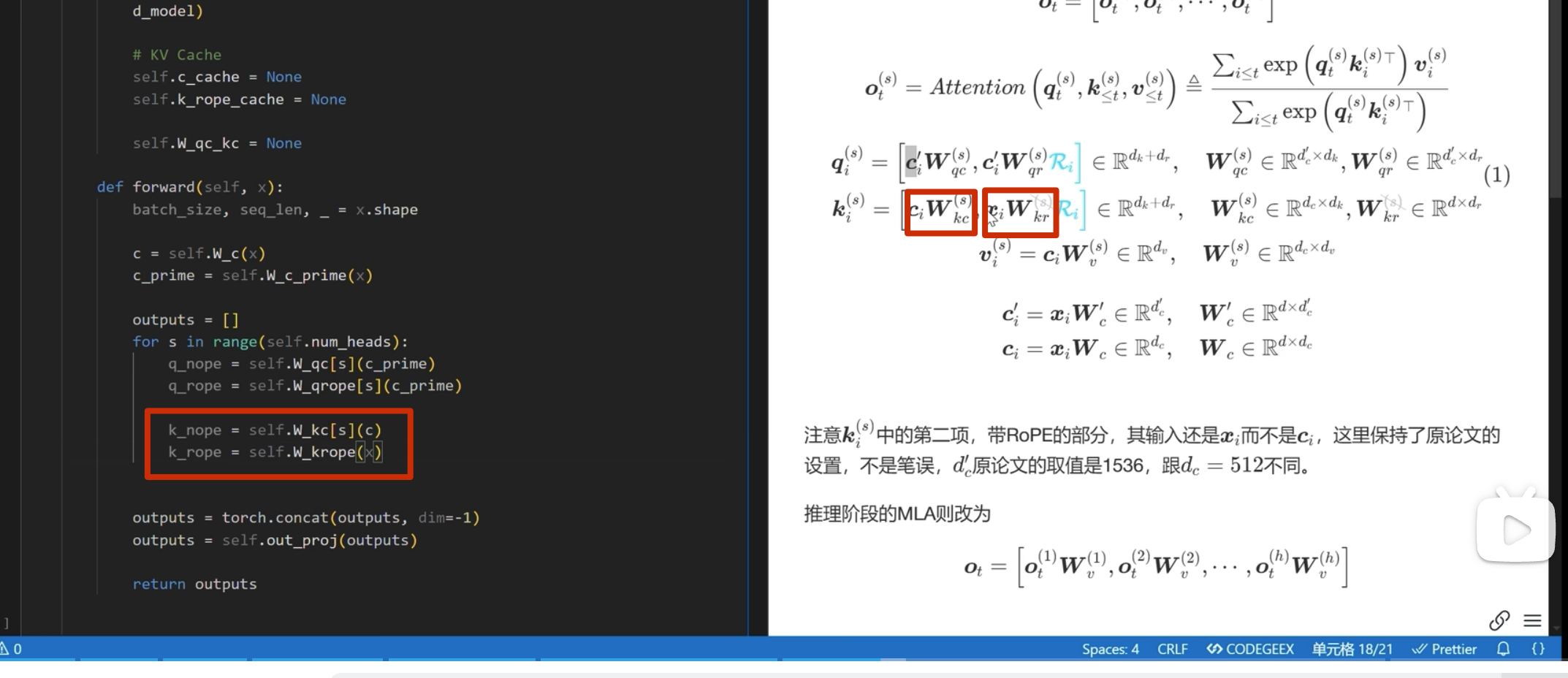

Part3

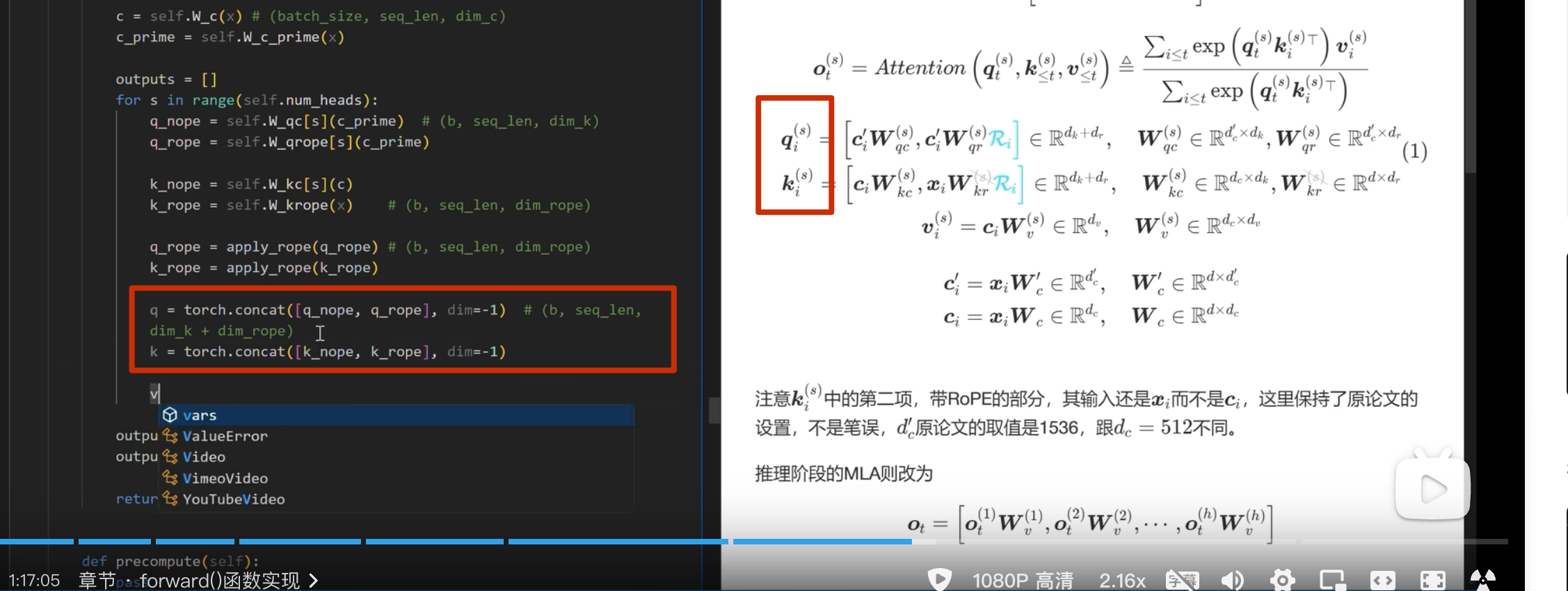

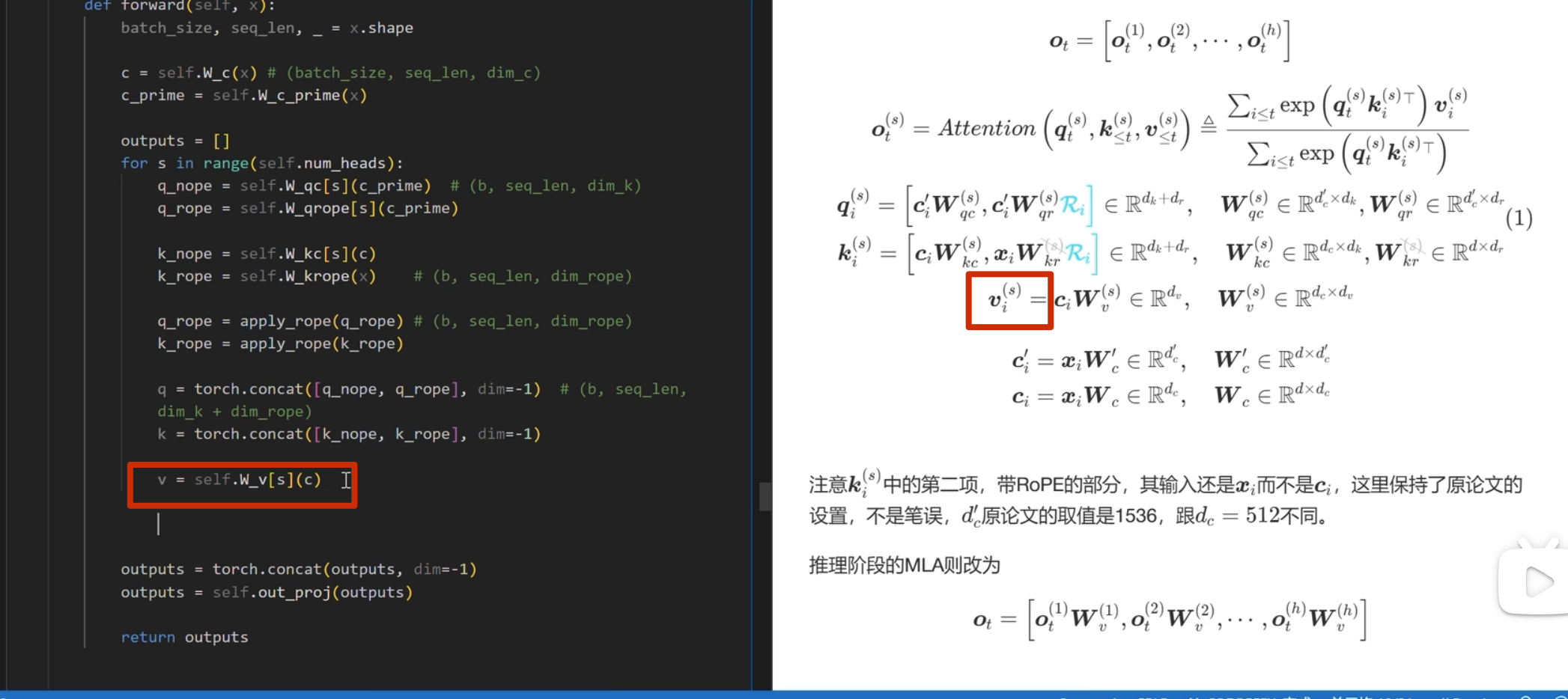

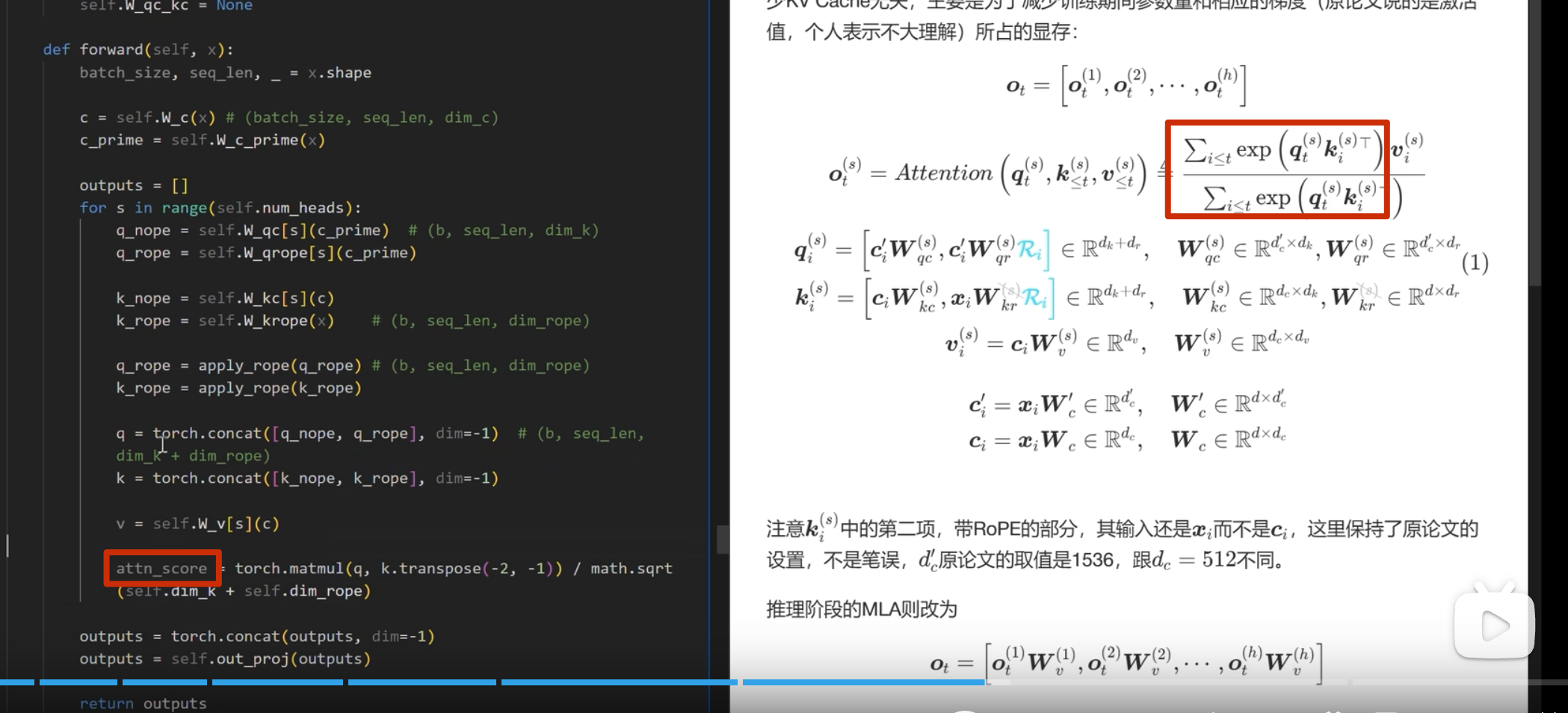

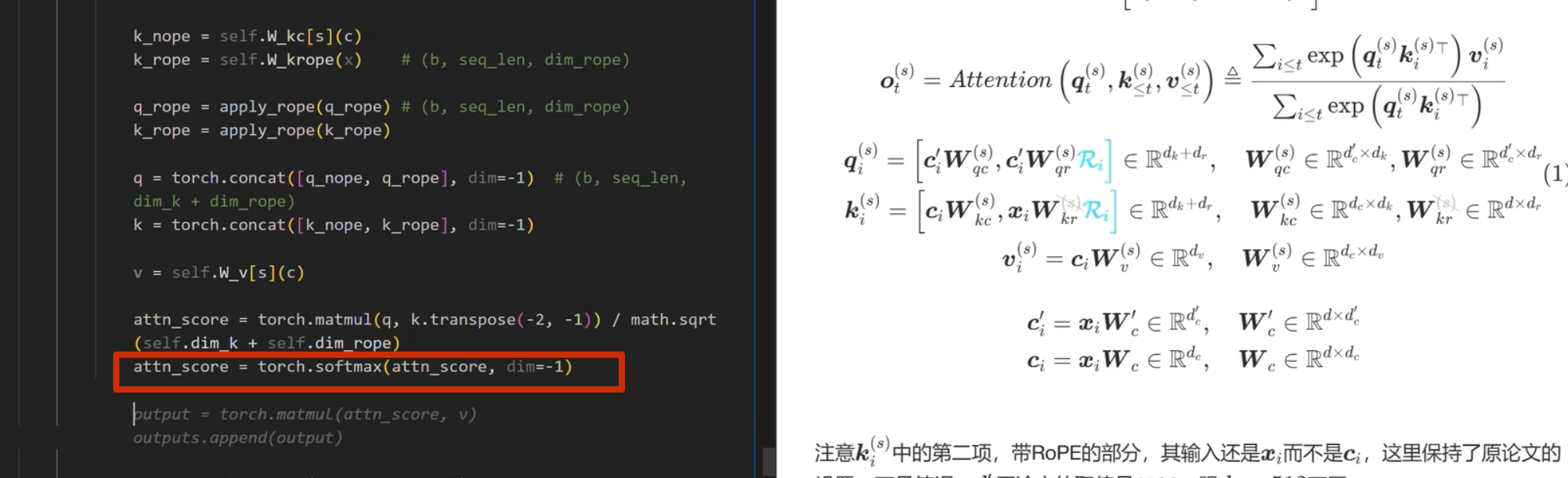

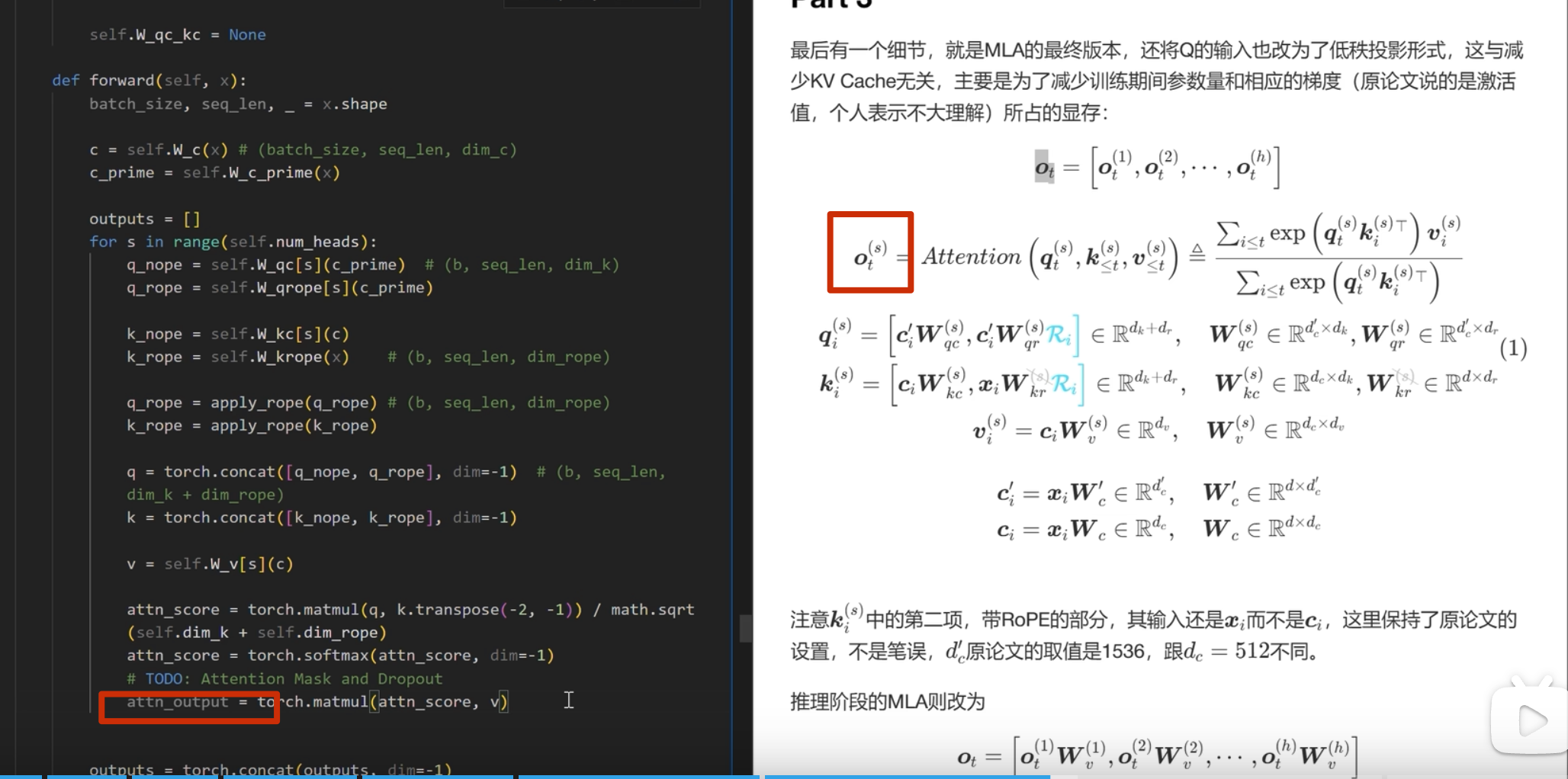

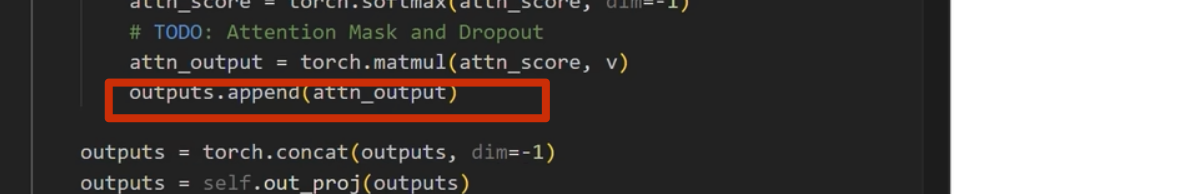

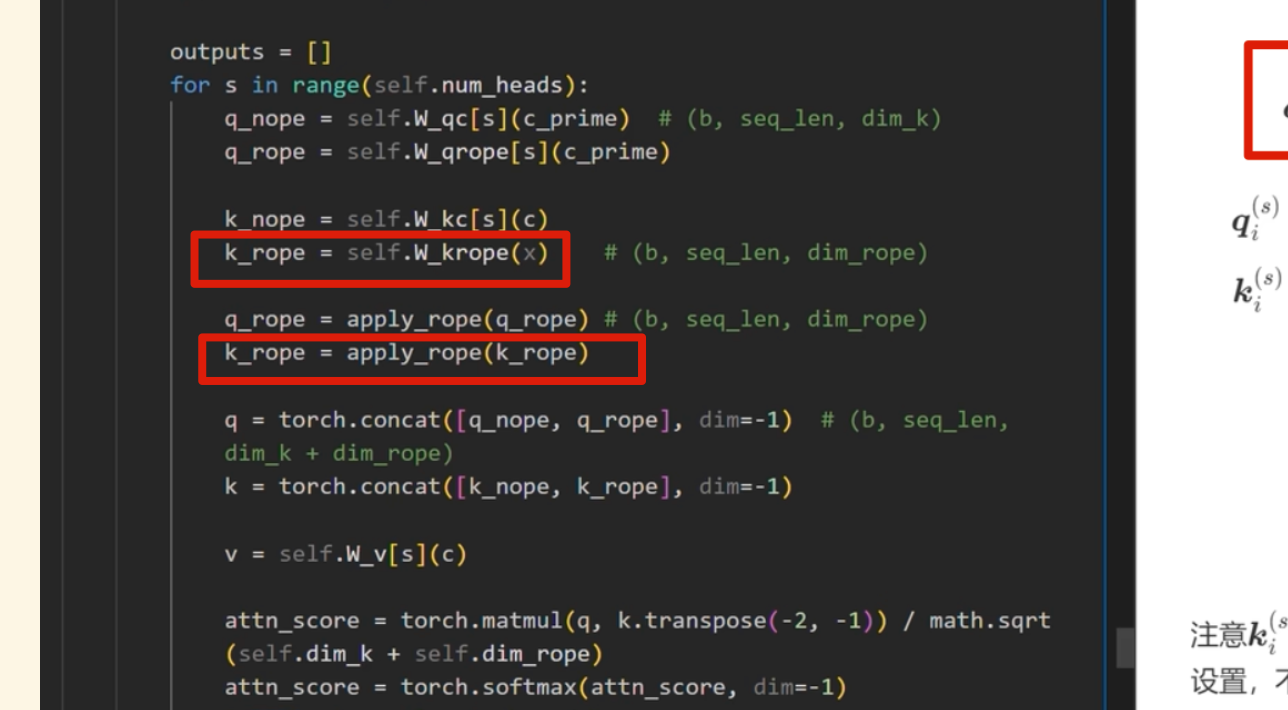

最终代码实现

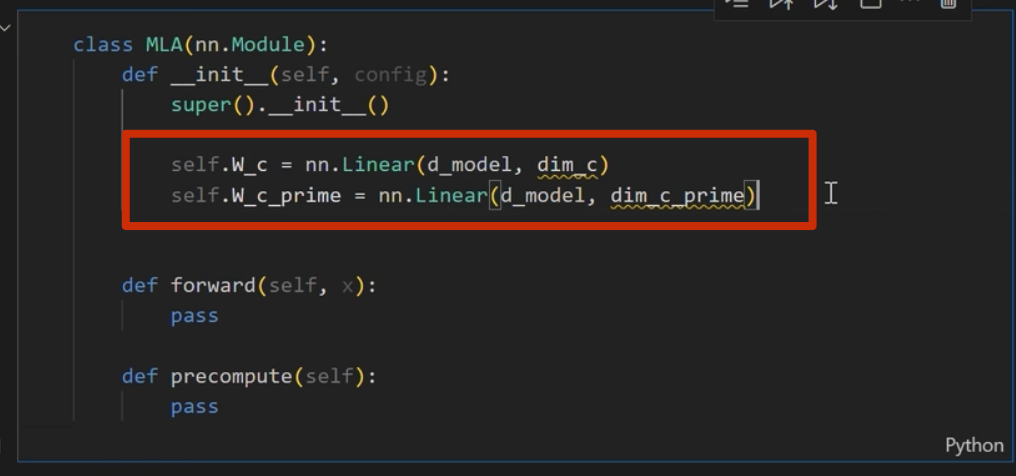

首先实现下面的

注意这里 k 是直接从 c_i和 xi 进行投影,而 不是像 q 一样从 c_i_prime投影(论文也是这么写的)

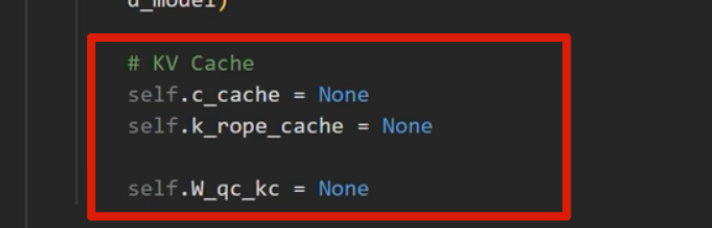

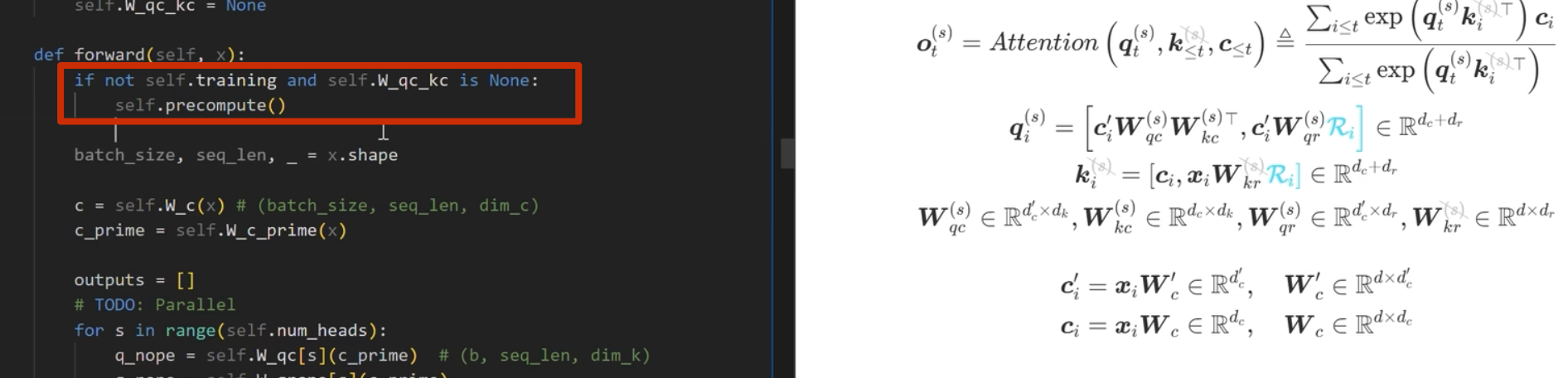

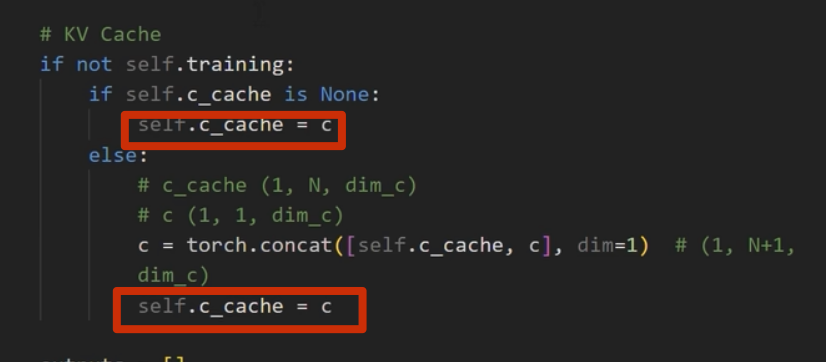

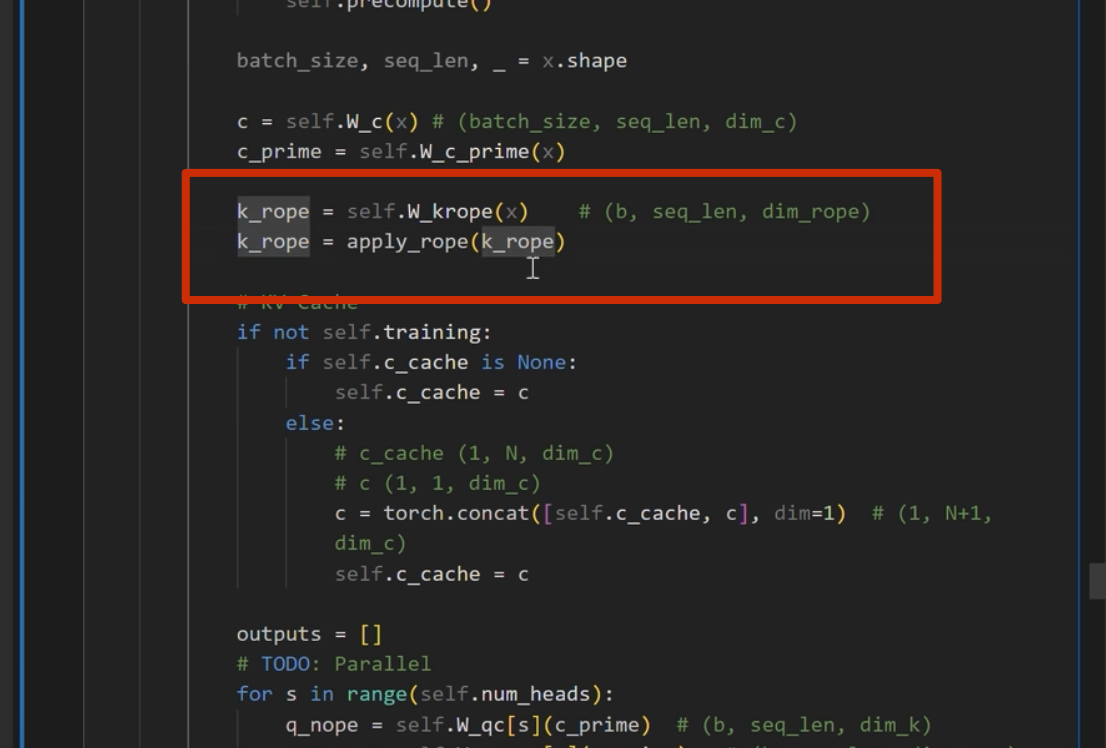

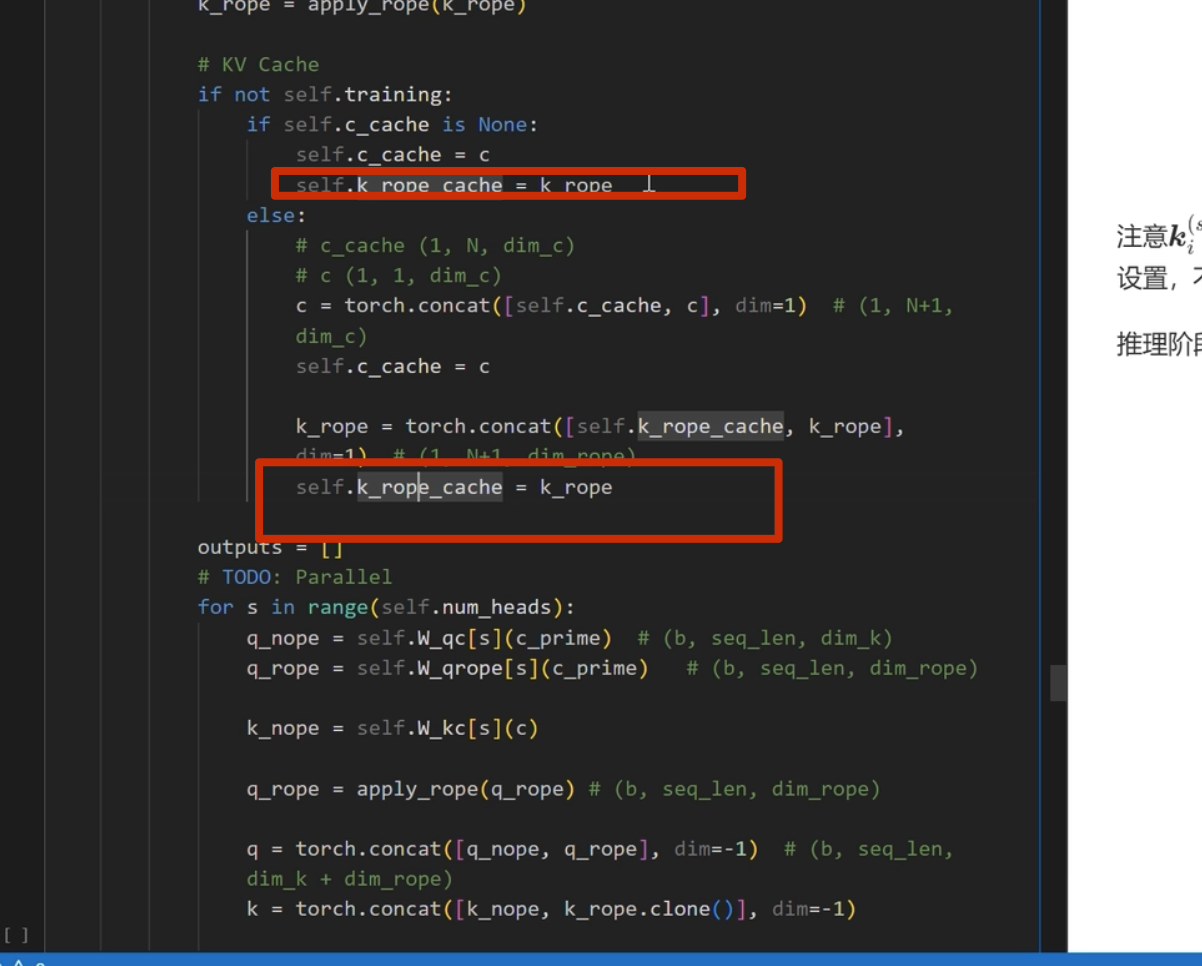

推理部分

kv-cache

apply_rope是加入位置编码

kv-cache 的计算

在每一次推理前调用

之前 k_rope是在 for 循环里面的,可以移到外面

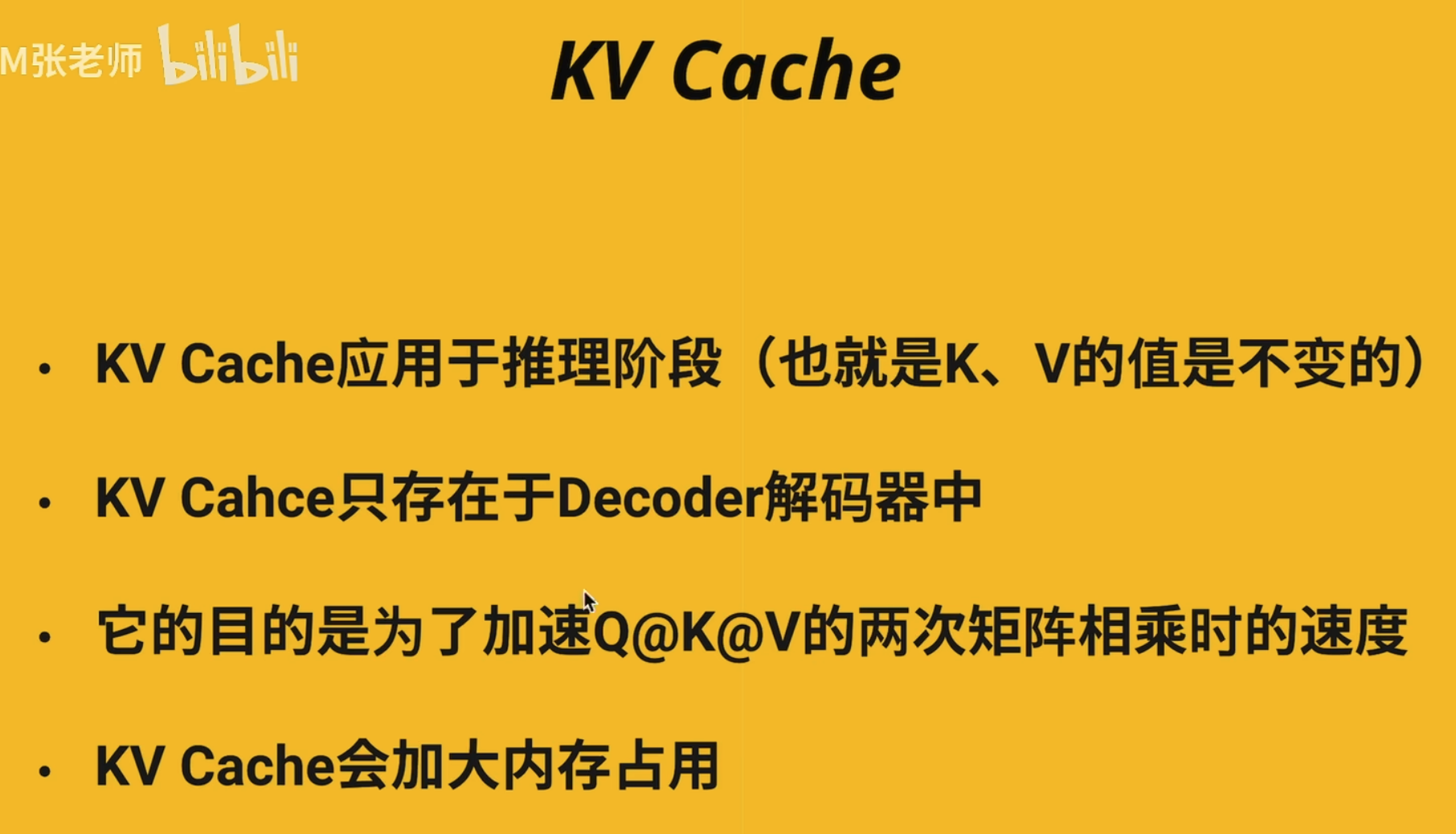

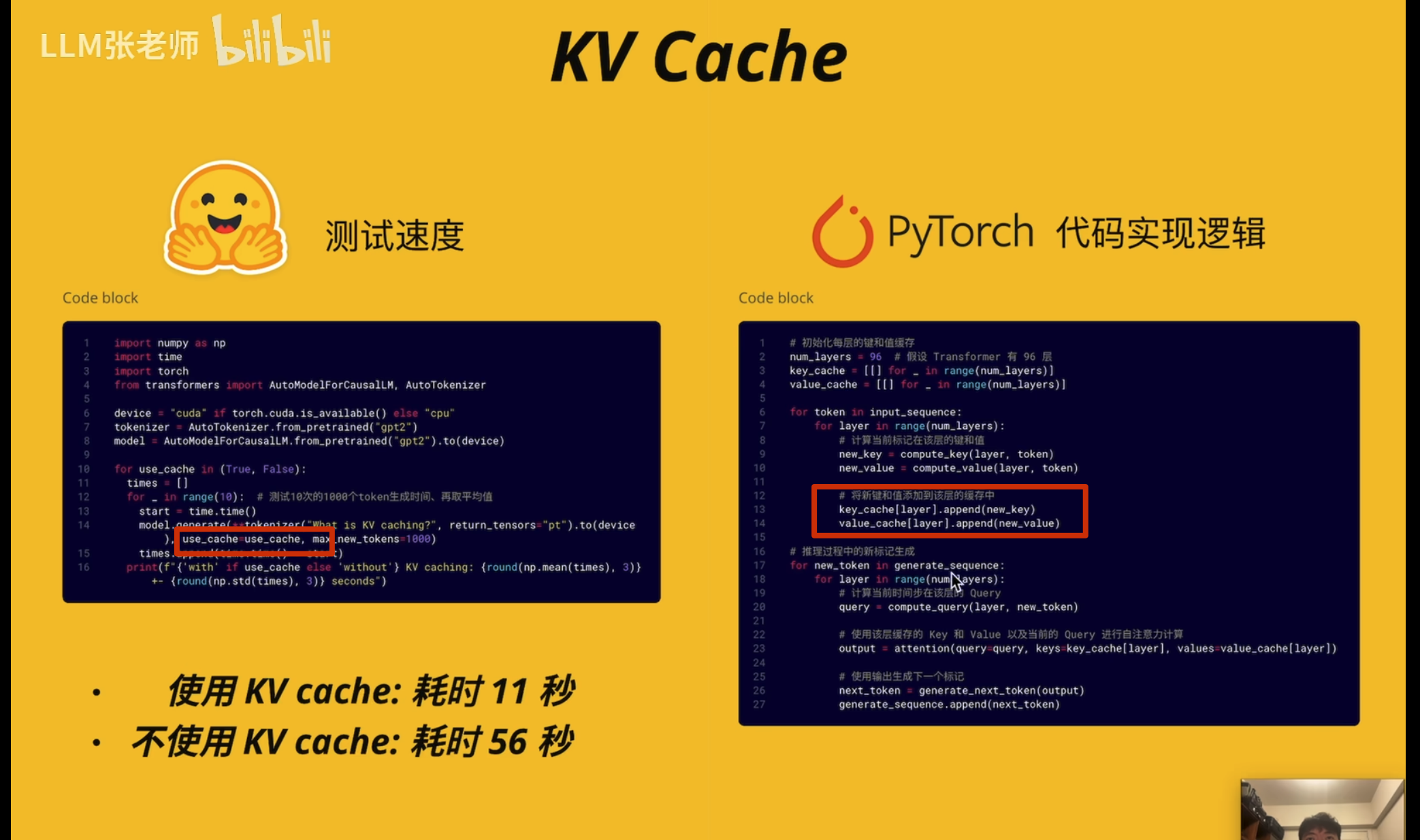

KV Cache

位置编码

基于 Rope 发展来的,但是很复杂

(针对一些中间变量变化特别大的情况做优化)

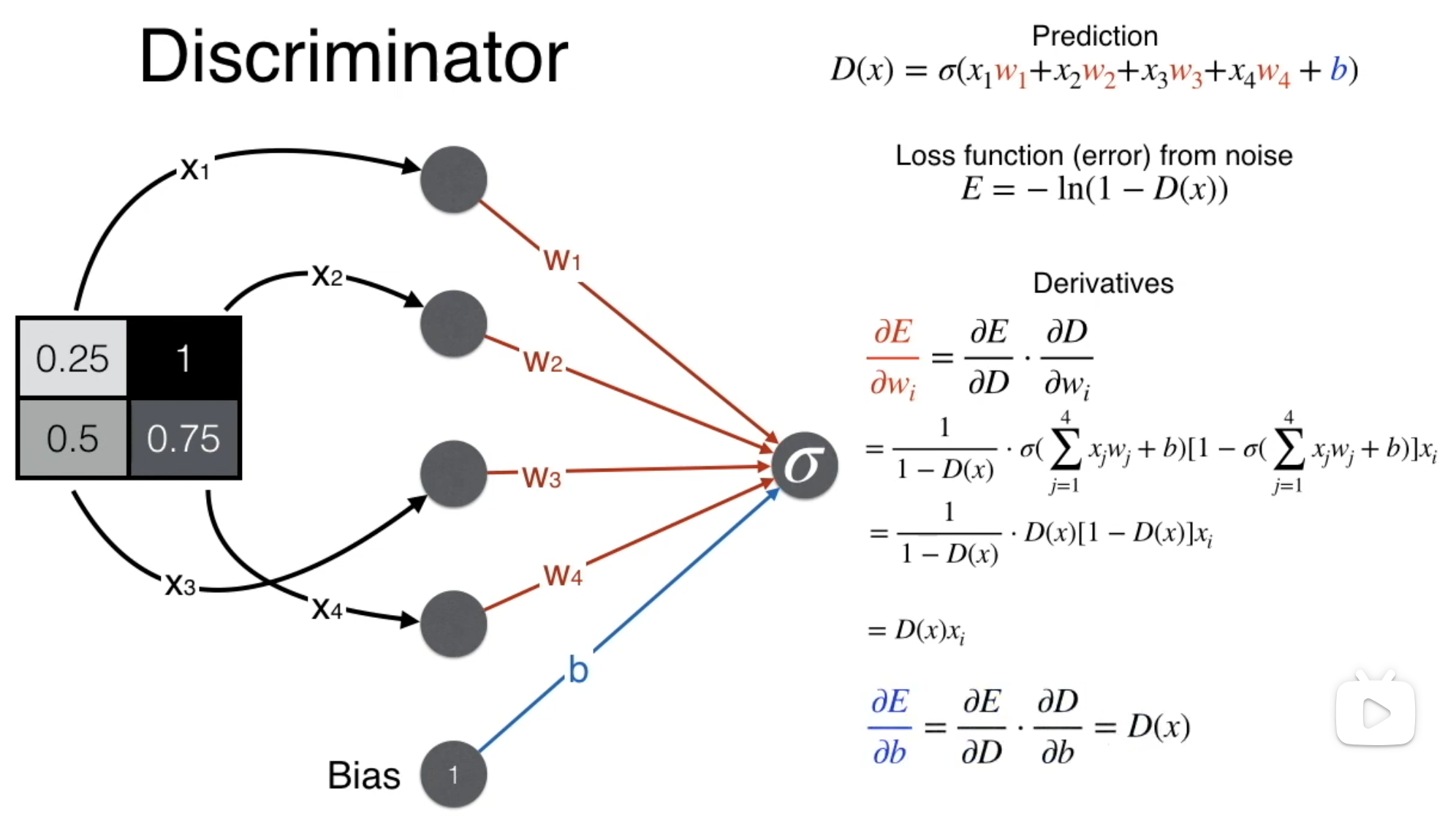

GAN

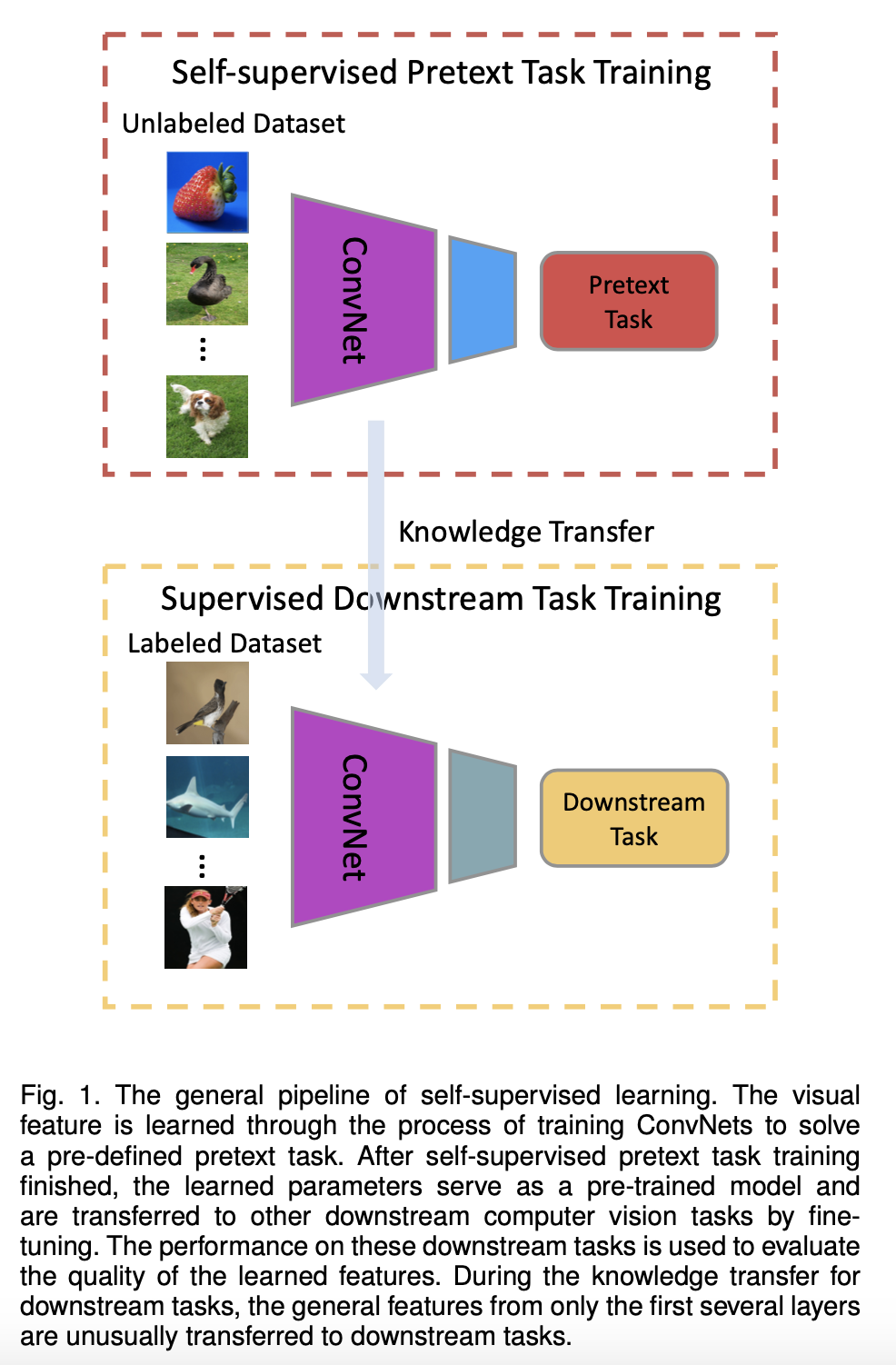

自监督学习

参考https://www.cnblogs.com/polly333/p/17791786.html

1、背景

为什么自监督火了?

- 大模型火了,数据需求量大

- 数据需求量大,导致标注成本提升

- 人工标准有一定误差

另一个层面来讲:

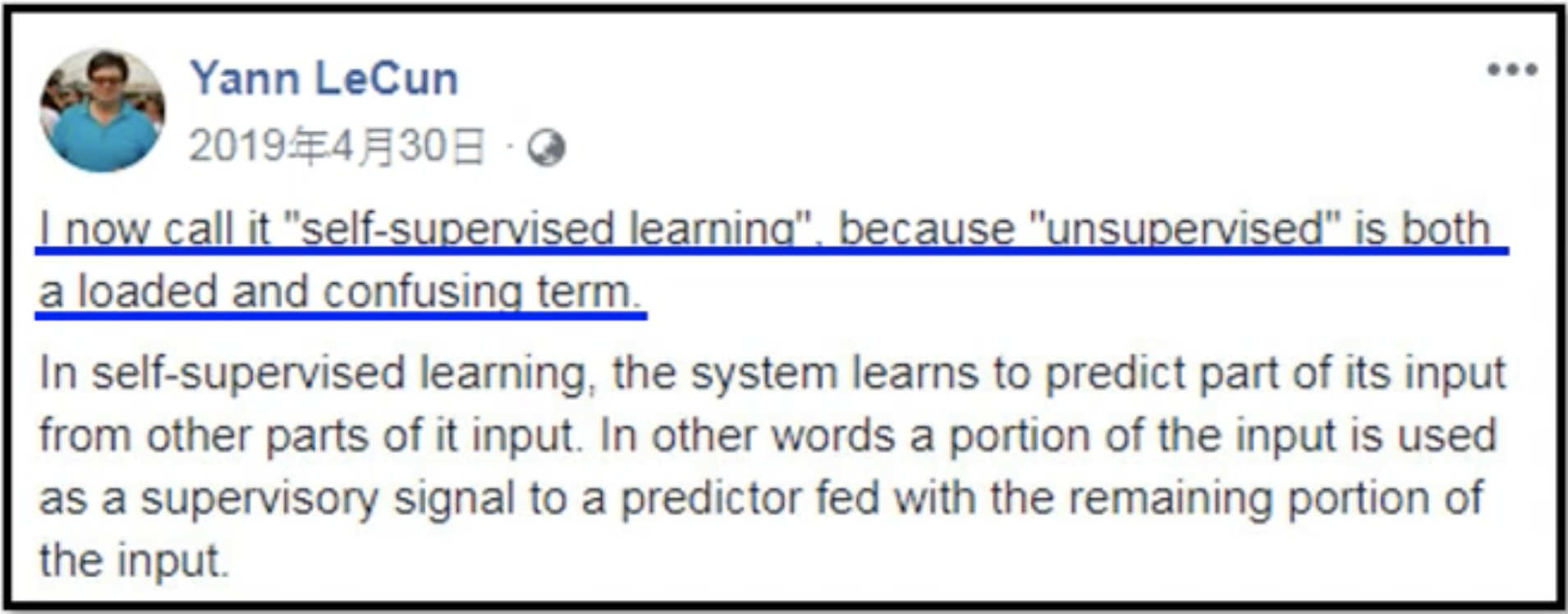

Yann Lecun在AAAI 2020的演讲中,指出目前深度学习遇到的挑战:

- 监督学习:深度模型有海量参数,需要大量的label数据,标注成本高、扩展性差,难以应用到无标记或标记数据少的场景。

- 强化学习:agent需要和环境大量的交互尝试,很多实际场景(例如互联网搜索推荐、无人驾驶)中交互成本大、代价高,很难应用。

而人类和动物学习快速的原因:最重要的是观察世界,而不是靠大量的监督、强化学习。自监督学习的思想就是 通过构造任务来提升预训练模型预测能力 ,即Predicting everything from everything else。具体方法是假装输入中的一部分不存在,然后基于其余的部分用模型预测这个部分,从而学习得到一个能很好地建模输入语义信息的表示学习模型

基于以上的问题,我们可以通过自监督的方法一定程度上进行解决。当然,自监督的方法也不是完全正确的,但是可以提高标注和训练的速度,减少人为因素的干扰

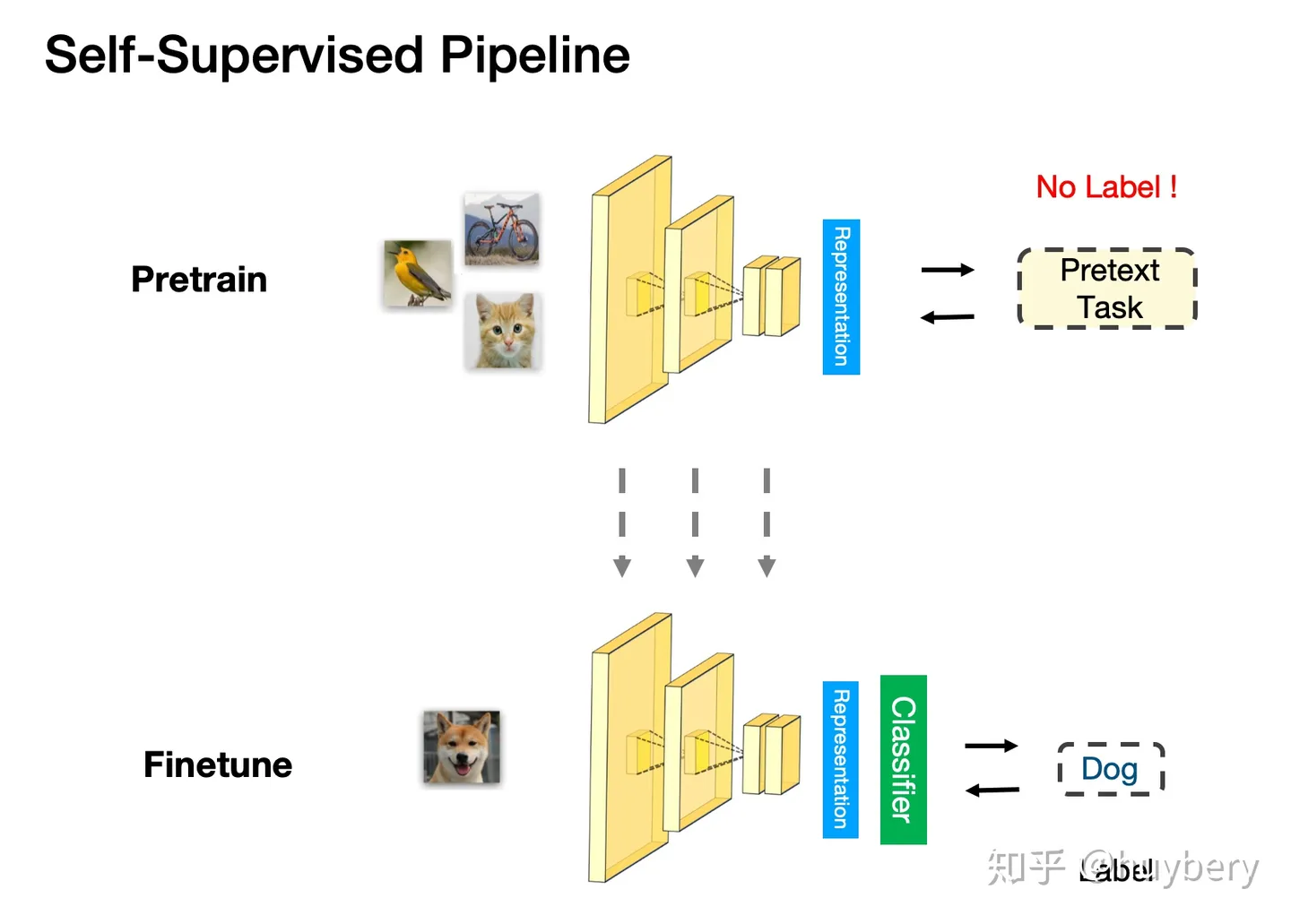

2、自监督学习理论

Self-Supervised Learning 的目的一般是使用大量的无 label 的资料去Pre-train一个模型,这么做的原因是无 label 的资料获取比较容易,且数量一般相当庞大,我们希望先用这些廉价的资料获得一个预训练的模型,接着根据下游任务的不同在不同的有 label 数据集上进行 Fine-tune 即可

2.1 什么是自监督学习

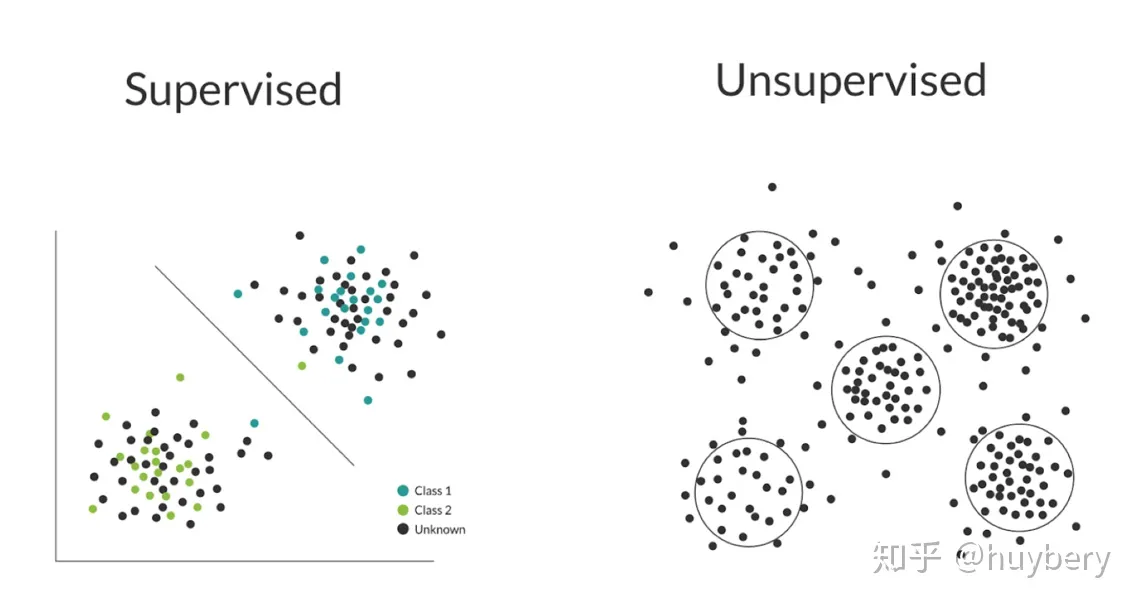

监督学习利用大量的标注数据来训练模型,无监督学习不依赖任何标签值,通过对数据内在特征的挖掘,找到样本间的关系,比如聚类相关的任务。有监督和无监督最主要的区别在于模型在训练时是否需要人工标注的标签信息。

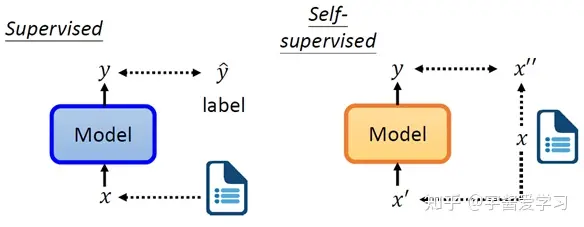

自监督从无监督的概念中分离出来,成为一个独立的概念,通常为定义一个Pretext task (辅助任务),即从无监督的数据中,通过巧妙地设计自动构造出有监督(伪标签)数据,学习一个预训练模型。

具体来说自监督可以定义为:

从部分无标签数据自身出发通过设计半自动预训练任务进行处理学习具有监督性质的表征信息。

通过这部分学习到特征的数据去预测其他无标签的数据,实现标签的泛化

下面是 BERT这种预训练模型为例子(BERT,基于transformer的双向编码表示,它是一个预训练模型,模型训练时的两个任务是预测句子中被掩盖的词以及判断输入的两个句子是不是上下句。在预训练好的BERT模型后面根据特定任务加上相应的网络,可以完成NLP的下游任务,比如文本分类、机器翻译等。https://arxiv.org/abs/1810.04805)

BERT预训练目标-——这里是最小化交叉熵

如果学习的预训练模型能准确预测缺失部分的数据,说明它的表示学习能力很强,能够学习到输入中的高级语义信息、泛化能力比较强

Self-Supervised Learning 是无监督学习里面的一种,主要是希望能够学习到一种通用的特征表达用于 下游任务 (Downstream Tasks) 。预训练阶段使用 无标签的数据集 (unlabeled data) ,想先把参数从 一张白纸 训练到 初步成型 ,再从 初步成型 训练到 完全成型 。注意这是2个阶段。这个 训练到初步成型的东西 ,我们把它叫做 Visual Representation 。预训练模型的时候,就是模型参数从 一张白纸 到 初步成型 的这个过程,还是用无标签数据集。等我把模型参数训练个八九不离十,这时候再根据你 下游任务 (Downstream Tasks) 的不同去用带标签的数据集把参数训练到 完全成型 ,那这时用的数据集量就不用太多了,因为参数经过了第1阶段就已经训练得差不多了

2.2 如何实现

在自监督学习中,最重要的问题是:如何定义Pretext任务、如何从Pretext任务学习预训练模型

对于自监督学习来说,存在三个挑战:

- 对于大量的无标签数据,如何进行表征学习?

- 从数据的本身出发,如何设计有效的辅助任务 pretext?

- 对于自监督学习到的表征,如何来评测它的有效性?

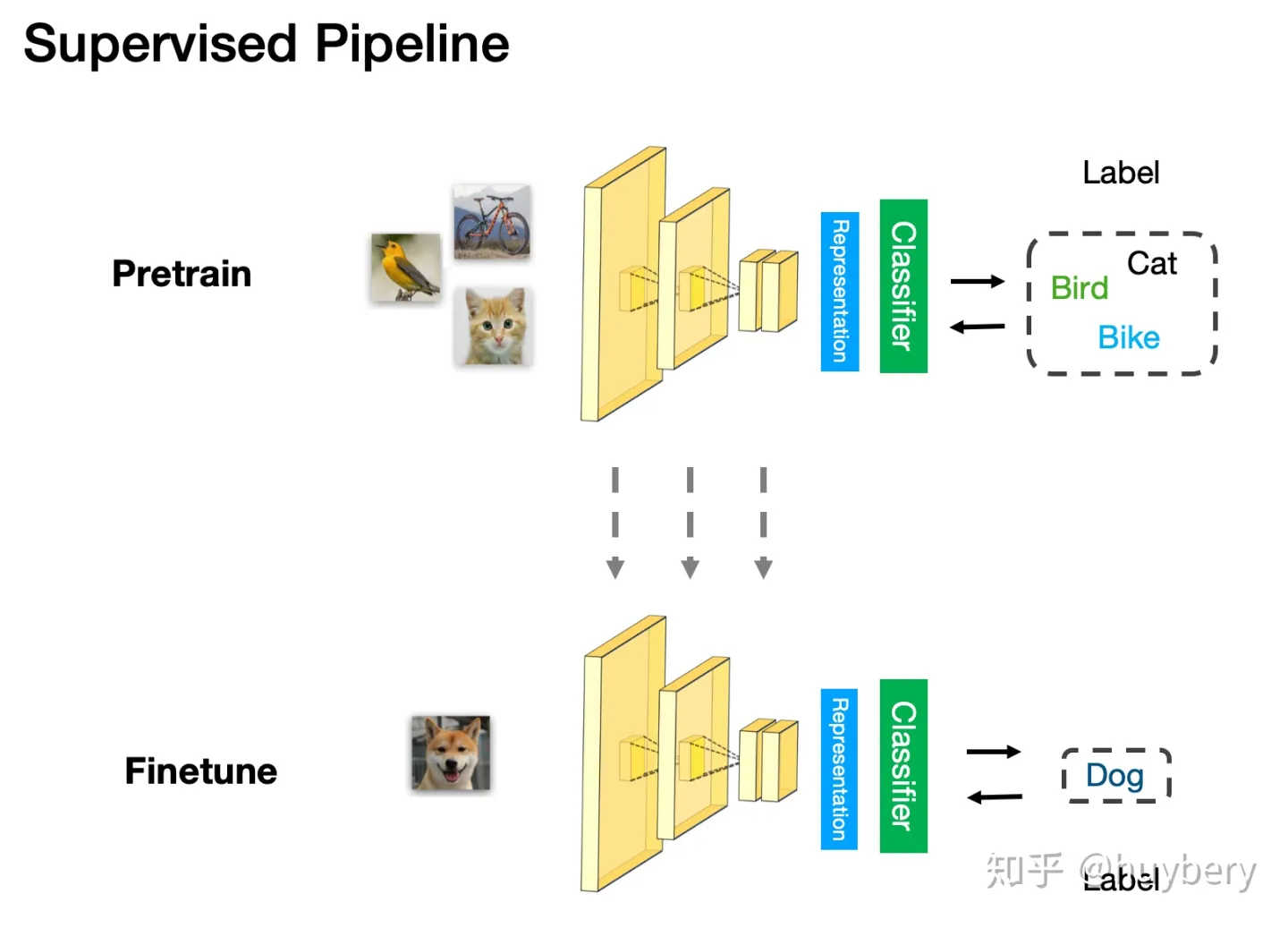

评测自监督学习的能力,主要是 通过 Pretrain-Fintune 的模式 。

监督学习中的 Pretrain - Finetune 流程:我们首先从大量的有标签数据上进行训练,得到预训练的模型,然后对于新的下游任务(Downstream task),我们将学习到的参数进行迁移,在新的有标签任务上进行「微调」,从而得到一个能适应新任务的网络。

自监督的 Pretrain - Finetune 流程:

首先从大量的无标签数据中通过 pretext

来训练网络,得到预训练的模型,然后对于新的下游任务,和监督学习一样,迁移学习到的参数后微调即可。所以自监督学习的能力主要由下游任务的性能来体现

。

监督学习的 Pretrain-Finetune

3 、自监督的学习方法

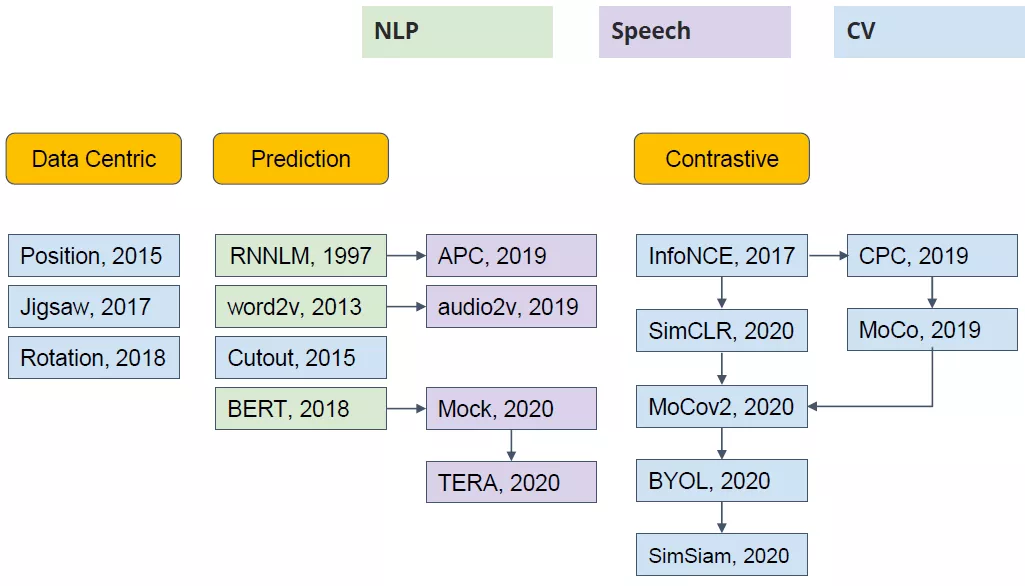

自监督学习的方法主要可以分为 3 类:1. 基于上下文(Context based) 2. 基于时序(Temporal Based)3. 基于对比(Contrastive Based)

3.1 基于上下文

context-based中文就是基于上下文的自监督学习。这也是早期自监督模型设计的主要思路方法。这部分内容将通过几篇极具代表性的文章进行讲解。

基于数据本身的上下文信息,我们其实可以构造很多任务,比如在 NLP 领域中最重要的算法 Word2vec 。 Word2vec 主要是利用语句的顺序,例如 CBOW 通过前后的词来预测中间的词,而 Skip-Gram 通过中间的词来预测前后的词。

本身是自然语言的处理方式,通过此思想引入到图像领域。

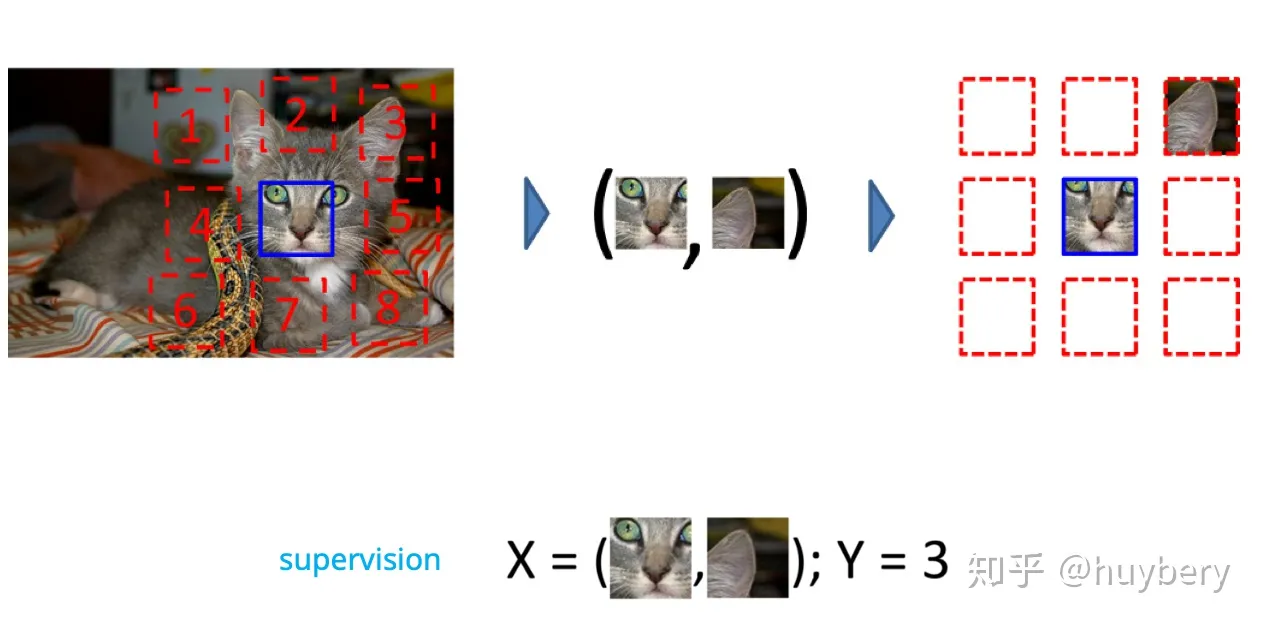

1. 拼图

[1] Carl Doersch, Abhinav Gupta, and Alexei A Efros. “Unsupervised visual representation learning by context prediction”. In: Proceedings of the IEEE international conference on computer vision. 2015, pp. 1422–1430.

首先是一篇发布于ICCV 2015[1]上利用图片色块(patch)相对位置预测进行预训练的自监督模型。具体的方法如下所示:

将一张图分成 9

个部分,然后通过预测这几个部分的相对位置来产生损失 ,比如我们

输入这张图中的小猫的眼睛和右耳朵,期待让模型学习到猫的右耳朵是在脸部的右上方的

,如果模型能很好的完成这个任务,那么我们就可以认为模型学习到的表征是具有语义信息的。

在给定一个色块后,为周围8个色块分别打上1-8的位置“伪标签”。预训练需要做的是预测随机选取的第二个色块所对应的数字。如例子所示,第二个色块选取了右边的猫耳,模型训练后给出了相对位置3。为了学习到高级的语义信息(物体层次的特征属性等,而不是颜色,质地,形状等低级语义),在进行色块选取的时候还采用了以下的操作:

- 色块与色块之间存在一定的距离,约为色块宽度的一半。这样做的目的是避免边缘信息提供相对位置之间的暗示。

- 随机抖动色块的位置使其偏移7个像素。从上图可以看出,每个色块并不是整齐排列的,他们或左或右,或上或下有些偏移。

- 对图片进行color dropping 或者添加高斯噪声防止色差的影响。

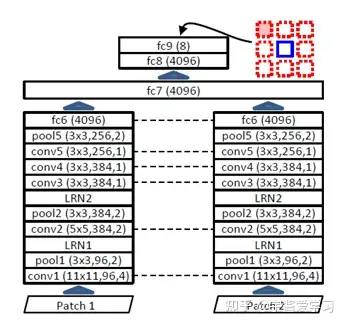

预训练的模型采用的是AlexNet为基础的架构,采用的是parallel的形式,具体如图:

在第6个全连接层(fc)后将两个网络结合到一起变成一个更大的全连接层。之后的输出是一个8个单元的向量,进行位置判断。

在应用在下游任务前,作者还对这个网络学习到的表征和有监督学习和传统无监督学习进行了对比:

这个evaluation采用了nearest neighbors的方法,计算了每个图片的embedding,然后通过embedding的相似程度去寻找与输入最近的图片,进行聚类。通过这个方法,可以一定程度上衡量网络学习到的表征信息。从上图可以看出,三种方法中,随机初始化的效果最差,而自监督和有监督旗鼓相当,效果都不错。

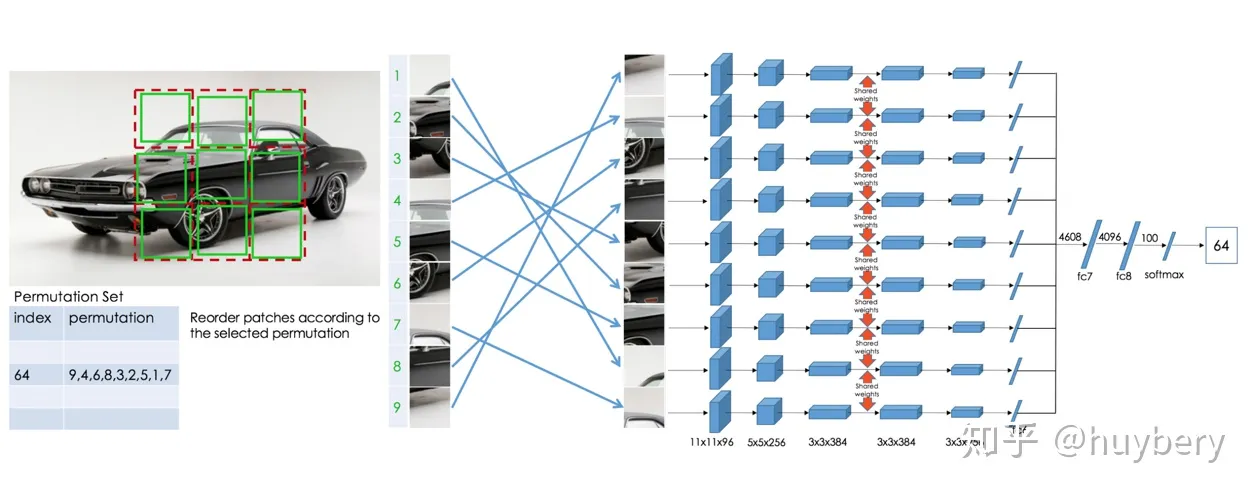

后续的工作[8]人们又拓展了这种拼图的方式,设计了更加复杂的,或者说更难的任务。

- 首先我们依然将图片分为 9 块,我们预先定义好 64 种排序方式。

- 模型输入任意一种被打乱的序列,期待能够学习到这种序列的顺序属于哪个类。

上个工作相比,这个模型需要学习到更多的相对位置信息。这个工作带来的启发就是使用更强的监督信息,或者说辅助任务越难,最后的性能越好。

2.抠图

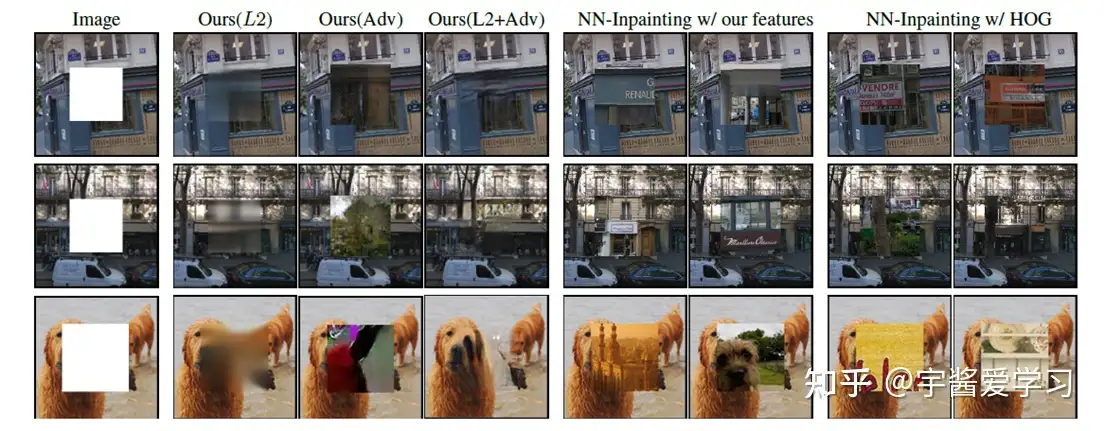

Features learning by inpainting

[2] Deepak Pathak et al. “Context encoders: Feature learning by inpainting”. In: Proceedings of the IEEE conference on computer vision and pattern recognition. 2016, pp. 2536–2544.

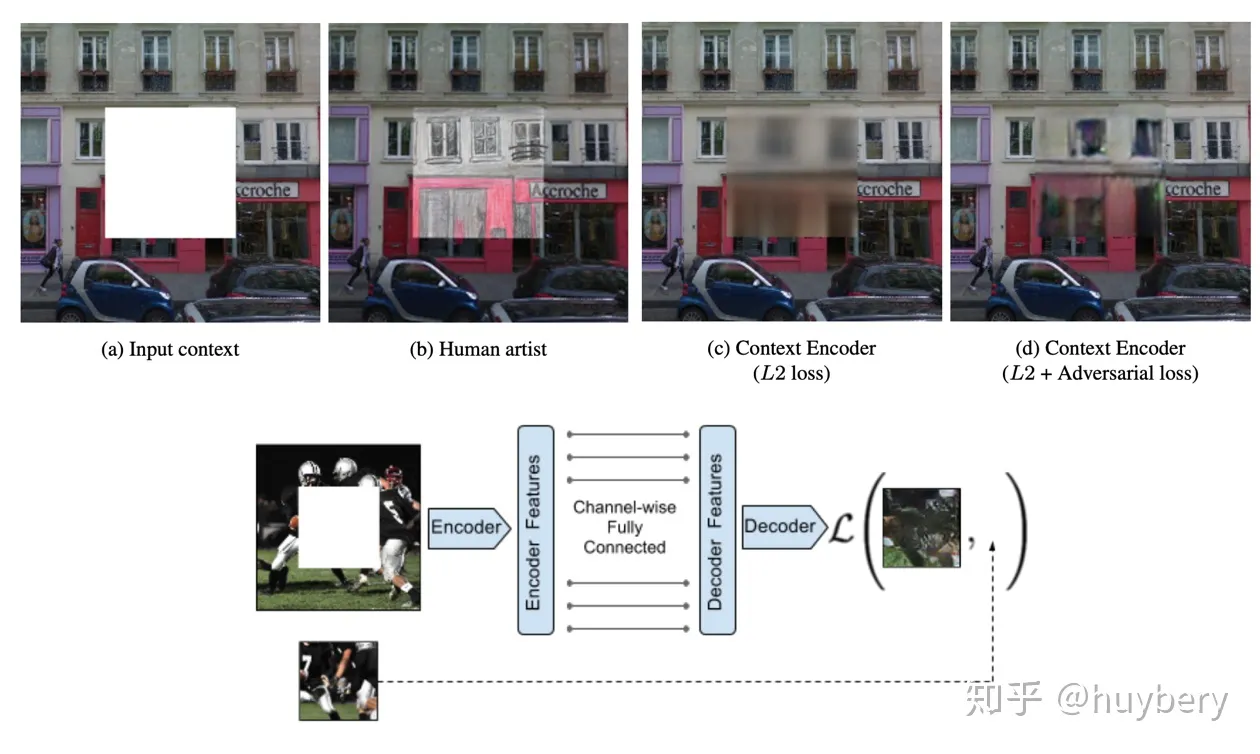

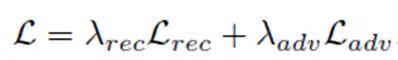

随机的将图片中的一部分删掉,然后利用剩余的部分来预测扣掉的部分,只有模型真正读懂了这张图所代表的含义,才能有效的进行补全

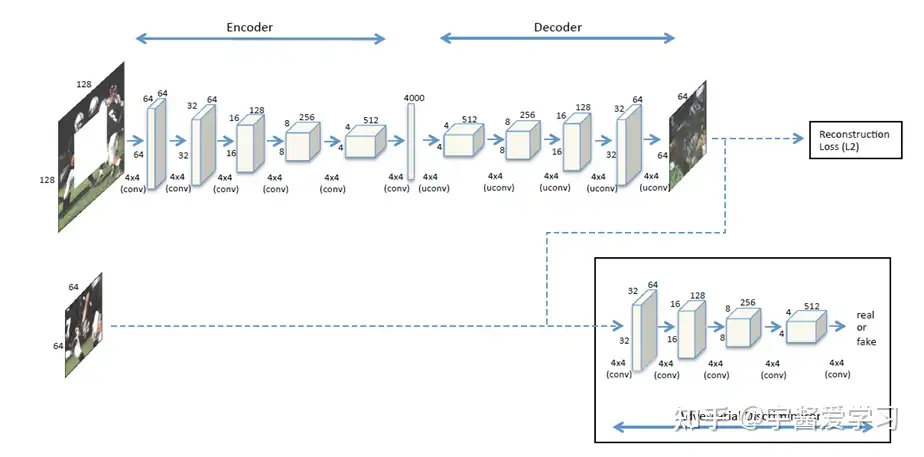

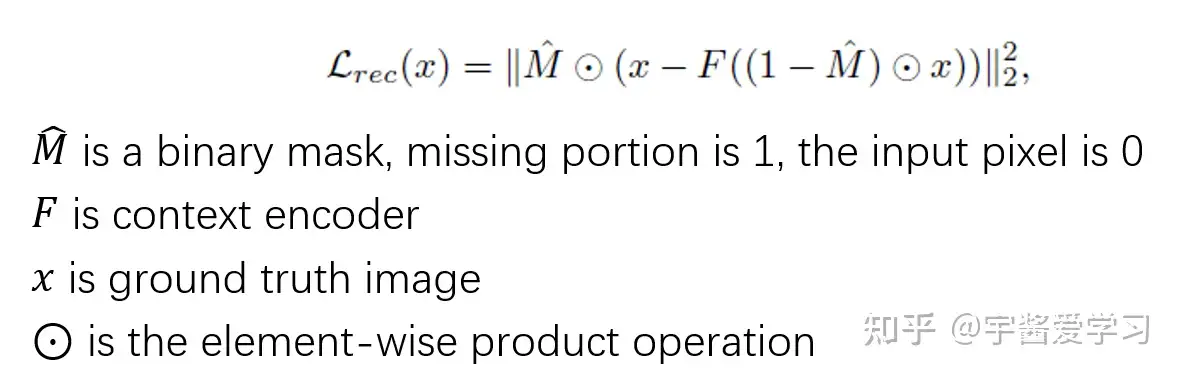

在这个网络架构中使用了两种函数,一个是重构损失L2,衡量了encoder-decoder阶段生成的图片与真实缺块间的距离。可以用下面的公式表示:

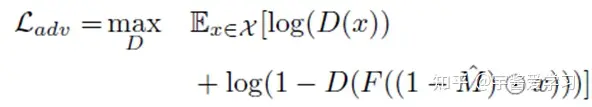

此外,辨别器(discriminator)需要判断生成的图片能否通过检测,因此需要一个对抗损失(adversarial

loss),在这里只提取了GAN损失函数中discriminator的部分:

判别器的作用就是尽量分辨图片的来源:是真实的还是生成的?因此,要尽可能让两者间的差距大。接着将两个损失函数通过超参数结合在一起就是最终的损失:

在实验中$ λ_{rec}=0.999,λ_{adv}=0.001$

此外,为了增加生成的困难度和提高模型的泛化能力,挖空的方式除了中心挖空外,还有以下几种情况:

同样,在文章中作者对encoder-decoder学习到的表征和其他算法进行了对比,结果如下:(看起来效果也不是很好啊)

可以看到,在只用了encoder-decoder而没用discriminator时,生成的缺块有点模糊;而反之只使用discriminator时生成的缺块与周围像素不匹配。因此将两者结合起来时,补全的图形与真实情况最为接近。

但是这个预训练任务也存在一些缺陷。在这篇文章[3]中指出了其中三个:

- 损失函数无法捕捉修复的质量。(Loss function may not capture inpainting quality)

- 由于下游任务的输入是完整的图片,因此在训练和测试时可能会产生domain gap的问题。(Cause a “domain gap” between training and test)

- 在预测生成缺块时主要利用的是周围的像素信息,包括颜色,形状,灰度值等,因此没有高级语义信息的应用。(Solved inpainting without high-level reasoning)

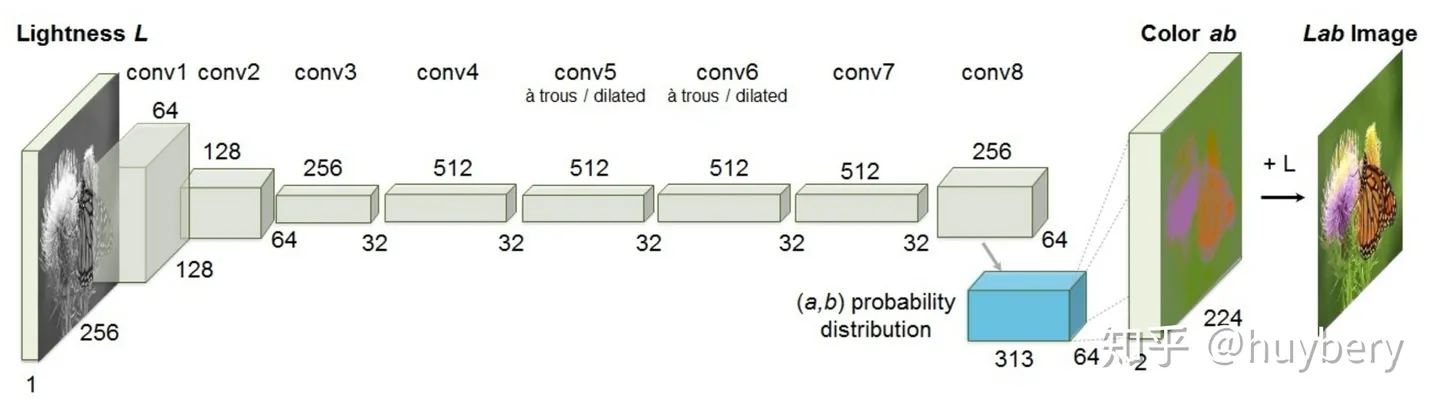

3.颜色信息

模型输入图像的灰度图,来预测图片的色彩 。只有模型可以理解图片中的语义信息才能得知哪些部分应该上怎样的颜色,比如天空是蓝色的,草地是绿色的,只有模型从海量的数据中学习到了这些语义概念,才能得知物体的具体颜色信息。同时这个模型在训练结束后就可以做这种图片上色的任务。

对于原始数据,首先分成两部分,然后通过一部分的信息来预测另一部分,最后再合成完成的数据。和传统编码器不同的是,这种预测的方式可以促使模型真正读懂数据的语义信息才能够实现,所以相当于间接地约束编码器不单单靠

pixel-wise 层面来训练,而要同时考虑更多的语义信息

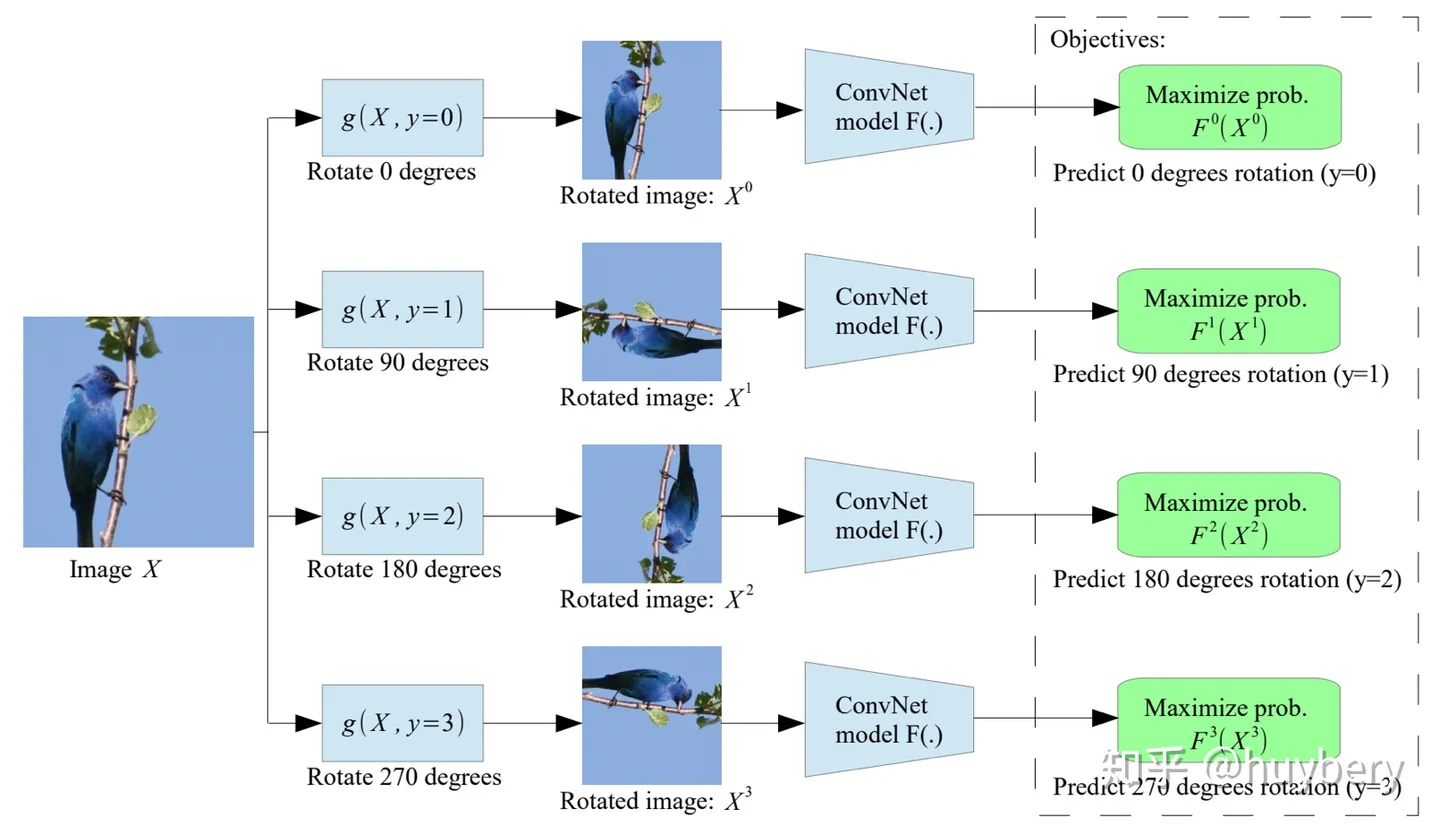

4.数据增广

给定一张输入的图片,我们对其进行不同角度的旋转,模型的目的是预测该图片的旋转角度 。

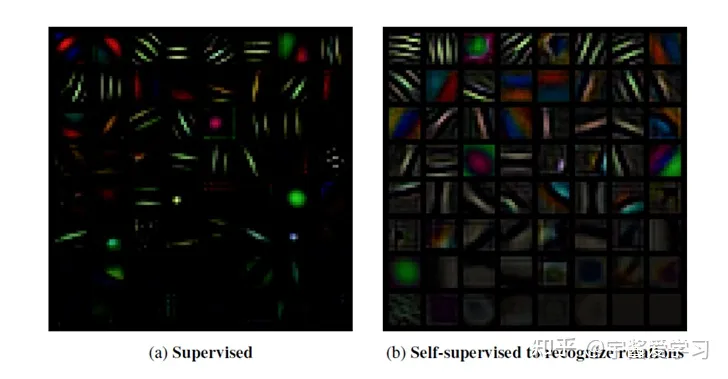

文章中还出现了自监督和有监督学习first layer filters的比较:

可以看到,自监督的结果主要是各种频率的定向边缘过滤器。并且,相比有有监督学习,自监督增加了旋转角度的预测,因此有更多的种类。

3.2.基于时序

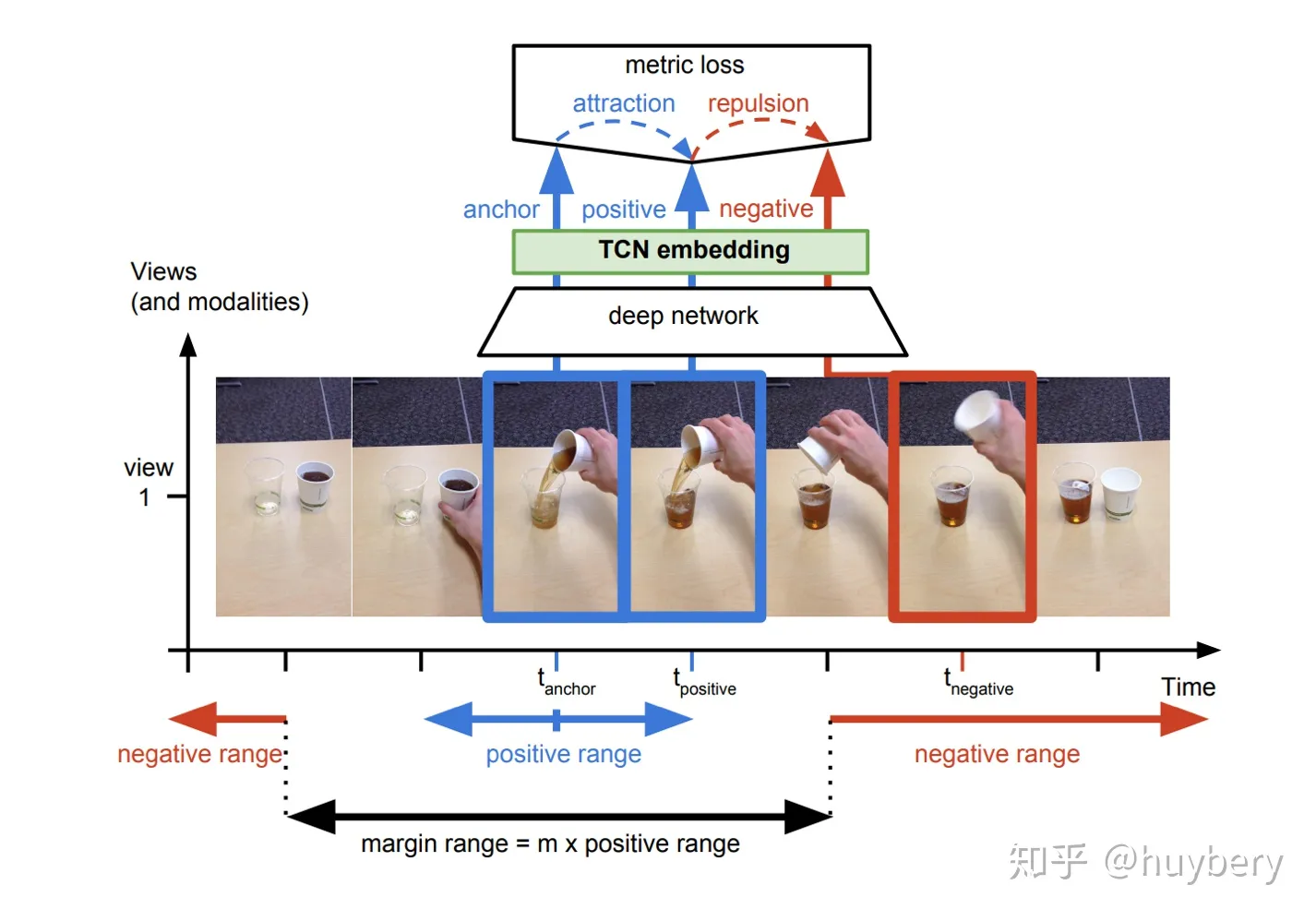

之前介绍的方法大多是基于样本自身的信息,比如旋转、色彩、裁剪等。而样本间其实也是具有很多约束关系的,这里我们来介绍利用时序约束来进行自监督学习的方法。最能体现时序的数据类型就是视频了(video)。

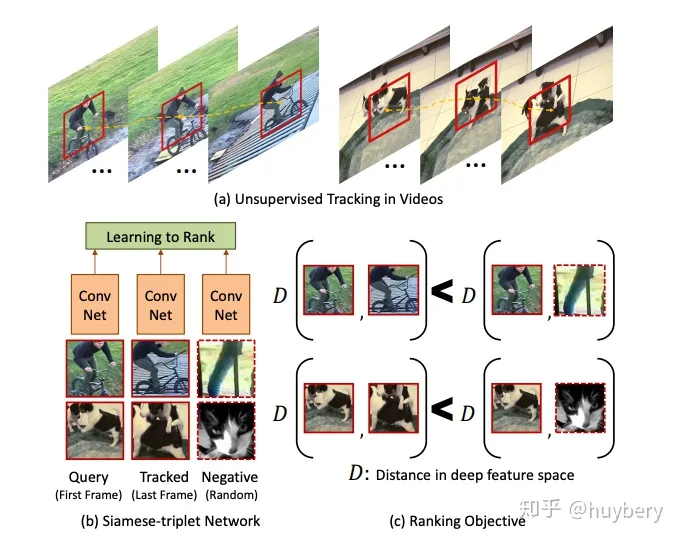

1.相邻特征相似性

视频中的相邻帧特征是相似的,而相隔较远的视频帧是不相似的,通过构建这种相似(position)和不相似(negative)的样本来进行自监督约束

2.多视角相似性

对于同一个物体的拍摄是可能存在多个视角(multi-view),对于多个视角中的同一帧,可以认为特征是相似的,对于不同帧可以认为是不相似的 。

基于顺序的约束还被应用了到了对话系统中,ACL 2019 [20] 提出的自监督对话学习就是基于这种思想。这篇文章主要是想解决对话系统中生成的话术连贯性的问题,期待机器生成的回复和人类交谈一样是符合之前说话的风格、习惯等等。从大量的历史预料中挖掘出顺序的序列(positive)和乱序的序列(negative),通过模型来预测是否符合正确的顺序来进行训练。训练完成后就拥有了一个可以判断连贯性的模型,从而可以嵌入到对话系统中,最后利用对抗训练的方式生成更加连贯的话术。

3.基于对比

介绍的基于时序的方法已经涉及到了这种基于对比的约束, 通过构建正样本(positive)和负样本(negative),然后度量正负样本的距离来实现自监督学习 。核心思想样本和正样本之间的相似度远远大于样本和负样本之间的相似度。

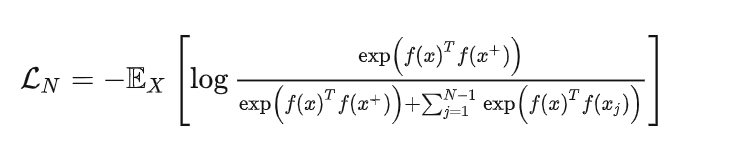

这里的 x 通常也称为 「anchor」数据,为了优化 anchor 数据和其正负样本的关系,我们可以使用点积的方式构造距离函数,然后构造一个 softmax 分类器,以正确分类正样本和负样本。

这个损失也被称为 InfoNCE,后面的所有工作也基本是围绕这个损失进行的。

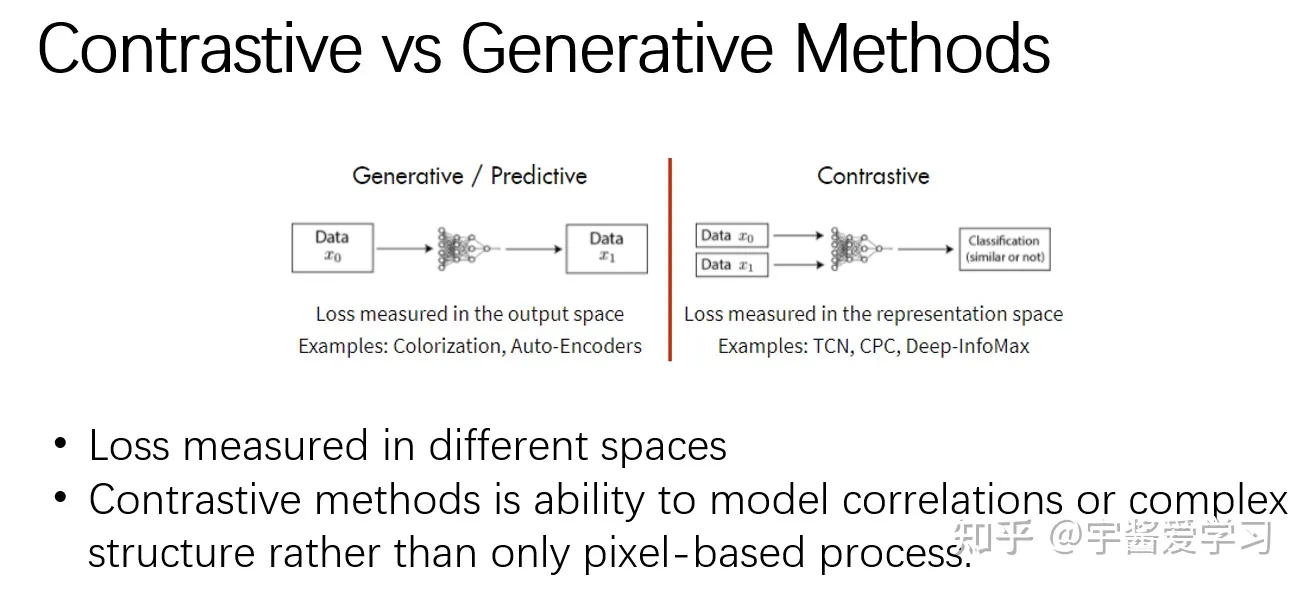

对比学习和之前提到的生成学习有什么区别呢?

区别主要在两个方面:

- 损失计算的空间不同。生成或者预测类方法损失是在输出空间计算的;而对比方法的损失是在表征空间计算的。

- 对比方法有对相关性或复杂结构进行建模的能力,而不仅仅像生成方法一样基于像素进行特征学习。

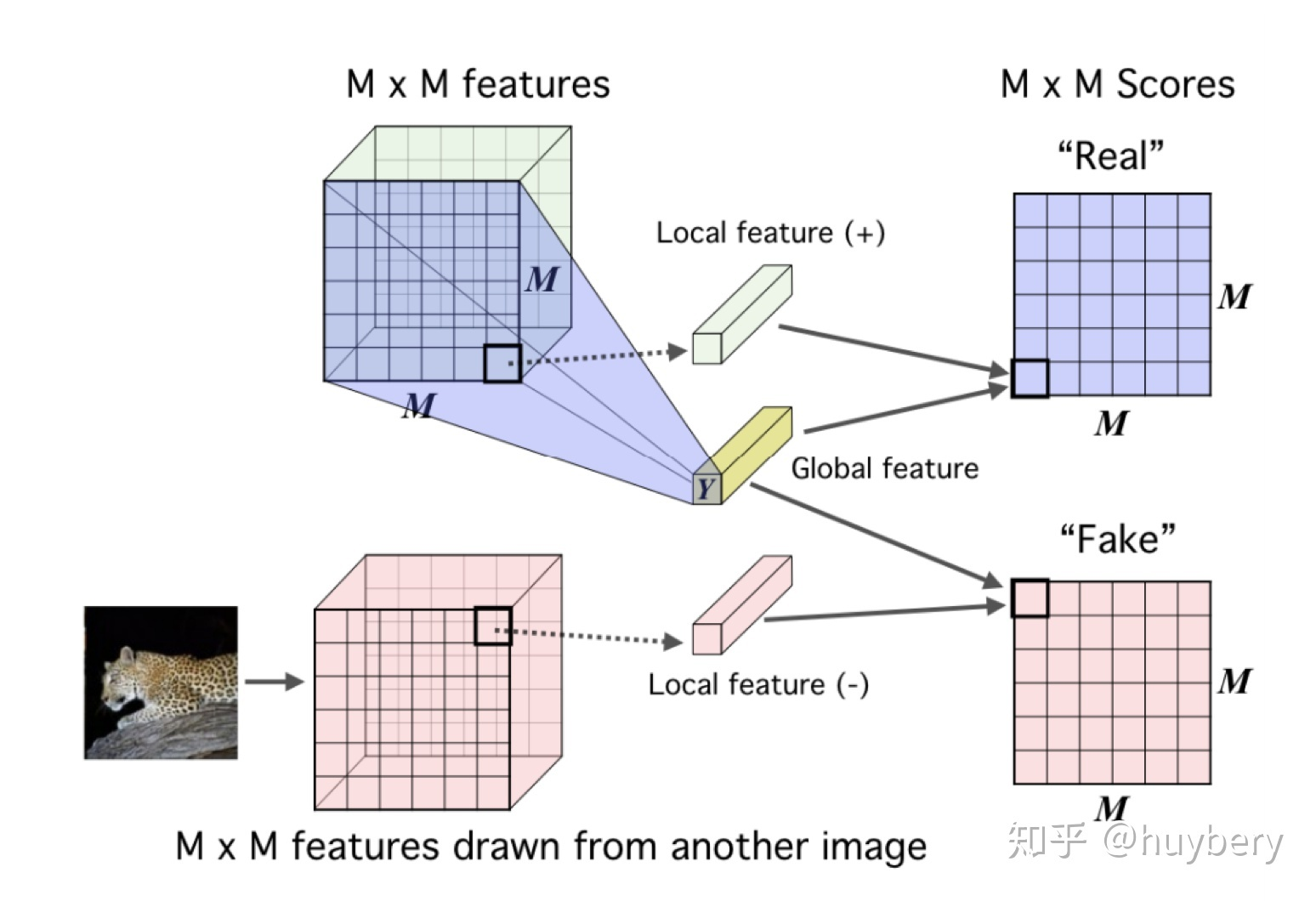

DIM

DIM 的具体思想是对于隐层的表达,对不同的图片用卷积encoder进行表征的提取,encoder最终的输出为全局的特征(global features);而中间层的输出为本地特征(local features), 模型需要分类全局特征和局部特征是否来自同一图像 。所以这里 x 是来自一幅图像的全局特征,正样本是该图像的局部特征,而负样本是其他图像的局部特征。

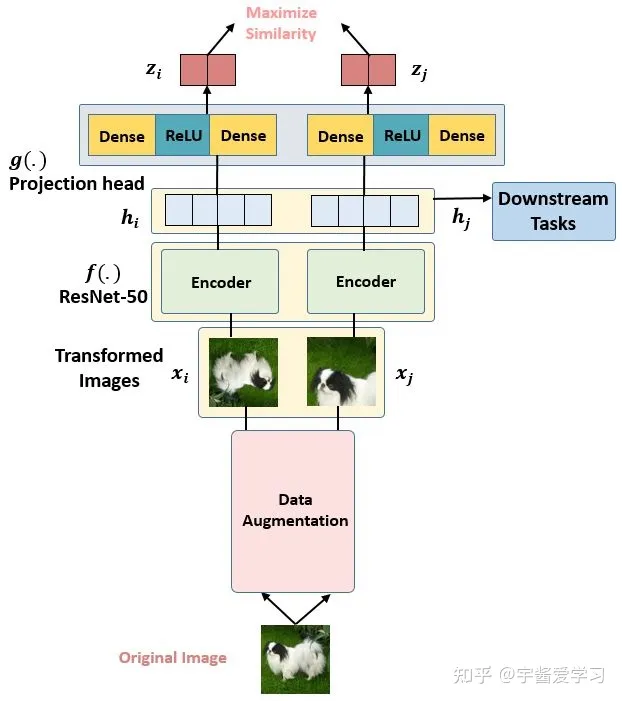

SimCLR

SimCLR

V1是Hitom团队在2020年时提出的一种针对视觉的对比自监督模型。后续文章会详细讲解

4、展望

自监督学习分类示意图

自监督学习在预训练模型中的成功让研究人员觉得非常兴奋,同时也激发了更多的灵感。越来越多的工作开始思考自监督学习和具体任务紧密结合的方法(Task

Related Self-Supervised Learning)

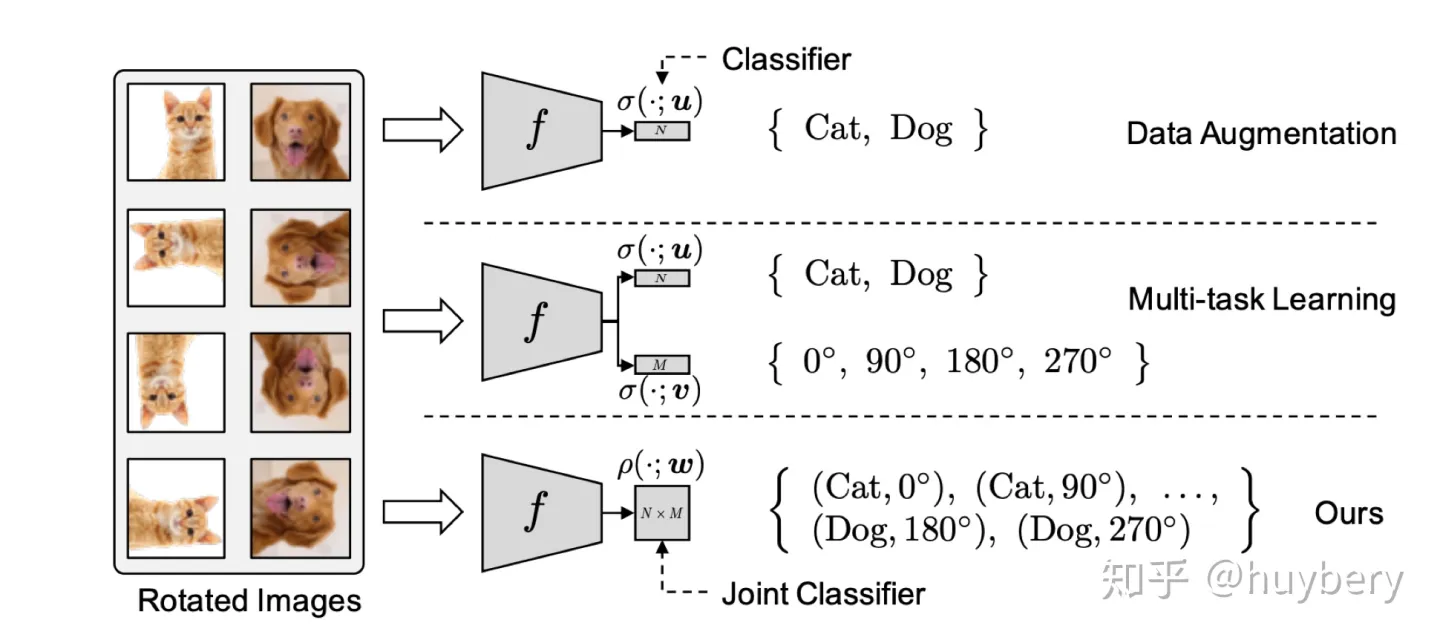

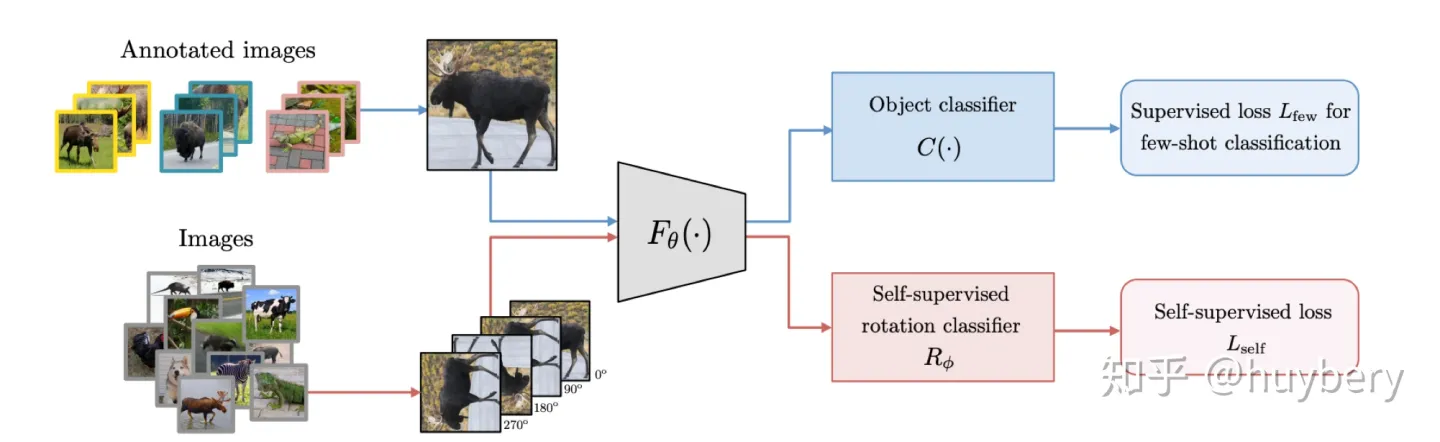

Lee, Hankook et al

[14]探索了在多任务学习中增加自监督学习的可能,他们将普通的分类任务中嵌入了旋转预测任务。除了简单的多任务学习,也可以设计联合学习策略,直接预测两种监督信息。同样的想法也被用到了小样本学习[15]中,一个分支进行传统的小样本分类,另一个分支来进行自监督旋转预测,虽然这篇文章的想法和设计不是很亮眼,但提升还是比较明显的。

而自监督和半监督学习[16]也可以进行结合,对于无标记的数据进行自监督学习(旋转预测),和对于有标记数据,在进行自监督学习的同时利用联合训练的想法进行有监督学习

Lee, Hankook et al [14]探索了在多任务学习中增加自监督学习的可能,他们将普通的分类任务中嵌入了旋转预测任务。除了简单的多任务学习,也可以设计联合学习策略,直接预测两种监督信息。同样的想法也被用到了小样本学习[15]中,一个分支进行传统的小样本分类,另一个分支来进行自监督旋转预测,虽然这篇文章的想法和设计不是很亮眼,但提升还是比较明显的。

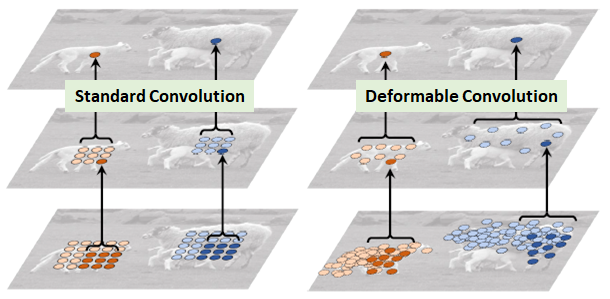

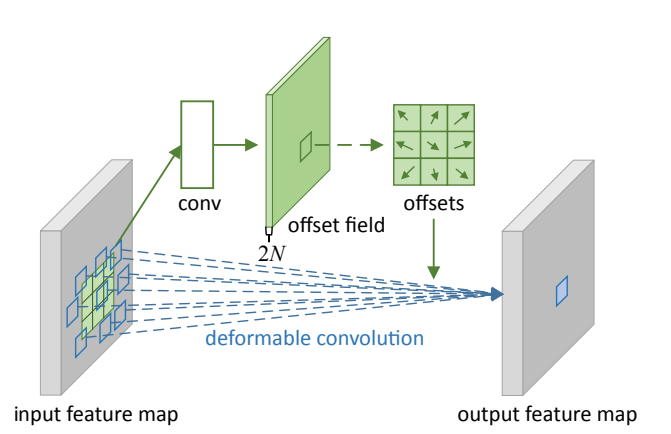

可变形卷积

提出背景¶

视觉识别的一个关键挑战是如何适应物体尺度、姿态、视点和零件变形的几何变化或模型几何变换。

但对于视觉识别的传统CNN模块,不可避免的都存在固定几何结构的缺陷:卷积单元在固定位置对输入特征图进行采样;池化层以固定比率降低空间分辨率;一个ROI(感兴趣区域)池化层将一个ROI分割成固定的空间单元;缺乏处理几何变换的内部机制等。

这些将会引起一些明显的问题。例如,同一CNN层中所有激活单元的感受野大小是相同的,这对于在空间位置上编码语义的高级CNN层是不需要的。而且,对于具有精细定位的视觉识别(例如,使用完全卷积网络的语义分割)的实际问题,由于不同的位置可能对应于具有不同尺度或变形的对象,因此,尺度或感受野大小的自适应确定是可取的。

为了解决以上所提到的局限性,一个自然地想法就诞生了: 卷积核自适应调整自身的形状 。这就产生了可变形卷积的方法。

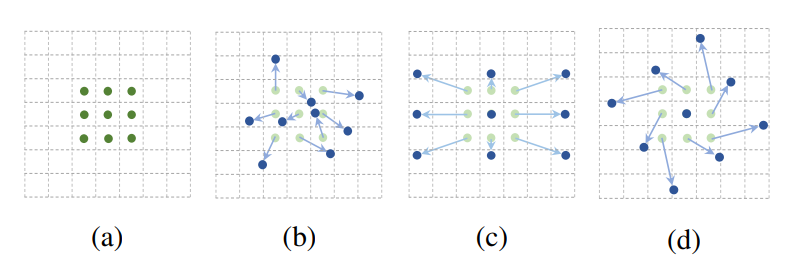

可变形卷积¶

DCN v1¶

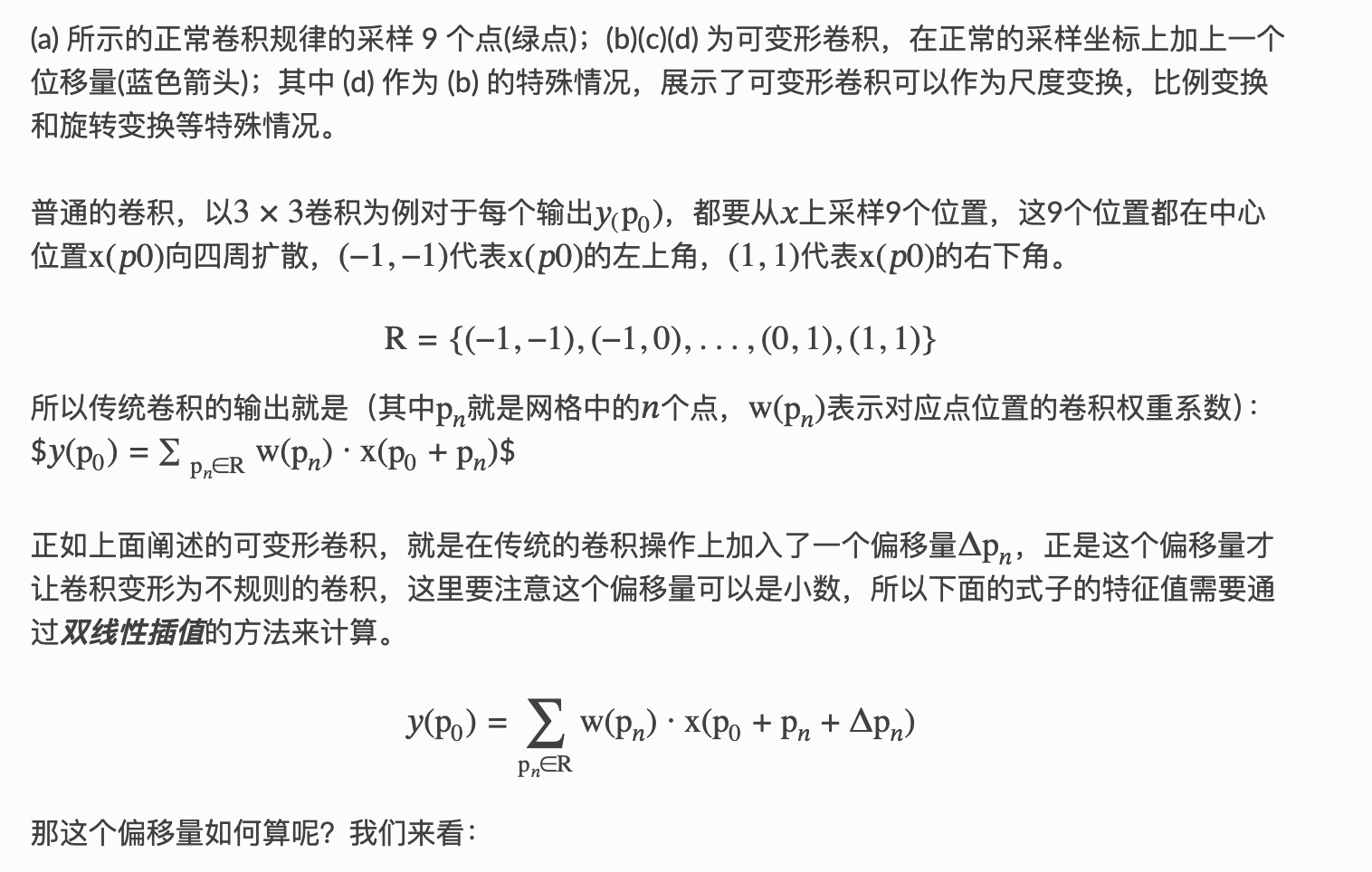

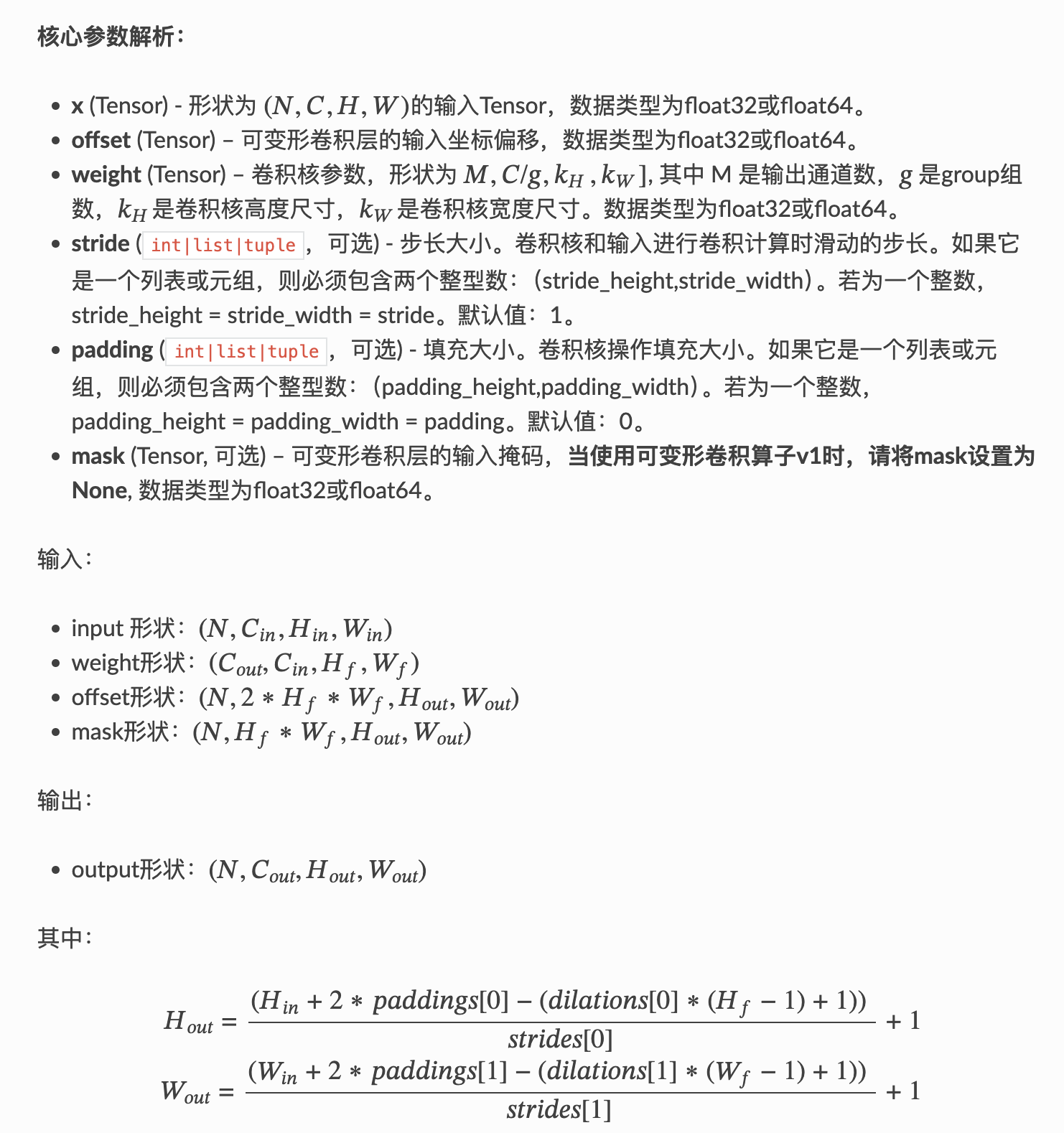

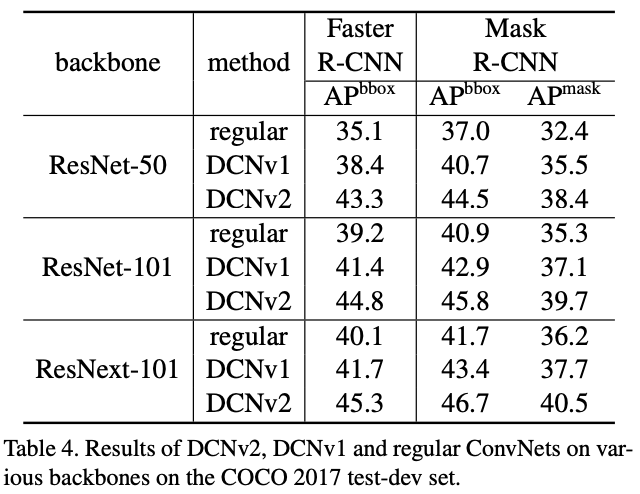

可变形卷积顾名思义就是卷积的位置是可变形的,并非在传统的𝑁×𝑁N×N的网格上做卷积,这样的好处就是更准确地提取到我们想要的特征(传统的卷积仅仅只能提取到矩形框的特征),通过一张图我们可以更直观地了解:

图1 绵羊特征提取

在上面这张图里面,左边传统的卷积显然没有提取到完整绵羊的特征,而右边的可变形卷积则提取到了完整的不规则绵羊的特征。

那可变卷积实际上是怎么做的呢?

其实就是在每一个卷积采样点加上了一个偏移量 ,如下图所示:

图2 卷积核和可变形卷积核

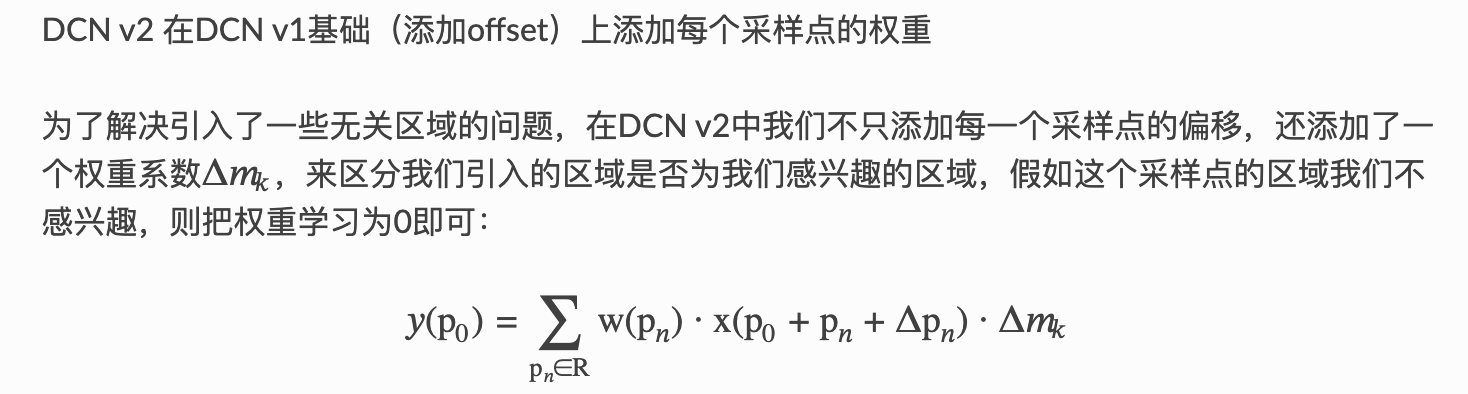

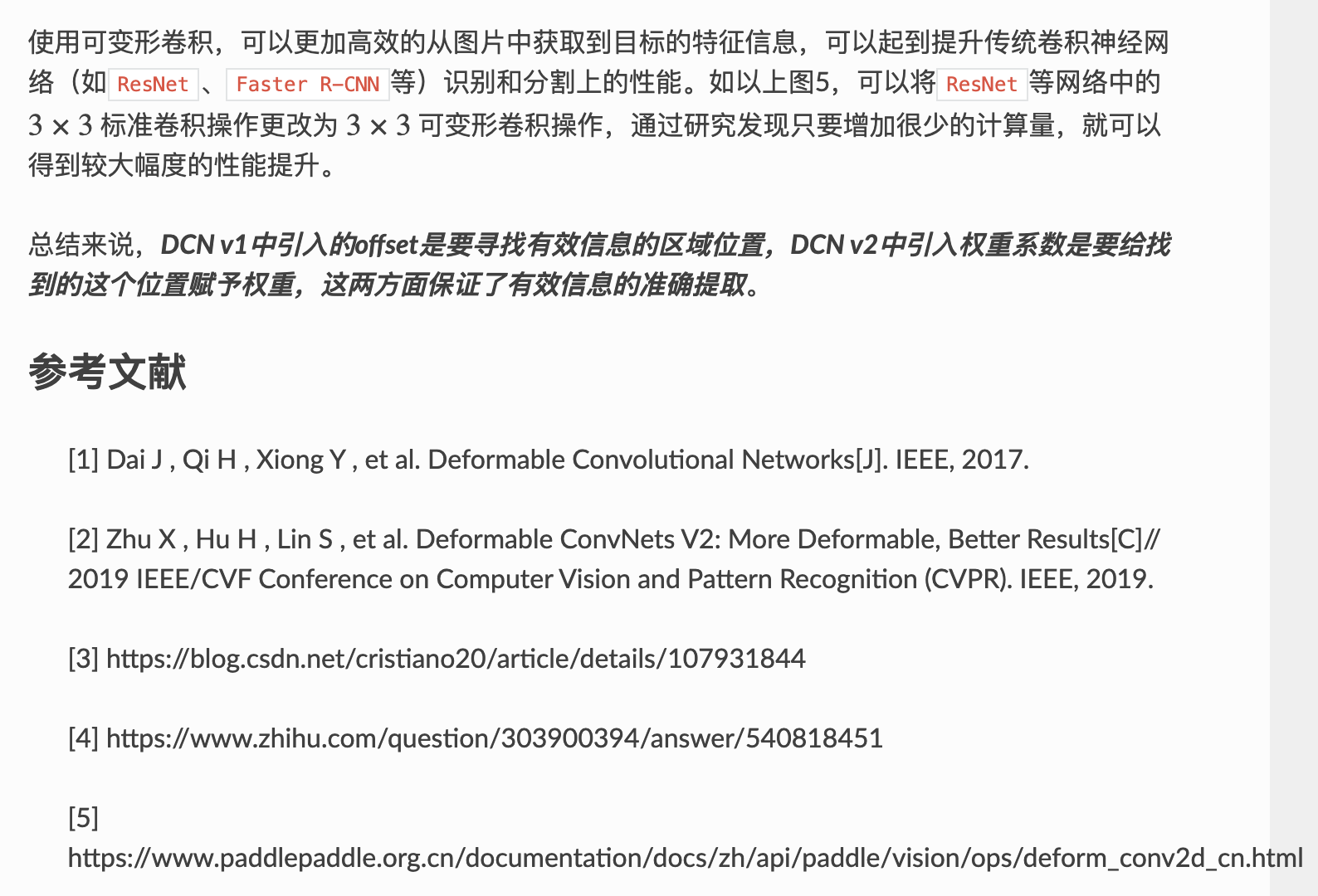

DCN v2

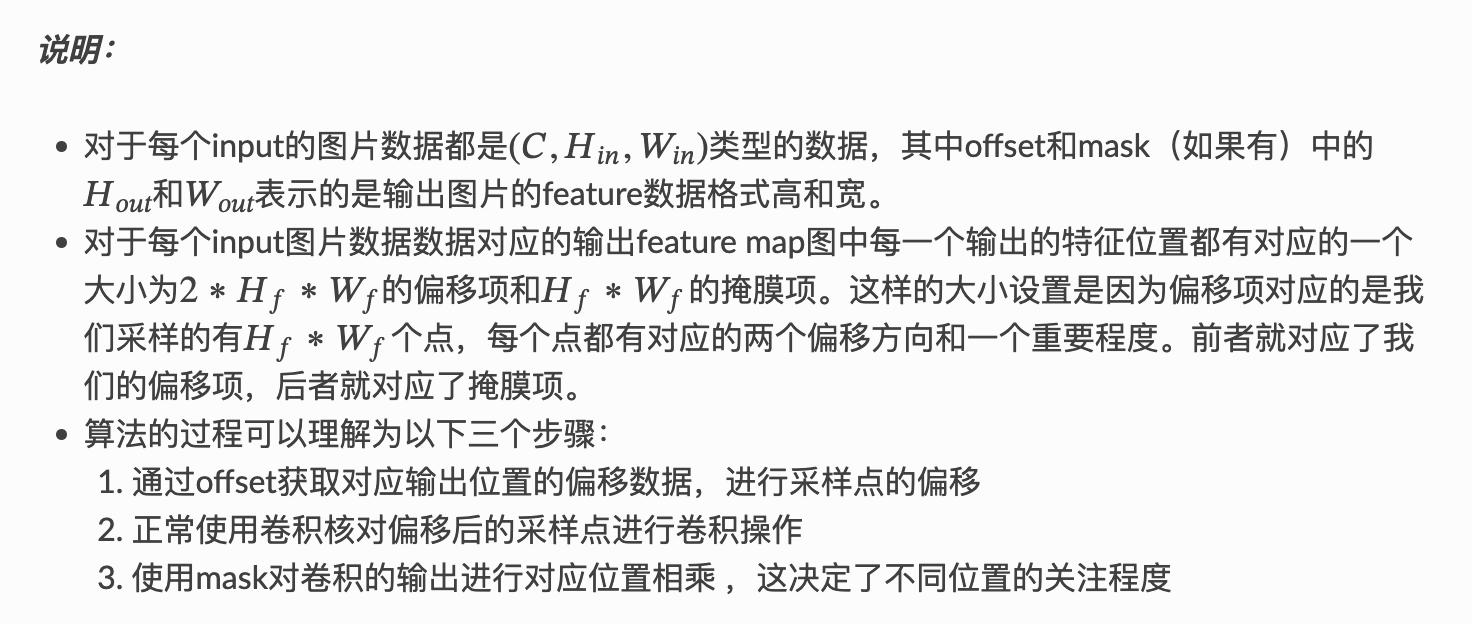

paddle中的API

1 | paddle.vision.ops.deform_conv2d(*x*, *offset*, *weight*, *bias=None*, *stride=1*, *padding=0*, *dilation=1*, *deformable_groups=1*, *groups=1*, *mask=None*, *name=None*); |

deform_conv2d 对输入4-D Tensor计算2-D可变形卷积。详情参考deform_conv2d。

算法实例:

1 | #deformable conv v2: |

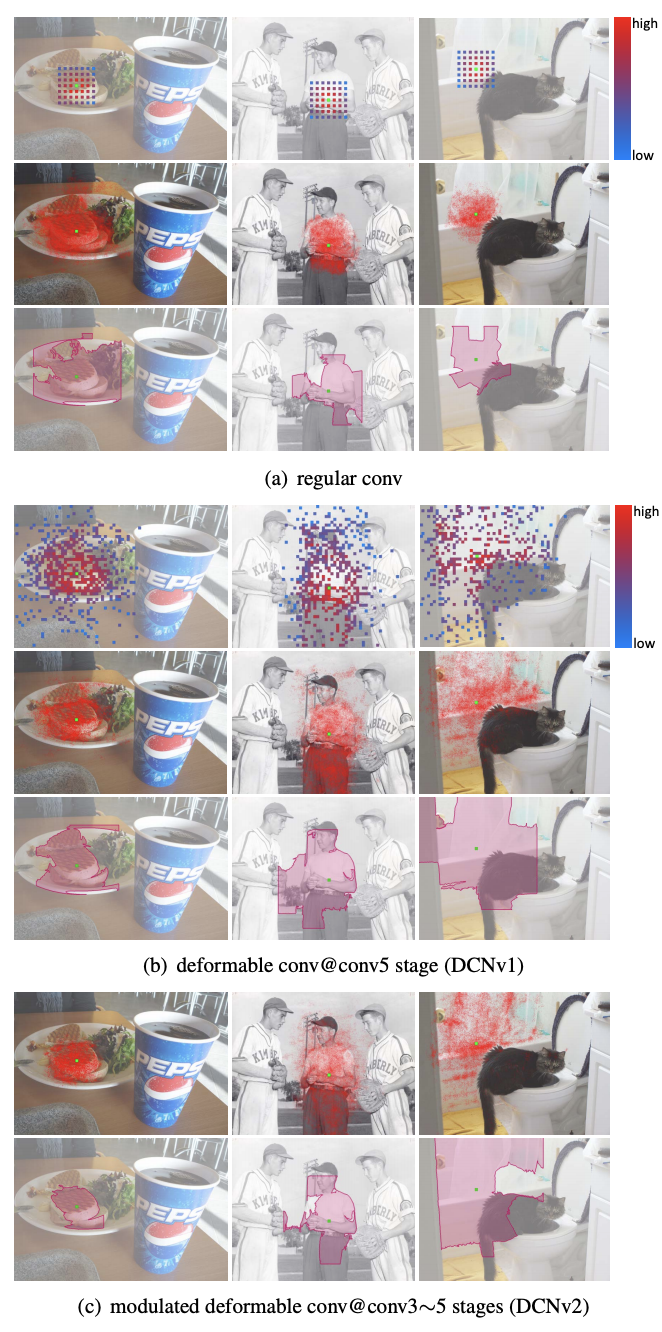

实例效果¶

图4 regular、DCN v1、DCN v2的感受野对比

图5 regular、DCN v1、DCN v2的准确率对比

多层感知机

多层感知机(Multilayer Perceptron,MLP)是一种前馈人工神经网络模型。

一、结构组成

- 输入层:接收输入数据,输入层的神经元数量通常与输入数据的特征数量相对应。例如,如果输入的是一幅图像,输入层的神经元数量可以是图像的像素数量或者经过特征提取后的特征向量的维度。

- 隐藏层:位于输入层和输出层之间,可以有一个或多个隐藏层。每个隐藏层由多个神经元组成,这些神经元通过权重与上一层的神经元连接。隐藏层的作用是对输入数据进行非线性变换,提取更高级别的特征。

- 输出层:产生最终的输出结果,输出层的神经元数量通常与任务的输出维度相对应。例如,在分类任务中,输出层的神经元数量可以是类别数量;在回归任务中,输出层通常只有一个神经元,输出一个连续的值。

二、工作原理

信号传播:

- 前向传播:数据从输入层进入网络,通过各层之间的连接权重进行加权求和,然后经过激活函数的非线性变换,传递到下一层。这个过程在每个隐藏层和输出层中重复,直到得到最终的输出结果。

- 反向传播:在训练过程中,根据输出结果与真实标签之间的误差,通过反向传播算法调整网络中的连接权重。反向传播算法从输出层开始,计算每个神经元的误差梯度,并将误差梯度反向传播到上一层,依次调整各层的连接权重,以减小误差。

激活函数:

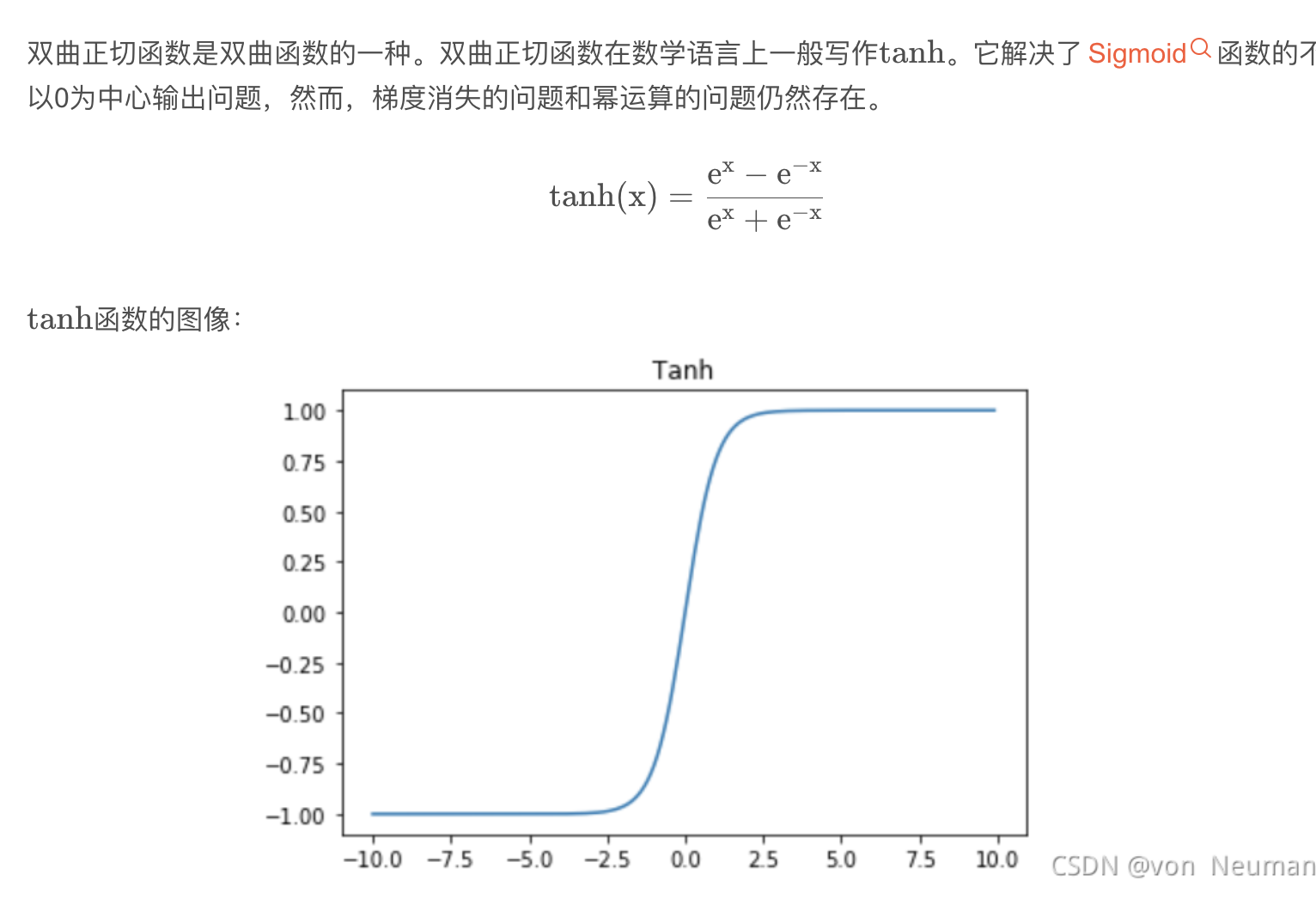

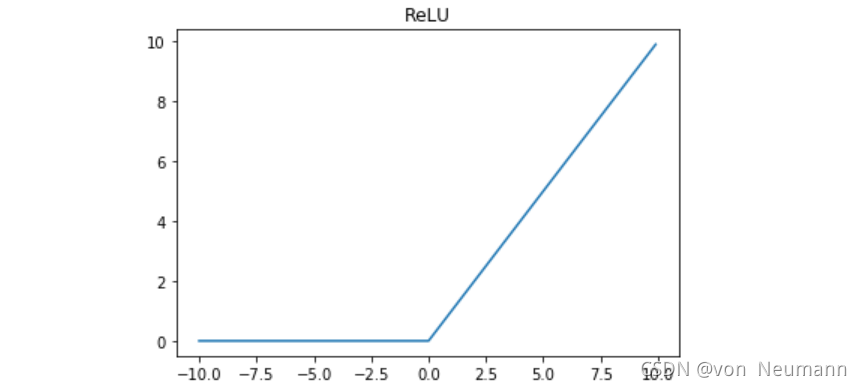

- 作用:在每个神经元中,加权求和的结果经过激活函数进行非线性变换。激活函数的作用是引入非线性因素,使网络能够学习和表示复杂的函数关系。常见的激活函数有 Sigmoid 函数、ReLU 函数、Tanh 函数等。

- 不同激活函数的特点:

- Sigmoid 函数:将输入值压缩到 0 到 1 之间,具有平滑的曲线,在早期的神经网络中广泛使用。但在输入值较大或较小时,函数的梯度趋近于零,容易导致梯度消失问题。

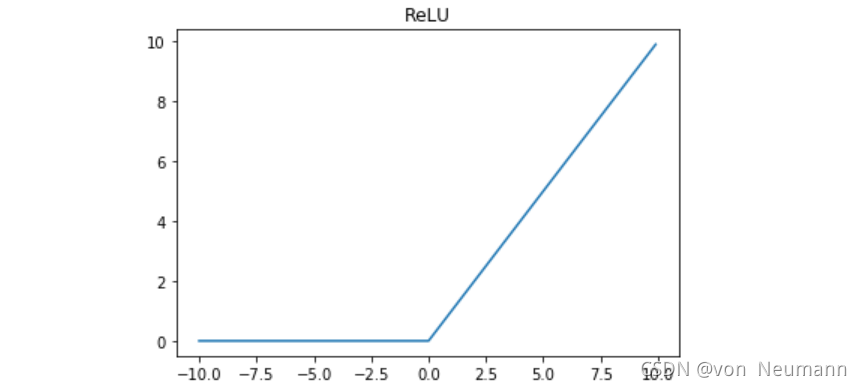

- ReLU 函数:对于正输入值,输出等于输入;对于负输入值,输出为零。ReLU 函数计算简单,能够有效地缓解梯度消失问题,并且在训练过程中收敛速度较快。

- Tanh 函数:将输入值压缩到 -1 到 1 之间,具有类似 Sigmoid 函数的形状,但在输入值较大或较小时,梯度变化比 Sigmoid 函数更平缓,一定程度上缓解了梯度消失问题。

三、应用领域

- 分类任务:MLP 可以用于图像分类、文本分类、语音识别等领域。通过学习输入数据的特征表示,MLP 能够将输入数据划分到不同的类别中。

- 回归任务:在预测连续值的任务中,如房价预测、股票价格预测等,MLP 可以通过学习输入数据与输出值之间的函数关系,进行回归分析。

- 模式识别:MLP 可以识别和提取输入数据中的模式和特征,例如在手写数字识别、人脸识别等任务中,MLP 能够学习到数字或人脸的特征表示,实现准确的识别。

总之,多层感知机是一种强大的人工神经网络模型,通过多个神经元组成的层次结构和非线性激活函数,能够学习和表示复杂的函数关系,在各种机器学习任务中得到了广泛的应用。

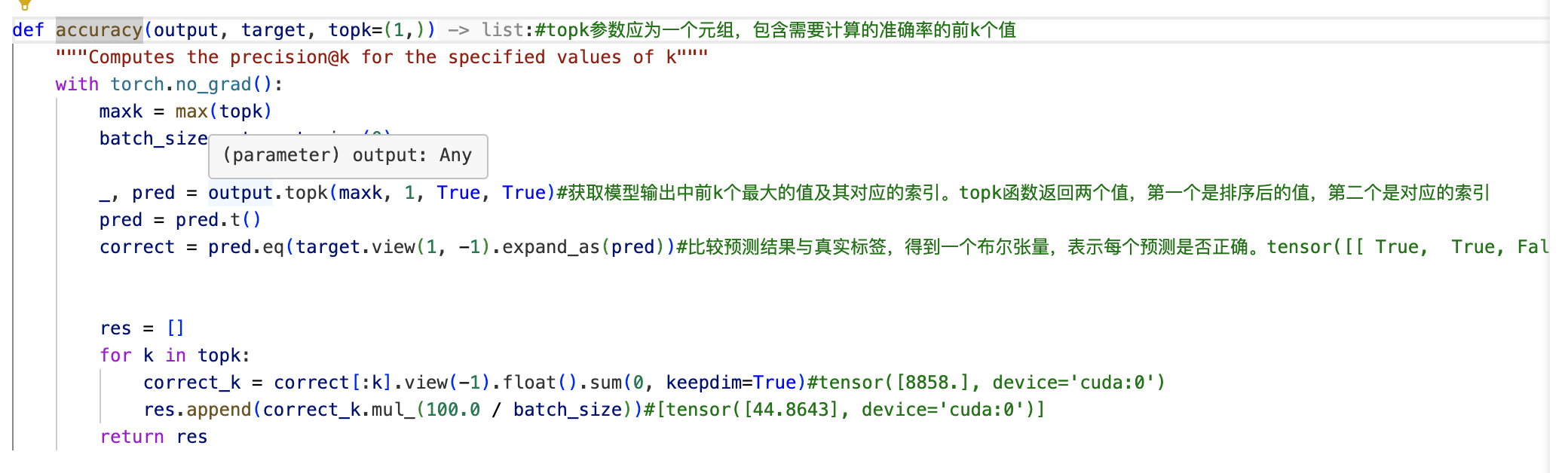

分类问题所使用的指标

准确率

简单来说就是计算一个批次数据中 true 的数量占总的数量

混淆矩阵的定义

对于二分类问题,混淆矩阵是一个2x2的矩阵,如下所示:

预测为正类 预测为负类实际为正类 TP FN 实际为负类 FP TN

- TP(True Positive):被正确预测为正类的样本数。

- FN(False Negative):被错误预测为负类的正类样本数。

- FP(False Positive):被错误预测为正类的负类样本数。

- TN(True Negative):被正确预测为负类的样本数。

对于多分类问题,混淆矩阵是一个nxn的矩阵,其中n是类别的数量。

混淆矩阵的示例

假设有一个二分类问题,模型预测的结果如下:

实际为正类的样本有100个,其中被正确预测为正类的有80个,被错误预测为负类的有20个。

实际为负类的样本有200个,其中被错误预测为正类的有30个,被正确预测为负类的有170个。

预测为正类 预测为负类 实际为正类 80 20 实际为负类 30 170

对于多分类问题,混淆矩阵是一个nxn的矩阵,其中n是类别的数量。矩阵的行表示实际类别,列表示预测类别。例如,对于一个三分类问题,混淆矩阵可能如下所示:

1 | 预测为类别1 预测为类别2 预测为类别3 |

- TP1、TP2、TP3分别表示被正确预测为类别1、类别2、类别3的样本数。

- FP12、FP13、FP21、FP23、FP31、FP32分别表示被错误预测为类别1、类别2、类别3的样本数。

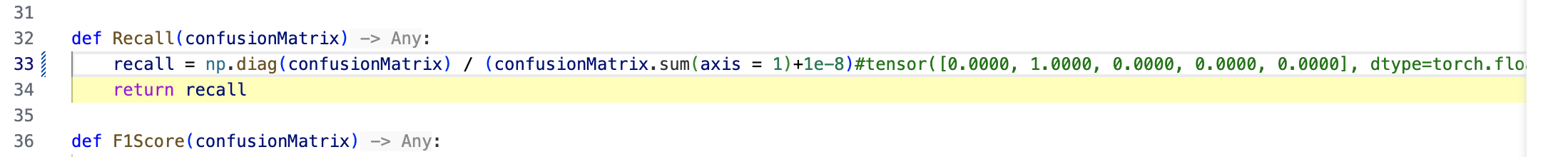

召回率

输入为混淆矩阵

召回率是分类问题中衡量模型性能的一个重要指标,它表示被正确分类为正例的样本占所有实际正例样本的比例。

混淆矩阵是一个二维数组,用于描述分类模型在测试集上的表现。矩阵的行表示实际类别,列表示预测类别。例如,如果混淆矩阵是

1 | [[TP, FN], |

其中,TP(True Positive)表示被正确分类为正例的样本数,FN(False Negative)表示被错误分类为负例的正例样本数,FP(False Positive)表示被错误分类为正例的负例样本数,TN(True Negative)表示被正确分类为负例的样本数。

计算召回率

:函数首先计算混淆矩阵对角线上的元素(即TP和TN)占每一行(即实际类别)的和的比例。这里使用了

np.diag(confusionMatrix)来获取混淆矩阵对角线上的元素,confusionMatrix.sum(axis=1)计算每一行的和。为了避免除以零的情况,代码中使用了

1e-8作为分母的一个小值。

返回结果 :函数返回一个数组,其中每个元素表示对应类别的召回率。

Recall函数主要用于评估分类模型的性能,特别是在正负样本不平衡的情况下。通过计算每个类别的召回率,可以了解模型在识别正例样本方面的表现。

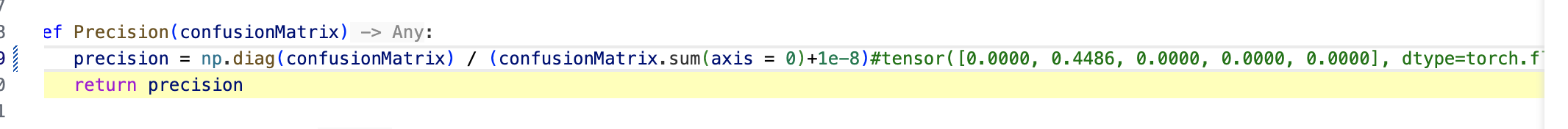

精确率

精确率是分类问题中衡量模型预测为正类(positive class)的样本中实际为正类的比例。下面是对代码的详细解释:

np.diag(confusionMatrix):提取混淆矩阵的对角线元素,这些元素表示模型正确预测为正类的样本数。confusionMatrix.sum(axis = 0):计算混淆矩阵在列方向(axis=0)上的和,即每一列的和,这些和表示模型预测为正类的样本总数。+1e-8:为了避免除以零的情况,给分母加上一个极小值。np.diag(confusionMatrix) / (confusionMatrix.sum(axis = 0)+1e-8):计算精确率,即对角线元素(正确预测为正类的样本数)除以列和(预测为正类的样本总数)。

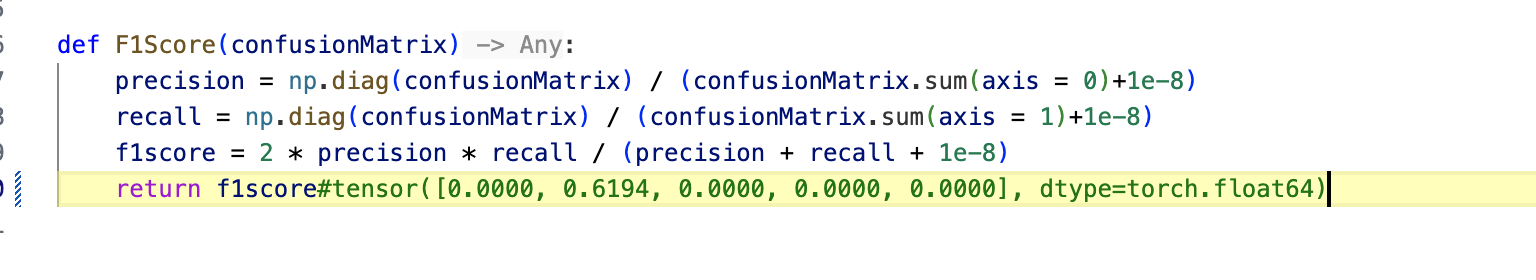

F1分数

F1分数是精确度(Precision)和召回率(Recall)的调和平均数,常用于评估分类模型的性能

F1分数的值介于0和1之间,值越大,表示模型的性能越好。

F1分数计算公式为:2 * 精确度 * 召回率 / (精确度 + 召回率)

F1分数的优点在于,它同时考虑了精确度和召回率,避免了单一指标可能带来的误导。例如,如果一个模型在正类样本上具有很高的召回率,但在负类样本上具有很低的精确度,那么这个模型可能仍然具有很高的F1分数,因为精确度和召回率的平衡点被考虑在内。

随机森林

1.什么是随机森林

1.1 Bagging思想

Bagging是bootstrap aggregating。思想就是从总体样本当中随机取一部分样本进行训练,通过多次这样的结果,进行投票获取平均值作为结果输出,这就极大可能的避免了不好的样本数据,从而提高准确度。因为有些是不好的样本,相当于噪声,模型学入噪声后会使准确度不高。

举个例子 :

假设有1000个样本,如果按照以前的思维,是直接把这1000个样本拿来训练,但现在不一样,先抽取800个样本来进行训练,假如噪声点是这800个样本以外的样本点,就很有效的避开了。重复以上操作,提高模型输出的平均值。

1.2 随机森林

Random Forest(随机森林)是一种基于树模型的Bagging的优化版本,一棵树的生成肯定还是不如多棵树,因此就有了随机森林,解决决策树泛化能力弱的特点。(可以理解成三个臭皮匠顶过诸葛亮)

而同一批数据,用同样的算法只能产生一棵树,这时Bagging策略可以帮助我们产生不同的数据集。Bagging策略来源于bootstrap aggregation:从样本集(假设样本集N个数据点)中重采样选出\(N_b\)个样本(有放回的采样,样本数据点个数仍然不变为N),在所有样本上,对这n个样本建立分类器(ID3),重复以上两步m次,获得m个分类器,最后根据这m个分类器的投票结果,决定数据属于哪一类。

.

每棵树的按照如下规则生成:

- 如果训练集大小为N,对于每棵树而言,随机且有放回地从训练集中的抽取N个训练样本,作为该树的训练集;

- 如果每个样本的特征维度为M,指定一个常数m<<M,随机地从M个特征中选取m个特征子集,每次树进行分裂时,从这m个特征中选择最优的;

- 每棵树都尽最大程度的生长,并且没有剪枝过程。

一开始我们提到的随机森林中的“随机”就是指的这里的两个随机性。两个随机性的引入对随机森林的分类性能至关重要。由于它们的引入,使得随机森林不容易陷入过拟合,并且具有很好得抗噪能力(比如:对缺省值不敏感)。

总的来说就是随机选择样本数,随机选取特征,随机选择分类器,建立多颗这样的决策树,然后通过这几课决策树来投票,决定数据属于哪一类( 投票机制有一票否决制、少数服从多数、加权多数 )

2. 随机森林分类效果的影响因素

- 森林中任意两棵树的相关性:相关性越大,错误率越大;

- 森林中每棵树的分类能力:每棵树的分类能力越强,整个森林的错误率越低。

减小特征选择个数m,树的相关性和分类能力也会相应的降低;增大m,两者也会随之增大。所以关键问题是如何选择最优的m(或者是范围),这也是随机森林唯一的一个参数。

.

随机森林有什么优缺点

优点:

- 在当前的很多数据集上,相对其他算法有着很大的优势,表现良好。

- 它能够处理很高维度(feature很多)的数据,并且不用做特征选择(因为特征子集是随机选择的)。

- 在训练完后,它能够给出哪些feature比较重要。

- 训练速度快,容易做成并行化方法(训练时树与树之间是相互独立的)。

- 在训练过程中,能够检测到feature间的互相影响。

- 对于不平衡的数据集来说,它可以平衡误差。

- 如果有很大一部分的特征遗失,仍可以维持准确度。

缺点:

- 随机森林已经被证明在某些噪音较大的分类或回归问题上会过拟合。

- 对于有不同取值的属性的数据,取值划分较多的属性会对随机森林产生更大的影响,所以随机森林在这种数据上产出的属性权值是不可信的。

4. 随机森林如何处理缺失值?

根据随机森林创建和训练的特点,随机森林对缺失值的处理还是比较特殊的。

- 首先,给缺失值预设一些估计值,比如数值型特征,选择其余数据的中位数或众数作为当前的估计值

- 然后,根据估计的数值,建立随机森林,把所有的数据放进随机森林里面跑一遍。记录每一组数据在决策树中一步一步分类的路径.

- 判断哪组数据和缺失数据路径最相似,引入一个相似度矩阵,来记录数据之间的相似度,比如有N组数据,相似度矩阵大小就是N*N

- 如果缺失值是类别变量,通过权重投票得到新估计值,如果是数值型变量,通过加权平均得到新的估计值,如此迭代,直到得到稳定的估计值。

其实,该缺失值填补过程类似于推荐系统中采用协同过滤进行评分预测,先计算缺失特征与其他特征的相似度,再加权得到缺失值的估计,而随机森林中计算相似度的方法(数据在决策树中一步一步分类的路径)乃其独特之处。

5. 什么是OOB?随机森林中OOB是如何计算的,它有什么优缺点?

OOB :

上面我们提到,构建随机森林的关键问题就是如何选择最优的m,要解决这个问题主要依据计算袋外错误率oob error(out-of-bag error)。

bagging方法中Bootstrap每次约有1/3的样本不会出现在Bootstrap所采集的样本集合中,当然也就没有参加决策树的建立,把这1/3的数据称为 袋外数据oob(out of bag) ,它可以用于取代测试集误差估计方法。

袋外数据(oob)误差的计算方法如下:

- 对于已经生成的随机森林,用袋外数据测试其性能,假设袋外数据总数为O,用这O个袋外数据作为输入,带进之前已经生成的随机森林分类器,分类器会给出O个数据相应的分类

- 因为这O条数据的类型是已知的,则用正确的分类与随机森林分类器的结果进行比较,统计随机森林分类器分类错误的数目,设为X,则袋外数据误差大小=X/O

优缺点 :

这已经经过证明是无偏估计的,所以在随机森林算法中不需要再进行交叉验证或者单独的测试集来获取测试集误差的无偏估计。

6. 随机森林的过拟合问题

- 你已经建了一个有10000棵树的随机森林模型。在得到0.00的训练误差后,你非常高兴。但是,验证错误是34.23。到底是怎么回事?你还没有训练好你的模型吗? 答:该模型过度拟合,因此,为了避免这些情况,我们要用交叉验证来调整树的数量。

7. 代码实现

0.import工具库

In [1]:

1 | import pandas as pd |

1.加载数据

In [2]:

1 | boston_house = load_boston() |

In [3]:

1 | boston_feature_name = boston_house.feature_names |

In [4]:

1 | boston_feature_name |

Out[4]:

1 | array(['CRIM', 'ZN', 'INDUS', 'CHAS', 'NOX', 'RM', 'AGE', 'DIS', 'RAD', |

构建模型

1 | help(RandomForestRegressor) |

1 | Help on class RandomForestRegressor in module sklearn.ensemble.forest: |

1 | rgs = RandomForestRegressor(n_estimators=15) ##随机森林模型 |

In [10]:

1 | rgs |

Out[10]:

1 | RandomForestRegressor(bootstrap=True, criterion='mse', max_depth=None, |

In [11]:

1 | rgs.predict(boston_features) |

Out[11]:

1 | array([ 26.16666667, 22.24 , 33.76666667, 33.67333333, |

1 | from sklearn import tree |

In [13]:

1 | rgs2 = tree.DecisionTreeRegressor() ##决策树模型,比较两个模型的预测结果! |

Out[13]:

1 | DecisionTreeRegressor(criterion='mse', max_depth=None, max_features=None, |

In [14]:

1 | rgs2.predict(boston_features) |

Out[14]:

1 | array([ 24. , 21.6, 34.7, 33.4, 36.2, 28.7, 22.9, 27.1, 16.5, |

GBDT(Gradient Boosting Decision Tree),全名叫梯度提升决策树

GBDT(Gradient Boosting Decision Tree),全名叫梯度提升决策树,使用的是Boosting的思想。

1. 解释一下GBDT算法的过程

GBDT(Gradient Boosting Decision Tree),全名叫梯度提升决策树,使用的是Boosting的思想。

1.1 Boosting思想

Boosting方法训练基分类器时采用串行的方式,各个基分类器之间有依赖。它的基本思路是将基分类器层层叠加,每一层在训练的时候,对前一层基分类器分错的样本,给予更高的权重。测试时,根据各层分类器的结果的加权得到最终结果。

Bagging与Boosting的串行训练方式不同,Bagging方法在训练过程中,各基分类器之间无强依赖,可以进行并行训练

1.2 GBDT原来是这么回事

GBDT的原理很简单,就是所有弱分类器的结果相加等于预测值,然后下一个弱分类器去拟合误差函数对预测值的残差(这个残差就是预测值与真实值之间的误差)。当然了,它里面的弱分类器的表现形式就是各棵树。

举一个非常简单的例子,比如我今年30岁了,但计算机或者模型GBDT并不知道我今年多少岁,那GBDT咋办呢?

- 它会在第一个弱分类器(或第一棵树中)随便用一个年龄比如20岁来拟合,然后发现误差有10岁;

- 接下来在第二棵树中,用6岁去拟合剩下的损失,发现差距还有4岁;

- 接着在第三棵树中用3岁拟合剩下的差距,发现差距只有1岁了;

- 最后在第四课树中用1岁拟合剩下的残差,完美。

- 最终,四棵树的结论加起来,就是真实年龄30岁(实际工程中,gbdt是计算负梯度,用负梯度近似残差)。

为何gbdt可以用用负梯度近似残差呢?

回归任务下,GBDT 在每一轮的迭代时对每个样本都会有一个预测值,此时的损失函数为均方差损失函数,

那此时的负梯度是这样计算的

所以,当损失函数选用均方损失函数是时,每一次拟合的值就是(真实值 -

当前模型预测的值),即残差。此时的变量是,即“当前预测模型的值”,也就是对它求负梯度。

训练过程

简单起见,假定训练集只有4个人:A,B,C,D,他们的年龄分别是14,16,24,26。其中A、B分别是高一和高三学生;C,D分别是应届毕业生和工作两年的员工。如果是用一棵传统的回归决策树来训练,会得到如下图所示结果:

现在我们使用GBDT来做这件事,由于数据太少,我们限定叶子节点最多有两个,即每棵树都只有一个分枝,并且限定只学两棵树。我们会得到如下图所示结果:

在第一棵树分枝和图1一样,由于A,B年龄较为相近,C,D年龄较为相近,他们被分为左右两拨,每拨用平均年龄作为预测值。

- 此时计算残差(残差的意思就是:A的实际值 - A的预测值 = A的残差),所以A的残差就是实际值14 - 预测值15 = 残差值-1。

- 注意,A的预测值是指前面所有树累加的和,这里前面只有一棵树所以直接是15,如果还有树则需要都累加起来作为A的预测值。

然后拿它们的残差-1、1、-1、1代替A B C D的原值,到第二棵树去学习,第二棵树只有两个值1和-1,直接分成两个节点,即A和C分在左边,B和D分在右边,经过计算(比如A,实际值-1 - 预测值-1 = 残差0,比如C,实际值-1 - 预测值-1 = 0),此时所有人的残差都是0。残差值都为0,相当于第二棵树的预测值和它们的实际值相等,则只需把第二棵树的结论累加到第一棵树上就能得到真实年龄了,即每个人都得到了真实的预测值。

换句话说,现在A,B,C,D的预测值都和真实年龄一致了。Perfect!

- A: 14岁高一学生,购物较少,经常问学长问题,预测年龄A = 15 – 1 = 14

- B: 16岁高三学生,购物较少,经常被学弟问问题,预测年龄B = 15 + 1 = 16

- C: 24岁应届毕业生,购物较多,经常问师兄问题,预测年龄C = 25 – 1 = 24

- D: 26岁工作两年员工,购物较多,经常被师弟问问题,预测年龄D = 25 + 1 = 26

所以,GBDT需要将多棵树的得分累加得到最终的预测得分,且每一次迭代,都在现有树的基础上,增加一棵树去拟合前面树的预测结果与真实值之间的残差。

2. 梯度提升和梯度下降的区别和联系是什么?

下表是梯度提升算法和梯度下降算法的对比情况。可以发现,两者都是在每 一轮迭代中,利用损失函数相对于模型的负梯度方向的信息来对当前模型进行更 新,

只不过在梯度下降中,模型是以参数化形式表示,从而模型的更新等价于参 数的更新。

而在梯度提升中,模型并不需要进行参数化表示,而是直接定义在函 数空间中,从而大大扩展了可以使用的模型种类。

3. GBDT的优点和局限性有哪些?

3.1 优点

- 预测阶段的计算速度快,树与树之间可并行化计算。

- 在分布稠密的数据集上,泛化能力和表达能力都很好,这使得GBDT在Kaggle的众多竞赛中,经常名列榜首。

- 采用决策树作为弱分类器使得GBDT模型具有较好的解释性和鲁棒性,能够自动发现特征间的高阶关系。

3.2 局限性

- GBDT在高维稀疏的数据集上,表现不如支持向量机或者神经网络。

- GBDT在处理文本分类特征问题上,相对其他模型的优势不如它在处理数值特征时明显。

- 训练过程需要串行训练,只能在决策树内部采用一些局部并行的手段提高训练速度。

4. RF(随机森林)与GBDT之间的区别与联系

相同点 :

- 都是由多棵树组成,最终的结果都是由多棵树一起决定。

- RF和GBDT在使用CART树时,可以是分类树或者回归树。

不同点 :

- 组成随机森林的树可以并行生成,而GBDT是串行生成

- 随机森林的结果是多数表决表决的,而GBDT则是多棵树累加之和

- 随机森林对异常值不敏感,而GBDT对异常值比较敏感

- 随机森林是减少模型的方差,而GBDT是减少模型的偏差

- 随机森林不需要进行特征归一化。而GBDT则需要进行特征归一化

5. 代码实现

GitHub:https://github.com/NLP-LOVE/ML-NLP/blob/master/Machine%20Learning/3.2%20GBDT/GBDT_demo.ipynb

1 | import numpy as np |

获取训练数据

In [54]:

1 | train_feature = np.genfromtxt("train_feat.txt",dtype=np.float32) |

Out[54]:

| 0 | 1 | 2 | 3 | 4 | 5 | 6 | 7 | |

|---|---|---|---|---|---|---|---|---|

| 0 | 0.005988 | 0.569231 | 0.647059 | 0.951220 | -0.225434 | 0.837989 | 0.357258 | -0.003058 |

| 1 | 0.161677 | 0.743195 | 0.682353 | 0.960976 | -0.086705 | 0.780527 | 0.282945 | 0.149847 |

| 2 | 0.113772 | 0.744379 | 0.541176 | 0.990244 | -0.005780 | 0.721468 | 0.434110 | -0.318043 |

| 3 | 0.053892 | 0.608284 | 0.764706 | 0.951220 | -0.248555 | 0.821229 | 0.848604 | -0.003058 |

| 4 | 0.173653 | 0.866272 | 0.682353 | 0.951220 | 0.017341 | 0.704709 | -0.021002 | -0.195719 |

In [55]:

1 | train_label |

Out[55]:

1 | 0 320.0 |

获取测试数据

In [56]:

1 | test_feature = np.genfromtxt("test_feat.txt",dtype=np.float32) |

Out[56]:

| 0 | 1 | 2 | 3 | 4 | 5 | 6 | 7 | |

|---|---|---|---|---|---|---|---|---|

| 0 | 0.005988 | 0.569231 | 0.647059 | 0.951220 | -0.225434 | 0.837989 | 0.357258 | -0.003058 |

| 1 | 0.161677 | 0.743195 | 0.682353 | 0.960976 | -0.086705 | 0.780527 | 0.282945 | 0.149847 |

| 2 | 0.113772 | 0.744379 | 0.541176 | 0.990244 | -0.005780 | 0.721468 | 0.434110 | -0.318043 |

| 3 | 0.053892 | 0.608284 | 0.764706 | 0.951220 | -0.248555 | 0.821229 | 0.848604 | -0.003058 |

| 4 | 0.173653 | 0.866272 | 0.682353 | 0.951220 | 0.017341 | 0.704709 | -0.021002 | -0.195719 |

In [57]:

1 | test_label |

Out[57]:

1 | 0 320.0 |

GBDT模型建立

In [58]:

1 | gbdt = GradientBoostingRegressor( |

1 | pred: 320.0008173984891 label: 320.0 |

因果卷积

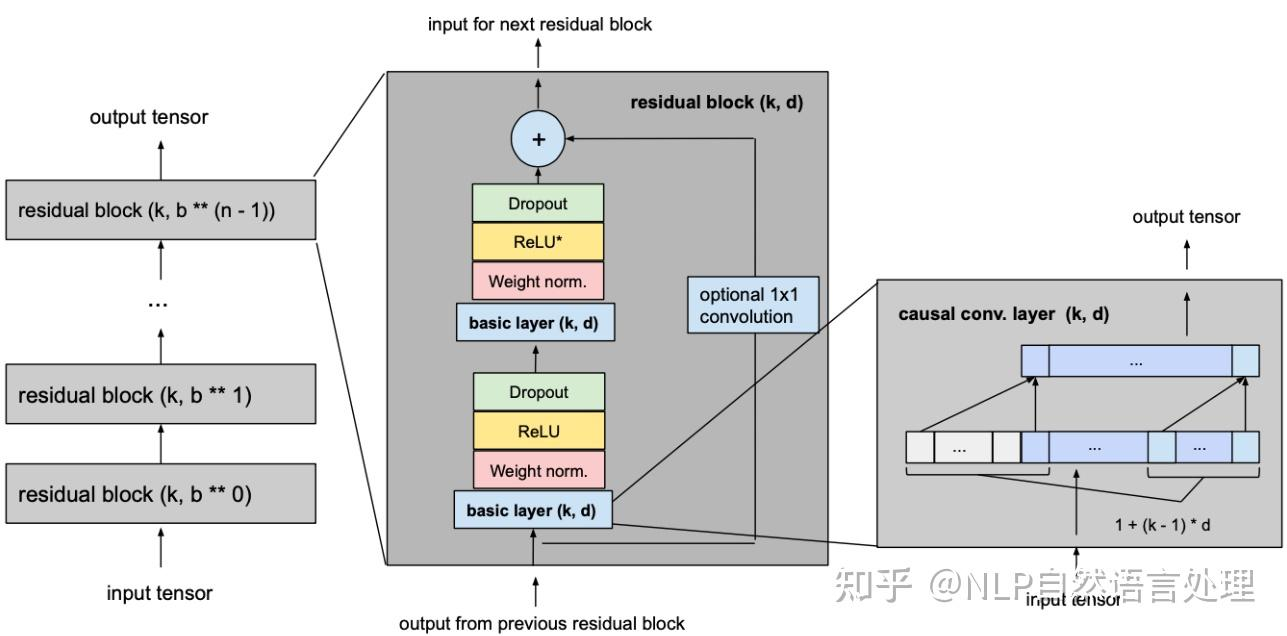

temporal convolutional network (TCN)

专为时间序列预测而设计的深度学习网络结构

参考https://zhuanlan.zhihu.com/p/422177151

动机

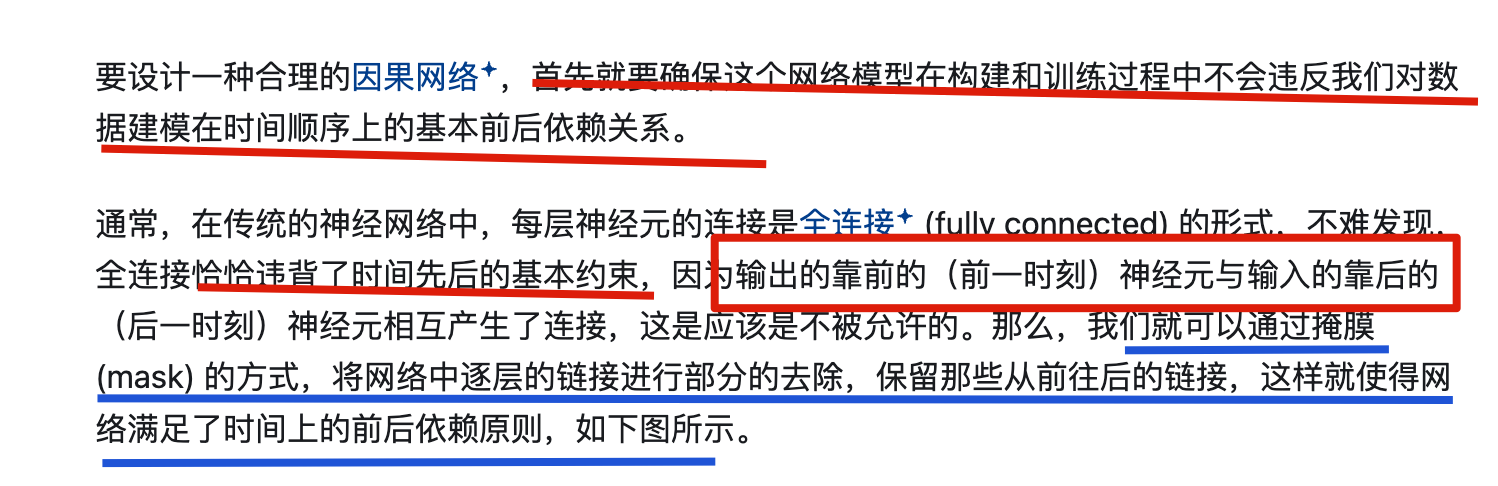

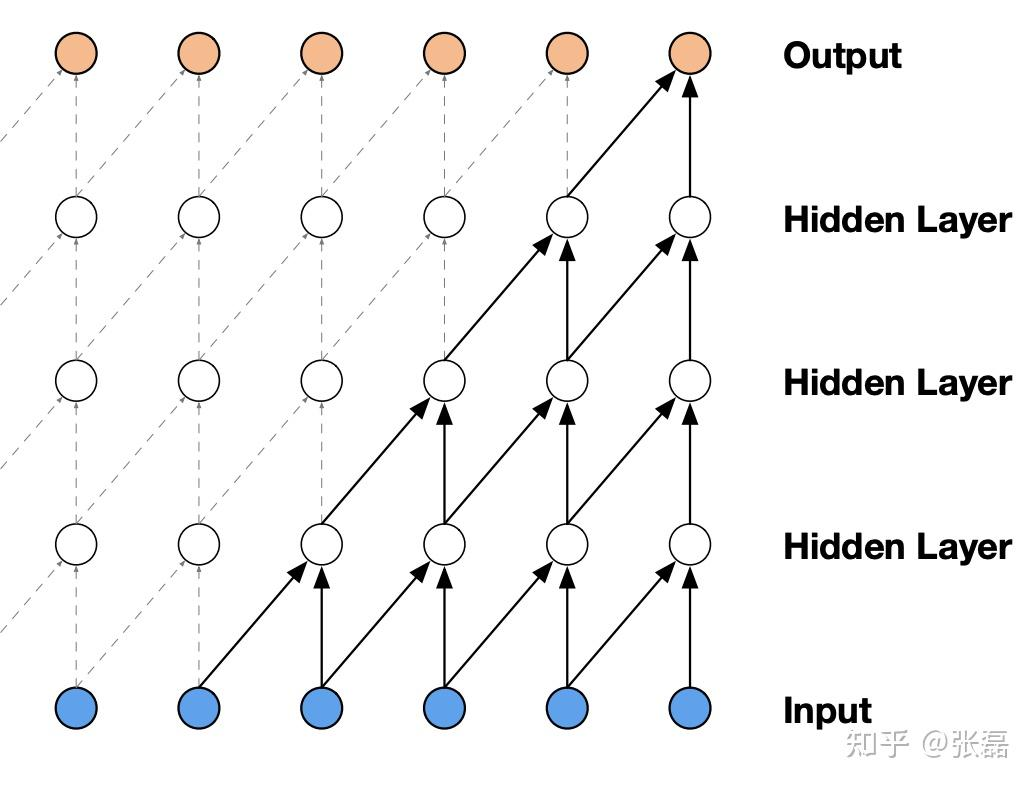

因果卷积神经网络的设计结构

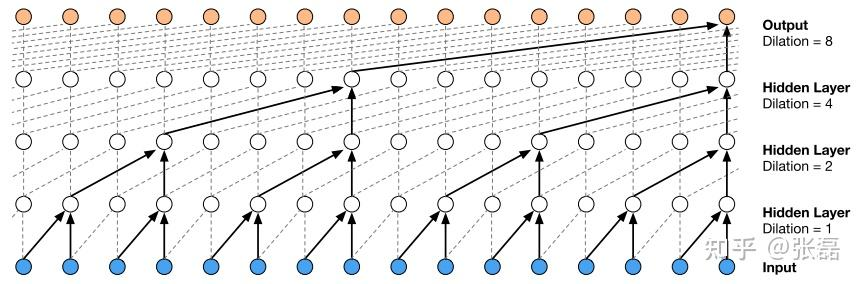

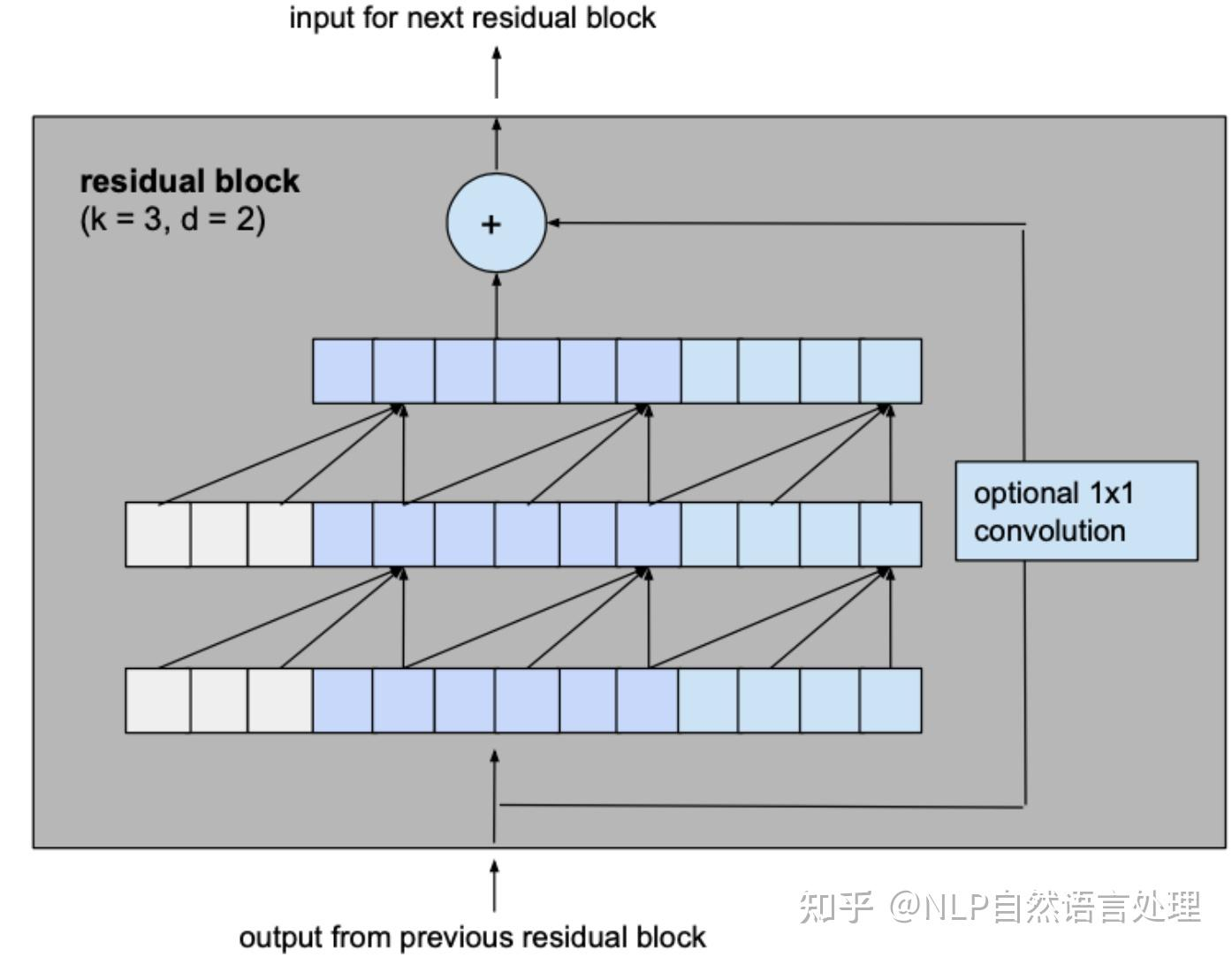

因果卷积神经网络 (causal convolutional network) 的基本结构

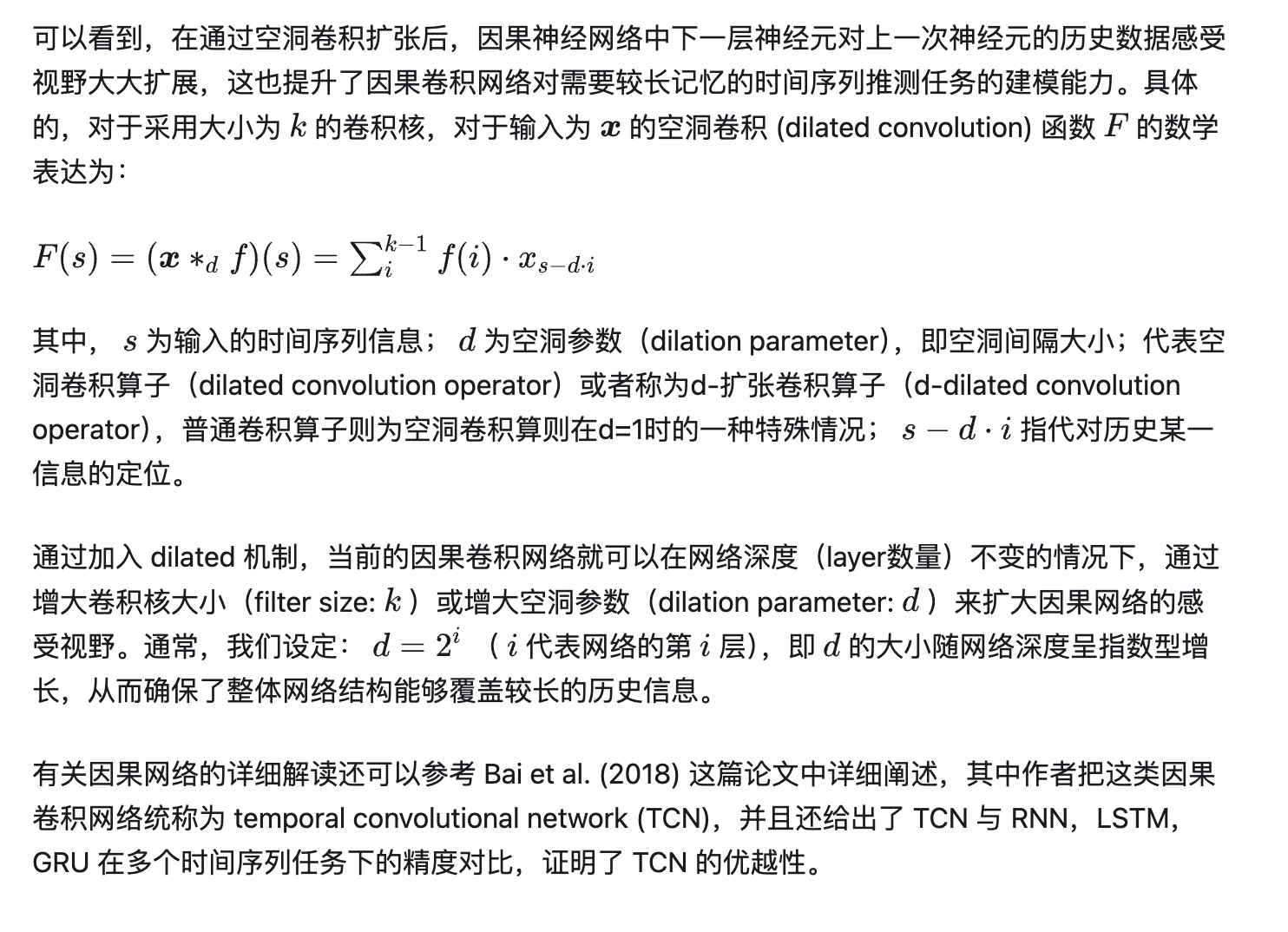

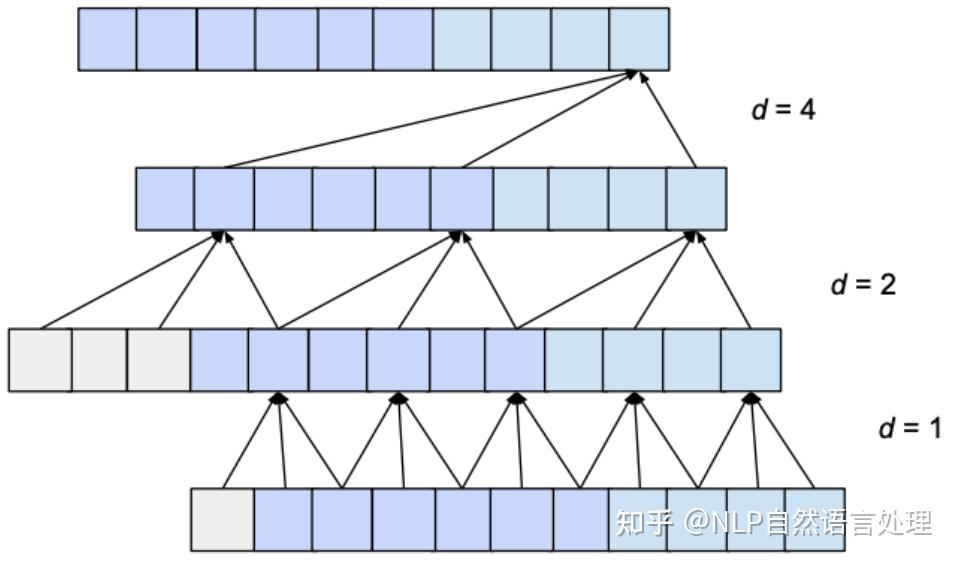

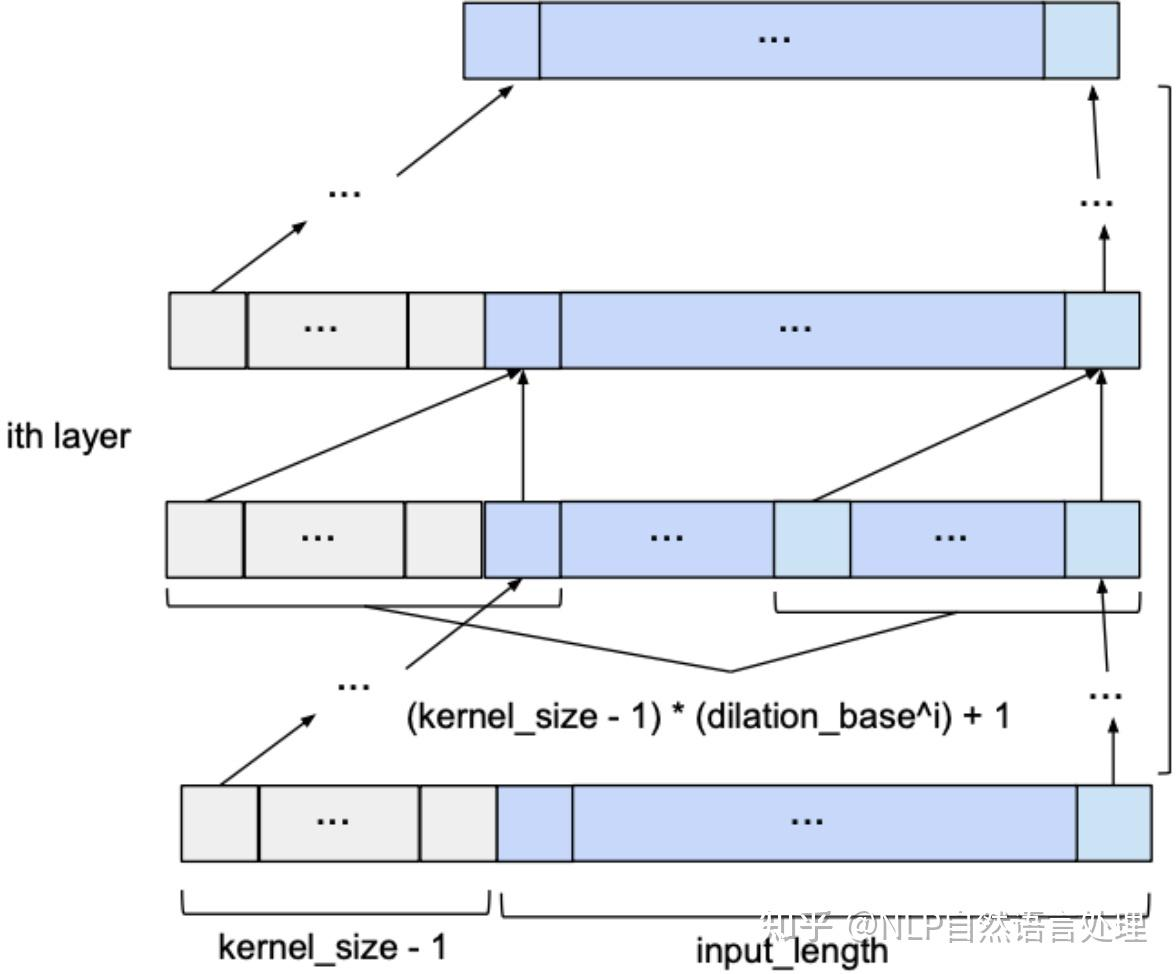

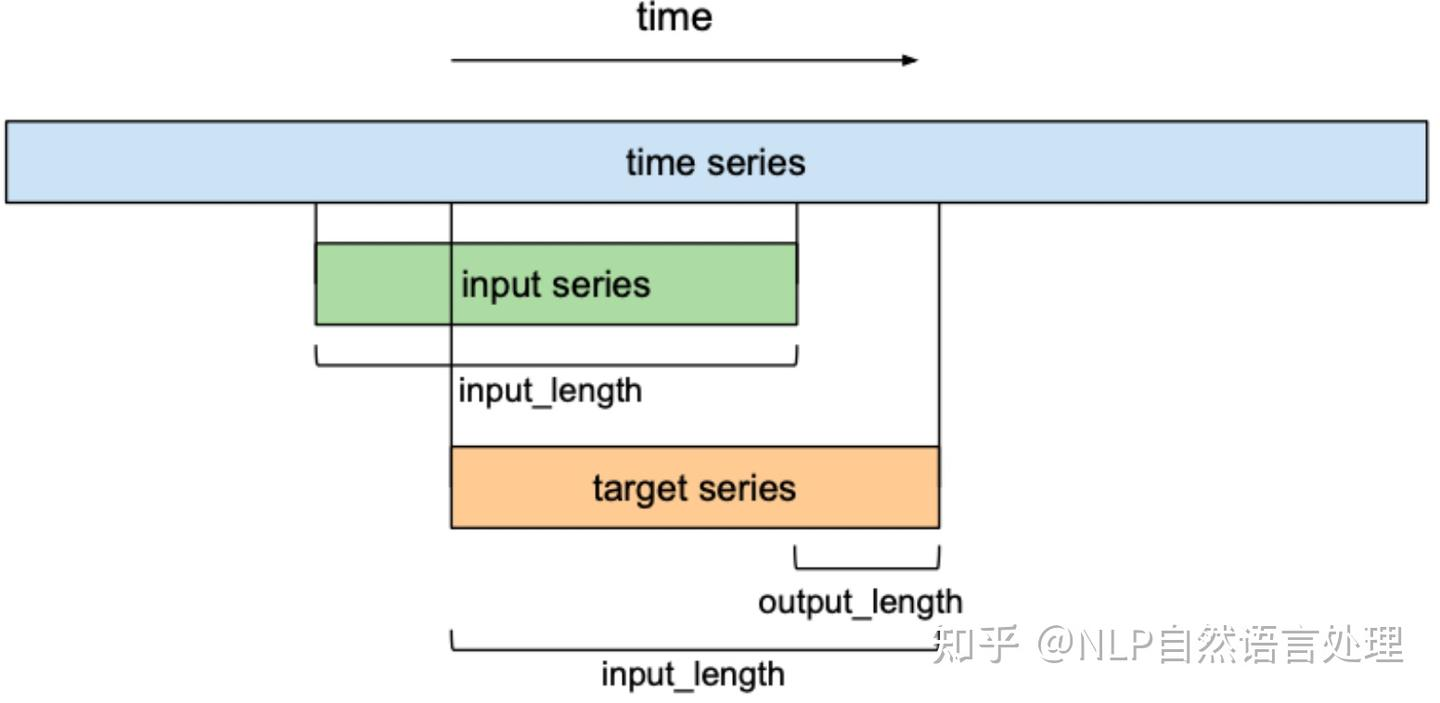

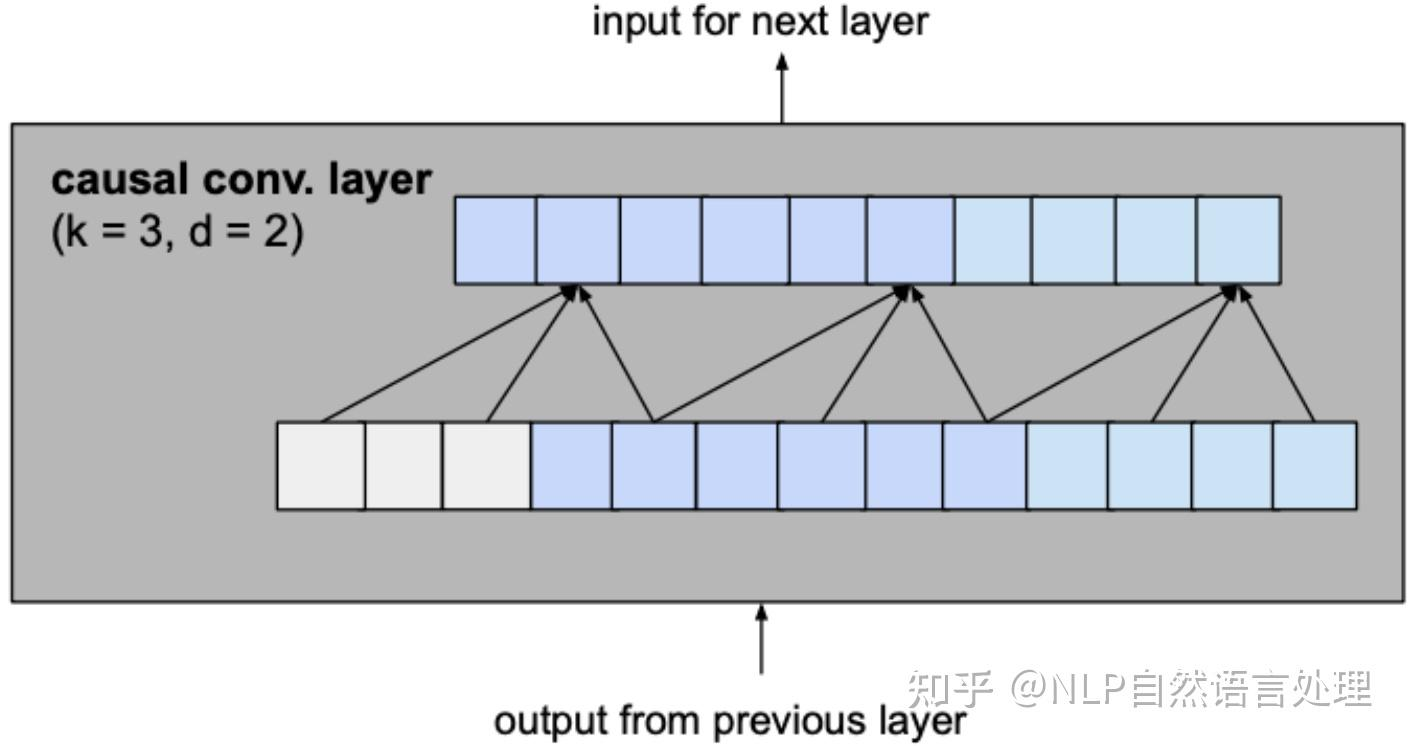

(缺陷)然而,当我们观察这样的网络结构时,也发现了一个问题:因果卷积对历史信息的覆盖范围不大,比如上面这个图中,最后的输出结果值能基于第一层输入中的5个神经元来计算,更前面的输入信息丢失浪费了。 (扩大因果卷积对历史数据的覆盖范围) 那么,怎么扩大因果卷积对历史数据的覆盖范围呢? 简单的一种思路是,我们可以不断增加网络深度,网络层数,即 layer 的数量越多,就可以逐渐扩大历史信息的捕捉视野,然而,这种方式显得有些差强人意,因为通过增加网络深度的方式只能在线性时间尺度上扩大对捕捉历史信息的捕捉,而且,随着深度的逐渐增大,网络中的参数也成倍增加,使得网络的训练难度迅速变大。 因此,这样的方式并非可取,那么有什么聪明的方法能够在网络不太深的情况下尽可能捕捉到尽可能多的信息历史呢?

为了解决这个问题,Oord et al. (2016)

提出了采用空洞卷积的方式来扩大因果卷积网络对历史信息的感受视野(reception

field)。

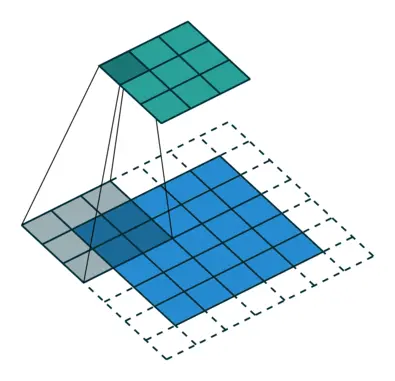

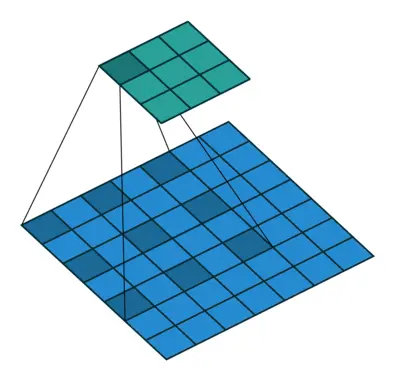

简单来说,就是在卷积核移动过程中加入了步长间隔dilation这个参数,比如在二维图像卷积中,传统的卷积是这样的:

加入空洞卷积机制后的卷积: v2-c4c54d9b304259d1597b26c07c722a79_b

上面的两个动图的例子是针对二维形式的输入数据,那么简单的对于输入数据为一维向量时,加入dilation机制后的因果卷积神经网络结构图就是这样:

代码结合上面的图看:

1 | import numpy as np |

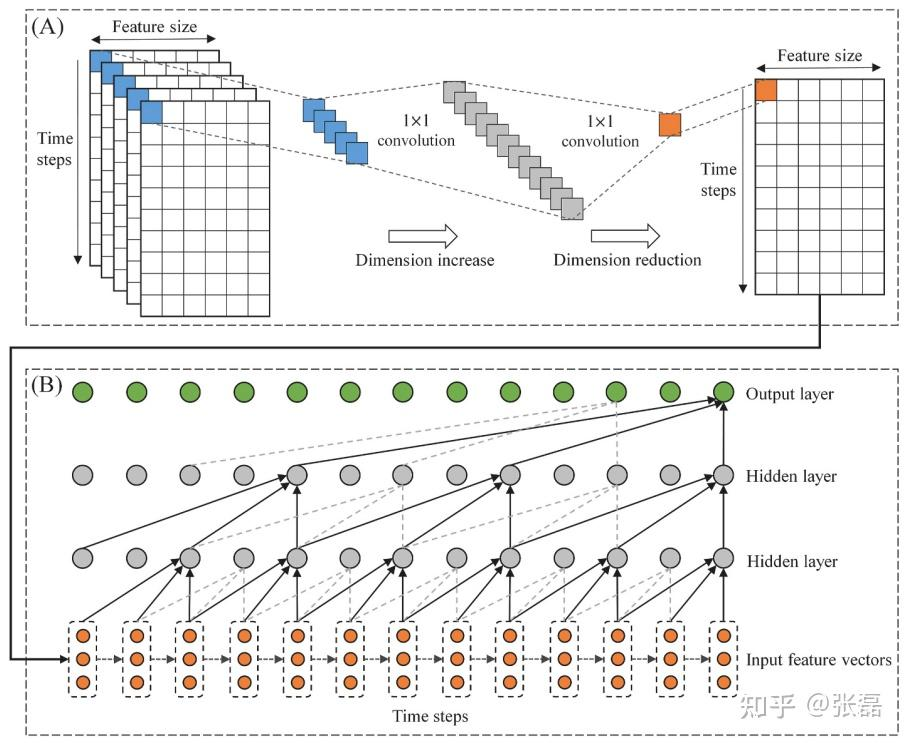

可以看到,由于空气污染PM2.5的数据是由空间上多个观测站点同时观测记录构成的,因此我们自然的想到当推测某一个站点区域内未来PM2.5浓度大小时,需要同时考虑其余站点与该目标站点之间存在的空间上的相关性,即多观测站点之间空间依赖。我们将这种空间依赖通过上图(A)部分中所示的 1 × 1 convolution 卷积算子进行处理,将多站点上对应时间和对应特征的数据值通过 1 × 1 卷积进行维度提升,再进行降维,从而将多站点的时间序列数据(3维)压缩到一个二维形式。然后在将此作为 CausalConvNet 的输入从而完成整个时空因果卷积网络的构建。

有关该研究的更多详细信息,欢迎阅读已发表在 Computers and Geosciences 上的论文:

论文信息:

Zhang, L., Na, J., Zhu, J., Shi, Z., Zou, C., Yang, L., 2021. Spatiotemporal causal convolutional network for forecasting hourly PM2.5 concentrations in Beijing, China. Computers & Geosciences 155, 104869. DOI: https://doi.org/10.1016/j.cageo.2021.104869

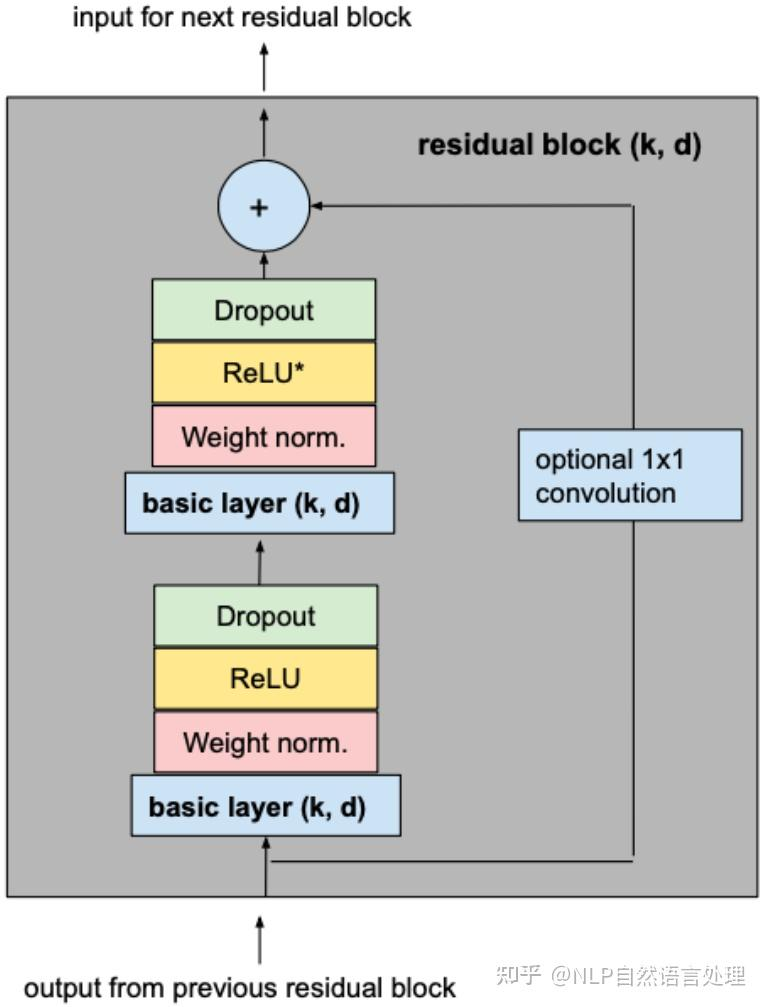

weight_norm权重归一化

注意:

weight_norm是PyTorch中的一种权重归一化方法,还有其他归一化方法如Batch Normalization等。- 根据具体任务和模型结构选择合适的归一化方法。

定义第一个卷积层,并使用weight_norm函数对卷积层的权重进行归一化。

self.conv1 = weight_norm(nn.Conv1d(n_inputs, n_outputs, kernel_size,

stride=stride, padding=padding, dilation=dilation))权重归一化(Weight Normalization)是一种在深度学习中常用的技术,主要用于加速模型的训练过程,提高模型的稳定性,并有助于防止梯度消失或爆炸。以下是一些常见的场景,在这些场景中,对权重进行归一化可能特别有用:

训练深层神经网络:

- 深层神经网络(如ResNet、VGG等)通常包含大量的权重参数,这些参数的初始化和更新对模型的训练效果有很大影响。权重归一化可以稳定这些参数的更新过程,加速收敛。

处理梯度消失或爆炸问题:

- 在深层神经网络中,梯度消失和梯度爆炸是常见的问题。权重归一化通过调整权重的大小,可以减少这些问题的出现,从而提高模型的训练稳定性。

加速训练过程:

- 权重归一化可以加速模型的训练过程。通过稳定权重参数的更新,模型可以更快地收敛到最优解。

提高模型泛化能力:

- 权重归一化有助于模型更好地泛化到新的数据集。通过减少权重参数的方差,模型可以更好地捕捉到数据的全局特征,从而提高泛化能力。

处理时间序列数据:

- 在处理时间序列数据时,一维卷积层(如 \(nn.Conv1d\))经常被使用。权重归一化可以稳定这些卷积层的权重更新,提高模型对时间序列数据的处理能力。

处理语音信号:

- 在语音信号处理任务中,一维卷积层也经常被使用。权重归一化可以稳定这些卷积层的权重更新,提高模型对语音信号的处理能力。

处理图像数据:

- 在图像处理任务中,虽然通常使用二维卷积层(如

nn.Conv2d),但权重归一化也可以应用于这些层,以提高模型的训练效率和稳定性。

- 在图像处理任务中,虽然通常使用二维卷积层(如

注意事项

计算复杂度:

- 权重归一化会增加模型的计算复杂度,因为需要额外的计算步骤来归一化权重。

参数调整:

- 权重归一化需要调整一些参数,如归一化因子等,这些参数的选择可能会影响模型的性能。

与其他正则化技术的结合:

- 权重归一化可以与其他正则化技术(如dropout、L2正则化等)结合使用,以进一步提高模型的泛化能力和训练稳定性。

总之,权重归一化是一种非常有用的技术,可以在多种场景下提高模型的训练效率和稳定性。然而,也需要根据具体任务和模型结构选择合适的归一化方法,并进行适当的参数调整。

除了

weight_norm,还有其他几种常见的权重归一化方法,包括:

https://blog.csdn.net/wxc971231/article/details/139925707

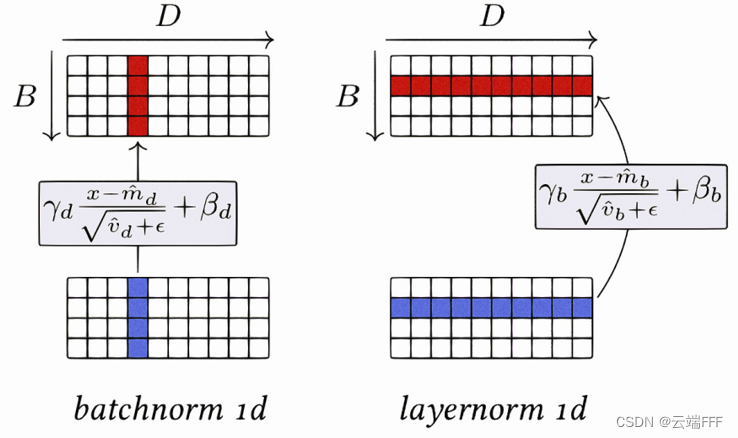

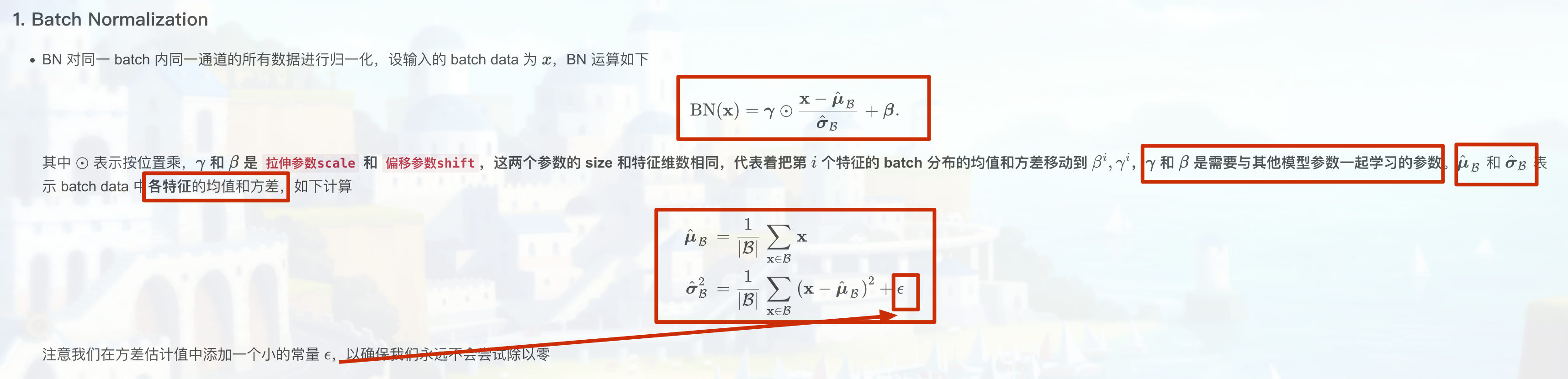

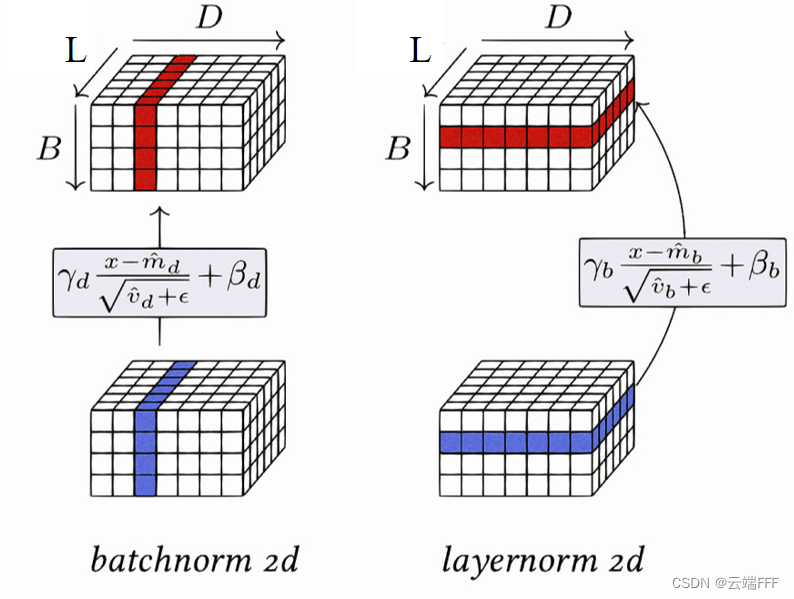

Batch Normalization(批归一化):

- Batch Normalization是一种在训练深层神经网络时常用的技术,它通过对每个小批量数据的激活值进行归一化,这消除了不同特征之间的大小关系,但是保留了不同样本间的大小关系,使得网络更容易训练。Batch Normalization不仅可以加速模型的训练过程,还可以提高模型的泛化能力。BatchNorm 适用于 CV 领域,这时输入尺寸为 b × c × h × w (批量大小x通道x长x宽),图像的每个通道 c 看作一个特征,BN 可以把各通道特征图的数量级调整到差不多,同时保持不同图片相同通道特征图间的相对大小关系

BatchNorm是一种在深度学习训练中广泛使用的归一化技术,有很多好处,包括正则化效应、减少过拟合、减少对权重初始值的依赖、允许使用更高的学习率等

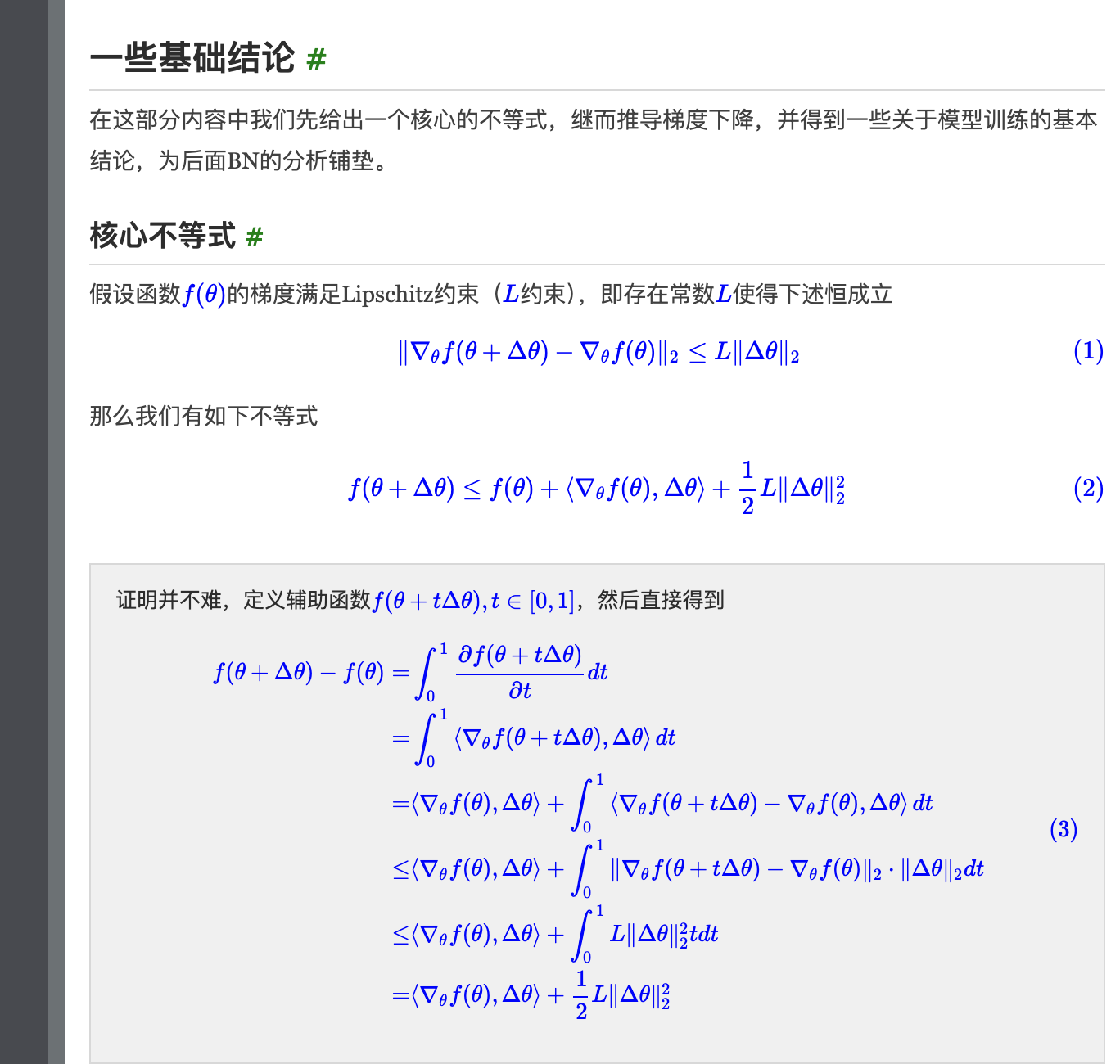

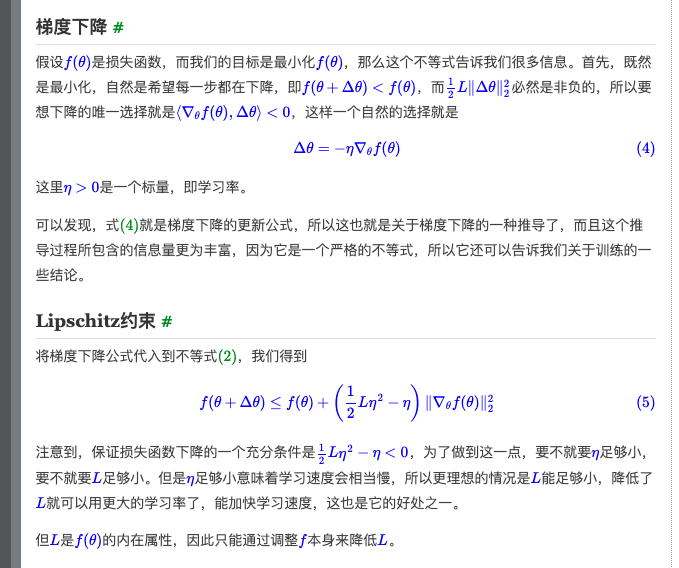

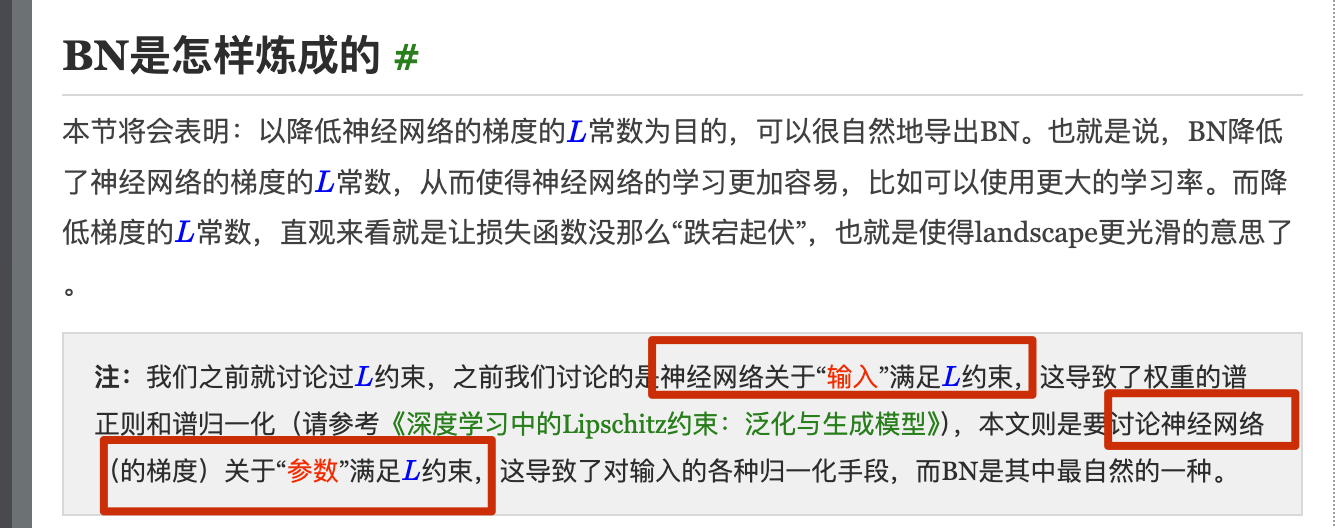

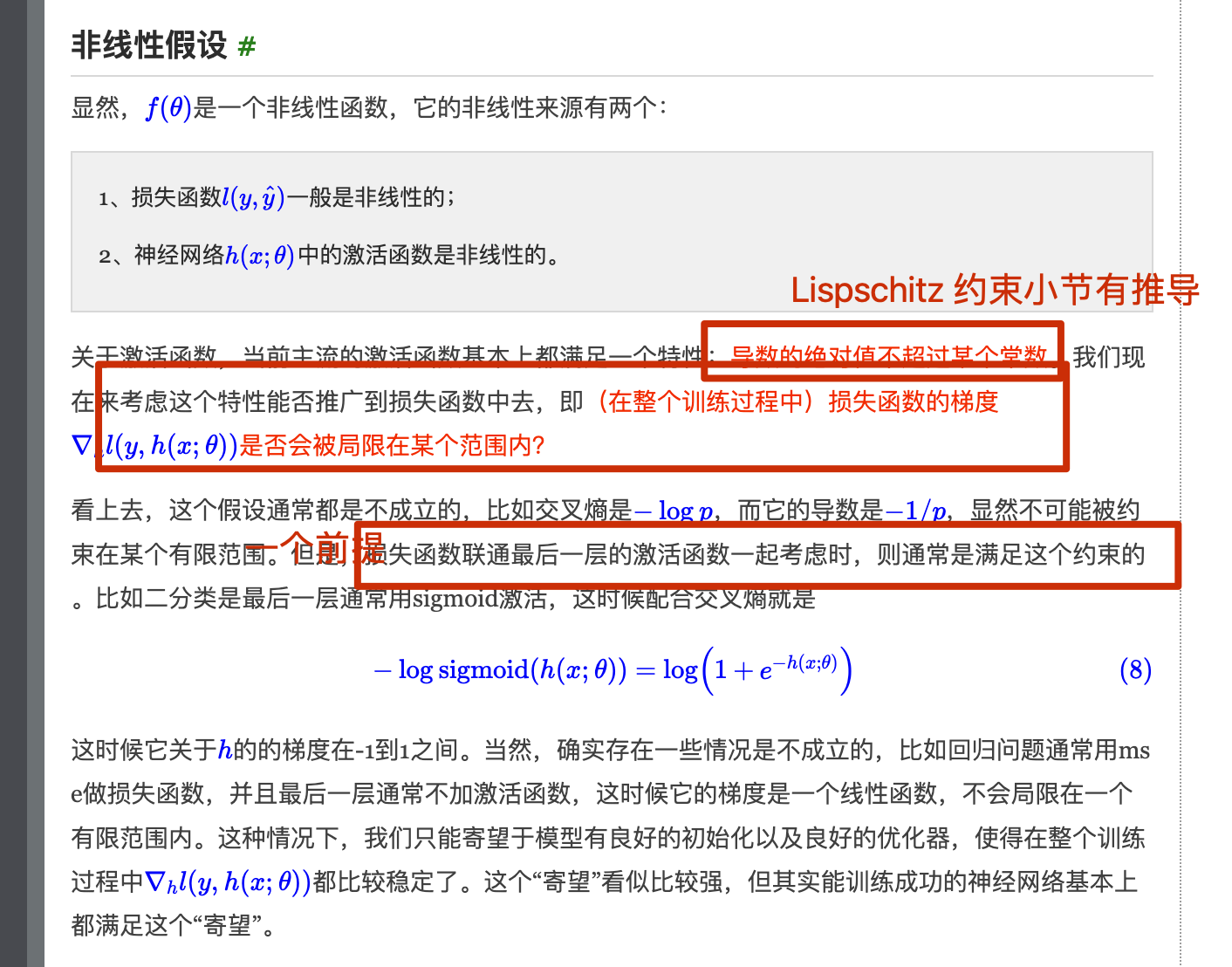

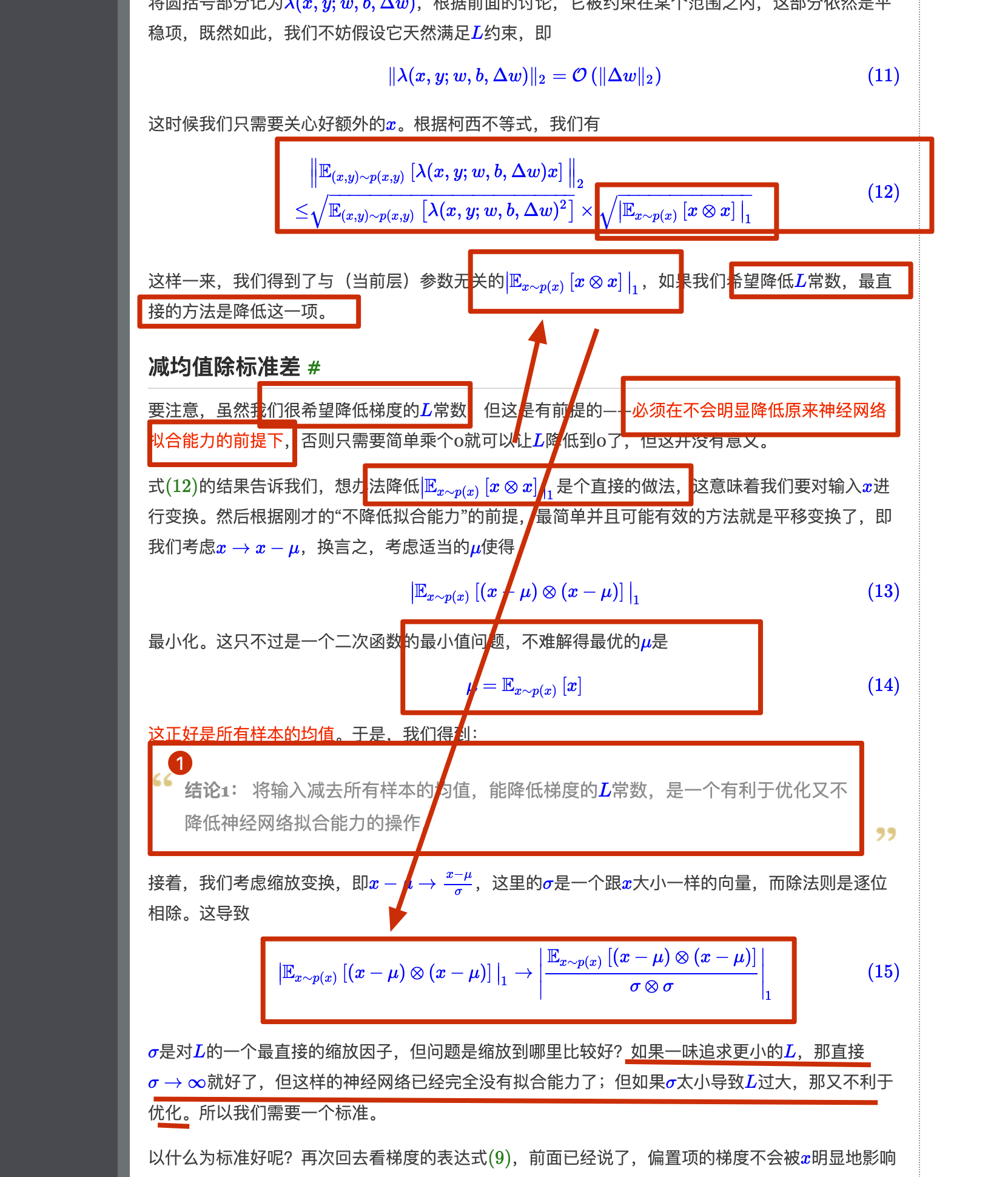

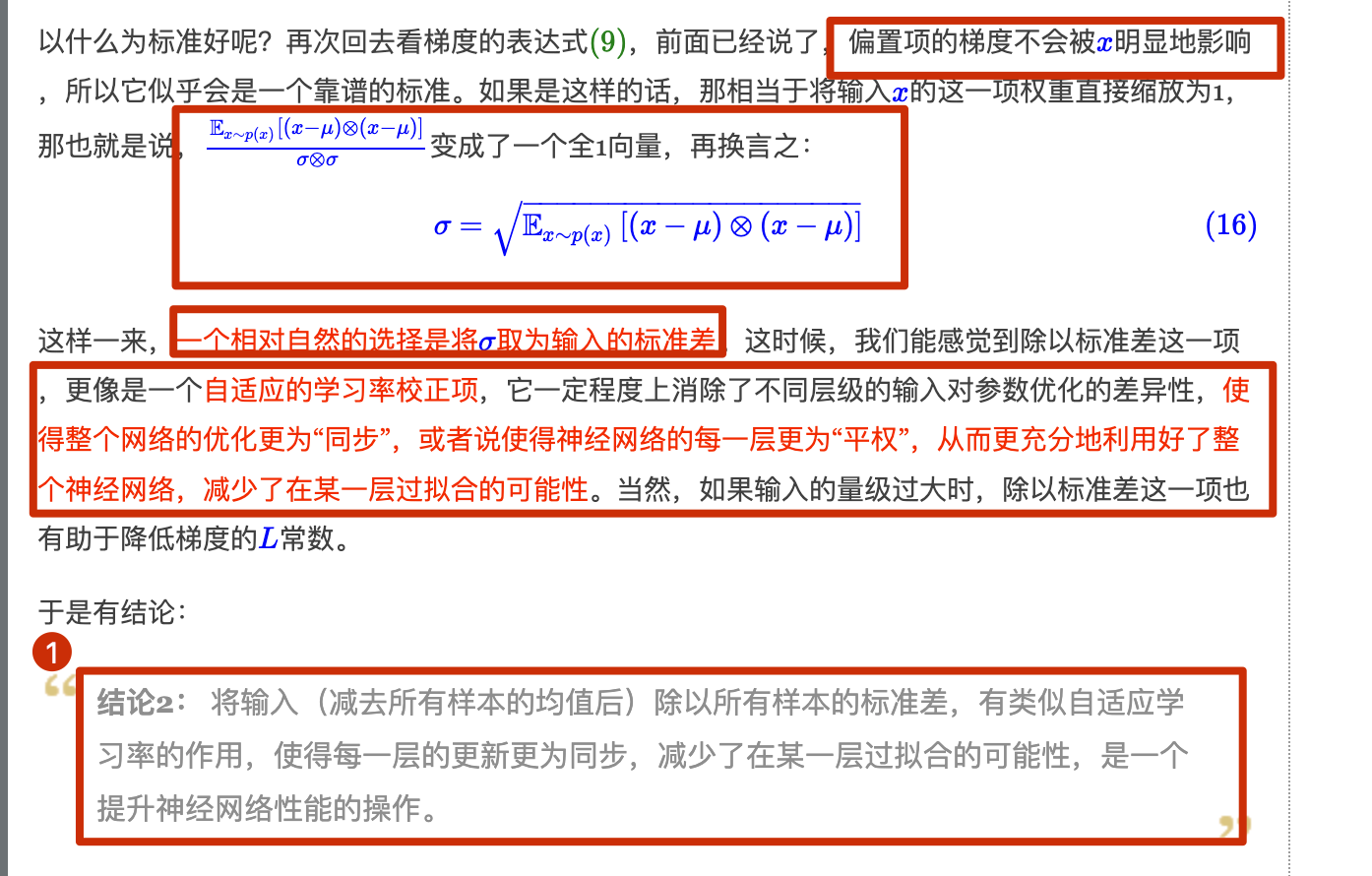

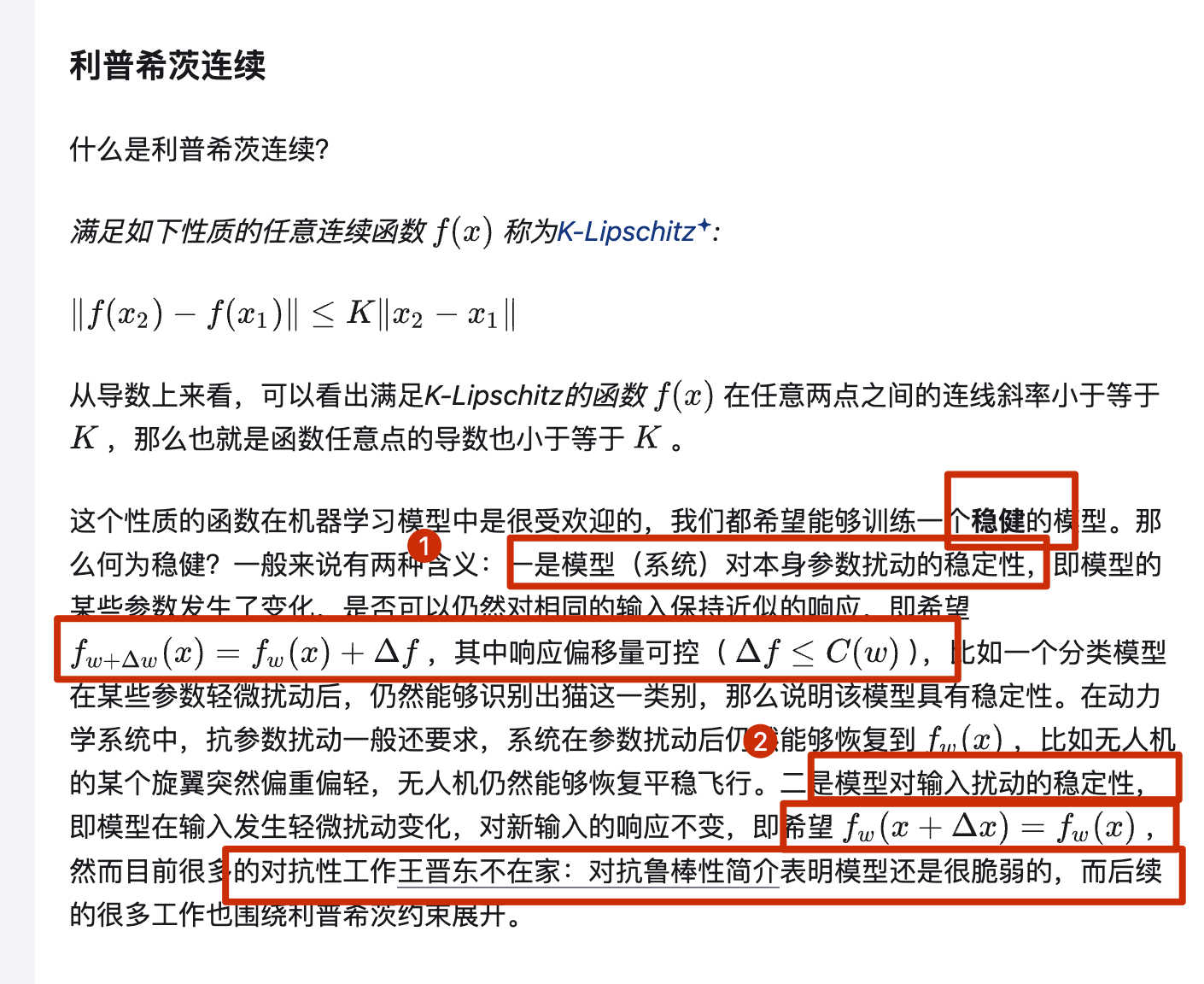

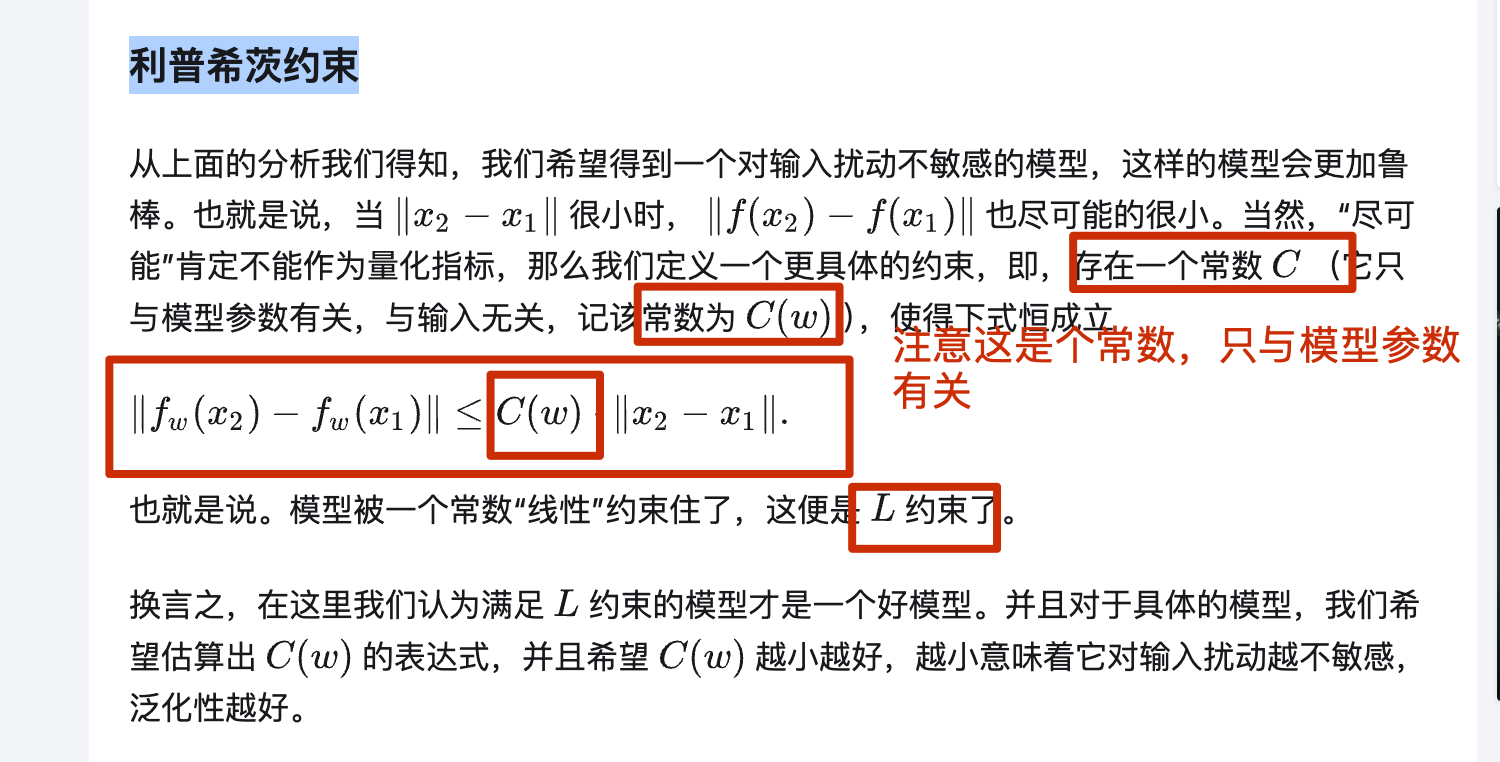

一方面,BN 使每一层隐藏值分布主动居中,并将它们重新调整为学习到的最佳均值和方差,这种操作可能将参数的量级进行了统一,因此直觉上往往被认为可以使优化更加平滑 (科学性存在争议)另一方面,BN 有效性的科学性解释一度存在争议。15 年提出BN的论文(https://papers.cool/arxiv/1502.03167)声称 BN 减小了所谓的 内部协变量偏移internal covariate shift,因此可以提高模型性能,但其分析中假设了每层隐变量值都服从某种正态分布,这个假设过强了,很多后续研究指出了其问题。18 年的论文 《How Does Batch Normalization Help Optimization?》认为 BN 的主要作用是使得整个损失函数的 landscape 更为平滑,从而使得我们可以更平稳地进行训练。相关分析可以参考苏神的博文(https://kexue.fm/archives/6992) 注意:后面其他节也有关于 Lispschitz 的一些理解补充,需要结合一起看(https://zhuanlan.zhihu.com/p/520107941):

即下面的:

即下面的:

1 | class BatchNorm(nn.Module): |

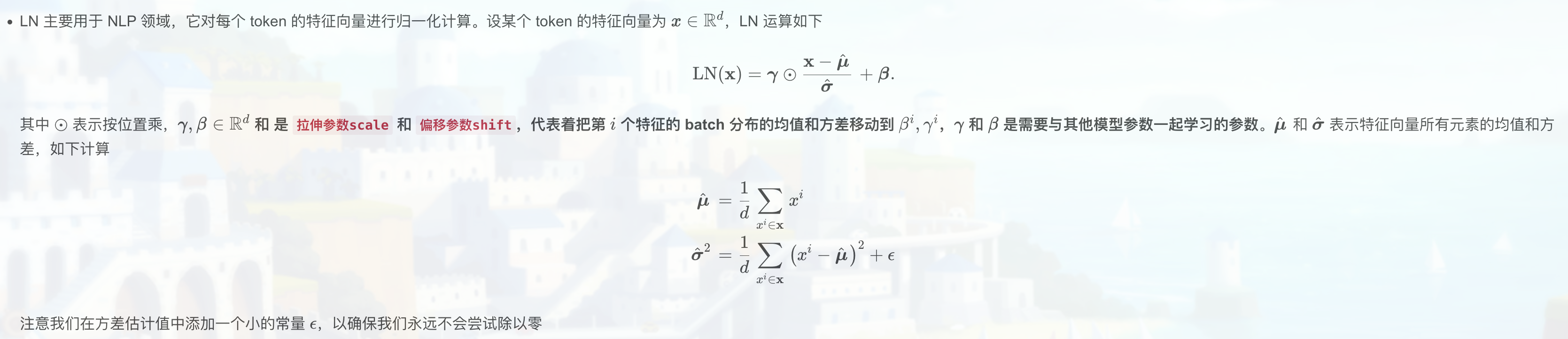

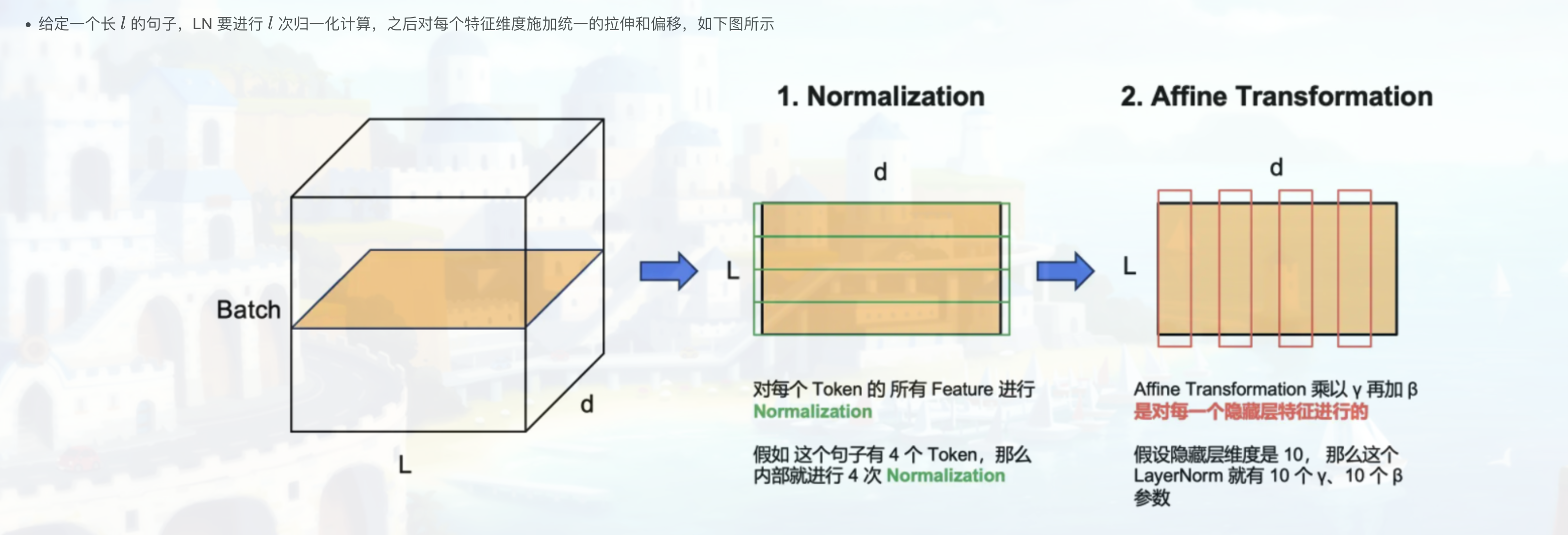

Layer Normalization(层归一化):

- Layer Normalization与Batch Normalization类似,但它是在整个输入层上进行的归一化操作,而不是在每个小批量数据上(对每个样本的所有特征做归一化,这消除了不同样本间的大小关系,但是保留了一个样本内不同特征之间的大小关系)。Layer Normalization适用于序列模型,如RNN和Transformer。LayerNorm 适用于 NLP 领域,这时输入尺寸为 b × l × d (批量大小x序列长度x嵌入维度),如下图所示

- 注意这时长 l ll 的 token 序列中,每个 token 对应一个长为 d 的特征向量,LayerNorm 会对各个 token 执行 l 次归一化计算,保留每个 token d 维嵌入内部的相对大小关系,同时拉近了不同 token 对应特征向量间的距离。与之相比,BN 会消除 d 维特征向量各维度之间的大小关系,破坏了 token 的特征(以下第 2 节会进一步说明这一点)

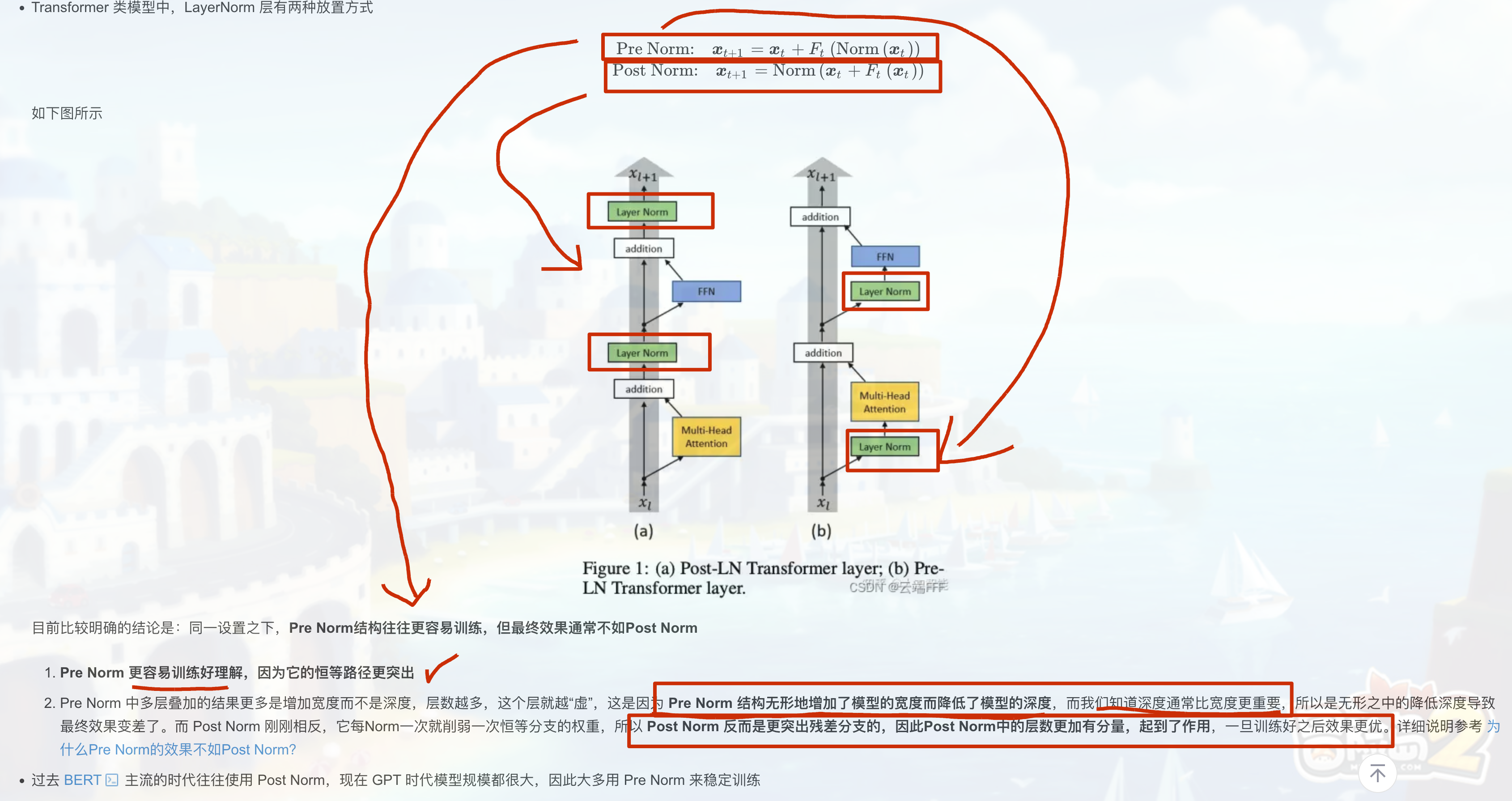

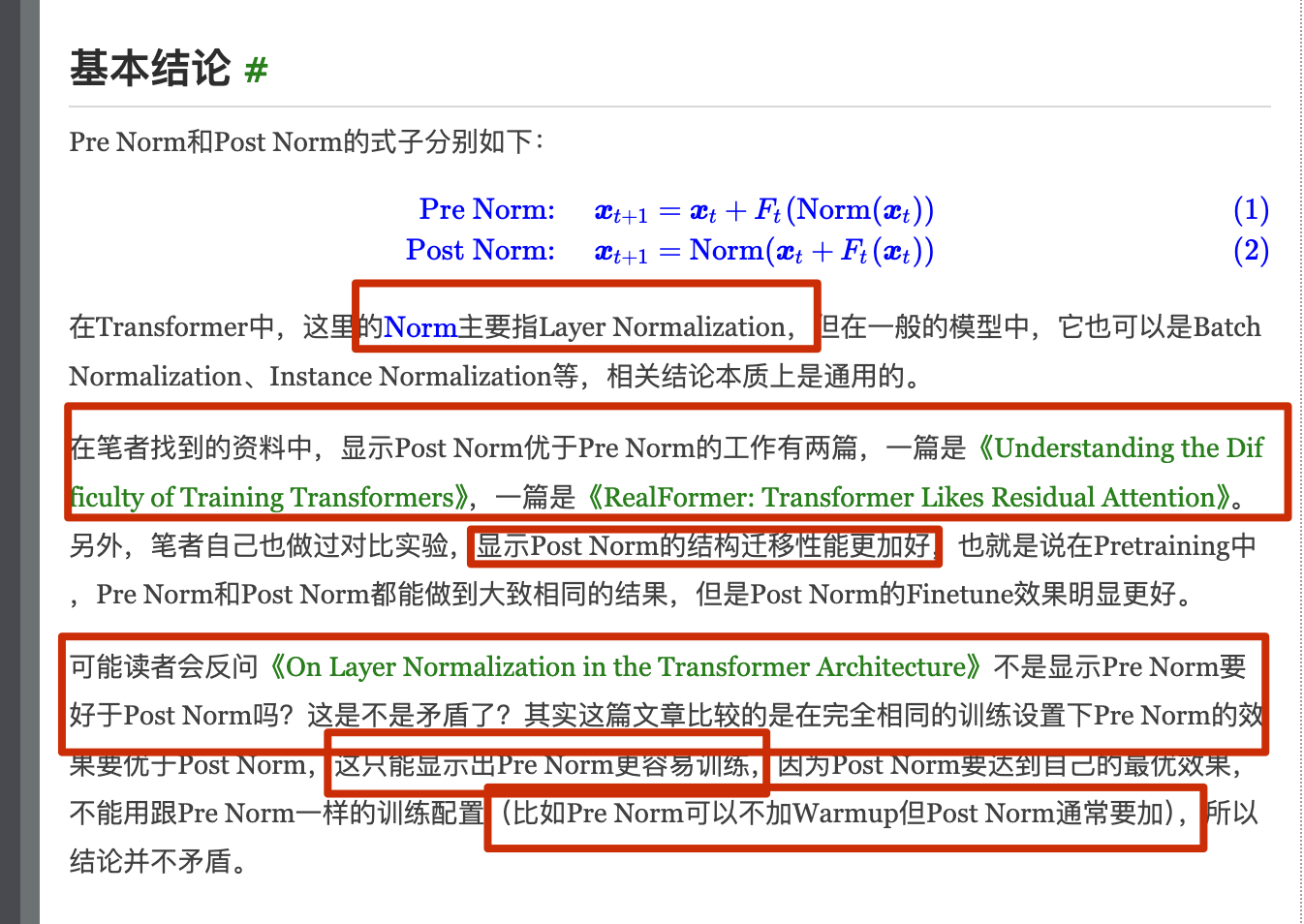

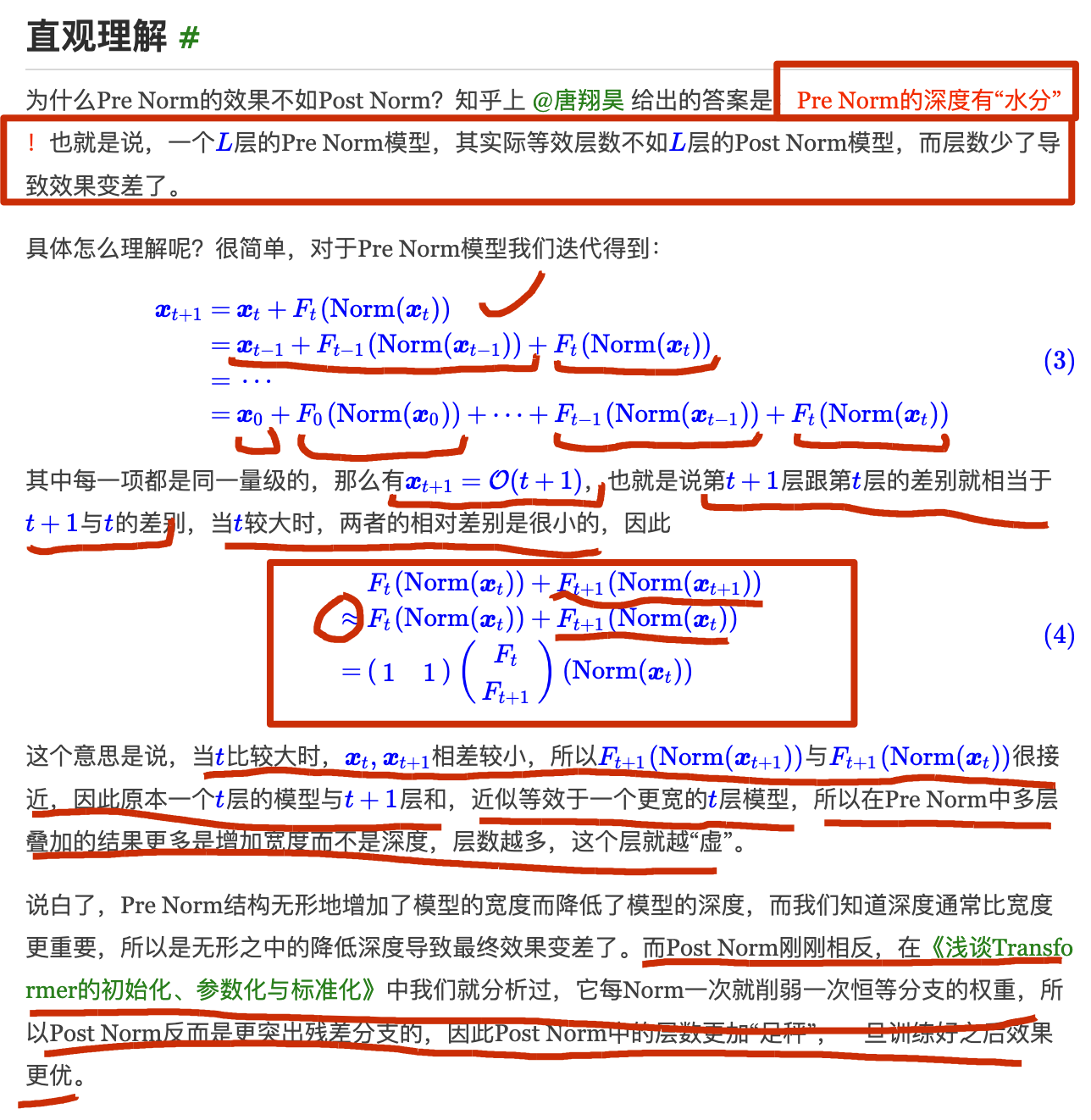

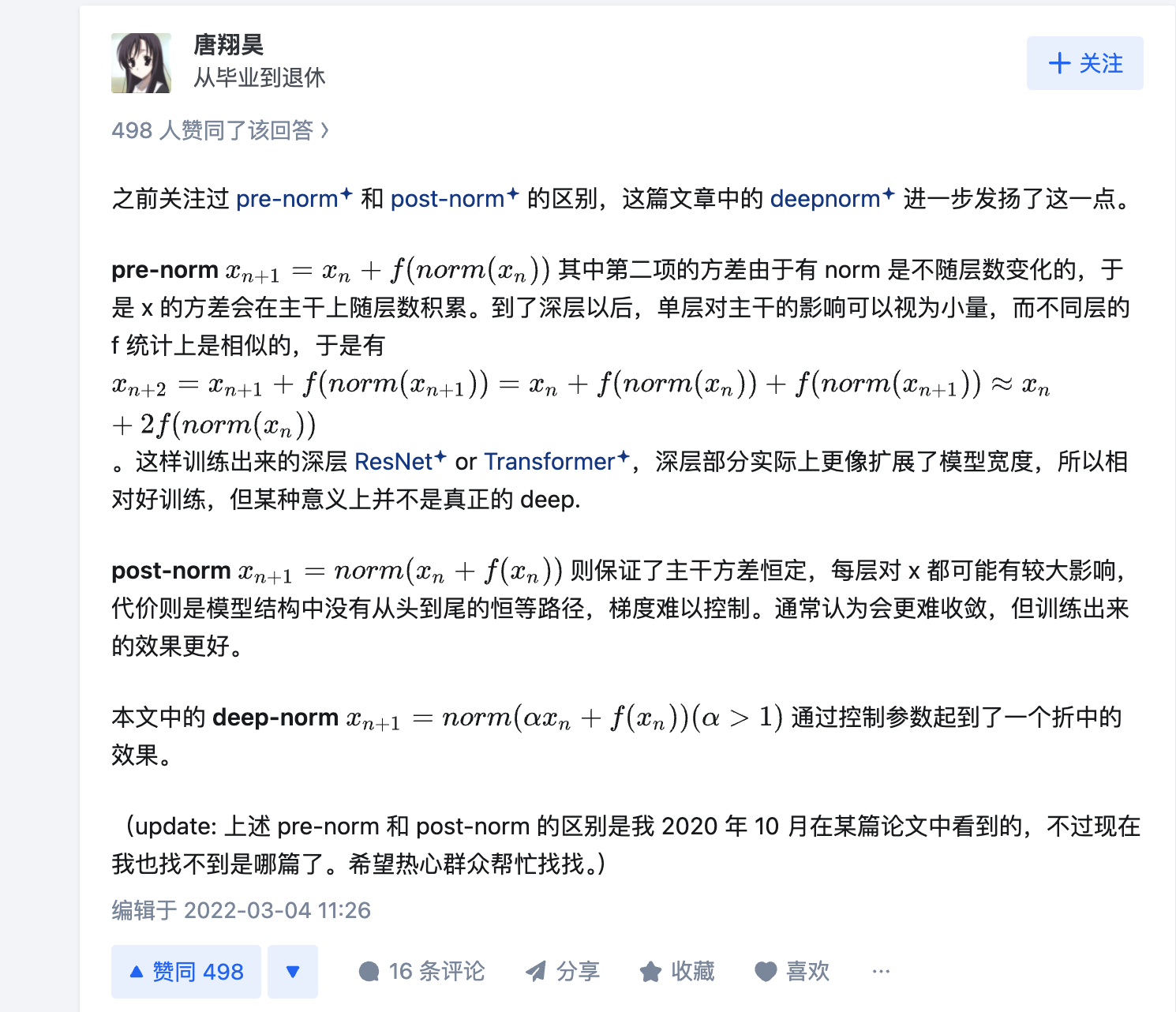

为什么Pre Norm的效果不如Post Norm? https://kexue.fm/archives/9009

什么是 warmup?

不理解

首先,“同一量级” 应该是指每次经过 Norm 和 F 函数处理后,输出的向量模长或各分量的大小保持在相似的范围,比如经过 Layer Normalization 后,数据的均值和方差被标准化,所以每次 F 的输出不会有太大的数值变化。假设每一项 Fₜ(Norm (xₜ)) 的模长大约为常数 C,那么累加 t+1 项后,xₜ₊₁的模长大约是 (t+1)*C,也就是 O (t+1)。

接下来,第 t+1 层和第 t 层的差别是 Fₜ(Norm (xₜ)),其模长是 C,而 xₜ的模长是 tC,所以相对差别是 C/(tC)=1/t,当 t 很大时,这个相对差别趋近于 0,意味着相邻层之间的变化越来越小,模型的有效深度被稀释,因为每层的贡献相对于总输出来说变得微不足道,导致深层的信息更新不明显,相当于模型实际深度没有层数显示的那么深,而是更像宽度的增加,因为每层的贡献相似,堆叠起来更像增加了宽度而不是深度。 https://www.zhihu.com/question/519668254/answer/2371885202 On Layer Normalization in Transformer Architecture

rmsNorm

1 | class LlamaRMSNorm(nn.Module): |

Instance Normalization(实例归一化):

- Instance Normalization是在每个样本的每个通道上进行的归一化操作,而不是在整个批次或整个层上。Instance Normalization常用于图像生成模型,如GAN和StyleGAN。

Group Normalization(组归一化):

- Group Normalization是一种介于Batch Normalization和Layer Normalization之间的归一化方法。它将输入的通道分成若干组,然后在每个组内进行归一化操作。Group Normalization可以在一定程度上缓解Batch Normalization在训练小批量数据时的不稳定问题。

Layer-wise Scale and Bias(层归一化):

- 这种方法是在每个神经元的输出上添加可学习的缩放和偏移参数,以实现归一化效果。这种方法类似于Batch Normalization,但它是在每个神经元上独立进行的,而不是在整个层或整个批次上。

Group-wise Factorization(组归一化):

- 这种方法将卷积层的权重分解为两个矩阵,然后对这两个矩阵分别进行归一化操作。这种方法可以在一定程度上提高模型的训练效率和泛化能力。

这些归一化方法各有优缺点,选择哪种方法取决于具体任务和模型结构。在实际应用中,通常需要根据实验结果来选择最合适的归一化方法。 归一化是常用的稳定训练的手段,CV 中常用 Batch Norm; Transformer 类模型中常用 layer norm,而 RMSNorm 是近期很流行的 LaMMa 模型使用的标准化方法,它是 Layer Norm 的一个变体

从一维卷积、因果卷积(Causal CNN)、扩展卷积(Dilation CNN) 到 时间卷积网络 (TCN)

引言

卷积神经网络 (CNN) 尽管通常与图像分类任务相关,但经过改造,同样可以用于序列建模预测。在本文中,我们将详细探讨时间卷积网络 (TCN) 所包含的基本构建块,以及它们如何组合在一起从而变成强大的预测模型。本文对 时间卷积网络 (TCN) 的描述基于以下论文:https://link.zhihu.com/?target=https%3A//arxiv.org/pdf/1803.01271.pdf

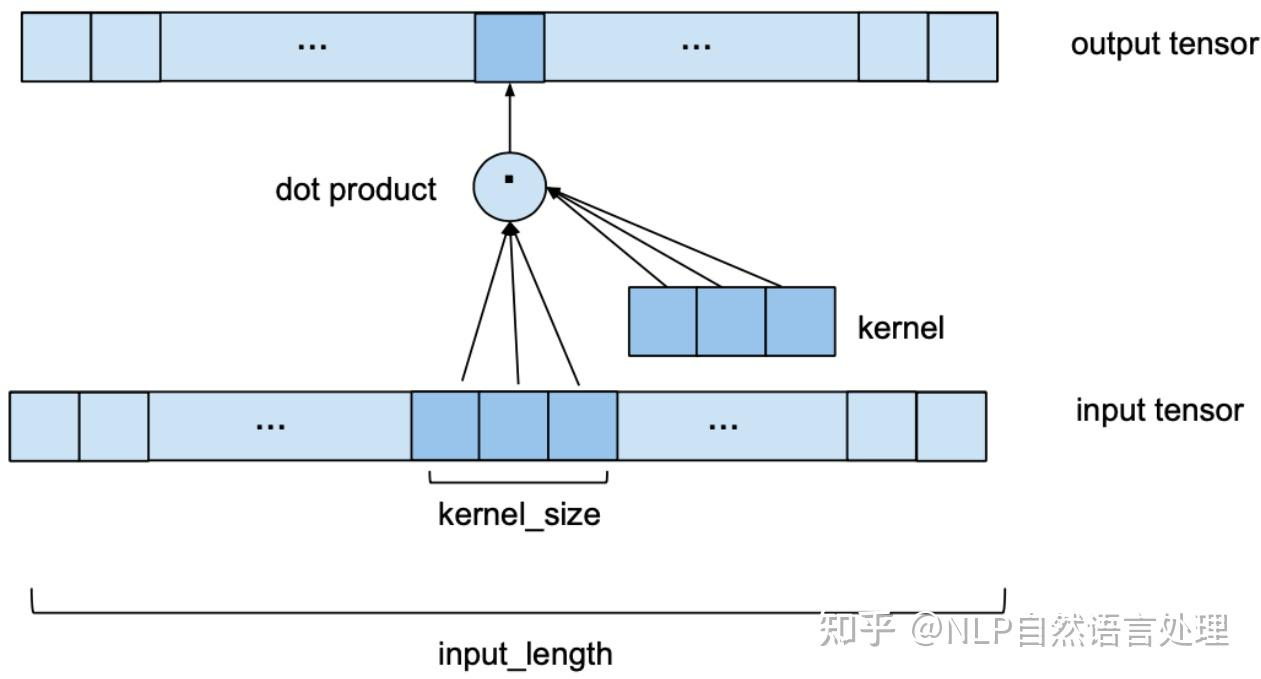

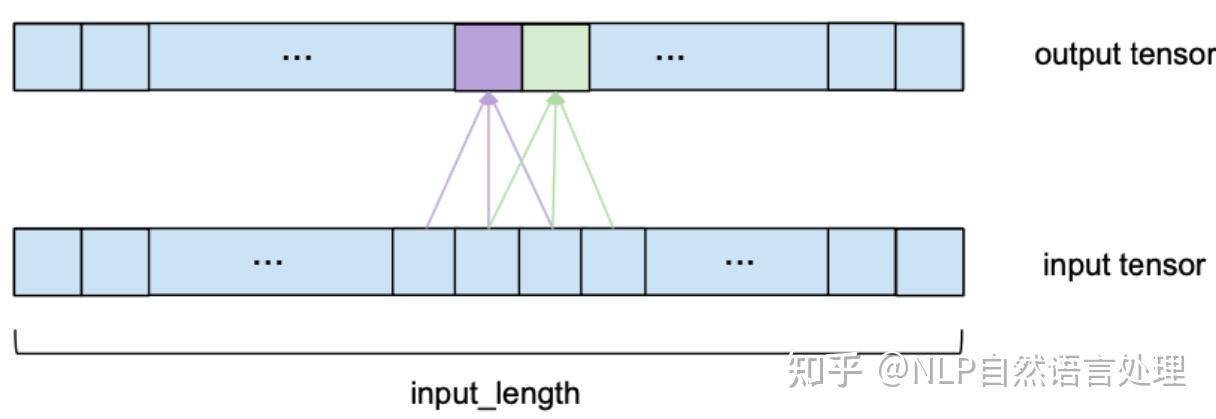

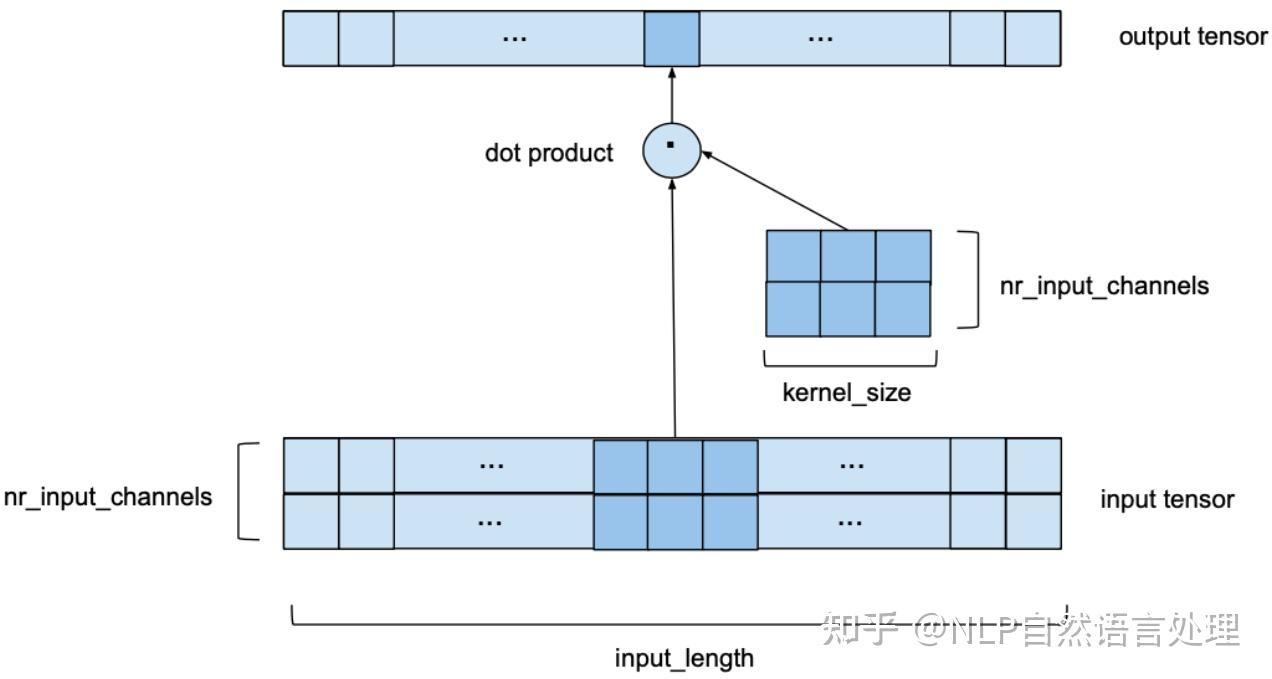

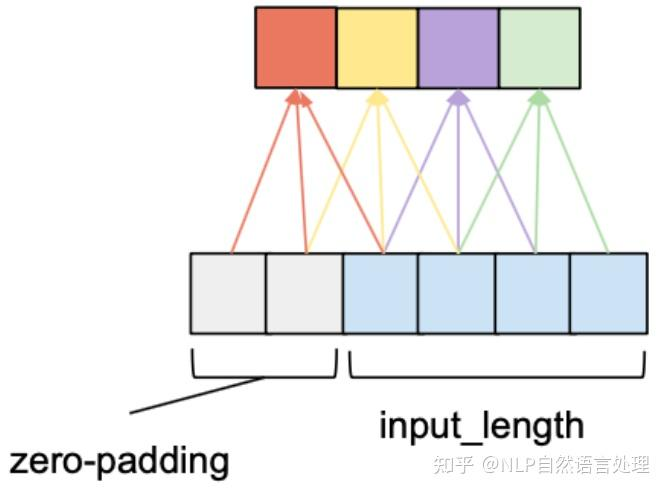

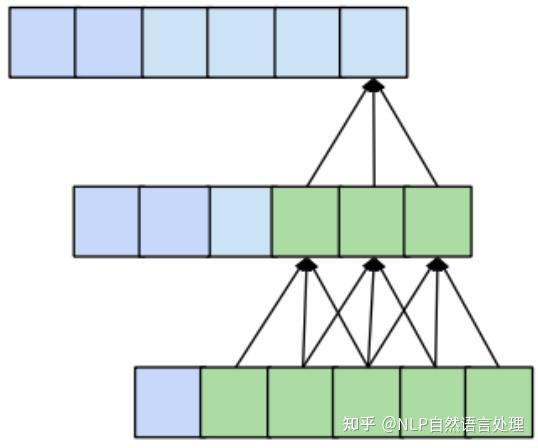

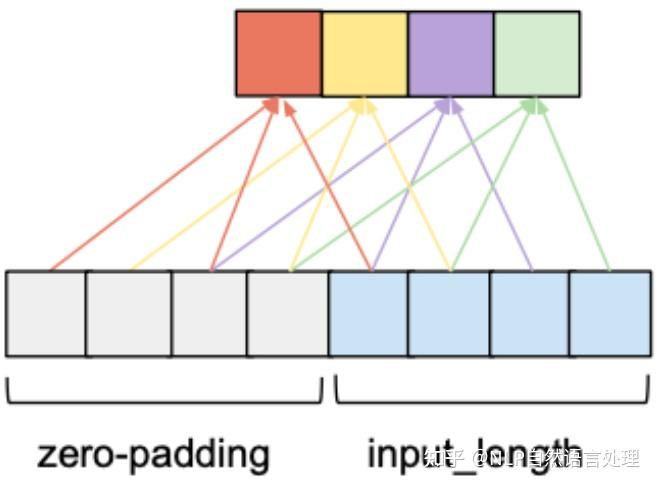

背景介绍